02. Apr. 2025·8 Min

Bob Kahn und TCP/IP: Die unsichtbare Schicht hinter modernen Apps

Erfahre, wie Bob Kahn TCP/IP mitgestaltete, warum zuverlässige Paketvermittlung wichtig ist und wie dieses Design noch heute Apps, APIs und Cloud‑Dienste trägt.

Erfahre, wie Bob Kahn TCP/IP mitgestaltete, warum zuverlässige Paketvermittlung wichtig ist und wie dieses Design noch heute Apps, APIs und Cloud‑Dienste trägt.

Die meisten Apps wirken „sofort“: Du tippst auf einen Button, ein Feed aktualisiert sich, eine Zahlung geht durch, ein Video startet. Was du nicht siehst, ist die Arbeit darunter: winzige Datenstücke über WLAN, Mobilfunk, Heimrouter und Rechenzentren — oft durch mehrere Länder — zu bewegen, ohne dass du dich um die unangenehmen Details kümmern musst.

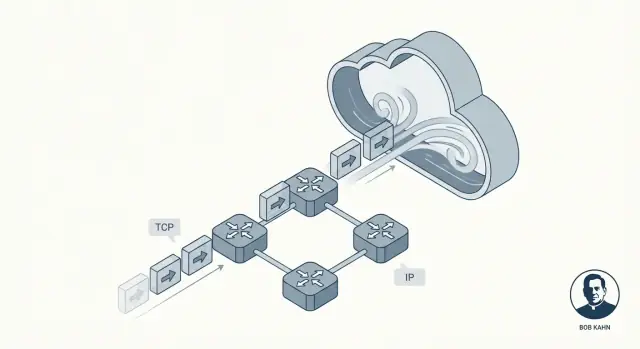

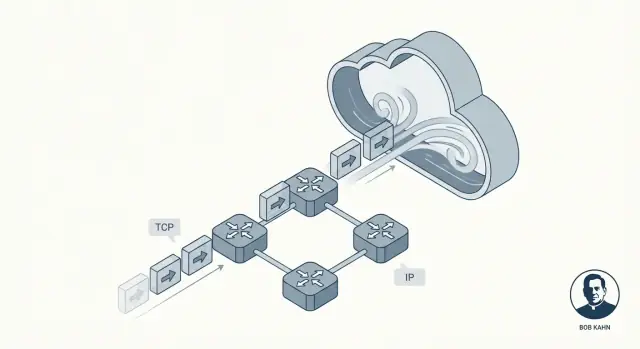

Diese Unsichtbarkeit ist das Versprechen, das TCP/IP erfüllt. Es ist kein einzelnes Produkt oder Cloud‑Feature. Es ist eine Sammlung gemeinsamer Regeln, die Geräte und Server so miteinander sprechen lässt, dass es meistens glatt und verlässlich wirkt, auch wenn das Netz laut, überlastet oder teilweise ausgefallen ist.

Bob Kahn war einer der Schlüsselfiguren, die das möglich gemacht haben. Gemeinsam mit Mitarbeitern wie Vint Cerf formte Kahn die Kernideen zu TCP/IP: eine gemeinsame "Sprache" für Netzwerke und eine Methode, Daten so zu liefern, dass Anwendungen darauf bauen können. Kein Hype nötig — diese Arbeit war wichtig, weil sie unzuverlässige Verbindungen in etwas verwandelte, auf das Software zuverlässig aufbauen kann.

Statt eine ganze Nachricht als einen durchgehenden Strom zu senden, zerlegt die Paketvermittlung sie in kleine Stücke, sogenannte Pakete. Jedes Paket kann seinen eigenen Weg zum Ziel nehmen, wie einzelne Umschläge, die durch verschiedene Postämter gehen.

Wir werden aufschlüsseln, wie TCP das Gefühl von Zuverlässigkeit erzeugt, warum IP absichtlich keine Perfektion verspricht und wie Layering das System verständlich hält. Am Ende kannst du dir vorstellen, was passiert, wenn eine App eine API aufruft — und warum diese Jahrzehnte alten Ideen noch immer moderne Cloud‑Dienste antreiben.

Frühe Computernetze entstanden nicht als „das Internet“. Sie wurden für spezifische Gruppen und Ziele gebaut: ein Uni‑Netz hier, ein militärisches Netz dort, ein Forschungslabor anderswo. Jedes funktionierte intern gut, nutzte aber oft unterschiedliche Hardware, Nachrichtenformate und Regeln für den Datenverkehr.

Das führte zu einer frustrierenden Realität: Selbst wenn zwei Rechner „vernetzt“ waren, konnten sie trotzdem nicht unbedingt Informationen austauschen. Es ist ein bisschen wie viele Eisenbahnsysteme mit unterschiedlichen Spurweiten und unterschiedlichen Signalen. Binnen eines Systems klappt der Verkehr, das Überschreiten in ein anderes System ist kompliziert, teuer oder unmöglich.

Bob Kahns zentrale Herausforderung war nicht einfach „Computer A mit Computer B verbinden“. Sie lautete: Wie verbindet man Netzwerke miteinander, so dass Verkehr mehrere unabhängige Systeme durchqueren kann, als wären sie ein größeres System?

Genau das bedeutet "Internetworking" — einen Weg zu bauen, damit Daten von einem Netzwerk ins nächste hüpfen können, selbst wenn diese Netzwerke unterschiedlich gestaltet und von verschiedenen Organisationen betrieben werden.

Damit Internetworking im großen Maßstab funktioniert, brauchte es ein gemeinsames Regelwerk — Protokolle — das nicht von der internen Gestaltung eines einzelnen Netzes abhängt. Diese Regeln mussten auch reale Beschränkungen widerspiegeln:

TCP/IP wurde die praktische Antwort: eine gemeinsame "Vereinbarung", die unabhängige Netze verbinden und dennoch Daten zuverlässig genug für reale Anwendungen bewegen ließ.

Bob Kahn ist vor allem als einer der Architekten der "Regeln der Straße" des Internets bekannt. In den 1970ern, während seiner Zeit bei DARPA, half er dabei, Netzwerke von einem cleveren Forschungsexperiment in etwas zu überführen, das viele verschiedene Netzwerktypen verbinden konnte — ohne sie zur gleichen Hardware, Verkabelung oder internem Design zu zwingen.

ARPANET bewies, dass Computer über paketvermittelte Verbindungen kommunizieren können. Aber auch andere Netze entstanden — Funknetze, Satellitenverbindungen und weitere experimentelle Netze — jedes mit eigenen Eigenheiten. Kahns Fokus war Interoperabilität: eine Nachricht so zu ermöglichen, dass sie mehrere Netze durchquert, als wäre es ein einziges.

Statt ein "perfektes" einzelnes Netz zu bauen, verfolgte er einen Ansatz, bei dem:

Gemeinsam mit Vint Cerf entwarf Kahn, was TCP/IP werden sollte. Ein dauerhaftes Ergebnis war die saubere Trennung der Verantwortlichkeiten: IP kümmert sich um Adressierung und Weiterleitung über Netze hinweg, TCP um zuverlässige Lieferung für Anwendungen, die sie brauchen.

Wenn du jemals eine API aufgerufen, eine Webseite geladen oder Logs aus einem Container an einen Monitoring‑Dienst geschickt hast, verlässt du dich auf Kahns Internetworking‑Modell. Du musst nicht wissen, ob Pakete über WLAN, Glasfaser, LTE oder ein Cloud‑Backbone laufen. TCP/IP lässt das alles wie ein durchgehendes System erscheinen — so kann sich Software auf Funktionen statt auf Verkabelung konzentrieren.

Eine der klügsten Ideen hinter TCP/IP ist Layering: statt ein riesiges "Alles‑könner"‑Netzwerk zu bauen, stapelt man kleinere Teile, wobei jede Schicht eine Sache gut macht.

Das ist wichtig, weil Netze nicht alle gleich sind. Unterschiedliche Kabel, Funktechniken, Router und Anbieter können trotzdem zusammenarbeiten, wenn sie sich auf ein paar klare Verantwortlichkeiten einigen.

Denk an IP (Internet Protocol) als den Teil, der antwortet: Wohin gehen die Daten, und wie bringen wir sie dem Ziel näher?

IP stellt Adressen bereit (damit Maschinen identifiziert werden können) und grundlegendes Routing (damit Pakete von Netzwerk zu Netzwerk hüpfen). Wichtig: IP versucht nicht, perfekt zu sein. Es konzentriert sich darauf, Pakete Schritt für Schritt voranzubringen, auch wenn sich der Pfad ändert.

Darauf sitzt TCP (Transmission Control Protocol) und beantwortet: Wie erzeugen wir das Gefühl einer verlässlichen Verbindung?

TCP übernimmt die für Anwendungen wichtige "Zuverlässigkeit": korrekte Reihenfolge, Erkennung fehlender Teile, erneutes Senden und das Dosieren der Übertragung, damit der Sender den Empfänger oder das Netz nicht überlastet.

Eine hilfreiche Vorstellung der Aufteilung ist das Postsystem:

Du fragst ja auch nicht die Straße nach einer Zustellgarantie — diese Zusicherung baust du obendrauf.

Weil die Verantwortlichkeiten getrennt sind, kannst du eine Schicht verbessern, ohne alles neu zu entwerfen. Neue physische Netze können IP transportieren, und Anwendungen können sich auf TCP‑Verhalten verlassen, ohne Routing im Detail zu verstehen. Diese saubere Trennung ist ein Hauptgrund, warum TCP/IP zur unsichtbaren, gemeinsamen Grundlage unter fast jeder App und API wurde.

Paketvermittlung ist die Idee, die große Netze praktikabel gemacht hat: anstatt eine dedizierte Leitung für deine ganze Nachricht zu reservieren, zerschneidet man die Nachricht in kleine Teile und sendet jedes Stück unabhängig.

Ein Paket ist ein kleines Datenbündel mit einem Header (wer schickt, wer empfängt und Routing‑Infos) plus einem Teil des Inhalts.

Das Zerteilen hilft, weil das Netz:

Hier beginnt das "Chaos". Pakete derselben Übertragung können verschiedene Routen nehmen, abhängig davon, was gerade ausgelastet oder verfügbar ist. Das bedeutet, sie können außer Reihenfolge ankommen — Paket #12 kann vor Paket #5 eintreffen.

Die Paketvermittlung versucht das nicht zu verhindern. Sie priorisiert das schnelle Durchkommen, auch wenn die Ankunftsreihenfolge durcheinander ist.

Paketverlust ist nicht selten und nicht immer die Schuld irgendjemandes. Häufige Ursachen:

Die zentrale Designentscheidung ist, dass das Netz unvollkommen sein darf. IP konzentriert sich auf bestmögliche Weiterleitung, ohne Zustellung oder Reihenfolge zu versprechen. Diese Freiheit ermöglicht Skalierung — und erklärt, warum höhere Schichten (wie TCP) existieren, um das Chaos aufzuräumen.

IP liefert Pakete best‑effort: einige kommen verspätet, außer Reihenfolge, doppelt oder gar nicht an. TCP sitzt darüber und schafft etwas, dem Anwendungen vertrauen können: einen einzelnen, geordneten, vollständigen Bytestrom — genau die Verbindung, die du beim Hochladen, Webseitenladen oder API‑Aufruf erwartest.

Wenn man sagt, TCP sei "zuverlässig", meint man meist:

TCP zerlegt deine Daten in Stücke und versieht sie mit Sequenznummern. Der Empfänger sendet Acknowledgements (ACKs) zurück, um zu bestätigen, was angekommen ist.

Wenn der Sender kein ACK rechtzeitig sieht, nimmt er Paketverlust an und führt eine Retransmission durch. Das ist die zentrale "Illusion": obwohl das Netz Pakete fallen lässt, versucht TCP so lange, bis der Empfänger den Empfang bestätigt.

Das klingt ähnlich, löst aber verschiedene Probleme:

Zusammen helfen sie TCP, schnell zu bleiben, ohne rücksichtslos zu sein.

Feste Timeouts würden in langsamen wie schnellen Netzen versagen. TCP passt Timeouts kontinuierlich anhand gemessener Round‑Trip‑Times an. Verschlechtert sich die Verbindung, wartet es länger vor einem Retransmit; wird sie schneller, reagiert es zügiger. Diese Anpassungsfähigkeit erklärt, warum TCP über WLAN, Mobilnetze und Langstreckenverbindungen hinweg funktioniert.

Eine der wichtigsten Ideen hinter TCP/IP ist das Ende‑zu‑Ende‑Prinzip: "Intelligenz" an die Ränder (Endpunkte) legen und das Netzinnere relativ einfach halten.

Konkret sind die Endpunkte die Geräte und Programme, denen die Daten wirklich wichtig sind: dein Telefon, dein Laptop, ein Server und die darauf laufenden Betriebssysteme und Anwendungen. Der Netzwerkkern — Router und Verbindungen dazwischen — konzentriert sich hauptsächlich aufs Weiterleiten.

Anstatt jeden Router "perfekt" zu machen, akzeptiert TCP/IP, dass das Netzmittelstück unvollkommen ist, und lässt die Endpunkte die kontextabhängigen Aufgaben übernehmen.

Ein einfacherer Kern erleichterte die Expansion des Internets. Neue Netze konnten beitreten, ohne dass jedes Zwischenstück die Anforderungen jeder Anwendung kennen musste. Router müssen nicht wissen, ob ein Paket zu einem Videoanruf, einem Datei‑Download oder einer API‑Anfrage gehört — sie leiten einfach weiter.

An den Endpunkten handhabt man typischerweise:

Im Netz kümmert man sich hauptsächlich um:

Ende‑zu‑Ende skaliert gut, schiebt aber Komplexität nach außen. Betriebssysteme, Bibliotheken und Anwendungen werden verantwortlich dafür, dass über unordentliche Netze alles "funktioniert". Das ist flexibel, kann aber auch bedeuten, dass Bugs, falsch konfigurierte Timeouts oder zu aggressive Retries echte Nutzerprobleme erzeugen.

IP (Internet Protocol) macht ein einfaches Versprechen: Es wird versuchen, deine Pakete in Richtung ihres Ziels zu bewegen. Das war’s.

Das klingt vielleicht wie ein Mangel — bis man betrachtet, was das Internet werden musste: ein globales Netz aus vielen kleineren Netzen, im Besitz verschiedener Organisationen und ständig im Wandel.

Router sind die "Verkehrsleiter" von IP. Ihre Hauptaufgabe ist Weiterleitung: Wenn ein Paket ankommt, schaut der Router auf die Zieladresse und wählt den nächsten Hop, der gerade am besten erscheint.

Router verfolgen keine Unterhaltung wie ein Telefonvermittler. Sie reservieren in der Regel keine Kapazität für dich und bestätigen nicht, dass ein Paket angekommen ist. Indem Router sich auf Weiterleitung konzentrieren, bleibt der Netzwerkkern einfach — und skaliert zu einer enormen Zahl von Geräten und Verbindungen.

Garantie sind teuer. Wenn IP Zustellung, Reihenfolge und Zeit für jedes Paket garantieren wollte, müsste jedes Netz auf der Erde eng koordiniert werden, viel Zustand speichern und Ausfälle auf die gleiche Weise beheben. Diese Koordinationslast würde Wachstum verlangsamen und Ausfälle schwerer machen.

Stattdessen toleriert IP Unordnung. Fällt ein Link aus, kann ein Router Pakete über einen anderen Weg senden. Wird ein Pfad überlastet, werden Pakete verzögert oder verworfen, aber der Verkehr läuft oft über Alternativrouten weiter.

Das Ergebnis ist Resilienz: Das Internet kann weiterarbeiten, auch wenn Teile davon brechen oder sich ändern — weil das Netz nicht gezwungen ist, perfekt zu sein, um nützlich zu bleiben.

Wenn du eine API mit fetch() aufrufst, auf "Speichern" klickst oder eine Websocket öffnest, "sprichst" du nicht in einem glatten Strom direkt mit dem Server. Deine App gibt Bytes an das Betriebssystem, das sie in Pakete zerschneidet und über viele verschiedene Netze schickt — jeder Hop trifft eigene Entscheidungen.

Eine häufige Überraschung: Du kannst guten Durchsatz haben und trotzdem eine träge UI, weil jede Anfrage auf Round‑Trips wartet.

TCP versucht verlorene Pakete erneut, aber es kennt nicht, was für die Nutzererfahrung "zu lange" ist. Deshalb fügen Anwendungen hinzu:

Pakete können verzögert, umsortiert, dupliziert oder verworfen werden. Staus können Latenzspitzen verursachen. Ein Server kann antworten, aber die Antwort erreicht dich nie. Das äußert sich als flakige Tests, sporadische 504er oder "bei mir klappt es". Oft ist der Code in Ordnung — der Pfad zwischen den Maschinen nicht.

Cloud‑Plattformen fühlen sich manchmal wie eine neue Art des Rechnens an — verwaltete DBs, Serverless‑Funktionen, "unbegrenztes" Scaling. Darunter laufen deine Anfragen aber immer noch auf denselben TCP/IP‑Fundamenten, die Bob Kahn mit angestoßen hat: IP bewegt Pakete, TCP (oder manchmal UDP) formt die Anwendungserfahrung.

Virtualisierung und Container verändern wo Software läuft und wie sie verpackt ist:

Das sind Deployment‑Details. Pakete nutzen weiterhin IP‑Adressen und Routing, viele Verbindungen verlassen sich weiterhin auf TCP für geordnete, zuverlässige Lieferung.

Gängige Cloud‑Architekturen basieren auf bekannten Bausteinen:

Selbst wenn du keine IP‑Adresse siehst, vergibt und routet die Plattform sie im Hintergrund und verfolgt Verbindungen.

TCP kann verlorene Pakete wiederherstellen, Lieferung ordnen und sich an Stau anpassen — aber es kann kein Unmögliches versprechen. In Cloud‑Systemen ist Zuverlässigkeit eine gemeinsame Aufgabe:

Deshalb hängen auch "vibe‑coding"‑Plattformen, die Full‑Stack‑Apps generieren und deployen (z. B. Koder.ai), auf denselben Grundlagen: Sobald eine App mit einer API, DB oder einem Client spricht, bist du wieder in TCP/IP‑Territorium — Verbindungen, Timeouts, Retries und alles drumherum.

Wenn Entwickler vom "Netz" sprechen, entscheiden sie sich meist zwischen zwei Transporten: TCP und UDP. Beide sitzen über IP, treffen aber unterschiedliche Kompromisse.

TCP passt gut, wenn Daten in Ordnung und vollständig ankommen müssen und man lieber wartet als zu raten. Denk an Webseiten, API‑Aufrufe, Dateiübertragungen, DB‑Verbindungen.

Deshalb läuft so viel Alltagsinternet darüber — HTTPS nutzt TCP (mit TLS), und viele Request/Response‑Systeme setzen auf TCP‑Verhalten.

Der Haken: TCP‑Zuverlässigkeit kann Latenz hinzufügen. Fehlt ein Paket, können spätere Pakete solange zurückgehalten werden, bis die Lücke gefüllt ist ("Head‑of‑Line‑Blocking"). Für interaktive Erlebnisse kann dieses Warten schlimmer wirken als gelegentliche Fehler.

UDP ist nahe an "sende eine Nachricht und hoffe, sie kommt an". Es gibt keine eingebaute Reihenfolge, kein Retransmit und keine Staukontrolle auf UDP‑Ebene.

Entwickler wählen UDP, wenn Timing wichtiger ist als Perfektion — Live‑Audio/Video, Gaming oder Echtzeit‑Telemetrie. Viele Anwendungen bauen eigene, leichte Zuverlässigkeitsmechanismen (oder gar keine), basierend darauf, was Nutzer tatsächlich bemerken.

Ein großes modernes Beispiel: QUIC läuft über UDP, sodass Anwendungen schnellere Verbindungsaufbauten erreichen und einige TCP‑Engpässe vermeiden — ohne das zugrunde liegende IP‑Netz ändern zu müssen.

Entscheide nach:

TCP wird oft als "zuverlässig" beschrieben, aber das heißt nicht, dass deine App sich immer zuverlässig anfühlt. TCP kann viele Netzwerkprobleme ausbügeln, aber es kann keine niedrige Verzögerung, konstanten Durchsatz oder ein gutes Nutzererlebnis auf einem instabilen Pfad versprechen.

Paketverlust zwingt TCP zu Retransmits. Die Zuverlässigkeit bleibt, aber die Performance kann einbrechen.

Hohe Latenz (lange RTT) verlangsamt jeden Request/Response‑Zyklus, selbst ohne Paketverlust.

Bufferbloat entsteht, wenn Router oder OS‑Queues zu viel Daten halten. TCP sieht weniger Verluste, Nutzer erleben aber große Verzögerungen und "Lag".

Falsch konfigurierte MTU kann Fragmentierung oder Blackholing verursachen (Pakete verschwinden, wenn sie "zu groß" sind) und sehr verwirrende Fehler hervorrufen.

Statt eines klaren "Netzwerkfehlers" siehst du oft:

Diese Symptome sind real, aber nicht immer durch deinen Code verursacht. Häufig arbeitet TCP genau wie vorgesehen — es retransmittiert, drosselt und wartet — während deine Anwendungs‑Uhr weiterläuft.

Klassifiziere zunächst: Liegt das Problem eher an Verlust, Latenz oder Pfadänderungen?

Wenn du schnell aufbaust (z. B. mit Koder.ai eine Service‑Prototype deployst), lohnt es sich, diese Observability‑Basics gleich in die Planungsphase zu nehmen — Netzfehler zeigen sich zuerst als Timeouts und Retries, nicht als ordentliche Exceptions.

Geh davon aus, dass Netze sich danebenbenehmen. Nutze Timeouts, Retries mit exponentialem Backoff und mache Operationen idempotent, damit Retries keine Doppelbuchungen, Doppelanfertigungen oder Inkonsistenzen erzeugen.

TCP/IP ist ein gemeinsamer Satz von Netzwerkregeln, der es verschiedenen Netzwerken erlaubt, miteinander zu interagieren und Daten vorhersehbar zu transportieren.

Es ist wichtig, weil es heterogene, unzuverlässige Verbindungen (WLAN, LTE, Glasfaser, Satellit) nutzbar für Software macht — so können Apps davon ausgehen, Bytes zu senden und Antworten zu erhalten, ohne die physische Netzwerkinfrastruktur im Detail kennen zu müssen.

Bob Kahn trieb die Idee des "Internetworking" voran: Netzwerke miteinander zu verbinden, ohne sie dazu zu zwingen, dieselbe interne Hardware oder Struktur zu verwenden.

Gemeinsam mit anderen (vor allem Vint Cerf) formte er die Trennung, wonach IP Adressierung und Routing zwischen Netzwerken übernimmt und TCP auf dieser Basis Zuverlässigkeit für Anwendungen bereitstellt.

Paketvermittlung teilt eine Nachricht in kleine Pakete, die unabhängig voneinander reisen können.

Vorteile:

IP hat eine klare Aufgabe: Pakete in Richtung Zieladresse weiterleiten. Es garantiert weder Zustellung noch Reihenfolge oder Timing.

Dieses "Best‑Effort"‑Modell skaliert global, weil Router einfach und schnell bleiben können und das Netz weiterarbeitet, während Verbindungen oder Routen sich ändern.

TCP verwandelt die Best‑Effort‑Pakete von IP in einen für Anwendungen brauchbaren geordneten Bytestrom.

Dafür nutzt es:

Sie lösen unterschiedliche Probleme:

Gute Performance benötigt beide Mechanismen: ein schneller Sender muss sowohl den Empfänger als auch das Netz respektieren.

Layering trennt Verantwortlichkeiten, sodass jede Schicht unabhängig weiterentwickelt werden kann.

Für Entwickler heißt das: APIs bauen, ohne die App für jeden Netztyp neu erfinden zu müssen.

Das Ende‑zu‑Ende‑Prinzip hält das Kernnetz (Router) relativ einfach und legt die "Intelligenz" an die Endpunkte.

Praktische Folge: Anwendungen und Betriebssysteme übernehmen Zuverlässigkeit, Timeouts, Retries und Verschlüsselung (oft via TLS), weil das Netz nicht für jede Anwendung maßgeschneidert reagieren kann.

Latenz ist die Rundlaufzeit; sie schadet chatty Mustern (viele kleine Anfragen, Weiterleitungen, wiederholte API‑Aufrufe).

Durchsatz ist die Menge an Daten pro Sekunde; er ist wichtig für große Transfers (Uploads, Bilder, Backups).

Praktische Tipps:

Wähle nach Bedarf:

Faustregel: Bei request/response‑Mustern und Korrektheitsanspruch ist TCP (bzw. QUIC/HTTP/3) meist der Startpunkt.