Warum Butler Lampson für Systeme im großen Maßstab noch wichtig ist

Butler Lampson gehörte zu den einflussreichsten Entwerfern von Computersystemen der letzten fünf Jahrzehnte. Bei Xerox PARC in den 1970er und 80er Jahren prägte er, wie vernetzte Computer sich verhalten sollten — nicht als isolierte Maschinen, sondern als Teile einer geteilten Umgebung, in der Programme, Dateien, Drucker und Menschen zuverlässig zusammenarbeiten können.

Was Lampsons Arbeit ungewöhnlich dauerhaft macht, ist, dass sie sich auf Fundamentals konzentrierte: Schnittstellen, die skalieren, Mechanismen, die komponieren, und Systeme, die reale Fehler annehmen statt sie als Ausnahme zu behandeln.

Was „Systeme im großen Maßstab“ wirklich bedeutet

„Skalierung“ heißt nicht nur ein riesiges Rechenzentrum zu haben. Es ist das, was passiert, wenn dein System viele Nutzer, viele Maschinen und reale Unordnung hat. Denk an: ein Büro, in dem hunderte Laptops und Dienste Logins und Dateien teilen; ein Produkt, das von tausenden Kunden gleichzeitig genutzt wird; oder eine Unternehmens-App, die weiter funktionieren muss, wenn ein Server ausfällt, eine Netzwerkverbindung langsam ist oder ein Update unvollständig ausgerollt wird.

Ab diesem Punkt ändern sich die harten Fragen. Du hörst auf zu fragen „Läuft es auf meinem Rechner?“ und beginnst stattdessen zu fragen:

- Was passiert, wenn ein Teil mitten in einer Anfrage ausfällt?\n- Wie findet man den richtigen Dienst oder die richtige Ressource, wenn Namen und Orte sich ändern?\n- Wie hält man die Performance hoch, ohne veraltete oder falsche Daten auszuliefern?

Was du aus diesem Artikel mitnimmst

Dies ist keine Nostalgie- oder Trivia-Tour. Lampsons Arbeit ist nützlich, weil sie Designideen hervorgebracht hat, die Bestand haben: klare Schnittstellen, einfache Bausteine und Systeme, die mit Ausfall rechnen.

Wir konzentrieren uns auf Konzepte, die in moderne Betriebssysteme und verteiltes Rechnen weitergetragen wurden — Netzwerke, RPC, Namensgebung, Caching und praktische Sicherheit — damit du diese Muster in heutigen Architekturen erkennst und auf deine eigenen Dienste anwenden kannst.

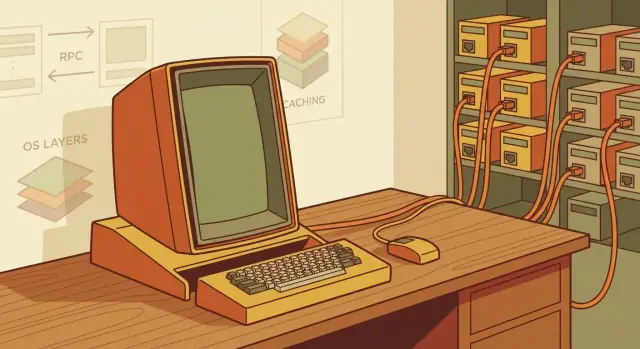

Xerox PARC in einem Bild: Ein vernetzter Arbeitsplatz

Stell dir ein Büro vor, in dem jede Person einen leistungsfähigen Personalcomputer auf dem Tisch hat, verbunden mit gemeinsamen Diensten, die das ganze Arbeitsumfeld wie ein kohärentes System wirken lassen. Das war PARCs Wette: nicht nur „ein Computer“, sondern eine vernetzte Umgebung, in der Rechnen, Dokumente und Kommunikation mühelos zwischen Menschen und Maschinen fließen.

Was PARC bauen wollte

PARC wollte Personalcomputing für die tägliche Arbeit praktisch machen — Schreiben, Gestalten, Dateien teilen, Entwürfe drucken und Zusammenarbeiten — ohne einen Mainframe-Bediener oder spezielle Rituale. Das Ziel war kein einzelnes Durchbruchgerät; es war ein funktionierendes Setup, in dem man den ganzen Tag leben konnte.

Die zentralen Zutaten (und warum sie wichtig waren)

Der Alto war der „persönliche“ Teil: ein Computer für interaktive Arbeit. Ethernet war der „Arbeitsplatz“-Teil: ein schnelles lokales Netzwerk, das Altos miteinander und mit geteilten Ressourcen sprechen ließ.

Diese geteilten Ressourcen waren essentiell, nicht optional:\n

- Geteilte Drucker machten hochwertige Ausgabe zu einem normalen Schritt im Workflow.\n- Dateiserver verwandelten Speicherung und Teilen in einen Dienst, nicht in einen Haufen Platten unter dem Schreibtisch.

Diese Kombination veränderte das Denkmodell: Dein Computer ist allein leistungsfähig, aber er wird dramatisch nützlicher, wenn er zuverlässig Netzwerkdienste nutzen kann.

Ein zentrales Thema: Baue das Ganze und beobachte dann die reale Nutzung

PARC blieb nicht bei Prototypen oder isolierten Demos stehen. Sie stellten komplette Systeme zusammen — Hardware, Betriebssysteme, Netzwerk und Anwendungen — und lernten aus dem tatsächlichen Arbeitsverhalten der Menschen.

Diese Feedback-Schleife offenbarte die harten Probleme, die nur in der Praxis auftreten: Dinge benennen, Überlast behandeln, mit Ausfällen umgehen, Performance vorhersehbar halten und geteilte Ressourcen „nah“ statt „fern“ erscheinen lassen.

Der „PARC-Stil“

Viele PARC-Systeme zeigen einen wiedererkennbaren Ansatz: einfache Primitive mit starker Ingenieursdisziplin. Halte Schnittstellen klein und verständlich, baue Dienste, die sauber komponieren, und teste Ideen in realen Deployments. Dieser Stil ist ein großer Grund, warum die Lehren noch heute auf moderne Teams übertragbar sind, die Systeme im großen Maßstab bauen.

Der Alto und die Client/Server-Mentalität

Der Xerox Alto war nicht nur „ein Computer auf dem Schreibtisch“. Er markierte einen Wendepunkt, weil er drei Ideen in einer alltäglichen Erfahrung bündelte: eine persönliche Maschine, eine hochwertige grafische Oberfläche und ein schnelles lokales Netzwerk, das dich mit geteilten Ressourcen verband.

Diese Kombination veränderte Erwartungen. Dein Computer fühlte sich dir zugehörig an — reaktionsschnell, interaktiv und immer verfügbar — und gleichzeitig wie eine Tür in ein größeres System: Dateiserver, Drucker und Kollaborationstools. Das ist der Keim der Client/Server-Mentalität.

Ein Personalcomputer, der ein Netzwerk voraussetzt

Vor Alto-ähnlichen Systemen bedeutete Rechnen oft, zum Rechner zu gehen (oder ein Terminal zu benutzen). Der Alto drehte das um: Der „Client“ lebt mit dem Nutzer, und das Netzwerk macht leistungsfähige geteilte Fähigkeiten nahe.

In der Praxis war „Client/Server“ kein Diagramm — es war ein Workflow. Manche Arbeit geschah lokal, weil sie sofortiges Feedback brauchte: Textbearbeitung, Zeichnen, Interaktion mit Fenstern. Andere Arbeit geschah remote, weil sie natürlicherweise geteilt war oder zu teuer war, um sie auf jedem Schreibtisch zu duplizieren: autoritative Dokumente speichern, Drucker verwalten, Zugriff koordinieren und später geteilte Dienste betreiben.

Dieselbe Aufteilung, die wir heute leben

Wenn du „Alto“ durch „Laptop“ und „Datei-/Druckserver“ durch „Cloud-Dienste“ ersetzt, ist das mentale Modell vertraut. Dein Gerät bleibt der Client: es rendert die UI, cached Daten und handhabt kurz-latenz Interaktionen. Die Cloud bleibt die Serverseite: sie liefert geteilten Zustand, Zusammenarbeit, zentrale Richtlinien und elastische Rechnerkapazität.

Die Lehre ist, dass gute Systeme diese Aufteilung annehmen statt gegen sie anzukämpfen. Nutzer wollen lokale Reaktionsfähigkeit und Offline-Toleranz, während Organisationen geteilte Wahrheit und koordinierte Zugriffe wollen.

Druck auf OS-Design: schnell lokal, kohärent global

Diese Aufteilung erzeugt ständige Spannungen für Betriebssystem- und Systemdesigner:\n

- Lokale Reaktionsfähigkeit: die UI darf nicht aufs Netzwerk warten.\n- Netzwerkweite Konsistenz: geteilte Dateien, Identitäten und Berechtigungen müssen sich vorhersagbar verhalten, auch wenn mehrere Clients gleichzeitig agieren.

Die Arbeit aus der PARC-Ära machte diese Spannung früh sichtbar. Sobald du das Netzwerk als Teil des Computers annimmst, musst du Schnittstellen, Caching und Fehlverhalten so gestalten, dass „lokal“ und „remote“ sich wie ein System anfühlen — ohne so zu tun, als seien sie dasselbe.

Ethernet: Der verborgene Ermöglicher verteilten Rechnens

Ethernet ist leicht zu übersehen, weil es sich wie „nur Netzwerk“ anfühlt. Bei Xerox PARC war es der praktische Durchbruch, der ein Zimmer voller Personalmaschinen wie ein geteiltes System wirken ließ.

Warum Ethernet bei PARC wichtig war

Vor Ethernet bedeutete Verbinden oft teure, spezialisierte Leitungen. Ethernet veränderte die Ökonomie: ein vergleichsweise günstiges, geteiltes Medium, an das viele Maschinen gleichzeitig angeschlossen werden konnten.

Das verschob die Annahme von „ein großer Computer“ hin zu „viele kleinere Computer kooperieren“, weil Zusammenarbeit keine heroische Infrastruktur mehr erforderte.

Ebenso wichtig: das geteilte Medium förderte ein neues Systemdesign: Dienste konnten auf verschiedenen Maschinen leben, Drucker und Dateiserver wurden netzgebunden, und Teams konnten schnell iterieren, weil Konnektivität nicht selten war.

Die moderne Übersetzung: das Netzwerk ist eine Kernabhängigkeit

Heute behandeln wir das Netzwerk wie ein Betriebssystem Arbeitsspeicher oder Speicher: es ist kein Add-on, es ist Teil der Plattform. Das lokale Verhalten deiner App hängt oft von Remote-Aufrufen, Remote-Daten, remote Identität und Remote-Konfiguration ab.

Sobald du das akzeptierst, hörst du auf so zu entwerfen, als würde das Netzwerk höflich aus dem Weg bleiben.

Erstes Ergebnis: Staus und Ausfälle sind normal

Ein geteiltes Netzwerk bedeutet Konkurrenz. Pakete werden verzögert, verworfen oder umsortiert. Peers starten neu. Switches werden überlastet. Selbst wenn nichts „kaputt“ ist, kann das System kaputt wirken.

Die richtige Haltung ist, für normalen Betrieb unter unvollkommenen Bedingungen zu bauen:\n

- Früh instrumentieren: Logs, einfache Metriken und Request-Tracing, damit du siehst, wo Zeit verloren geht.\n- Verwende Timeouts standardmäßig, nicht als Last-Minute-Flickwerk.\n- Gestalte Retries sorgfältig (mit Backoff und Limits), damit die Wiederherstellung die Staus nicht verstärkt.

Ethernet machte verteiltes Rechnen praktikabel; es zwang auch die Disziplin, die verteiltes Rechnen verlangt.

Dienste statt Monolithen: frühe Bausteine verteilter Systeme

Bei Xerox PARC war ein „Dienst“ einfach ein Programm, das im Netzwerk eine Aufgabe für andere erledigte.

Ein Dateidienst speicherte und lieferte Dokumente. Ein Druckdienst nahm ein Dokument an und erzeugte Papierausgabe. Ein Verzeichnis- oder Namensdienst half dir, den richtigen Dateiserver, Drucker oder die richtige Person zu finden, ohne Maschinen-Details auswendig zu lernen. Jeder Dienst hatte einen klaren Zweck, eine definierte Schnittstelle und Nutzer (Menschen oder andere Programme), die darauf angewiesen waren.

Warum Aufteilung in Dienste half

Ein großes System in kleinere Dienste zu zerlegen machte Änderungen sicherer und schneller. Wenn das Drucksystem neue Features brauchte, konnte es sich entwickeln, ohne die Dateispeicherung neu zu entwerfen. Grenzen klärten auch Verantwortlichkeiten: „hier leben die Dateien“ vs. „hier passiert Drucken“.

Ebenso förderten Dienste die Gewohnheit, zuerst Schnittstellen zu entwerfen. Wenn dein Programm mit einer anderen Maschine sprechen muss, bist du gezwungen, Eingaben, Ausgaben und Fehler zu spezifizieren — Details, die in einem Monolithen oft vage bleiben.

Die Abwägung: mehr Aufrufe, mehr Fehlerquellen

Mehr Dienste bedeuten mehr Netzwerkaufrufe. Das kann Latenz erhöhen, Last steigern und neue Fehlermodi erzeugen: der Dateidienst ist erreichbar, der Druckdienst aber nicht, oder der Verzeichnisdienst ist langsam.

Ein Monolith fällt „auf einmal“ aus; verteilte Dienste fallen partiell und verwirrend aus. Die Lösung ist nicht, Dienste zu vermeiden — sondern explizit für partielle Fehler zu entwerfen.

Ein moderner Vergleich (ohne Hype)

Viele Cloud-Apps laufen heute als interne Dienste: Nutzerkonten, Billing, Suche, Benachrichtigungen. Die PARC-Lehre gilt weiterhin: teile zur Klarheit und unabhängigen Weiterentwicklung — plane aber Netzlatenz und partielle Ausfälle von Anfang an mit.

Zur praktischen Anleitung koppeln Teams häufig Service-Grenzen mit grundlegenden Timeouts, Retries und klaren Fehlermeldungen (siehe /blog/failure-is-normal).

Remote Procedure Call (RPC): Das Netzwerk lokal erscheinen lassen

Skalierungsmuster praktisch testen

Starte ein internes Tool, um Naming, Caching und Timeouts in echten Abläufen zu üben.

Remote Procedure Call (RPC) ist eine einfache Idee mit großer Wirkung: eine Funktion auf einer anderen Maschine aufrufen, als wäre es ein lokaler Funktionsaufruf. Anstatt eine Anfrage manuell zu verpacken, übers Netzwerk zu senden und die Antwort zu entpacken, lässt RPC ein Programm sagen „führe getUser(42) aus“ und das System kümmert sich um das Nachrichtensenden.

Dieses ‚sich lokal anfühlen‘-Ziel war zentral für PARCs verteilte Arbeiten — und es ist immer noch, was Teams wollen: klare Schnittstellen, vorhersehbares Verhalten und weniger bewegliche Teile im Anwendungscode.

Was gutes RPC braucht (damit es dich nicht belügt)

Die Gefahr ist, dass RPC zu sehr wie ein normaler Funktionsaufruf aussieht. Ein lokaler Aufruf läuft entweder oder bringt deinen Prozess zum Absturz; ein Netzwerkaufruf kann langsam sein, verschwinden, teilweise ausgeführt werden oder erfolgreich sein, ohne dass du etwas davon erfährst. Gutes RPC-Design beachtet diese Realitäten:\n

- Namensgebung / Service-Discovery: der Aufrufer muss zuverlässig finden, welche Maschine oder Instanz den Aufruf bearbeiten soll. Ohne Namensauflösung ist RPC nur „sende ein Paket und hoffe“.\n- Versionierung: Clients und Server entwickeln sich. Eine RPC-Schnittstelle braucht Wege, Felder oder Methoden hinzuzufügen, ohne alte Clients zu brechen (und eine Ablöse-Policy).\n- Timeouts: endloses Warten ist selten korrekt. Ein Timeout macht „unbekannt“ zu einem handhabbaren Ergebnis.\n- Fehlerbehandlung: RPC braucht ein klares Fehlermodell (Transportfehler, Serverfehler, Autorisierungsfehler), damit Aufrufer entscheiden können, was zu wiederholen, was dem Nutzer zu zeigen und was zu alarmieren ist.

Idempotenz: sichere Retries ohne unbeabsichtigte Seiteneffekte

Timeouts und verlorene Antworten machen Retries unvermeidlich. Deshalb ist Idempotenz wichtig: eine Operation ist idempotent, wenn sie einmal oder mehrfach ausgeführt denselben Effekt hat.

Ein einfaches Beispiel: chargeCreditCard(orderId, amount) ist standardmäßig nicht idempotent — ein Retry nach Timeout könnte doppelt belasten. Ein sichereres Design ist chargeCreditCard(orderId), wobei orderId die Belastung eindeutig identifiziert und der Server Wiederholungen als „bereits erledigt“ behandelt. Der Retry wird damit sicher, weil der Server dedupliziert.

Wie das mit heutigen APIs zusammenhängt (gRPC/REST und Co.)

Moderne APIs sind direkte Nachfahren der RPC-Mentalität. gRPC macht das Modell „rufe eine entfernte Methode auf“ explizit mit definierten Schnittstellen und typisierten Nachrichten. REST wirkt oft ressourcenorientierter statt methodenorientiert, aber das Ziel ist ähnlich: standardisieren, wie Dienste sprechen, Verträge definieren und Fehler handhaben.

Welchen Stil du auch wählst: Die PARC-Lehre bleibt: das Netzwerk ist ein Werkzeug, kein Detail zum Ignorieren. Gutes RPC macht Verteilung bequem — ohne so zu tun, als sei sie umsonst.

Namensgebung und Verzeichnisse: Dinge zuverlässig finden

Ein verteiltes System fühlt sich nur dann ‚verteilbar‘ an, wenn es ausfällt. Viele Tage fühlt es sich kaputt an, weil etwas nicht gefunden werden kann.

Namensgebung ist schwierig, weil die reale Welt nicht stillhält: Maschinen werden ersetzt, Dienste wandern zu neuen Hosts, Netzwerke werden umnummeriert, und Menschen erwarten weiterhin stabile, merkbare Pfade wie „der Dateiserver“ oder „Druck auf LaserWriter“. Wenn der Name, den du eingibst, auch die Location ist, wird jede Änderung zu einer benutzer sichtbaren Störung.

Namen vs. Orte

Eine zentrale Idee aus der PARC-Ära ist, was du willst von wo es gerade lebt zu trennen. Ein Name sollte stabil und bedeutungsvoll sein; ein Ort ist ein Implementierungsdetail, das sich ändern kann.

Wenn beides verschmolzen ist, entstehen fragile Systeme: Shortcuts, hardcodierte IPs und Konfigurationsdrift.

Verzeichnisse als Klebstoff

Verzeichnisdienste beantworten die Frage „wo ist X gerade?“ indem sie Namen auf Orte (und oft Metadaten wie Typ, Besitzer oder Zugriffsregeln) abbilden. Die besten Verzeichnisse speichern nicht nur Lookups — sie kodieren, wie eine Organisation arbeitet.

Gutes Namens- und Verzeichnisdesign teilt praktische Eigenschaften:\n

- Stabilität: Namen überdauern Hardware-Erneuerungen und Migrationen.\n- Delegation: Teams verwalten eigene Subbäume ohne zentrale Engpässe.\n- Caching: Clients behalten Antworten, um ständige Roundtrips zu vermeiden.\n- Updates und Freshness: Änderungen propagieren sicher, mit klaren Regeln, wie lange Caches alten Antworten trauen dürfen.

Der moderne Echo: DNS und Service-Discovery

DNS ist das klassische Beispiel: ein menschenfreundlicher Name mappt auf eine sich verändernde Menge von IPs, mit Caching gesteuert durch TTLs.

Innerhalb von Unternehmen wiederholen Service-Discovery-Systeme dasselbe Muster: stabile Servicenamen, wechselnde Instanzen und ein stetes Spannungsfeld zwischen Cache-Performance und Update-Geschwindigkeit.

Die Lehre ist einfach: Wenn du Systeme willst, die skalieren — und verständlich bleiben — behandle Namensgebung als erstklassiges Designproblem, nicht als Nachgedanken.

Fehlerbehandlung fest integrieren

Baue einen kleinen Service und übe Idempotenz und Retries Ende‑zu‑Ende.

Caching ist eine einfache Idee: halte eine nahe Kopie von etwas, das du bereits geholt hast, damit die nächste Anfrage schneller ist. Statt jedes Mal das Netzwerk zu überqueren (oder eine langsame Platte oder einen überlasteten Server zu treffen), verwendest du die lokale Kopie.

Bei Xerox PARC war das wichtig, weil vernetzte Workstations und geteilte Dienste das ständige ‚frag den Server nochmal‘ teuer machten. Caching ließ entfernte Ressourcen schnell erscheinen — meistens.

Die Kernspannung: Geschwindigkeit vs. Aktualität

Der Haken ist Aktualität. Ein Cache kann falsch werden.

Stell dir ein geteiltes Dokument auf einem Server vor. Dein Arbeitsplatz cached die Datei, um sie sofort zu öffnen. Ein Kollege editiert dieselbe Datei und speichert eine neue Version. Wenn dein Cache das nicht mitbekommt, siehst du möglicherweise weiter den alten Inhalt — oder noch schlimmer: du bearbeitest eine veraltete Kopie und überschreibst neuere Arbeit.

Jedes Caching-Design ist also ein Tradeoff zwischen:\n

- Performance: weniger Netzwerktrips, schnellere Antworten\n- Konsistenz: Vermeidung veralteter Daten und überraschendem Verhalten

Gängige Techniken (auf hohem Niveau)

Teams steuern diesen Tradeoff typischerweise mit einigen Werkzeugen:\n

- TTLs (Time-to-Live): gecachte Daten verfallen nach einer Zeit und erzwingen ein Update.\n- Invalidierungen: wenn sich Daten ändern, versucht das System, Caches zu benachrichtigen, damit sie Einträge löschen oder aktualisieren.\n- Leases: ein Cache darf Daten für eine kurze gewährte Periode als „gültig“ halten; danach muss er erneuern.

Wie sich das heute zeigt

Moderne Systeme nutzen dieselben Muster überall: CDNs cachen Webinhalte nahe bei den Nutzern, Browser und Mobile-Apps cachen Assets und API-Antworten, und Datenbank-Caching-Schichten (wie Redis oder Memcached) reduzieren die Last auf Primärspeichern.

Die Lektion bleibt: Caching ist oft der billigste Performance-Gewinn — aber nur, wenn du explizit festlegst, was „frisch genug“ für dein Produkt bedeutet.

Sicherheit und Capabilities: praktische Zugriffskontrolle

Sicherheit in großem Maßstab fragt nicht nur „wer bist du?“ — sondern auch „was darfst du gerade mit dieser spezifischen Ressource tun?“ Lampson und die Xerox PARC-Tradition förderten dafür eine sehr praktische Idee: Capabilities.

Capabilities in einfachen Worten

Eine Capability ist ein unfälschbares Token, das Zugang zu etwas gewährt — etwa einer Datei, einem Drucker, einem Postfach oder einer Service-Operation. Wenn du das Token hast, kannst du die erlaubte Aktion ausführen; wenn nicht, kannst du es nicht.

Das Entscheidende ist unfälschbar: das System macht es rechnerisch oder strukturell unmöglich, ein gültiges Token durch Raten zu erzeugen.

Denk an eine Hotelschlüsselkarte, die nur deine Tür (und nur während deines Aufenthalts) öffnet, nicht an eine handgeschriebene Notiz mit „Ich darf rein“.

Wie sich das von Identity+ACL-Prüfungen unterscheidet

Viele Systeme setzen auf identitätsbasierte Sicherheit: du authentifizierst dich als Nutzer, und jeder Zugriff wird gegen eine ACL (Access Control List) geprüft — eine Liste auf der Ressource, die sagt, welche Nutzer/Gruppen was dürfen.

ACLs sind intuitiv, aber in verteilten Systemen können sie umständlich werden:\n

- Jeder Dienst muss deine Identität zuverlässig kennen.\n- Jede Ressource muss Berechtigungsliste(n) speichern und pflegen.\n- Delegation von Zugriff („lass diesen Job eine Datei 10 Minuten lesen“) führt oft zu Speziallogik.

Capabilities kehren die Default-Annäherung um. Statt ständig eine zentrale Autorität zu fragen, legst du ein Token vor, das das Recht bereits kodiert.

Warum verteilte Systeme das interessieren sollte

Verteilte Systeme geben Arbeit ständig über Maschinen weiter: ein Frontend ruft ein Backend; ein Scheduler übergibt einen Task an einen Worker; ein Service triggert einen anderen Service. Jeder Hop braucht eine sichere Möglichkeit, genau genug Berechtigung mitzuschleppen.

Capabilities machen das natürlich: du kannst ein Token zusammen mit einer Anfrage übergeben, und die Empfangsmaschine validiert es, ohne das Trust-Rad jedes Mal neu zu erfinden.

Richtig gemacht reduziert das versehentliche Über-Berechtigen und begrenzt die Blast-Radius, wenn etwas schiefgeht.

Moderne Analoga, die du wahrscheinlich kennst

Capabilities tauchen heute auf als:\n

- Signierte Tokens (z. B. JWTs), die Ansprüche in einer Anfrage beweisen.\n- Gescopte Credentials (OAuth-Access-Tokens, Cloud-Session-Tokens), die verfallen und Aktionen einschränken.\n- Least-Privilege Service-Identitäten (Workload Identity, Service Accounts), bei denen Credentials eng gefasst sind.

Die Lektion ist: Entwerfe Zugriff um Delegation, Umfang und Ablauf, nicht nur um langlebige Identitäten. Das ist Capability-Denken, aktualisiert für moderne Infrastruktur.

Ausfall ist normal: für partielle Ausfälle entwerfen

Verteilte Systeme „brechen“ nicht auf eine saubere Weise. Sie scheitern chaotisch und partiell: eine Maschine stürzt mitten in einer Aufgabe ab, ein Switch bootet neu, eine Netzwerkverbindung verwirft Pakete, oder ein Stromereignis nimmt ein Rack aber nicht das andere offline.

Aus Nutzersicht ist der Dienst ‚up‘, aber ein Teil davon ist unerreichbar.

Fang mit einem expliziten Fehlermodell an

Ein praktisches Fehlermodell ist klar:\n

- Prozesse können abstürzen und flüchtigen Zustand verlieren.\n- Maschinen können ohne Vorwarnung neu starten.\n- Netzwerke können splitten (zwei Gruppen können nicht miteinander sprechen), langsamer werden oder Nachrichten umordnen/ verzögern.\n- Zeit ist unsicher: eine Anfrage kann langsam sein, aber nicht verloren.

Wenn du das akzeptierst, behandelst du Fehler nicht als „Randfälle“, sondern als normalen Steuerfluss.

Die klassischen Antworten: Timeouts, Retries, Backoff, Failover

Die meisten Systeme verlassen sich auf eine kleine Menge an Mitteln.

Timeouts verhindern, dass Aufrufer ewig warten. Entscheidend ist, Timeouts auf Basis realer Latenzdaten zu wählen, nicht nach Schätzwerten.

Retries können von transienten Fehlern erholen, aber sie können auch die Last während eines Ausfalls vervielfachen. Deshalb sind exponentielles Backoff (längere Wartezeit bei weiteren Retries) und Jitter (Zufall) wichtig: sie verhindern synchrone Retry-Stürme.

Failover (Wechseln zu einer Standby-Instanz oder Replik) hilft, wenn eine Komponente wirklich down ist, aber es funktioniert nur, wenn der Rest des Systems Ausfälle sicher und schnell erkennen kann.

„Mindestens-einmal“ vs. „genau-einmal“, in einfachen Worten

Wenn du eine Anfrage wiederholst, kann sie mehrfach ausgeführt werden. Das ist mindestens-einmal-Lieferung: das System versucht stark, Arbeit nicht zu verlieren, aber Duplikate können passieren.

Genau-einmal bedeutet, die Aktion passiert genau einmal, keine Duplikate. Das ist über ein Netzsegment schwer zu garantieren.

Viele Teams entwerfen stattdessen Operationen so, dass sie idempotent sind (wiederholbar ohne Seiteneffekte), sodass mindestens-einmal akzeptabel wird.

Messen und Ausfall testen — nicht wegdenken

Die zuverlässigsten Teams führen aktiv Fehler in Staging (und manchmal in Produktion) ein und beobachten, was passiert: killen Instanzen, blockieren Netzwerkpfade, verlangsamen Abhängigkeiten und prüfen Alarme, Retries und Nutzer-Auswirkungen.

Behandle Ausfälle als Experimente zur Verbesserung deines Designs, nicht als Überraschungen, die „nicht passieren sollten“.

Moderne OS-Design-Lektionen: Schnittstellen, Isolation und Einfachheit

RPC-Schnittstellen explizit definieren

Entwirf typisierte APIs und iteriere über Versionierung und Fehlerbehandlung beim Entwickeln.

Betriebssysteme altern wie Hundejahre: jede neue Funktion vermehrt die Art, wie Dinge interagieren, und dort verstecken sich Fehler.

Lampsons Denkschule — geformt bei Xerox PARC — behandelt OS-Struktur als Skalierungsstrategie. Wenn der Kern unordentlich ist, erbt alles Obenstehende diese Unordnung.

Kleine Primitive, große Systeme

Eine wiederkehrende PARC-Lektion ist, den Kernel (oder die „vertrauenswürdige Basis“) schmal und aus einfachen, komponierbaren Primitiven zu machen. Statt Dutzende Spezialfälle einzubauen, definiere wenige Mechanismen, die leicht zu erklären und schwer falsch zu verwenden sind.

Klare Schnittstellen sind ebenso wichtig wie die Mechanismen selbst. Wenn Grenzen explizit sind — was eine Komponente verspricht, was sie annehmen kann — kannst du Implementationen austauschen, Teile isoliert testen und versehentliche Kopplungen vermeiden.

Isolation ist ein Feature, kein Add-on

Isolation begrenzt die Blast-Radius. Ob Speicherprotektion, Prozessseparation oder least-privilege Zugriff auf Ressourcen — Isolation verwandelt „ein Bug bricht alles“ in „ein Bug ist enthalten“.

Dieses Denken führt auch zu capability-ähnlichen Designs: gib Code nur die Autorität, die er braucht, und mache Zugriff explizit statt impliziert.

Pragmatismus zeigt sich auch in der Performance: baue schnelle Wege für die üblichen Operationen und vermeide Overhead, der dir keine Sicherheit oder Klarheit bringt.

Das Ziel ist nicht, alles zu mikro-optimieren — sondern den normalen Fall sofortig wirken zu lassen bei gleichzeitiger Bewahrung der Korrektheit.

Du siehst dieselben Ideen in heutigen Kerneln, Sprach-Runtimes und containerisierten Plattformen: eine kleine vertrauenswürdige Basis, wohldefinierte APIs und Isolation-Grenzen (Prozesse, Sandboxes, Namespaces), die Teams schnelles Ausliefern erlauben, ohne Fehler-Modi zu teilen.

Die Details haben sich geändert; die Design-Gewohnheiten zahlen sich weiterhin aus.

Was du heute anwenden kannst: Eine praktische Checkliste für Teams

PARCs großer Gewinn war nicht eine einzelne Erfindung — es war eine kohärente Art, vernetzte Systeme zu bauen, die Menschen tatsächlich benutzen konnten. Die Namen änderten sich, aber die Kernprobleme (Latenz, Ausfälle, Vertrauen, Ownership) blieben.

Die Klassiker in moderne Bausteine übersetzen

Eine kurze „mentale Übersetzungshilfe“, wenn du Designs prüfst:\n

- RPC → APIs (REST/gRPC/GraphQL): verberge die Leitung, aber halte Timeouts, Retries und Idempotenz explizit.\n- Namensgebung & Verzeichnisse → DNS + Service-Discovery: „Wo ist es?“ ist eine erstklassige Sorge.\n- Caching → CDNs + lokale Caches + Edge-Storage: Geschwindigkeit ist einfach; Korrektheit ist schwer.\n- Capabilities → Tokens/Keys/Scopes (OAuth-Scopes, Macaroons, signierte URLs): erteile spezifische Rechte, nicht pauschalen Zugriff.\n- Dienste statt Monolithen → modulare Systeme mit klaren Verträgen: Trennung nützt nur, wenn Ownership und Schnittstellen scharf sind.

Praktische Architektur-Checkliste

Nimm das, wenn du ein System im großen Maßstab bewertest:\n

- Was sind die Service-Grenzen und wer ist Owner? Ohne zuständiges Team verfällt ein Bestandteil.\n2. Wie finden Clients den Dienst? Definiere Discovery, Versionierung und Rollout-Strategie früh.\n3. Was ist der Ausfallplan? Entscheide: Timeouts, Retries, Circuit-Breaker und wie „degradierten Modus“ aussieht.\n4. Wo liegt Zustand und wie ist er geschützt? Identifiziere autoritative Quellen, Replikationsregeln und Backup/Restore.\n5. Wo cachen wir und was darf veraltet sein? Schreib Konsistenz-Erwartungen in Klartext.\n6. Wie ist das Berechtigungsmodell? Bevorzuge Least-Privilege-Tokens und kurzlebige Credentials.\n7. Wie beobachten wir es? Logs, Metriken, Traces und klare SLOs, verknüpft mit Nutzererlebnis.

Kurz zur schnelleren Entwicklung, ohne die Grundlagen zu überspringen

Eine moderne Änderung ist, wie schnell Teams verteilte Architekturen prototypisieren können. Tools wie Koder.ai (eine Vibe-Coding-Plattform, die Web-, Backend- und Mobile-Apps aus Chat erzeugt) können die Phase „erstes funktionierendes System“ beschleunigen — React im Frontend, Go + PostgreSQL im Backend und Flutter für Mobile — während du Quellcode exportieren und wie in einem ernsthaften Produktions-Repo weiterentwickeln kannst.

Die Lampson-Ära-Lektion gilt trotzdem: Geschwindigkeit ist nur ein Gewinn, wenn Schnittstellen klar bleiben, Fehlverhalten explizit gehandhabt wird (Timeouts, Retries, Idempotenz) und Namensgebung, Caching und Berechtigungen als erstklassige Design-Entscheidungen behandelt werden.

Was zu kopieren, anzupassen und zu vermeiden ist

Kopiere die Disziplin: einfache Schnittstellen, explizite Verträge und Entwurf für partielle Ausfälle. Passe die Mechanismen an: heute verwendest du gemanagte Discovery, API-Gateways und Cloud-IAM — nicht eigene Verzeichnisse und handgestrickte Auth.

Vermeide Überzentralisierung (ein „God Service“, von dem alle abhängen) und unklare Ownership (geteilte Komponenten ohne Verantwortlichen).

Die Tools ändern sich ständig — neue Runtimes, Clouds, Protokolle — aber die Zwänge bleiben: Netzwerke fallen aus, Latenz existiert, und Systeme skalieren nur, wenn Menschen sie betreiben können.