Jedes Mal, wenn Sie eine Nachricht senden, ein Video ansehen oder sich mit Wi‑Fi verbinden, nutzen Sie Ideen von Claude Shannon. Nicht weil Ihr Telefon ‚Shannon kennt‘, sondern weil moderne digitale Systeme um das einfache Versprechen gebaut sind: wir können unordentliche Echtwelt‑Nachrichten in Bits verwandeln, diese Bits durch unvollkommene Kanäle schicken und trotzdem den Originalinhalt mit hoher Zuverlässigkeit wiederherstellen.

Informationstheorie ist die Mathematik der Nachrichten: wie viel Auswahl (Ungewissheit) eine Nachricht enthält, wie effizient sie dargestellt werden kann und wie zuverlässig sie übertragen werden kann, wenn Rauschen, Interferenzen und Stau dazwischenfunken.

Dahinter steckt Mathematik, aber man braucht keine Statistik‑Professur, um die praktische Intuition zu verstehen. Wir verwenden Alltagsbeispiele — etwa warum sich manche Fotos besser komprimieren lassen als andere, oder warum Ihr Anruf noch gut klingt, obwohl das Signal schwach ist — und erklären die Ideen ohne schwere Formeln.

Die vier Säulen, die Sie überall wiederfinden

Dieser Beitrag dreht sich um vier Shannon‑inspirierte Säulen, die in moderner Technik immer wieder auftauchen:

- Kompression: Daten (Audio, Video, Dateien) so zu verkleinern, dass das Wesentliche erhalten bleibt.\n- Fehlerkorrektur: genau die richtige Menge zusätzlicher Bits hinzuzufügen, damit Fehler erkannt und behoben werden können.\n- Netzwerk‑Zuverlässigkeit: mit Paketverlusten über Retries, Reihenfolge und Durchsatz‑Abwägungen umgehen.\n- End‑to‑end‑digitale Kommunikation: die gesamte Kette vom Sender (Ihre Nachricht) über den Kanal (Wi‑Fi, Mobilfunk, Glasfaser) bis zum Empfänger betrachten.

Was Sie danach vernünftig einschätzen können

Am Ende sollten Sie über echte Trade‑offs nachdenken können: warum höhere Videoqualität mehr Bandbreite braucht, warum „mehr Balken“ nicht automatisch schnelleres Internet heißt, warum manche Apps sofort wirken, andere aber puffern, und warum jedes System an Grenzen stößt — insbesondere an die berühmte Shannon‑Grenze für die zuverlässige Übertragungsrate eines Kanals.

Claude Shannon in einer Seite: Die große Idee

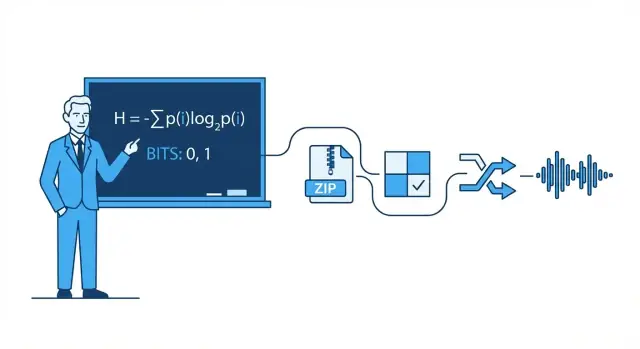

1948 veröffentlichte der Mathematiker und Ingenieur Claude Shannon eine Arbeit mit dem unscheinbaren Titel A Mathematical Theory of Communication, die stillschweigend unsere Sicht auf Datenübertragung veränderte. Anstatt Kommunikation als Kunst zu sehen, betrachtete er sie als Ingenieursproblem: eine Quelle erzeugt Nachrichten, ein Kanal überträgt sie, Rauschen verfälscht sie, und ein Empfänger versucht, das Gesendete zu rekonstruieren.

Shannons Schlüsselidee war, Information so zu definieren, dass sie messbar und für Maschinen nützlich ist. In seinem Rahmen geht es nicht darum, wie wichtig eine Nachricht erscheint, was sie bedeutet oder ob sie wahr ist. Es geht darum, wie überraschend eine Nachricht ist — wie viel Ungewissheit verschwindet, wenn man das Ergebnis kennt.

Wenn Sie bereits wissen, was passieren wird, trägt die Nachricht kaum Information. Wenn Sie wirklich unsicher sind, liefert das Ergebnis mehr.

Das Bit: die einfachste zählbare Einheit

Um Information zu messen, popularisierte Shannon das Bit (binary digit). Ein Bit ist die Informationsmenge, die nötig ist, um eine einfache Ja/Nein‑Ungewissheit aufzulösen.

Beispiel: Wenn ich frage „Leuchtet das Licht?“ und Sie vorher keinerlei Ahnung haben, kann die Antwort (ja oder nein) als 1 Bit Information angesehen werden. Viele reale Nachrichten lassen sich in lange Folgen solcher binären Entscheidungen zerlegen, weshalb alles von Text über Fotos bis zu Audio als Bits gespeichert und übertragen werden kann.

Was dieser Beitrag tut (und was nicht)

Dieser Artikel konzentriert sich auf die praktische Intuition hinter Shannons Ideen und darauf, warum sie überall auftauchen: Kompression (Dateien kleiner machen), Fehlerkorrektur (Korruption reparieren), Netzwerk‑Zuverlässigkeit (Neusendungen und Durchsatz) und Kanalkapazität (wie schnell man über verrauschte Leitungen senden kann).

Was er nicht tut, ist schwere Beweise durchzugehen. Sie brauchen keine fortgeschrittene Mathematik, um die Quintessenz zu begreifen: sobald Sie Information messen können, lassen sich Systeme entwerfen, die die theoretisch mögliche Effizienz erreichen — oft überraschend nahe an Shannons Grenzen.

Bits, Symbole und Codes: Ein praktischer Wortschatz

Bevor wir über Entropie, Kompression oder Fehlerkorrektur sprechen, hilft es, ein paar Alltagsbegriffe festzulegen. Shannons Ideen werden leichter, wenn Sie die Teile benennen können.

Symbole, Alphabet und Nachrichten

Ein Symbol ist ein einzelnes ‚Token‘ aus einer vereinbarten Menge. Diese Menge ist das Alphabet. Im Englischen kann das Alphabet Buchstaben (plus Leerzeichen und Interpunktion) sein. In einer Computerdatei kann das Alphabet die Byte‑Werte 0–255 sein.

Eine Nachricht ist eine Folge von Symbolen aus diesem Alphabet: ein Wort, ein Satz, eine Fotodatei oder ein Audiostream.

Um es konkret zu halten, stellen Sie sich ein kleines Alphabet vor: {A, B, C}. Eine Nachricht könnte sein:

A A B C A B A ...

Bits und Codes

Ein Bit ist eine binäre Ziffer: 0 oder 1. Computer speichern und übertragen Bits, weil Hardware zwei Zustände zuverlässig unterscheiden kann.

Ein Code ist eine Regel, Symbole mit Bits (oder anderen Symbolen) darzustellen. Für unser {A, B, C}‑Alphabet ist ein mögliches binäres Codierungsbeispiel:

- A → 0\n- B → 10\n- C → 11

Jetzt kann jede Nachricht aus A/B/C in einen Bitstrom verwandelt werden.

Kodierung vs. Kompression vs. Verschlüsselung

Diese Begriffe werden oft vermischt:\n\n- Kodierung: Übersetzen von Daten in ein Format, damit sie gespeichert/übertragen/verarbeitet werden können (z. B. Abbildung A/B/C → Bits oder Text → UTF‑8).\n- Kompression: Kodierung, die im Durchschnitt weniger Bits verwendet, indem Muster und ungleiche Häufigkeiten ausgenutzt werden.\n- Verschlüsselung: Daten mit einem Schlüssel verschleiern, damit Außenstehende sie nicht lesen können; es geht um Geheimhaltung, nicht um Größe.

Eine schnelle Wahrscheinlichkeits‑Intuition

Reale Nachrichten sind nicht zufällig: manche Symbole treten häufiger auf als andere. Angenommen, A kommt zu 70 % vor, B 20 %, C 10 %. Ein gutes Kompressionsverfahren vergibt normalerweise kürzere Bitmuster an häufige Symbole (A) und längere an seltene (C). Diese ‚Ungleichheit‘ ist das, was spätere Abschnitte mit Entropie quantifizieren werden.

Entropie: Überraschung messen (und warum sie Komprimierbarkeit vorhersagt)

Shannons berühmteste Idee ist die Entropie: eine Möglichkeit zu messen, wie viel ‚Überraschung‘ in einer Informationsquelle steckt. Nicht Überraschung als Gefühl — Überraschung als Unvorhersehbarkeit. Je unvorhersehbarer das nächste Symbol ist, desto mehr Information bringt es, wenn es ankommt.

Entropie als ‚durchschnittliche Überraschung‘

Stellen Sie sich vor, Sie beobachten Münzwürfe.

- Faire Münze (50/50): Jeder Wurf ist schwer vorherzusagen. Kopf ist genauso wahrscheinlich wie Zahl, sodass Sie regelmäßig ‚überrascht‘ sind. Diese hohe Unvorhersehbarkeit bedeutet hohe Entropie.\n- Gezinkte Münze (z. B. 95 % Kopf, 5 % Zahl): Die meisten Würfe sind Kopf. Nach ein paar Würfen erwarten Sie meist Kopf, sodass ein Kopf wenig neue Information liefert. Nur die seltene Zahl ist überraschend. Im Durchschnitt ist die Folge niedrigere Entropie.

Dieses ‚durchschnittliche Überraschung‘‑Bild passt zu Alltagsmustern: eine Textdatei mit vielen Leerzeichen und gebräuchlichen Wörtern ist leichter vorherzusagen als eine Datei mit zufälligen Zeichen.

Warum Vorhersagbarkeit Komprimierbarkeit bedeutet

Kompression funktioniert, indem häufigen Symbolen kürzere Codes und seltenen längere Codes zugewiesen werden. Wenn die Quelle vorhersagbar (niedrige Entropie) ist, kann man überwiegend kurze Codes verwenden und so Platz sparen. Ist die Quelle nahezu zufällig (hohe Entropie), bleibt wenig Raum zum Schrumpfen, weil nichts oft genug vorkommt, um ausgenutzt zu werden.

Entropie und die bestmögliche durchschnittliche Codelänge

Shannon zeigte, dass Entropie eine konzeptionelle Untergrenze setzt: sie ist die theoretische untere Schranke für die durchschnittliche Anzahl Bits pro Symbol, die Sie beim Kodieren von Daten aus dieser Quelle erreichen können.

Wichtig: Entropie ist kein Kompressionsalgorithmus. Sie sagt nicht exakt, wie man eine Datei komprimiert. Sie sagt, was theoretisch möglich ist — und ob ein praktisches Verfahren bereits nahe am Limit arbeitet.

Kompression: Entropie in kleinere Dateien verwandeln

Kompression tritt auf, wenn Sie eine Nachricht, die kürzer beschrieben werden könnte, tatsächlich kürzer machen. Shannons Einsicht war, dass Daten mit niedrigerer Entropie (mehr Vorhersagbarkeit) ‚Platz zum Schrumpfen‘ haben, während hochentropische Daten (nahezu zufällig) kaum geschrumpft werden können.

Warum Muster und ungleiche Häufigkeiten gut komprimieren

Wiederholte Muster sind offensichtlich vorteilhaft: enthält eine Datei dieselben Sequenzen immer wieder, können Sie die Sequenz einmal speichern und mehrfach referenzieren. Aber selbst ohne klare Wiederholungen helfen schiefe Symbolhäufigkeiten.

Wenn ein Text ‚e‘ viel öfter verwendet als ‚z‘ oder eine Logdatei dieselben Zeitstempel und Schlüsselwörter wiederholt, müssen Sie nicht für jedes Zeichen gleich viele Bits ausgeben. Je ungleicher die Häufigkeiten, desto vorhersagbarer die Quelle und desto besser die Komprimierbarkeit.

Variable‑Längen‑Kodierung (die Kernintuition)

Eine praktische Methode, schiefe Häufigkeiten zu nutzen, ist variable‑Längen‑Kodierung:\n\n- Häufige Symbole erhalten kurze Codes\n- Seltene Symbole erhalten lange Codes

Richtig angewendet reduziert das die durchschnittliche Bitzahl pro Symbol ohne Informationsverlust.

Gängige Familien verlustfreier Kompressoren kombinieren mehrere Ideen, aber häufig begegnen Sie:\n\n- Huffman‑Kodierung: erzeugt ein effizientes ‚kurz‑für‑häufig‘‑Codebuch\n- Arithmetische Kodierung: packt Symbole in einen Bruchbereich und kommt oft näher an die Entropiegrenze\n- LZ (Lempel–Ziv)‑Methoden: finden wiederholte Teilstrings und ersetzen sie durch Referenzen (in vielen ZIP‑Formaten verwendet)

Verlustfrei vs. verlustbehaftet (ZIP vs. JPEG/MP3)

Verlustfreie Kompression stellt das Original perfekt wieder her (z. B. ZIP, PNG). Essentiell für Software, Dokumente und alles, wo ein einzelnes falsches Bit problematisch ist.

Verlustbehaftete Kompression verwirft gezielt Informationen, die Menschen typischerweise nicht bemerken (z. B. JPEG‑Bilder, MP3/AAC‑Audio). Das Ziel verschiebt sich von ‚gleiche Bits zurück‘ zu ‚gleiche Wahrnehmung‘ und erreicht oft deutlich kleinere Dateien, indem wahrnehmbare Details entfernt werden.

Fehler passieren: Warum Redundanz nützlich ist

Komprimierbarkeit erkunden

Erstelle einen Telemetrie- oder Logging-Flow und teste, was sich wirklich gut komprimieren lässt.

Jedes digitale System beruht auf einer fragilen Annahme: eine 0 bleibt 0 und eine 1 bleibt 1. In Wirklichkeit können Bits kippen.

Woher Fehler kommen

Bei der Übertragung können elektrische Störungen, schwache Wi‑Fi‑Signale oder Funkrauschen ein Signal so beeinflussen, dass der Empfänger es falsch interpretiert. Bei der Speicherung können physikalische Effekte — Verschleiß in Flash‑Speicher, Kratzer auf optischen Medien, sogar kosmische Strahlung — den gespeicherten Zustand ändern.

Weil Fehler unausweichlich sind, fügen Ingenieurinnen und Ingenieure absichtlich Redundanz hinzu: zusätzliche Bits, die keine ‚neue‘ Information tragen, aber helfen, Schäden zu erkennen oder zu reparieren.

Einfache Redundanz, die Sie schon genutzt haben

Paritätsbit (schnelle Erkennung). Ein zusätzliches Bit sorgt dafür, dass die Anzahl der Einsen gerade (even parity) oder ungerade ist. Kipp ein einzelnes Bit, schlägt die Paritätsprüfung fehl.

- Stärke: billig und schnell.\n- Limit: kann meistens nicht sagen, welches Bit falsch ist; zwei Kippfehler können sich aufheben und trotzdem als korrekt erscheinen.

Prüfsumme (bessere Erkennung für Blöcke). Anstatt eines Bits berechnet man eine kleine Zusammenfassung eines Pakets oder einer Datei (z. B. additive Checksumme, CRC). Der Empfänger berechnet erneut und vergleicht.

- Stärke: erkennt viele Mehrbitfehler über einen Block.\n- Limit: meist nur Erkennung; bei Fehlern braucht man oft Neusenden oder ein Backup.

Replikationscode (einfache Korrektur). Jede Bit dreimal senden: 0 → 000, 1 → 111. Der Empfänger verwendet Mehrheitsscheidung.

- Stärke: kann einen einzelnen Fehler in jeder Gruppe von drei korrigieren.\n- Limit: extrem ineffizient — verdreifacht die Daten.

Erkennung vs. Korrektur (und wann man welches wählt)

Fehlererkennung beantwortet: ‚Ist etwas schiefgelaufen?‘ Sie ist üblich, wenn Neusendungen billig sind — etwa bei Netzwerkpaketen, die erneut angefordert werden können.

Fehlerkorrektur beantwortet: ‚Was waren die ursprünglichen Bits?‘ Sie kommt zum Einsatz, wenn Neusendungen teuer oder unmöglich sind — etwa beim Streaming über verrauschte Links, in der Deep‑Space‑Kommunikation oder beim Auslesen von beschädigtem Speicher.

Redundanz wirkt verschwenderisch, aber sie ist der Grund, warum moderne Systeme trotz unvollkommener Hardware und verrauschter Kanäle schnell und vertrauenswürdig bleiben.

Kanalkapazität und die Shannon‑Grenze (ohne schwere Mathematik)

Wenn Sie Daten über einen realen Kanal schicken — Wi‑Fi, Mobilfunk, ein USB‑Kabel oder eine Festplatte — können Rauschen und Interferenz Bits kippen oder Symbole verwischen. Shannons überraschendes Versprechen war: zuverlässige Kommunikation ist möglich, selbst über verrauschte Kanäle, solange Sie nicht zu viel Information auf einmal durchschicken.

Kanalkapazität in einfachen Worten

Kanalkapazität ist das ‚Tempolimit‘ eines Kanals: die maximale Rate (Bits pro Sekunde), die Sie übertragen können, wobei die Fehlerwahrscheinlichkeit beliebig klein gemacht werden kann, gegebenem Rauschen und Beschränkungen wie Bandbreite und Sendeleistung.

Sie ist nicht identisch mit der Rohsymbolrate (wie schnell Sie ein Signal umschalten). Es geht darum, wie viel sinnvolle Information nach Rauschen übrigbleibt — wenn Sie intelligente Kodierung, Redundanz und Decodierung berücksichtigen.

Die Shannon‑Grenze: eine Grenze, der Ingenieure nachjagen

Die Shannon‑Grenze ist der praktische Name für diese Grenze: darunter kann man (theoretisch) die Zuverlässigkeit beliebig hoch machen; darüber geht es nicht — Fehler bleiben, egal wie clever das Design ist.

Ingenieurinnen und Ingenieure arbeiten hart daran, dieser Grenze näher zu kommen, durch bessere Modulation und fehlerkorrigierende Codes. Moderne Systeme wie LTE/5G und Wi‑Fi nutzen fortschrittliche Kodierungen, damit sie nahe an dieser Grenze arbeiten, statt enorme Mengen an Leistung oder Bandbreite zu verschwenden.

Der zentrale Trade‑off (Rate vs. Fehlerwahrscheinlichkeit)

Stellen Sie sich vor, Sie packen Gegenstände in einen fahrenden, holprigen Lkw:\n\n- Packen Sie zu voll (Rate oberhalb der Kapazität), werden einige Gegenstände unvermeidlich beschädigt (eine nicht‑null Fehlerwahrscheinlichkeit).\n- Packen Sie mit Puffer und Polster (Rate unterhalb der Kapazität), können Sie Bruch so selten machen, wie Sie wollen — zu dem Preis, dass Sie weniger durchsatzstark sind oder mehr Redundanz verwenden.

Shannon hat keinen einzigen ‚besten Code‘ gegeben, aber bewiesen, dass die Grenze existiert — und dass es sich lohnt, ihr näherzukommen.

Fehlerkorrigierende Codes in realen Systemen

Zuverlässige APIs entwerfen

Erstelle eine Go- und PostgreSQL-API, die Pakete, Checksummen und Wiederholungen sauber handhabt.

Shannons Rauschanalysesatz ist häufig zusammengefasst als Versprechen: wenn Sie unterhalb der Kanalkapazität senden, existieren Codes, die Fehler beliebig selten machen können. Praktische Ingenieursarbeit besteht darin, aus diesem Existenzbeweis brauchbare Verfahren zu machen, die in Chips, Akkus und zeitlichen Beschränkungen passen.

Das praktische Werkzeugfeld: Blockbildung, Interleaving und bessere Vermutungen

Die meisten realen Systeme nutzen Blockcodes (schützen einen Bitblock auf einmal) oder stromorientierte Codes (schützen eine fortlaufende Sequenz).

Bei Blockcodes fügen Sie jedem Block sorgfältig entworfene Redundanz hinzu, damit der Empfänger Fehler erkennen und korrigieren kann. Mit Interleaving mischt man die Reihenfolge der gesendeten Bits/Symbole so, dass ein Rausch‑Burst (viele Fehler hintereinander) in kleinere, korrigierbare Fehler über mehrere Blöcke verteilt wird — in Funk und Speicherung oft entscheidend.

Ein weiterer großer Unterschied ist, wie der Empfänger ‚entscheidet‘, was er gehört hat:\n\n- Hard‑Decisions: jedes empfangene Signal wird sofort zu 0 oder 1 gemacht.\n- Soft‑Decisions: der Empfänger behält zusätzlich die Zuversicht (z. B. ‚das ist wahrscheinlich eine 1, aber nicht sicher‘).

Soft‑Decisions liefern mehr Information an den Decoder und verbessern die Zuverlässigkeit deutlich, besonders in Wi‑Fi und Mobilfunk.

Codes, die Sie wahrscheinlich schon genutzt haben

- Reed–Solomon‑Codes: arbeiten auf Symbolen (nicht einzelnen Bits) und sind exzellent gegen Bursts. Verwendet in QR‑Codes, CD/DVD und manchen Broadcast/Storage‑Systemen.\n- Faltungs‑Codes (Convolutional): klassische Wahl für kontinuierliche Streams; historisch oft in Satellitenlinks genutzt.\n- Turbo‑Codes: ein großer Fortschritt in den 1990er‑Jahren, weit verbreitet in 3G/4G.\n- LDPC (Low‑Density Parity‑Check): sehr effiziente moderne Blockcodes, eingesetzt in Wi‑Fi, 5G und vielen Hochdurchsatzsystemen.

Wo sie wirklich zählen

Von Deep‑Space‑Kommunikation (wo Neusendungen teuer oder unmöglich sind) über Satelliten, Wi‑Fi bis 5G sind fehlerkorrigierende Codes die Brücke zwischen Shannons Theorie und der Praxis verrauschter Kanäle — sie tauschen zusätzliche Bits und Rechenaufwand gegen weniger abgebrochene Verbindungen, schnellere Downloads und robustere Links ein.

Netzwerk‑Zuverlässigkeit: Pakete, Neusendungen und Durchsatz

Das Internet funktioniert, obwohl einzelne Links unvollkommen sind. Wi‑Fi verblasst, Mobilverbindungen werden blockiert, und Kupfer wie Glas leiden unter Rauschen und gelegentlichen Hardwarefehlern. Shannons Kernbotschaft — Rauschen ist unvermeidbar, aber Zuverlässigkeit ist erreichbar — zeigt sich im Netzwerk als Mischung aus Fehlererkennung/-korrektur und Neusendungen.

Pakete: kleine Wetten statt einer großen

Daten werden in Pakete aufgeteilt, damit das Netzwerk um Probleme herum routen und Verluste beheben kann, ohne alles neu zu senden. Jedes Paket trägt Zusatzbits (Header und Prüfsummen), die dem Empfänger helfen zu entscheiden, ob das Eingetroffene vertrauenswürdig ist.

Ein gängiges Muster ist ARQ (Automatic Repeat reQuest):\n\n- Der Empfänger prüft ein Paket (typischerweise mit einer Prüfsumme/CRC).\n- Wenn es in Ordnung ist, sendet er eine Bestätigung (ACK).\n- Fehlt es oder ist es beschädigt, sendet der Sender nach einer Zeitüberschreitung neu (oder bei negativem ACK).

Korrigieren vs. Neusenden: der Latenz‑Trade‑off

Wenn ein Paket fehlerhaft ist, haben Sie zwei Hauptoptionen:\n\n- Jetzt korrigieren mit Forward Error Correction (FEC): genug Redundanz vorsehen, damit der Empfänger einige Fehler ohne Neusenden reparieren kann.\n- Neusenden mit ARQ: weniger Redundanz vorab, dafür Zeitverlust, wenn etwas schiefgeht.

FEC kann Verzögerungen auf Verbindungen mit hohen RTTs oder intermittierenden Ausfällen reduzieren. ARQ ist effizient, wenn Verluste selten sind, weil man dann nicht jedes Paket mit starker Redundanz belasten muss.

Durchsatz, Stau und warum Zuverlässigkeit nicht umsonst ist

Zuverlässigkeitsmechanismen verbrauchen Kapazität: zusätzliche Bits, extra Pakete und Wartezeit. Neusendungen erhöhen die Last und können Stau verschlimmern; Stau wiederum erhöht Verzögerung und Verlust, was noch mehr Neusendungen auslöst.

Gutes Netzwerkdesign sucht das Gleichgewicht: genug Zuverlässigkeit, um korrekte Daten zu liefern, aber wenig Overhead, damit der Durchsatz unter wechselnden Bedingungen erhalten bleibt.

Digitale Kommunikation End‑to‑End: Von der Quelle bis zum Kanal

Eine nützliche Sicht auf moderne digitale Systeme ist die Pipeline mit zwei Aufgaben: die Nachricht kleiner machen und die Nachricht die Reise überstehen lassen. Shannons Einsicht war, dass man diese oft als getrennte Schichten betrachten kann — auch wenn Produkte sie gelegentlich vermischen.

Schritt 1: Source Coding (Kompression)

Sie beginnen mit einer Quelle: Text, Audio, Video, Sensormessungen. Source Coding entfernt vorhersehbare Struktur, damit Sie keine Bits verschwenden. Das kann ZIP für Dateien, AAC/Opus für Audio oder H.264/AV1 für Video sein.

Kompression ist der praktische Ort, an dem Entropie sichtbar wird: je vorhersagbarer Inhalte sind, desto weniger Bits brauchen sie im Durchschnitt.

Schritt 2: Channel Coding (Fehlerkorrektur)

Dann müssen die komprimierten Bits einen verrauschten Kanal überqueren: Wi‑Fi, Mobilfunk, Glasfaser, USB. Channel Coding fügt gezielt Redundanz hinzu, damit der Empfänger Fehler erkennen und korrigieren kann. Das ist die Welt von CRCs, Reed–Solomon, LDPC und anderen FEC‑Methoden.

Shannons Trennungsprinzip (praktisches Denkmodell)

Shannon zeigte, dass man in der Theorie Source Coding unabhängig von Channel Coding optimieren kann: Kompression bis nahe an die beste Effizienz und Kanal‑Codes bis nahe an die Zuverlässigkeitsgrenze. In der Praxis ist diese Trennung ein hilfreiches Debugging‑Modell: wenn die Performance schlecht ist, fragen Sie, ob die Kompression ineffizient ist, der Link zu verrauscht, oder ob Sie zu viel Latenz durch Neusendungen und Puffern haben.

Konkretes Beispiel: Video‑Streaming über Wi‑Fi

Beim Streaming komprimiert ein Codec Frames. Über Wi‑Fi können Pakete verloren oder beschädigt werden, also fügt das System Fehlererkennung, manchmal FEC hinzu und nutzt Neusendungen (ARQ) wenn nötig. Wenn die Verbindung schlechter wird, wechselt der Player oft auf eine niedrigere Bitrate.

Echte Systeme vermischen die Trennung, weil Zeit wichtig ist: auf Neusendungen zu warten kann zu Pufferung führen, und Funkbedingungen ändern sich schnell. Deshalb kombinieren Streaming‑Stacks Kompressionswahl, Redundanz und Adaptation — nicht perfekt getrennt, aber immer noch nach Shannons Modell ausgerichtet.

Häufige Missverständnisse und praktische Trade‑offs

Fürs Bauen belohnt werden

Verdiene Credits, indem du teilst, was du mit Koder.ai gebaut hast und was du gelernt hast.

Informationstheorie wird oft zitiert und einige Ideen werden vereinfacht weitergegeben. Hier sind typische Missverständnisse — und die realen Abwägungen, die Ingenieurinnen und Ingenieure beim Bau von Kompression, Speicherung und Netzwerken treffen.

Missverständnis 1: ‚Entropie bedeutet Zufall‘

Im Alltagsgebrauch kann ‚zufällig‘ ‚chaotisch‘ oder ‚unvorhersehbar‘ meinen. Shannons Entropie ist enger: sie misst Überraschung relativ zu einem Wahrscheinlichkeitsmodell.

- Eine perfekt vorhersehbare Folge (z. B. nur Nullen) hat niedrige Entropie.\n- Eine Folge, die schwer vorherzusagen ist gegeben dem, was Sie wissen, hat höhere Entropie.

Entropie ist also keine Stimmung, sondern eine Zahl, die an Annahmen über das Verhalten der Quelle gebunden ist.

Missverständnis 2: ‚Mehr Kompression ist immer besser‘

Kompression entfernt Redundanz. Fehlerkorrektur fügt oft gezielt Redundanz hinzu, damit der Empfänger beschädigte Daten wiederherstellen kann.

Das schafft eine praktische Spannung:\n\n- Wenn Sie sehr aggressiv komprimieren und dann über einen verrauschten Kanal senden, haben Sie vielleicht weniger ‚Spielraum‘, um Schäden zu beheben.\n- Gut gestaltete Systeme komprimieren in der Regel zuerst (entfernen vorhersehbare Muster) und fügen dann strukturierte Redundanz für den Kanal hinzu.

Missverständnis 3: ‚Wir können bei beliebiger Geschwindigkeit perfekt zuverlässig sein‘

Shannons Kanalkapazität sagt: jeder Kanal hat eine maximale zuverlässige Durchsatzrate bei gegebenem Rauschen. Unterhalb dieses Limits können Fehler mit dem richtigen Code extrem selten gemacht werden; oberhalb bleiben Fehler unvermeidbar.

Deshalb ist ‚perfekt zuverlässig bei jeder Geschwindigkeit‘ nicht möglich: Geschwindigkeitserhöhung bedeutet in der Regel höhere Fehlerwahrscheinlichkeit, höhere Latenz (mehr Neusendungen) oder mehr Overhead (stärkere Kodierung).

Eine einfache Checkliste für reale Systeme

Bei der Bewertung eines Produkts oder einer Architektur fragen Sie:\n\n1. Quellenstatistiken: Sind die Daten vorhersehbar (Text, Logs) oder schon nah an zufällig (verschlüsselt, komprimiert)?\n2. Rauschen: Was kann sie beschädigen — Funkinterferenzen, Bitrot, Paketverlust?\n3. Latenzbudget: Können Sie Neusendungen und Pufferung aushalten, oder muss es echtzeitfähig sein?\n4. Overhead‑Entscheidung: Investieren Sie Bits in Kompressionsgewinn, Fehlerkorrektur, Neusendungen oder eine Mischung?

Diese vier Punkte richtig zu treffen ist wichtiger als Formeln auswendig zu lernen.

Wichtige Erkenntnisse und wohin Sie als Nächstes gehen sollten

Shannons Kernbotschaft ist, dass Information messbar ist und mit wenigen Ideen verschoben, geschützt und komprimiert werden kann.

- Ein Bit ist die gemeinsame Währung, die Text, Audio, Video und Sensordaten einheitlich behandelbar macht, sobald sie kodiert sind.\n- Entropie misst, wie unvorhersehbar eine Quelle ist und sagt voraus, wie gut sich Daten komprimieren lassen.\n- Rauschen und Verluste sind unvermeidlich, also fügen zuverlässige Systeme Redundanz über Fehlererkennung und fehlerkorrigierende Codes hinzu.\n- Kanalkapazität setzt eine echte Obergrenze: jenseits einer bestimmten Rate hilft auch ausgeklügelte Technik nicht — man muss Rate senken, den Kanal verbessern oder die Kodierung ändern.

Moderne Netzwerke und Speichersysteme sind im Kern ständige Abwägungen zwischen Rate, Zuverlässigkeit, Latenz und Rechenaufwand.

Ein praktischer Hinweis für Entwickler

Wenn Sie reale Produkte bauen — APIs, Streaming‑Features, Mobile Apps, Telemetrie‑Pipelines — ist Shannons Rahmenwerk eine nützliche Design‑Checkliste: komprimieren, wo Sie können; schützen, wo Sie müssen; und seien Sie explizit im Latenz/Durchsatz‑Budget. Ein direkter Ort, um das sofort anzuwenden, ist beim schnellen Prototyping: mit einer Plattform wie Koder.ai können Teams schnell eine React‑Webapp, ein Go‑Backend mit PostgreSQL und sogar einen Flutter‑Mobile‑Client aus einer chatgesteuerten Spezifikation hochziehen und reale Trade‑offs (Payload‑Größe, Neusendungen, Pufferverhalten) früh testen. Funktionen wie Planungsmodus, Snapshots und Rollback erleichtern das Experimentieren mit ‚stärkerer Zuverlässigkeit vs. niedrigerem Overhead‘, ohne an Tempo zu verlieren.

Wer sollte tiefer einsteigen

Vertiefung lohnt sich für:\n\n- Studierende, die ein klares Modell wollen, das Wahrscheinlichkeit mit Kompression und Kodierung verbindet\n- Produktmanager, die zwischen Qualität, Latenz, Bandbreite und Kosten abwägen müssen\n- Ingenieurinnen und Ingenieure, die an Netzwerken, Mediencodecs, Speicherung, Telemetrie oder ML‑Datenpipelines arbeiten

Um weiterzumachen, schauen Sie sich verwandte Erklärungen in /blog an und dann /docs, um zu sehen, wie unser Produkt Kommunikations‑ und Kompressions‑Einstellungen sowie APIs freigibt. Beim Vergleich von Plänen oder Durchsatzlimits ist /pricing die nächste Station.