14. Nov. 2025·8 Min

Craig McLuckie und Cloud‑Native: Platform Thinking gewinnt

Ein praktischer Blick auf Craig McLuckies Rolle bei der Cloud‑Native‑Adoption und wie Platform Thinking Container in zuverlässige Produktionsinfrastruktur verwandelte.

Ein praktischer Blick auf Craig McLuckies Rolle bei der Cloud‑Native‑Adoption und wie Platform Thinking Container in zuverlässige Produktionsinfrastruktur verwandelte.

Teams scheitern nicht, weil sie keinen Container starten können. Sie haben Probleme, weil sie Hunderte davon sicher betreiben, ohne Ausfallzeit updaten, nach Fehlern wiederherstellen und gleichzeitig Features termingerecht ausliefern müssen.

Craig McLuckies „cloud‑native“‑Geschichte ist relevant, weil sie kein Siegeszug für beeindruckende Demos ist. Sie dokumentiert, wie Container in realen Umgebungen betriebbar wurden — dort, wo es Vorfälle gibt, Compliance gilt und das Geschäft vorhersehbare Auslieferung braucht.

„Cloud‑native“ heißt nicht nur „in der Cloud betrieben“. Es ist ein Ansatz zum Bauen und Betreiben von Software, damit sie häufig deploybar, bei Nachfrage skalierbar und bei Ausfällen schnell reparierbar ist.

In der Praxis bedeutet das meist:

Frühe Container‑Nutzung sah oft wie ein Werkzeugkasten aus: Teams nahmen Docker, klebten Skripte zusammen und hofften, dass der Betrieb mitkommt. Platform Thinking kehrt das um. Statt dass jedes Team seinen eigenen Weg in Produktion erfindet, baut man gemeinsame "paved roads" — eine Plattform, die die sichere, konforme und beobachtbare Methode zugleich zur einfachen Methode macht.

Dieser Wechsel ist die Brücke von „wir können Container betreiben“ zu „wir können ein Geschäft darauf betreiben."

Das richtet sich an Verantwortliche für Ergebnisse, nicht nur an Leute mit Architekturdiagrammen:

Wenn Ihr Ziel verlässliche Auslieferung in großem Maßstab ist, enthält diese Geschichte praktische Lektionen.

Craig McLuckie ist einer der bekanntesten Namen der frühen Cloud‑Native‑Bewegung. Man begegnet ihm in Gesprächen über Kubernetes, die Cloud Native Computing Foundation (CNCF) und die Idee, Infrastruktur als Produkt zu behandeln — nicht als einen Haufen Tickets und tribales Wissen.

Es ist wichtig, präzise zu sein. McLuckie hat nicht allein „cloud‑native erfunden“, und Kubernetes war niemals ein Einmannprojekt. Kubernetes entstand bei einem Team in Google, und McLuckie war Teil dieser frühen Arbeit.

Wofür man ihn oft lobt, ist, ein Engineering‑Konzept so zu formen, dass die breitere Industrie es tatsächlich übernehmen konnte: bessere Community‑Arbeit, klarere Verpackung und ein Vorstoß hin zu wiederholbaren Betriebspraktiken.

Bei Kubernetes und in der CNCF‑Ära war McLuckies Botschaft weniger architektonischer Trend, sondern mehr Produktion vorhersagbar zu machen. Das heißt:

Wenn Sie Begriffe wie „paved roads“, „golden paths“ oder „Platform as a Product“ gehört haben, kreisen Sie um dieselbe Idee: die kognitive Last für Teams verringern, indem man das Richtige zur einfachen Option macht.

Dieser Beitrag ist keine Biografie. McLuckie ist ein nützlicher Bezugspunkt, weil seine Arbeit an der Schnittstelle dreier Kräfte sitzt, die die Softwarelieferung veränderten: Container, Orchestrierung und Ökosystemaufbau. Die Lektionen drehen sich nicht um Persönlichkeit, sondern darum, warum Platform Thinking die Entsperrung war, damit Container in echter Produktion laufen konnten.

Container waren eine spannende Idee, lange bevor „cloud‑native“ ein gängiges Label wurde. Ein Container ist einfach gesagt eine Möglichkeit, eine Anwendung zusammen mit benötigten Dateien und Bibliotheken so zu verpacken, dass sie auf verschiedenen Maschinen gleich läuft — wie ein Produkt in einer versiegelten Box mit allen Teilen.

Anfangs nutzten viele Teams Container für Side‑Projekte, Demos und Entwickler‑Workflows. Sie waren großartig, um neue Dienste schnell auszuprobieren, Testumgebungen zu starten und „auf meinem Laptop läuft es“‑Probleme bei Übergaben zu vermeiden.

Doch der Schritt von einer Handvoll Container zu einem Produktionssystem, das 24/7 läuft, ist eine andere Aufgabe. Die Tooling‑Grundlage war da, aber die operative Geschichte war unvollständig.

Häufige Probleme traten schnell auf:

Container erhöhten die Portabilität, aber Portabilität allein garantierte keine Zuverlässigkeit. Teams brauchten noch konsistente Deploy‑Praktiken, klare Verantwortlichkeiten und operative Leitplanken — damit containerisierte Apps nicht nur einmal laufen, sondern jeden Tag vorhersagbar laufen.

Platform Thinking ist der Moment, in dem ein Unternehmen aufhört, Infrastruktur als einmaliges Projekt zu sehen, und anfängt, sie wie ein internes Produkt zu bauen. Die „Kundinnen“ sind Ihre Entwickler, Data‑Teams und alle, die Software ausliefern. Das Ziel ist nicht mehr mehr Server oder mehr YAML — es ist ein reibungsloserer Weg von Idee zu Produktion.

Eine echte Plattform hat ein klares Versprechen: „Wenn Sie auf diesen Pfaden bauen und deployen, erhalten Sie Zuverlässigkeit, Sicherheit und vorhersehbare Auslieferung.“ Dieses Versprechen erfordert Produktgewohnheiten — Dokumentation, Support, Versionierung und Feedback‑Schleifen. Es erfordert auch ein bewusstes Nutzererlebnis: sinnvolle Defaults, paved roads und einen Fluchtweg, wenn Teams ihn wirklich brauchen.

Standardisierung entfernt Entscheidungs‑Müdigkeit und verhindert versehentliche Komplexität. Wenn Teams gleiche Deploy‑Muster, Logging und Zugriffskontrollen teilen, werden Probleme wiederholbar — und damit lösbar. On‑Call‑Rotationen werden besser, weil Vorfälle vertraut wirken. Sicherheitsprüfungen gehen schneller, weil die Plattform Leitplanken vorgibt, statt dass jedes Team sie neu erfinden muss.

Es geht nicht darum, alle in dieselbe Schublade zu zwingen. Es geht darum, sich über die 80 % zu einigen, die langweilig sein sollten, damit Teams ihre Energie auf die 20 % richten können, die das Geschäft unterscheiden.

Früher hing Infrastruktur oft von speziellem Wissen ab: Ein paar Leute wussten, welche Server gepatcht sind, welche Einstellungen sicher sind und welche Skripte „die guten“ sind. Platform Thinking ersetzt das durch wiederholbare Muster: Templates, automatisierte Provisionierung und konsistente Umgebungen von Dev bis Prod.

Richtig gemacht schaffen Plattformen bessere Governance mit weniger Papierkram. Policies werden zu automatisierten Checks, Genehmigungen zu prüfbaren Workflows und Compliance‑Nachweise entstehen beim Deployen — so gewinnt die Organisation Kontrolle, ohne alle zu bremsen.

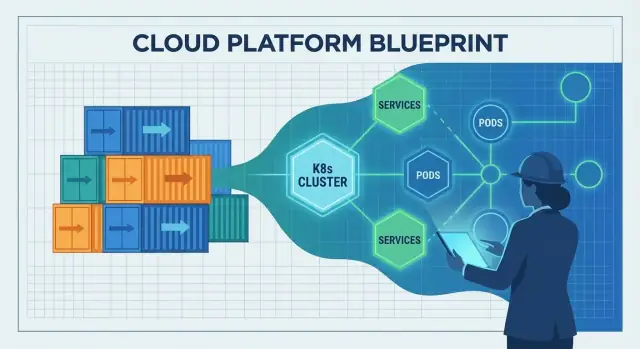

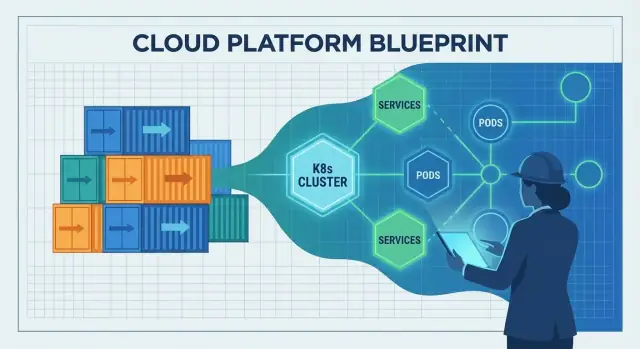

Container machten es einfach, eine App zu verpacken und zu verschicken. Die schwierige Frage war, was danach passiert: wo sie laufen soll, wie sie gesund bleibt und wie man reagiert, wenn Last oder Infrastruktur sich ändern.

Genau diese Lücke schloss Kubernetes. Es verwandelte „einen Haufen Container“ in etwas, das Sie Tag für Tag betreiben können, selbst wenn Server ausfallen, Releases passieren und die Nachfrage schwankt.

Kubernetes wird oft als „Container‑Orchestrierung“ beschrieben, aber die praktischen Probleme sind spezifischer:

Ohne Orchestrator enden Teams damit, diese Verhaltensweisen zu skripten und Ausnahmen manuell zu verwalten — bis die Skripte nicht mehr zur Realität passen.

Kubernetes popularisierte die Idee einer gemeinsamen Control Plane: Ein Ort, an dem man deklariert, was man will („starte 3 Kopien dieses Dienstes“) und die Plattform stetig daran arbeitet, die reale Welt diesem Soll‑Zustand anzupassen.

Das ist ein großer Verantwortungswandel:

Kubernetes entstand nicht, weil Container in Mode waren. Es wuchs aus den Erfahrungen beim Betrieb großer Flotten: Infrastruktur als System mit Rückkopplungsschleifen behandeln, nicht als Menge Einzelserveraufgaben. Diese operative Denkweise ist der Grund, warum es die Brücke von „wir können Container betreiben“ zu „wir können sie zuverlässig in Produktion betreiben“ wurde.

Cloud‑native brachte nicht nur neue Tools — es veränderte den täglichen Rhythmus der Softwareauslieferung. Teams wechselten von „handgefertigten Servern und manuellen Runbooks“ zu Systemen, die über APIs, Automatisierung und deklarative Konfiguration gesteuert werden.

Ein cloud‑native Setup geht davon aus, dass Infrastruktur programmierbar ist. Braucht man eine Datenbank, einen Load‑Balancer oder eine neue Umgebung? Statt auf manuelle Einrichtung zu warten, beschreibt das Team, was es will, und lässt die Automatisierung es erstellen.

Der Schlüsselsprung ist deklarative Konfiguration: Sie definieren den gewünschten Zustand („starte 3 Kopien dieses Dienstes, expose auf diesem Port, beschränke den Speicher auf X“) und die Plattform arbeitet kontinuierlich daran, diesen Zustand zu erreichen. Das macht Änderungen überprüfbar, wiederholbar und leichter zurückrollbar.

Traditionelle Auslieferung beinhaltete häufig das Patchen live‑stehender Server. Mit der Zeit wurde jede Maschine ein wenig anders — Konfigurationsdrift, der sich nur in einem Vorfall zeigt.

Cloud‑native fördert immutable Deployments: Ein artefakt (z. B. ein Container‑Image) wird einmal gebaut und deployed; Änderungen erfolgen durch das Ausrollen einer neuen Version. In Kombination mit automatisierten Rollouts und Health‑Checks reduziert das mysteriöse Ausfälle, die durch Ein‑Off‑Fixes entstehen.

Container erleichterten das Verpacken und Ausführen vieler kleiner Dienste, was Microservice‑Architekturen förderte. Microservices erhöhten wiederum den Bedarf an konsistenter Auslieferung, Skalierung und Service Discovery — Bereiche, in denen Orchestrierung glänzt.

Der Trade‑off: Mehr Dienste bedeuten mehr operativen Overhead (Monitoring, Networking, Versionierung, Incident Response). Cloud‑native hilft, diese Komplexität zu managen, aber es beseitigt sie nicht.

Portabilität verbesserte sich, weil Teams auf gemeinsame Deploy‑Primitive und APIs standardisierten. Dennoch bedeutet „überall laufen“ Arbeit — Unterschiede in Sicherheit, Storage, Networking und Managed Services sind relevant. Cloud‑native reduziert Lock‑in und Reibung, eliminiert sie aber nicht vollständig.

Kubernetes verbreitete sich nicht nur, weil es mächtig war. Es verbreitete sich, weil es ein neutrales Zuhause, klare Governance und einen Ort bekam, an dem konkurrierende Firmen kooperieren konnten, ohne dass ein Anbieter die Regeln bestimmte.

Die Cloud Native Computing Foundation (CNCF) schuf geteilte Governance: offene Entscheidungsprozesse, vorhersehbare Projektabläufe und öffentliche Roadmaps. Das ist wichtig für Teams, die auf Kerninfrastruktur setzen. Wenn die Regeln transparent sind und nicht an das Geschäftsmodell einer einzelnen Firma gebunden, wirkt Adoption weniger riskant — und Beiträge werden attraktiver.

Indem die CNCF Kubernetes und verwandte Projekte hostete, half sie, aus „einem beliebten Open‑Source‑Tool“ eine langfristig angelegte Plattform mit institutioneller Unterstützung zu machen. Sie bot:

Mit vielen Mitwirkenden (Cloud‑Provider, Startups, Enterprises und unabhängigen Ingenieuren) entwickelte sich Kubernetes schneller und in realistischere Richtungen: Networking, Storage, Sicherheit und Day‑2‑Operationen. Offene APIs und Standards erleichterten die Integration von Tools, verringerten Lock‑in und stärkten das Vertrauen in den Produktivbetrieb.

Die CNCF beschleunigte auch eine Ökosystemexplosion: Service‑Meshes, Ingress‑Controller, CI/CD‑Tools, Policy‑Engines, Observability‑Stacks und mehr. Diese Vielfalt ist eine Stärke — aber sie erzeugt Überschneidungen.

Für die meisten Teams liegt der Erfolg darin, eine kleine Menge gut unterstützter Komponenten zu wählen, Interoperabilität zu priorisieren und klare Besitzverhältnisse festzulegen. Ein „Best of everything“‑Ansatz führt oft zu Wartungsaufwand statt besserer Auslieferung.

Container und Kubernetes lösten einen großen Teil der Frage „wie betreiben wir Software?“ Aber sie lösten nicht automatisch die härtere Frage: „wie halten wir sie am Laufen, wenn echte Nutzer auftauchen?“ Die fehlende Schicht ist operative Zuverlässigkeit — klare Erwartungen, gemeinsame Praktiken und ein System, das das richtige Verhalten zum Default macht.

Ein Team kann schnell ausliefern und trotzdem eine schlechte Auslieferungseinheit sein, wenn die Produktionsbasislinie undefiniert ist. Mindestens braucht man:

Ohne diese Basis erfindet jeder Dienst seine eigenen Regeln und Zuverlässigkeit wird zur Glückssache.

DevOps und SRE brachten wichtige Gewohnheiten: Ownership, Automatisierung, gemessene Zuverlässigkeit und Lernen aus Vorfällen. Aber Gewohnheiten allein skalieren nicht über Dutzende Teams und Hunderte Dienste.

Plattformen machen diese Praktiken wiederholbar. SRE setzt Ziele (wie SLOs) und Feedback‑Schleifen; die Plattform bietet paved roads, um sie zu erreichen.

Zuverlässige Auslieferung erfordert meist ein konsistentes Set an Fähigkeiten:

Eine gute Plattform backt diese Defaults in Templates, Pipelines und Laufzeit‑Policies ein: Standard‑Dashboards, gemeinsame Alert‑Regeln, Deployment‑Guardrails und Rollback‑Mechanismen. So wird Zuverlässigkeit optionales Feature zu einem vorhersehbaren Ergebnis beim Ausliefern von Software.

Cloud‑native Tooling kann mächtig sein und sich trotzdem für die meisten Produktteams wie „zu viel“ anfühlen. Platform Engineering existiert, um diese Lücke zu schließen. Die Mission ist einfach: die kognitive Last der Anwendungsteams reduzieren, damit sie Features ausliefern können, ohne nebenbei Infrastruktur‑Expert*innen werden zu müssen.

Ein gutes Platform‑Team behandelt interne Infrastruktur wie ein Produkt. Das bedeutet klare Nutzer (Entwickler), klare Ergebnisse (sichere, wiederholbare Auslieferung) und einen Feedback‑Kreislauf. Statt einen Haufen Kubernetes‑Primitiven zu übergeben, bietet die Plattform meinungsstarke Wege, Dienste zu bauen, zu deployen und zu betreiben.

Eine praktische Fragestellung ist: „Kann ein Entwickler von Idee zu laufendem Service kommen, ohne ein Dutzend Tickets zu eröffnen?“ Werkzeuge, die diesen Workflow komprimieren — bei Erhalt der Leitplanken — passen zur cloud‑native Plattform‑Vision.

Die meisten Plattformen sind eine Sammlung wiederverwendbarer paved roads, die Teams standardmäßig wählen können:

Das Ziel ist nicht, Kubernetes zu verbergen — es ist, es in sinnvolle Defaults zu packen, die versehentliche Komplexität verhindern.

In diesem Geist kann Koder.ai als eine "DX‑Beschleuniger"‑Schicht genutzt werden für Teams, die schnell interne Tools oder Produktfeatures per Chat hochziehen wollen und dann Quellcode exportieren, wenn es Zeit ist, in eine formellere Plattform zu integrieren. Für Platform‑Teams können der Planning‑Mode und eingebaute Snapshots/Rollback‑Funktionen auch die gleiche Zuverlässigkeits‑zuerst‑Haltung widerspiegeln, die man in Produktionsworkflows haben möchte.

Jeder paved road hat einen Trade‑off: mehr Konsistenz und sicherere Operationen, aber weniger Einzeloptionen. Platform‑Teams sind dann am erfolgreichsten, wenn sie bieten:

Plattform‑Erfolg zeigt sich messbar: schnellere Onboarding‑Zeiten für neue Ingenieure, weniger maßgeschneiderte Deploy‑Skripte, weniger „Snowflake“‑Cluster und klarere Besitzverhältnisse bei Vorfällen. Wenn Teams beantworten können "wer besitzt diesen Service und wie shippen wir ihn?" ohne Meeting, erfüllt die Plattform ihren Zweck.

Cloud‑native kann Auslieferung beschleunigen und Betrieb beruhigen — aber nur, wenn Teams klar sind, was sie verbessern wollen. Viele Verzögerungen entstehen, wenn Kubernetes und sein Ökosystem als Ziel und nicht als Mittel behandelt werden.

Ein häufiger Fehler ist, Kubernetes einzuführen, weil es „moderne Teams tun das“, ohne konkrete Ziele wie kürzere Lead Time, weniger Vorfälle oder bessere Konsistenz. Das Ergebnis ist viel Migrationsarbeit ohne sichtbaren Gewinn.

Wenn Erfolgskriterien nicht vorher definiert werden, wird jede Entscheidung subjektiv: Welches Tool wählen, wie stark standardisieren und wann ist die Plattform „fertig“?

Kubernetes ist eine Grundlage, kein vollständiges Produkt. Teams hängen oft schnell Add‑ons an — Service‑Mesh, mehrere Ingress‑Controller, Custom Operators, Policy‑Engines — ohne klare Grenzen oder Zuständigkeit.

Über‑Customizing ist eine weitere Falle: maßgeschneiderte YAML‑Muster, selbstgemachte Templates und Einzelfälle, die nur die Urheber verstehen. Die Komplexität steigt, das Onboarding verlangsamt sich und Upgrades werden riskant.

Cloud‑native macht es leicht, Ressourcen zu erstellen — und leicht, sie zu vergessen. Cluster‑Sprawl, ungenutzte Namespaces und überprovisionierte Workloads treiben Kosten unauffällig in die Höhe.

Sicherheitsfallen sind ebenso verbreitet:

Starten Sie klein mit ein oder zwei klar abgegrenzten Diensten. Definieren Sie früh Standards (goldene Pfade, zugelassene Basis‑Images, Upgrade‑Regeln) und halten Sie die Plattform‑Oberfläche absichtlich begrenzt.

Messen Sie Ergebnisse wie Deployment‑Frequenz, Mean Time To Recovery und Developer Time‑to‑First‑Deploy — und behandeln Sie alles, was diese Zahlen nicht verbessert, als optional.

Man „adoptiert cloud‑native“ nicht mit einem einzigen Schritt. Erfolgreiche Teams folgen derselben Kernidee aus McLuckies Ära: Baue eine Plattform, die den richtigen Weg zum einfachen Weg macht.

Klein anfangen, dann das Funktionierende kodifizieren.

Wenn Sie mit neuen Workflows experimentieren, ist ein nützliches Muster, das End‑to‑End‑Erlebnis des „goldenen Pfads“ zu prototypisieren, bevor Sie es standardisieren. Beispielsweise können Teams Koder.ai verwenden, um per Chat schnell eine funktionierende Web‑App (React), ein Backend (Go) und eine Datenbank (PostgreSQL) zu erzeugen und den resultierenden Code als Ausgangspunkt für Templates und CI/CD‑Konventionen der Plattform zu nehmen.

Bevor Sie Tooling hinzufügen, fragen Sie:

Messen Sie Ergebnisse, nicht Tool‑Nutzung:

Wenn Sie Beispiele für gute "Platform MVP"‑Pakete sehen möchten, siehe /blog. Für Budget‑ und Rollout‑Planung können Sie auch /pricing konsultieren.

Die große Lektion des letzten Jahrzehnts ist einfach: Container „gewannen" nicht, weil sie clever verpackten. Sie gewannen, weil Platform Thinking sie verlässlich machte — wiederholbare Deploys, sichere Rollouts, konsistente Sicherheitskontrollen und vorhersehbarer Betrieb.

Das nächste Kapitel dreht sich nicht um ein einzelnes Durchbruchswerkzeug. Es geht darum, cloud‑native so langweilig wie möglich zu machen: weniger Überraschungen, weniger Einzelreparaturen und ein flüssigerer Weg von Code zu Produktion.

Policy‑as‑Code wird zum Default. Anstatt jede Deployment‑Entscheidung manuell zu prüfen, kodifizieren Teams Regeln für Sicherheit, Netzwerk und Compliance, sodass Leitplanken automatisch und prüfbar sind.

Developer Experience (DX) wird als Produkt behandelt. Mehr Fokus auf paved roads: Templates, Self‑Service‑Umgebungen und klare goldene Pfade, die kognitive Last reduzieren, ohne Autonomie einzuschränken.

Einfachere Ops, nicht mehr Dashboards. Die besten Plattformen verbergen Komplexität: meinungsstarke Defaults, weniger bewegliche Teile und integrierte Zuverlässigkeitsmuster statt aufgebohrter Add‑ons.

Cloud‑native‑Fortschritt verlangsamt sich, wenn Teams Features statt Ergebnisse jagen. Wenn Sie nicht erklären können, wie ein neues Tool Lead Time reduziert, Vorfallraten senkt oder die Security‑Posture verbessert, ist es wahrscheinlich keine Priorität.

Bewerten Sie Ihre aktuellen Auslieferungsprobleme und ordnen Sie sie den Plattformbedürfnissen zu:

Behandeln Sie die Antworten als Ihr Platform‑Backlog — und messen Sie Erfolg an den Auswirkungen, die Ihre Teams jede Woche spüren.

Cloud‑native ist ein Ansatz zum Bauen und Betreiben von Software, sodass Sie häufig deployen, bei Bedarf skalieren und schnell von Ausfällen erholen können.

In der Praxis umfasst das meist Container, Automatisierung, kleinere Dienste und standardisierte Wege, um das Laufende zu beobachten, abzusichern und zu steuern.

Ein Container hilft, Software konsistent auszuliefern, aber er löst nicht automatisch die harten Produktionsprobleme — wie sichere Upgrades, Service Discovery, Sicherheitskontrollen und dauerhafte Observability.

Die Lücke wird sichtbar, wenn man von einer Handvoll Container zu hunderten, die rund um die Uhr laufen, übergeht.

„Platform Thinking“ heißt, interne Infrastruktur wie ein internes Produkt zu behandeln: klare Nutzer (Entwickler) und ein klares Versprechen (sichere, wiederholbare Auslieferung).

Statt dass jedes Team seinen eigenen Weg in Produktion zusammenflickt, baut die Organisation gemeinsame paved roads (goldene Pfade) mit sinnvollen Defaults und Support.

Kubernetes liefert die operative Schicht, die aus „einem Haufen Container“ ein System macht, das man Tag für Tag betreiben kann:

Außerdem führt es eine gemeinsame ein, in der man gewünschten Zustand deklariert und das System versucht, die reale Welt daran anzupassen.

Deklarative Konfiguration bedeutet, dass Sie beschreiben, was Sie wollen (den gewünschten Zustand), statt Schritt‑für‑Schritt‑Anweisungen zu schreiben.

Praktische Vorteile sind:

Bei immutablen Deployments patchen Sie keine laufenden Server. Sie bauen ein Artefakt einmal (oft ein Container‑Image) und deployen genau dieses Artefakt.

Änderungen erfolgen durch das Ausliefern einer neuen Version, nicht durch Modifikation des laufenden Systems. Das reduziert Konfigurationsdrift und macht Vorfälle reproduzierbarer und einfacher zurückzunehmen.

Die CNCF bot Kubernetes und verwandten Projekten ein neutrales Governance‑Zuhause, was das Risiko reduzierte, auf eine zentrale Infrastruktur zu setzen.

Sie half bei:

Eine Produktionsbasislinie ist die Mindestmenge an Fähigkeiten und Praktiken, die Zuverlässigkeit vorhersehbar macht, z. B.:

Ohne diese Basis erfindet jeder Service seine eigenen Regeln und Zuverlässigkeit wird zum Glücksspiel.

Platform Engineering reduziert die kognitive Last für Entwickler, indem cloud‑native Primitive zu meinungsstarken Defaults gebündelt werden:

Das Ziel ist nicht, Kubernetes zu verstecken, sondern den sicheren Pfad zum einfachsten Pfad zu machen.

Häufige Fallen sind:

Gegenmaßnahmen: