Warum Kaminskys DNS‑Arbeit noch zählt

Dan Kaminsky (1979–2021) wird von Praktikern weiterhin zitiert, weil er gezeigt hat, wie „internet‑skalierte“ Sicherheit aussieht, wenn sie gut gemacht ist: neugierig, praktisch und unermüdlich auf echte Konsequenzen fokussiert.

Seine DNS‑Entdeckung von 2008 blieb nicht nur wegen der Cleverness in Erinnerung. Sie war bedeutsam, weil sie eine abstrakte Sorge — „vielleicht hat die Infrastruktur Löcher“ — in etwas Messbares und Dringliches verwandelte: eine Schwachstelle, die große Teile des Internets zugleich betreffen konnte. Dieser Perspektivwechsel half Sicherheitsteams und Führungskräften zu erkennen, dass manche Bugs nicht „dein Bug“ oder „mein Bug“ sind. Sie sind der Bug von allen.

Was „reale Sicherheitsforschung" hier bedeutet

Kaminskys Arbeit wird oft als real‑weltlich beschrieben, weil sie drei Dinge verband, die nicht immer zusammenkommen:

- Praktische Tests: Ideen, die überprüfbar sind, nicht nur theoretisch.

- Impact‑Fokus: Priorisierung dessen, was Nutzern, Unternehmen und Vertrauen schaden könnte.

- Koordination: Die Erkenntnis, dass die Behebung gemeinsamer Infrastruktur genauso Menschen‑ und Kommunikationsfähigkeiten verlangt wie technische Fertigkeiten.

Diese Kombination spricht noch immer Teams an, die mit Cloud‑Abhängigkeiten, Managed Services und Lieferkettenrisiken umgehen. Wenn eine Schwäche in einer weit verbreiteten Komponente sitzt, kannst du die Behebung nicht wie ein normales Ticket behandeln.

Was dieser Artikel ist (und was nicht)

Das ist eine Lessons‑learned‑Erzählung über systemisches Risiko, Offenlegungs‑Koordination und die Realität des Patchens von Infrastruktur. Es ist kein Schritt‑für‑Schritt‑Exploit‑Guide und enthält keine Anleitungen, die zur Reproduktion von Angriffen dienen.

Wenn du Sicherheits‑ oder Zuverlässigkeitsprogramme leitest, erinnert Kaminskys DNS‑Lehre daran, über deinen Perimeter hinauszublicken: manchmal leben die wichtigsten Risiken in geteilten Schichten, die alle als „funktionierend“ voraussetzen.

DNS in einfachen Worten: was passieren soll

Wenn du eine Website‑Adresse wie example.com eingibst, weiß dein Gerät nicht von selbst, wohin es soll. Es braucht eine IP‑Adresse, und DNS ist der Verzeichnisdienst, der Namen in diese Adressen übersetzt.

Die Hauptakteure

Meistens spricht dein Rechner mit einem rekursiven Resolver (oft vom ISP, Arbeitsplatz oder einem öffentlichen Anbieter betrieben). Die Aufgabe des Resolvers ist, die Antwort in deinem Namen zu finden.

Hat der Resolver die Antwort nicht, fragt er die für diesen Namen zuständigen DNS‑Server, sogenannte autoritativen Nameserver. Autoritative Nameserver sind die „Quelle der Wahrheit“ für eine Domain: sie geben an, welche IP‑Adresse (oder andere Einträge) zurückgegeben werden sollen.

Warum Caching existiert (und warum es wichtig ist)

Rekursive Resolver cachen Antworten, damit sie nicht bei jeder Anfrage neu nachsehen müssen. Das beschleunigt das Surfen, reduziert die Last auf autoritativen Servern und macht DNS günstiger und zuverlässiger.

Jeder gecachte Eintrag enthält einen Timer namens TTL (Time to Live). TTL sagt dem Resolver, wie lange er die Antwort wiederverwenden darf, bevor er sie erneuern muss.

Caching macht Resolver zudem zu wertvollen Zielen: Eine gecachte Antwort kann viele Nutzer und viele Anfragen beeinflussen, bis die TTL abläuft.

Wo Vertrauen angenommen wird — und wo es scheitern kann

DNS baut auf einer Kette von Annahmen auf:

- Du gehst davon aus, dass dein Resolver dir die richtige Antwort gibt.

- Der Resolver geht davon aus, dass die Antworten von den korrekten autoritativen Servern stammen.

- Alle gehen davon aus, dass Antworten zu den richtigen Anfragen gehören.

Diese Annahmen sind meist sicher, weil DNS stark standardisiert und weit verbreitet ist. Das Protokoll wurde jedoch in einer Zeit entworfen, in der bösartiger Verkehr weniger erwartet wurde. Kann ein Angreifer einen Resolver dazu bringen, eine falsche Antwort als legitim zu akzeptieren, kann das „Adressbuch“ für einen Namen falsch sein — ohne dass der Nutzer etwas Ungewöhnliches bemerkt.

Die Schwachstelle: eine einfache Idee mit großen Folgen

DNS ist ein Vertrauenssystem: Dein Gerät fragt einen Resolver „wo ist example.com?“ und akzeptiert in der Regel die erhaltene Antwort. Die Schwachstelle, die Kaminsky aufzeigte, zeigte, wie dieses Vertrauen auf der Caching‑Ebene manipuliert werden kann — leise, in großem Umfang und mit Folgen, die wie „normales Internetverhalten“ aussehen.

Cache‑Vergiftung (oberflächlich, kein How‑to)

Resolver fragen nicht bei jeder Anfrage das globale DNS ab. Sie cachen Antworten, damit wiederholte Lookups schnell sind.

Cache‑Vergiftung ist, wenn ein Angreifer es schafft, einen Resolver dazu zu bringen, eine falsche Antwort zu speichern (zum Beispiel eine reale Domain auf ein angreiferkontrolliertes Ziel zeigen zu lassen). Danach können viele Nutzer, die sich auf diesen Resolver verlassen, umgeleitet werden, bis der Cacheeintrag abläuft oder korrigiert wird.

Das Beängstigende ist nicht nur die Umleitung selbst — es ist die Plausibilität. Browser zeigen weiterhin den erwarteten Domainnamen. Anwendungen funktionieren weiter. Nichts „stürzt ab."

Warum das nicht nur ein weiterer Bug war

Das Problem traf eine Kernannahme: dass Resolver zuverlässig erkennen können, welche DNS‑Antworten legitim sind. Wenn diese Annahme ausfällt, ist die Explosionskraft nicht eine Maschine — es können ganze Netzwerke sein, die Resolver teilen (Unternehmen, ISPs, Campusnetze und manchmal ganze Regionen).

Warum es viele Implementierungen bedrohte, nicht einen Anbieter

Die zugrunde liegende Schwäche lag in üblichen DNS‑Designmustern und Standardkonfigurationen, nicht in einem einzelnen Produkt. Unterschiedliche DNS‑Server und rekursive Resolver — oft von verschiedenen Teams in verschiedenen Sprachen geschrieben — waren auf ähnliche Weise exponiert.

Das ist die Definition von systemischem Risiko: Patchen war nicht „Vendor X updaten“, sondern Änderungen über eine Kernprotokollabhängigkeit hinweg zu koordinieren, die überall verwendet wird. Selbst gut geführte Organisationen mussten inventarisieren, herausfinden, wo sie was laufen hatten, Upgrades upstream finden, testen und ausrollen, ohne die Namensauflösung zu zerstören — denn wenn DNS ausfällt, fällt alles aus.

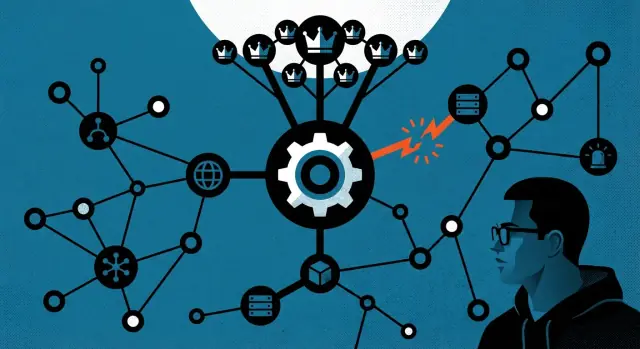

Systemisches Risiko erklärt am Beispiel DNS

Systemisches Risiko ist das, was passiert, wenn ein Problem nicht „dein Problem“ oder „ihr Problem“ ist, sondern jedermanns Problem, weil so viele Menschen von derselben zugrunde liegenden Komponente abhängig sind. Es ist der Unterschied zwischen dem Hack eines einzelnen Unternehmens und einer Schwäche, die in großem Maßstab gegen Tausende unzusammenhängender Organisationen wiederverwendet werden kann.

Was „systemisches Risiko" für Internetinfrastruktur bedeutet

Internetinfrastruktur basiert auf geteilten Protokollen und gemeinsamen Annahmen. DNS gehört zu den am stärksten geteilten Diensten: nahezu jede App, Website, E‑Mail‑System und API‑Aufruf hängt davon ab, Namen (wie example.com) in Netzwerkadressen zu übersetzen.

Hat eine Kerndefizienz wie DNS eine Sicherheitslücke, ist der Blast‑Radius ungewöhnlich groß. Eine einzelne Technik lässt sich über Branchen, Geografien und Unternehmensgrößen hinweg wiederholen — oft ohne dass Angreifer jedes Ziel tief verstehen müssen.

Geteilte Abhängigkeiten: ein schwacher Punkt, tausende Organisationen

Die meisten Organisationen betreiben DNS nicht isoliert. Sie verlassen sich auf rekursive Resolver bei ISPs, Unternehmen, Cloud‑Anbietern und Managed‑DNS‑Diensten. Diese gemeinsame Abhängigkeit schafft einen Multiplikatoreffekt:

- Eine Schwäche in gängiger DNS‑Software kann viele Resolver‑Betreiber betreffen.

- Diese Resolver bedienen viele Endnutzer und interne Systeme.

- Diese Nutzer und Systeme verbinden sich dann anhand der DNS‑Antworten zu „vertrauenswürdigen“ Zielen.

Risiko konzentriert sich also: Die Behebung einer Organisation löst nicht die breitere Exposition, wenn das Ökosystem ungleich gepatcht bleibt.

Kaskadierende Effekte: Phishing, Malware‑Lieferung, Traffic‑Interception

DNS sitzt stromaufwärts vieler Sicherheitskontrollen. Kann ein Angreifer beeinflussen, wohin ein Name auflöst, haben nachgelagerte Verteidigungen möglicherweise nie eine Chance zu helfen. Das ermöglicht realistische Phishing‑Angriffe (Nutzer zu überzeugenden Lookalikes leiten), Malware‑Lieferung (Updates oder Downloads zu bösartigen Servern umleiten) und Traffic‑Interception (Verbindungen an den falschen Endpunkt leiten). Die Lehre ist klar: systemische Schwächen verwandeln kleine Risse in breite, wiederholbare Auswirkungen.

Von der Entdeckung zur Koordination: Zeitlinie der Offenlegung

Kaminskys DNS‑Fund ist oft als „ein großer Bug 2008“ zusammengefasst, aber die lehrreichere Geschichte ist, wie damit umgegangen wurde. Die Zeitlinie zeigt, wie koordinierte Offenlegung aussieht, wenn das verwundbare "Produkt" praktisch das Internet ist.

1) Entdeckung und Validierung (Anfang 2008)

Nach dem Auffallen ungewöhnlichen Verhaltens in DNS‑Resolvern testete Kaminsky seine Hypothese über gängige Implementierungen hinweg. Der Schlüssel war nicht eine auffällige Demo — es war die Bestätigung, dass das Problem real, reproduzierbar und breit anwendbar war.

Er tat auch, was gute Forscher tun: Schlussfolgerungen gegenprüfen, Bedingungen eingrenzen, die die Schwäche möglich machten, und validieren, dass Gegenmaßnahmen für Betreiber praktikabel wären.

2) Ruhige Kontaktaufnahme (Frühjahr 2008)

Statt sofort zu publizieren, kontaktierte er große DNS‑Software‑Maintainer, OS‑Anbieter und Infrastrukturorganisationen vertraulich. Dazu gehörten Teams, die für populäre Resolver und Unternehmensnetzwerkgeräte verantwortlich sind.

Diese Phase beruhte stark auf Vertrauen und Diskretion. Forscher und Anbieter mussten glauben:

- der Bericht ist akkurat und nicht aufgebauscht

- die Details würden nicht durchsickern, bevor ein Fix verfügbar ist

- alle würden sich auf einen gemeinsamen Plan einigen statt nach Schlagzeilen zu jagen

3) Koordination und Patch‑Vorbereitung (Frühjahr–Sommer 2008)

Weil DNS in Betriebssysteme, Firewalls, Router und ISP‑Infrastruktur eingebettet ist, hätte eine fragmentierte Veröffentlichung eine vorhersehbare „Patch‑Lücke“ geschaffen, die Angreifer gezielt hätten ausnutzen können. Das Ziel war daher synchronisierte Bereitschaft: Fixes wurden entwickelt, getestet und verpackt, bevor öffentliche Diskussionen stattfanden.

4) Öffentliche Offenlegung mit verfügbaren Updates (Juli 2008)

Als die Schwachstelle öffentlich gemacht wurde, waren Patches und Gegenmaßnahmen bereits verfügbar (notabel abgestimmt mit einem großen Vendor‑Update‑Zyklus). Dieses Timing war wichtig: es verkürzte das Fenster, in dem Verteidiger wussten, dass sie exponiert waren, aber nichts tun konnten.

Die bleibende Lehre: Bei systemischen Verwundbarkeiten ist Koordination kein bürokratischer Ballast — sie ist ein Sicherheitsmechanismus.

Warum das Patchen von Infrastruktur einzigartig schwierig ist

Lebt ein Bug in der Infrastruktur, wird „einfach patchen“ zu einer Koordinationsaufgabe. DNS ist ein gutes Beispiel, weil es kein einzelnes Produkt ist, das einer Firma gehört und an einem Ort eingesetzt wird. Es sind tausende unabhängig betriebene Systeme — ISPs, Unternehmen, Universitäten, Managed Service Provider — jeweils mit eigenen Prioritäten und Beschränkungen.

Verteilte Verantwortlichkeit und ungleichmäßige Upgrade‑Zyklen

Ein Webbrowser kann über Nacht für Millionen automatisch aktualisiert werden. Resolver funktionieren nicht so. Manche werden von großen Teams mit Change‑Management und Staging‑Umgebungen betrieben; andere stecken in Appliances, Routern oder Legacy‑Servern, die seit Jahren nicht angefasst wurden. Selbst wenn ein Fix verfügbar ist, kann es Wochen oder Monate dauern, bis er sich verbreitet, weil niemand einen einzigen „Update‑Button" fürs gesamte Ökosystem hat.

Warum Resolver‑Patches sich von Endpoint‑Patches unterscheiden

Resolver liegen auf kritischen Pfaden: funktionieren sie nicht, erreichen Nutzer keine E‑Mails, Zahlungsseiten, interne Apps — nichts. Das macht Betreiber konservativ. Endpoint‑Patches können oft kleinere Störungen tolerieren; ein fehlgeschlagenes Resolver‑Upgrade kann wie ein Ausfall aussehen, der alle gleichzeitig betrifft.

Es gibt auch eine Sichtbarkeitslücke. Viele Organisationen haben keine vollständige Inventur, wo DNS behandelt wird (on‑prem, in der Cloud, vom Provider, in Filial‑Gear). Du kannst nicht patchen, was du nicht weißt, dass du es betreibst.

Operative Realitäten: Legacy‑Systeme, Change‑Windows und Risikoakzeptanz

Infrastrukturänderungen konkurrieren mit Geschäftsterminen. Viele Teams patchen nur während enger Wartungsfenster, nach Tests, Genehmigungen und Rollback‑Planung. Manchmal ist die Entscheidung eine explizite Risikoakzeptanz: „Wir können das nicht aktualisieren, bis der Vendor es unterstützt“, oder „Eine Änderung könnte riskanter sein als es so zu belassen."

Die unbequeme Erkenntnis: Systemische Probleme zu beheben ist genauso sehr Operations‑, Anreiz‑ und Koordinationsarbeit wie Code‑Arbeit.

Koordinierte Schwachstellenoffenlegung in großem Maßstab

CVD ist schwer, wenn das betroffene „Produkt" nicht die Software eines Anbieters ist, sondern ein Ökosystem. Eine DNS‑Schwachstelle ist nicht nur ein Bug in einem Resolver; sie berührt Betriebssysteme, Router‑Firmware, ISP‑Infrastruktur, Unternehmens‑DNS‑Appliances und Managed‑DNS‑Dienste. Die Behebung erfordert synchronisierte Aktionen über Organisationen hinweg, die normalerweise nicht auf demselben Zeitplan liefern.

Wie Koordination praktisch aussieht

In großem Maßstab ähnelt CVD weniger einer einzelnen Ankündigung und mehr einem sorgfältig gemanagten Projekt.

Vendoren arbeiten über vertrauenswürdige Kanäle (oft über CERT/CC oder ähnliche Koordinatoren), um Wirkungsdetails zu teilen, Zeitpläne abzustimmen und zu validieren, dass Patches dasselbe Grundproblem adressieren. ISPs und große Unternehmen werden früh eingebunden, weil sie hochvolumige Resolver betreiben und das internetweite Risiko schnell reduzieren können. Das Ziel ist nicht Geheimhaltung um ihrer selbst willen — es ist Zeit zu gewinnen, damit Deployments erfolgen, bevor Angreifer das Problem zuverlässig reproduzieren können.

Wie „stille Fixes" in der Praxis aussehen

„Still“ heißt nicht versteckt; es heißt gestaffelt.

Du siehst Sicherheits‑Advisories, die Dringlichkeit und Gegenmaßnahmen betonen, Software‑Updates, die in reguläre Patch‑Kanäle einfließen, und Konfigurations‑Härtungsempfehlungen (z. B. sicherere Defaults aktivieren oder mehr Zufälligkeit in Anfrageverhalten einführen). Manche Änderungen werden als Defense‑in‑Depth‑Verbesserungen ausgeliefert, die die Exploitierbarkeit reduzieren, selbst wenn nicht jedes Gerät sofort aktualisiert werden kann.

Dringlichkeit kommunizieren, ohne Panik zu erzeugen

Gute Kommunikation trifft eine Nadelöhre: klar genug, damit Betreiber priorisieren, vorsichtig genug, damit Angreifer keinen Bauplan bekommen.

Effektive Advisories erklären, wer gefährdet ist, was zuerst zu patchen ist und welche kompensierenden Kontrollen existieren. Sie geben eine praxisnahe Zeitachse: was heute zu tun ist, diese Woche und dieses Quartal. Interne Kommunikation sollte diese Struktur widerspiegeln, mit einer klaren Verantwortlichkeit, einem Rollout‑Plan und einem expliziten „wie wissen wir, dass wir fertig sind".

Was sich technisch änderte (oberflächlich, keine Exploit‑Schritte)

Die wichtigste Veränderung nach Kaminskys Fund war kein einziger „Schalter umlegen"‑Fix. Die Branche betrachtete es als Infrastrukturproblem, das Defense‑in‑Depth verlangte: mehrere kleine Barrieren, die zusammengenommen großflächigen Missbrauch unpraktisch machen.

Warum es keinen magischen Schalter gab

DNS ist bewusst verteilt. Eine Anfrage kann viele Resolver, Caches und autoritative Server passieren, die verschiedene Softwareversionen und Konfigurationen nutzen. Selbst wenn ein Anbieter schnell einen Patch ausliefert, bleiben heterogene Deployments, eingebettete Appliances und schwer zu aktualisierende Systeme. Eine dauerhafte Antwort muss das Risiko über viele Fehlermodi reduzieren und darf nicht von perfektem Patchen überall ausgehen.

Konzeptuelle Gegenmaßnahmen

Mehrere Schichten wurden in gängigen Resolver‑Implementierungen verstärkt:

- Randomisierung: Resolver erhöhten die Unvorhersehbarkeit in Anfrage‑Details, sodass Antworten schwerer „erratbar" sind. Das umfasst mehr Variation bei Quellports und anderen Anfrageeigenschaften (ohne in die Mechanik zu gehen).

- Strengere Validierung: Antworten werden sorgfältiger auf Konsistenz mit der ursprünglichen Anfrage und erwartetem DNS‑Verhalten geprüft. Ziel ist es, „merkwürdige" Antworten abzulehnen.

- Monitoring und Anomalieerkennung: Betreiber verbesserten Logging und Alerting für verdächtige Antwortmuster, unerwarteten Wechsel in gecachten Einträgen und ungewöhnliche Spitzen bei Anfragefehlern — Signale, dass etwas nicht stimmt, auch wenn es noch nicht bestätigt ist.

Protokollverbesserungen + Implementationsänderungen

Einige Verbesserungen betrafen wie Resolver gebaut und konfiguriert werden (Implementationshärtung). Andere betrafen die Entwicklung des Protokoll‑Ökosystems, damit DNS langfristig stärkere Zusicherungen liefern kann.

Eine Schlüsselerkenntnis: Protokollarbeit und Softwareänderungen verstärken einander. Protokollverbesserungen können das Sicherheitsniveau anheben, aber solide Defaults, sicherere Validierung und operative Sichtbarkeit machen diese Vorteile im Internet tatsächlich wirksam.

Operative Handlungsfelder für Teams, die DNS betreiben

DNS wirkt „einmal einrichten“ — bis es das nicht mehr tut. Kaminskys Arbeit erinnert daran, dass Resolver sicherheitskritische Systeme sind und guter Betrieb genauso viel Disziplin wie Software verlangt.

Wie guter Betrieb im Alltag aussieht

Beginne mit Klarheit darüber, was du betreibst und was „gepatcht“ für jedes Teil bedeutet.

- Resolver‑Patch‑Status: Verfolge Versionen rekursiver Resolver (und vendor‑Appliances) und abonniere deren Sicherheits‑Advisories. Behandle Resolver‑Updates als prioritäre Infrastrukturpatches, nicht als Routine‑Backlog.

- Konfigurations‑Drift: Dokumentiere deine beabsichtigten Resolver‑Einstellungen (Forwarder, Rekursionsregeln, ACLs, DNSSEC‑Validation, Logging) und vergleiche laufende Konfigurationen periodisch mit Baselines. Drift ist der Weg, auf dem „temporäre" Notänderungen zu permanentem Risiko werden.

- Asset‑Inventar: Kenne, wo Resolver existieren (Rechenzentren, Filialen, Cloud VPCs, Kubernetes‑Nodes, Endpunkte), wer sie besitzt und was von ihnen abhängt. Schattenresolver — für ein Projekt hochgezogene und vergessen — sind häufige Fehlerpunkte.

Monitoring‑Signale, die einen Alarm wert sind

DNS‑Vorfälle zeigen sich oft als „Merkwürdigkeiten", nicht als klare Fehler.

Achte auf:

- Ungewöhnliche NXDOMAIN‑Spitzen (nach Domain, Client‑Subnet oder global), was auf Fehlkonfiguration, Upstream‑Probleme oder bösartige Einflüsse hindeuten kann.

- Cache‑Anomalien wie plötzliche TTL‑Änderungen, unerwarteten Answer‑Churn bei stabilen Domains oder einen Schub von SERVFAILs.

- Upstream‑Änderungen: Forwarder‑Health, Latenzverschiebungen zwischen Resolver und Authoritative sowie unerwartete Änderungen, welche Upstreams verwendet werden.

Runbooks: DNS unter Druck langweilig machen

Habe ein DNS‑Incident‑Runbook, das Rollen und Entscheidungen benennt.

Definiere wer triagiert, wer kommuniziert und wer Produktions‑Resolver konfigurieren darf. Füge Eskalationspfade (Netzwerk, Security, Vendor/ISP) und vorab genehmigte Maßnahmen hinzu wie temporäres Wechseln von Forwardern, Logging erhöhen oder verdächtige Client‑Segmente isolieren.

Plane schließlich ein Rollback: Halte bekannte‑gute Konfigurationen bereit und einen schnellen Pfad, um Resolver‑Änderungen zurückzunehmen. Ziel ist, die Auflösung zuverlässig wiederherzustellen und dann ohne Ratespiele im Nachgang zu untersuchen.

Wenn deine Runbooks oder internen Checklisten verstreut sind, behandle sie wie ein kleines Softwareprodukt: versioniert, überprüfbar und leicht zu aktualisieren. Plattformen wie Koder.ai können Teams helfen, schnell leichte interne Tools (z. B. ein Runbook‑Hub oder eine Incident‑Checklisten‑App) per Chat‑gesteuerter Entwicklung bereitzustellen — nützlich, wenn du Konsistenz zwischen Netzwerk, Security und SRE brauchst, ohne lange Entwicklungszyklen.