18. März 2025·8 Min

Dennis Ritchie und C: Kleine Sprache, große Wirkung für Systeme

Wie Dennis Ritchies C Unix formte und heute noch Kernel, Embedded‑Geräte und performante Software antreibt — plus worauf es bei Portabilität, Performance und Sicherheit ankommt.

Warum C noch zählt

C ist eine dieser Technologien, die viele Leute nie direkt anfassen, von denen aber fast alle abhängen. Wenn du ein Telefon, einen Laptop, einen Router, ein Auto, eine Smartwatch oder sogar eine Kaffeemaschine mit Display nutzt, ist es sehr wahrscheinlich, dass C irgendwo im Stack beteiligt ist — es sorgt dafür, dass das Gerät startet, mit Hardware spricht oder schnell genug läuft, um „sofort“ zu wirken.

Für Entwickler bleibt C praktisch, weil es eine seltene Mischung aus Kontrolle und Portabilität bietet. Es kann sehr nah an der Maschine laufen (so dass du Speicher und Hardware direkt verwaltest), ist aber gleichzeitig mit relativ wenig Umschreiben auf verschiedene CPUs und Betriebssysteme übertragbar. Diese Kombination ist schwer zu ersetzen.

Die drei Bereiche, in denen C immer noch dominiert

C hat seine größte Verbreitung in drei Bereichen:

- Betriebssysteme: Kernel, Kernbibliotheken, Treiber und niedrigstufige Hilfsprogramme, auf die alles andere aufbaut.

- Embedded-Geräte: Kleine Systeme mit engen Grenzen bei Speicher, Energie und Flash, wo vorhersehbares Verhalten zählt.

- Performance-Hotspots: Geschwindigkeitskritische Teile größerer Programme — Codepfade, in denen wenige Millisekunden oder Watt viel ausmachen.

Selbst wenn eine Anwendung in höheren Sprachen geschrieben ist, gehen Teile ihrer Grundlage (oder performance-sensitiven Module) oft auf C zurück.

Was du in diesem Artikel lernst

Dieser Beitrag verbindet Dennis Ritchie, die ursprünglichen Ziele von C, und die Gründe, warum es heute noch in modernen Produkten auftaucht. Wir behandeln:

- eine kurze, gut lesbare Geschichtsskizze (inkl. Unixes Einfluss),

- Designentscheidungen, die C klein, aber mächtig machen,

- wo C heute passt — seine Stärken und seine Sicherheitsherausforderungen.

Umfangshinweis

Es geht hier ausdrücklich um C, nicht um „alle low-level-Sprachen“. C++ und Rust tauchen zum Vergleich auf, aber der Fokus liegt darauf, was C ist, warum es so entworfen wurde und warum Teams es weiterhin für reale Systeme wählen.

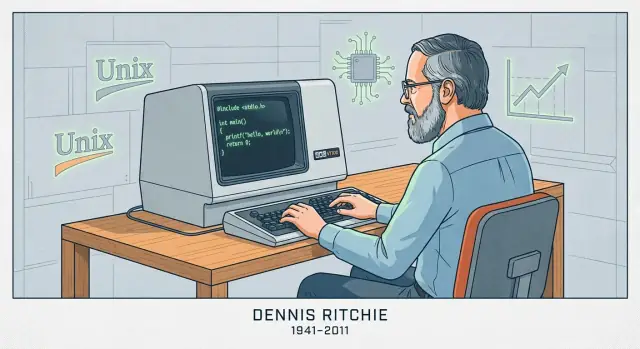

Dennis Ritchie in Kürze

Dennis Ritchie (1941–2011) war ein US‑amerikanischer Informatiker, bekannt für seine Arbeit bei AT&T’s Bell Labs — einer Forschungseinrichtung, die eine zentrale Rolle in der Frühzeit der Informatik und Telekommunikation spielte.

Bell Labs, Unix und eine neue Art von Systemsoftware

Ende der 1960er und in den 1970er Jahren arbeitete Ritchie bei Bell Labs mit Ken Thompson und anderen an Betriebssystem-Forschung, die zu Unix führte. Thompson erschuf eine frühe Version von Unix; Ritchie wurde zum wichtigen Mitgestalter, als das System sich zu etwas entwickelte, das wartbar, erweiterbar und in Forschung wie Industrie verbreitbar war.

C erschaffen, um reale Systeme zu bauen

Ritchie entwickelte auch die Programmiersprache C, aufgebaut auf Ideen aus früheren Sprachen, die bei Bell Labs verwendet wurden. C wurde praktisch für Systemsoftware entworfen: Es gibt Programmierenden direkten Zugriff auf Speicher und Datenrepräsentation, bleibt dabei lesbarer und portabler als reines Assembler.

Das war wichtig, weil Unix schließlich in C neu geschrieben wurde. Das war kein Rewrite aus Stilgründen — es machte Unix deutlich einfacher, auf neue Hardware zu bringen und im Laufe der Zeit zu erweitern. Das erzeugte eine starke Rückkopplung: Unix bot einen anspruchsvollen Anwendungsfall für C, und C erleichterte die Verbreitung von Unix über einzelne Maschinen hinaus.

Warum das Duo Unix + C einflussreich wurde

Gemeinsam halfen Unix und C, das zu definieren, was wir heute unter „Systemprogrammierung“ verstehen: Betriebssysteme, Kernbibliotheken und Tools in einer Sprache zu bauen, die nah an der Maschine ist, aber nicht an einen Prozessor gebunden. Ihr Einfluss zeigt sich in späteren Betriebssystemen, Entwicklerwerkzeugen und den Konventionen, die viele Ingenieure noch heute lernen — weniger wegen Mythos, mehr weil der Ansatz in großem Maßstab funktionierte.

Wie C entworfen wurde: klein, portabel, nah an der Maschine

Frühe Betriebssysteme waren meist in Assembler geschrieben. Das gab vollen Hardwarezugriff, machte aber jede Änderung langsam, fehleranfällig und fest an einen Prozessor gebunden. Selbst kleine Features konnten Seiten von Low-Level-Code erfordern, und die Portierung auf eine andere Maschine bedeutete oft umfassendes Umschreiben.

Von BCPL über B zu C (kurz)

C entstand nicht im Vakuum. Es wuchs aus früheren, einfacheren Systemsprachen bei Bell Labs:

- BCPL bot einen kompakten Stil zum Schreiben von Tools und Systemsoftware.

- B (von Ken Thompson) adaptierte BCPL‑Ideen für frühe Unix‑Arbeit, vermisste aber Datentypen und Struktur für größere Systeme.

- C bewahrte den Geist einer „kleinen Sprache“ und fügte die nötigen Features hinzu, damit Unix praktisch auf realer Hardware gebaut und gewartet werden konnte.

Das Designziel: eine dünne Schicht über der Maschine

C wurde so entworfen, dass es sauber abbildet, was Computer tatsächlich tun: Bytes im Speicher, Arithmetik in Registern und Sprünge im Code. Daher sind einfache Datentypen, expliziter Speicherzugriff und Operatoren, die CPU‑Instruktionen entsprechen, zentral. Du kannst Code schreiben, der hoch genug ist, um ein großes Projekt zu strukturieren, aber immer noch direkt genug, um Layout und Performance zu kontrollieren.

Was „portabel“ im Klartext heißt

„Portabel“ heißt: denselben C‑Quellcode auf eine andere Maschine bringen, dort zu kompilieren und mit minimalen Änderungen dasselbe Verhalten zu erhalten. Anstatt das gesamte Betriebssystem für jede neue CPU neu zu schreiben, konnte man den größten Teil des Codes behalten und nur kleine, hardware-spezifische Teile austauschen. Diese Mischung — größtenteils gemeinsamer Code, kleine maschinenabhängige Ecken — war der Durchbruch, der Unix verbreitete.

Die Kernideen, die C schnell machen

C‑Performance ist kein Zauber — sie folgt daraus, wie direkt C das abbildet, was der Computer tut, und wie wenig „zusätzliche Arbeit“ zwischen deinem Code und der CPU liegt.

Was die Kompilierung produziert

C wird typischerweise kompiliert. Das heißt: du schreibst Quellcode, und ein Compiler übersetzt ihn in Maschinencode — die Rohinstruktionen, die der Prozessor ausführt.

In der Praxis produziert der Compiler eine ausführbare Datei (oder Objektdateien, die später gelinkt werden). Der entscheidende Punkt ist, dass das Ergebnis nicht zeilenweise zur Laufzeit interpretiert wird — es liegt bereits in der Form vor, die die CPU versteht, was Overhead reduziert.

Vorhersehbare Steuerung, geringer Overhead

C bietet einfache Bausteine: Funktionen, Schleifen, Ganzzahlen, Arrays und Zeiger. Weil die Sprache klein und explizit ist, kann der Compiler oft geradlinigen Maschinencode erzeugen.

Normalerweise gibt es keine verpflichtende Laufzeit, die im Hintergrund Dinge macht wie Objektverfolgung, versteckte Prüfungen oder komplexe Metadatenverwaltung. Wenn du eine Schleife schreibst, bekommst du in der Regel eine Schleife. Wenn du auf ein Array zugreifst, bekommst du meist direkten Speicherzugriff. Diese Vorhersehbarkeit ist ein wichtiger Grund, warum C in performance-kritischen Teilen gut abschneidet.

Manuelle Speicherverwaltung: Kontrolle mit Konsequenzen

C verwendet manuelle Speicherverwaltung, d. h. dein Programm fordert Speicher explizit an (z. B. mit malloc) und gibt ihn explizit frei (z. B. mit free). Das existiert, weil Systemsoftware oft feinkörnige Kontrolle darüber braucht, wann Speicher alloziert wird, wie viel und wie lange — mit minimalem versteckten Overhead.

Der Kompromiss ist klar: mehr Kontrolle kann mehr Geschwindigkeit und Effizienz bedeuten, aber es bringt auch Verantwortung. Vergisst du, Speicher freizugeben, gibst du ihn zweimal frei oder verwendest Speicher nach dem Freigeben, können Bugs schwerwiegend und sicherheitskritisch sein.

C in Betriebssystemen: Kernel, Treiber und Kernbibliotheken

Betriebssysteme sitzen an der Grenze zwischen Software und Hardware. Der Kernel muss Speicher verwalten, die CPU planen, Interrupts behandeln, mit Geräten sprechen und Systemaufrufe bereitstellen, auf die alles andere angewiesen ist. Diese Aufgaben sind nicht abstrakt — sie bedeuten, bestimmte Speicheradressen zu lesen und zu schreiben, mit CPU‑Registern zu arbeiten und auf Ereignisse zu reagieren, die zu ungünstigen Zeiten eintreffen.

Warum Kernel und Treiber niedrigen Zugriff brauchen

Gerätetreiber und Kernel brauchen eine Sprache, die ausdrücken kann „genau das tun“ ohne versteckte Arbeit. In der Praxis heißt das:

- Präzise Kontrolle über Speicherlayout (Strukturen, die hardwaredefinierte Formate abbilden)

- Direkte Zeigermanipulation beim Mapping von Geräte‑Speicher oder beim Aufbau von Seitentabellen

- Fähigkeit, mit Interrupts und Concurrency‑Primitiven zu interagieren

- Vorhersehbare Aufrufkonventionen und minimale Laufzeitanforderungen

C passt gut, weil sein Kernmodell nah an der Maschine ist: Bytes, Adressen und einfache Kontrollflüsse. Es gibt keine Pflichtlaufzeit, keinen Garbage Collector und kein Objektmodell, das der Kernel zuerst hosten müsste, bevor er bootet.

C als Default für Kernel und Kernbibliotheken

Unix und frühe Systeme popularisierten den von Ritchie mitgeprägten Ansatz: den Großteil des OS in einer portablen Sprache implementieren, dabei die hardware‑spezifische Kante dünn halten. Viele moderne Kernel folgen diesem Muster. Selbst dort, wo Assembler nötig ist (Bootcode, Kontextwechsel), übernimmt C meist den Großteil der Implementierung.

C dominiert auch in Kernsystembibliotheken — Komponenten wie die Standard-C‑Bibliotheken, grundlegende Netzwerkcode-Stücke und niedrigstufige Laufzeitkomponenten, von denen höhere Sprachen oft abhängen. Wenn du Linux, BSD, macOS, Windows oder ein RTOS benutzt hast, hast du fast sicher C‑Code verwendet, auch wenn dir das nicht bewusst war.

Warum Teams C hier weiterhin vertrauen

C ist in der Betriebssystemarbeit weniger Nostalgie als Ingenieursökonomie:

- Stabile Toolchains: Compiler, Linker, Debugger und Profiler sind ausgereift und gut verstanden

- Portabilität: dieselbe C‑Codebasis kann auf neue CPUs und Boards gebracht werden mit überschaubarem Aufwand

- Klares Hardware‑Mentalmodell: es ist einfacher zu verstehen, was der Compiler erzeugt und wie sich Code unter engen Randbedingungen verhält

Andere Sprachen existieren — C bleibt die Basis

Rust, C++ und andere Sprachen werden in Teilen von Betriebssystemen eingesetzt und können echte Vorteile bringen. Dennoch bleibt C das gemeinsame Minimum: die Sprache, in der viele Kernel geschrieben sind, die die meisten niedrigstufigen Schnittstellen erwarten und mit der andere Systemsprachen interagieren müssen.

C in Embedded‑Geräten: geringer Footprint, vorhersehbare Kontrolle

Code portabel halten

Erhalten Sie einen Quellcode-Export, wenn Sie bereit sind, den Stack zu übernehmen.

„Embedded“ meint meist Computer, an die man nicht als Computer denkt: Mikrocontroller in Thermostaten, Smart Speakern, Routern, Autos, Medizinprodukten, Fabriksensoren und zahllosen Haushaltsgeräten. Diese Systeme führen oft eine Aufgabe jahrelang aus, still, mit engen Kosten-, Leistungs- und Speichergrenzen.

Die Beschränkungen, mit denen Embedded‑Teams leben

Viele Embedded‑Ziele haben Kilobytes (nicht Gigabytes) RAM und begrenzten Flash‑Speicher für Code. Manche laufen auf Batterien und müssen die meiste Zeit schlafen. Andere haben Echtzeit‑Deadlines — wird eine Motorsteuerung um wenige Millisekunden zu spät ausgeführt, kann die Hardware fehlerhaft reagieren.

Diese Beschränkungen formen jede Entscheidung: wie groß das Programm ist, wie oft es aufwacht und ob sein Timing vorhersehbar ist.

Warum C so gut passt

C erzeugt oft kleine Binaries mit minimalem Laufzeit‑Overhead. Es gibt keine nötige virtuelle Maschine, und dynamische Allokation lässt sich häufig ganz vermeiden. Das ist wichtig, wenn Firmware in begrenzte Flashgrößen passen oder garantieren muss, dass das Gerät nicht unerwartet „pausiert".

Gleich wichtig ist, dass C das Sprechen mit Hardware vereinfacht. Embedded‑Chips bieten Peripherie — GPIOs, Timer, UART/SPI/I2C — über memory-mapped Register an. Cs Modell passt natürlich dazu: du kannst spezifische Adressen lesen und schreiben, einzelne Bits kontrollieren und das mit sehr wenig Abstraktion dazwischen tun.

Häufige Muster in echten Projekten

Viel Embedded‑C ist entweder:

- Bare‑metal: kein Betriebssystem, nur Startup‑Code, eine main‑Schleife und Interrupt‑Handler.

- RTOS‑basiert: ein kleines Echtzeit‑OS, in dem C‑Tasks mit Queues, Semaphoren und Timern kooperieren.

In beiden Fällen siehst du Code um Hardware‑Register (oft als volatile markiert), feste Puffergrößen und sorgfältiges Timing. Dieser „nah an der Maschine“-Stil ist genau der Grund, warum C die Standardwahl für Firmware bleibt, die klein, stromsparend und zuverlässig unter Deadlines sein muss.

C in performanzkritischer Software: wo Geschwindigkeit sich lohnt

„Performanzkritisch“ heißt: Zeit und Ressourcen sind Teil des Produkts — Millisekunden beeinflussen die Nutzererfahrung, CPU‑Zyklen die Serverkosten, Speicher darüber, ob ein Programm überhaupt hineinpasst. In solchen Bereichen ist C oft die Default‑Option, weil Teams so das Datenlayout im Speicher, die Arbeitsplanung und die Optimierungsmöglichkeiten des Compilers kontrollieren können.

Wo C‑Speed in der Praxis zählt

C findest du häufig im Kern von Systemen mit hohem Volumen oder engen Latenzbudgets:

- Datenbanken und Storage‑Engines (Indexierung, Caching, Kompression, Query‑Ausführung)

- Codecs für Audio/Video und Bildverarbeitung (Encode/Decode‑Schleifen, die Milliardenfach laufen)

- Netzwerke (Paketverarbeitung, Proxies, TLS‑Primitive, Event‑Loops)

- Game‑Engines (Frame‑Budgets, Physik, Asset‑Streaming)

- HPC‑Bausteine (numerische Kerne, vektorisierte Routinen, angepasste Speicherallokatoren)

Diese Domänen sind selten überall „schnell“ — meist dominieren spezifische innere Schleifen die Laufzeit.

Der „Hot‑Path“: optimiere die 5 %, die 95 % kosten

Teams schreiben selten ein ganzes Produkt in C, nur um schneller zu werden. Stattdessen werden Profile erstellt, der Hot‑Path gefunden (kleiner Teil des Codes, der die meiste Zeit kostet) und dieser optimiert.

C hilft, weil Hot‑Paths oft von low‑level Details begrenzt werden: Speicherzugriffsmuster, Cache‑Verhalten, Branch‑Prediction und Allokations‑Overhead. Wenn du Datenstrukturen abstimmen, unnötige Kopien vermeiden und Allokation kontrollieren kannst, sind dramatische Beschleunigungen möglich — ohne den Rest der Anwendung anzufassen.

Zusammenarbeit mit höheren Sprachen: Extensions und FFI

Moderne Produkte sind oft „gemischt-sprachig": Python, Java, JavaScript oder Rust für den Großteil, und C für den kritischen Kern.

Gängige Integrationsansätze sind:

- Native Extensions (z. B. Python C‑Extensions, Node‑API Addons)

- FFI (Foreign Function Interface), bei dem eine Sprache kompilierte C‑Funktionen über eine stabile ABI aufruft

- C‑Bibliotheken als Shared Dependencies, die von vielen Laufzeiten genutzt werden (eine schnelle Implementierung, viele Aufrufer)

Dieses Modell hält Entwicklung praktisch: schnelle Iteration in einer hohen Sprache und vorhersehbare Performance dort, wo sie zählt. Der Nachteil sind die Grenzen — Datenkonvertierung, Ownership‑Regeln und Fehlerbehandlung — denn das Überschreiten der FFI‑Schnittstelle muss effizient und möglichst sicher erfolgen.

Portabilität und Standards: warum C gut reist

Erst planen, dann sicher bauen

Definieren Sie Funktionen und Datenmodelle vor dem Code, um spätere Nacharbeiten zu vermeiden.

Ein Grund, warum C sich so schnell verbreitete, ist, dass es reist: dieselbe Kernsprache kann auf sehr unterschiedlichen Maschinen implementiert werden, von winzigen Mikrocontrollern bis zu Supercomputern. Diese Portabilität ist kein Zufall — sie folgt gemeinsamen Standards und einer Kultur, danach zu schreiben.

Wie Standards aus „C“ überall dasselbe machen

Frühe C‑Implementierungen unterschieden sich zwischen Anbietern, was das Teilen von Code erschwerte. Der große Wandel kam mit ANSI C (auch C89/C90 genannt) und später ISO C (Revisionen wie C99, C11, C17 und C23). Du musst Versionsnummern nicht auswendig kennen; wichtig ist, dass ein Standard eine öffentliche Vereinbarung darüber ist, was Sprache und Standardbibliothek tun.

Was ein C‑Standard konkret liefert

Ein Standard stellt bereit:

- Konsistente Regeln für die Sprache (Typen, Operatoren, Kontrollfluss)\n- Eine Standardbibliothek mit vorhersehbarem Verhalten (I/O, Strings, Mathe, Speicherallokation)\n- Eine Basis, die Compilerautoren implementieren und auf die Teams bauen können

Deshalb kann Code, der sich am Standard orientiert, oft überraschend einfach zwischen Compilern und Plattformen bewegt werden.

Wo Portabilität in der Praxis bricht

Portabilitätsprobleme entstehen meist durch Annahmen, die der Standard nicht garantiert, darunter:

- Undefined behavior: Code, den der Compiler beliebig behandeln darf (inkl. „scheint zu funktionieren, bis ein Build bricht“). Klassische Beispiele: Überschreiten von Array‑Grenzen oder Gebrauch uninitialisierter Werte.

- Annahmen über Größen:

intist nicht garantiert 32‑Bit, und Pointergrößen variieren. Wenn dein Programm stille Annahmen über exakte Größen macht, kann es beim Wechsel des Targets versagen. - Plattform‑spezifische APIs: OS‑spezifische Funktionen sind manchmal nötig, begrenzen aber die Ausführbarkeit des Codes.

Praktischer Tipp: „Standard‑first“, dann tunen

Ein guter Default ist, die Standardbibliothek zu bevorzugen und nicht‑portable Stellen hinter kleinen, klar benannten Wrappern zu halten.

Kompiliere außerdem mit Flags, die dich zu portablem, wohl definiertem C drängen. Übliche Optionen sind z. B. -std=c11 und Warnflags wie -Wall -Wextra.

Diese Kombination — Standard‑first‑Code plus strikte Builds — tut mehr für Portabilität als jede „clevere" Tricklösung.

Der schwierige Teil: Zeiger, Speicher und typische Fehlerklassen

C’s Kraft ist auch seine scharfe Kante: es erlaubt Arbeiten nahe am Speicher. Das ist ein Grund für Geschwindigkeit und Flexibilität — und auch dafür, dass Anfänger (und müde Experten) Fehler machen, die andere Sprachen verhindern.

Zeiger, erklärt mit „Adressen zu Kästchen"

Stell dir den Speicher deines Programms als eine lange Straße nummerierter Briefkästen vor. Eine Variable ist ein Kästchen, das etwas enthält (z. B. eine Ganzzahl). Ein Zeiger ist nicht das Ding selbst — er ist die Adresse auf einem Zettel, der dir sagt, welches Kästchen du öffnen sollst.

Das ist nützlich: du kannst die Adresse weiterreichen statt den Inhalt zu kopieren, und du kannst auf Arrays, Puffer, Structs oder sogar Funktionen zeigen. Ist die Adresse jedoch falsch, öffnest du das falsche Kästchen.

Häufige Risiken

- Buffer overflows: Überschreiben des Endes eines Puffers (wie zusätzliche Briefe in Briefkasten #10 stecken und in #11 überlaufen). Das kann Programme zum Absturz bringen oder ausgenutzt werden.

- Use-after-free: Speicher freigeben und später einen Zeiger verwenden, der noch die alte Adresse „erinnert“, obwohl dieser Speicher inzwischen neu vergeben sein kann.

- Integer overflows: Arithmetik, die umläuft (z. B. eine Größenberechnung wird kleiner als beabsichtigt), was zu zu kleiner Allokation und anschließender Pufferüberläufe führen kann.

Warum diese Bugs wichtig sind

Solche Fehler zeigen sich als Abstürze, stille Datenkorruption und Sicherheitslücken. In Systemcode — wo C oft eingesetzt wird — können diese Fehler alles darüberliegende beeinträchtigen.

Eine ausgewogene Sicht

C ist nicht „unsicher per Default“. Es ist permissiv: der Compiler geht davon aus, dass du genau meinst, was du schreibst. Das ist großartig für Performance und low‑level Kontrolle, macht C aber leicht missbrauchbar, wenn du nicht diszipliniert arbeitest und passende Werkzeuge einsetzt.

C in der Praxis sicherer machen

C gibt direkte Kontrolle, verzeiht aber selten Fehler. Die gute Nachricht: „sicheres C“ ist weniger Magie als disziplinierte Praktiken, klare Schnittstellen und Tools, die langweilige Prüfungen übernehmen.

Verteidigende Techniken, die skalieren

Entwirf APIs so, dass falsche Nutzung schwer fällt. Bevorzuge Funktionen, die Puffergrößen zusammen mit Zeigern nehmen, explizite Statuscodes zurückgeben und dokumentieren, wer den allozierten Speicher besitzt.

Bounds‑Checks sollten Routine sein, nicht Ausnahme. Wenn eine Funktion in einen Puffer schreibt, validiere Längen vorab und fehlschlage schnell. Für Speicher‑Ownership: eine einfache Regel — ein Allokator, ein entsprechender Free‑Pfad — und eine klare Vereinbarung, ob Caller oder Callee Ressourcen freigibt.

Tooling: Fehler finden, bevor Nutzer sie sehen

Moderne Compiler können riskante Muster warnen — behandle Warnungen in CI als Fehler. Füge während der Entwicklung Laufzeitprüfungen mit Sanitizern hinzu (AddressSanitizer, UBSan, LeakSanitizer), um Out‑of‑Bounds, Use‑After‑Free, Integer‑Überläufe und andere Gefahren aufzudecken.

Statische Analyse und Linter helfen, Probleme zu finden, die Tests nicht aufdecken. Fuzzing ist besonders effektiv für Parser und Protokollhandler: es erzeugt unerwartete Eingaben, die oft Puffer‑ oder Zustandsmaschinenfehler enthüllen.

Review‑ und Testpraktiken

Code‑Reviews sollten gezielt nach typischen C‑Fehlern suchen: Off‑by‑one, fehlende NUL‑Terminatoren, Signed/Unsigned‑Mischungen, unbehandelte Rückgabewerte und Speicherlecks in Fehlerpfaden.

Tests sind wichtiger, wenn die Sprache dich nicht schützt. Unit‑Tests sind gut; Integrationstests besser; Regressions‑Tests für gefundene Bugs sind am besten.

Sicherere Teilmengen und Richtlinien

Bei sehr hohen Zuverlässigkeitsanforderungen lohnt sich eine restriktive „Subset“-Policy für C und ein geschriebenes Regelwerk (z. B. Pointerarithmetik einschränken, bestimmte Library‑Aufrufe verbieten oder Wrapper verlangen). Entscheidend ist Konsistenz: wähle Regeln, die das Team mit Tools und Reviews durchsetzen kann, nicht bloße Ideale auf Folien.

C vs. andere Sprachen: warum Teams es weiterhin wählen

Kritischen Pfad schnell validieren

Machen Sie aus einer Idee für einen Performance-Hotspot ein funktionierendes Tool, bevor Sie optimieren.

C liegt an einer ungewöhnlichen Schnittstelle: klein genug, um end‑to‑end verstanden zu werden, und nah genug an Hardware und OS‑Grenzen, um die „Klebstoff“-Sprache zu sein, auf die alles andere angewiesen ist. Diese Kombination ist der Grund, warum Teams immer wieder zu C greifen — selbst wenn neuere Sprachen auf dem Papier hübscher aussehen.

C vs C++: unterschiedliche Ziele, komplizierte Kompatibilität, praktisches Mischen

C++ zielte darauf ab, stärkere Abstraktionen (Klassen, Templates, RAII) hinzuzufügen und gleichzeitig größtenteils source‑kompatibel zu C zu bleiben. „Kompatibel“ ist aber nicht „identisch"; C++ hat andere Regeln für implizite Konversionen, Overload‑Resolution und Gültigkeit mancher Deklarationen.

In realen Produkten mischt man oft:

- Niedrigstufige Module bleiben in C wegen stabiler ABIs und einfacher Aufrufkonventionen.

- Höhere Schichten nutzen C++ für Struktur und sichereres Ressourcenmanagement.

Die Brücke ist typischerweise eine C‑API‑Grenze. C++ exportiert Funktionen mit extern "C", um Namensmangling zu vermeiden, und beide Seiten einigen sich auf einfache Datenstrukturen. So kann man inkrementell modernisieren, ohne alles neu zu schreiben.

C vs Rust (auf hohem Niveau): Sicherheit gewinnt, aber Einschränkungen zählen

Rust verspricht Speicher‑Safety ohne GC, unterstützt von starken Tools und einem wachsenden Ökosystem. Für viele Neuprojekte kann es ganze Klassen von Bugs vermeiden (Use‑After‑Free, Datenrennen).

Aber Adoption kostet: Teams sind oft gebunden an bestehende C‑Bibliotheken, Treiber oder Vendor‑SDKs; an Compiler/Debugger, die für bestimmte Targets validiert sind; an Zertifizierungsregime, bei denen Tool‑Reife und Evidenz wichtig sind; oder an langfristige Wartungsanforderungen.

Rust kann mit C interagieren, aber die Grenze erhöht die Komplexität, und nicht jedes Embedded‑Target oder jede Build‑Umgebung ist gleichermaßen gut unterstützt.

Warum Teams C weiterhin wählen: Legacy, Zertifizierung, Toolchains, Einfachheit

Ein Großteil des fundamentalen Codes der Welt liegt in C, und ein Rewrite ist riskant und teuer. C passt außerdem in Umgebungen, in denen man vorhersehbare Binärdateien, minimale Laufzeit‑Annahmen und breite Compilerverfügbarkeit braucht — von winzigen Mikrocontrollern bis zu Mainstream‑CPUs.

Entscheidungen nach Zwängen, nicht nach Trends

Wenn du maximale Reichweite, stabile Schnittstellen und bewährte Toolchains brauchst, ist C oft eine rationale Wahl. Wenn Sicherheit höchste Priorität hat und die Rahmenbedingungen es erlauben, kann eine neuere Sprache sinnvoll sein. Die beste Entscheidung beginnt meist mit Zielhardware, Tooling und langfristiger Wartung — nicht mit dem aktuellen Hype.

Wie die Zukunft aussieht (und wie man C heute lernt)

C verschwindet nicht, aber sein Schwerpunkt wird klarer. Es wird dort weiter gedeihen, wo direkte Kontrolle über Speicher, Timing und Binärdateien zählt — und Boden verlieren, wo Sicherheit und schnelle Iteration wichtiger sind als das letzte Mikrosekunden‑Tuning.

Bereiche, in denen C stark bleibt

C bleibt wahrscheinlich die Default‑Wahl für:

- Kernel- und low‑level OS‑Arbeit (Scheduler, Speicherverwaltung, Dateisysteme)

- Treiber und hardwarenahe Codeabschnitte, in denen Registermapping und Interrupts entscheidend sind

- Embedded‑Systeme mit engen RAM/Flash‑Limits und Echtzeitanforderungen

- Kernbibliotheken und Laufzeiten (Kompression, Kryptoprimitive, VMs, Multimedia‑Codecs) mit stabilen ABIs und hoher Portabilität

Diese Bereiche entwickeln sich langsam, haben enorme Legacy‑Codebasen und belohnen Ingenieure, die Bytes, Aufrufkonventionen und Fehlerzustände verstehen.

Bereiche, in denen C schrumpfen könnte (und warum)

Für neue Anwendungsentwicklung bevorzugen viele Teams Sprachen mit stärkeren Sicherheitsgarantien und reicheren Ökosystemen. Speicherfehler sind teuer, und moderne Produkte priorisieren oft schnelle Lieferung, Nebenläufigkeit und sichere Defaults. Selbst in der Systemprogrammierung wandern einige neue Komponenten in sicherere Sprachen — während C als „Betonboden" bestehen bleibt, mit dem sie interagieren.

Ein moderner Workflow‑Hinweis: C im größeren Produkt

Auch wenn der low‑level Kern in C ist, brauchen Teams meist umgebende Software: ein Web‑Dashboard, einen API‑Service, ein Device‑Management‑Portal, interne Tools oder eine kleine Mobile‑App für Diagnosen. Diese Schicht ist oft dort, wo Iterationsgeschwindigkeit zählt.

Wenn du diese höheren Schichten schnell entwickeln willst, ohne die gesamte Pipeline neu aufzubauen, kann Koder.ai helfen: eine Vibe‑Coding‑Plattform, mit der du Web‑Apps (React), Backends (Go + PostgreSQL) und Mobile‑Apps (Flutter) per Chat erstellen kannst — praktisch, um ein Admin‑UI, Log‑Viewer oder Flotten‑Management‑Tool zu prototypen. Planning‑Modus und Source‑Code‑Export machen es einfach, den Prototyp später zu übernehmen.

Wie man C heute praktisch lernt

Beginne mit den Grundlagen, aber lerne sie so, wie Profis C einsetzen:

- Syntax + Datenmodell: Ganzzahlen, Arrays, Structs, Zeiger‑Basics und wie sie im Speicher abgebildet werden.

- Build‑Tools: Kompilieren und Linken, Header‑Organisation und ein einfaches Makefile (später CMake).

- Debugging: Mit gdb/lldb schrittweise durch Code gehen; Backtraces lesen.

- Sicherheitsgewohnheiten: Mit Warnungen kompilieren, AddressSanitizer/UBSan nutzen und kleine Tests schreiben.

Wenn du mehr systemspezifische Artikel und Lernpfade suchst, stöbere in /blog.

FAQ

Warum ist C in der modernen Informatik noch relevant?

C bleibt wichtig, weil es niedrige Kontrolle (Speicher, Datenlayout, Hardwarezugriff) mit breiter Portabilität verbindet. Diese Kombination macht es praktisch für Code, der Maschinen booten, unter engen Randbedingungen laufen oder vorhersehbare Performance liefern muss.

Wo wird C heute am häufigsten eingesetzt?

C dominiert weiterhin in:

- Betriebssystemen (Kernel, Treiber, Kernbibliotheken)

- Firmware/Embedded (Mikrocontroller, RTOS, Geräteansteuerung)

- Performance-Hotspots innerhalb größerer Produkte (Codecs, Datenbanken, Netzwerke, Game-Engines)

Selbst wenn der Großteil einer Anwendung in einer höheren Sprache geschrieben ist, basieren viele kritische Fundamente oft auf C.

Wofür hat Dennis Ritchie C entworfen und warum war das für Unix wichtig?

Dennis Ritchie entwarf C bei Bell Labs, um Systemsoftware praktisch zu machen: nahe an der Maschine, aber portabler und besser wartbar als Assembler. Ein wichtiger Beweis war das Umbauen von Unix in C, was Unix deutlich einfacher auf neue Hardware zu bringen und über die Zeit zu erweitern machte.

Was bedeutet „C ist portabel“ genau?

Portabilität bedeutet hier praktisch: du kannst denselben C-Quellcode auf unterschiedlichen CPUs/OS kompilieren und mit minimalen Änderungen konsistentes Verhalten erwarten. Meist bleibt der Großteil des Codes gemeinsam, und hardware-/plattform-spezifische Teile werden hinter kleinen Modulen oder Wrappern isoliert.

Warum ist C oft schneller (oder vorhersehbarer) als höherstufige Sprachen?

C ist oft schneller, weil es den Maschinenbetrieb direkt abbildet und in der Regel wenig verpflichtenden Laufzeit-Overhead hat. Compiler erzeugen für Schleifen, Arithmetik und Speicherzugriffe oft sehr geradlinigen Maschinencode, was in engen inneren Schleifen große Vorteile bringt.

Was ist manuelle Speicherverwaltung in C und warum setzen Teams sie noch ein?

Viele C‑Programme verwenden manuelle Speicherverwaltung:

- Speicher explizit anfordern (z. B.

malloc) - Speicher explizit freigeben (z. B.

free)

Das erlaubt präzise Kontrolle darüber, und Speicher genutzt wird — wertvoll in Kernel-, Embedded- und Performance‑kritischen Teilen. Der Nachteil: Fehler können zu Abstürzen oder Sicherheitsproblemen führen.

Warum werden Betriebssysteme und Treiber oft in C geschrieben?

Kernel und Treiber benötigen:

- genaue Kontrolle über Speicherlayout (hardwaredefinierte Strukturen)

- direkten Einsatz von Zeigern für memory-mapped I/O und Seitentabellen

- minimale Laufzeit‑Annahmen (kein VM/GC nötig, bevor das System bootet)

C passt, weil es niedrigen Zugriff bietet, stabile Toolchains hat und vorhersehbare Binärdateien erzeugt.

Warum ist C die Standardwahl für Embedded‑Geräte?

Embedded-Ziele haben oft sehr begrenzten RAM/Flash, strenge Energiegrenzen und manchmal Echtzeitvorgaben. C eignet sich, weil es kleine Binärdateien erzeugt, schweren Laufzeit‑Overhead vermeidet und direkt mit Peripherie über memory-mapped Register und Interrupts kommunizieren kann.

Wie nutzen Teams C für Performance, ohne das ganze Produkt in C zu schreiben?

Das übliche Vorgehen ist, den Großteil des Produkts in einer höheren Sprache zu belassen und nur den Hot Path in C zu implementieren. Integrationswege sind z. B.:

- Native Extensions

- FFI-Aufrufe in eine kompilierte C‑Bibliothek

- Gemeinsame C‑Bibliotheken als Abhängigkeiten

Wichtig sind effiziente Grenzen und klare Regeln zu Besitz/Fehlerbehandlung.

Wie kann man C‑Code in realen Projekten sicherer machen?

„Sichereres C“ ist meistens eine Kombination aus Disziplin und Tools:

- Mit strengen Warnungen kompilieren (z. B.

-Wall -Wextra) und sie ernst nehmen - Sanitizer in Tests verwenden (ASan/UBSan/LSan)

- Längen mit Zeigern übergeben und Grenzen prüfen

- Klare Ownership‑Regeln definieren (wer allokiert/freed)

- Statische Analyse und Fuzzing einsetzen

Das verhindert viele typische Fehlerklassen, eliminiert aber nicht alle Risiken.