Welches Problem die App löst (und wer sie nutzt)

Eine Geschäftsannahme ist eine Überzeugung, nach der dein Team handelt, bevor sie vollständig bewiesen ist. Sie kann sich auf Folgendes beziehen:

- Markt: „Dieses Segment wächst schnell genug, um unser Produkt zu tragen.“

- Kunde: „Nutzer wechseln von Tabellen, wenn die Einrichtung unter 10 Minuten dauert.“

- Preisgestaltung: „Teams zahlen 49$/Monat für dieses Feature-Set.“

- Betrieb: „Der Support kann das Onboarding mit einer Person bewältigen.“

- Risiken: „Dieser Ansatz löst keine Compliance-Probleme aus.“

Solche Annahmen tauchen überall auf—Pitch-Decks, Roadmap-Diskussionen, Sales-Calls, Flurgespräche—und verschwinden dann still.

Warum Teams Annahmen verlieren

Die meisten Teams verlieren Annahmen nicht, weil sie egal sind. Sie gehen verloren, weil Dokumentation driftet, Leute Rollen wechseln und Wissen tribal wird. Die „aktuelle Wahrheit“ verteilt sich über ein Doc, einen Slack-Thread, ein paar Tickets und das Gedächtnis einer Person.

Dann wiederholen Teams dieselben Debatten, führen dieselben Experimente erneut durch oder treffen Entscheidungen, ohne zu realisieren, was noch ungeprüft ist.

Gewünschte Ergebnisse

Eine einfache App zur Annahmenverfolgung gibt dir:

- Klarheit: was ihr glaubt, was bewiesen ist und was noch offen ist

- Verantwortlichkeit: wer die Annahme betreut und wann sie zuletzt geprüft wurde

- Schnelleres Lernen: engere Schleifen zwischen Hypothesen, Experimenten und Evidenz

- Weniger Wiederaufwärmen von Diskussionen: ein gemeinsames Protokoll reduziert zirkuläre Gespräche

Wer sie nutzt (und wie groß sie sein muss)

Product Manager, Gründer:innen, Growth-Teams, Researcher und Sales-Leads profitieren—eigentlich jede:r, die Wetten eingeht. Beginne mit einem leichten „Annahmen-Log“, das sich einfach aktuell halten lässt, und erweitere Funktionen nur, wenn die Nutzung es verlangt.

Definiere das Kern-Datenmodell

Bevor du Bildschirme entwirfst oder einen Tech-Stack wählst, entscheide, welche „Dinge“ deine App speichern wird. Ein klares Datenmodell hält das Produkt konsistent und ermöglicht später Reporting.

Kernobjekte (klein halten)

Beginne mit fünf Objekten, die abbilden, wie Teams Ideen validieren:

- Assumption: die Behauptung, die ihr für wahr haltet (bis sie widerlegt ist)

- Evidence: Links, Notizen, Dateien oder Metriken, die eine Annahme stützen oder schwächen

- Experiment: ein strukturierter Test (Interview, Umfrage, A/B-Test, Prototyp), der Evidenz erzeugt

- Review: ein periodischer Checkpoint, bei dem jemand den aktuellen Status/Confidence bestätigt

- Comment: leichte Diskussion, an eine Annahme (und optional an Evidenz/Experimente) gebunden

Empfohlene Felder für eine Annahme

Ein Annahmen-Datensatz sollte schnell erstellbar, aber aussagekräftig genug sein:

- Statement (erforderlich): ein einzelner, testbarer Satz

- Category (erforderlich): z. B. Kunde, Problem, Pricing, Channel, Machbarkeit

- Owner (erforderlich): wer es vorantreibt

- Confidence (erforderlich): low/medium/high (oder 1–5)

- Status (erforderlich): draft, active, validated, invalidated, archived

Füge Zeitstempel hinzu, damit die App Review-Workflows antreiben kann:

- Created at, Last updated at (systemgeneriert)

- Last reviewed at, Next review date (editierbar oder abgeleitet)

Beziehungen

Modelliere den Validierungsfluss:

- One Assumption → many Evidence items

- One Assumption → many Experiments

- One Assumption → many Reviews and Comments

Erforderlich vs. optional (Reibung reduzieren)

Mache nur das Nötigste verpflichtend: statement, category, owner, confidence, status. Lass Details wie Tags, Impact und Links optional, damit Leute Annahmen schnell protokollieren können—und sie später verbessern, wenn Evidenz eintrifft.

Status, Confidence und Review-Regeln festlegen

Damit dein Annahmen-Log nützlich bleibt, braucht jeder Eintrag sofort erkennbare Bedeutung: wo er im Lebenszyklus steht, wie stark der Glauben ist und wann er wieder geprüft werden soll. Diese Regeln verhindern außerdem, dass Teams leise Vermutungen als Fakten behandeln.

Ein einfacher, konsistenter Lebenszyklus

Verwende für jede Annahme denselben Status-Flow:

Draft → Active → Validated / Invalidated → Archived

- Draft: erfasst, aber noch nicht als etwas vereinbart, das verfolgt werden soll.

- Active: das Team verlässt sich darauf (oder könnte sich darauf verlassen) und beabsichtigt zu testen oder zu überwachen.

- Validated: Evidenz erfüllt euren Mindeststandard (siehe unten).

- Invalidated: Evidenz widerspricht klar; behalte sie für Learnings.

- Archived: nicht mehr relevant (Produkt/Markt/Strategie hat sich geändert).

Confidence-Scoring (1–5)

Wähle eine 1–5-Skala und definiere sie in einfachen Worten:

- Spekulation (keine Evidenz)

- Schwaches Signal (ein Datenpunkt)

- Etwas Unterstützung (mehrere Signale, noch Lücken)

- Starke Unterstützung (konsequente Evidenz, wenig Zweifel)

- Sehr stark (wiederholbare Ergebnisse, stabil über Zeit)

Mache „Confidence“ abhängig von der Stärke der Evidenz—nicht davon, wie sehr sich jemand etwas wünscht.

Entscheidungsrelevanz: Was zuerst validieren

Füge Decision impact: Low / Medium / High hinzu. High-Impact-Annahmen sollten früher getestet werden, weil sie Preisgestaltung, Positionierung, Go-to-Market oder größere Build-Entscheidungen formen.

Definiere, was „validated“ bedeutet

Schreibe pro Annahme explizite Kriterien: welches Ergebnis zählt und welche minimale Evidenz benötigt wird (z. B. 30+ Umfrageantworten, 10+ Verkaufsgespräche mit konsistentem Muster, A/B-Test mit vordefiniertem Erfolgskriterium, 3 Wochen Retention-Daten).

Regeln für Nachprüfung und Review

Setze automatische Review-Trigger:

- Review High-impact Annahmen alle 2–4 Wochen

- Review, wenn Kernmetriken sich ändern (Conversion, Churn, CAC)

- Review nach großen Produkt- oder Marktveränderungen

So wird verhindert, dass „validated“ zu „für immer wahr“ wird.

Entwerfe die User Experience und wichtige Bildschirme

Eine Annahmen-Tracking-App funktioniert, wenn sie sich schneller anfühlt als eine Tabelle. Designe um die wenigen Aktionen, die Leute jede Woche wiederholen: eine Annahme hinzufügen, aktualisieren, belegen, und das nächste Review-Datum setzen.

Primäre Flows (ein Klick)

Strebe eine enge Schleife an:

- Annahme erstellen: starte von einer Vorlage (Problem, Kunde, Pricing, Channel) mit sinnvollen Defaults.

- Status aktualisieren: schnell zwischen Draft → Active → Validated/Invalidated wechseln, mit optionaler Notiz.

- Evidenz anhängen: Datei per Drag & Drop hochladen oder Link einfügen und dann an eine oder mehrere Annahmen taggen.

- Review planen: setze das „Next review“ direkt nach einer Änderung, damit nichts veraltet.

Kernbildschirme, die du wirklich brauchst

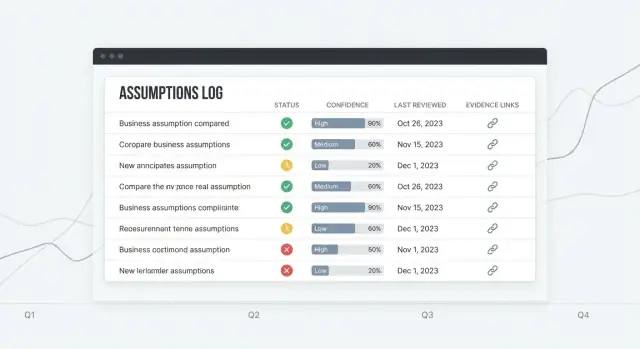

Assumptions-Liste sollte die Homebase sein: eine lesbare Tabelle mit klaren Spalten (Status, Confidence, Owner, Last reviewed, Next review). Füge eine prominente „Quick add“-Zeile hinzu, damit neue Einträge kein volles Formular erfordern.

Assumption-Detail ist der Ort, an dem Entscheidungen getroffen werden: eine kurze Zusammenfassung oben, dann eine Timeline von Updates (Statuswechsel, Confidence-Änderungen, Kommentare) und ein dediziertes Evidenz-Panel.

Evidence-Library hilft, Learnings wiederzuverwenden: Suche nach Tag, Quelle und Datum und verknüpfe Evidenz mit mehreren Annahmen.

Dashboard sollte beantworten: „Was braucht Aufmerksamkeit?“ Zeige anstehende Reviews, kürzlich geänderte Annahmen und High-Impact-Items mit niedriger Confidence.

Filtern, Suchen und Unordnung kontrollieren

Mach Filter persistent und schnell: Category, Owner, Status, Confidence, Last reviewed date. Reduziere Unordnung mit Templates, Standardwerten und progressiver Offenlegung (erweiterte Felder erst anzeigen, wenn nötig).

Barrierefreiheit-Grundlagen

Nutze hohen Kontrast, klare Labels und keyboard-freundliche Controls. Tabellen sollten Zeilenfokus, sortierbare Header und lesbaren Abstand unterstützen—insbesondere für Status- und Confidence-Badges.

Wähle einen praktikablen Tech-Stack

Eine Annahmen-Tracking-App besteht hauptsächlich aus Formularen, Filtern, Suche und einem Audit-Trail. Gute Nachrichten: Du kannst Wert mit einem einfachen, verlässlichen Stack liefern und deine Energie auf Workflow-Funktionen (Review-Regeln, Evidenz, Entscheidungen) statt Infrastruktur verwenden.

Ein unkomplizierter Stack, der funktioniert

Eine verbreitete, praktische Zusammenstellung ist:

- Frontend: React, oft via Next.js (schnelle UI, Routing, serverseitiges Rendering wenn nützlich)

- Backend: Node.js (Express/Nest) oder Python (FastAPI/Django)

- Datenbank: Postgres

Wenn dein Team bereits eine dieser Technologien beherrscht, wähle diese—Konsistenz schlägt Neuheit.

Wenn du schnell prototypen willst, ohne alles manuell zu verdrahten, kann eine Vibe-Coding-Plattform wie Koder.ai dich schnell zu einem internen Tool bringen: beschreibe dein Datenmodell und deine Bildschirme im Chat, iteriere im Planning Mode und generiere eine React-UI mit einem produktionsbereiten Backend (Go + PostgreSQL), das du später als Quellcode exportieren kannst, falls du die Wartung selbst übernehmen willst.

Warum Postgres gut passt

Postgres handhabt die vernetzte Natur der Annahmenverwaltung gut: Annahmen gehören zu Workspaces, haben Owner, verknüpfen sich mit Evidenz und Experimenten. Eine relationale DB hält diese Verknüpfungen zuverlässig.

Sie ist außerdem indexfreundlich für Queries, die du oft ausführen wirst (Status, Confidence, fällig für Review, Tag, Owner) und auditfreundlich, wenn du Versionshistorie und Änderungsprotokolle hinzufügst. Du kannst Change-Events in einer separaten Tabelle ablegen und für Reports abfragbar halten.

Hosting und Ops schlank halten

Setze auf Managed-Services:

- Managed Postgres (automatische Backups, Upgrades, später Read-Replicas)

- App-Hosting für Next.js und deine API (oder eine einzelne Full-Stack Next.js-App)

Das reduziert das Risiko, dass „die Sache am Laufen halten“ deine Woche auffrisst.

Wenn du die Infrastruktur früh nicht selbst betreiben willst, kann Koder.ai auch Deployment und Hosting übernehmen, plus Komfortfunktionen wie Custom Domains und Snapshots/Rollback, während du Workflows mit echten Nutzern verfeinerst.

API-Ansatz: REST zuerst

Starte mit REST-Endpunkten für CRUD, Suche und Aktivitätsfeeds. Das ist leicht zu debuggen und zu dokumentieren. Ziehe GraphQL nur in Betracht, wenn du wirklich komplexe, clientseitig getriebene Queries über viele verknüpfte Objekte brauchst.

Klare Umgebungen verwenden

Plane von Anfang an drei Umgebungen:

- Local (Entwickler-Maschinen)

- Staging (sicherer Ort, um Imports, Benachrichtigungen und Berechtigungen zu testen)

- Production (echte Daten, strengere Zugriffe, Monitoring)

Dieses Setup unterstützt die Verfolgung von Geschäftsannahmen, ohne dein Annahmen-Log zu überentwickeln.

Authentifizierung, Rollen und Workspaces implementieren

Bauen und Credits verdienen

Erhalte Credits, indem du teilst, was du auf Koder.ai gebaut hast, oder Kolleg:innen einlädst.

Wenn dein Annahmen-Log geteilt wird, muss Zugriffskontrolle langweilig und vorhersehbar sein. Leute sollten genau wissen, wer sehen, bearbeiten oder Änderungen genehmigen kann—ohne das Team zu verlangsamen.

Authentifizierung: einfach starten, SSO hinzufügen wenn nötig

Für die meisten Teams reicht E-Mail + Passwort, um zu starten und zu lernen. Füge Google oder Microsoft SSO hinzu, wenn du größere Organisationen oder strenge IT-Policies erwartest. Wenn du beides unterstützt, lass Admins pro Workspace wählen.

Halte den Login-Surface minimal: Registrierung, Anmeldung, Passwort zurücksetzen und (optional) später erzwungene MFA.

Rollen und Berechtigungen (Admin / Editor / Viewer)

Definiere Rollen einmal und halte sie im ganzen Produkt konsistent:

- Admin: verwaltet Workspace-Einstellungen, Mitglieder, Rollen und Integrationen; kann Datensätze löschen (oder Löschung anfragen).

- Editor: kann Annahmen erstellen und bearbeiten, Evidenz anhängen, Experimente protokollieren und Status/Confidence ändern.

- Viewer: nur Lesezugriff auf Annahmen, Evidenz, Experimentergebnisse und Dashboards.

Führe Berechtigungsprüfungen serverseitig durch (nicht nur in der UI). Wenn du später „Approval“ hinzufügst, behandle es als Berechtigung, nicht als neue Rolle.

Workspaces: Teams, Produkte und Kunden trennen

Ein Workspace ist die Grenze für Daten und Mitglieder. Jede Annahme, jedes Evidenz-Item und Experiment gehört genau einem Workspace, so bleiben Agenturen, Multiplattform-Unternehmen oder Startups mit mehreren Initiativen organisiert und vermeiden versehentliches Teilen.

Einladungen, Offboarding und Mindest-Audit

Verwende E-Mail-Einladungen mit Ablaufzeit. Beim Offboarding Zugriff entfernen, aber Historie intakt lassen: vergangene Änderungen sollten noch den ursprünglichen Akteur zeigen.

Speichere mindestens eine Audit-Spur: wer hat was und wann geändert (User-ID, Timestamp, Objekt, Aktion). Das fördert Vertrauen, Verantwortlichkeit und erleichtert Debugging, wenn Entscheidungen später infrage gestellt werden.

CRUD mit Versionshistorie und Änderungsprotokollen bauen

CRUD ist der Punkt, an dem dein Annahmen-Log vom Dokument zum System wird. Ziel ist nicht nur, Annahmen zu erstellen und zu bearbeiten—sondern jede Änderung nachvollziehbar und rückgängig machbar zu machen.

CRUD-Endpunkte und UI-Aktionen

Unterstütze mindestens folgende Aktionen für Annahmen und Evidenz:

- Erstellen, Ansehen, Bearbeiten, Archivieren (Soft-Delete) und Wiederherstellen von Annahmen

- Evidenz anhängen (Links, Dateien, Notizen) und deren Metadaten bearbeiten

- Status ändern (z. B. Draft → Active → Validated/Invalidated)

Halte diese Aktionen nahe an der Assumption-Detailseite: ein klares „Edit“, ein dediziertes „Change status“ und eine „Archive“-Aktion, die bewusst schwerer zu klicken ist.

Versionierung: Revisionen vs. Append-only-Logs

Du hast zwei praktische Strategien:

-

Vollständige Revisionen speichern (Snapshot bei jedem Speichern). Das macht „vorherige Version wiederherstellen“ unkompliziert.

-

Append-only-Change-Log (Event-Stream). Jede Änderung schreibt ein Event wie „Statement geändert“, „Confidence geändert“, „Evidenz angehängt“. Das ist großartig für Auditing, erfordert aber mehr Arbeit, um alte Zustände wiederherzustellen.

Viele Teams nutzen eine Hybrid-Lösung: Snapshots für größere Änderungen + Events für kleine Aktionen.

Mach History lesbar (nicht nur gespeichert)

Biete eine Timeline auf jeder Annahme an:

- Wer hat was wann geändert

- Eine Diff-Ansicht für Textfelder (Statement, Hypothese, Erfolgskriterien)

- Eine Restore previous-Schaltfläche auf früheren Versionen (mit Bestätigung)

Kontext: Kommentare und Entscheidungsnotizen

Erzwinge eine kurze „Warum“-Notiz bei sinnvollen Änderungen (Status-/Confidence-Änderungen, Archivierung). Behandle das als leichtes Entscheidungsprotokoll: was sich geändert hat, welche Evidenz es ausgelöst hat und was als Nächstes geschieht.

Unabsichtliche Änderungen verhindern

Füge Bestätigungen für destruktive Aktionen hinzu:

- Statuswechsel, die eine Annahme schließen

- Archivierung

- Wiederherstellung einer alten Version (hinweisen, dass dadurch eine neue Revision entsteht)

So bleibt deine Versionshistorie vertrauenswürdig—auch wenn Leute schnell arbeiten.

Evidenz anhängen und Experimente verfolgen

Annahmen werden gefährlich, wenn sie sich „wahr“ anhören, ohne dass man auf etwas Zeigbares verweisen kann. Deine App sollte Teams ermöglichen, Evidenz anzuhängen und leichte Experimente zu dokumentieren, damit jede Behauptung eine Spur hat.

Evidenz: was speichern (ohne Chaos)

Unterstütze übliche Evidenztypen: Interview-Notizen, Umfrageergebnisse, Produkt- oder Umsatzmetriken, Dokumente (PDFs, Slides) und einfache Links (z. B. Analytics-Dashboards, Support-Tickets).

Wenn jemand Evidenz anhängt, erfasse ein kleines Set an Metadaten, damit sie auch Monate später nutzbar bleibt:

- Source (Kundenname, Dataset, Tool oder interner Dokumentverantwortlicher)

- Date collected (und optional Upload-Datum)

- Method (Interview, Usability-Test, A/B-Test, Desk Research, etc.)

- Quality / Strength Rating (siehe unten)

Um doppelte Uploads zu vermeiden, modelle Evidenz als eigenes Entity und verknüpfe sie many-to-many: eine Interview-Notiz kann drei Annahmen stützen und eine Annahme kann zehn Evidenzstücke haben. Speichere die Datei einmal (oder nur den Link) und verknüpfe sie dort, wo sie gebraucht wird.

Experiment-Tracking: aus „das sollten wir testen“ ein Record machen

Füge ein einfach zu befüllendes „Experiment“-Objekt hinzu:

- Hypothesis (was ihr erwartet und warum)

- Method (was ihr tun werdet)

- Key metric (die Zahl, die ihr beobachtet)

- Result (was passiert ist)

- Conclusion (behalten, ändern oder Annahme verwerfen)

Verknüpfe Experimente mit den getesteten Annahmen und hänge optional automatisch erzeugte Evidenz an (Charts, Notizen, Metrik-Snapshots).

Evidenzstärke: Anleitung gegen falsche Sicherheit

Verwende ein einfaches Rubric (z. B. Weak / Moderate / Strong) mit Tooltips:

- Weak: Meinungen, einzelne Anekdoten, unbestätigter Link

- Moderate: mehrere Interviews, konsistentes Umfragesignal, frühe Metrik-Trends

- Strong: wiederholte Ergebnisse über Segmente, klarer Metrik-Effekt, kontrolliertes Experiment

Das Ziel ist nicht Perfektion—sondern Confidence explizit zu machen, damit Entscheidungen nicht auf Gefühlen beruhen.

Erinnerungen und Review-Workflows hinzufügen

Validieren, bevor du dich festlegst

Teste deine Idee in der Gratisstufe und wechsle erst, wenn dein Team mehr braucht.

Annahmen veralten leise. Ein einfacher Review-Workflow hält das Log nützlich, indem er „wir sollten das nochmal ansehen“ in eine vorhersehbare Gewohnheit verwandelt.

Setze eine Review-Cadence passend zum Risiko

Verknüpfe die Review-Frequenz mit Impact und Confidence, damit nicht jede Annahme gleich behandelt wird.

- Wöchentlich: hoher Impact + niedrige Confidence (z. B. Kernpreis, Hauptakquisitionskanal)

- Monatlich: hoher Impact + mittlere Confidence oder mittlerer Impact + niedrige Confidence

- Quartalsweise (optional): niedriger Impact + hohe Confidence

Speichere das nächste Review-Datum an der Annahme und berechne es automatisch neu bei Änderungen von Impact/Confidence.

Erinnerungen ohne Spam

Unterstütze sowohl E-Mail als auch In-App-Benachrichtigungen. Halte Defaults konservativ: ein Reminder bei Überfälligkeit, dann ein sanfter Follow-up.

Mach Benachrichtigungen konfigurierbar pro Nutzer und Workspace:

- Kanalpräferenzen (E-Mail/In-App)

- Erinnerungshäufigkeit (täglich/wöchentlich)

- Ruhezeiten / Zeitzone

- Opt-out für Low-Impact-Items

Digest-Views, die zum Handeln bewegen

Statt Leuten eine lange Liste zu schicken, erstelle fokussierte Digests:

- Needs review (überfällig oder bald fällig)

- High impact + low confidence (höchstes Risiko)

- Recent changes (Annahmen editiert, Confidence gesunken, Evidenz entfernt)

Diese sollten erstklassige Filter in der UI sein, damit dieselbe Logik Dashboard und Benachrichtigungen antreibt.

Einfache Eskalationsregeln

Eskalation sollte vorhersehbar und leichtgewichtig sein:

- Benachrichtige den Owner, wenn überfällig.

- Wenn nach X Tagen immer noch überfällig, benachrichtige die Teamleitung (oder Workspace-Admin).

Protokolliere jede Erinnerung und Eskalation in der Aktivitäts-History der Annahme, damit Teams sehen können, was wann passiert ist.

Dashboards und Reporting erstellen

Dashboards machen aus deinem Annahmen-Log etwas, das Teams tatsächlich aufrufen. Ziel sind keine aufwändigen Analytics—sondern schnelle Sichtbarkeit: was riskant ist, was veraltet und was sich ändert.

Dashboard-KPIs, die "Sind wir sicher?" beantworten

Beginne mit wenigen Kacheln, die sich automatisch aktualisieren:

- Annahmen nach Status (Draft, Active, Validated, Invalidated, Archived)

- Confidence-Verteilung (wie viele sind 1–5 oder Low/Medium/High)

- Überfällige Reviews (Anzahl + Direktlink zur Überfälligen-Liste)

Verknüpfe jede KPI mit einer Aktionsansicht, damit Leute nicht nur beobachten, sondern handeln können.

Trendcharts (nützlich, aber ehrlich)

Ein einfacher Linienchart für Validierungen vs. Invalidierungen über Zeit hilft Teams zu erkennen, ob Lernen schneller wird oder stagniert. Bleibe vorsichtig in der Interpretation:

- Behandle Trends als Signale, nicht als Leistungsnachweis.

- Zeige die Stichprobengröße (z. B. „8 Ergebnisse diesen Monat“), damit eine einzelne Woche nicht wie ein Durchbruch aussieht.

Gespeicherte Ansichten für verschiedene Stakeholder

Verschiedene Rollen stellen unterschiedliche Fragen. Biete gespeicherte Filter wie:

- Product: Annahmen, die Discovery betreffen, gruppiert nach Produktbereich

- Sales/CS: Annahmen zu Pricing, Einwänden, Zielsegmenten

- Leadership: höchste Impact-Items, Top-Risiken, Review-Gesundheit

Gespeicherte Ansichten sollten per stabilem URL teilbar sein (z. B. /assumptions?view=leadership-risk).

Risiko hervorheben: hoher Impact + schwache Evidenz

Erstelle eine „Risk Radar“-Tabelle, die Items zeigt, bei denen Impact High und Evidence strength Low (oder Confidence niedrig) ist. Das wird eure Agenda für Planung und Pre-Mortems.

Exportierbare Zusammenfassungen für Meetings

Mach Reporting portabel:

- One-Click-Export einer Ansicht als PDF/CSV

- Eine „Wöchentliche Annahmen-Zusammenfassung“, die Top-Änderungen, neue Invalidierungen und überfällige Reviews auflistet

So bleibt die App in der Planung präsent, ohne dass alle mitten im Meeting einloggen müssen.

Importe, Exporte und Integrationen unterstützen

Volle Code‑Kontrolle behalten

Wenn du bereit bist, exportiere den Quellcode und entwickle mit deinem Team weiter.

Ein Tracking-Tool funktioniert nur, wenn es in die bestehende Arbeitsweise passt. Im-/Exports helfen beim schnellen Start und wahren die Datenhoheit; leichte Integrationen reduzieren manuelles Kopieren—ohne das MVP in eine Integrationsplattform zu verwandeln.

Exporte, die Leute tatsächlich nutzen

Beginne mit CSV-Export für drei Tabellen: assumptions, evidence/experiments und change logs. Halte die Spalten vorhersehbar (IDs, Statement, Status, Confidence, Tags, Owner, Last reviewed, Timestamps).

Kleine UX-Details:

- Exportiere aktuelle Ansicht (Filter angewendet) und vollen Workspace

- Lass Nutzer wählen, ob archivierte Items eingeschlossen werden

- Füge eine stabile Assumption ID hinzu, damit Tabellen später zusammengeführt werden können

Import aus Tabellen (ohne Schmerz)

Die meisten Teams starten mit einer unordentlichen Google Sheet. Biete einen Import-Flow, der unterstützt:

- CSV hochladen

- Spaltenzuordnung (z. B. „Hypothesis" → Statement, "Risk" → Impact)

- Validierung mit klaren Fehlern (fehlende Pflichtfelder, unbekannte Status, ungültige Daten)

- Eine Vorschau, die zeigt, wie viele Annahmen erstellt vs. aktualisiert werden

Behandle Import als erstklassiges Feature: es ist oft der schnellste Weg zur Adoption. Dokumentiere das erwartete Format und die Regeln unter /help/assumptions.

Optionale Integrationen: simpel, nicht endlos

Halte Integrationen optional, damit der Kern simpel bleibt. Zwei praktische Muster:

- Webhooks: feuere Events wie

assumption.created, status.changed, review.overdue ab.

- Link-out References: speichere URLs zu Jira-Tickets, Notion-Dokumenten oder Research-Ordnern als „Related links“ an einer Annahme.

Für sofortigen Nutzen unterstütze eine einfache Slack-Alert-Integration (via Webhook-URL), die postet, wenn eine High-Impact-Annahme den Status ändert oder Reviews überfällig sind. So bekommen Teams Awareness, ohne Tools wechseln zu müssen.

Sicherheit, Privacy und Datenschutz-Grundlagen

Sicherheit und Privacy sind Produkt-Features für ein Annahmen-Log. Leute fügen Links, Notizen aus Calls und interne Entscheidungen ein—deshalb entwerfe standardmäßig „safe by default“, auch in einer frühen Version.

Grundlegender Datenschutz

Verwende TLS überall (nur HTTPS). Leite HTTP auf HTTPS um und setze sichere Cookies (HttpOnly, Secure, SameSite).

Speichere Passwörter gehasht mit modernen Algorithmen wie Argon2id (bevorzugt) oder bcrypt mit starkem Kostenfaktor. Niemals Klartext-Passwörter speichern und keine Auth-Tokens ins Log schreiben.

Wende Least-Privilege-Prinzip an:

- Trenne Rollen (Admin, Editor, Viewer) und prüfe Permissions bei jedem Schreibvorgang

- Verwende scoped API-Keys für Integrationen und erlaube Widerruf

- Beschränke DB-Zugriffe, sodass die App nicht auf Tabellen zugreift, die sie nicht braucht

Row-Level Access Rules (Workspaces)

Die meisten Datenlecks in Multi-Tenant-Apps sind Autorisierungsfehler. Mach Workspace-Isolation zur Kernregel:

- Jeder Datensatz (Assumption, Evidence, Experiment, Comment) muss

workspace_id enthalten.

- Erzwinge Zugriff auf DB-Ebene mit Row-Level-Security (RLS) oder Äquivalenten, nicht nur in der App-Logik.

- In Tests: erstelle zwei Workspaces und verifiziere, dass ein Nutzer aus Workspace A nichts von Workspace B lesen, suchen, exportieren oder IDs erraten kann.

Backups und Aufbewahrung (was du umsetzen wirst)

Definiere einen einfachen Plan, den du ausführen kannst:

- Automatisierte tägliche DB-Backups an separatem Ort

- Aufbewahrungsrichtlinie (z. B. 30 Tage tägliche Backups und 12 Monate monatliche Backups)

- Vierteljährliche Restore-Drills: Wiederherstellung in Staging und Validierung wichtiger Flows

Logging und Umgang mit sensiblen Daten

Überlege genau, was gespeichert wird. Vermeide es, Secrets in Evidenz-Notizen zu speichern (API-Keys, Passwörter, private Links). Falls Nutzer das trotzdem tun, warne und ziehe automatische Redaktionen für gängige Muster in Betracht.

Halte Logs minimal: logge nicht ganze Request-Bodies für Endpunkte, die Notizen oder Anhänge akzeptieren. Für Diagnostics logge Metadaten (workspace ID, record ID, Error-Codes) statt vollem Inhalt.

Privacy beim Speichern von Interview-Notizen

Interview-Notizen können personenbezogene Daten enthalten. Biete Möglichkeiten:

- Felder als „enthält personenbezogene Daten“ markieren und deren Sichtbarkeit einschränken

- Notizen auf Anfrage löschen oder anonymisieren

- Kurzen Privacy-Hinweis (Link in

/settings oder /help) bereitstellen, was gespeichert wird und warum

Launch, Monitoring und Planung der nächsten Iteration

Eine Annahmen-App ausliefern heißt weniger „fertig“ als vielmehr: sie in echte Workflows bringen, sicher betreiben und aus Nutzung lernen.

Praktische Deployment-Checkliste

Bevor du Nutzer einlädst, führe eine kleine, wiederholbare Checkliste aus:

- Datenbank-Migrationen anwenden (und prüfen, dass sie reversibel sind)

- Seed-Daten laden (Status, Confidence-Level, Review-Cadences)

- Ersten Admin-Account und einen Default-Workspace anlegen

- E-Mail-/Benachrichtigungs-Einstellungen für Review-Reminders prüfen

- Basis-Backups aktivieren und Restore einmal verifizieren

Wenn du eine Staging-Umgebung hast, probe das Release dort zuerst—gerade Prozesse, die Versionshistorie und Change-Logs betreffen.

Starte simpel: du willst Sichtbarkeit ohne massive Einrichtung.

Nutze ein Error-Tracking (z. B. Sentry/Rollbar), um Crashes, fehlgeschlagene API-Calls und Hintergrundjob-Fehler zu erfassen. Füge Basis-Performance-Monitoring (APM oder Server-Metriken) hinzu, um langsame Seiten wie Dashboards und Reports zu erkennen.

Tests, die zentrale Regeln schützen

Fokussiere Tests dort, wo Fehler teuer sind:

- Unit-Tests für Status-Transitions, Confidence-Regeln und Review-Scheduling

- Integrationstests für Main-Flows: create assumption → attach evidence → log experiment → change status → see audit trail

Onboarding, das die App "greifbar" macht

Stelle Templates und Beispielannahmen bereit, damit neue Nutzer nicht auf einem leeren Bildschirm sitzen. Eine kurze Guided Tour (3–5 Schritte) sollte zeigen: wo Evidenz angehängt wird, wie Reviews funktionieren und wie man das Entscheidungsprotokoll liest.

Plane die nächste Iteration

Nach dem Launch priorisiere Verbesserungen basierend auf echtem Nutzerverhalten:

- Scoring-Modelle (Impact × Uncertainty oder kundenspezifische Confidence-Formeln)

- Genehmigungsflüsse für hochriskante Änderungen

- Optionale AI-unterstützte Zusammenfassungen von Evidenz und Experiment-Ergebnissen

Wenn du schnell iterierst, nutze Tools, die die Zeit zwischen „wir sollten diesen Workflow hinzufügen“ und „es ist live“ verkürzen. Viele Teams verwenden z. B. Koder.ai, um neue Screens und Backend-Änderungen aus einem Chat-Brief zu entwerfen, dann auf Snapshots und Rollback zu setzen, um Experimente sicher auszurollen—und den Code zu exportieren, sobald die Produktrichtung klar ist.