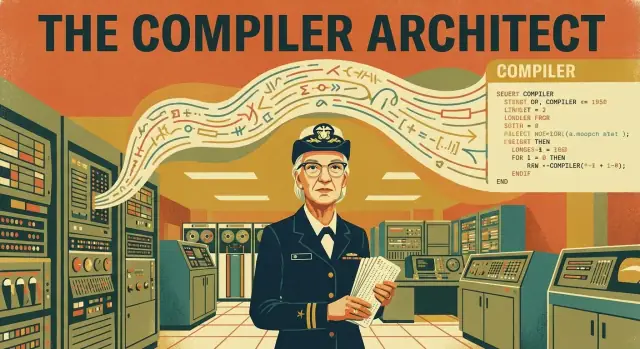

Warum Grace Hopper für das Programmieren noch wichtig ist

Die meisten von uns schreiben Code mit der Erwartung, dass er lesbar, wiederverwendbar und relativ portabel ist. Wir benennen Variablen, rufen Bibliotheken auf und gehen davon aus, dass unser Programm auf Maschinen läuft, die wir vielleicht nie gesehen haben. Diese Erwartung kam nicht zufällig zustande. Sie ist das Ergebnis einer grundlegenden Verschiebung in der Arbeitsteilung zwischen Menschen und Computern — und Compiler sind die Brücke.

Die zentrale Frage: Was hat sich geändert, und warum war das wichtig?

Frühe Programmierer haben nicht „Code getippt“, wie wir uns das heute vorstellen. Sie arbeiteten auf einer Ebene, die so detailliert und fragil war, dass jede Anweisung wie maßgeschneiderte Handarbeit an einer Maschine wirkte. Die Kernfrage lautet:

Wie wurde Programmierung von einem hardware-spezifischen Handwerk zu einer menschenzentrierten Praxis, die Teams über die Zeit pflegen können?

Hoppers Rolle: Die Maschine an den Menschen anpassen

Grace Hopper steht im Zentrum dieses Wandels, weil sie eine radikale Idee für ihre Zeit vorantrieb: der Computer sollte mehr Übersetzungsarbeit übernehmen. Anstatt Menschen zu zwingen, lange, fehleranfällige Abfolgen zu schreiben, die auf eine einzelne Maschine zugeschnitten sind, half Hopper, frühe Compiler‑Arbeit zu entwickeln — Systeme, die menschenfreundlichere Anweisungen in die niedrigstufigen Schritte übersetzen konnten, die ein Computer tatsächlich ausführt.

Ihre Arbeit bewies, dass „Übersetzung“ kein Luxus ist. Es war ein Produktivitätssprung. Sobald man Absicht klarer ausdrücken kann, kann man:

- Programme schneller schreiben,

- Fehler leichter entdecken,

- Code mit anderen teilen,

- und Software aktualisieren, ohne alles neu schreiben zu müssen.

Was du in diesem Artikel lernst

Wir gehen durch, wie Programmierung vor den Compilern aussah, was ein Compiler tatsächlich macht (ohne Fachchinesisch) und wie Hoppers A-0‑Arbeit und der Aufstieg von COBOL die Software in Richtung lesbarer, standardisierter Sprachen drängten. Unterwegs siehst du praktische Folgen, die die moderne Entwicklung noch heute prägen: Portabilität, Teamarbeit, langfristige Wartung und die alltägliche Annahme, dass Code für Menschen verständlich sein sollte — nicht nur für Maschinen.

Wenn du jemals von klaren Fehlermeldungen, portablen Programmen oder einer Sprache profitiert hast, die wie eine Anleitung zu lesen ist, lebst du in der Welt, die Hopper mit aufgebaut hat.

Programmierung vor den Compilern: der harte Weg

Grace Hopper begann nicht damit, Programmierung „einfacher“ machen zu wollen. Sie begann dort, wo frühe Computer es erforderten: bei den Grenzen der Maschine. Als ausgebildete Mathematikerin trat sie während des Zweiten Weltkriegs in die US‑Navy ein und arbeitete am Harvard Mark I, einem der ersten großangelegten elektromechanischen Computer.

Der Mark I war kein Laptop, den man nach einem Fehler neu starten konnte — er war ein raumfüllendes Gerät, das von einem Team geteilt, sorgfältig terminiert und wie teure Laborgeräte behandelt wurde.

Wie Programmierung ohne Compiler aussah

Vor den Compilern war Programmierung eher dem Verdrahten einer Schalttafel ähnlich als dem Schreiben von Code, wie wir ihn heute kennen. Anweisungen mussten exakt den Bedürfnissen der Hardware entsprechen, oft als numerische Codes oder sehr niedrigstufige Operationen. Wollte man die Maschine addieren, vergleichen oder Werte verschieben lassen, drückte man das in der eigenen Maschinensprache aus — Schritt für Schritt.

Diese Arbeit war:

- Manuell: Du übersetztest deine Logik selbst in winzige Operationen.

- Fehleranfällig: Eine einzige falsche Ziffer oder Adresse konnte alles zerstören.

- Langsam zu ändern: Selbst kleine Anpassungen erforderten das Überprüfen langer Anweisungsfolgen.

Die eigentliche Einschränkung: Zeit war teuer

Frühe Computer waren rar und „Computerzeit“ ein knappes Budget. Man konnte ein Programm nicht einfach zehnmal ausführen, um zu sehen, was passiert. Teams bereiteten sich sorgfältig vor, überprüften alles doppelt und warteten dann auf ihren Ausführungsauftrag. Jede verlorene Minute war Zeit, die nicht für die Lösung des eigentlichen Problems verwendet wurde.

Dieser Druck prägte Hoppers Denken: Wenn Menschen mehr Aufwand darauf verwenden, mit der Maschine zu sprechen als das Problem zu lösen, ist das Nadelöhr nicht nur die Hardware — es ist die Methode.

Maschinencode, Assembly und das Problem der menschlichen Zeit

Vor Compilern sprachen Programmierer die „Muttersprache“ des Computers.

Maschinencode, einfach erklärt

Maschinencode ist ein Strom von 0en und 1en, den der Prozessor direkt ausführen kann. Jedes Muster bedeutet etwas wie „addiere diese beiden Zahlen“, „verschiebe diesen Wert“ oder „springe zu einem anderen Schritt“. Er ist präzise — und für Menschen brutal schwer zu lesen, zu schreiben und zu debuggen.

Assembly: ein kleiner Schritt Richtung Lesbarkeit

Assembly‑Sprache ist Maschinencode mit Spitznamen. Anstelle roher Bits schreibt man kurze Wörter wie LOAD, ADD oder JUMP sowie Speicheradressen. Ein Assembler übersetzt diese Wörter dann in die genauen 0en und 1en für die jeweilige Maschine.

Assembly war leichter als reiner Maschinencode, aber es zwang weiterhin dazu, wie die Hardware zu denken: Register, Speicherstellen und die genaue Reihenfolge der Operationen.

Warum frühe Programme an ihre Hardware geklebt waren

Frühe Computer waren nicht austauschbar. Verschiedene Maschinen hatten unterschiedliche Befehlssätze, Speicherlayouts und sogar verschiedene Darstellungen von Zahlen. Ein Programm für den Befehlssatz einer Maschine lief oft gar nicht auf einer anderen.

Software war weniger ein „Rezept“ und mehr ein maßgeschneiderter Schlüssel für ein einzelnes Schloss.

Wenn kleine Änderungen große Umbauten erforderten

Weil Programme aus niedrigstufigen Schritten aufgebaut waren, konnte eine „einfache“ Anforderung — etwa eine neue Spalte im Bericht, ein geändertes Dateiformat oder eine andere Rundungsregel — das ganze Programm durchziehen.

Brauchte eine neue Funktion zusätzliche Anweisungen, musste man eventuell Speicheradressen verschieben, Sprungziele anpassen und jede Stelle überprüfen, die vom alten Layout ausging. Die Zeit der Maschine war wertvoll, aber die menschliche Zeit war das eigentliche Nadelöhr — und sie wurde an Details verbrannt, die wenig mit der Geschäftslogik zu tun hatten.

Die große Idee: Was ein Compiler macht

Frühe Computer waren mächtig, aber schmerzlich wörtlich. Sie konnten nur Anweisungen ausführen, die in dem engen Operatorensatz ihrer Hardware ausgedrückt waren. Das bedeutete, Programmieren sah oft aus wie direktes Schreiben an die Maschine, Schritt für Schritt.

Ein Compiler drehte dieses Arbeitsmuster um: Anstatt dass Menschen „Maschine sprechen“, kann man Anweisungen in einer menschenfreundlicheren Form schreiben — und Software übernimmt die Übersetzung. Praktisch ist ein Compiler ein Programm, das hilft, Programme zu erzeugen.

Was „kompilieren“ wirklich heißt

Kompilieren ist der Prozess, menschenlesbaren und -schreibbaren Code in Maschinensprache umzuwandeln, die der Computer ausführen kann. Man kann es sich vorstellen wie das Übersetzen eines Rezepts in die genauen Knopfdruck‑Anweisungen für einen Küchenroboter.

Auf hoher Ebene macht ein Compiler typischerweise:

- liest deinen Quellcode (den Text, den du geschrieben hast),

- prüft ihn auf Fehler und Inkonsistenzen,

- übersetzt ihn in eine niedrigere Form, die die Maschine ausführen kann (oft eine ausführbare Datei oder eine andere Ausgabedatei).

Die Magie besteht nicht darin, dass der Computer plötzlich „Englisch versteht“. Die Magie ist, dass der Compiler die lästige, fehleranfällige Übersetzungsarbeit schnell und konsistent übernimmt.

Compiler vs. Interpreter (die häufige Verwirrung)

Viele verwechseln Compiler und Interpreter, weil beide helfen, menschengerechten Code auszuführen.

Eine einfache Unterscheidung:

- Ein Compiler übersetzt das gesamte Programm (oder große Teile davon) im Voraus und erzeugt etwas, das die Maschine laufen lassen kann.

- Ein Interpreter führt dein Programm aus, indem er es beim Laufen Schritt für Schritt übersetzt und ausführt.

Beide Ansätze können von außen ähnlich wirken („Ich schreibe Code und er läuft“), aber Arbeitsablauf und Performance‑Abwägungen unterscheiden sich. Für Hoppers Geschichte ist entscheidend, dass Kompilierung das Schreiben von Code weniger an Hardwaredetails band und mehr zum Ausdruck von Absicht machte.

Hoppers A-0 und die ersten Schritte zu Compilern

Grace Hoppers A-0‑System (oft auf 1952 datiert) ist eines der frühesten „compiler‑ähnlichen“ Werkzeuge — auch wenn es nicht wie moderne Compiler aussah, die eine komplett menschenlesbare Sprache in Maschinencode übersetzen.

Was A-0 tat (einfach gesagt)

Anstatt jede Anweisung von Hand zu schreiben, konnte ein Programmierer ein Programm erstellen, das auf vorgefertigte Routinen per Identifier verwies. A-0 würde dann:

- die gewünschten Routinen in einem Katalog (einer Bibliotheksliste) nachschlagen,

- die entsprechenden Maschinencode‑Blöcke für diese Routinen holen,

- sie zu einem vollständigen ausführbaren Programm zusammenfügen (was wir heute Linking nennen).

Der Programmierer verlangte die Maschine also noch nicht auf Englisch zu verstehen. Er verlangte, dass sie eine sich wiederholende, fehleranfällige Assemblierarbeit automatisierte: bekannte Bausteine auswählen und zusammensetzen.

Subroutinen und Bibliotheken: weniger Wiederholung, weniger Fehler

A-0 stützte sich auf eine mächtige Idee: Subroutinen. Wenn es bereits eine getestete Routine für Ein-/Ausgabe, mathematische Operationen oder Datenbewegung gab, musste man sie nicht jedes Mal neu schreiben.

Das veränderte die tägliche Arbeit in zwei wesentlichen Punkten:

- Geschwindigkeit: Teams konnten neue Programme durch Wiederverwendung vorhandener Teile bauen.

- Zuverlässigkeit: Die Nutzung bewährter Routinen verringerte die Wahrscheinlichkeit, durch Duplizierung neue Fehler einzuführen.

Der Denkwechsel: Programmieren als Wiederverwendung + Automatisierung

Der tiefere Einfluss von A-0 war nicht nur technisch — er war kulturell. Er schlug vor, dass Programmieren bedeuten kann, zu beschreiben, was man aus verlässlichen Komponenten zusammenbauen möchte, und Werkzeuge die mechanische Arbeit erledigen zu lassen.

Diese Haltung — Bibliotheken wiederverwenden, Routinen standardisieren und Übersetzung automatisieren — wurde zur Grundlage für Compiler, standardisierte Sprachen und moderne Softwarepraktiken.

Menschengerechter Code: Der Vorstoß für Lesbarkeit

Änderungen ohne Angst vornehmen

Nutze Snapshots und Rollbacks, um beim Ändern von Funktionen oder Refactoring sicher zu experimentieren.

Frühe Programmierer stritten nicht nur mit Maschinen — sie stritten auch über die Vorstellungen der Kollegen, wie „echte“ Programmierung auszusehen habe. Für viele Ingenieure bedeutete ernsthafte Arbeit, dass Anweisungen der Hardware ähneln mussten: knapp, numerisch und explizit. Alles, was nach Alltagssprache aussah, wirkte suspekt.

Warum „englisch‑ähnlicher“ Code falsch klang

Grace Hopper argumentierte, Computer sollten den Menschen dienen, nicht umgekehrt. Ihr Einsatz für lesbarere Notation — Aussagen, die näher an Geschäftstermen als an Maschinenoperationen liegen — war umstritten, weil er einen Kernglauben herausforderte: Effizienz erfordere, dass Menschen in maschinenförmigen Schritten denken.

Skeptiker befürchteten, englischähnliche Befehle seien mehrdeutig, verschleierten wichtige Details und förderten schludriges Denken. Hoppers Gegenargument war praktisch: Die meiste Programmierzeit wird nicht mit Eingeben von Anweisungen verbracht — sie wird damit verbracht, sie später zu verstehen.

Lesbarkeit ist eine Wartungsstrategie

Lesbarer Code zielt nicht darauf ab, Programme „einfach“ zu machen; er will sie überleben lassen. Wenn Code Absicht kommuniziert, können Teams Änderungen schneller prüfen, neue Leute mit weniger Fehlern einarbeiten und Probleme diagnostizieren, ohne jede Entscheidung zurückzuentwickeln.

Das ist über Jahre noch wichtiger. Software überdauert Jobrollen, Abteilungen und manchmal sogar den ursprünglichen Zweck. Menschengerechte Struktur und Benennung senken die Kosten für Änderungen, die oft den größten Aufwand in Software darstellen.

Hoppers Ansatz hatte Grenzen. Frühe Compiler und Werkzeuge waren unausgereift, und höherstufiger Code konnte langsamere oder größere Programme erzeugen als handoptimierte Assembly. Debugging konnte sich indirekter anfühlen: Fehler tauchten womöglich in der kompilierten Ausgabe statt im Quelltext auf.

Trotzdem war die langfristige Rendite klar: Lesbarer Quellcode machte es möglich, größere Systeme mit mehr Menschen zu bauen — und diese Systeme auch Jahre nach der ersten Auslieferung funktionsfähig zu halten.

COBOL und der Schritt zu standardisierten Sprachen

COBOL (Common Business‑Oriented Language) wurde mit einem einfachen Ziel gebaut: Programme so lesbar zu machen, dass die Menschen, die Unternehmen leiten, sie verstehen können — nicht nur jene, die Maschinen verdrahten. Grace Hopper setzte sich stark für diese Idee ein — wenn Code Jahre überdauern, zwischen Teams wechseln und Personalfluktuation überstehen soll, muss er verständlich sein.

Was COBOL erreichen wollte

COBOL wurde für die Geschäftsdatenauswertung entwickelt: Lohnabrechnung, Inventar, Abrechnung und andere Aufgaben, bei denen die Struktur der Daten genauso zählt wie die Rechnung. Deshalb legte COBOL großen Wert auf Records, Felder und klare Beschreibungen dessen, was ein Programm tut.

Ein großer Teil der Ambition war Klarheit. COBOL setzte auf englischähnliche Strukturen, damit jemand, der das Programm überfliegt, die Absicht folgen kann. Es ging nicht darum, Programmieren „leicht“ zu machen — sondern lesbar und wartbar, wenn Fehler in Geschäftssystemen enorme Kosten verursachen können.

Komitees, Standards und warum das wichtig war

COBOLs echter Durchbruch war nicht nur seine Syntax. Es war der Schritt zur Standardisierung.

Anstatt an die Hardware eines Herstellers oder an eine private Sprache eines Unternehmens gebunden zu sein, wurde COBOL von Komitees und formalen Spezifikationen geprägt. Dieser Prozess konnte langsam und politisch sein, aber er schuf ein gemeinsames Ziel, das mehrere Anbieter implementieren konnten.

In der Praxis bedeutete das, dass Organisationen mit mehr Vertrauen in COBOL investieren konnten: Schulungsmaterialien blieben länger brauchbar, die Personalbeschaffung wurde einfacher und Code hatte höhere Chancen, einen Hardwarewechsel zu überstehen.

Standardisierung veränderte auch Erwartungen. Sprachen waren nicht länger nur Werkzeuge, die „mit der Maschine kamen“. Sie wurden zu öffentlichen Vereinbarungen — Regeln dafür, wie Menschen Anweisungen schreiben und wie Compiler sie übersetzen.

Eine ausgewogene Sicht: Stärken und Kritik

COBOLs Stärken sind leicht zu erklären: es ist explizit, Datentypen stehen im Mittelpunkt und es unterstützt langlebige Geschäftssysteme. Diese Langlebigkeit ist kein Zufall; sie folgt Designentscheidungen zugunsten von Klarheit und Stabilität.

Die Kritik ist ebenso real. COBOL kann wortreich sein und seine Lesbarkeit starr wirken im Vergleich zu modernen Sprachen. Aber die Wortfülle war oft Absicht: der Code zeigt seine Arbeitsweise, was Auditierung, Wartung und Übergaben erleichtern kann.

COBOL markiert einen Wendepunkt, an dem Programmiersprachen weniger zu persönlichen Abkürzungen wurden und mehr zu standardgetriebener Infrastruktur — geteilt, lehrbar und gebaut, um zu bestehen.

Von einer Maschine zu vielen: Portabilität und Standardisierung

Wartung erleichtern

Nutze den Chat, um lesbare, wiederverwendbare Module zu erzeugen, damit du später weniger Code-Archäologie betreiben musst.

Frühe Programme waren häufig mit einer bestimmten Maschine verheiratet. Wechselte man den Computer, zog man nicht nur Dateien um — oft musste man das Programm neu schreiben, weil Instruktions‑ und Konventionsunterschiede zu groß waren. Das machte Software fragil, teuer und hemmte die Einführung neuer Hardware.

Portabilität: das echte „write once, run (almost) anywhere“

Compiler führten eine kraftvolle Trennung ein: Du schreibst dein Programm in einer höherstufigen Sprache und der Compiler übersetzt es in die nativen Instruktionen eines bestimmten Computers.

Das ist es, was man unter Portabilität versteht: derselbe Quellcode lässt sich für unterschiedliche Maschinen bauen — vorausgesetzt, es gibt einen passenden Compiler und man vermeidet hardware‑spezifische Annahmen. Statt ein Lohnabrechnungssystem für jede neue Maschine neu zu schreiben, konnten Organisationen die Logik behalten und einfach neu kompilieren.

Bessere Hardware ohne Software‑Neuanfang

Diese Verschiebung veränderte die Ökonomie von Hardwareverbesserungen. Hersteller konnten schnellere oder leistungsfähigere Maschinen herausbringen, und Kunden mussten nicht jahrelange Softwareinvestitionen verwerfen.

Compiler wurden zu einer Art „Adapterlage“ zwischen stabilen Geschäftsanforderungen und sich schnell ändernder Technologie. Man konnte Prozessoren, Speicherarchitekturen und Peripherie upgraden und dabei die Intention der Anwendung intakt lassen. Einige Änderungen erforderten trotzdem Anpassungen — besonders bei Ein-/Ausgabe — aber die Kernidee war nicht mehr an einen bestimmten Opcode‑Satz gebunden.

Standardisierung: gemeinsame Sprachen, gemeinsame Ökosysteme

Portabilität verbessert sich erheblich, wenn die Sprache standardisiert ist. Gemeinsame Regeln bedeuten, dass Code für einen Compiler eher auf einem anderen kompiliert werden kann, wodurch Vendor‑Lock‑in reduziert und das Teilen von Software erleichtert wird.

Dieses Erbe zeigt sich heute überall:

- plattformübergreifende Apps aus einer gemeinsamen Codebasis (Desktop, Mobile, Web),

- standardisierte Sprachen und Laufzeiten, die sich auf verschiedenen Systemen vorhersehbar verhalten,

- große Ökosysteme — Bibliotheken, Tools und Einstellungs‑Pipelines —, die existieren, weil man darauf vertraut, dass „derselbe Code“ in verschiedenen Umgebungen ungefähr dasselbe bedeutet.

Grace Hoppers Vorstoß zu menschengerechter, breit nutzbarer Programmierung war nicht bloß Bequemlichkeit. Er half, Software von maschinenspezifischen Instruktionen in ein portables Gut zu verwandeln, das Hardwaregenerationen überdauern kann.

Wie Compiler die Arbeit und Wartung von Software veränderten

Compiler beschleunigten die Programmierung nicht nur — sie formten auch die Organisation von Softwareteams neu. Wenn Code höherstufig verfasst werden konnte (näher an Geschäftsregeln als an Maschineninstruktionen), konnten unterschiedliche Personen effektiver beitragen.

Neue Rollen, klarere Übergaben

Frühe Projekte teilten Arbeit oft in Rollen wie Analysten (die definierten, was das System tun sollte), Programmierer (die das in Code übersetzten) und Operatoren (die Jobs ausführten und Maschinenzeit verwalteten). Mit Compilern konnten Analysten Arbeitsabläufe strukturierter beschreiben, während Programmierer weniger Zeit mit dem „Hand‑Assemble“ von Instruktionen und mehr Zeit mit Logik verbrannten, die zu diesen Arbeitsabläufen passt.

Das Ergebnis war eine sauberere Übergabe: Anforderungen → lesbarer Quellcode → kompiliertes Programm. Große Projekte hingen dadurch weniger von wenigen Spezialisten ab, die die Eigenheiten einer Maschine kannten.

Wartung wurde zur echten Rechnung

Als Software jahrelang lebte — nicht nur Wochen — wurde Wartung zu einem großen Kostenfaktor. Fehlerbehebungen, Updates und kleine Regeländerungen summierten sich. Lesbarer Quellcode machte das erträglich: Eine neue Person konnte die Absicht verstehen, ohne Tausende niedrigstufiger Schritte zu entschlüsseln.

Compiler unterstützten das, indem sie Struktur förderten: benannte Variablen, wiederverwendbare Routinen und klarere Kontrollflüsse. Wenn der Code sich selbst erklärt, wird Wartung weniger zur Archäologie.

Bessere Test‑ und Debugging‑Gewohnheiten

Klarere Abstraktionen verbesserten auch Tests und Debugging. Anstatt einer falschen Maschineninstruktion hinterherzujagen, konnten Teams über Features nachdenken („Diese Berechnung ist für Rückerstattungen falsch“) und Probleme auf ein Modul oder eine Funktion eingrenzen.

Auch wenn Compiler früher kryptische Fehler ausgaben, brachten sie eine wertvolle Disziplin: halte Quellcode organisiert, prüfe Verhalten schrittweise und ändere dort, wo die Bedeutung ausgedrückt wird — nicht dort, wo die Hardware gerade Bits speichert.

Häufige Mythen über Compiler und „einfaches“ Programmieren

Compiler übersetzen menschenfreundliche Anweisungen in maschinenfreundliche. Diese Verschiebung machte Software schneller zu schreiben und leichter zu teilen — aber sie erzeugte auch einige Mythen, die noch heute in Gesprächen über Programmierung auftauchen.

Mythos 1: „Der Compiler macht das Programm korrekt"

Ein Compiler prüft primär, ob dein Code den Regeln der Sprache folgt und übersetzt werden kann. Wenn deine Logik falsch ist, erzeugt der Compiler oft ein valides Programm, das dennoch das falsche Ergebnis liefert.

Beispiel: Eine Lohnberechnung kann sauber kompilieren und trotzdem falsche Beträge auszahlen, weil eine Formel fehlerhaft ist, ein Randfall fehlt oder eine Zeitzonenannahme übersehen wurde.

Mythos 2: „Hochsprachen verhindern Bugs"

Höhere Sprachen reduzieren bestimmte Fehlerklassen — etwa das manuelle Management von Speicher oder die Verwechslung von CPU‑Instruktionen — aber sie eliminieren Bugs nicht. Du kannst immer noch:

- Eingaben falsch behandeln und Sicherheitslücken erzeugen,

- Code schreiben, der für „normale“ Fälle funktioniert, aber bei ungewöhnlichen Fällen versagt,

- Systeme bauen, die schwer zu ändern sind, weil sie unklar oder inkonsistent sind.

Lesbarkeit ist ein großer Vorteil, aber Lesbarkeit ist nicht dasselbe wie Korrektheit.

Mythos 3: „Wenn es lesbar ist, muss es sicher und effizient sein"

Code kann schön benannt und formatiert sein und trotzdem unsicher (z. B. vertrauensselig gegenüber Nutzereingaben), langsam (z. B. wiederholte Datenbankaufrufe in einer Schleife) oder fragil (z. B. versteckte Abhängigkeiten).

Besser formuliert: Lesbarer Code erleichtert es, Probleme zu finden und zu beheben. Er garantiert sie nicht.

Praktische Gewohnheiten, die Mythen entkräften

Compiler sind Werkzeuge, keine Babysitter. Zuverlässigkeit kommt weiterhin durch gute Arbeitsweisen:

- Benennung: Wähle Namen, die die Absicht erklären, nicht nur die Mechanik.

- Dokumentation: Halte Annahmen fest (Eingaben, Ausgaben, Grenzen).

- Reviews: Hol dir eine zweite Meinung, bevor Änderungen live gehen.

- Tests: Überprüfe Verhalten automatisch, damit Änderungen alte Versprechen nicht brechen.

Grace Hopper forderte Code, den Menschen verstehen. Die beste Umsetzung ist, diese Lesbarkeit mit disziplinierten Praktiken zu verbinden, damit „einfach“ nicht in „nachlässig“ kippt.

Schneller als manuelles Übersetzen

Teste einen compilerähnlichen Workflow zum Erstellen von Apps aus dem Chat mit dem kostenlosen Tarif.

Hoppers Kernwette war einfach: Wenn wir Arbeit in Begriffen beschreiben können, die Menschen verstehen, sollen Computer die Übersetzung übernehmen. Diese Idee steckt in praktisch jedem modernen Programmiererlebnis — vom Schreiben in Python oder JavaScript bis zum Deployment mit industriellen Compiler‑Toolchains.

Heute ist ein „Compiler“ selten ein einzelnes Programm. Es ist eine Pipeline: der Code wird geparst, geprüft, transformiert, optimiert und etwas Ausführbares erzeugt (Maschinencode, Bytecode oder ein optimiertes Bundle). Ob du Go, Rust, Swift oder C# schreibst — du profitierst von derselben Zusage, die Hopper vorantrieb: menschliche Mühsal reduzieren, Absicht klarhalten und Maschinen die sich wiederholende Übersetzungsarbeit überlassen.

Deshalb gehen moderne Entwicklungsansätze weiter in Richtung höherstufiger Schnittstellen, die trotzdem reale, auslieferbare Systeme erzeugen. In Plattformen wie Koder.ai zum Beispiel beschreibst du in einer Chat‑Schnittstelle, was du willst, und ein agentenbasiertes Workflow‑System hilft, eine Anwendung (Web, Backend oder Mobil) zu erzeugen und zu verfeinern, während es exportierbaren Quellcode liefert. Sehr Hopper‑haft ist das Ziel dasselbe: Aufwand von lästiger Übersetzung hin zu klarer Absicht, überprüfbarem Output und schneller Iteration verschieben.

Lebensqualitäts‑Features, die wir heute für selbstverständlich halten

Moderne Compiler übersetzen nicht nur — sie lehren und schützen.

Wenn du eine Fehlermeldung siehst, die auf die genaue Zeile zeigt und eine mögliche Korrektur vorschlägt, ist das ein Erbe der Auffassung, Programmieren als menschliche Tätigkeit zu behandeln und nicht als maschinelles Ritual.

Optimierung ist ein weiterer stiller Gewinn: Compiler können Code schneller oder kleiner machen, ohne dass Entwickler jede Instruktion von Hand tunen müssen.

Statische Analyse (oft in Compilern integriert oder als begleitende Tools) entdeckt Probleme früh — Typinkonsistenzen, unerreichbaren Code, mögliche Null‑Fehler — bevor Software bei Kunden landet.

Wie sich das im Alltag zeigt

Das alles summiert sich zu schnelleren Entwicklungszyklen: du schreibst klareren Code, Tools markieren Probleme früher und Builds erzeugen verlässliche Outputs über Umgebungen hinweg. Auch wenn du nie das Wort „Compiler“ aussprichst, spürst du es, wenn dein IDE einen Bug unterstreicht, dein CI‑Build mit einer präzisen Diagnose fehlschlägt oder ein Toolchain‑Update dein Release beschleunigt.

Das ist Hoppers Vision, die sich im Alltag widerspiegelt.

Zentrale Erkenntnisse: Die Verschiebung, die Software für immer veränderte

Grace Hoppers Compiler‑Arbeit machte Computer nicht nur leichter programmierbar — sie veränderte, was Software überhaupt sein kann. Vor Compilern hing jede Verbesserung von mühsamer, niedrigstufiger Arbeit ab. Nach Compilern konnte ein größerer Anteil menschlicher Zeit in Ideen, Regeln und Verhalten fließen statt in Instruction‑by‑Instruction‑Übersetzung.

Was sich tatsächlich änderte — und warum es Bestand hatte

Zwei Verschiebungen machten den Unterschied:

- Automatisierung: Der Compiler übernahm die repetitiven Aufgaben, bedeutungsvolle Anweisungen in maschinenbereite Schritte zu verwandeln. Das verringerte manuelle Fehler und beschleunigte Iterationen.

- Lesbarkeit: Code rückte näher an menschliche Sprache und Geschäftslogik. Programme wurden zu Dokumenten, die Teams diskutieren, prüfen und warten konnten — nicht nur zu Rätseln, die nur der Autor lösen konnte.

Diese Vorteile verstärkten sich gegenseitig. Wenn Code leichter zu lesen ist, lässt er sich einfacher verbessern. Wenn Übersetzung automatisiert ist, können Teams refaktorisieren und Software anpassen, wenn sich Anforderungen ändern. Deshalb waren Compiler kein einmaliger Trick — sie wurden zur Grundlage moderner Sprachen, Tools und Zusammenarbeit.

Die Hauptbotschaft: Compiler skalieren menschliche Arbeit

Ein Compiler macht Programmieren weniger „einfach“ im Sinne von trivial, sondern mehr skalierbar. Er lässt die Absicht einer Person weiter wirken: über größere Projekte, größere Teams, längere Zeiträume und auf mehr Maschinen.

Ein kurzer Impuls für deinen eigenen Code

Wenn morgen jemand Neu in dein Team käme, welche eine kleine Änderung könntest du vornehmen, damit er deinen Code schneller versteht — bessere Namen, klarere Struktur oder ein kurzer Kommentar, der das „Warum" erklärt?