26. Aug. 2025·8 Min

Guillermo Rauch, Vercel & Next.js: Bereitstellung vereinfachen

Erfahre, wie Guillermo Rauch, Vercel und Next.js Deployment, SSR und Frontend‑Infrastruktur für breite Anwender zu einfacheren Produkten gemacht haben.

Erfahre, wie Guillermo Rauch, Vercel und Next.js Deployment, SSR und Frontend‑Infrastruktur für breite Anwender zu einfacheren Produkten gemacht haben.

Vor nicht allzu langer Zeit bedeutete das Live‑Schalten einer Web‑App meist: bauen, einen Host finden, verdrahten und am Laufen halten. Selbst bei einfachem Code zwang das Live‑Setzen oft Entscheidungen über Server, Caching, Build‑Pipelines, TLS‑Zertifikate und Monitoring. Nichts davon war glamourös, aber unvermeidlich — und es lenkte Teams regelmäßig vom eigentlichen Produkt ab.

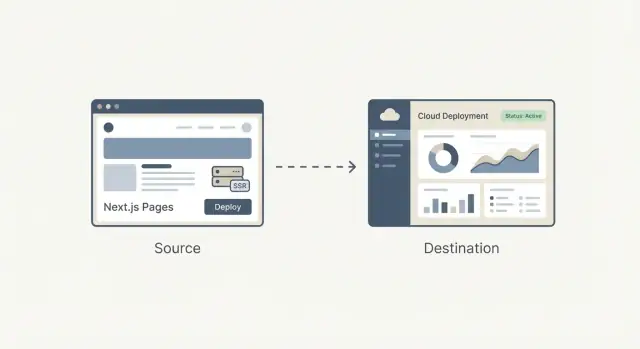

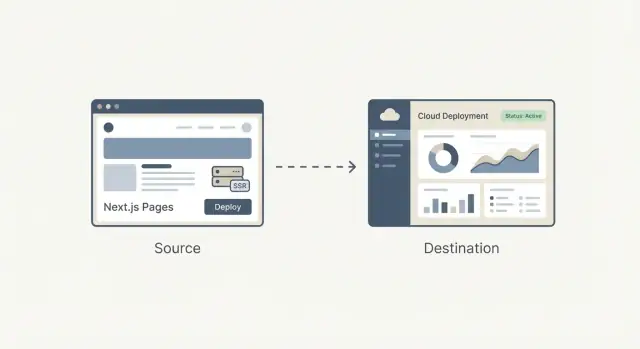

Der große Wandel war, dass Deployment aufhörte, ein einmaliges technisches Projekt zu sein, und stattdessen zu einem Workflow wurde, den man jeden Tag wiederholt. Teams wollten Preview‑URLs für jeden Pull Request, Rollbacks ohne Detektivarbeit und einen verlässlichen Pfad vom lokalen Code zur Produktion.

Als diese Bedürfnisse bei Startups, Agenturen und Unternehmen alltäglich wurden, begann Deployment weniger wie maßgeschneiderte Technik auszusehen und mehr wie etwas, das man verpacken kann: ein Produkt mit klaren Voreinstellungen, einer UI, sinnvoller Automation und vorhersehbaren Ergebnissen.

Server‑Side‑Rendering (SSR) brachte eine zusätzliche Komplexitätsebene. Es ist nicht nur „Dateien ausliefern“; es ist „Code auf dem Server ausführen, HTML generieren, sicher cachen und aktualisieren, ohne Nutzer zu stören“. SSR gut zu betreiben bedeutete, folgende Dinge zu verstehen:

Das war für Spezialisten handhabbar, aber leicht falsch zu konfigurieren — und schwer zu pflegen, wenn ein Projekt wuchs.

Was heißt es also, Frontend‑Infrastruktur zu "productizen"?

Es bedeutet, die unordentlichen, fehleranfälligen Bestandteile des Frontend‑Shipping — Builds, Deploys, Previews, SSR/SSG‑Handling, Caching und Edge‑Auslieferung — in ein standardisiertes, größtenteils automatisches System zu verwandeln, das in Projekten auf ähnliche Weise funktioniert.

In den folgenden Abschnitten ist das Ziel praktisch: zu verstehen, was vereinfacht wird, was du gewinnst und welche Kompromisse du eingehst — ohne ein Ops‑Experte werden zu müssen.

Guillermo Rauch ist heute vor allem als CEO von Vercel und als eine treibende Stimme hinter Next.js bekannt. Sein Einfluss ist weniger eine einzelne Erfindung als eine beständige Obsession: Web‑Entwicklung für Produkt‑Macher „offensichtlich“ zu machen.

Rauch hat einen großen Teil seiner Karriere damit verbracht, Entwickler‑Tools öffentlich auszuliefern. Bevor Vercel entstand, baute und pflegte er populäre Open‑Source‑Projekte (nicht zuletzt Socket.IO) und half dabei, eine Kultur zu etablieren, in der Dokumentation, Beispiele und sinnvolle Voreinstellungen Teil des Produkts sind — nicht bloße Nachgedanken.

Später gründete er ZEIT (heute Vercel), ein Unternehmen, das Deployment in einen schlanken Workflow verwandeln wollte. Next.js, ursprünglich in diesem Ökosystem entstanden, wurde zum Flaggschiff‑Framework, das moderne Frontend‑Erfahrung mit produktionstauglichen Features verband.

Eine nützliche Sicht auf Rauchs Einfluss sind die wiederkehrenden Entscheidungen:

Dieses Augenmerk prägte sowohl das Framework als auch die Plattform: Next.js ermutigte Teams, SSR und statische Generierung zu nutzen, ohne ein komplett neues Betriebs‑Playbook zu lernen, während Vercel Deployment in Richtung vorhersehbarer, wiederholbarer Defaults drückte.

Es ist einfach, die Geschichte auf eine Einzelperson zu reduzieren. Genau genommen half Rauch, einen bereits im Gange befindlichen Wandel zu synchronisieren: Frontend‑Teams wollten schneller iterieren, weniger Übergaben und Infrastruktur, die nicht für jede Änderung einen Ops‑Spezialisten erforderte.

Vercel und Next.js funktionieren als Fallstudie für Produktdenken, weil sie diese Wünsche in Voreinstellungen verpackten, die Mainstream‑Teams tatsächlich nutzen konnten.

Next.js ist ein React‑Framework, das dir ein „Full‑Web‑App‑Starterkit“ auf React‑Basis liefert. Komponenten baust du weiterhin wie gewohnt, aber Next.js ergänzt die fehlenden Bausteine, die die meisten Teams sowieso zusammensetzen: Pages, Routing, Datenlade‑Muster und produktionsfreundliche Performance‑Defaults.

Routing und Pages: In einer reinen React‑App fügst du meist eine Router‑Bibliothek hinzu, definierst URL‑Konventionen und verdrahtest alles. Next.js macht URLs und Pages zu einem Kernfeature, sodass deine Projektstruktur natürlich Routen abbildet.

Datenladen: Reale Apps brauchen Daten — Produktlisten, Benutzerkonten, CMS‑Inhalte. Next.js bietet gängige Muster, um Daten serverseitig, zur Build‑Zeit oder im Browser zu laden, ohne dass jedes Team ein eigenes Setup erfinden muss.

Performance‑Defaults: Next.js sorgt von Haus aus für praktische Optimierungen — Code‑Splitting, intelligentes Asset‑Handling und Rendering‑Entscheidungen — sodass du gute Geschwindigkeit bekommst, ohne eine lange Liste von Plugins abzuarbeiten.

Eine einfache React‑App ist oft „React + viele Entscheidungen“: Routing‑Lib, Build‑Konfiguration, SSR/SSG‑Tools (falls nötig) und Konventionen, die nur im eigenen Repo existieren.

Next.js ist opinionierter: Es standardisiert übliche Entscheidungen, damit neue Entwickler das Projekt schneller verstehen und Teams weniger Zeit mit dem Unterbau verbringen.

Next.js kann übertrieben sein, wenn du eine kleine, überwiegend statische Seite mit wenigen Seiten oder ein einfaches internes Tool baust, bei dem SEO und initiale Ladezeit keine Priorität haben.

Wenn du keine mehrere Rendering‑Optionen, kein strukturiertes Routing oder kein serverseitiges Laden benötigst, ist ein leichtgewichtiges React‑Setup (oder gar kein React) oft einfacher und günstiger.

Moderne Web‑Apps erscheinen oft mysteriös, weil sich „wo die Seite gebaut wird" je nach Ansatz ändert. Eine einfache Denkweise zu SSR, SSG und CSR lautet: wann und wo wird das HTML erzeugt?

Bei SSR erzeugt der Server das HTML für jede Anfrage (oder für viele Anfragen, wenn gecacht wird). Das hilft bei SEO und lässt die erste Ansicht schnell erscheinen — besonders auf langsameren Geräten — weil der Browser früh echten Inhalt bekommt.

Ein verbreiteter Irrtum: SSR ist nicht automatisch schneller. Wenn jede Anfrage langsame DB‑Aufrufe auslöst, kann SSR träge wirken. Die echte Geschwindigkeit kommt oft vom Caching (Server, CDN oder Edge), damit wiederholte Besuche nicht dieselbe Arbeit neu auslösen.

Bei SSG werden Seiten im Voraus (während eines Build‑Schritts) vorgefertigt und als statische Dateien ausgeliefert. Das ist zuverlässig und kosteneffizient und liefert oft exzellente Ladezeiten, weil die Seite „fertig“ ist, bevor der Nutzer kommt.

SSG eignet sich hervorragend für Marketing‑Seiten, Dokumentation und Inhalte, die nicht sekündlich aktualisiert werden. Der Kompromiss ist die Aktualität: Änderungen erfordern meist einen Rebuild oder eine inkrementelle Aktualisierungsstrategie.

Bei CSR lädt der Browser JavaScript und baut die UI auf dem Gerät des Nutzers auf. Das ist ideal für stark interaktive, personalisierte Bereiche (Dashboards, Editoren), kann aber die erste sinnvolle Ansicht verzögern und SEO erschweren, wenn Inhalte nicht als HTML vorliegen.

Die meisten echten Produkte kombinieren Modi: SSG für Landingpages (SEO & Speed), SSR für dynamische, indexierbare Seiten (Produktseiten, Listings) und CSR für eingeloggene Erlebnisse.

Gute Wahl verbindet sich direkt mit Ergebnissen: SEO (Auffindbarkeit), Geschwindigkeit (Conversion) und Zuverlässigkeit (weniger Incidents, stabilerer Umsatz).

Bevor Plattformen Deployment zum Klick‑Erlebnis machten, bedeutete das Ausliefern einer Web‑App oft, ein eigenes kleines Infrastrukturprojekt zusammenzubauen. Selbst eine einfache Marketingseite mit einem dynamischen Kontaktformular konnte zu einer Kette aus Servern, Skripten und Diensten werden, die synchron gehalten werden mussten.

Ein gängiges Setup sah so aus: Du provisionierst einen oder mehrere Server (VMs), installierst einen Webserver und richtest eine CI‑Pipeline ein, die deine App baut und Artefakte per SSH kopiert.

Dazu kommt oft ein Reverse‑Proxy (z. B. Nginx) für Routing, TLS‑Termination und Kompression. Dann Caching: eventuell ein HTTP‑Cache, CDN‑Konfiguration und Regeln, welche Seiten wie lange gecacht werden können.

Wenn du SSR brauchtest, betreibst du einen Node‑Prozess, der gestartet, überwacht, neu gestartet und skaliert werden musste.

Die Probleme waren nicht theoretisch — sie traten bei jedem Release auf:

Lokale Entwicklung versteckt die unordentlichen Teile: Du hast einen warmen Cache, eine andere Node‑Version, andere Env‑Variablen und kein echtes Traffic‑Pattern.

Nach dem Deploy treten diese Unterschiede sofort auf — oft als subtile SSR‑Mismatchs, fehlende Secrets oder anders funktionierendes Routing hinter einem Proxy.

Fortgeschrittene Setups (SSR, Multi‑Region, sichere Preview‑Umgebungen) waren möglich, verlangten aber Betriebszeit. Für viele kleine Teams bedeutete das, sich für einfachere Architektur zu entscheiden — nicht weil sie besser war, sondern weil der Deployment‑Aufwand zu groß war.

Vercel hat Deployment nicht nur automatisiert — die Firma hat es als Default‑Workflow verpackt, der sich wie Teil des Codierens anfühlt. Die Produktidee ist simpel: Deployment sollte keine separate Ops‑Aufgabe sein, sondern die normale Konsequenz alltäglicher Entwicklung.

„Git push to deploy“ wird oft wie ein hübsches Skript beschrieben. Vercel behandelt es eher wie ein Versprechen: Wenn dein Code in Git ist, ist er zuverlässig deploybar — konsistent, wiederholbar und ohne eine Checkliste manueller Schritte.

Der Unterschied ist wichtig, weil er verändert, wer sich sicher fühlt zu deployen. Du brauchst keinen Spezialisten, der Server‑Settings, Cache‑Regeln oder Build‑Schritte jedes Mal interpretiert. Die Plattform macht diese Entscheidungen zu Voreinstellungen und Guardrails.

Preview‑Deploys sind ein großer Grund, warum sich das wie ein Workflow anfühlt, nicht nur wie ein Tool. Jeder Pull Request kann eine teilbare URL erzeugen, die der Produktionsumgebung sehr ähnlich ist.

Designer prüfen Abstände und Interaktionen in einer echten Umgebung. QA testet exakt den Build, der ausgeliefert würde. PMs klicken Features an und geben konkretes Feedback — ohne auf einen Staging‑Push warten oder jemanden bitten zu müssen, den Branch lokal zu starten.

Wenn Deploys häufig werden, wird Sicherheit zum täglichen Bedürfnis. Schnelle Rollbacks machen ein schlechtes Release zur Unannehmlichkeit statt zum Incident.

Umgebungsgleichheit — Previews, Staging und Produktion ähnlich zu halten — reduziert das „auf meinem Rechner funktioniert's“‑Problem, das Teams ausbremst.

Stell dir vor, du rollst eine neue Pricing‑Seite aus plus eine kleine Änderung im Signup‑Flow. Mit Preview‑Deploys prüft Marketing die Seite, QA testet den Flow und das Team merged mit Vertrauen.

Zeigt die Analyse nach dem Launch ein Problem, rollst du in Minuten zurück, während du den Fix baust — ohne alles andere einfrieren zu müssen.

Ein CDN (Content Delivery Network) ist ein Netzwerk von Servern weltweit, das Kopien deiner Dateien (Bilder, CSS, JavaScript und manchmal HTML) speichert, damit Nutzer von einem nahegelegenen Ort laden.

Caching ist das Regelwerk dafür, wie lange diese Kopien wiederverwendet werden dürfen. Gutes Caching bedeutet schnellere Seiten und weniger Last beim Origin. Schlechtes Caching bedeutet veraltete Inhalte oder Angst davor, überhaupt zu cachen.

Die Edge ist der nächste Schritt: Anstatt nur Dateien global zu verteilen, kannst du kleine Code‑Stücke nahe beim Nutzer zur Anfragezeit ausführen.

Hier wird „Frontend‑Infrastruktur ohne Ops‑Team“ real: Viele Teams erhalten globale Verteilung und intelligentes Request‑Handling, ohne Server in mehreren Regionen verwalten zu müssen.

Edge‑Funktionen sind ideal, wenn du schnelle Entscheidungen vor dem Ausliefern einer Seite brauchst:

Wenn deine Seite größtenteils statisch ist, niedrigen Traffic hat oder du strikte Vorgaben zum Ausführungsort (rechtlich, Datenresidenz) hast, fügt Edge Komplexität ohne klaren Nutzen hinzu.

Code in vielen Locations auszuführen erschwert Observability und Debugging: Logs und Traces sind verteilt, und das Reproduzieren von „funktioniert nur in einer Region“‑Fehlern braucht Zeit.

Es gibt auch anbieter‑spezifisches Verhalten (APIs, Limits, Laufzeitunterschiede), das Portabilität beeinflussen kann.

Bei bedachter Nutzung bieten Edge‑Fähigkeiten „global by default“‑Performance und Kontrolle — ohne ein Ops‑Team zusammenzunähen.

Ein Framework und eine Hosting‑Plattform „passen zusammen“, wenn der Host versteht, was das Framework zur Build‑Zeit erzeugt — und was es zur Anfragezeit braucht.

Das erlaubt dem Host, Build‑Output zu interpretieren (statische Dateien vs. Server‑Funktionen), richtige Routing‑Regeln anzuwenden (dynamische Routen, Rewrites) und sinnvolles Caching zu setzen (was am Edge gecacht werden darf, was frisch sein muss).

Wenn die Plattform die Konventionen des Frameworks kennt, verschwindet viel Arbeit:

Der Gesamtnutzen sind weniger maßgeschneiderte Skripte und weniger „auf meinem Rechner funktioniert's nicht“‑Überraschungen beim Deploy.

Der Nachteil ist Bequemlichkeits‑Lock‑in. Vertraut dein App auf plattformspezifische Features (Edge‑APIs, proprietäre Caching‑Regeln, Build‑Plugins), kann ein späterer Wechsel Teile deines Routings, Middleware oder Deployment‑Pipelines zur Überarbeitung zwingen.

Um Portabilität zu bewahren: trenne Belange, halte Geschäftslogik framework‑nah, dokumentiere host‑spezifisches Verhalten und bevorzuge Standards (HTTP‑Header, Redirects, Env‑Variablen).

Gehe nicht davon aus, dass es eine beste Wahl gibt. Vergleiche Plattformen nach: Deployment‑Flow, unterstützten Rendering‑Modi, Cache‑Kontrolle, Edge‑Support, Observability, vorhersehbarer Preisgestaltung und wie einfach ein Exit ist.

Ein kleines Proof‑of‑Concept — dasselbe Repo bei zwei Providern deployen — zeigt oft die realen Unterschiede schneller als Dokumentation.

Performance ist nicht nur ein guter Benchmarkwert. Sie ist ein Produktfeature: schnellere Seiten senken Absprungraten und erhöhen Conversion, und schnellere Builds erlauben Teams, öfter zu releasen, ohne zu warten.

Für Nutzer heißt „schnell“, dass eine Seite auf typischen Geräten zügig nutzbar wird — besonders auf Mittelklasse‑Phones und langsamen Netzen. Für Teams heißt „schnell“, dass Deploys in Minuten (oder Sekunden) abgeschlossen sind, sodass Änderungen mit Vertrauen live gehen.

Vercel machte populär, dass man beides gleichzeitig optimieren kann, indem Performance Teil des Default‑Workflows wird statt ein Spezialprojekt.

Ein traditioneller Build baut oft alles neu, selbst wenn du nur eine Zeile auf einer Seite geändert hast. Inkrementelle Builds versuchen nur das neu zu bauen, was sich geändert hat — wie ein einzelnes Kapitel in einem Buch aktualisieren statt das ganze Buch neu zu drucken.

Caching hilft, indem es vorher berechnete Ergebnisse wiederverwendet:

In Next.js passen Muster wie Incremental Static Regeneration (ISR) zu diesem Denken: serviere eine schnelle vorgefertigte Seite und aktualisiere sie im Hintergrund, wenn Inhalte sich ändern.

Ein Performance‑Budget ist eine einfache Grenze, z. B. „Homepage unter 200KB JS halten“ oder „Largest Contentful Paint unter 2,5s auf typischem Mobilgerät“. Der Punkt ist nicht Perfektion, sondern zu verhindern, dass Seiten langsam werden.

Halt es leichtgewichtig und konsistent:

Wenn Geschwindigkeit als Feature behandelt wird, verbessert sich Nutzererlebnis und Takt der Team‑Iterationen, ohne dass jeder Release eine Performance‑Feuerwehrübung wird.

Die meisten Tools werden nicht mainstream, weil sie am flexibelsten sind — sie siegen, weil neue Nutzer schnell Erfolg haben können.

Mainstream‑Builder (kleine Teams, Agenturen, Produktentwickler ohne tiefes Infra‑Wissen) prüfen Plattformen mit einfachen Fragen:

Hier zählen Templates, klare Docs und „Happy‑Path“‑Workflows. Ein Template, das in Minuten deployed und Routing, Datenabruf und Auth demonstriert, überzeugt oft mehr als eine Feature‑Matrix.

Dokumentation, die einen empfohlenen Weg zeigt (und erklärt, wann man abweichen sollte), reduziert Rätselzeit.

Eine lange Liste von Schaltern kann mächtig wirken, zwingt aber jedes Team, Experte zu werden, nur um Basisentscheidungen zu treffen. Sinnvolle Defaults senken die kognitive Last:

Wenn Defaults stimmen, verbringen Teams Zeit mit Produktarbeit statt Konfiguration.

Real‑World Builder starten oft mit bewährten Mustern:

Die besten Templates sehen nicht nur gut aus — sie kodieren bewährte Strukturen.

Zwei Fehler tauchen oft auf:

Eine gute Lernkurve lenkt Teams zu einem klaren Startpunkt und macht fortgeschrittene Entscheidungen zu bewusst gewählten Upgrades, nicht zu Pflichtaufgaben.

Deployment‑Plattformen haben den Weg von Git zur Produktion produktisiert. Ein ähnlicher Trend passiert früher im Prozess: den Weg von Idee zu einer funktionierenden Codebasis zu productizen.

Koder.ai ist ein Beispiel für dieses „vibe‑coding“: Du beschreibst, was du willst, in einer Chat‑Schnittstelle, und die Plattform nutzt agentenbasierte LLM‑Workflows, um eine echte Anwendung zu generieren und iterativ zu verbessern. Sie zielt auf Web, Server und Mobile (React im Frontend, Go + PostgreSQL im Backend, Flutter für Mobile) mit praktischen Versandfeatures wie Quellcode‑Export, Deployment/Hosting, Custom Domains, Snapshots und Rollback.

In der Praxis passt das gut zu dem hier beschriebenen Workflow: Die Schleife von Absicht → Implementierung → Preview‑URL → Produktion wird verkürzt, während ein Fluchtweg (exportierbarer Code) bleibt, wenn du die Defaults übersteigen willst.

Eine Frontend‑Plattform zu wählen heißt nicht nur „wo hosten“. Es ist die Wahl des Default‑Workflows, in dem dein Team lebt: wie Code zur URL wird, wie Änderungen geprüft werden und wie Ausfälle gehandhabt werden.

Viele Plattformen sehen auf der Startseite ähnlich aus, divergieren aber bei der Abrechnung. Vergleiche Einheiten, die zu deinem echten Einsatz passen:

Praktischer Tipp: Schätze Kosten für einen normalen Monat und einen „Launch‑Woche“‑Monat. Wenn du beides nicht simulieren kannst, überrascht dich die Rechnung zum ungünstigsten Zeitpunkt.

Du musst kein Infra‑Experte sein, aber stelle direkte Fragen:

Wenn deine Kunden global sind, können Regionsabdeckung und Cache‑Verhalten genauso wichtig sein wie rohe Performance.

Achte auf alltägliche Schutzmaßnahmen statt vager Versprechen:

Nutze das als Schnellfilter vor tieferer Evaluierung:

Wähle die Plattform, die die „Deployment‑Entscheidungen" reduziert, die dein Team wöchentlich treffen muss — und dir gleichzeitig genug Kontrolle lässt, wenn es wichtig wird.

Productisierung verwandelt Deployment‑ und Rendering‑Entscheidungen von maßgeschneiderter Ingenieursarbeit in wiederholbare Voreinstellungen. Das reduziert Reibung an zwei Stellen, die Teams meist ausbremsen: Änderungen live zu bekommen und Performance vorhersagbar zu halten.

Wenn der Pfad von Commit → Preview → Produktion standardisiert ist, wird die Iteration schneller, weil weniger Releases von einem Spezialisten abhängen (oder von einem glücklichen Nachmittag Debugging).

Starte mit der kleinsten Oberfläche, die dir Feedback liefert:

Wenn das funktioniert, weite schrittweise aus:

Wenn du tiefer einsteigen willst, ohne dich zu verirren, schau dir Muster und Fallstudien auf /blog an und prüfe Kosten und Limits auf /pricing.

Wenn du außerdem schneller von Anforderungen zu einer funktionierenden Basis kommen willst — besonders für kleine Teams — kann Koder.ai als Begleiter nützlich sein: Erstversion per Chat generieren, schnell mit Stakeholdern iterieren und denselben produktisierten Weg zu Previews, Rollbacks und Produktion nutzen.

Integrierte Plattformen optimieren für Geschwindigkeit beim Shipping und weniger operative Entscheidungen. Der Kompromiss ist geringere Low‑Level‑Kontrolle (kundenspezifische Infrastruktur, spezielle Compliance‑Anforderungen, individuelles Networking).

Wähle das „am meisten produktisierte" Setup, das noch zu deinen Constraints passt — und halte einen Exit‑Plan (portable Architektur, klare Build‑Schritte) bereit, damit deine Entscheidung aus Stärke statt aus Lock‑in entsteht.

Das bedeutet, die unordentlichen Teile des Frontend-Lieferprozesses — Builds, Deploys, Previews, SSR/SSG-Verwaltung, Caching und globale Auslieferung — in einen wiederholbaren Workflow mit sinnvollen Voreinstellungen zu verpacken.

Praktisch reduziert das die Anzahl an benutzerdefinierten Skripten und dem „tribal knowledge“, das nötig ist, um von einem Commit zu einer verlässlichen Produktions‑URL zu kommen.

Weil Deployment zu einem täglichen Workflow wurde, nicht zu einem gelegentlichen Projekt. Teams brauchten:

Als diese Bedürfnisse allgemein wurden, ließen sie sich als Produkt‑Erlebnis standardisieren statt für jedes Team neu zu erfinden.

SSR ist nicht nur das Ausliefern von Dateien; es bedeutet, Server‑Code auszuführen, um HTML zu erzeugen, und das schnell und sicher mit Caching und Routing zu machen.

Typische Komplexitätsquellen sind Laufzeitumgebung (Node/Serverless), Cache‑Invalidierung, Cold‑Starts, Header/Rewrite‑Regeln und sicherzustellen, dass das Produktionsverhalten der lokalen Entwicklung entspricht.

Denke in dem Moment und dem Ort, an dem HTML erzeugt wird:

Viele Apps mischen die Modi: SSG für Marketing/Docs, SSR für indexierbare dynamische Seiten und CSR für sehr interaktive, eingeloggte Bereiche.

Eine einfache React‑App wird oft zu „React + einem Haufen Entscheidungen“ (Routing, Build‑Konfiguration, Rendering‑Strategie, Projektkonventionen). Next.js standardisiert häufige Anforderungen:

Besonders wertvoll ist Next.js, wenn du SEO, mehrere Render‑Modi oder eine konsistente Full‑App‑Struktur brauchst.

Wenn du eine kleine, überwiegend statische Seite, ein einfaches internes Tool oder etwas baust, bei dem SEO und First‑Load‑Performance keine wichtige Rolle spielen, kann Next.js unnötigen Overhead bringen.

In solchen Fällen ist ein leichtgewichtiges statisches Setup (oder ein einfaches SPA) oft billiger zu betreiben und leichter zu verstehen.

Preview‑Deploys erzeugen für jeden Pull Request eine teilbare URL, die der Produktionsumgebung sehr ähnlich ist.

Dadurch verbessert sich die Zusammenarbeit, weil:

Das verringert auch letzte „nur‑staging“-Überraschungen.

Nicht automatisch. SSR kann langsam sein, wenn jede Anfrage teure Arbeit (DB‑Abfragen, langsame APIs) auslöst.

SSR wirkt schnell, wenn es mit klugen Caching‑Regeln kombiniert wird:

Der Performance‑Gewinn kommt oft aus der Caching‑Strategie, nicht aus SSR allein.

Edge führt kleine Code‑Stücke nahe beim Nutzer aus — nützlich für:

Überflüssig ist Edge, wenn deine Seite größtenteils statisch ist, wenig Traffic hat oder du strikte Anforderungen an den Ausführungsort (Datenresidenz/Compliance) hast. Debugging kann schwieriger sein, weil Logs und Fehler über Regionen verteilt sind.

Die Integration vereinfacht Routing, Previews und Caching, weil der Host weiß, was das Framework zur Build‑Zeit produziert. Der Nachteil ist durch Bequemlichkeit entstehende Lock‑in.

Um einen Ausstiegsweg offen zu halten:

Ein praktischer Test: deploye dasselbe Repo zu zwei Anbietern und vergleiche den Aufwand.