15. Dez. 2025·8 Min

James Gosling, Java und der Aufstieg von „Write Once, Run Anywhere“

Wie James Goslings Java und „Write Once, Run Anywhere“ Unternehmenssysteme, Tooling und heutige Backend‑Praktiken beeinflussten — von der JVM bis zur Cloud.

Was dieser Beitrag abdeckt (und warum es noch wichtig ist)

Das bekannteste Versprechen von Java — „Write Once, Run Anywhere“ (WORA) — war kein Marketing-Claim für Backend-Teams. Es war eine praktische Wette: Man konnte ein ernsthaftes System einmal bauen, es auf unterschiedlichen Betriebssystemen und Hardware betreiben und es wartbar halten, während das Unternehmen wuchs.

Dieser Beitrag erklärt, wie diese Wette funktionierte, warum Unternehmen Java so schnell übernahmen und wie Entscheidungen aus den 1990er Jahren noch heute moderne Backend-Entwicklung prägen — Frameworks, Build-Tools, Deployment-Muster und die lange Lebensdauer vieler Produktionssysteme.

Was Sie aus dieser Geschichte mitnehmen

Wir beginnen mit James Goslings ursprünglichen Zielen für Java und wie Sprache und Laufzeit entworfen wurden, um Portabilitätsprobleme zu reduzieren, ohne die Performance zu stark zu opfern.

Dann verfolgen wir die Unternehmensgeschichte: warum Java für große Organisationen eine sichere Wahl war, wie App-Server und Unternehmensstandards entstanden und warum Tooling (IDEs, Build-Automation, Tests) zum Multiplikator für Produktivität wurde.

Abschließend verbinden wir die „klassische“ Java-Welt mit heutigen Realitäten — dem Aufstieg von Spring, Cloud-Deployments, Containern, Kubernetes und was „run anywhere“ wirklich bedeutet, wenn Ihre Laufzeit dutzende Dienste und Drittanbieter-Abhängigkeiten umfasst.

Wichtige Begriffe (im Beitrag verwendet)

Portabilität: Die Fähigkeit, dasselbe Programm in verschiedenen Umgebungen (Windows/Linux/macOS, unterschiedliche CPU-Typen) mit minimalen oder keinen Änderungen auszuführen.

JVM (Java Virtual Machine): Die Laufzeit, die Java-Programme ausführt. Statt direkt in maschinenspezifischen Code zu kompilieren, zielt Java auf die JVM.

Bytecode: Das Zwischenformat, das der Java-Compiler erzeugt. Bytecode ist das, was die JVM ausführt, und bildet den Kernmechanismus hinter WORA.

WORA ist noch relevant, weil viele Backend-Teams heute mit denselben Abwägungen kämpfen: stabile Laufzeiten, vorhersehbare Deployments, Teamproduktivität und Systeme, die eine Dekade oder länger überdauern müssen.

James Gosling und die ursprünglichen Ziele von Java

Java wird eng mit James Gosling verbunden, war aber nie ein Alleingang. Bei Sun Microsystems Anfang der 1990er Jahre arbeitete Gosling mit einem kleinen Team (oft das „Green“-Projekt genannt) daran, eine Sprache und Laufzeit zu schaffen, die über verschiedene Geräte und Betriebssysteme hinweg laufen konnte, ohne jedes Mal neu geschrieben werden zu müssen.

Das Ergebnis war nicht nur eine neue Syntax — es war die Idee einer kompletten „Plattform“: Sprache, Compiler und eine virtuelle Maschine, die zusammen entworfen wurden, damit Software mit weniger Überraschungen ausgeliefert werden konnte.

Die Ziele: Sicherheit, Portabilität, Produktivität

Einige praktische Ziele prägten Java von Anfang an:

- Sicherheit und Zuverlässigkeit: Java beseitigte oder beschränkte häufige Absturzursachen aus C/C++ — insbesondere direkte Pointer-Manipulation — und ergänzte Laufzeitprüfungen, die vorhersehbare Fehler statt stiller Korruption bevorzugen.

- Portabilität: Statt in den Maschinencode einer CPU zu kompilieren, kompiliert Java in Bytecode, der auf einer kompatiblen JVM läuft. Diese Entscheidung machte „cross-platform“ weniger zu bedingter Kompilierung und mehr zu einem konsistenten Laufzeitvertrag.

- Entwicklerproduktivität: Java hatte das Ziel, alltägliches Programmieren schneller und weniger fehleranfällig zu machen — durch eine Standardbibliothek, konsistente Tooling-Erwartungen und automatische Speicherverwaltung.

Das waren keine akademischen Ziele, sondern Antworten auf reale Kosten: Debugging von Speicherproblemen, Pflege mehrerer plattformspezifischer Builds und das Onboarding von Teams in komplexe Codebasen.

Was „Write Once, Run Anywhere“ bedeutete (und nicht)

In der Praxis bedeutete WORA:

- Wenn Sie auf die JVM zielen, können Sie in der Regel denselben Bytecode auf verschiedene Betriebssysteme ausliefern.

- Sie müssen trotzdem Umgebungsunterschiede handhaben: Dateipfade, Locale-Verhalten, Netzwerkbesonderheiten, Performance-Charakteristika, native Integrationen und Packaging für Deployments.

Der Slogan war also kein Versprechen magischer Portabilität. Er verlagert vielmehr die Arbeit an der Portabilität: weg von plattformspezifischen Umschreibungen hin zu einer standardisierten Laufzeit und Bibliotheken.

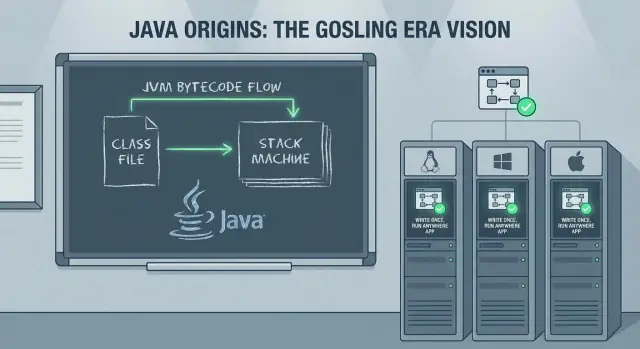

Wie WORA funktioniert: Bytecode und die JVM

WORA ist ein Kompilations- und Laufzeitmodell, das Bauen und Ausführen von Software trennt.

Quellcode → Bytecode → JVM-Ausführung

Java-Quell Dateien (.java) werden von javac in Bytecode (.class-Dateien) kompiliert. Bytecode ist ein kompaktes, standardisiertes Instruktionsset, das unabhängig davon ist, ob Sie auf Windows, Linux oder macOS kompiliert haben.

Zur Laufzeit lädt die JVM diesen Bytecode, verifiziert ihn und führt ihn aus. Die Ausführung kann interpretiert, zur Laufzeit kompiliert (JIT) oder eine Mischung aus beidem sein — abhängig von JVM und Workload.

Die JVM als OS/CPU-„Adapter"

Statt beim Build Maschinencode für jede Ziel-CPU und jedes Betriebssystem zu erzeugen, zielt Java auf die JVM. Jede Plattform liefert ihre eigene JVM-Implementierung, die weiß, wie sie:

- Bytecode in native Instruktionen für die lokale CPU übersetzt

- mit dem lokalen Betriebssystem interagiert (Dateien, Netzwerk, Threads)

Diese Abstraktion ist der zentrale Trade-off: Ihre Anwendung spricht mit einer konsistenten Laufzeit, und die Laufzeit spricht mit der Maschine.

Laufzeitprüfungen und Speicherverwaltung

Portabilität hängt auch von zur Laufzeit durchgesetzten Garantien ab. Die JVM führt Bytecode-Verifikation und weitere Prüfungen durch, die unsichere Operationen verhindern helfen.

Und statt Entwickler manuell Speicher zuweisen und freigeben zu lassen, bietet die JVM automatische Speicherverwaltung (Garbage Collection), wodurch eine ganze Kategorie plattformspezifischer Abstürze und „läuft nur auf meinem Rechner“-Bugs reduziert wird.

Warum das Deployment über viele Systeme vereinfacht wurde

Für Unternehmen mit gemischter Hardware und verschiedenen Betriebssystemen war der Nutzen operativ: dieselben Artefakte (JARs/WARs) an verschiedene Server liefern, sich auf eine JVM-Version standardisieren und weitgehend einheitliches Verhalten erwarten. WORA beseitigte nicht alle Portabilitätsprobleme, aber es fokussierte sie — was großangelegte Deployments einfacher zu automatisieren und zu warten machte.

Warum Unternehmen Java so schnell übernahmen

In den späten 1990er und frühen 2000er Jahren hatten Unternehmen eine konkrete Wunschliste: Systeme, die jahrelang betrieben werden können, Personalwechsel überstehen und auf einem unordentlichen Mix aus UNIX-Boxen, Windows-Servern und wechselnder Hardware laufen.

Java kam mit einer ungewöhnlich unternehmensfreundlichen Geschichte: Teams konnten einmal bauen und einheitliches Verhalten über heterogene Umgebungen erwarten, ohne mehrere plattformspezifische Codebasen zu pflegen.

Weniger Umschreibungen, weniger QA-Aufwand

Vor Java bedeutete das Verschieben einer Anwendung zwischen Plattformen oft, plattformspezifische Teile (Threads, Netzwerk, Dateipfade, UI-Toolkits, Compiler-Unterschiede) umzuschreiben. Jede Umschreibung vervielfachte Testaufwand — und Unternehmens-Tests sind teuer, weil sie Regressionstests, Compliance-Prüfungen und das „Payroll darf nicht ausfallen“-Vorgehen einschließen.

Java reduzierte diesen Aufwand. Statt mehrere native Builds zu verifizieren, konnten viele Organisationen auf ein einziges Build-Artefakt und eine konsistente Laufzeit standardisieren, wodurch laufende QA-Kosten sanken und Lebenszyklusplanung realistischer wurde.

Eine Standardbibliothek mit konsistentem Verhalten

Portabilität ist nicht nur, denselben Code auszuführen; es geht auch darum, auf dasselbe Verhalten zu vertrauen. Die Java-Standardbibliotheken boten eine verlässliche Basis für Kernaufgaben wie:

- Netzwerk- und Webprotokolle

- Datenbankzugriff (via JDBC und Vendor-Treibern)

- Sicherheitsprimitiven

- Threading- und Concurrency-Bausteinen

Diese Konsistenz erleichterte gemeinsame Praktiken in Teams, das Onboarding von Entwicklern und die Nutzung von Drittanbieterbibliotheken ohne viele Überraschungen.

Wo Portabilität dennoch scheiterte

Die „write once“-Geschichte war nicht perfekt. Portabilität konnte scheitern, wenn Teams von folgenden Dingen abhingen:

- nativen Bibliotheken (JNI) für Hardware-Integration oder Legacy-Code

- betriebssystemspezifischen Dateisystem- oder Locale-Besonderheiten

- vendor-spezifischen Datenbank- oder Application-Server-Features

Dennoch reduzierte Java das Problem häufig auf einen kleinen, klar definierten Randbereich — statt die gesamte Anwendung plattformspezifisch zu machen.

Unternehmensplattformen: App-Server und Jakarta EE

Als Java von Desktops in Rechenzentren vorrückte, brauchten Teams mehr als Sprache und JVM — sie brauchten vorhersehbare Wege, gemeinsame Backend-Funktionen zu deployen und zu betreiben. Diese Nachfrage förderte das Aufkommen von Application Servern wie WebLogic, WebSphere und JBoss (und leichtergewichtigen Servlet-Containern wie Tomcat).

Standardisiertes Deployment (WAR/EAR)

Ein Grund für die Verbreitung von App-Servern war das Versprechen standardisierter Packaging- und Deployment-Modelle. Statt für jede Umgebung ein eigenes Installationsskript zu liefern, konnten Teams eine Anwendung als WAR (Web Archive) oder EAR (Enterprise Archive) bündeln und in einen Server mit konsistentem Laufzeitmodell deployen.

Dieses Modell trennte Verantwortlichkeiten: Entwickler konzentrierten sich auf Business-Logik, während der Betrieb sich auf den App-Server für Konfiguration, Sicherheitsintegration und Lifecycle-Management verließ.

Unternehmensmuster, die jeder brauchte

App-Server popularisierten Muster, die in nahezu jedem ernsthaften Geschäftssystem auftauchen:

- Transaktionen: Koordination mehrstufiger Operationen (oft über Datenbanken und Dienste), damit Fehler keine halbfertigen Daten hinterlassen.

- Messaging: Asynchrone Verarbeitung über Queues und Topics, die Lastspitzen abfedert und Systeme entkoppelt.

- Connection Pooling: Wiederverwendung teurer Datenbankverbindungen statt Öffnen pro Anfrage.

Das waren keine „Nice-to-haves“ — es war die Infrastruktur für zuverlässige Zahlungsflüsse, Auftragsverarbeitung, Bestandsaktualisierungen und interne Workflows.

Von Servlets/JSP zu modernen Web-Backends

Die Servlet/JSP-Ära war eine wichtige Brücke. Servlets etablierten ein Standard-Request/Response-Modell, während JSP die serverseitige HTML-Generierung zugänglicher machte.

Obwohl die Branche später zu APIs und Frontend-Frameworks wechselte, legten Servlets das Fundament für heutige Web-Backends: Routing, Filter, Sessions und konsistentes Deployment.

Jakarta EE als Standardisierungsbemühung

Diese Fähigkeiten wurden im Laufe der Zeit als J2EE, später Java EE und heute Jakarta EE formalisiert: eine Sammlung von Spezifikationen für Enterprise-Java-APIs. Der Wert von Jakarta EE liegt in der Standardisierung von Schnittstellen und Verhalten über Implementierungen hinweg, sodass Teams gegen bekannte Verträge entwickeln können statt gegen einen proprietären Vendor-Stack.

Performance: JIT, GC und die Kosten der Portabilität

Sicher bereitstellen

Stelle und hoste deine App mit einem wiederholbaren Workflow, der sich einfach zurückrollen lässt.

Java-Portabilität wirft die Frage auf: Wenn dasselbe Programm auf sehr unterschiedlichen Maschinen laufen kann, wie kann es dann auch schnell sein? Die Antwort liegt in Laufzeit-Technologien, die Portabilität für reale Workloads praktikabel machten — besonders auf Servern.

Garbage Collection: weniger Zeit mit Speicherverwaltung, weniger Produktionsfehler

Garbage Collection (GC) war wichtig, weil große Serveranwendungen enorme Mengen an Objekten erzeugen und verwerfen: Anfragen, Sessions, gecachte Daten, geparste Payloads und mehr. In Sprachen mit manueller Speicherverwaltung führen diese Muster oft zu Leaks, Abstürzen oder schwer zu debuggender Korruption.

Mit GC konnten sich Teams auf Business-Logik konzentrieren, statt auf „wer free't was und wann“. Für viele Unternehmen überwog dieser Zuverlässigkeitsvorteil Mikro-Optimierungen.

JIT-Kompilierung: die Performance-Brücke für Portabilität

Java führt Bytecode auf der JVM aus, und die JVM nutzt Just-In-Time (JIT)-Kompilierung, um heiße Teile Ihres Programms in optimierten Maschinencode für die aktuelle CPU zu übersetzen.

Das ist die Brücke: Ihr Code bleibt portabel, während die Laufzeit sich an die Umgebung anpasst — und oft die Performance im Lauf der Zeit verbessert, indem sie lernt, welche Methoden am meisten genutzt werden.

Die Trade-offs: Warm-up, Tuning und Latenzempfindlichkeit

Diese Laufzeitsmarts sind nicht umsonst. JIT verursacht Aufwärmzeit, in der die Performance langsamer sein kann, bis die JVM genügend Verkehr beobachtet hat, um zu optimieren.

GC kann ebenfalls Pausen verursachen. Moderne Collector reduzieren diese drastisch, aber latenzempfindliche Systeme brauchen weiterhin sorgfältige Auswahl und Tuning (Heap-Größe, Collector-Auswahl, Allokationsmuster).

Profiling als normaler Teil der Java-Arbeit

Weil viel Performance vom Laufzeitverhalten abhängt, wurde Profiling zur Routine. Java-Teams messen oft CPU, Allokationsraten und GC-Aktivität, um Engpässe zu finden — und behandeln die JVM als etwas, das man beobachtet und anpasst, nicht als Blackbox.

Tooling, das Teamproduktivität veränderte

Java gewann nicht nur durch Portabilität. Es brachte auch eine Tooling-Story mit, die große Codebasen überlebbar machte — und Enterprise-Entwicklung weniger wie Glücksspiel erscheinen ließ.

IDEs: vom Dateieneditieren zum Verständnis ganzer Systeme

Moderne Java-IDEs (und die Sprachfeatures, auf denen sie aufbauten) veränderten die tägliche Arbeit: präzise Navigation über Pakete hinweg, sichere Refactorings und immer eingeschaltete statische Analyse.

Methoden umbenennen, ein Interface extrahieren oder eine Klasse zwischen Modulen verschieben — und dabei automatisch Imports, Aufrufstellen und Tests aktualisieren. Für Teams bedeutete das weniger „Nicht anfassen“-Zonen, schnellere Code-Reviews und konsistentere Struktur mit wachsendem Projektumfang.

Builds und Abhängigkeiten: Ant → Maven/Gradle

Frühe Java-Builds nutzten oft Ant: flexibel, aber leicht zu einem individuellen Skript verkommen, das nur eine Person verstand. Maven brachte ein konventionsbasiertes Vorgehen mit standardisierter Projektstruktur und Abhängigkeitsmodell, das auf jedem Rechner reproduzierbar war. Gradle brachte später ausdrucksstärkere Builds und schnellere Iterationen, während das Abhängigkeitsmanagement im Fokus blieb.

Der große Wandel war Reproduzierbarkeit: derselbe Befehl, dasselbe Ergebnis auf Entwickler-Laptops und in CI.

Warum Standard-Tooling Teams beim Skalieren half

Standard-Projektstrukturen, Abhängigkeitskoordinaten und vorhersehbare Build-Schritte reduzierten Tribal Knowledge. Onboarding wurde einfacher, Releases weniger manuell und es wurde praktikabel, gemeinsame Qualitätsregeln (Formatting, Checks, Test-Gates) über viele Services hinweg durchzusetzen.

Praktische Checkliste für ein modernes Java-Projekt

- Verwenden Sie eine aktuelle LTS-JDK-Version (und fixieren Sie sie in CI).

- Wählen Sie Maven oder Gradle; halten Sie das Build minimal und dokumentiert.

- Zentralisieren Sie Abhängigkeitsversionen (BOM oder Version Catalog).

- Fügen Sie Formatierung + statische Checks (z. B. Checkstyle/SpotBugs) als Build-Schritte hinzu.

- Erzwingen Sie Unit-Tests und erzeugen Sie Coverage-Reports.

- Nutzen Sie eine reproduzierbare CI-Pipeline, die Build + Tests bei jeder Änderung ausführt.

- Dokumentieren Sie „Wie lokal starten“ in einer kurzen README.

Testing und Delivery: Von JUnit zu CI/CD

Sicher iterieren

Erstelle Snapshots und rolle Änderungen zurück, wenn Experimente scheitern.

Java-Teams bekamen nicht nur eine portable Laufzeit — sie erlebten einen Kulturwandel: Tests und Lieferung wurden standardisierbar, automatisierbar und wiederholbar.

Wie JUnit Unit-Tests normalisierte

Vor JUnit waren Tests oft ad-hoc (oder manuell) und lebten außerhalb des normalen Entwicklungsflusses. JUnit änderte das, indem Tests wie First-Class-Code wirkten: kleine Testklassen schreiben, im IDE ausführen und unmittelbares Feedback bekommen.

Dieser enge Loop war wichtig für Unternehmenssysteme, bei denen Regressionen teuer sind. Mit der Zeit wurde „keine Tests“ eher als Risiko denn als Ausnahme angesehen.

CI-Vorteile: ein Build, viele Umgebungen

Ein großer Vorteil der Java-Lieferkette ist, dass Builds typischerweise durch dieselben Befehle gesteuert werden — Developer-Laptops, Build-Agents, Linux-Server oder Windows-Runners — weil JVM und Build-Tools konsistent funktionieren.

In der Praxis verringerte diese Konsistenz das klassische „funktioniert nur auf meinem Rechner“-Problem. Wenn Ihr CI-Server mvn test oder gradle test ausführen kann, erhalten Sie meist dieselben Ergebnisse, die das ganze Team sieht.

Code-Qualitäts-Tools, die in die Pipeline passen

Das Java-Ökosystem machte „Quality Gates“ einfach zu automatisieren:

- Formatierung: Spotless oder eine gemeinsame IDE-Formatter-Config, um Diffs sauber zu halten

- Linting/stat. Analyse: Checkstyle, PMD, SpotBugs für häufige Fehler

- Security-Scans: OWASP Dependency-Check (oder ein gehostetes Tool wie Snyk) zur Erkennung verwundbarer Bibliotheken

Diese Tools funktionieren am besten, wenn sie vorhersehbar sind: gleiche Regeln für jedes Repo, in CI erzwungen, mit klaren Fehlermeldungen.

Eine einfache CI-Pipeline für einen Java-Service

Halten Sie es langweilig und wiederholbar:

- Checkout + Java-Version setzen (JDK pinnen)

- Build + Unit-Tests (

mvn test/gradle test) - Statische Checks (Format, Lint, Security-Scan)

- Artefakt packen (JAR) und ablegen

- Integrationstests (optional, aber wertvoll)

- Deploy in Staging, dann Produktion mit Genehmigungen

Diese Struktur skaliert von einem Service auf viele — und spiegelt das Thema: eine konsistente Laufzeit und konsistente Schritte machen Teams schneller.

Spring und der Wandel zur modernen Backend-Entwicklung

Java gewann früh Vertrauen in Unternehmen, aber echte Business-Anwendungen bedeuteten oft, sich mit schweren App-Servern, verbose XML und container-spezifischen Konventionen herumzuschlagen. Spring veränderte das Alltagsgefühl, indem es „normales“ Java ins Zentrum der Backend-Entwicklung rückte.

Inversion of Control: warum es zu Unternehmensanforderungen passte

Spring popularisierte Inversion of Control (IoC): Statt dass Ihr Code alles selbst erstellt und verdrahtet, setzt das Framework die Anwendung aus wiederverwendbaren Komponenten zusammen.

Mit Dependency Injection (DI) deklarieren Klassen, was sie brauchen, und Spring liefert es. Das verbessert die Testbarkeit und erleichtert es Teams, Implementierungen zu tauschen (z. B. echtes Zahlungs-Gateway vs. Stub in Tests), ohne Business-Logik umzuschreiben.

Vereinfachte Konfiguration und Integration

Spring reduzierte Reibung, indem es gängige Integrationen standardisierte: JDBC-Templates, später ORM-Unterstützung, deklarative Transaktionen, Scheduling und Security. Die Konfiguration verschob sich von langen, brüchigen XML-Dateien hin zu Annotationen und externalisierten Properties.

Dieser Wandel passte gut zu moderner Auslieferung: dasselbe Build kann lokal, in Staging oder in Produktion laufen, indem nur umgebungsspezifische Konfigurationen geändert werden statt Code.

WORA, Portabilität und moderne Service-Muster

Spring-basierte Services hielten das „run anywhere“-Versprechen praktisch: eine mit Spring gebaute REST-API kann unverändert auf dem Laptop, einer VM oder einem Container laufen — weil der Bytecode auf die JVM zielt und das Framework viele Plattformdetails abstrahiert.

Heutige gängige Muster — REST-Endpunkte, Dependency Injection und Konfiguration über Properties/Env-Vars — sind im Wesentlichen Springs Standard-Mentalmodell für Backend-Entwicklung. Mehr zu Deployment-Realitäten siehe /blog/java-in-the-cloud-containers-kubernetes-and-reality.

Java in der Cloud: Container, Kubernetes und die Realität

Java brauchte keinen „Cloud- Rewrite“, um in Containern zu laufen. Ein typischer Java-Service wird weiterhin als JAR (oder WAR) verpackt, mit java -jar gestartet und in ein Container-Image gelegt. Kubernetes plant diesen Container wie jeden anderen Prozess: starten, überwachen, neu starten und skalieren.

Was sich in Containern ändert (auch wenn Ihr Code gleich bleibt)

Die große Veränderung ist die Umgebung um die JVM herum. Container führen strengere Ressourcenbegrenzungen und schnellere Lebenszyklusereignisse ein als traditionelle Server.

Speicherlimits sind das erste praktische Problem. In Kubernetes setzen Sie ein Memory-Limit, und die JVM muss damit umgehen — sonst wird der Pod gekillt. Moderne JVMs sind container-aware, aber Teams tunen oft Heap-Größen, um Platz für Metaspace, Threads und nativen Speicher zu lassen. Ein Service, der „auf VM funktioniert“, kann in einem Container abstürzen, wenn der Heap zu großzügig bemessen ist.

Auch Startzeit wird wichtiger. Orchestratoren skalieren hoch und runter, und langsame Cold-Starts beeinträchtigen Autoscaling, Rollouts und Incident-Recovery. Image-Größe wird zur operativen Belastung: größere Images ziehen langsamer, verlängern Deploy-Zeiten und belasten Registry/Netzwerk.

Java besser passend machen: kleiner, schneller, vorhersagbarer

Mehrere Ansätze helfen, Java in Cloud-Deployments natürlicher zu machen:

- Leichtere Laufzeiten: schlanke Base-Images und Runtime-Reduktion mit Tools wie

jlink(wenn praktikabel) reduzieren Image-Größe. - Schnellere Starts: Class Data Sharing (CDS) und saubere Abhängigkeitsorganisation reduzieren Cold-Start-Overhead.

- Alternative Packagings: Ahead-of-Time-Kompilierung (für geeignete Services) kann Start- und Memory-Profile deutlich verbessern, auf Kosten anderer Build/Debug-Trade-offs.

Für eine praktische Anleitung zum JVM-Tuning und zur Abwägung von Performance-Trade-offs siehe /blog/java-performance-basics.

Abwärtskompatibilität und langlebige Systeme

Entwerfen, bevor du baust

Nutze Planning Mode, um Endpunkte, Daten und Aufgaben zu skizzieren, bevor du Code generierst.

Ein Grund, warum Java Vertrauen in Unternehmen gewann, ist einfach: Code überlebt oft Teams, Vendoren und sogar Geschäftsstrategien. Die Kultur stabiler APIs und Abwärtskompatibilität machte es möglich, dass eine Anwendung, die vor Jahren geschrieben wurde, nach OS-Upgrades, Hardware-Refreshes und neuen Java-Releases oft weiterlief — ohne Komplett-Neuentwicklung.

Warum stabile APIs für Unternehmen wichtig sind

Unternehmen optimieren für Vorhersehbarkeit. Wenn Kern-APIs kompatibel bleiben, sinken die Kosten für Änderungen: Trainingsmaterialien bleiben relevant, Betriebsrunbooks müssen nicht ständig neu geschrieben werden und kritische Systeme können schrittweise verbessert werden statt in großen Migrationen.

Diese Stabilität beeinflusste auch Architekturentscheidungen. Teams bauten gerne große Shared-Plattformen und interne Bibliotheken, weil sie erwarteten, dass diese lange funktionieren.

Bibliotheken, Wartung und die „für immer“-Erwartung

Das Java-Ökosystem (von Logging bis Datenbankzugriff und Web-Frameworks) verstärkte die Idee, dass Abhängigkeiten langfristige Verpflichtungen sind. Die Kehrseite ist Wartung: langlebige Systeme häufen alte Versionen, transitive Abhängigkeiten und „temporäre“ Workarounds an, die dauerhaft werden.

Security-Updates und Abhängigkeits-Hygiene sind kontinuierliche Arbeit, kein einmaliges Projekt. Regelmäßiges Patchen der JDK, Aktualisieren von Bibliotheken und CVE-Tracking senken Risiken, ohne Produktion zu destabilisieren — besonders bei inkrementellen Upgrades.

Ältere Java-Apps sicher upgraden

Ein praktischer Ansatz behandelt Upgrades als Produktarbeit:

- Beginnen Sie mit dem Hinzufügen oder Verbessern automatisierter Tests für kritische Workflows.

- Führen Sie Upgrades in kleinen Schritten durch (z. B. eine LTS-Linie nach der anderen) und messen Sie Performance sowie Speicher, nicht nur Kompilierbarkeit.

- Lassen Sie alte und neue Versionen side-by-side in Staging laufen und halten Sie Rollback-Pläne bereit.

- Erstellen Sie früh ein Inventar der Abhängigkeiten; viele „Java-Upgrades“ scheitern, weil eine Schlüsselbibliothek aufgegeben wurde.

Abwärtskompatibilität ist keine Garantie für Schmerzfreiheit — aber sie schafft eine Grundlage für vorsichtige, risikoarme Modernisierung.

Zentrale Lektionen für Backend-Teams heute

Was WORA wirklich geliefert hat (und was nicht)

WORA funktionierte am besten auf der Ebene, die Java versprach: derselbe compilierte Bytecode konnte auf jeder Plattform mit einer kompatiblen JVM laufen. Das machte plattformübergreifende Server-Deployments und vendor-neutrales Packaging deutlich einfacher als in vielen nativen Ökosystemen.

Worüber es nicht hinweg half, war alles rund um die JVM-Grenze. Unterschiede in Betriebssystemen, Dateisystemen, Netzwerk-Defaults, CPU-Architekturen, JVM-Flags und nativen Drittanbieter-Abhängigkeiten blieben relevant. Performance-Portabilität war nie automatisch — man konnte überall laufen, musste aber beobachten und tunen, wie es lief.

Praktische Erkenntnisse für Teams, die heute Java wählen

Javas größter Vorteil ist nicht ein einzelnes Feature, sondern die Kombination aus stabilen Laufzeiten, ausgereiftem Tooling und einem großen Talentpool.

Einige teamorientierte Lektionen:

- Behandeln Sie die JVM als Plattform: wählen Sie eine unterstützte JDK-Distribution, standardisieren Sie Versionen und führen Sie Upgrades geplant durch.

- Bevorzugen Sie langweilige Defaults: halten Sie Builds, Logging, Metriken und Abhängigkeitsverwaltung konsistent über Services.

- Entwerfen Sie für Betrieb: investieren Sie früh in Monitoring, sichere Konfiguration und vorhersagbares Memory/GC-Verhalten.

- Nutzen Sie das Ökosystem: Frameworks und Bibliotheken sparen Zeit, aber prüfen Sie Abhängigkeitswachstum und Security-Updates.

Entscheidungsfaktoren: wann Java die richtige Wahl ist

Wählen Sie Java, wenn Ihr Team Wert auf langfristige Wartbarkeit, starke Bibliotheksunterstützung und vorhersehbaren Betrieb legt.

Prüfen Sie folgende Aspekte:

- Teamfähigkeiten: Verfügen Sie bereits über Java/Spring-Erfahrung oder müssen Sie neu trainieren?

- Laufzeitbeschränkungen: Sind Startzeit und Memory-Footprint kritisch (für manche Workloads sind Go/Node besser geeignet), oder stehen Durchsatz und Stabilität im Vordergrund?

- Ökosystembedarf: Brauchen Sie ausgereifte Messaging-, Datenbanktreiber-, Observability- oder Enterprise-Integrationen?

- Lebensdauer: Wird das System über Jahre mit wenigen Neuentwicklungen leben?

Nächste Schritte

Wenn Sie Java für ein neues Backend oder eine Modernisierungsinitiative evaluieren, starten Sie mit einem kleinen Pilot-Service, definieren Sie eine Upgrade-/Patch-Policy und einigen Sie sich auf ein Framework-Baseline. Wenn Sie Hilfe bei der Scope-Definition dieser Entscheidungen möchten, melden Sie sich über /contact.

Wenn Sie außerdem mit schnellen Wegen experimentieren, „Sidecar“-Services oder interne Tools um eine bestehende Java-Landschaft aufzubauen, können Plattformen wie Koder.ai dabei helfen, von der Idee zu einer funktionierenden Web-/Server-/Mobile-App per Chat zu kommen — nützlich für Prototyping von Begleitdiensten, Dashboards oder Migrations-Utilities. Koder.ai unterstützt Code-Export, Deployment/Hosting, Custom-Domains sowie Snapshots/Rollbacks, was gut zur operativen Denkweise passt, die Java-Teams schätzen: reproduzierbare Builds, vorhersehbare Umgebungen und sicheres Iterieren.