Was JavaScript-Runtimes sind und warum sie wichtig sind

JavaScript ist die Sprache. Eine JavaScript-Runtime ist die Umgebung, die die Sprache außerhalb eines Browsers nützlich macht: sie bettet eine JavaScript-Engine (wie V8) ein und umgibt sie mit den Systemfunktionen, die reale Apps brauchen—Dateizugriff, Netzwerk, Timer, Prozessverwaltung und APIs für Kryptographie, Streams und mehr.

Wenn die Engine das „Gehirn“ ist, das JavaScript versteht, ist die Runtime der ganze „Körper“, der mit dem Betriebssystem und dem Internet sprechen kann.

Wo Runtimes auftauchen

Moderne Runtimes dienen nicht nur Webservern. Sie treiben an:

- Server und APIs (traditionelle Backend-Apps)

- CLI-Tools (Formatter, Build-Tools, Automatisierungsskripte)

- Edge-Funktionen (Code, der nah an Nutzer:innen läuft, oft mit strengeren Limits)

- Desktop-Apps (häufig über Frameworks, die eine Runtime bündeln)

Die gleiche Sprache kann an all diesen Orten laufen, aber jede Umgebung hat andere Beschränkungen—Startzeit, Speicherlimits, Sicherheitsgrenzen und verfügbare APIs.

Warum mehrere Runtimes existieren (und sich weiterentwickeln)

Runtimes entwickeln sich, weil Entwickler:innen unterschiedliche Kompromisse wünschen. Manche priorisieren maximale Kompatibilität mit dem bestehenden Node.js-Ökosystem. Andere zielen auf strengere Sicherheits-Defaults, bessere TypeScript-Ergonomie oder schnellere Cold Starts für Tools.

Selbst wenn zwei Runtimes dieselbe Engine teilen, können sie sich in vielen Punkten stark unterscheiden:

- Eingebaute APIs und Standard-Unterstützung

- Ansatz für Paketmanagement

- Berechtigungs- und Sandboxing-Modell

- Tooling-Erlebnis (Tests, Formatierung, Bundling)

Was „Wettbewerb" wirklich bedeutet

Wettbewerb geht über reine Geschwindigkeit hinaus. Runtimes konkurrieren um Adoption (Community und Mindshare), Kompatibilität (wie viel vorhandener Code „einfach funktioniert“) und Vertrauen (Sicherheitslage, Stabilität, langfristige Wartung). Diese Faktoren entscheiden, ob eine Runtime zur Default-Wahl wird oder ein Nischenwerkzeug bleibt.

Ein kurzer Überblick über populäre Runtimes

Wenn Leute „JavaScript-Runtime" sagen, meinen sie meist „die Umgebung, die JS außerhalb (oder innerhalb) eines Browsers ausführt, plus die APIs, mit denen man tatsächlich Dinge baut." Die gewählte Runtime bestimmt, wie Sie Dateien lesen, Server starten, Pakete installieren, Berechtigungen handhaben und Produktionsfehler debuggen.

Übliche Beispiele, die Sie hören werden

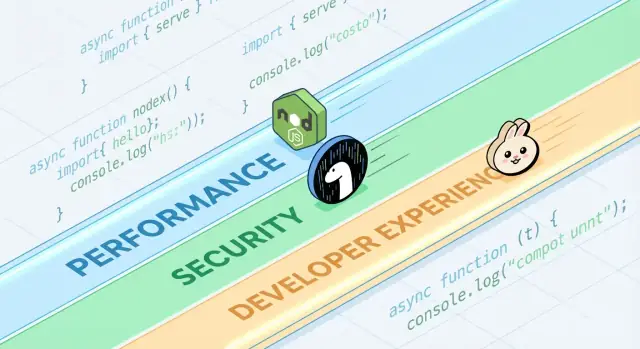

Node.js ist der langjährige Default für serverseitiges JavaScript. Es hat das breiteste Ökosystem, ausgereifte Tools und große Community-Momentum.

Deno wurde mit modernen Defaults entworfen: TypeScript als Erstklassiger Input, eine stärkere Sicherheits-Standardkonfiguration und ein eher „batteries included“-Ansatz in der Standardbibliothek.

Bun legt großen Wert auf Geschwindigkeit und Entwicklerkomfort, indem es eine schnelle Runtime mit einer integrierten Toolchain (z. B. Paketinstallation und Testing) bündelt, um Einrichtungsaufwand zu reduzieren.

Browser-Runtimes (Chrome, Firefox, Safari) bleiben insgesamt die häufigsten JS-Runtimes. Sie sind auf UI-Arbeit optimiert und liefern Web-APIs wie DOM, fetch und Storage—bieten aber keinen direkten Dateisystemzugriff wie Server-Runtimes.

Was Runtimes gemeinsam haben

Die meisten Runtimes koppeln eine JavaScript-Engine (oft V8) mit einer Event-Loop und einer Reihe von APIs für Netzwerk, Timer, Streams und mehr. Die Engine führt Code aus; die Event-Loop koordiniert asynchrone Arbeit; die APIs sind das, was Sie im Alltag aufrufen.

Was sich unterscheidet (und warum das den Alltag prägt)

Unterschiede zeigen sich in eingebauten Features (z. B. integrierte TypeScript-Verarbeitung), Standard-Tooling (Formatter, Linter, Test-Runner), Kompatibilität mit Node-APIs und Sicherheitsmodellen (z. B. ob Datei-/Netzwerkzugriff uneingeschränkt oder permission-gated ist). Deshalb ist die „Runtime-Auswahl“ kein abstraktes Thema—sie wirkt sich darauf aus, wie schnell Sie ein Projekt starten, wie sicher Sie Skripte ausführen und wie mühsam Bereitstellung und Debugging sind.

„Schnell" ist keine einzelne Zahl. JavaScript-Runtimes können in einem Diagramm fantastisch aussehen und in einem anderen durchschnittlich, weil sie unterschiedliche Definitionen von Geschwindigkeit optimieren.

Latenz vs. Durchsatz

Latenz ist, wie schnell eine einzelne Anfrage fertig ist; Durchsatz ist, wie viele Anfragen Sie pro Sekunde abarbeiten können. Eine Runtime, die für niedrige Startlatenz und schnelle Antworten optimiert ist, kann unter hoher Parallelität beim Spitzen-Durchsatz Kompromisse eingehen—und umgekehrt.

Beispiel: Eine API für Benutzerprofil-Lookups achtet auf Tail-Latenz (p95/p99). Ein Batch-Job, der tausende Events pro Sekunde verarbeitet, interessiert sich mehr für Durchsatz und steady-state Effizienz.

Cold Start-Zeit (Serverless und CLIs)

Cold Start ist die Zeit von „nichts läuft“ bis „bereit zu arbeiten“. Sie ist besonders wichtig für Serverless-Funktionen, die auf null skalieren, und für CLI-Tools, die Nutzer:innen häufig starten.

Cold Starts werden von Modul-Laden, TypeScript-Transpilation (falls vorhanden), Initialisierung eingebauter APIs und davon beeinflusst, wie viel Arbeit die Runtime vor Ihrer Codeausführung macht. Eine Runtime kann im Warm-Zustand sehr schnell sein, sich aber träge anfühlen, wenn der Boot Vorgang länger dauert.

Die meiste serverseitige JavaScript-Arbeit ist I/O-bound: HTTP-Anfragen, DB-Calls, Datei-Lesen, Streaming. Hier geht Performance oft um die Effizienz der Event-Loop, die Qualität der Async-I/O-Bindings, Stream-Implementierungen und wie gut Backpressure behandelt wird.

Kleine Unterschiede—wie schnell die Runtime Header parst, Timer plant oder Writes flushed—können in Webservern und Proxies spürbare Vorteile bringen.

CPU-lastige Arbeit: Stärken und Grenzen der Engines

CPU-intensive Aufgaben (Parsing, Kompression, Bildverarbeitung, Crypto, Analytics) belasten die JS-Engine und den JIT-Compiler. Engines können heiße Codepfade optimieren, aber JavaScript hat weiterhin Grenzen für anhaltende numerische Workloads.

Wenn CPU-lastige Arbeit dominiert, ist die „schnellste Runtime“ oft die, die das einfachste Vorgehen bietet, heiße Schleifen in nativen Code zu verlagern oder Worker-Threads ohne großen Aufwand zu nutzen.

Benchmarking Reality Check (und typische Fallen)

Benchmarks sind nützlich, aber leicht fehlzuinterpretieren—vor allem, wenn sie als universelle Rangliste behandelt werden. Eine Runtime, die ein Diagramm „gewinnt“, kann für Ihre API, Ihre Build-Pipeline oder Ihren Datenverarbeitungsjob immer noch langsamer sein.

Microbenchmarks vs. reale Anwendungen

Microbenchmarks testen oft eine winzige Operation (JSON-Parsing, Regex, Hashing) in enger Schleife. Das hilft, eine einzelne Zutat zu messen, nicht den ganzen Teller.

Reale Apps verbringen Zeit mit Dingen, die Microbenchmarks ignorieren: Netzwerkwartezeiten, Datenbankaufrufe, Dateisystem-I/O, Framework-Overhead, Logging und Memory Pressure. Wenn Ihre Workload hauptsächlich I/O-bound ist, kann eine 20 % schnellere CPU-Schleife Ihre End-to-End-Latenz überhaupt nicht beeinflussen.

Ergebnisse ändern sich mit Workload, OS und Versionen

Kleine Unterschiede in der Umgebung können Ergebnisse umdrehen:

- Workload-Form: viele kleine Anfragen vs. wenige große; Streaming vs. Buffering

- OS und Hardware: Linux vs. macOS; unterschiedliche CPUs; Container-Limits

- Runtime- und Dependency-Versionen: Engine-Updates, libc-Unterschiede und Bibliotheksänderungen können dominieren

Wenn Sie einen Benchmark sehen, fragen Sie nach Versionen und Flags—und ob diese Ihrer Produktionsumgebung entsprechen.

Warm-up (JIT) und Caching-Effekte

JS-Engines nutzen JIT-Kompilierung: Code läuft zunächst langsamer und beschleunigt, sobald die Engine heiße Pfade identifiziert. Messen Sie nur die ersten Sekunden, kann das die falschen Gewinner belohnen.

Caching spielt ebenfalls eine Rolle: Disk-Cache, DNS-Cache, HTTP keep-alive und Anwendungs-Caches lassen spätere Läufe dramatisch besser aussehen. Das kann realistisch sein, muss aber kontrolliert werden.

Faire, wiederholbare Tests entwerfen

Zielen Sie auf Benchmarks, die Ihre Fragen beantworten:

- End-to-end messen: Framework + typische Middleware + reale Payload-Größen einbeziehen.

- Cold vs. Warm trennen: Start, erste Anfrage und steady-state aufzeichnen.

- Mehrere Durchläufe: Median und Varianz berichten, nicht nur den besten Lauf.

- Umgebung fixieren: Versionen pinnen, CPU isolieren und Befehle dokumentieren.

Wenn Sie eine praktische Vorlage brauchen, legen Sie Ihren Test-Harness in ein Repo und verlinken ihn in internen Docs (oder auf /blog/runtime-benchmarking-notes), damit Ergebnisse reproduzierbar sind.

Unter der Haube: Engines, APIs und Ausführungsmodelle

Mach die Checkliste umsetzbar

Verwandle deine Laufzeit-Checkliste in ein konkretes Pilotprojekt, das du ausführen kannst.

Wenn Leute Node.js, Deno und Bun vergleichen, sprechen sie oft über Features und Benchmarks. Unter der Oberfläche prägen vier große Teile das „Gefühl" einer Runtime: die JavaScript-Engine, die eingebauten APIs, das Ausführungsmodell (Event-Loop + Scheduler) und wie nativer Code eingebunden ist.

Engines: V8, JavaScriptCore und warum sie wichtig sind

Die Engine ist der Teil, der JavaScript parst und ausführt. V8 (in Node.js und Deno) und JavaScriptCore (bei Bun) führen fortgeschrittene Optimierungen wie JIT und Garbage Collection durch.

Praktisch kann die Wahl der Engine beeinflussen:

- Startzeit und Speicherverhalten

- Performance von heißem Code nach Optimierungen

- Welche Low-Level-Features zuerst verfügbar sind (einige Engines liefern neue JS-Fähigkeiten früher)

Eingebaute APIs: mehr als „Kann ich fetchen?"

Moderne Runtimes konkurrieren damit, wie vollständig sich ihre Standardbibliothek anfühlt. Eingebautes fetch, Web Streams, URL-Utilities, Datei-APIs und Crypto können Abhängigkeits-Explosion reduzieren und Code portabler zwischen Server und Browser machen.

Der Haken: Derselbe API-Name bedeutet nicht immer identisches Verhalten. Unterschiede beim Streaming, Timeouts oder File-Watching können reale Apps stärker beeinflussen als rohe Geschwindigkeit.

Ausführungsmodelle: Event-Loops, Scheduler und native Bindings

JavaScript ist obenrum single-threaded, aber Runtimes koordinieren Hintergrundarbeit (Netzwerk, Datei-I/O, Timer) über eine Event-Loop und interne Scheduler. Manche Runtimes setzen stark auf native Bindings (kompilierten Code) für I/O und performance-kritische Aufgaben, andere betonen Web-Standard-Interfaces.

WebAssembly: wann es hilft

WebAssembly (Wasm) ist nützlich, wenn Sie vorhersehbare, schnelle Berechnungen (Parsing, Bildverarbeitung, Kompression) brauchen oder Code aus Rust/C/C++ wiederverwenden wollen. Es beschleunigt nicht automatisch typische I/O-lastige Webserver, kann aber für CPU-intensive Module sehr stark sein.

Sicherheit: Defaults, Berechtigungen und Lieferketten-Realität

„Secure by default" in einer JavaScript-Runtime bedeutet meist, dass die Runtime untrusted Code als Standard annimmt, bis Sie explizit Zugriff gewähren. Das kehrt das traditionelle Servermodell um (wo Skripte oft Dateien lesen, das Netzwerk anrufen und Env-Variablen standardmäßig einsehen können) und sorgt für vorsichtigere Defaults.

Gleichzeitig beginnen viele echte Vorfälle bevor Ihr Code läuft—im Inneren Ihrer Abhängigkeiten oder während des Installationsprozesses—deshalb ist Runtime-Sicherheit nur eine Schicht in einer Gesamtstrategie.

Berechtigungs-Prompts und Allowlists

Manche Runtimes können sensible Fähigkeiten hinter Berechtigungen verbergen. Praktische Varianten sind Allowlists:

- Dateisystem: Lesen/Schreiben nur für bestimmte Pfade erlauben (z. B. ein Config-Verzeichnis)

- Netzwerk: Ausgehende Anfragen nur zu genehmigten Hosts/Ports erlauben

- Umgebungsvariablen: Nur bestimmte Keys statt der gesamten process.env zugänglich machen

Das reduziert versehentliche Datenlecks und begrenzt die Blast-Radius bei Ausführen von Dritt-Skripten—besonders in CLIs, Build-Tools und Automatisierung.

Sandboxing hat Grenzen

Berechtigungen sind kein magischer Schutz. Wenn Sie Netzwerkzugang zu „api.mycompany.com" erlauben, kann eine kompromittierte Abhängigkeit trotzdem Daten an denselben Host exfiltrieren. Und wenn Sie das Lesen eines Verzeichnisses erlauben, vertrauen Sie allem darin. Das Modell hilft, Absicht auszudrücken, ersetzt aber nicht das Vetting von Abhängigkeiten, Lockfiles und sorgfältige Review dessen, was Sie erlauben.

Sichere Defaults in gängigen APIs

Sicherheit lebt auch in kleinen Defaults:

- TLS/HTTPS: sinnvolle Zertifikatsvalidierung und moderne Protokolleinstellungen von Haus aus

- HTTP: sicheres Redirect-Verhalten und klare Kontrolle über Header/Cookies

- Crypto-APIs: moderne Primitive mit schwer misszuverwendenden Interfaces

Der Kompromiss ist Reibung: striktere Defaults können Legacy-Skripte brechen oder Flags nötig machen, die Sie pflegen müssen. Die beste Wahl hängt davon ab, ob Sie Bequemlichkeit für vertrauenswürdige Services oder Leitplanken für Code mit gemischtem Vertrauen bevorzugen.

Lieferketten-Risiken, die Sie nicht ignorieren können

Lieferketten-Angriffe nutzen oft, wie Pakete entdeckt und installiert werden:

- Typosquatting: bösartiges Paket mit einem Zeichen Unterschied zum populären Paket

- Dependency confusion: ein öffentliches Paket wird unter dem Namen eines internen Pakets veröffentlicht

- Kompromittierte Maintainer: Account-Übernahme liefert legitim aussehende Updates mit injiziertem Code

Diese Risiken betreffen jede Runtime, die aus einem öffentlichen Registry lädt—gute Hygiene ist deshalb genauso wichtig wie Runtime-Features.

Lockfiles, Integritätsprüfungen und Provenance

Lockfiles pinnen exakte Versionen (inkl. transitive Abhängigkeiten) und machen Installs reproduzierbar. Integritätsprüfungen (Hashes im Lockfile oder Metadaten) helfen, Manipulation beim Download zu erkennen.

Provenance ist der nächste Schritt: beantworten zu können „wer hat dieses Artefakt gebaut, aus welchem Source, mit welchem Workflow?" Selbst wenn Sie keine vollständige Provenance-Pipeline einführen, können Sie approximative Maßnahmen ergreifen:

- Bevorzugen gepflegte Pakete mit transparenten Release-Praktiken

- Vermeiden ungepinnten Git-Abhängigkeiten in Produktions-Builds

- Tags/Releases statt zufälliger Commits verlangen

Audit- und Update-Workflows, die funktionieren

Behandeln Sie Dependency-Arbeit wie Routine-Wartung:

- automatisierte Audits in CI für jeden PR laufen lassen,

- regelmäßige Update-Fenster planen (wöchentlich/2-wöchentlich), um „Big Bang“-Upgrades zu vermeiden,

- Changelogs bei großen Sprüngen und sicherheitsrelevanten Releases prüfen.

Team-Policies, die das Tempo nicht bremsen

Leichte Regeln bringen viel:

- neue Abhängigkeiten nur blockieren, wenn ein klarer Bedarf und ein Owner vorhanden sind,

- Install-Skripte einschränken, wo möglich (häufiger Angriffsvektor),

- private Registries oder scoped Packages für interne Namen nutzen, um Verwirrung zu reduzieren.

Gute Hygiene ist weniger Perfektion als konsistente, langweilige Gewohnheiten.

Kompatibilität und Ökosystem als Wettbewerbsvorteile

Performance und Sicherheit bekommen Schlagzeilen, aber Kompatibilität und Ökosystem entscheiden oft, was wirklich shipped. Eine Runtime, die Ihren vorhandenen Code ausführt, Ihre Abhängigkeiten unterstützt und sich konsistent verhält, reduziert Risiko mehr als jedes einzelne Feature.

Kompatibilität beeinflusst Sicherheit und Wartbarkeit

Kompatibilität ist nicht nur Bequemlichkeit. Weniger Rewrites bedeutet weniger Chancen, subtile Bugs einzuführen, und weniger Einmal-Patches, die Sie vergessen zu aktualisieren. Reife Ökosysteme haben zudem bekannte Failure-Modes: gängige Bibliotheken sind öfter auditiert, Probleme sind dokumentiert und Workarounds leichter zu finden.

Andererseits kann „Kompatibilität um jeden Preis" veraltete Muster am Leben erhalten (z. B. zu weitreichende Datei-/Netzwerkzugriffe), also brauchen Teams trotzdem klare Grenzen und gute Dependency-Hygiene.

Node-Kompatibilitätslayer vs. Web-Standard-APIs

Runtimes, die drop-in kompatibel mit Node.js sein wollen, können die meisten serverseitigen JS direkt ausführen—ein großer praktischer Vorteil. Kompatibilitätslayer können Unterschiede überbrücken, aber sie können auch runtime-spezifisches Verhalten verbergen—besonders bei Dateisystem, Netzwerk und Modulauflösung—was das Debuggen erschwert, wenn in Produktion etwas anders läuft.

Web-Standard-APIs (wie fetch, URL, Web Streams) treiben Code in Richtung Portabilität zwischen Runtimes und Edge-Umgebungen. Der Kompromiss: einige Node-spezifische Pakete setzen Node-Interna voraus und funktionieren ohne Shims nicht.

Das NPM-Ökosystem: Stärken und Kompromisse

Die größte Stärke von npm ist simpel: es hat nahezu alles. Diese Breite beschleunigt die Lieferung, erhöht aber auch die Exposition gegenüber Lieferketten-Risiken und Dependency-Bloat. Selbst bei populären Paketen können transitive Abhängigkeiten überraschen.

Wann „funktioniert überall" neue Features schlägt

Wenn Ihre Priorität vorhersehbare Deployments, einfaches Hiring und weniger Integrationsüberraschungen sind, gewinnt oft „funktioniert überall“. Neue Runtime-Fähigkeiten sind spannend—aber Portabilität und ein bewährtes Ökosystem sparen im Lebenszyklus eines Projekts oft Wochen.

Experimentiere mit einfachem Rollback

Iteriere sicher an einem Prototyp mit Snapshots und Rollback, wenn Experimente schiefgehen.

Developer Experience ist der Bereich, in dem Runtimes still gewinnen oder verlieren. Zwei Runtimes können denselben Code ausführen und sich beim Setup eines Projekts, bei der Fehlersuche oder beim schnellen Ausliefern eines kleinen Services völlig unterschiedlich anfühlen.

TypeScript-Unterstützung: eingebaut vs. „Bring your own"

TypeScript ist ein guter DX-Litmus-Test. Manche Runtimes behandeln es als Erstklassigen Input (Sie können .ts-Dateien mit minimaler Zeremonie ausführen), andere erwarten eine traditionelle Toolchain (tsc, ein Bundler oder Loader), die Sie konfigurieren.

Keiner der Ansätze ist universell „besser":

- Eingebaute Unterstützung reduziert Setup und kann Defaults im Team standardisieren.

- Konfiguriertes Tooling gibt feinkörnigere Kontrolle über tsconfig, Emit-Targets und Build-Ausgabe—nützlich für Libraries und große Monorepos.

Die Schlüsselfrage ist, ob die TypeScript-Story Ihrer Runtime zu Ihrer tatsächlichen Auslieferungsweise passt: direkte Ausführung im Dev, kompilierte Builds in CI oder beides.

Bundling, Transpiling und Test-Defaults

Moderne Runtimes liefern zunehmend opinionated Tooling: Bundler, Transpiler, Linter und Test-Runner, die out-of-the-box funktionieren. Das kann die „choose-your-own-stack“-Tax für kleinere Projekte eliminieren.

Defaults sind aber nur dann DX-positiv, wenn sie vorhersehbar sind:

- Lassen sich Output-Formate (ESM/CJS), Targets und externe Abhängigkeiten leicht ändern?

- Integriert der Test-Runner gut mit Coverage und CI?

- Ist die Konfiguration minimal und stabil über Versionen hinweg?

Wenn Sie häufig neue Services starten, kann eine Runtime mit soliden Built-ins und guter Doku Stunden pro Projekt sparen.

Debugging: Stacktraces, Sourcemaps und Inspector

Beim Debugging wird Runtime-Polish sichtbar. Hochwertige Stacktraces, korrektes Sourcemap-Handling und ein Inspector, der „einfach funktioniert“, bestimmen, wie schnell Sie Fehler verstehen.

Achten Sie auf:

- Klare Fehler, die auf Ihren Source (nicht auf generierten Code) verweisen

- Zuverlässige asynchrone Stacktraces

- Gute Integration mit Editoren und Chrome-DevTools-ähnlichen Inspectors

Templates und Scaffolding, die Reibung entfernen

Projekt-Generatoren sind unterschätzt: ein sauberes Template für API, CLI oder Worker setzt oft den Ton für ein Repo. Bevorzugen Sie Scaffolds, die eine minimale, production-geformte Struktur (Logging, Env-Handling, Tests) erstellen, ohne Sie in ein schweres Framework zu fixieren.

Wenn Sie Inspiration brauchen, siehe verwandte Guides in /blog.

Als praktischen Workflow nutzen Teams manchmal Koder.ai, um einen kleinen Service oder CLI in verschiedenen „Runtime-Stilen“ (Node-first vs Web-Standard-APIs) zu prototypisieren und den generierten Quellcode für einen echten Benchmark-Lauf zu exportieren. Es ersetzt nicht Produkttests, kann aber die Zeit von Idee → lauffähigem Vergleich deutlich verkürzen.

Paketverwaltung entscheidet über DX

Paketmanagement ist der Moment, in dem „Developer Experience" greifbar wird: Install-Geschwindigkeit, Lockfile-Verhalten, Workspace-Support und wie zuverlässig CI Builds reproduziert. Runtimes behandeln das Thema zunehmend als erstklassiges Feature.

Node.js hat historisch externe Tools (npm, Yarn, pnpm) verwendet—eine Stärke (Wahl) und eine Quelle von Inkonsistenzen. Neuere Runtimes haben Meinungen: Deno integriert Dependency-Management via deno.json (und unterstützt npm-Pakete), während Bun einen schnellen Installer und Lockfile mitbringt.

Diese runtime-nativen Tools optimieren oft für weniger Netzwerk-Roundtrips, aggressives Caching und engere Integration mit dem Modul-Loader—hilfreich für Cold-Starts in CI und Onboarding neuer Teammitglieder.

Monorepos, Workspaces und Caching-Basics

Die meisten Teams brauchen irgendwann Workspaces: geteilte interne Pakete, konsistente Dependency-Versionen und vorhersehbare Hoisting-Regeln. npm, Yarn und pnpm unterstützen Workspaces, verhalten sich aber unterschiedlich hinsichtlich Disk-Nutzung, node_modules-Layout und Deduplikation. Das beeinflusst Install-Zeiten, Editor-Resolution und „läuft auf meinem Rechner“-Bugs.

Caching ist genauso wichtig. Ein guter Startpunkt ist das Cachen des Paketmanagers-Stores (oder Download-Cache) plus lockfile-basierte Install-Schritte, dann deterministische Scripts. Dokumentieren Sie das neben Ihren Build-Schritten in /docs.

Publishing und Konsumption: was Teams wissen müssen

Internes Package-Publishing (oder Konsum privater Registries) zwingt Sie dazu, Auth, Registry-URLs und Versionierungsregeln zu standardisieren. Stellen Sie sicher, dass Ihre Runtime/Tools .npmrc-Konventionen, Integritätsprüfungen und Provenance-Erwartungen unterstützen.

Migrations-Bedenken: Lockfile-Änderungen und CI-Anpassungen

Ein Paketmanager-Wechsel oder die Einführung eines runtime-bündelten Installers ändert typischerweise Lockfiles und Install-Befehle. Planen Sie PR-Änderungen, aktualisieren Sie CI-Images und einigen Sie sich auf ein „Source of Truth“-Lockfile—ansonsten debuggen Sie Dependency-Drift statt an Features zu arbeiten.

Eine Runtime nach Anwendungsfall wählen (nicht nach Hype)

Starte eine benchmarkfähige API

Erstelle per Chat eine kleine API und nutze sie als realistisches End-to-End-Benchmarkziel.

Eine JavaScript-Runtime zu wählen heißt weniger, „den Gewinner“ zu finden, als den Entscheid zu treffen, der Reibung für Ihre Constraints reduziert. Eine gute Wahl verringert Risiko und verbessert Outcomes für Ihr Team und Produkt.

Serverless- und Edge-Workloads

Hier zählen Cold-Start und Concurrency-Verhalten genauso wie roher Durchsatz. Achten Sie auf:

- Startzeit

- Isolation-Modell (Prozesse vs Isolates/Worker-Stil)

- API-Verfügbarkeit (Web-APIs,

fetch, Streams, Crypto) in der Zielplattform

Node.js ist bei vielen Providern weit verbreitet; Denos Web-Standard-APIs und Berechtigungsmodell sind attraktiv, wenn sie unterstützt werden; Buns Geschwindigkeit kann helfen, prüfen Sie aber Plattform-Support und Edge-Kompatibilität vor einer Festlegung.

Bei Kommandozeilen-Utilities kann Distribution die Entscheidung dominieren. Priorisieren Sie:

- Single-Binary-Builds und vorhersehbare Installs

- Cross-Plattform-Verhalten (macOS, Windows, Linux)

- Schneller Start und gute Entwickler-Ergonomie

Denos eingebaute Tools und einfache Distribution sind stark für CLIs. Node.js ist solide, wenn Sie die Breite von npm brauchen. Bun kann sich für schnelle Skripte eignen—prüfen Sie Packaging und Windows-Support für Ihre Zielgruppe.

Container und langlebige Services

In Containern überwiegen Stabilität, Speicherverhalten und Observability oft Headline-Benchmarks. Evaluieren Sie steady-state Speichernutzung, GC-Verhalten unter Last und die Reife von Debugging/Profiling-Tools. Node.js gilt oft als „sichere Default" für langlebige Services wegen Ökosystem-Reife und operationaler Vertrautheit.

Team-Constraints schlagen Neuheit

Wählen Sie die Runtime, die zu den Fähigkeiten Ihres Teams, Bibliotheken und Operationen passt (CI, Monitoring, Incident-Response). Wenn eine Runtime Rewrites, neue Debugging-Workflows oder unklare Dependency-Praktiken erzwingt, kann ein Performance-Gewinn durch Liefer-Risiko wieder aufgehoben werden.

Wenn Ihr Ziel schnelle Feature-Auslieferung ist, überlegen Sie, wo JavaScript tatsächlich im Stack sitzt. Zum Beispiel fokussiert Koder.ai auf komplette Anwendungen per Chat—Frontend in React, Backends in Go mit PostgreSQL, Mobile in Flutter—so dass Runtime-Entscheidungen oft nur dort getroffen werden, wo Node/Deno/Bun wirklich relevant sind (Tooling, Edge-Skripte, bestehende JS-Services), während Teams weiterhin schnell mit einem production-geeigneten Baseline arbeiten.

Entscheidungs-Checkliste und nächste Schritte

Eine Runtime zu wählen heißt, Risiko zu reduzieren und Outcomes für Team und Produkt zu verbessern.

Kurze Checkliste

- Performance-Tests: Kennen Sie Ihre Top-3-Bottlenecks (Startzeit, Durchsatz, CPU-lastige Arbeit, I/O-Latenz)? Können Sie sie lokal und in CI reproduzieren?

- Sicherheitsbedarf: Brauchen Sie ein Berechtigungsmodell (Datei/Netz/Env), stärkere Sandboxes oder Compliance-Kontrollen?

- DX-Prioritäten: Welche Reibung kostet heute am meisten—TypeScript-Setup, Debugging, Hot Reload, Test-Tooling oder Packaging?

Fragen vor einem Runtime-Wechsel

- Welches Problem lösen wir: Kosten, Latenz, Entwickler-Geschwindigkeit oder Sicherheit?

- Welche Systemteile sind runtime-sensitiv (Edge-Funktionen, CLIs, APIs, Hintergrundjobs)?

- Sind wir an ein bestimmtes Paket-Ökosystem-Verhalten gebunden (native Addons, postinstall-Skripte, CJS/ESM-Erwartungen)?

- Was ist unser Rollback-Plan, falls eine Abhängigkeit oder Plattformintegration anders reagiert?

- Wer übernimmt Upgrades der Runtime und verfolgt Breaking Changes?

Ein praktischer Pilotplan

Starten Sie klein und messbar:

- Wählen Sie einen einzigen Service oder internes Tool mit klaren Ein-/Ausgängen (z. B. Webhook-Handler, CLI, kleiner Worker).

- Definieren Sie Erfolgsmessgrößen: p95-Latenz, Speicher, CPU, Build-Zeit, Cold Start und Entwickler-Zeit-bis-fix.

- Führen Sie den Pilot in zwei Umgebungen aus: Staging und (wenn möglich) eine Produktions-Canary.

- Vergleichen Sie Ergebnisse, dokumentieren Sie Überraschungen und iterieren (Konfigurationen tunen, Abhängigkeitswahl anpassen), bevor Sie eine breitere Migration erwägen.

Wenn Sie die Rückkopplungsschleife verkürzen wollen, können Sie den Pilot-Service und einen Benchmark-Harness schnell in Koder.ai entwerfen, Planning Mode nutzen, um das Experiment (Metriken, Endpunkte, Payloads) zu skizzieren, und dann den Quellcode exportieren, damit die finalen Messungen in Ihrer kontrollierten Umgebung laufen.

Wo Sie als Nächstes mehr lernen

Nutzen Sie primäre Quellen und laufende Signale:

- Offizielle Dokus und Kompatibilitäts-Notizen für Node.js, Deno und Bun

- Release Notes und Changelogs (achten Sie auf Sicherheitsfixes und Breaking Changes)

- Security-Advisories und CVE-Feeds für Ihre Abhängigkeiten

- Community-Issue-Tracker, um reale Edge-Cases zu erkennen

Wenn Sie eine tiefere Anleitung zum fairen Messen von Runtimes möchten, siehe /blog/benchmarking-javascript-runtimes.