18. Dez. 2025·8 Min

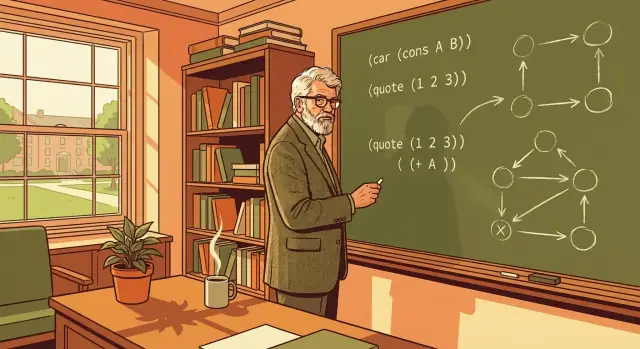

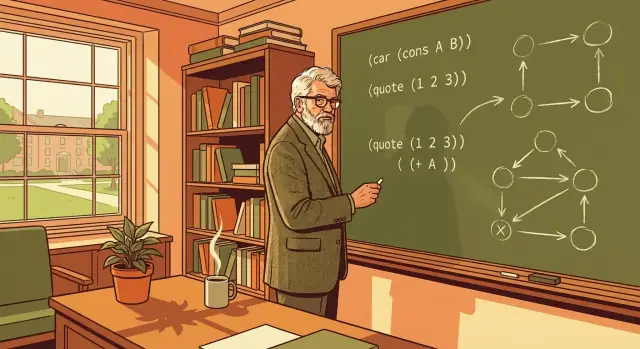

John McCarthy, Lisp und die Wurzeln des symbolischen KI-Designs

Erkunde, wie John McCarthys symbolischer Ansatz und Lisp-Designideen — Listen, Rekursion und Garbage Collection — KI und moderne Programmierung beeinflussten.

Erkunde, wie John McCarthys symbolischer Ansatz und Lisp-Designideen — Listen, Rekursion und Garbage Collection — KI und moderne Programmierung beeinflussten.

Das hier ist keine Museumsführung durch „alte KI“. Es ist eine praxisnahe Geschichtsstunde für alle, die Software bauen — Programmierer, Tech Leads und Produktverantwortliche — denn John McCarthys Ideen haben geprägt, wozu wir Programmiersprachen nutzen.

Lisp war nicht nur eine neue Syntax. Es war die Wette darauf, dass Software Ideen (nicht nur Zahlen) manipulieren kann und dass Designentscheidungen in einer Sprache Forschung, Produktiteration und ganze Tooling-Ökosysteme beschleunigen können.

Eine nützliche Art, McCarthys Vermächtnis zu lesen, ist als Frage, die heute noch zählt: Wie direkt können wir Absicht in ein ausführbares System verwandeln — ohne im Boilerplate, Reibung oder ungewollter Komplexität zu versinken? Diese Frage hallt vom Lisp-REPL bis zu modernen „Chat-to-App“-Workflows nach.

John McCarthy wird nicht nur dafür in Erinnerung behalten, dass er geholfen hat, KI als Forschungsfeld zu starten, sondern auch dafür, dass er auf eine bestimmte Art von KI bestand: Systeme, die Ideen manipulieren können, nicht nur Antworten berechnen. Mitte der 1950er organisierte er das Dartmouth Summer Research Project (wo der Begriff „artificial intelligence“ vorgeschlagen wurde) und prägte später die KI-Arbeit am MIT und in Stanford. Sein vielleicht dauerhaftester Beitrag ist die Frage, die er immer wieder stellte: Was wäre, wenn Schlussfolgern selbst als Programm ausdrückbar wäre?

Die frühen Erfolge der Informatik waren meist numerisch: Ballistik-Tabellen, technische Simulationen, Optimierung und Statistik. Diese Probleme ließen sich gut in Arithmetik fassen.

McCarthy zielte auf etwas anderes. Menschliches Denken arbeitet oft mit Konzepten wie „wenn“, „weil“, „gehört zu“, „ist eine Art von“ und „alle Dinge, die diese Bedingungen erfüllen“. Das lässt sich nicht natürlich als Fließkommazahl abbilden.

McCarthys Ansatz behandelte Wissen als Symbole (Namen, Relationen, Kategorien) und Denken als regelbasierte Transformationen über diese Symbole.

Eine hohe Sichtweise: numerische Ansätze beantworten „wie viel?“, symbolische Ansätze versuchen zu beantworten „was ist es?“ und „was folgt aus dem, was wir wissen?"

Wenn du glaubst, dass Schlussfolgern programmierbar ist, brauchst du eine Sprache, die Ausdrücke wie Regeln, logische Aussagen und verschachtelte Beziehungen bequem repräsentieren und verarbeiten kann.

Lisp wurde genau dafür gebaut. Anstatt Ideen in starre, vorgefertigte Datenstrukturen zu pressen, machte Lisp es natürlich, Code und Wissen in ähnlicher Form darzustellen. Diese Wahl war keine akademische Spielerei — sie war die praktische Brücke zwischen einer Idee beschreiben und einem Verfahren ausführen, genau die Brücke, die McCarthy von der KI erwartete.

Wenn McCarthy und frühe KI-Forscher „symbolisch“ sagten, meinten sie keine mysteriöse Mathematik. Ein Symbol ist schlicht ein sinntragendes Label: ein Name wie customer, ein Wort wie hungry oder ein Tag wie IF und THEN. Symbole sind wichtig, weil sie einem Programm erlauben, mit Ideen (Kategorien, Beziehungen, Regeln) zu arbeiten statt nur mit rohen Zahlen.

Einfach dargestellt: Tabellenkalkulationen sind großartig, wenn deine Welt aus Spalten und Rechenoperationen besteht. Symbolische Systeme sind stark, wenn deine Welt Regeln, Kategorien, Ausnahmen und Struktur hat.

In vielen Programmen ist der Unterschied zwischen 42 und "age" nicht nur der Datentyp — es ist, wofür der Wert steht. Ein Symbol gibt etwas, das du vergleichen, speichern und kombinieren kannst, ohne Bedeutung zu verlieren.

So lassen sich Aussagen wie „Paris ist eine Stadt“ oder „wenn die Batterie schwach ist, finde ein Ladegerät“ natürlich darstellen.

Um etwas Nützliches mit Symbolen zu tun, brauchst du Struktur. Lisp popularisierte eine sehr einfache Struktur: die Liste. Eine Liste ist einfach eine geordnete Gruppe von Elementen, und diese Elemente können selbst Listen sein. Mit dieser einen Idee kannst du Sätze, Formulare und baumförmiges Wissen darstellen.

Hier ein kleines konzeptuelles Beispiel (im Lisp-ähnlichen Stil):

(sentence (subject robot) (verb needs) (object power))

Es liest sich fast wie Englisch: ein Satz aus Subjekt, Prädikat und Objekt. Weil es strukturiert ist, kann ein Programm etwa (subject robot) herausgreifen oder (object power) durch etwas anderes ersetzen.

Sobald Informationen in symbolischen Strukturen vorliegen, werden klassische KI-Aufgaben handhabbar:

IF ein Muster passt, THEN schließe etwas Neues.Der entscheidende Wandel ist, dass das Programm nicht nur rechnet; es manipuliert bedeutungsvolle Wissensstücke in einer Form, die es inspizieren und transformieren kann.

Lisp-Designentscheidungen blieben nicht in der Akademie. Sie beeinflussten, wie Menschen Werkzeuge bauten und wie schnell sie Ideen erforschen konnten:

Diese Eigenschaften erzeugen tendenziell Ökosysteme, in denen Experimentieren günstig ist, Prototypen schneller zu Produkten werden und Teams sich an wechselnde Anforderungen anpassen können.

Lisp begann mit einem sehr praktischen Designproblem: wie schreibt man Programme, die natürlich mit Symbolen arbeiten, so wie sie mit Zahlen arbeiten?

McCarthy wollte keine „besseren Taschenrechner“ bauen. Er wollte eine Sprache, in der ein Ausdruck wie (is (parent Alice Bob)) so einfach gespeichert, inspiziert, transformiert und begründet werden konnte wie (+ 2 3).

Priorität war, symbolische Information einfach darzustellen und zu manipulieren. Das führte zu einem Fokus auf Listen- und baumartige Strukturen, weil sie gut zu dem passen, was Menschen nutzen, um Bedeutung auszudrücken: Sätze, logische Regeln, verschachtelte Kategorien und Beziehungen.

Ein weiteres Ziel war, den Kern der Sprache klein und konsistent zu halten. Wenn eine Sprache weniger „Sonderfälle“ hat, verbringst du weniger Zeit damit, Regeln zu lernen, und mehr damit, Ideen zu kombinieren. Lisp setzte auf wenige Bausteine, die sich zu größeren Abstraktionen zusammensetzen ließen.

Eine zentrale Einsicht war, dass Programme und Daten dieselbe Struktur teilen können. Kurz gesagt: wenn deine Daten eine verschachtelte Liste sind, kann dein Programm ebenfalls eine verschachtelte Liste sein.

Das erlaubt dir:

Lisp popularisierte auch eine Denkweise: Sprachen müssen nicht für alles gleichermaßen geeignet sein. Sie können um ein Problemfeld herum gestaltet werden — etwa Schlussfolgern, Suche und Wissensrepräsentation — und trotzdem langanhaltend Einfluss auf allgemeines Programmieren haben.

S-Expressions (kurz für symbolic expressions) sind Lisps Signaturidee: eine einzige, konsistente Art, Code und Daten als verschachtelte Listen darzustellen.

Auf den ersten Blick ist eine S-Expression nur Klammern um Elemente — einige Elemente sind Atome (Namen, Zahlen), einige sind selbst Listen. Die Regel „Listen in Listen“ ist der ganze Punkt.

Weil die Struktur einheitlich ist, werden Lisp-Programme von denselben Bausteinen bis ganz nach unten aufgebaut. Ein Funktionsaufruf, ein konfigurationsähnlicher Datenblock und ein Stück Programmstruktur lassen sich alle als Liste ausdrücken.

Diese Konsistenz zahlt sich sofort aus:

Auch wenn du nie Lisp schreibst: die Designlektion bleibt wichtig: Wenn ein System aus ein oder zwei vorhersehbaren Formen besteht, verschwendest du weniger Zeit an Edge-Cases und mehr Zeit fürs Bauen.

S-Expressions fördern Komposition, weil kleine, lesbare Teile sich natürlich zu größeren verbinden. Wenn dein Programm „nur verschachtelte Listen“ ist, bedeutet Kombinieren oft, einen Ausdruck in einen anderen zu verschachteln oder Listen aus wiederverwendbaren Teilen zusammenzusetzen.

Das treibt dich zu einem modularen Stil: kleine Operationen, die eine Sache tun, und diese dann zusammenstecken, um größere Absichten auszudrücken.

Der offensichtliche Nachteil ist Ungewohntheit. Für viele Neulinge sieht die klammerlastige Syntax seltsam aus.

Doch der Vorteil ist Vorhersehbarkeit: Wenn du die Verschachtelungsregeln verstanden hast, siehst du zuverlässig die Struktur eines Programms — und Werkzeuge können das ebenfalls. Diese Klarheit ist ein Hauptgrund, warum S-Expressions weit über Lisp hinaus Wirkung entfalteten.

Rekursion lässt sich am leichtesten mit einer Alltagsmetapher erklären: ein unordentliches Zimmer aufräumen, indem du es in kleinere „Zimmer“ aufteilst. Du versuchst nicht, alles auf einmal zu lösen. Du nimmst einen Gegenstand, legst ihn an seinen Platz und wiederholst dieselbe Aktion für den Rest. Die Schritte sind einfach; die Kraft kommt vom Wiederholen, bis nichts mehr übrig ist.

Lisp nutzt diese Idee, weil viele seiner Daten natürlich aus Listen aufgebaut sind: eine Liste hat ein „erstes Element“ und den „Rest“. Diese Form passt perfekt zum rekursiven Denken.

Um eine Liste zu verarbeiten, bearbeitest du das erste Element und wendest dieselbe Logik auf den Rest an. Wenn die Liste leer ist, hörst du auf — das ist der klare „nichts mehr zu tun“-Moment, der Rekursion definiert und weniger mysteriös erscheinen lässt.

Stell dir vor, du willst die Summe einer Liste von Zahlen berechnen.

Das ist alles. Die Definition liest sich wie klares Englisch, und die Programmstruktur spiegelt die Idee.

Symbolische KI repräsentiert Ausdrücke oft als baumartige Strukturen (ein Operator mit Unterausdrücken). Rekursion ist ein natürlicher Weg, diesen Baum zu „durchlaufen“: den linken Teil genauso auswerten wie den rechten, und so weiter, bis du auf einen einfachen Wert triffst.

Diese Muster prägten später funktionale Programmierung: kleine Funktionen, klare Basisfälle und Datentransformationen, die sich leicht begründen lassen. Auch außerhalb von Lisp führt die Gewohnheit, Arbeit in „mache einen Schritt, dann wiederhole für das Übrige“ zu zerlegen, zu saubererem Code und weniger versteckten Seiteneffekten.

Frühe Programmierer mussten oft Speicher manuell verwalten: Platz anfordern, Besitz verfolgen und daran denken, ihn zur richtigen Zeit freizugeben. Das verlangsamt nicht nur die Entwicklung — es erzeugt eine Fehlerklasse, die schwer zu reproduzieren und leicht auszuliefern ist: Lecks, die Leistung heimlich verschlechtern, und Dangling-Pointer, die ein Programm lange nach dem ursprünglichen Fehler abstürzen lassen.

John McCarthy führte Garbage Collection für Lisp ein, um Programmierern zu ermöglichen, sich auf Bedeutung statt auf Buchhaltung zu konzentrieren.

Auf hoher Ebene findet GC automatisch Speicherbereiche, die vom laufenden Programm nicht mehr erreichbar sind — Werte, die nie wieder verwendet werden können — und gibt diesen Platz frei.

Anstatt zu fragen „haben wir jedes Objekt genau einmal freigegeben?“, verschiebt GC die Frage zu „ist dieses Objekt noch zugänglich?“. Wenn das Programm es nicht erreichen kann, gilt es als Müll.

Für symbolische KI-Arbeit erzeugen Lisp-Programme häufig viele kurzlebige Listen, Bäume und Zwischenresultate. Manuelle Speicherverwaltung würde Experimente in einen ständigen Kampf um Ressourcenbereinigung verwandeln.

GC ändert die tägliche Erfahrung:

Die Kernidee ist, dass ein Sprachfeature ein Team-Multiplikator sein kann: weniger Stunden mit dem Debuggen mysteriöser Korruption bedeuten mehr Zeit für die eigentliche Logik.

McCarthys Wahl blieb nicht auf Lisp beschränkt. Viele spätere Systeme übernahmen GC (und Varianten davon), weil der Kompromiss sich oft auszahlt: Java-, C#-, Python-, JavaScript-Runtimes und Go setzen auf Garbage Collection, um großskalige Entwicklung sicherer und schneller zu machen — selbst wenn Performance wichtig ist.

In Lisp ist ein Ausdruck ein Stück Code in einer konsistenten Form (oft eine Liste). Auswertung ist der Prozess, zu entscheiden, was dieser Ausdruck bedeutet und was er ergibt.

Wenn du zum Beispiel schreibst „addiere diese Zahlen“ oder „rufe diese Funktion mit diesen Eingaben auf“, folgt der Evaluator einer kleinen Menge von Regeln, um den Ausdruck in ein Ergebnis zu verwandeln. Denk an ihn als den Schiedsrichter der Sprache: er entscheidet, was als Nächstes zu tun ist, in welcher Reihenfolge und wann aufgehört wird.

McCarthys entscheidender Zug war nicht nur neue Syntax zu erfinden — er hielt die „Bedeutungsmaschine“ kompakt und regelmäßig. Wenn der Evaluator aus wenigen klaren Regeln besteht, passieren zwei gute Dinge:

Diese Konsistenz machte Lisp zu einem Experimentierfeld für symbolische KI: Forscher konnten neue Repräsentationen und Kontrollstrukturen schnell ausprobieren, ohne auf ein Compiler-Team warten zu müssen.

Makros sind Lisps Mittel, um wiederkehrende Code-Formen zu automatisieren, nicht nur wiederkehrende Werte. Wo eine Funktion dir hilft, Berechnungen nicht zu wiederholen, hilft ein Makro, Strukturen nicht zu wiederholen — gängige Muster wie „mach X, aber logge es auch“ oder „definiere eine Mini-Sprache für Regeln“.

Die praktische Folge ist, dass Lisp sich von innen heraus neue Komfortfunktionen wachsen lassen kann. Viele moderne Werkzeuge spiegeln diese Idee wider — Templates, Code-Generatoren und Metaprogramming-Funktionen — weil sie dasselbe Ziel unterstützen: schnellere Experimente und klarere Absicht.

Wenn du neugierig bist, wie diese Denkweise alltägliche Entwicklungs-Workflows beeinflusst hat, siehe /blog/the-repl-and-fast-feedback-loops.

Ein großer Teil von Lisps Reiz war nicht nur die Sprache — es war, wie man mit ihr arbeitete. Lisp popularisierte das REPL: Read–Eval–Print Loop. Alltagssprachlich ist das wie ein Gespräch mit dem Computer. Du tippst einen Ausdruck ein, das System führt ihn sofort aus, gibt das Ergebnis aus und wartet auf deine nächste Eingabe.

Statt ein ganzes Programm zu schreiben, zu kompilieren, auszuführen und dann zu suchen, was falsch lief, kannst du Ideen Schritt für Schritt ausprobieren. Du definierst eine Funktion, testest sie mit ein paar Eingaben, passt sie an und testest erneut — alles in Sekunden.

Dieses Tempo fördert Experimentierfreude, was für frühe KI-Arbeit wichtig war, weil man oft nicht wusste, welcher Ansatz der richtige ist.

Schnelles Feedback verwandelt „große Wetten“ in „kleine Prüfungen“. Für Forschung erleichtert es das Untersuchen von Hypothesen und das Inspizieren von Zwischenresultaten.

Für Produktprototyping senkt es die Kosten der Iteration: du kannst Verhalten mit realen Daten schnell validieren, Edge-Cases früher bemerken und Features verfeinern, ohne lange Build-Zyklen abzuwarten.

Deshalb sind moderne Vibe-Coding-Tools attraktiv: sie komprimieren die Feedback-Schleife aggressiv. Zum Beispiel nutzt Koder.ai eine Chat-Oberfläche (mit einer agentenbasierten Architektur im Hintergrund), um Produktabsicht schnell in funktionierenden Web-, Backend- oder Mobilcode zu verwandeln — oft fühlt sich die „versuche → anpassen → erneut versuchen“-Schleife näher an einem REPL als an einer traditionellen Pipeline.

Die REPL-Idee taucht heute auf in:

Verschiedene Werkzeuge, derselbe Grundsatz: verkürze die Distanz zwischen Denken und Sehen.

Teams profitieren am meisten von REPL-ähnlichen Workflows, wenn sie unsichere Anforderungen erkunden, datenintensive Features bauen, APIs designen oder komplexe Logik debuggen. Wenn die Arbeit schnelles Lernen erfordert — über Nutzer, Daten oder Edge-Cases — ist interaktives Feedback kein Luxus, sondern ein Multiplikator.

Lisp „gewann“ nicht dadurch, dass es jede Tages-Syntax wurde. Es gewann dadurch, dass es Ideen säte, die in vielen Ökosystemen normal wurden.

Konzepte, die in Lisp Standard waren — Funktionen als Werte, umfangreicher Einsatz höherer Funktionen und Zusammensetzen kleiner Teile — tauchen heute weit verbreitet auf. Selbst Sprachen, die äußerlich nicht nach Lisp aussehen, fördern map/filter-Transformationen, unveränderliche Datengewohnheiten und rekursionsähnliches Denken (oft über Iteratoren oder Folds ausgedrückt).

Der mentale Wandel ist: behandle Datentransformationen als Pipeline und Verhalten als etwas, das du herumreichen kannst.

Lisp machte Programme leicht als Daten darstellbar. Diese Denkweise zeigt sich heute darin, wie wir ASTs (Abstract Syntax Trees) für Compiler, Formatter, Linter und Codegeneratoren bauen und manipulieren. Wer mit ASTs arbeitet, tut etwas Verwandtes zu „Code als Daten“, auch wenn die Strukturen JSON-Objekte, getypte Knoten oder Bytecode-Graphen sind.

Der gleiche symbolische Ansatz treibt praktische Automatisierung an: Konfigurationsformate, Templating-Systeme und Build-Pipelines beruhen auf strukturierten Repräsentationen, die Werkzeuge inspizieren, transformieren und validieren können.

Moderne Lisp-Familien (im weiten Sinne: zeitgenössische Lisps und Lisp-inspirierte Werkzeuge) beeinflussen weiterhin, wie Teams interne DSLs gestalten — kleine, fokussierte Mini-Sprachen für Tests, Deployment, Datenaufbereitung oder UI.

Auch außerhalb von Lisp zielen Makrosysteme, Metaprogramming-Bibliotheken und Code-Generierungs-Frameworks auf dasselbe Ergebnis: die Sprache an das Problem anzupassen.

Ein pragmatischer Befund: Syntaxvorlieben ändern sich, aber die dauerhaften Ideen — symbolische Struktur, komponierbare Funktionen und Erweiterbarkeit — zahlen über Jahrzehnte und Codebasen hinweg Mieten ein.

Lisp hat einen Ruf zwischen „brillant“ und „unlesbar“, oft basierend auf Zweiter-Hand-Eindrücken statt Alltagserfahrung. Die Wahrheit ist gewöhnlicher: Lisp trifft Entscheidungen, die in passenden Umgebungen mächtig und in anderen unbequem sind.

Für Neulinge kann Lisps einheitliche Syntax so wirken, als sähe man das „Innenleben“ eines Programms statt einer polierten Oberfläche. Dieses Unbehagen ist real, vor allem wenn du an Sprachen gewöhnt bist, deren Syntax verschiedene Konstrukte optisch trennt.

Historisch ist Lisps Struktur aber genau der Punkt: Code und Daten teilen dieselbe Form, was Programme leichter transformierbar, generierbar und analysierbar macht. Mit guter Editorunterstützung (Einrückung, strukturelle Navigation) wird Lisp-Code oft eher nach Form als nach Klammerzählung gelesen.

Ein verbreitetes Stereotyp ist, dass Lisp grundsätzlich langsam sei. Manche Implementierungen hatten historisch Schwierigkeiten im Vergleich zu Low-Level-Sprachen, und dynamische Features können Overhead verursachen.

Aber „Lisp“ ist kein einheitliches Leistungsprofil. Viele Lisp-Systeme unterstützen seit langem Kompilierung, Typdeklarationen und ernsthafte Optimierungen. Nützlicher ist die Frage: wie viel Kontrolle brauchst du über Speicherlayout, vorhersehbare Latenz oder rohe Durchsatzleistung — und zielt deine Lisp-Implementierung auf diese Bedürfnisse?

Ein weiterer legitimer Kritikpunkt ist die Ökosystem-Passung. Je nach Dialekt können Bibliotheken, Tooling und verfügbare Entwickler kleiner sein als in Mainstream-Stacks. Das kann wichtiger sein als sprachliche Eleganz, wenn du schnell mit einem breit aufgestellten Team liefern musst.

Anstatt Lisp nach Stereotypen zu beurteilen, bewerte seine zugrundeliegenden Ideen separat: einheitliche Struktur, interaktive Entwicklung und Makros als Mittel, domänenspezifische Abstraktionen zu bauen. Selbst wenn du nie ein Lisp-System auslieferst, können diese Konzepte schärfen, wie du Sprachdesign denkst — und wie du in jeder Sprache programmierst.

McCarthy hinterließ uns nicht nur eine historische Sprache — er hinterließ eine Reihe von Gewohnheiten, die Software leichter änderbar, erklärbar und erweiterbar machen.

Bevorzuge einfache Kerne gegenüber cleveren Oberflächen. Eine kleine Menge orthogonaler Bausteine ist leichter zu lernen und schwerer zu zerstören.

Halte Datenformen einheitlich. Wenn vieles dieselbe Repräsentation teilt (wie Listen/Bäume), werden Drucker, Debugger, Serializer und Transformer einfacher wiederverwendbar.

Behandle Programme als Daten (und Daten als Programme), wenn es hilft. Wenn du Strukturen inspizieren und transformieren kannst, kannst du sicherere Refactors, Migrationen und Code-Generatoren bauen.

Automatisiere die langweilige Arbeit. Garbage Collection ist das klassische Beispiel, aber der breitere Punkt ist: Investiere in Automatisierung, die ganze Fehlerklassen verhindert.

Optimiere für Feedback-Schleifen. Interaktive Auswertung (REPL-Stil) fördert kleine Experimente, schnelle Verifikation und bessere Intuition über Verhalten.

Mache Erweiterung zum erstklassigen Designziel. Lisp-Makros sind eine Antwort; in anderen Ökosystemen können Plugins, Templates, DSLs oder Compile-Time-Transforms das sein.

Bevor du eine Bibliothek oder Architektur auswählst, nimm ein echtes Feature — sagen wir „Rabattregeln“ oder „Support-Ticket-Routing“ — und zeichne es als Baum. Schreibe diesen Baum dann als verschachtelte Listen (oder JSON). Frage: Was sind die Knoten, was sind die Blätter und welche Transformationen brauchst du?

Auch ohne Lisp kannst du die Denkweise übernehmen: baue AST-ähnliche Repräsentationen, nutze Code-Generierung für sich wiederholende Glue und standardisiere auf datenzentrierte Pipelines (parsieren → transformieren → auswerten). Viele Teams erhalten die Vorteile allein dadurch, dass sie Zwischenrepräsentationen explizit machen.

Wenn du das REPL-Prinzip magst, aber Produktfeatures in Mainstream-Stacks auslieferst, kannst du den Geist auch ins Tooling holen: enge Iterationsschleifen, Snapshots/Rollbacks und explizite Planung vor Ausführung. Koder.ai etwa bietet einen Planungsmodus plus Snapshots und Rollback, um schnelle Iteration sicherer zu machen — ein operationelles Echo von Lisps Motto „schnell ändern, aber in Kontrolle bleiben“.

McCarthys bleibender Einfluss lautet: Programmieren wird mächtiger, wenn wir das Schlussfolgern selbst programmierbar machen — und den Weg von der Idee zum ausführbaren System so direkt wie möglich halten.

Symbolisches Denken repräsentiert Konzepte und Beziehungen direkt (z. B. „Kunde“, „ist-ein“, „abhängig-von“, „wenn…dann…“) und wendet dann Regeln und Transformationen auf diese Repräsentationen an.

Es ist besonders nützlich, wenn dein Problem voller Struktur, Ausnahmen und Bedeutung ist (Regelsysteme, Planung, Compiler, Konfiguration, Workflow-Logik) und nicht nur aus Arithmetik besteht.

McCarthy vertrat die Idee, dass Schlussfolgern als Programme ausdrückbar ist — nicht nur das Rechnen.

Diese Perspektive prägte:

Listen sind eine minimale, flexible Art, „aus Teilen gemachte Dinge“ darzustellen. Da Listenelemente selbst Listen sein können, entstehen natürlich Baumstrukturen.

Das macht es einfach zu:

S-Expressions geben dir eine einheitliche Form für Code und Daten: verschachtelte Listen.

Diese Einheitlichkeit vereinfacht Systeme, weil:

Ein Makro automatisiert wiederkehrende Code-Strukturen, nicht nur wiederkehrende Berechnungen.

Verwende Makros, wenn du:

Wenn du nur wiederverwendbare Logik brauchst, ist in der Regel eine Funktion die bessere Wahl.

Garbage Collection (GC) gibt automatisch Speicher frei, der vom laufenden Programm nicht mehr erreichbar ist, und reduziert damit ganze Kategorien von Fehlern (dangling pointers, double frees).

Das ist besonders hilfreich, wenn Programme viele kurzlebige Strukturen erzeugen (Listen/Bäume/ASTs), weil man dann prototypen und refaktorieren kann, ohne zuerst ein manuelles Speicherbesitzmodell zu entwerfen.

Ein REPL verkürzt die "denken → ausprobieren → beobachten"-Schleife. Du kannst eine Funktion definieren, sie ausführen, anpassen und sofort wieder ausführen.

Um denselben Vorteil in Nicht-Lisp-Stacks zu nutzen:

Verwandter Artikel: /blog/the-repl-and-fast-feedback-loops

Viele moderne Arbeitsweisen übernehmen dieselben Grundideen:

map/filter, Komposition)Selbst wenn du nie Lisp einsetzt, benutzt du wahrscheinlich täglich von Lisp abstammende .

Praktische Abwägungen:

Der sinnvolle Ansatz ist, die Eignung nach Domäne und Randbedingungen zu beurteilen, nicht nach Ruf.

Probiere diese 10-Minuten-Übung:

Das offenbart oft, wo „Code-als-Daten“-Muster, Regelsysteme oder DSL-ähnliche Konfigurationen dein System vereinfachen.

Viele Teams erreichen die Vorteile einfach dadurch, dass sie Zwischenrepräsentationen explizit machen.