06. Mai 2025·8 Min

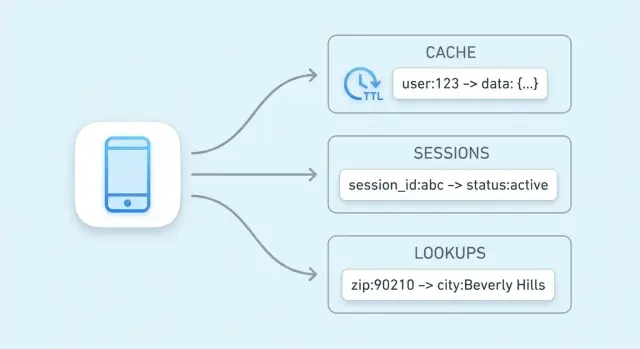

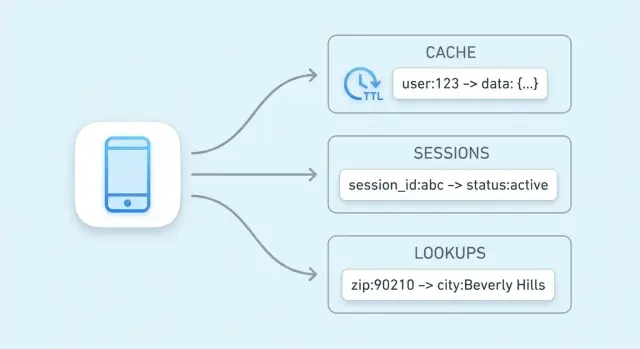

Key‑Value‑Stores für Caching, Sessions und schnelle Lookups

Lerne, wie Key‑Value‑Stores Caching, Sessions und schnelle Abfragen ermöglichen — inkl. TTLs, Eviction, Skalierungsoptionen und praktischen Kompromissen.

Lerne, wie Key‑Value‑Stores Caching, Sessions und schnelle Abfragen ermöglichen — inkl. TTLs, Eviction, Skalierungsoptionen und praktischen Kompromissen.

Das Hauptziel eines Key‑Value‑Stores ist einfach: Latenz für Endnutzer reduzieren und die Last auf der Primärdatenbank senken. Anstatt dieselbe teure Abfrage erneut auszuführen oder dasselbe Ergebnis neu zu berechnen, kann deine Anwendung einen vorab berechneten Wert in einem einzigen, vorhersehbaren Schritt abrufen.

Ein Key‑Value‑Store ist auf eine Operation optimiert: „gegeben diesen Key, gib den Wert zurück.“ Dieser enge Fokus ermöglicht einen sehr kurzen kritischen Pfad.

In vielen Systemen kann ein Lookup oft durch folgende Mechanismen sehr effizient durchgeführt werden:

Das Ergebnis sind niedrige und konsistente Antwortzeiten — genau das, was man für Caching, Session‑Speicherung und andere hochfrequente Lookups braucht.

Selbst wenn deine Datenbank gut optimiert ist, muss sie Queries parsen, Pläne erstellen, Indizes lesen und nebenläufige Zugriffe koordinieren. Wenn tausende Anfragen dieselbe „Top‑Produkte“-Liste anfordern, summiert sich diese wiederholte Arbeit.

Ein Key‑Value‑Cache verlagert diesen wiederholten Lesetraffic weg von der Datenbank. Deine Datenbank kann sich auf Anfragen konzentrieren, die sie wirklich erfordern: Writes, komplexe Joins, Reporting und konsistenzkritische Lesevorgänge.

Geschwindigkeit ist nicht umsonst. Key‑Value‑Stores geben in der Regel reichhaltige Abfragefunktionen (Filter, Joins) auf und haben je nach Konfiguration unterschiedliche Garantien bezüglich Persistenz und Konsistenz.

Sie glänzen, wenn du Daten mit einem klaren Key benennen kannst (zum Beispiel user:123, cart:abc) und schnelle Abrufe willst. Wenn du häufig „Finde alle Items, bei denen X gilt“ brauchst, ist in der Regel eine relationale oder dokumentenorientierte Datenbank besser als Primärspeicher.

Ein Key‑Value‑Store ist die einfachste Art von Datenbank: Du speicherst einen Wert (ein Datum) unter einem eindeutigen Key (einem Label) und später holst du den Wert, indem du den Key angibst.

Betrachte einen Key als einen Identifikator, den man exakt wiederholen kann, und einen Value als das, was man zurückhaben möchte.

Keys sind üblicherweise kurze Strings (wie user:1234 oder session:9f2a...). Values können klein sein (ein Zähler) oder größer (ein JSON‑Blob).

Key‑Value‑Stores sind gebaut für „Gib mir den Wert zu diesem Key“-Abfragen. Intern verwenden viele eine Struktur ähnlich einer Hash‑Tabelle: Der Key wird in einen Ort transformiert, an dem der Wert schnell gefunden werden kann.

Deshalb hört man oft von Konstantzeit‑Lookups (häufig als O(1) geschrieben): Die Performance hängt viel mehr davon ab, wie viele Requests du ausführst, als davon, wie viele Gesamt‑Records existieren. Es ist kein Zauber — Kollisionen und Speicherbegrenzungen spielen eine Rolle — aber für typische Cache/Session‑Nutzung ist es sehr schnell.

Hot Data ist der kleine Teil der Informationen, der wiederholt angefragt wird (beliebte Produktseiten, aktive Sessions, Rate‑Limit‑Zähler). Heiße Daten in einem Key‑Value‑Store — besonders im Speicher — zu halten, vermeidet langsame Datenbankabfragen und sorgt für vorhersehbare Antwortzeiten unter Last.

Caching bedeutet, eine Kopie häufig benötigter Daten an einem schnelleren Ort zu halten als die Originalquelle. Ein Key‑Value‑Store ist ein häufiger Ort dafür, weil er einen Wert in einem einzigen Lookup nach Key zurückgeben kann, oft in wenigen Millisekunden.

Caching lohnt sich, wenn dieselben Fragen immer wieder gestellt werden: beliebte Seiten, wiederholte Suchen, häufige API‑Aufrufe oder teure Berechnungen. Es ist auch nützlich, wenn die „echte“ Quelle langsamer oder rate‑limitiert ist — etwa eine primäre Datenbank unter hoher Last oder eine Drittanbieter‑API, für die pro Anfrage bezahlt wird.

Gute Kandidaten sind Ergebnisse, die oft gelesen werden und nicht unbedingt auf dem neuesten Stand sein müssen:

Eine einfache Regel: Cache Outputs, die du bei Bedarf regenerieren kannst. Vermeide das Cachen von Daten, die ständig ändern oder bei denen Konsistenz über alle Lesenden hinweg zwingend ist (z. B. Kontostand).

Ohne Caching würde jeder Seitenaufruf mehrere Datenbankabfragen oder API‑Aufrufe auslösen. Mit einem Cache kann die Anwendung viele Anfragen aus dem Key‑Value‑Store bedienen und nur bei einem Cache‑Miss auf die Primärdatenquelle zurückfallen. Das senkt die Abfrageanzahl, reduziert Verbindungs‑Contention und kann die Zuverlässigkeit bei Traffic‑Spitzen verbessern.

Caching tauscht Aktualität gegen Geschwindigkeit. Wenn gecachte Werte nicht schnell genug aktualisiert werden, sehen Nutzer möglicherweise veraltete Informationen. In verteilten Systemen können zwei Anfragen kurzzeitig unterschiedliche Versionen derselben Daten lesen.

Diese Risiken steuert man mit passenden TTLs, indem man entscheidet, welche Daten „etwas älter“ sein dürfen, und indem man die Anwendung so entwirft, dass gelegentliche Cache‑Misses oder Verzögerungen bei der Aktualisierung toleriert werden.

Ein Cache‑„Pattern“ ist ein wiederholbarer Ablauf, wie deine Anwendung Daten liest und schreibt, wenn ein Cache beteiligt ist. Die Wahl hängt weniger vom Tool (Redis, Memcached etc.) ab als davon, wie oft die zugrunde liegenden Daten sich ändern und wie viel Staleness du tolerierst.

Bei Cache‑aside kontrolliert deine Anwendung den Cache explizit:

Beste Verwendung: Daten, die oft gelesen, aber selten geändert werden (Produktseiten, Konfiguration, öffentliche Profile). Es ist auch ein guter Standard, weil Fehler sanft degradieren: Ist der Cache leer, kannst du weiterhin aus der Datenbank lesen.

Read‑through: Die Cache‑Schicht lädt bei Misses automatisch aus der Datenbank (dein App‑Code liest „vom Cache“, und der Cache kennt einen Loader). Das vereinfacht App‑Code, erhöht aber die Komplexität des Cache‑Tiers.

Write‑through: Jeder Write geht synchron in Cache und Datenbank. Reads sind oft schnell und konsistent, aber Writes sind langsamer, weil zwei Operationen abgeschlossen werden müssen.

Beste Verwendung: Daten, bei denen du weniger Cache‑Misses und einfachere Lesekonsistenz möchtest (User‑Settings, Feature‑Flags) und bei denen Schreiblatenz akzeptabel ist.

Bei Write‑back schreibt deine App zuerst in den Cache, und der Cache spült Änderungen später (oft in Batches) in die Datenbank.

Vorteile: sehr schnelle Writes und geringere Datenbanklast.

Risiko: Fällt der Cache‑Knoten aus, bevor er gespült hat, gehen Daten verloren. Verwende dies nur, wenn du Datenverlust tolerieren kannst oder starke Durability‑Mechanismen hast.

Wenn sich Daten selten ändern, reicht meist Cache‑aside mit sinnvoller TTL. Wenn Daten sehr häufig ändern und veraltete Lesungen problematisch sind, ziehe Write‑through (oder sehr kurze TTLs plus explizite Invalidierung) in Betracht. Bei extrem hoher Schreiblast und akzeptablem gelegentlichen Verlust kann Write‑behind sinnvoll sein.

Gecachte Daten „frisch genug“ zu halten heißt hauptsächlich, die richtige Ablaufstrategie pro Schlüssel zu wählen. Ziel ist nicht perfekte Genauigkeit, sondern zu verhindern, dass veraltete Ergebnisse Nutzer überraschen und gleichzeitig die Geschwindigkeitsvorteile zu behalten.

Eine TTL (Time To Live) setzt eine automatische Ablaufzeit für einen Schlüssel, sodass er nach einer Dauer verschwindet oder nicht mehr verfügbar ist. Kurze TTLs reduzieren Staleness, erhöhen aber Miss‑Raten und Backend‑Last. Längere TTLs verbessern die Trefferquote, riskieren jedoch veraltete Werte.

Praktische Herangehensweise:

TTL ist passiv. Wenn du weißt, dass sich Daten geändert haben, ist es oft besser, aktiv zu invalidieren: den alten Schlüssel löschen oder den neuen Wert sofort hineinschreiben.

Beispiel: Nach dem Ändern einer Benutzer‑Email lösche user:123:profile oder aktualisiere ihn direkt im Cache. Aktive Invalidierung verringert das Zeitfenster veralteter Daten, verlangt aber, dass deine Anwendung die Cache‑Updates zuverlässig ausführt.

Statt alte Keys zu löschen, kannst du eine Version im Key‑Namen verwenden, z. B. product:987:v42. Wenn sich das Produkt ändert, erhöhe die Version und schreibe/lese v43. Alte Versionen laufen später natürlich aus. Das vermeidet Rennen, bei denen ein Server löscht, während ein anderer gerade schreibt.

Ein Stampede passiert, wenn ein populärer Key ausläuft und viele Anfragen ihn gleichzeitig neu aufbauen.

Gängige Lösungen:

Session‑Daten sind das kleine Paket an Informationen, das deine App braucht, um einen wiederkehrenden Browser oder Client zu erkennen. Mindestens ist das ein Session‑ID (oder Token), das auf serverseitigen Zustand zeigt. Je nach Produkt kann es auch User‑State (eingeloggt‑Flag, Rollen, CSRF‑Nonce), temporäre Präferenzen und zeitkritische Daten wie Warenkorb‑Inhalt oder Checkout‑Schritte enthalten.

Key‑Value‑Stores sind deswegen eine natürliche Wahl, weil Session‑Reads und ‑Writes einfach sind: Token nachschlagen, Wert holen, aktualisieren und Ablauf setzen. TTLs sorgen dafür, dass inaktive Sessions automatisch verschwinden, was Speicher sauber hält und das Risiko bei Token‑Diebstahl reduziert.

Ein typischer Ablauf:

Verwende klare, gescoped Keys und halte Values klein:

sess:<token> oder sess:v2:<token> (Versionierung hilft bei späteren Änderungen).user_sess:<userId> -> <token> pflegen, um „eine aktive Session pro Nutzer“ durchzusetzen oder Sessions per Nutzer zu widerrufen.Logout sollte den Session‑Key und alle zugehörigen Indizes (z. B. user_sess:<userId>) löschen. Zur Rotation (empfohlen nach Login, Privilegänderungen oder regelmäßig) erstellst du ein neues Token, schreibst die neue Session und löscht dann den alten Key. So verkleinerst du das Zeitfenster, in dem ein gestohlener Token nützlich ist.

Caching ist der gebräuchlichste Use‑Case, aber nicht der einzige Weg, wie ein Key‑Value‑Store dein System beschleunigen kann. Viele Anwendungen brauchen schnelle Reads für kleine, häufig referenzierte Zustände — Dinge, die „neben der Quelle der Wahrheit“ liegen und bei fast jeder Anfrage geprüft werden müssen.

Autorisierungschecks liegen oft im kritischen Pfad: Jeder API‑Call muss vielleicht beantworten „darf dieser Nutzer das?“ Berechtigungen bei jeder Anfrage aus einer relationalen DB zu holen, kann Latenz und Last erhöhen.

Ein Key‑Value‑Store kann kompakte Autorisierungsdaten für schnelle Lookups halten, z. B.:

perm:user:123 → Liste/Set von Berechtigungscodesentitlement:org:45 → aktivierte Plan‑FeaturesDas ist besonders nützlich, wenn das Berechtigungsmodell leseintensiv ist und sich relativ selten ändert. Bei Änderungen (Rollen‑Update, Plan‑Upgrade) aktualisierst oder invalidierst du wenige Keys, damit die nächste Anfrage die neue Regel sieht.

Feature‑Flags sind kleine, häufig gelesene Werte, die schnell und konsistent across Services verfügbar sein müssen.

Typische Speicherung:

flag:new-checkout → true/falseconfig:tax:region:EU → JSON‑Blob oder versionierte KonfigurationKey‑Value‑Stores sind hier passend, weil Lesezugriffe einfach, vorhersehbar und extrem schnell sind. Versionierte Werte (config:v27:...) erleichtern sichere Rollouts und schnelles Rollback.

Rate‑Limiting wird oft auf Zählern pro Nutzer, API‑Key oder IP aufgebaut. Key‑Value‑Stores bieten atomare Operationen, mit denen du einen Zähler sicher inkrementierst, auch wenn viele Anfragen gleichzeitig eintreffen.

Beispiele:

rl:user:123:minute → bei jeder Anfrage inkrementieren, nach 60 Sekunden ablaufen lassenrl:ip:203.0.113.10:second → kurzfenstrige Burst‑KontrolleMit TTL auf jedem Zähler‑Key setzen sich Limits automatisch zurück, ohne Hintergrundjobs.

Zahlungen und andere „genau ein‑mal“-Operationen brauchen Schutz vor Retries — durch Timeouts, Client‑Retries oder Message‑Re‑Delivery.

Ein Key‑Value‑Store kann Idempotency‑Keys speichern:

idem:pay:order_789:clientKey_abc → gespeichertes Ergebnis oder StatusBei der ersten Anfrage verarbeitest du und speicherst das Ergebnis mit TTL. Spätere Retries geben das gespeicherte Ergebnis zurück, anstatt die Operation erneut auszuführen. Die TTL verhindert unendliches Wachstum und deckt realistische Retry‑Fenster ab.

Diese Verwendungen sind nicht klassisches Caching; sie dienen dazu, Latenz für häufige Reads zu halten und Koordinationsprimitive zu beschleunigen, die atomare Operationen erfordern.

„Key‑Value‑Store“ bedeutet nicht immer „String rein, String raus“. Viele Systeme bieten reichhaltigere Datenstrukturen, mit denen gängige Bedürfnisse direkt im Store modelliert werden können — oft schneller und mit weniger Komponenten als alles in der App‑Logik zu lösen.

Hashes (oder Maps) eignen sich, wenn du ein einzelnes „Ding“ mit mehreren Attributen hast. Anstatt viele Keys wie user:123:name, user:123:plan, user:123:last_seen zu erstellen, kannst du alles unter user:123 mit Feldern halten.

Das reduziert Key‑Sprawl und erlaubt, nur das benötigte Feld zu holen oder zu ändern — nützlich für Profile, Feature‑Flags oder kleine Konfigurations‑Blobs.

Sets sind ideal für „Ist X in der Gruppe?“-Fragen:

Sorted Sets fügen eine Reihenfolge über einen Score hinzu — nützlich für Bestenlisten, „Top N“-Listen und Rankings nach Zeit oder Beliebtheit. Du kannst Scores als View‑Counts oder Timestamps speichern und schnell die Top‑Items lesen.

Nebenläufigkeitsprobleme treten oft bei kleinen Features auf: Zähler, Kontingente, einmalige Aktionen und Rate‑Limits. Wenn zwei Requests gleichzeitig ankommen und die App „lesen → +1 → schreiben“ macht, gehen Updates verloren.

Atomare Operationen lösen das, indem die Änderung als einzelne, unteilbare Aktion im Store ausgeführt wird:

Mit atomaren Inkrementen brauchst du keine Locks oder zusätzliche Koordination zwischen Servern. Das bedeutet weniger Race‑Conditions, einfachere Codepfade und vorhersehbareres Verhalten unter Last — besonders bei Rate‑Limiting und Nutzungslimits, wo „fast richtig“ schnell kundenrelevante Fehler verursacht.

Wenn ein Key‑Value‑Store ernsthaften Traffic handhabt, heißt „schneller machen“ meist „breiter machen“: Reads und Writes auf mehrere Knoten verteilen und das System während Ausfällen vorhersehbar halten.

Replikation hält mehrere Kopien derselben Daten.

Sharding teilt den Keyspace über Knoten auf.

Viele Deployments kombinieren beides: Shards für Durchsatz, Replikate pro Shard für Verfügbarkeit.

„Hohe Verfügbarkeit“ bedeutet im Allgemeinen, dass die Cache/Session‑Schicht weiter Anfragen bedient, auch wenn ein Knoten ausfällt.

Bei client‑seitigem Routing berechnet deine Anwendung (oder die genutzte Bibliothek), welcher Knoten einen Key hält (häufig mit konsistentem Hashing). Das ist sehr schnell, aber Clients müssen Topologieänderungen lernen.

Bei server‑seitigem Routing sendest du Requests an einen Proxy oder Cluster‑Endpunkt, der an den richtigen Knoten weiterleitet. Das vereinfacht Clients und Rollouts, fügt aber einen Hop hinzu.

Plane Speicher Top‑down:

Key‑Value‑Stores wirken „instant“, weil sie heiße Daten im Speicher halten und für schnelle Reads/Writes optimieren. Diese Geschwindigkeit hat ihren Preis: Du wählst oft zwischen Performance, Haltbarkeit und Konsistenz. Das Verständnis dieser Trade‑Offs verhindert unangenehme Überraschungen später.

Viele Key‑Value‑Stores laufen mit verschiedenen Persistenzmodi:

Wähle den Modus passend zur Datenbedeutung: Caches tolerieren Verlust; Sessions erfordern oft mehr Sorgfalt.

In verteilten Setups siehst du möglicherweise eventual consistency — Lesezugriffe können kurz nach einem Write noch einen älteren Wert zurückliefern, besonders bei Failover oder Replikationsverzögerung. Stärkere Konsistenz (z. B. Acknowledgements von mehreren Knoten) reduziert Anomalien, erhöht jedoch Latenz und kann Verfügbarkeit bei Netzwerkproblemen einschränken.

Caches füllen sich. Eine Eviktionsstrategie entscheidet, was entfernt wird: am wenigsten kürzlich verwendet (LRU), am wenigsten häufig verwendet (LFU), zufällig oder „nicht evictieren“ (was bei vollem Speicher zu Schreibfehlern führt). Entscheide, ob du lieber fehlende Cache‑Einträge oder Fehler unter Druck haben willst.

Gehe von Ausfällen aus. Typische Fallbacks:

Solche Verhaltensweisen bewusst zu entwerfen macht das System für Nutzer zuverlässig.

Key‑Value‑Stores sitzen oft auf dem „hot path“ deiner App. Das macht sie sowohl sensibel (sie können Session‑Tokens oder Nutzerkennungen halten) als auch kostenintensiv (meist speicherlastig). Die Grundlagen früh richtig zu setzen verhindert spätere Vorfälle.

Beginne mit klaren Netzwerkgrenzen: Platziere den Store in einem privaten Subnetz/VPC und erlaube nur Verkehr von den Applikationsdiensten, die ihn wirklich brauchen.

Nutze Authentifizierung, falls das Produkt es unterstützt, und folge dem Prinzip der geringsten Privilegien: getrennte Anmeldeinformationen für Apps, Admins und Automatisierung; Secrets rotieren; vermeide geteilte „Root“‑Tokens.

Verschlüssele Daten in Transit (TLS), besonders wenn Traffic Hosts oder Zonen überquert. Verschlüsselung at rest ist produkt‑ und deploymentabhängig; falls verfügbar, aktiviere sie für Managed Services und prüfe auch Backup‑Verschlüsselung.

Ein kleiner Satz Metriken sagt dir, ob der Cache hilft oder schadet:

Setze Alerts für plötzliche Änderungen, nicht nur absolute Schwellen, und logge Schlüsseloperationen sorgfältig (vermiede das Protokollieren sensibler Werte).

Hauptkostentreiber sind:

Ein praktischer Kostenhebel ist, Wertgrößen zu reduzieren und realistische TTLs zu setzen, damit der Store nur hält, was aktiv nützlich ist.

Beginne damit, die Key‑Namensgebung zu standardisieren, damit Cache‑ und Session‑Keys vorhersehbar, durchsuchbar und sicher für Bulk‑Operationen sind. Eine einfache Konvention wie app:env:feature:id (z. B. shop:prod:cart:USER123) hilft, Kollisionen zu vermeiden und das Debugging zu beschleunigen.

Definiere eine TTL‑Strategie bevor du auslieferst. Entscheide, welche Daten schnell (Sekunden/Minuten), länger (Stunden) oder gar nicht gecached werden sollen. Wenn du Datenbankzeilen cached, stimmen TTLs mit der Änderungsfrequenz der zugrunde liegenden Daten überein.

Schreibe einen Invalidierungsplan für jeden gecachten Item‑Typ:

product:v3:123) für einfaches „alles invalidieren“Wähle einige Erfolgsmessgrößen und verfolge sie von Anfang an:

Beobachte auch Eviction‑Counts und Speichernutzung, um zu bestätigen, dass dein Cache passend dimensioniert ist.

Zu große Values erhöhen Netzwerkzeit und Speicherdruck — bevorzuge kleinere, vorab berechnete Fragmente. Vermeide fehlende TTLs (veraltete Daten und Speicherlecks) und unbegrenztes Key‑Wachstum (z. B. das Cachen jeder Suchanfrage für immer). Achte darauf, keine nutzerspezifischen Daten unter gemeinsamen Keys zu cachen.

Wenn du Optionen evaluierst, vergleiche einen lokalen In‑Process‑Cache gegen einen verteilten Cache und entscheide, wo Konsistenz am wichtigsten ist. Für Implementierungsdetails und Betriebsführung siehe /docs. Wenn du Kapazitäten planst oder Kostenannahmen brauchst, siehe /pricing.

Wenn du ein neues Produkt baust (oder ein bestehendes modernisierst), hilft es, Caching und Session‑Speicherung von Anfang an als first‑class Belange zu behandeln. Bei Koder.ai prototypen Teams oft eine End‑to‑End‑App (React im Web, Go‑Services mit PostgreSQL und optional Flutter für Mobile) und iterieren dann an der Performance mit Mustern wie Cache‑aside, TTLs und Rate‑Limiting‑Zählern. Features wie Planungsmodus, Snapshots und Rollbacks erleichtern das Ausprobieren von Cache‑Key‑Designs und Invalidierungsstrategien, und du kannst den Quellcode exportieren, wenn du bereit bist, ihn in deiner eigenen Pipeline zu betreiben.

Key‑Value‑Stores sind auf eine Operation optimiert: gib einen Key, bekomme einen Wert zurück. Dieser enge Fokus ermöglicht schnelle Pfade wie In‑Memory‑Indizes und Hashing und erspart viel Query‑Planungsaufwand, wie ihn allgemeine Datenbanksysteme benötigen.

Indirekt beschleunigen sie dein System auch, weil sie wiederholte Lesezugriffe (beliebte Seiten, häufige API‑Antworten) auslagern, sodass die Primärdatenbank sich auf Schreibvorgänge und komplexe Abfragen konzentrieren kann.

Ein Key ist ein eindeutiger Bezeichner, den du exakt wiederholen kannst (oft ein String wie user:123 oder sess:<token>). Der Wert ist alles, was du zurückhaben möchtest – von einem kleinen Zähler bis zu einem JSON‑Blob.

Gute Keys sind stabil, gescoped und vorhersehbar, was Caching, Sessions und Lookups einfacher zu betreiben und zu debuggen macht.

Cache Ergebnisse, die häufig gelesen werden und bei Bedarf neu erzeugbar sind.

Gängige Beispiele:

Vermeide das Cachen von Daten, die jederzeit absolut aktuell sein müssen (z. B. Kontostände), es sei denn, du hast eine robuste Invalidierungsstrategie.

Cache‑aside (lazy loading) ist meist die Standardwahl:

key aus dem Cache.Das Muster degradiert elegant: Ist der Cache leer oder ausgefallen, kannst du trotzdem aus der Datenbank bedienen (mit entsprechenden Schutzmaßnahmen).

Verwende Read‑through, wenn die Cache‑Schicht bei Misses automatisch aus der Datenbank lädt (vereinfacht App‑Code, erfordert aber eine Loader‑Integration im Cache).

Verwende Write‑through, wenn jeder Schreibvorgang synchron sowohl in Cache als auch in die Datenbank geht—Ergebnisse bleiben meist konsistenter, aber Writes werden langsamer.

Wähle nach dem, was du tolerieren kannst: zusätzliche Komplexität (Read‑through) oder höhere Schreiblatenz (Write‑through).

Eine TTL legt automatisch fest, wie lange ein Schlüssel gültig ist. Kurze TTLs reduzieren Staleness, erhöhen aber Miss‑Raten und Backend‑Last; lange TTLs verbessern die Trefferquote, riskieren jedoch veraltete Daten.

Praktische Hinweise:

Ein Cache‑Stampede entsteht, wenn ein heißer Schlüssel ausläuft und viele Anfragen ihn gleichzeitig neu berechnen.

Gängige Gegenmaßnahmen:

Diese Techniken reduzieren plötzliche Lastspitzen auf Datenbank oder externe APIs.

Sessions passen gut, weil Zugriffe einfach sind: Token lesen/schreiben und Ablauf setzen. TTLs sorgen dafür, dass inaktive Sessions automatisch verschwinden und reduzieren das Risiko bei Token‑Diebstahl.

Gute Praktiken:

Viele Key‑Value‑Stores bieten atomare Inkremente, wodurch Zähler unter gleichzeitigen Zugriffen sicher aktualisiert werden können.

Typisches Muster:

rl:user:123:minute → bei jeder Anfrage inkrementierenÜberschreitet der Zähler den Schwellenwert, drossle oder lehne die Anfrage ab. TTLs sorgen dafür, dass Limits automatisch ohne Hintergrundjobs zurückgesetzt werden.

Wichtige Trade‑Offs:

Plane auch einen Degradationsmodus: Cache überspringen, leicht veraltete Daten liefern, oder für sensible Operationen fail‑closed—je nachdem, was dein Produkt verlangt.

sess:<token>sess:v2:<token>