Was „Kosten, Zeit und Reibung“ in der Softwarearbeit bedeuten

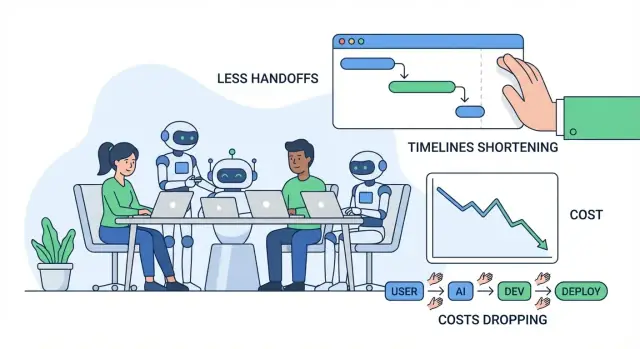

Wenn Leute über bessere Softwarelieferung sprechen, meinen sie meist drei Dinge: Kosten, Zeit und Reibung. Diese hängen eng zusammen, sind aber nicht identisch – und es hilft, sie klar zu definieren, bevor wir über KI sprechen.

Kosten: was du für Ergebnisse zahlst

Kosten sind die gesamten Ausgaben, die erforderlich sind, um ein Feature zu liefern und zu betreiben: Gehälter und Contractor‑Stunden, Cloud‑Rechnungen, Tools und die „versteckten“ Kosten für Meetings, Koordination und das Beheben von Fehlern. Ein Feature, das zwei Wochen länger dauert, kostet nicht nur mehr Entwicklungszeit – es kann Umsatz verzögern, den Supportaufwand erhöhen oder dazu zwingen, ältere Systeme länger laufen zu lassen.

Zeit: wie lange es vom Gedanken bis zum ausgelieferten Wert dauert

Zeit ist die Kalenderzeit von „wir sollten das bauen“ bis „Kund:innen können es zuverlässig nutzen“. Das umfasst Entwicklung, aber auch Entscheidungen, Genehmigungen, Warten auf Reviews, auf Umgebungen, auf QA‑Ergebnisse und auf jemanden mit dem richtigen Kontext, der Fragen beantwortet.

Reibung: Aufwand, der durch Verzögerung, Verwirrung und Unterbrechungen verloren geht

Reibung ist die alltägliche Bremse, die Arbeit langsamer erscheinen lässt als sie sein müsste: unklare Anforderungen, ständiges Hin und Her, Kontextwechsel, doppelte Arbeit oder lange Übergaben zwischen Rollen oder Teams.

Der größte Teil der Verschwendung in Softwareprojekten zeigt sich als Übergaben, Nacharbeit und Warten. Ein kleines Missverständnis früh kann später zu Neugestaltung, Bug‑Jagd oder Wiederholung von Meetings werden. Eine langsame Review‑Queue oder fehlende Dokumentation kann Fortschritt blockieren, obwohl alle „beschäftigt“ sind.

In diesem Artikel umfasst KI‑Tools Coding‑Copilots, Chat‑Assistenten für Recherche und Erklärungen, automatisierte Analysen für Anforderungen und Tickets, Test‑Generierungshelfer und Workflow‑Automatisierung in QA/DevOps.

KI kann Aufwand reduzieren und Zyklen beschleunigen – aber sie entbindet nicht von Verantwortung. Teams brauchen weiterhin klare Ownership, gutes Urteilsvermögen, Sicherheitskontrollen und menschliche Abnahme für das, was ausgeliefert wird.

Wo Softwareprojekte typischerweise Zeit und Geld verlieren

Die meisten Kostenüberschreitungen entstehen nicht durch „schwieriges Coden“. Sie entstehen durch alltägliche Engpässe, die sich aufschaukeln: unklare Anforderungen, ständige Kontextwechsel, langsame Review‑Schleifen und manuelle Tests, die zu spät stattfinden.

Die häufigen Engpässe (und warum sie teuer sind)

Unklare Anforderungen verursachen die größten nachgelagerten Kosten. Ein kleines Missverständnis am Anfang kann später eine Woche Nacharbeit bedeuten – besonders wenn verschiedene Personen dasselbe Feature unterschiedlich interpretieren.

Kontextwechsel ist der stille Productivity‑Killer. Entwickler springen zwischen Tickets, Chat‑Fragen, Meetings und Produktionsproblemen hin und her. Jeder Wechsel hat einen Wiederanlauf‑Preis: Codebasis neu laden, Entscheidungshistorie rekapitulieren und das „Warum“ wiederherstellen.

Langsame Reviews verzögern nicht nur Merges – sie verzögern Lernen. Wenn Feedback Tage später kommt, ist der Autor oft schon weitergezogen, und die Behebung dauert länger.

Manuelle Tests und späte QA bedeuten oft, dass Probleme entdeckt werden, wenn sie am teuersten zu beheben sind: nachdem mehrere Features übereinander gelegt wurden oder kurz vor der Veröffentlichung.

Die versteckten Kosten, die Leute nicht budgetieren

Offensichtliche Kosten sind Gehälter und Vendor‑Rechnungen. Die versteckten treffen oft härter:

- Nacharbeit: Code umschreiben und Flows neu gestalten, weil Anforderungen sich verschoben haben oder missverstanden wurden.

- Verzögerungen: Warten auf Entscheidungen, Genehmigungen, Testumgebungen oder auf „die eine Schlüsselfigur“.\n- Koordinationsaufwand: Abgleich zwischen Produkt, Design, Engineering, QA, Security und Stakeholdern.

Ein einfacher Idea → Release‑Workflow (mit Schmerzpunkten)

Idea → requirements → design → build → review → test → release → monitor

Typische Schmerzpunkte: Anforderungen (Ambiguität), Build (Unterbrechungen), Review (Queue‑Zeit), Test (manuelle Arbeit), Release (Übergaben), Monitor (langsame Fehlersuche).

Schnelldiagnose: Friction‑Mapping

Versucht ein „Friction‑Map“ in 30 Minuten: listet jeden Schritt auf und markiert (1) wo Arbeit wartet, (2) wo Entscheidungen stocken und (3) wo Nacharbeit passiert. Diese markierten Bereiche sind oft die Stellen, an denen KI‑Tools am schnellsten Einsparungen bringen — durch Reduktion von Missverständnissen, Beschleunigung von Feedback und Wegfall repetitiver manueller Arbeit.

KI‑unterstützte Discovery und Anforderungen: weniger Missverständnisse

Discovery ist der Punkt, an dem viele Projekte unbemerkt vom Kurs abkommen: Notizen sind verstreut, Feedback widersprüchlich und Entscheidungen leben im Kopf von Personen. KI ersetzt nicht das Gespräch mit Nutzer:innen, aber sie kann den „Übersetzungsverlust“ zwischen Gesprächen, Dokumenten und dem, was Entwickler bauen, verringern.

Teams sammeln oft einen Berg an Research‑Notizen – Interview‑Transkripte, Support‑Tickets, Ausschnitte aus Sales‑Calls, Umfrageantworten – und kämpfen dann damit, Muster schnell zu extrahieren. KI‑Tools können diesen Schritt beschleunigen, indem sie:\n\n- Lange Research‑Notizen in konsistente Takeaways (Schmerzpunkte, Ziele, Einwände) zusammenfassen\n- Feedback in Themen clustern (z. B. Onboarding‑Verwirrung vs. fehlende Integrationen)\n- Erste User Stories und Jobs‑to‑be‑done‑Aussagen aus Rohdaten entwerfen\n\nDas erzeugt nicht automatisch Wahrheit, aber es schafft einen klaren Ausgangspunkt, der leichter zu kritisieren, zu verfeinern und abzustimmen ist.

Scope und Akzeptanzkriterien früher definieren

Missverständnisse zeigen sich meist später als „Das meinte ich nicht“‑Nacharbeit. KI hilft, indem sie schnell erste Entwürfe liefert für:\n\n- Scope‑Grenzen (was ist drin vs. was nicht für dieses Release)\n- Edge‑Cases und „was ist mit…“‑Szenarien basierend auf ähnlichen Patterns\n- Akzeptanzkriterien, die spezifisch genug zum Testen sind\n\nBeispiel: Wenn eine Anforderung sagt „Benutzer können Reports exportieren“, kann KI das Team dazu bringen, Details zu klären: Formate (CSV/PDF), Berechtigungen, Datumsbereiche, Zeitzonenverhalten und ob Exporte per E‑Mail versandt oder heruntergeladen werden. Diese Antworten früh zu bekommen reduziert Churn während Entwicklung und QA.

Konsistente Dokumentation, die tatsächlich genutzt wird

Wenn Anforderungen über Docs, Chat‑Threads und Tickets verstreut sind, zahlt das Team permanent einen „Kontextwechsel‑Steuersatz“. KI kann helfen, eine einzige lesbare Narrative zu pflegen, indem sie Entwürfe und Wartung übernimmt für:\n\n- Meeting‑Zusammenfassungen mit Entscheidungen und offenen Fragen\n- Anforderungsdokumente und Ticket‑Beschreibungen in einer konsistenten Vorlage\n- Glossare für Fachbegriffe (damit „account“, „workspace“ und „org“ nicht vermischt werden)\n\nDie Rendite ist weniger Unterbrechungen („Was hatten wir entschieden?“) und flüssigere Übergaben zwischen Produkt, Design, Entwicklung und QA.

Leitplanken: Annahmen validieren, nicht auslagern

KI‑Outputs sollten als Hypothesen behandelt werden, nicht als endgültige Anforderungen. Einfache Leitplanken:\n\n- Prüfe Zusammenfassungen immer gegen die Originalquellen (besonders Zitate und Zahlen)\n- Markiere unsichere Punkte als Fragen und bestätige sie mit Nutzer:innen und Stakeholdern\n- Behalte die Entscheidungsverantwortung beim Team: KI entwirft, Menschen genehmigen\n\nSo eingesetzt reduziert KI‑unterstützte Discovery Missverständnisse, ohne Verantwortlichkeit zu schwächen — und spart Kosten, Zeit und Reibung noch bevor die erste Codezeile geschrieben ist.

Schnellere Prototypen und Design‑Iterationen mit KI

Prototyping ist der Punkt, an dem viele Teams entweder Wochen sparen oder verbrennen. KI macht es günstiger, Ideen schnell zu erkunden, sodass du validieren kannst, was Nutzer wirklich wollen, bevor du Engineering‑Zeit in einen vollständigen Build investierst.

Rasche „First Drafts“ für Screens und Flows

Statt bei Null zu beginnen, kannst du KI nutzen, um zu generieren:\n\n- UI‑Texte für Buttons, Fehlermeldungen, Onboarding‑Schritte und Empty States (mit Tonalitätsoptionen wie „freundlich“ vs. „formell")\n- Wireframe‑Ideen als einfache Bildschirmbeschreibungen (was ist auf der Seite, was ist primär vs. sekundär)\n- Beispiel‑User‑Journeys: „Neuer Nutzer registriert sich → importiert Daten → setzt ein Ziel → erhält Erinnerung"\n\nDiese Entwürfe sind keine finalen Designs, geben dem Team aber etwas Konkretes, auf das es reagieren kann. Das reduziert Hin und Her wie „Ich dachte, du meintest X“ oder „Wir sind noch nicht beim selben Flow“.\n\n### Schnelle Demo‑Apps und Proof‑of‑Concepts

Für viele Produktentscheidungen brauchst du keinen Produktionscode, um zu lernen. KI kann helfen, eine einfache Demo‑App oder POC zusammenzustellen, die zeigt:\n\n- Die Kerninteraktion (was der Nutzer klickt, was er als Nächstes sieht)\n- Beispiel‑Daten und realistische Edge‑Cases\n- Einen einfachen „Happy Path“, der für interne Reviews oder Nutzerinterviews ausreicht\n\nWenn du weiter gehen willst als statische Mockups, können vibe‑coding Plattformen wie Koder.ai nützlich sein: Du beschreibst das Feature im Chat, generierst einen lauffähigen Web‑ oder Mobile‑App‑Entwurf (häufig React im Web und Flutter mobil) und verfeinerst ihn mit Stakeholdern, bevor du eine vollständige Engineering‑Phase startest.

Wo die Zeitersparnis wirklich entsteht

Die größten Einsparungen kommen meist nicht in der „Design‑Zeit“. Sie entstehen, weil du vermeidest, das falsche zu bauen. Wenn ein Prototyp Verwirrung, fehlende Schritte oder unklaren Wert aufzeigt, kannst du die Richtung anpassen, solange Änderungen noch günstig sind.

Wichtiger Hinweis: Nicht versehentlich Prototype‑Code in Produktion bringen

KI‑generierte Prototypen überspringen oft wichtige Aufräumarbeiten: Sicherheitschecks, Accessibility, Performance, ordentliches Fehlerhandling und wartbare Struktur. Behandle Prototype‑Code als verworfbar, sofern du ihn nicht bewusst hart machst — sonst riskierst du, dass ein schneller Versuch zur langfristigen Nacharbeit wird.

Wenn du Prototypen in echte Features überführst, nutze Workflows, die diesen Übergang explizit machen (z. B. Planungsmodus, Snapshots und Rollbacks). Das hilft Teams, schnell zu bleiben, ohne Rückverfolgbarkeit zu verlieren.

Schnelleres Coding mit KI‑Assistenten (und wo sie am meisten helfen)

Schnell einen prüfbaren Entwurf erstellen

Verwandle eine kurze Spezifikation mit Koder.ai im Chat in einen ausführbaren App-Entwurf.

KI‑Coding‑Assistenten sind besonders wertvoll bei den unspektakulären Teilen der Entwicklung: vom „Nichts“ zu einem funktionierenden Startpunkt kommen und repetitive Arbeit beseitigen, die Teams verlangsamt. Sie ersetzen kein Engineering‑Urteil, können aber die Zeit zwischen Idee und prüfbarem Pull Request stark verkürzen.

Wie sie die „Blank‑Page“-Zeit reduzieren

Beim Start eines neuen Endpunkts, Jobs oder UI‑Flows geht oft die erste Stunde in Wiring, Naming und Musterkopieren aus älterem Code. Assistenten können diese Initialstruktur schnell entwerfen: Ordner, Basisfunktionen, Fehlerbehandlung, Logging und Platzhalter‑Tests. So verbringen Entwickler mehr Zeit mit Produktlogik und Edge‑Cases und weniger mit Boilerplate.

Für Teams, die über „Editor‑Assist“ hinaus wollen, verpacken Plattformen wie Koder.ai dies in einen vollständigen Workflow: von einer Spezifikation im Chat zu einer lauffähigen App mit Backend‑Teilen (oft Go + PostgreSQL), plus Optionen wie Source‑Export und Deployment/Hosting. Der praktische Vorteil ist die Reduktion der Koordinationskosten des „Zu etwas kommen, das man reviewen kann".

Aufgaben mit bestem Fit (wo sie am meisten helfen)

Sie funktionieren besonders gut bei abgegrenzter, musterbasierter Arbeit, vor allem wenn die Codebasis bereits klare Konventionen hat:\n\n- Scaffolding: neue Routen/Controller, CRUD‑Screens, CLI‑Commands, Background‑Jobs, SDK‑Wrapper.\n- Refactors: Umbenennen und Neuordnen von Modulen, Funktionen extrahieren, einheitliche Fehlerbehandlung, veraltete APIs aktualisieren.\n- Translations: kleine Komponenten zwischen Sprachen/Frameworks portieren (z. B. Python zu TypeScript) mit Tests zur Verhaltenssicherung.\n- Kleine Features: eng umrissene Ergänzungen wie ein Filter, Export, Webhook‑Handler oder Validierungsregel.\n- Interne Tools: Admin‑Seiten, Skripte, Datenkorrekturen, Report‑Generatoren – hoher Nutzen, geringe UX‑Politur.

Prompt‑Muster, die nutzbaren Code liefern

Gute Prompts sehen weniger nach „schreibe Feature X“ aus und mehr nach Mini‑Specs. Enthalten sollten sie:\n\n- Kontext: was das Modul macht, wo es lebt und umgebende APIs.\n- Einschränkungen: Libraries, Stilregeln, Performance‑ oder Sicherheitsanforderungen.\n- Beispiele: existierende ähnliche Dateien oder ein Input/Output‑Sample.\n- Akzeptanztests: Edge‑Cases und „done means…“ Prüfungen (auch in einfachem Englisch).

Add a /v1/invoices/export endpoint.

Context: Node/Express, uses InvoiceService.list(), auth middleware already exists.

Constraints: stream CSV, max 50k rows, no PII fields, follow existing error format.

Example: match style of routes/v1/customers/export.ts.

Acceptance: returns 401 if unauthenticated; CSV has headers A,B,C; handles empty results.

Review ist unverzichtbar

KI‑generierter Code braucht weiterhin dieselben Standards: Code Review, Security Review und Tests. Entwickler sind verantwortlich für Korrektheit, Datenhandling und Compliance – behandle den Assistenten als schnellen Entwurf, nicht als Autorität.

Review‑Zyklen und Nacharbeit mit KI reduzieren

Code Review ist ein Ort, an dem viele „versteckte Kosten“ entstehen: Warten auf Feedback, Absicht neu erklären und dieselben Kategorien von Problemen wieder beheben. KI ersetzt nicht das Urteil eines Reviewers, kann aber die Zeit für mechanische Checks und Missverständnisse verringern.

Wie KI beim Code Review hilft

Ein guter KI‑Workflow unterstützt Reviewer schon bevor sie den PR öffnen:\n\n- Änderungen zusammenfassen: Erzeuge eine Klartext‑Zusammenfassung dessen, was der PR macht, welche Dateien sich ändern und welches Verhalten beabsichtigt ist. Das hilft Reviewern, schneller zu fokussieren und reduziert „Was sehe ich hier?“‑Kommentare.\n- Risikomuster aufzeigen: Markiere häufige Fehlerquellen – fehlende Null‑Checks, unsicheres String‑Parsing, flakige Zeitlogik, unbehandelte Fehler oder verdächtige Berechtigungsänderungen.\n- Tests vorschlagen: Schlage konkrete Testfälle vor, basierend auf dem Diff („füge Test für ungültige Eingaben hinzu“, „assert Zugriffskontrolle für Rolle X“, „cover neuen Edge‑Case in Pagination“).

Weniger Hin‑und‑Her

KI kann auch Klarheit und Konsistenz verbessern, was üblicherweise das Review‑Ping‑Pong antreibt:\n\n- Bessere PR‑Beschreibungen entwerfen (Motivation, Ansatz, Trade‑offs).\n- Namensgebung und Formatkonstanz durchsetzen, um subjektive Debatten zu vermeiden.\n- Kleine Refactors vorschlagen, die Code lesbarer machen, sodass Reviewer nicht später große Umbauten verlangen.

Praktische Regeln, die es sicher halten

Nutze KI, um Reviews zu beschleunigen, ohne Standards zu senken:\n\n- Menschliche Abnahme ist Pflicht für jeden PR.\n- Richte KI‑Vorschläge an deinem Styleguide und Lint‑Rules aus.\n- Halte PRs klein und fokussiert, damit Menschen und KI leichter argumentieren können.

Wo KI noch schwächelt

KI ist am schwächsten bei Domain‑Logik und Architektur: Geschäftsregeln, Edge‑Cases mit realen Nutzer:innen und systemweite Trade‑offs erfordern erfahrenes Urteil. Behandle KI als Assistent des Reviewers, nicht als den Reviewer.

KI in Testing und QA: früher Fehler finden mit weniger manueller Arbeit

Risikoarmen Pilot starten

Führen Sie einen kleinen KI-Workflow-Pilot mit dem Free-Tarif durch und messen Sie die Zykluszeit.

Testing ist der Punkt, an dem kleine Missverständnisse zu teuren Überraschungen werden. KI kann Qualität nicht garantieren, aber sie kann viel repetitive Arbeit entfernen – sodass Menschen mehr Zeit an den kniffligen Fällen verbringen, die Produkte wirklich brechen.

Automatisierte Testgenerierung: mit echten Codepfaden beginnen

KI‑Tools können Unit‑Tests vorschlagen, indem sie bestehenden Code lesen und gängige Ausführungspfade identifizieren (der „Happy Path“) sowie Zweige, die leicht vergessen werden (Fehlerbehandlung, Null/Empty‑Inputs, Retries, Timeouts). Wenn du zusätzlich eine kurze Spezifikation oder Akzeptanzkriterien lieferst, kann KI Edge‑Cases direkt aus Anforderungen ableiten – z. B. Grenzwerte, ungültige Formate, Berechtigungsprüfungen und „was, wenn der Upstream‑Service down ist?“‑Szenarien.

Der beste Einsatz hier ist Beschleunigung: Du erhältst schnell einen ersten Testentwurf, den Entwickler dann an die realen Geschäftsregeln anpassen.

Schnellere Testdaten, Mocks und Fixtures

Ein überraschender Zeitfresser in QA ist das Erstellen realistischer Testdaten und das Verdrahten von Mocks. KI kann helfen durch:\n\n- Erzeugung repräsentativer Beispieldatensätze (inkl. „seltsamer“ Fälle), die Validierungsregeln erfüllen\n- Schreiben von Mocks/Stubs für externe Services mit vorhersehbaren Antworten\n- Erstellen wiederverwendbarer Fixtures, die Tests kürzer und lesbarer machen\n\nDas beschleunigt sowohl Entwickler‑Unit‑Tests als auch Integrationstests, insbesondere bei vielen beteiligten APIs.

Bessere Bug‑Reports: klarere, schnellere Fixes

Wenn Probleme QA oder Produktion erreichen, kann KI Bug‑Reports verbessern, indem sie unstrukturierte Notizen in strukturierte Reproduktionsschritte verwandelt und erwartetes vs. tatsächliches Verhalten klar trennt. Anhand von Logs oder Konsolenausgaben kann sie Muster zusammenfassen (was zuerst fehlschlug, was sich wiederholte, was mit dem Fehler korreliert), sodass Entwickler die erste Stunde nicht nur mit Verstehen des Reports verbringen.

Qualitätskontrollen (nicht verhandelbar)

KI‑generierte Tests müssen weiterhin:\n\n- Sinnvoll sein: Assertions an echte Anforderungen gebunden, nicht nur „läuft ohne Crash“.\n- Deterministisch: keine flakigen Zeitabhängigkeiten, Zufallsseeds oder instabile externe Abhängigkeiten.\n- Gepflegt: wie Produktionscode behandelt – reviewed, gut benannt und aktualisiert, wenn sich Verhalten ändert.

So eingesetzt reduziert KI manuellen Aufwand und hilft Teams, Fehler früher zu finden – wenn Behebungen am günstigsten sind.

Release und Betrieb: weniger Warten, schnellere Fehlersuche

Release‑Arbeit ist ein Bereich, in dem „kleine Verzögerungen" sich aufschaukeln: eine flakige Pipeline, eine unklare Fehlermeldung, eine fehlende Konfigurationsvariable oder eine langsame Übergabe zwischen Dev und Ops. KI‑Tools helfen, die Zeit vom „etwas ist kaputt“ bis „wir wissen, was als Nächstes zu tun ist“ zu verkürzen.

KI für CI/CD und DevOps

Moderne CI/CD‑Systeme produzieren viele Signale (Build‑Logs, Testausgaben, Deploy‑Events). KI kann dieses Rauschen zu einer kurzen, handlungsfähigen Ansicht zusammenfassen: was fehlgeschlagen ist, wo es zuerst auftrat und was sich kürzlich geändert hat.

Sie kann außerdem kontextbezogene Lösungsvorschläge machen – z. B. eine Versionsinkompatibilität in einem Docker‑Image, eine falsch geordnete Step‑Abfolge in einem Workflow oder eine fehlende Umgebungsvariable – ohne dass du Hunderte von Zeilen manuell durchsuchen musst.

Wenn du eine End‑to‑End‑Plattform wie Koder.ai für Build und Hosting nutzt, können operative Features wie Snapshots und Rollback auch Releases risikoärmer machen: Teams können experimentieren, deployen und schnell zurückrollen, wenn die Realität von der Planung abweicht.

Incident‑Support: schnellere Hypothesen und Checklisten

Bei Incidents zählt vor allem die Geschwindigkeit in den ersten 15–30 Minuten. KI kann:\n\n- Root‑Cause‑Hypothesen aus Logs, Alerts und letzten Deployments entwerfen\n- Eine Remediation‑Checkliste generieren (Rollback, Feature‑Flag aus, skalieren, Queue leeren, DB‑Verbindungen prüfen)\n- Zielgerichtete Befehle und Queries vorschlagen, um jede Hypothese zu bestätigen oder auszuschließen\n\nDas reduziert die Belastung für On‑Call‑Teams, indem die Triage beschleunigt wird – nicht indem die Menschen, die den Dienst verantworten, ersetzt werden. Ownership, Urteilsvermögen und Verantwortlichkeit bleiben beim Team.

Sicherheits‑Hinweise (nicht überspringen)

KI ist nur dann nützlich, wenn sie sicher eingesetzt wird:\n\n- Keine Secrets (API‑Keys, Tokens, Kundendaten) in Prompts einfügen – Redaktion und Least‑Privilege nutzen.\n- Behandle KI‑Output als Vorschläge, nicht als Änderungen. Code‑Review, Freigaben und Change‑Management gelten weiter.\n- Bevorzuge Tools, die mit sanitisierten Logs arbeiten können und Audit‑Trails für Compliance bieten.

Dokumentation und Wissensaustausch: weniger Unterbrechungen und Übergaben

Anforderungen früh klären

Nutzen Sie den Planungsmodus, um Umfang und Abnahmekriterien zu entwerfen, die Ihr Team prüfen kann.

Gute Dokumentation ist eine der günstigsten Möglichkeiten, Engineering‑Reibung zu reduzieren – dennoch fällt sie bei engen Zeitplänen oft zuerst hinten runter. KI‑Tools helfen, Dokumentation von einer „später“ Aufgabe in einen leichten, wiederholbaren Teil der täglichen Arbeit zu verwandeln.

Was KI beschleunigen kann (ohne Ownership zu ersetzen)

Teams sehen oft schnelle Erfolge bei Dokumentation mit klaren Mustern:\n\n- API‑Docs: Endpunktbeschreibungen, Request/Response‑Beispiele und Fehler‑Tabellen aus Specs oder Codekommentaren generieren.\n- Runbooks: Schritt‑für‑Schritt Incident‑Playbooks aus vergangenen Tickets und Postmortems entwerfen.\n- Changelogs und Release‑Notes: Gemergte PRs in kunden‑ und intern‑geeignete Versionen zusammenfassen.\n- Onboarding‑Guides: „Erste Woche“ Checklisten, Service‑Übersichten und Glossare aus Repo‑Struktur und existierenden Docs erstellen.

Der Schlüssel ist, dass KI einen starken ersten Entwurf liefert; Menschen bestätigen, was stimmt, was sicher geteilt werden darf und was wichtig ist.

Weniger Unterbrechungen, weniger Engpässe

Wenn Docs durchsuchbar und aktuell sind, muss das Team weniger häufig wiederholte Fragen beantworten wie „Wo ist die Config?“ oder „Wie starte ich das lokal?“. Das reduziert Kontextwechsel, schützt Fokuszeit und verhindert, dass Wissen bei einer einzelnen „Go‑to“ Person stecken bleibt.

Gut gepflegte Docs verkleinern außerdem Übergaben: neue Kolleg:innen, QA, Support und nicht‑technische Stakeholder können Antworten selbst finden statt auf eine Entwickler:in zu warten.

Ein praktischer Workflow, der bleibt

Ein einfaches Muster funktioniert für viele Teams:\n\n1. Doc‑Updates aus PRs generieren (Zusammenfassung + was sich geändert hat + wie zu testen)\n2. Menschliche Bearbeitung & Verifikation (Genauigkeit, Sicherheit, Zielgruppentauglichkeit)\n3. Docs versionieren im Repo neben dem Code, damit Änderungen reviewed und zusammen veröffentlicht werden

Verständlichkeit für nicht‑technische Leser

KI kann dichte Notizen in klarere Sprache umschreiben, konsistente Überschriften ergänzen und Struktur standardisieren. Das macht Docs über Engineering hinaus nutzbar – ohne Entwickler zu professionellen Autoren machen zu müssen.

ROI messen: Einsparungen ohne Spekulation quantifizieren

ROI wird schwammig, wenn du nur fragst „Haben wir schneller geliefert?“. Besser ist es, die konkreten Kostentreiber zu bewerten, die KI berührt, und dann eine Baseline mit einem „mit‑KI“ Lauf zu vergleichen.

Mappe deine echten Kostentreiber

Starte damit, die Buckets aufzuschreiben, die für dein Team wirklich bewegen:\n\n- Engineering‑Stunden: bauen, reviewen, testen, fixen, nacharbeiten.\n- Cloud‑Kosten: laufende Umgebungen, langsame Pipelines, wiederholte Testläufe.\n- Tool‑Abos: KI‑Seats, Test‑Tools, Monitoring, Design‑Tools.\n- Support‑Last: Incident‑Response, Bug‑Triage, Kundentickets.\n- Verzögerungskosten: verschobener Umsatz, Vertragsstrafen, Opportunitätskosten.

Eine einfache Baseline vs. mit‑KI Schätzung

Wähle ein Feature oder einen Sprint und zerlege die Zeit in Phasen. Miss dann für jede Phase zwei Werte: durchschnittliche Stunden ohne KI vs. mit KI, plus neue Tool‑Kosten.

Eine leichte Formel:\n

\nSavings = (Hours_saved × Blended_hourly_rate) + Cloud_savings + Support_savings − Tool_cost\nROI % = Savings / Tool_cost × 100\n

Du brauchst kein perfektes Tracking – nutze Zeiterfassung, PR‑Cycle‑Time, Anzahl Review‑Runden, Flake‑Rate bei Tests und Lead Time to Deploy als Proxy‑Metriken.

Unterschätze nicht den „Risikokosten“ Anteil

KI kann auch Kosten erzeugen, wenn sie nicht gemanagt wird: Sicherheits‑Exposition, Lizenz/IP‑Probleme, Compliance‑Lücken oder geringere Codequalität. Schätze diese als Erwartungskosten:\n\n- Risk Cost = Probability × Impact (z. B. Nacharbeit nach einem Security‑Finding, Audit‑Remediation‑Zeit).

Klein anfangen, dann skalieren

Beginne mit einem Workflow (z. B. Testgenerierung oder Anforderungsklärung). Führe ihn 2–4 Wochen aus, dokumentiere Vorher/Nachher‑Metriken und skaliere erst danach. So wird KI‑Adoption zu einem messbaren Verbesserungszyklus, nicht zu einer Glaubensfrage.

Risiken und Leitplanken: Sicherheit, Qualität und Compliance

KI kann viel lästige Arbeit abnehmen, bringt aber auch neue Fehlerquellen mit. Behandle KI‑Output wie Autocomplete: nützlich zur Beschleunigung, nicht als Quelle der Wahrheit.

Zentrale Risiken

Erstens: falsche oder unvollständige Outputs. Modelle können plausibel klingen, aber Edge‑Cases auslassen, APIs erfinden oder Code erzeugen, der nur den Happy Path besteht und in Produktion versagt.

Zweitens: Sicherheitslecks. Secrets, Kundendaten, Incident‑Logs oder proprietärer Code in ungeprüfte Tools zu geben, kann unbeabsichtigte Exposition verursachen. Außerdem besteht das Risiko, unsichere Code‑Patterns zu generieren (schwache Auth, unsichere Deserialisierung, injection‑anfällige Queries).

Drittens: Lizenz/IP‑Sorgen. Generierter Code kann bestehenden urheberrechtlich geschützten Snippets ähneln oder Abhängigkeiten mit inkompatiblen Lizenzen einführen, wenn Entwickler blind kopieren.

Viertens: voreingenommene oder inkonsistente Entscheidungen. KI kann Priorisierung, Formulierungen oder Bewertungen in einer Weise beeinflussen, die unbeabsichtigt Nutzer ausschließt oder interne Richtlinien verletzt.

Praktische Schutzmaßnahmen, die Geschwindigkeit erhalten

Mache menschliche Reviewpflicht zur Regel: erfordere Code‑Review für KI‑generierte Änderungen und bitte Reviewer, auf Security, Fehlerbehandlung und Tests zu achten – nicht nur auf Stil.

Führe leichte Policy‑ und Zugriffskontrollen ein: zugelassene Tools, SSO, rollenbasierte Rechte und klare Regeln, welche Daten geteilt werden dürfen.

Halte Audit‑Trails: logge Prompts und Outputs in zugelassenen Umgebungen, wenn möglich, und dokumentiere, wann KI für Anforderungen, Code oder Tests verwendet wurde.

Datenhandhabung Basics

Vermeide es, sensitive Daten (PII, Credentials, Produktionslogs, Kundenverträge) in allgemeine KI‑Tools zu senden. Bevorzuge zugelassene Umgebungen, Redaction und synthetische Beispiele.

Fazit

KI‑Outputs sind Vorschläge, keine Garantien. Mit Leitplanken – Review, Policy, Zugriffskontrolle und Nachvollziehbarkeit – kannst du Geschwindigkeit gewinnen, ohne Security, Qualität oder Compliance zu opfern.

Ein praktischer Adoption‑Fahrplan für Teams jeder Größe

KI‑Tools erfolgreich einzuführen funktioniert am besten, wenn du es wie jede Prozessänderung behandelst: klein starten, erfolgreiche Praktiken standardisieren und mit klaren Leitplanken ausrollen. Ziel ist nicht „KI überall einsetzen“, sondern vermeidbares Hin‑und‑Her, Nacharbeit und Warten zu eliminieren.

Phase 1: Pilot (1–2 Wochen)

Wähle ein Team und einen Workflow mit niedrigem Risiko und sichtbaren Zeiteinsparungen (z. B. User Stories schreiben, Testfälle generieren, ein kleines Modul refactoren). Halte den Scope eng und vergleiche mit deiner normalen Baseline.

Phase 2: Standards (leichtgewichtig, nicht bürokratisch)

Schreibe auf, wie „guter KI‑Einsatz“ für dein Team aussieht.\n\n- Prompt‑Templates: kurze, wiederverwendbare Prompts für übliche Aufgaben (Anforderungsklärung, Code‑Review‑Notizen, Testplan‑Entwürfe).\n- Review‑Checklist: was Menschen prüfen müssen (Korrektheit, Security, Edge‑Cases, Übereinstimmung mit Anforderungen).\n- Do/Don’t Liste:\n - Do: Kontext, Einschränkungen, Akzeptanzkriterien und Beispiele liefern.\n - Don’t: Secrets, Produktions‑Credentials oder proprietäre Daten, die nicht geteilt werden dürfen.

Phase 3: Training (2–4 kurze Sessions)

Lehre, wie man bessere Fragen stellt und wie Outputs validiert werden. Fokussiere auf praktische Szenarien: „Verwandle eine vage Anforderung in testbare Akzeptanzkriterien“ oder „Generiere einen Migrationsplan und prüfe Risiken".

Phase 4: Automatisierung (wo sich Wiederholung auszahlt)

Nachdem das Team dem Workflow vertraut, automatisiere repetitive Teile: PR‑Beschreibungsvorlagen, Test‑Scaffolding, Release‑Notes und Ticket‑Triage. Behalte einen menschlichen Genehmigungsschritt für alles, was shipped wird.

Wenn du Plattformen evaluierst, achte darauf, ob sie sichere Iterationsfeatures unterstützen (z. B. Planungsmodus, Snapshots, Rollback) und praktische Adoptionsoptionen (z. B. Export von Source). In diesem Bereich ist Koder.ai so konzipiert, dass es sich in vorhandene Engineering‑Erwartungen einfügt: schnell bewegen, aber Kontrolle behalten.

Phase 5: Kontinuierliche Verbesserung

Überprüfe Templates und Regeln monatlich. Entferne Prompts, die nicht helfen, und erweitere Standards nur, wenn wiederkehrende Fehler auftreten.

Metriken, damit ROI keine Spekulation bleibt

Verfolge einige Indikatoren konsistent:\n\n- Cycle Time (Idee → deployed)\n- Review Time (PR offen → gemerged)\n- Defect Rate (entwichene Bugs + in QA gefundene Bugs)\n- Rework % (Tickets wieder geöffnet, Churn, wiederholte Änderungen)\n- Teamzufriedenheit (kurze Pulsumfrage)

Checkliste für dein nächstes Projekt

Wenn du Erkenntnisse aus deinem Pilot veröffentlichst, lohnt es sich oft, sie als internes Guidance‑Dokument oder als öffentliches Write‑up zu formalisieren – viele Teams finden, dass dokumentierte „Vorher/Nachher“‑Metriken AI‑Adoption von Experiment zu wiederholbarer Praxis wandeln. (Einige Plattformen, einschließlich Koder.ai, bieten zudem Programme an, mit denen Teams Credits für das Teilen praktischer Inhalte oder Empfehlungen verdienen können, was Tool‑Kosten in der Anfangsphase abfedern kann.)