17. Aug. 2025·8 Min

Warum KI-gestützte Workflows vorzeitige Abstraktion reduzieren

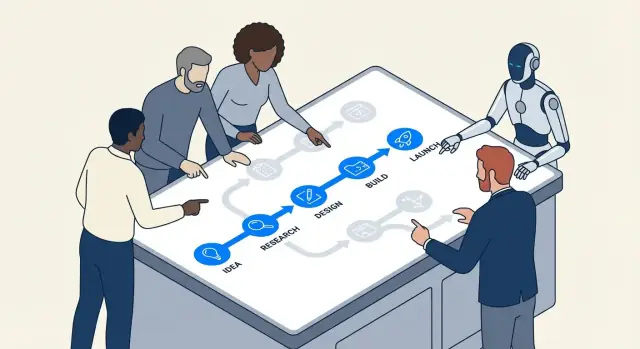

KI-gestützte Workflows treiben Teams zu konkreten Schritten, schnellem Feedback und messbaren Ergebnissen — und verringern so die Versuchung, zu früh zu abstrahieren oder zu über-engineeren.

Was wir unter vorzeitiger Abstraktion und Over-Engineering verstehen

Vorzeitige Abstraktion entsteht, wenn man eine „generelle Lösung“ baut, bevor man genug echte Fälle gesehen hat, um zu wissen, was verallgemeinert werden sollte.

Anstatt den einfachsten Code zu schreiben, der das heutige Problem löst, erfindet man ein Framework: zusätzliche Interfaces, Konfigurationssysteme, Erweiterungspunkte oder wiederverwendbare Module — weil man annimmt, man werde sie später brauchen.

Over-Engineering ist die übergeordnete Gewohnheit dahinter. Es bedeutet, Komplexität hinzuzufügen, die aktuell ihre Kosten nicht wieder einspielt: zusätzliche Schichten, Muster, Services oder Optionen, die jetzt nicht klar Kosten oder Risiken reduzieren.

Einfache Beispiele

Wenn euer Produkt einen einzigen Tarif hat und ihr trotzdem eine Multi-Tenant-Preismaschine „für den Fall“ baut, ist das vorzeitige Abstraktion.

Wenn eine Funktion durch eine einzige, einfache Funktion gelöst werden könnte, ihr sie aber in sechs Klassen mit Factories und Registries aufspaltet, um sie „erweiterbar“ zu machen, ist das Over-Engineering.

Warum es früh in Projekten auftaucht

Diese Gewohnheiten erscheinen oft am Anfang, weil frühe Projekte voller Unsicherheit sind:

- Angst vor Nacharbeit: Teams befürchten, dass eine einfache Lösung später komplett neu geschrieben werden muss.

- Unklare Anforderungen: Wenn niemand genau weiß, was das Produkt werden soll, ist die Versuchung groß, ein flexibles Skelett zu bauen, das „alles handeln“ kann.

- Sozialer Druck: Entwickler wollen oft vorausschauen und „es richtig machen“, selbst wenn das „Richtig“ noch nicht bestimmbar ist.

Das Problem ist: „flexibel“ heißt oft „schwerer zu ändern“. Zusätzliche Schichten können alltägliche Änderungen verlangsamen, Debugging erschweren und das Onboarding schmerzhafter machen. Die Komplexitätskosten zahlt man sofort — der Nutzen bleibt womöglich aus.

Wo KI reinpasst (und wo nicht)

KI-gestützte Workflows können Teams dazu bringen, bei konkreten Schritten zu bleiben — indem sie Prototyping beschleunigen, schnell Beispiele liefern und Annahmen testbar machen. Das kann die Ängste reduzieren, die spekulatives Design antreiben.

Aber KI ersetzt nicht das technische Urteilsvermögen. Sie kann auf Abruf clevere Architekturen und Abstraktionen generieren. Eure Aufgabe bleibt: Was ist das Einfachste, das heute funktioniert, und welche Evidenz rechtfertigt, morgen Struktur hinzuzufügen?

Tools wie Koder.ai sind hier besonders effektiv, weil sie den Weg vom Chat-Prompt zu einem lauffähigen Abschnitt einer echten App (Web, Backend oder Mobile) vereinfachen — so können Teams validieren, was nötig ist, bevor sie „zukunftssicher“ gestalten.

Wie KI-Workflows Teams zu konkreterem Arbeiten drängen

KI-unterstützte Entwicklung beginnt tendenziell mit etwas Greifbarem: einem spezifischen Bug, einer kleinen Funktion, einer Datenumwandlung, einem UI-Screen. Diese Einfärbung ist wichtig. Wenn der Workflow mit „das ist genau das, was wir brauchen“ startet, sind Teams weniger geneigt, eine generalisierte Architektur zu erfinden, bevor sie das Problem wirklich verstanden haben.

Konkrete Prompts erzeugen konkreten Code

Die meisten KI-Tools antworten am besten, wenn ihr Spezifika liefert: Eingaben, Ausgaben, Einschränkungen und ein Beispiel. Ein Prompt wie „design a flexible notification system“ ist vage, also füllt das Modell oft die Lücken mit zusätzlichen Schichten — Interfaces, Factories, Konfiguration — weil es die echten Grenzen nicht sehen kann.

Ist der Prompt hingegen geerdet, wird die Ausgabe geerdet:

- Input: „Given these order statuses…“

- Output: „Return the user-facing message and CTA…“

- Constraints: „Must be fast; no database call; needs i18n…“

- Examples: „For

PENDING_PAYMENTshow …“

Das pusht Teams natürlich dazu, einen engen Ausschnitt zu implementieren, der End-to-End funktioniert. Sobald ihr das ausführen, reviewen und zeigen könnt, operiert ihr in der Realität statt in der Spekulation.

„Erst zum Laufen bringen“ wird zum Standard

KI-Pair-Programming macht Iteration billig. Wenn eine erste Version leicht unordentlich, aber korrekt ist, ist der nächste Schritt meist „refactor this“ statt „ein System für alle zukünftigen Fälle entwerfen“. Diese Reihenfolge — erst lauffähiger Code, dann Verfeinerung — reduziert den Impuls, Abstraktionen zu bauen, die ihre Komplexität nicht verdient haben.

In der Praxis entwickeln Teams einen Rhythmus:

- Fordere eine minimale Implementierung an.\

- Teste sie an realen Beispielen.\

- Passe an, basierend auf dem, was bricht oder sich unhandlich anfühlt.\

- Extrahiere erst dann Helfer, Module oder Patterns.

Spezifizität offenbart fehlende Anforderungen früh

Prompts zwingen euch zu sagen, was ihr wirklich meint. Wenn ihr Eingaben/Ausgaben nicht klar definieren könnt, ist das ein Signal, dass ihr noch nicht bereit seid zu abstrahieren — ihr entdeckt noch Anforderungen. KI-Tools belohnen Klarheit und trainieren Teams subtil, zuerst zu klären und später zu verallgemeinern.

Kurze Feedback‑Schleifen reduzieren spekulatives Design

Schnelles Feedback verändert, was „gutes Engineering“ bedeutet. Wenn ihr eine Idee in Minuten ausprobieren könnt, wirkt spekulative Architektur nicht mehr wie ein beruhigendes Sicherheitsnetz, sondern wie ein zu vermeidender Kostenpunkt.

Die Schleife: entwerfen → ausführen → inspizieren → anpassen

KI-Workflows komprimieren den Zyklus:

- Entwerfen: bitte die Assistenz um einen kleinen, lauffähigen Ausschnitt (ein Script, einen Handler, eine Query)\

- Ausführen: führe ihn sofort mit realen Eingaben aus\

- Inspizieren: schaue auf Ausgaben, Logs, Randfälle und wie es fehlschlägt\

- Anpassen: verfeinere Code und Anforderungen gleichzeitig

Diese Schleife belohnt konkreten Fortschritt. Statt zu debattieren „wir brauchen ein Plug-in-System“ oder „dies muss 12 Datenquellen unterstützen“, sieht das Team, was das aktuelle Problem tatsächlich verlangt.

Warum Geschwindigkeit spekulative Architektur reduziert

Vorzeitige Abstraktion entsteht oft, wenn Teams Angst vor Änderungen haben: Sind Änderungen teuer, versucht man die Zukunft vorherzusagen und dafür zu designen. Mit kurzen Schleifen wird Change billig. Das kehrt die Anreize um:

- Du kannst Generalisierung aufschieben, bis wiederkehrende Arbeit ihre Notwendigkeit zeigt.\

- Du entdeckst echte Einschränkungen (Performance, Datenform, Nutzerverhalten) früh.\

- Du hörst auf, „für den Fall“ zu bauen, weil du „just in time“ iterieren kannst.

Ein einfaches Beispiel: Endpoint vor Framework

Angenommen, ihr fügt eine interne „Export nach CSV“-Funktion hinzu. Der über-engineerte Pfad beginnt mit dem Entwurf eines generischen Export-Frameworks, mehreren Formaten, Job-Queues und Konfigurationsebenen.

Ein schneller-Loop-Pfad ist kleiner: erzeugt einen einzelnen /exports/orders.csv Endpoint (oder ein Einmal-Skript), führt ihn gegen Staging-Daten aus und inspiziert Dateigröße, Laufzeit und fehlende Felder. Wenn ihr nach zwei oder drei Exports wiederkehrende Muster seht — gleiche Pagination-Logik, gemeinsam genutzte Filter, gemeinsame Header — verdient eine Abstraktion ihren Platz, weil sie auf Evidenz basiert, nicht auf Vermutungen.

Inkrementelle Änderungen lassen Abstraktionen sich beweisen

Inkrementelle Lieferung verändert die Ökonomie des Designs. Wenn ihr in kleinen Stücken ausliefert, muss jede „nice-to-have“-Schicht zeigen, dass sie jetzt hilft — nicht in einer erdachten Zukunft. Hier reduzieren KI-Workflows stillschweigend vorzeitige Abstraktion: KI ist gut im Vorschlagen von Strukturen, aber diese Strukturen sind am einfachsten zu validieren, wenn der Scope klein ist.

Kleiner Scope macht KI-Vorschläge testbar

Wenn ihr die Assistenz bittet, ein einzelnes Modul zu refactoren oder einen neuen Endpoint hinzuzufügen, könnt ihr schnell prüfen, ob die Abstraktion tatsächlich Klarheit schafft, Duplikation reduziert oder die nächste Änderung erleichtert. Bei einem kleinen Diff ist das Feedback unmittelbar: Tests bestehen oder nicht, der Code liest sich besser oder schlechter, und das Feature funktioniert oder eben nicht.

Bei großem Scope können KI-Vorschläge plausibel wirken, ohne tatsächlich nützlich zu sein. Man nimmt vielleicht ein generalisiertes Framework an, weil es „sauber aussieht“, nur um später zu entdecken, dass es reale Edge-Cases verkompliziert.

Kleine Komponenten zeigen, was zu behalten ist (und was gelöscht werden kann)

Inkrementelles Arbeiten ermutigt dazu, zuerst kleine, wegwerfbare Komponenten zu bauen — Helfer, Adapter, einfache Datenformen. Nach ein paar Iterationen wird klar, welche Teile in mehreren Features verwendet werden (wert zu behalten) und welche nur für ein einmaliges Experiment nötig waren (sicher zu löschen).

Abstraktionen werden so zu einem Zeugnis realer Wiederverwendung, nicht vorausgesagter Wiederverwendung.

Inkrementelle Lieferung senkt Refactor-Risiko

Wenn Änderungen kontinuierlich deployed werden, ist Refactoring weniger beängstigend. Du musst nicht „von Anfang an alles richtig machen“, weil du das Design mit der Zeit entwickeln kannst. Wenn ein Pattern sich wirklich bewährt und wiederkehrende Arbeit über mehrere Inkremente spart, ist das Extrahieren in eine Abstraktion eine risikoarme, gut begründete Entscheidung.

Diese Denkweise kehrt die Default‑Einstellung um: baue zuerst die einfachste Version, abstrahiere erst, wenn der nächste inkrementelle Schritt klar davon profitiert.

Einfaches Experimentieren begünstigt Einfachheit gegenüber „großem Design"

Flexibel bleiben, ohne zu überentwickeln

Beginne auf Koder.ai und exportiere den Quellcode, wenn du volle Kontrolle willst.

KI-Workflows machen Experimente so billig, dass „ein großes System bauen“ nicht mehr der Standard ist. Wenn ein Team mehrere Ansätze in einer einzigen Nachmittags-Session generieren, anpassen und erneut ausführen kann, lernt es leichter, was tatsächlich funktioniert, statt vorherzusagen, was funktionieren könnte.

KI macht kleine Varianten fast kostenlos

Statt Tage in ein generalisiertes Architekturdesign zu investieren, können Teams die KI bitten, ein paar enge, konkrete Implementierungen zu erstellen:

- eine einfache Version, die den Happy Path gut abdeckt\

- eine Version, optimiert für Lesbarkeit und Wartbarkeit\

- eine Version, die nur eine zusätzliche Fähigkeit hinzufügt (z. B. ein zweites Eingabeformat)

Weil das Erstellen dieser Varianten schnell geht, kann das Team Trade-offs erkunden, ohne sich auf ein großes Design festzulegen. Ziel ist es nicht, alle Varianten zu shippen — sondern Evidenz zu sammeln.

Variantenvergleich belohnt natürliche Weise einfachere Lösungen

Wenn ihr zwei oder drei lauffähige Optionen nebeneinander legen könnt, wird Komplexität sichtbar. Die einfachere Variante erfüllt oft dieselben Anforderungen, hat weniger bewegliche Teile zum Debuggen und macht zukünftige Änderungen leichter, weil weniger versteckte Kopplungen existieren.

Über-engineerte Optionen rechtfertigen sich häufig mit hypothetischen Bedürfnissen. Der Variantenvergleich ist ein Gegenmittel: liefert die zusätzliche Abstraktion keine klaren, kurzfristigen Vorteile, wirkt sie wie Kosten.

Checkliste: Was messen beim Vergleich von Optionen

Wenn ihr leichte Experimente fahrt, einigt euch darauf, was „besser“ bedeutet. Eine praktische Checkliste:

- Time-to-first-working-result: Wie lange bis es grundlegende Szenarien besteht?\

- Implementierungskomplexität: Dateien/Module geändert, Anzahl neuer Konzepte und wie viele Regeln sich ein Teammitglied merken muss.\

- Änderungskosten: Wie schwer ist es, eine neue (wahrscheinliche) Anforderung hinzuzufügen?\

- Fehlermodi: Was bricht, wie schlimm und wie leicht ist das zu erkennen (klare Fehler vs. still falsche Ausgaben).\

- Betrieblicher Risiko: Neue Abhängigkeiten, Konfigurationsoberfläche, Orte, an denen sich Produktionsverhalten ändern kann.\

- Testbarkeit: Wie leicht lässt sich ein kleiner Satz Tests schreiben, der das Verhalten erklärt.

Wenn eine abstraktere Variante nicht bei mindestens einem oder zwei dieser Punkte gewinnt, ist die einfachste funktionierende Lösung meistens die richtige Entscheidung — fürs Erste.

KI hilft, Anforderungen zu klären, bevor ihr abstrahiert

Vorzeitige Abstraktion beginnt oft mit einem Satz wie: „Das könnten wir später brauchen.“ Das ist etwas anderes als: „Das brauchen wir jetzt.“ Das Erste ist eine Vermutung über zukünftige Variabilität; das Zweite ist eine heute verifizierbare Einschränkung.

KI-Workflows machen diesen Unterschied schwerer zu ignorieren, weil sie gut darin sind, verschwommene Gespräche in explizite Aussagen zu verwandeln, die ihr inspizieren könnt.

Unklarheiten in einen schriftlichen Vertrag verwandeln (ohne Überverpflichtung)

Wenn ein Feature-Request vage ist, neigen Teams dazu, vorzubeugen und ein allgemeines Framework zu bauen. Nutzt stattdessen KI, um schnell eine einseitige Anforderungssnapshot zu erstellen, die trennt, was real ist und was vorgestellt wird:

- Was wir wissen (aktuelle Einschränkungen): Zielnutzer, unterstützte Plattformen, Performance-Erwartungen, notwendige Integrationen.\

- Was wir annehmen: „Nutzer haben mehrere Accounts“, „wir unterstützen 10 Lokalisierungen“, „es wird Preisstufen geben“.\

- Was wir noch nicht wissen: Randfälle, rechtliche Einschränkungen, Skalierung, Migrationsanforderungen.

Diese einfache Trennung verändert die Engineering‑Konversation. Ihr hört auf, für eine unbekannte Zukunft zu designen, und beginnt, für eine bekannte Gegenwart zu bauen — während ihr eine sichtbare Liste der Unsicherheiten zum späteren Überprüfen behaltet.

Koder.ai’s Planning Mode passt hier gut: ihr könnt eine vage Anforderung in einen konkreten Plan (Schritte, Datenmodell, Endpunkte, UI‑Zustände) verwandeln, bevor ihr Umsetzung generiert — ohne euch auf eine weitläufige Architektur festzulegen.

Eine leichte „zukunftsfreundliche“ Vorgehensweise

Ihr könnt trotzdem Raum für Entwicklung lassen, ohne eine tiefe Abstraktionsschicht zu bauen. Bevorzugt Mechanismen, die leicht zu ändern oder zu entfernen sind:

- Feature Flags, um eine enge Version auszuliefern und aus realer Nutzung zu lernen.\

- Konfiguration für variierende Werte (Timeouts, Schwellenwerte, Texte) statt polymorpher Systeme.\

- Kleine Erweiterungspunkte (ein Interface, ein Hook, ein Event) nur dort, wo Variation bereits wahrscheinlich ist.

Eine gute Regel: Wenn ihr die nächsten zwei konkreten Variationen nicht benennen könnt, baut das Framework nicht. Schreibt die vermuteten Variationen als „Unbekannte“ auf, liefert den einfachsten funktionierenden Pfad und lasst echtes Feedback die Abstraktion später rechtfertigen.

Wenn ihr diese Gewohnheit formalisieren wollt, dokumentiert die Notizen in eurem PR‑Template oder in einem internen „Assumptions“-Dokument, verlinkt aus dem Ticket (z. B. /blog/engineering-assumptions-checklist).

Tests und Beispiele entlarven unnötige Generalisierung

Ein häufiger Grund für Over-Engineering ist, dass Teams für vorgestellte Szenarien designen. Tests und konkrete Beispiele kehren das um: sie zwingen euch, reale Eingaben, reale Ausgaben und reale Fehlermodi zu beschreiben. Sobald das stehen, erscheinen „generische“ Abstraktionen oft weniger nützlich — und teurer — als eine kleine, klare Implementierung.

Wie KI Randfälle aufdeckt (ohne Architektur zu erfinden)

Wenn ihr die KI bittet, beim Schreiben von Tests zu helfen, schiebt sie euch natürlich in Richtung Spezifizität. Statt „mach das flexibel“ erhaltet ihr Fragen wie: Was gibt diese Funktion zurück, wenn die Liste leer ist? Was ist der maximal erlaubte Wert? Wie repräsentieren wir einen ungültigen Zustand?

Dieses Fragen ist wertvoll, weil es Randfälle früh findet, während ihr noch entscheidet, was das Feature wirklich braucht. Sind diese Randfälle selten oder außerhalb des Scopes, könnt ihr sie dokumentieren und weitergehen — ohne eine Abstraktion „für den Fall“ zu bauen.

Tests zuerst zeigen, ob eine Abstraktion nötig ist

Abstraktionen verdienen ihren Platz, wenn mehrere Tests dieselbe Setup- oder Verhaltenslogik teilen. Wenn eure Test-Suite nur ein oder zwei konkrete Szenarien hat, ein Framework oder Plugin‑System zu bauen, ist meist ein Zeichen dafür, dass ihr für hypothetische Zukunft optimiert.

Eine einfache Faustregel: Wenn ihr nicht mindestens drei verschiedene Verhaltensweisen ausdrücken könnt, die dieselbe generalisierte Schnittstelle benötigen, ist eure Abstraktion wahrscheinlich verfrüht.

Mini‑Template für praktische Testfälle

Benutzt diese leichte Struktur, bevor ihr zur „Generalisierung“ greift:

- Happy Path: Typische Eingabe → erwartete Ausgabe.\

- Boundary: Minimal-/Maximalwerte, leere Sammlungen, Limits (z. B. 0, 1, 1000).\

- Failure: Ungültige Eingabe, fehlende Abhängigkeiten, Timeouts, Berechtigungsfehler → erwarteter Fehler oder Fallback.

Sobald diese Tests geschrieben sind, möchte der Code oft einfach sein. Wenn sich über mehrere Tests Duplikation zeigt, ist das euer Signal zu refactoren — nicht euer Ausgangspunkt.

Sichtbare Wartungskosten entmutigen Over-Engineering

Für den nächsten Schritt entwerfen

Erstelle eine React‑Ansicht für den Hauptablauf und erweitere nur, wenn die Realität es verlangt.

Over-Engineering versteckt sich oft hinter guten Absichten: „Das werden wir später brauchen.“ Das Problem ist, Abstraktionen erzeugen laufende Kosten, die im Initialticket nicht sichtbar sind.

Die echte Rechnung für eine Abstraktion

Jede neue Schicht, die ihr einführt, erzeugt in der Regel wiederkehrende Arbeit:

- API‑Oberfläche: mehr Methoden, Parameter und Edge‑Cases, die zu unterstützen sind (und abwärtskompatibel bleiben müssen).\

- Dokumentation und Beispiele: Beim Onboarden müsst ihr die Abstraktion erklären, nicht nur das Feature.\

- Migrationen: Sobald anderer Code von der verallgemeinerten Schnittstelle abhängt, erfordern Änderungen Adapter, Deprecations und Release-Notes.\

- Testmatrix: „Generischer“ Code weitet Szenarien aus — mehrere Implementierungen, mehr Mocks, mehr Integrationstests.

KI-Workflows machen diese Kosten schwerer zu ignorieren, weil sie schnell aufzählen können, worauf ihr euch einlasst.

KI nutzen, um Komplexität zu schätzen: Zähle die beweglichen Teile

Ein praktischer Prompt ist: „Liste die beweglichen Teile und Abhängigkeiten auf, die dieses Design einführt.“ Ein guter KI-Assistent kann den Plan in konkrete Punkte zerlegen wie:

- neue Module/Packages\

- öffentliche Interfaces und Versionierungs‑Erwartungen\

- Datenbankschema‑Änderungen und Migrationsschritte\

- Cross‑Service‑Aufrufe und Fehlermodi\

- neue Konfigurationsflags, Berechtigungen oder Queues

Diese Liste neben einer einfacheren, direkten Implementierung zu sehen, verwandelt „saubere Architektur“-Argumente in klare Trade-offs: Wollt ihr acht neue Konzepte pflegen, um eine Duplikation zu vermeiden, die möglicherweise nie auftritt?

Ein „Komplexitätsbudget“, um Arbeit ehrlich zu halten

Eine leichte Policy: begrenzt die Anzahl neuer Konzepte pro Feature. Zum Beispiel erlaubt maximal:

- 1 neue öffentliche API\

- 1 neue geteilte Abstraktion (Interface/Base Class)\

- 1 neues Datenmodell/Tabelle

Wenn das Feature das Budget überschreitet, verlangt eine Rechtfertigung: welche zukünftige Änderung ermöglicht das, und welche Evidenz habt ihr, dass sie unmittelbar bevorsteht? Teams, die KI nutzen, um diese Rechtfertigung zu entwerfen (und Wartungsaufgaben vorherzusagen), neigen dazu, kleinere, reversible Schritte zu wählen — weil die laufenden Kosten sichtbar sind, bevor der Code shipped.

Wenn KI euch in die falsche Richtung drängt (und wie man das verhindert)

KI-Workflows treiben Teams oft zu kleinen, testbaren Schritten — aber sie können auch das Gegenteil bewirken. Da KI gut darin ist, „komplette“ Lösungen schnell zu produzieren, tendiert sie dazu, vertraute Muster, zusätzliche Struktur oder Scaffolding zu generieren, das ihr nicht angefragt habt. Das Ergebnis kann mehr Code sein, früher, als nötig.

Wie KI unbeabsichtigt Over‑Engineering fördert

Ein Modell wird (durch menschliche Wahrnehmung) oft dafür belohnt, gründlich zu klingen. Das kann sich in zusätzlichen Schichten, mehr Dateien und generalisierten Designs niederschlagen, die professionell wirken, aber kein aktuelles Problem lösen.

Warnzeichen sind unter anderem:

- Neue Abstraktionen ohne konkreten Anwendungsfall (z. B. „für zukünftige Flexibilität“).\

- Extra Schichten: service → manager → adapter → factory, wenn eine Funktion ausreicht.\

- Generische Interfaces mit nur einer Implementierung.\

- Plugin‑Systeme, Event‑Busse oder Dependency‑Injection‑Setups, die früh eingeführt werden.\

- Ein „Framework im Framework“, um etwas zu standardisieren, das ihr noch nicht wiederholt habt.

Maßnahmen, die KI‑Output geerdet halten

Behandelt KI wie schnelle Hände, nicht wie ein Architektur‑Gremium. Einige Einschränkungen helfen enorm:

- Beschränkt Prompts auf die Gegenwart. Fordert die kleinste Änderung an, die heutige Anforderungen erfüllt, und verbietet neue Patterns explizit, sofern sie nicht nötig sind.\

- Fordert reale Beispiele. Bevor ihr eine Abstraktion akzeptiert, verlangt 2–3 konkrete Call‑Sites (oder Nutzerflüsse) und bestätigt, dass die Abstraktion diese einfacher macht.\

- Begrenzt Architekturänderungen pro Iteration. Erlaubt nur eine strukturelle Änderung pro PR (z. B. „führe ein neues Modul ein“ oder „keine neuen Schichten in diesem PR“).\

- Review auf Löschbarkeit. Wenn das Entfernen der neuen Schicht das Verhalten kaum beeinträchtigt, hat sie sich wahrscheinlich nicht verdient.

Eine einfache Regel: lasst die KI nicht generalisieren, bis euer Codebase wiederkehrenden Schmerz zeigt.

Ein praktisches Entscheidungs‑Framework: Erst bauen, dann abstrahieren

Schnelle Feedback‑Schleifen

Stelle früh bereit, damit echte Nutzung statt Vermutungen entscheidet, was abstrahiert werden sollte.

KI macht es billig, Code zu generieren, zu refactoren und Alternativen zu probieren. Das ist ein Geschenk — sofern ihr es nutzt, um Abstraktion aufzuschieben, bis sie verdient ist.

Schritt 1: Beginnt konkret (optimiere fürs Lernen)

Startet mit der simpelsten Version, die das heutige Problem für einen „Happy Path“ löst. Nennt Dinge direkt nach ihrer Aufgabe (nicht nach dem, was sie später tun könnten) und haltet APIs eng. Wenn ihr unsicher seid, ob ein Parameter, Interface oder Plugin-System nötig ist, liefert zunächst ohne.

Eine hilfreiche Regel: bevorzuge Duplikation gegenüber Spekulation. Duplizierter Code ist sichtbar und leicht zu löschen; spekulative Generalität versteckt Komplexität in Indirektion.

Schritt 2: Extrahiere später (optimiere für Stabilität)

Sobald das Feature genutzt wird und sich verändert, refactort mit Evidenz. Mit KI-Unterstützung könnt ihr hier schnell vorgehen: fragt sie, eine Extraktion vorzuschlagen, besteht aber auf einem minimalen Diff und lesbaren Namen.

Wenn euer Tooling es unterstützt, nutzt Safety‑Nets, die Refactors risikoarm machen. Zum Beispiel machen Koder.ai‑Snapshots und Rollbacks Experimente mit Refactors einfacher, weil ihr schnell revertieren könnt, falls das „sauberere“ Design in der Praxis schlechter ist.

Wann Abstraktion gerechtfertigt ist (kurze Checkliste)

Eine Abstraktion hat sich verdient, wenn die meisten dieser Punkte zutreffen:

- Wiederkehrende Logik: dasselbe Verhalten existiert an 2–3 Stellen, und Updates erforderten bereits mehrere Änderungen.\

- Bewiesene Variabilität: ihr habt reale Variationen in Produktion oder validierten Prototypen gesehen (nicht „wir könnten X irgendwann brauchen“).\

- Klare Verantwortung: eine Person/ein Team besitzt die Abstraktion, deren Docs und deren zukünftige Änderungen.\

- Stabile Grenze: die Input/Output‑Form blieb über mindestens ein paar Iterationen konsistent.\

- Nettoversimplifizierung: das Extrahieren reduziert die Gesamtmenge an Code und die kognitive Last, statt nur umzustrukturieren.

Ein einfacher Ritus: die „eine Woche später“ Review

Setzt eine Erinnerung eine Woche nach dem Launch eines Features:

- Öffnet den Diff erneut und listet, was sich seit Release geändert hat.\

- Identifiziert Copy‑Paste‑Edits oder wiederkehrende Bugs.\

- Entscheidet eines von drei Ergebnissen: konkret behalten, kleinen Helfer extrahieren, geteiltes Modul einführen.

Das hält die Default‑Haltung: erst bauen, dann verallgemeinern — nur wenn die Realität euch dazu zwingt.

Was zu messen ist, um Engineering schlank zu halten

Lean Engineering ist kein Gefühl — man kann es beobachten. KI‑Workflows erleichtern es, kleine Änderungen schnell zu liefern, aber ihr braucht ein paar Signale, um zu merken, wann das Team wieder in spekulatives Design abrutscht.

Eine kleine Metrik‑Auswahl, die Over‑Engineering früh auffängt

Verfolgt einige führende Indikatoren, die mit unnötiger Abstraktion korrelieren:

- Cycle Time: Zeit von „Beginn der Arbeit“ bis „gemerged und deployed“. Wenn die Cycle Time wächst, ohne dass der Scope steigt, bedeutet das oft zusätzliche Indirektion oder Zukunftsplanung.\

- Diff‑Größe: durchschnittliche Zeilenänderung (oder berührte Dateien) pro Änderung. Große Diffs sind schwerer zu reviewen und laden zu generalisierten Lösungen ein.\

- Anzahl eingeführter Konzepte: zähle neue Module/Services/Packages, neue Interfaces, neue Konfigurationsknöpfe, neue Framework‑Primitiven. Konzepte sind eine Steuer, die ihr dauerhaft zahlt.\

- Defektrate: Produktions‑Bugs oder Support‑Tickets pro Release. Abstraktionen können Edge‑Cases verbergen; steigende Defekte nach „Aufräumarbeiten“ sind ein Warnsignal.\

- Onboarding‑Zeit: wie lange braucht ein neuer Entwickler, um seine erste kleine Änderung zu shippen. Wenn Onboarding langsamer wird, optimiert das System eventuell für Eleganz statt Klarheit.

Perfektion ist nicht nötig — Trendlinien reichen. Reviewt diese wöchentlich oder pro Iteration und fragt: „Haben wir mehr Konzepte hinzugefügt, als das Produkt erforderte?"

Leichte Dokumentation, die mysteriöse Abstraktionen verhindert

Fordert eine kurze „Warum existiert das?“-Notiz, wann immer jemand eine neue Abstraktion einführt (neues Interface, Helfer‑Layer, interne Bibliothek etc.). Haltet es bei ein paar Zeilen im README oder als Kommentar nahe dem Einstiegspunkt:

- Welches konkrete Problem hat es heute gelöst?\

- Welche Alternativen wurden ausprobiert?\

- Was würde seine Löschung rechtfertigen?

Ein Aktionsplan zum Start

Pilotiert einen kleinen KI‑gestützten Workflow für ein Team über 2–4 Wochen: KI‑unterstützte Ticketaufteilung, KI‑assistierte Code‑Review‑Checklisten und KI‑generierte Testfälle.

Am Ende vergleicht ihr die oben genannten Metriken und macht eine kurze Retrospektive: behaltet, was Cycle Time und Onboarding verbessert hat; rollt zurück, was die Anzahl eingeführter Konzepte erhöht hat, ohne messbaren Produktnutzen.

Wenn ihr eine praktische Umgebung für dieses Experiment sucht, kann eine vibe‑coding Plattform wie Koder.ai helfen, diese kleinen, konkreten Abschnitte schnell in deploybare Apps zu verwandeln (mit Source‑Export, wenn nötig), und verstärkt so die Gewohnheit, die dieser Artikel empfiehlt: liefere etwas Reales, lerne und abstrahiere erst dann.