03. Nov. 2025·8 Min

Leslie Lamport und verteilte Systeme: Zeit, Reihenfolge, Korrektheit

Lernen Sie Lamports zentrale Konzepte verteilter Systeme — logische Uhren, Kausalität (happened‑before), Konsens und Korrektheit — und warum sie moderne Infrastruktur noch leiten.

Warum Lamport für moderne verteilte Systeme noch wichtig ist

Leslie Lamport ist einer der seltenen Forscher, deren „theoretische“ Arbeiten jedes Mal auftauchen, wenn man ein echtes System ausliefert. Wenn Sie jemals einen Datenbank-Cluster, eine Message-Queue, eine Workflow-Engine oder irgendetwas betrieben haben, das Anfragen wiederholt und Ausfälle übersteht, dann sind Sie in Problemen unterwegs, die Lamport benannt und gelöst hat.

Was seine Ideen dauerhaft macht, ist, dass sie nicht an eine bestimmte Technologie gebunden sind. Sie beschreiben die unbequemen Wahrheiten, die immer dann auftauchen, wenn mehrere Maschinen versuchen, wie ein einziges System zu handeln: Uhren weichen ab, Netze verzögern und verlieren Nachrichten, und Ausfälle sind normal — nicht außergewöhnlich.

Drei Themen, die sich durchziehen

Zeit: In einem verteilten System ist „Welche Uhrzeit ist es?“ keine einfache Frage. Physische Uhren driften, und die Reihenfolge, in der Ereignisse beobachtet werden, kann zwischen Maschinen variieren.

Ordnung: Sobald Sie einer einzelnen Uhr nicht mehr vertrauen können, brauchen Sie andere Wege, um darüber zu sprechen, welche Ereignisse zuerst stattgefunden haben — und wann Sie alle dazu zwingen müssen, dieselbe Sequenz einzuhalten.

Korrektheit: „Es funktioniert meistens“ ist kein Design. Lamport trieb das Feld zu präzisen Definitionen (Safety vs. Liveness) und zu Spezifikationen, über die man nachdenken kann, nicht nur testen.

Was Sie erwarten können (keine schwere Mathematik)

Wir konzentrieren uns auf Konzepte und Intuition: die Probleme, die minimalen Werkzeuge, mit denen man klar denken kann, und wie diese Werkzeuge praktische Entwürfe prägen.

Hier ist die Karte:

- Warum keine gemeinsame Uhr keine einzige, globale Ereignisgeschichte zulässt

- Wie Kausalität („happened-before“) zu logischen Uhren und Lamport-Timestamps führt

- Wann eine partielle Ordnung nicht ausreicht und Sie eine einzige Zeitleiste brauchen

- Wie Konsens und Paxos mit dem Aushandeln einer Reihenfolge zusammenhängen

- Warum State-Machine-Replication funktioniert, wenn die Reihenfolge geteilt wird

- Wie man über Korrektheit in Spezifikationen spricht — und wie Modellierungswerkzeuge wie TLA+ helfen

Das Kernproblem: Keine gemeinsame Uhr, keine einzige Realität

Ein System ist „verteilt“, wenn es aus mehreren Maschinen besteht, die über ein Netzwerk kooperieren, um eine Aufgabe zu erfüllen. Das klingt einfach, bis man zwei Fakten akzeptiert: Maschinen können unabhängig ausfallen (partielle Ausfälle), und das Netzwerk kann Nachrichten verzögern, verwerfen, duplizieren oder umordnen.

In einem Einzelprogramm auf einem Rechner können Sie normalerweise sagen, „was zuerst passiert ist“. In einem verteilten System können verschiedene Maschinen unterschiedliche Ereignisfolgen beobachten — und beide können aus ihrer lokalen Sicht korrekt sein.

Warum Sie einer globalen Uhr nicht vertrauen können

Es ist verlockend, Koordination durch das Zeitstempeln von allem zu lösen. Aber es gibt keine einzige Uhr, auf die Sie verlässlich über Maschinen hinweg bauen können:

- Die Hardware-Uhr jedes Servers driftet mit eigener Rate.

- Uhrensynchronisation (z. B. NTP) ist Best-Effort, keine Garantie.

- Virtualisierung, CPU-Last oder Pausen können Zeit springen oder anhalten lassen.

„Ereignis A geschah um 10:01:05.123" auf einem Host vergleicht sich also nicht zuverlässig mit „10:01:05.120" auf einem anderen.

Wie Verzögerungen die Realität durcheinanderbringen

Netzwerkverzögerungen können das, was Sie „gesehen“ zu haben glauben, umkehren. Ein Write kann zuerst gesendet, aber als zweites ankommen. Ein Retry kann nach dem Original eintreffen. Zwei Rechenzentren können dieselbe Anfrage in entgegengesetzter Reihenfolge verarbeiten.

Das macht Debugging besonders verwirrend: Logs von verschiedenen Maschinen können sich widersprechen, und "nach Zeitstempel sortiert" kann eine Geschichte erzeugen, die niemals tatsächlich passiert ist.

Reale Konsequenzen

Wenn Sie eine einzige Zeitleiste annehmen, die es nicht gibt, bekommen Sie konkrete Fehler:

- Doppelte Verarbeitung (z. B. eine Zahlung wird nach Retries zweimal belastet)

- Inkonsistenzen (zwei Nutzer beanspruchen „erfolgreich“ dasselbe letzte Objekt)

- Scheinbarer Datenverlust (ein später eintreffendes Update überschreibt ein neueres)

Lamports zentrale Einsicht beginnt hier: Wenn Sie Zeit nicht teilen können, müssen Sie über Ordnung anders denken.

Kausalität und die happened‑before‑Relation

Verteilte Programme bestehen aus Ereignissen: etwas, das an einem bestimmten Knoten (Prozess, Server oder Thread) passiert. Beispiele sind „eine Anfrage empfangen“, „eine Zeile geschrieben“ oder „eine Nachricht gesendet“. Eine Nachricht verbindet Knoten: ein Event ist das Senden, ein anderes das Empfangen.

Lamports Kernidee ist: In einem System ohne verlässliche gemeinsame Uhr ist das Verlässlichste, was Sie nachverfolgen können, Kausalität — also welche Ereignisse andere Ereignisse hätten beeinflussen können.

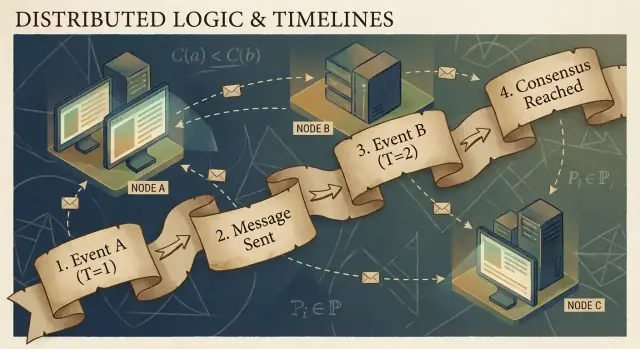

Die happened‑before‑Relation (→)

Lamport definierte eine einfache Regel namens happened-before, geschrieben als A → B (Ereignis A geschah vor Ereignis B):

- Gleicher Prozess: Wenn A und B im selben Prozess/Maschine passieren und A dort vor B beobachtet wird, dann gilt A → B.

- Nachrichtenreihenfolge: Wenn A „sende Nachricht m“ und B „empfange Nachricht m“ ist, dann gilt A → B.

- Transitivität: Wenn A → B und B → C, dann gilt A → C.

Diese Relation ergibt eine partielle Ordnung: sie sagt für einige Paare, welches zuerst war, aber nicht für alle.

Eine konkrete Geschichte: Nutzer → Anfrage → DB → Cache

Ein Nutzer klickt „Kaufen“. Der Klick löst eine Anfrage an einen API-Server aus (Ereignis A). Der Server schreibt eine Bestellzeile in die Datenbank (Ereignis B). Nachdem der Write abgeschlossen ist, veröffentlicht der Server eine „order created“-Nachricht (Ereignis C), und ein Cache-Service empfängt sie und aktualisiert einen Cache-Eintrag (Ereignis D).

Hier gilt A → B → C → D. Selbst wenn Uhren abweichen, erzeugen Nachrichtenaustausch und Programmstruktur echte kausale Verbindungen.

Was „konkurrierend“ wirklich bedeutet

Zwei Ereignisse sind konkurrent (concurrent), wenn keines das andere verursacht: nicht (A → B) und nicht (B → A). Konkurrenz bedeutet nicht „zur selben Zeit“ — es bedeutet „kein kausaler Pfad verbindet sie“. Deshalb können zwei Services jeweils behaupten, sie hätten „zuerst“ gehandelt, und beide können korrekt sein, sofern Sie keine Ordnungsregel hinzufügen.

Logische Uhren: Lamport‑Timestamps in einfachen Worten

Wenn Sie je versucht haben, „was passierte zuerst“ über mehrere Maschinen hinweg zu rekonstruieren, sind Sie auf das Grundproblem gestoßen: Rechner teilen keine perfekt synchronisierte Uhr. Lamports Workaround ist aufzuhören, perfekter Zeit nachzujagen, und stattdessen Ordnung zu verfolgen.

Die Idee: ein Zähler an jedes Ereignis hängen

Ein Lamport‑Timestamp ist einfach eine Zahl, die Sie jedem bedeutsamen Ereignis in einem Prozess anheften (Instanz, Knoten, Thread — je nachdem, wie Sie es wählen). Denken Sie an ihn als „Ereigniszähler“, der Ihnen eine konsistente Möglichkeit gibt zu sagen: „dieses Ereignis war vor jenem“, selbst wenn die Wand‑Uhr unzuverlässig ist.

Die zwei Regeln (und sie sind wirklich so einfach)

-

Lokal inkrementieren: Bevor Sie ein Ereignis protokollieren (z. B. „in DB geschrieben“, „Anfrage gesendet“, „Log-Eintrag angehängt“), erhöhen Sie Ihren lokalen Zähler.

-

Beim Empfangen max + 1: Wenn Sie eine Nachricht erhalten, die den Timestamp des Senders enthält, setzen Sie Ihren Zähler auf:

max(local_counter, received_counter) + 1

Dann stempeln Sie das Empfangsereignis mit diesem Wert.

Diese Regeln stellen sicher, dass Timestamps die Kausalität respektieren: Wenn Ereignis A B beeinflusst haben könnte (weil Information über Nachrichten geflossen ist), dann wird TS(A) kleiner sein als TS(B).

Was Lamport‑Timestamps können — und was nicht

Sie sagen etwas über kausale Reihenfolge:

- Wenn

TS(A) < TS(B), könnte A vor B passiert sein. - Wenn A B verursacht hat (direkt oder indirekt), dann ist notwendig

TS(A) < TS(B).

Sie sagen nichts über reale Zeit:

- Ein niedrigerer Timestamp heißt nicht „früher in Sekunden“.

- Zwei konkurrente Ereignisse können trotzdem unterschiedliche Timestamps haben, je nach Nachrichtenmuster.

Lamport‑Timestamps sind also großartig, um zu ordnen, nicht um Latenz zu messen oder zu fragen „um wieviel Uhr war das?".

Praktisches Beispiel: Logs über Dienste hinweg ordnen

Stellen Sie sich vor, Service A ruft Service B auf, und beide schreiben Audit‑Logs. Sie möchten eine einheitliche Log‑Ansicht, die Ursache und Wirkung erhält.

- Service A erhöht seinen Zähler, protokolliert „Zahlung gestartet“, sendet die Anfrage an B mit Timestamp 42.

- Service B empfängt die Anfrage mit 42, setzt seinen Zähler auf

max(local, 42) + 1, z. B. 43, und protokolliert „Karte validiert“. - B antwortet mit 44; A empfängt, erhöht auf 45, und protokolliert „Zahlung abgeschlossen".

Wenn Sie nun Logs von beiden Services aggregieren und nach (lamport_timestamp, service_id) sortieren, erhalten Sie eine stabile, erklärbare Timeline, die der tatsächlichen Kettenwirkung entspricht — selbst wenn Wanduhren gedriftet oder das Netzwerk verzögert war.

Von partieller Ordnung zur Totalorder: Wenn Sie eine einzige Zeitleiste brauchen

Kausalität liefert eine partielle Ordnung: manche Ereignisse sind klar „vor“ anderen (weil eine Nachricht oder Abhängigkeit sie verbindet), viele Ereignisse sind schlicht konkurrierend. Das ist kein Fehler — das ist die natürliche Form verteilter Realität.

Partielle Ordnung: für viele Fragen ausreichend

Wenn Sie debuggen wollen „was hätte dieses beeinflussen können?“ oder Regeln durchsetzen wie „eine Antwort muss einer Anfrage folgen“, dann ist die partielle Ordnung genau das Richtige. Sie müssen nur happened‑before‑Kanten respektieren; alles andere kann unabhängig behandelt werden.

Totalorder: nötig, wenn das System eine einzige Geschichte wählen muss

Manche Systeme kommen nicht mit „entweder Reihenfolge ist ok“ zurecht. Sie brauchen eine einzelne Sequenz von Operationen, insbesondere für:

- Schreibzugriffe auf ein geteiltes Objekt („Saldo setzen“, „Profil aktualisieren“, „an Log anhängen")

- Befehle, die überall identisch angewendet werden müssen (State‑Machine‑Replication)

- Konfliktauflösung, wo „last write wins" überall dieselbe Bedeutung haben muss

Ohne Totalorder können zwei Replikate lokal „korrekt“ sein, aber global auseinanderlaufen: eines wendet A dann B an, das andere B dann A, und das Ergebnis ist unterschiedlich.

Wie erzeugt man eine einzige Zeitleiste?

Sie führen einen Mechanismus ein, der Ordnung schafft:

- Ein Sequencer/Leader, der jeder Operation eine monoton wachsende Position zuweist.

- Oder Konsens (z. B. Paxos‑ähnliche Ansätze), sodass der Cluster sich auf den nächsten Logeintrag einigt, trotz Verzögerungen und Ausfällen.

Die unvermeidlichen Trade‑offs

Eine Totalorder ist mächtig, aber sie kostet:

- Latenz: Sie warten auf Koordination, bevor Sie committen.

- Durchsatz: Ein einzelnes geordnetes Log kann zum Flaschenhals werden.

- Verfügbarkeit bei Ausfällen: Wenn Sie nicht genug Knoten erreichen können, kann der Fortschritt pausieren, um Korrektheit zu schützen.

Die Designfrage ist einfach zu formulieren: Wenn Korrektheit eine gemeinsame Erzählung erfordert, zahlen Sie Koordinationskosten, um sie zu bekommen.

Konsens: Sich einigen angesichts von Verzögerung und Ausfall

Bestell-Demo erstellen

Verwandle deine Bestellideen in einen funktionierenden Go-Service und iteriere per einfachem Chat.

Konsens ist das Problem, mehrere Maschinen dazu zu bringen, sich auf eine Entscheidung zu einigen — einen Wert zu committen, einen Leader zu wählen, eine Konfiguration zu aktivieren — obwohl jede Maschine nur ihre lokalen Ereignisse und die Nachrichten sieht, die ihr zufällig ankommen.

Das klingt einfach, bis man sich erinnert, was ein verteiltes System tun darf: Nachrichten können verzögert, dupliziert, umgeordnet oder verloren gehen; Maschinen können abstürzen und neu starten; und ein sicheres Signal „dieser Knoten ist definitiv tot" gibt es selten. Konsens geht darum, Agreement unter diesen Bedingungen sicher zu machen.

Warum Einigkeit schwierig ist

Wenn zwei Knoten zeitweise nicht miteinander reden können (Network Partition), kann jede Seite versuchen, „voranzugehen“. Wenn beide Seiten unterschiedliche Werte entscheiden, bekommen Sie Split‑Brain: zwei Leader, zwei Konfigurationen oder zwei konkurrierende Historien.

Schon ohne Partitionen macht Verzögerung Probleme. Wenn ein Knoten eine Proposal‑Nachricht erst verspätet empfängt, haben andere Knoten vielleicht schon weitergemacht. Ohne gemeinsame Uhr können Sie nicht zuverlässig sagen „Proposal A kam vor Proposal B“, nur weil A einen früheren Wall‑Clock‑Zeitstempel hat — physische Zeit ist hier nicht maßgeblich.

Wo Sie Konsens im Alltag treffen

Sie nennen es vielleicht nicht täglich „Konsens“, aber es begegnet Ihnen in Infrastrukturaufgaben:

- Leader Election (Wer ist gerade verantwortlich?)

- Replizierte Logs (Was ist der nächste Eintrag in der gemeinsamen Historie?)

- Konfigurationsänderungen (Welche Menge von Knoten darf abstimmen/committen?)

In jedem Fall braucht das System ein einzelnes Ergebnis, auf das alle konvergieren, oder zumindest eine Regel, die verhindert, dass widersprüchliche Ergebnisse gleichzeitig als gültig gelten.

Paxos als Lamports Antwort

Lamports Paxos ist eine grundlegende Lösung für dieses „sichere Agreement“-Problem. Die Kernidee ist kein magischer Timeout oder ein perfekter Leader — es ist eine Menge von Regeln, die sicherstellen, dass nie zwei verschiedene Werte gewählt werden, selbst wenn Nachrichten spät kommen und Knoten ausfallen.

Paxos trennt Safety („nie zwei verschiedene Werte wählen") von Progress („irgendwann wähle etwas"), wodurch es ein praktisches Grundgerüst wird: Sie können die Performance in der Praxis optimieren, während die Kern‑Garantie erhalten bleibt.

Paxos, ohne Kopfschmerzen: Die zentrale Sicherheitsintuition

Paxos hat den Ruf, unlesbar zu sein, aber vieles davon liegt daran, dass „Paxos“ keine einzige, knappe Algorithmusbeschreibung ist. Es ist eine Familie eng verwandter Muster, um eine Gruppe zur Einigung zu bringen, selbst wenn Nachrichten verzögert, dupliziert oder Maschinen vorübergehend ausgefallen sind.

Die Rollen: Proposer, Acceptor und Quoren

Ein hilfreiches mentales Modell trennt wer vorschlägt von wer validiert.

- Proposer versuchen, einen Wert gewählt zu bekommen (z. B. „der nächste Logeintrag ist X“).

- Acceptor stimmen über Vorschläge ab.

- Ein Quorum ist „genug Acceptors“, um Fortschritt zu erzielen — typischerweise eine Mehrheit.

Die strukturelle Idee: zwei Mehrheiten überschneiden sich immer. In dieser Überlappung lebt die Sicherheit.

Das Sicherheitsziel: nie zwei verschiedene Werte entscheiden

Die Paxos‑Safety ist einfach formulierbar: Sobald das System einen Wert entschieden hat, darf es nie einen anderen Wert entscheiden — kein Split‑Brain.

Die zentrale Intuition ist, dass Vorschläge Nummern tragen (denken Sie an Wahl‑IDs). Acceptor versprechen, ältere Nummern zu ignorieren, sobald sie eine neuere gesehen haben. Und wenn ein Proposer mit einer neuen Nummer versucht, fragt er zuerst ein Quorum, was sie bereits akzeptiert haben.

Weil Quoren sich überschneiden, wird ein neuer Proposer unvermeidlich von mindestens einem Acceptor hören, der sich an den zuletzt akzeptierten Wert „erinnert“. Die Regel lautet: wenn irgendjemand im Quorum etwas akzeptiert hat, musst du eben diesen Wert (oder den jüngsten darunter) vorschlagen. Diese Einschränkung verhindert, dass zwei verschiedene Werte gewählt werden.

Liveness, auf hoher Ebene

Liveness bedeutet, dass das System irgendwann etwas entscheidet unter vernünftigen Bedingungen (z. B. ein stabiler Leader entsteht und das Netzwerk liefert schließlich Nachrichten). Paxos verspricht keine Geschwindigkeit im Chaos; es verspricht Korrektheit und Fortschritt, sobald die Bedingungen ruhig(er) werden.

State‑Machine‑Replication: Korrektheit durch geteilte Reihenfolge

Mit Konsens experimentieren

Entwirf einen Leader-Election-Service und teste Fehlerszenarien schnell mit Snapshots und Rollback.

State‑Machine‑Replication (SMR) ist das Arbeitspferd hinter vielen hochverfügbaren Systemen: Anstatt eines Servers, der Entscheidungen trifft, laufen mehrere Repliken, die alle dieselbe Befehlsfolge verarbeiten.

Die Idee des replizierten Logs

Im Zentrum steht ein repliziertes Log: eine geordnete Liste von Befehlen wie „put key=K value=V" oder „transfer $10 von A nach B." Clients senden Befehle an die Gruppe, und das System einigt sich auf eine Reihenfolge für diese Befehle; dann wendet jede Replika sie lokal an.

Warum Ordnung Korrektheit liefert

Wenn jede Replika aus demselben Anfangszustand startet und dieselben Befehle in derselben Reihenfolge ausführt, landen sie im gleichen Zustand. Das ist die Kern‑Safety‑Intuition: Sie versuchen nicht, mehrere Maschinen über Zeit zu synchronisieren; Sie machen sie durch Determinismus und gemeinsame Reihenfolge identisch.

Deshalb wird Konsens (z. B. Paxos/Raft) oft mit SMR kombiniert: Konsens entscheidet den nächsten Log‑Eintrag, und SMR wandelt diese Entscheidung in einen konsistenten Zustand über die Repliken um.

Wo Sie das in echten Systemen sehen

- Koordinationsdienste (z. B. für Konfiguration und Leader‑Election)

- Datenbanken mit replizierten Write‑Ahead‑Logs

- Messaging‑Systeme, die strikte Partition‑Ordering benötigen

Praktische Sorgen, die Ingenieure nicht ignorieren dürfen

Das Log wächst endlos, wenn Sie es nicht managen:

- Snapshots: Erfassen Sie periodisch den aktuellen Zustand, damit neue Knoten aufholen können, ohne die gesamte Historie abzuspielen.

- Log‑Kompaktion: Verwerfen Sie alte Einträge sicher, sobald sie im Snapshot reflektiert sind und nicht mehr gebraucht werden.

- Mitgliedschaftsänderungen: Hinzufügen/Entfernen von Repliken muss ebenfalls geordnet werden, sonst können verschiedene Knoten über die Gruppenmitglieder uneinig sein und Split‑Brain entstehen.

SMR ist kein Zauber; es ist eine disziplinierte Methode, „Einigung über Reihenfolge" in „Einigung über Zustand" zu verwandeln.

Korrektheit: Safety, Liveness und klare Spezifikationen schreiben

Verteilte Systeme versagen auf seltsame Weisen: Nachrichten kommen spät, Knoten starten neu, Uhren sind uneinheitlich, Netzwerke splitten. „Korrektheit" ist kein Gefühl — es sind Versprechen, die Sie präzise formulieren und gegen jede Situation (inkl. Ausfälle) prüfen können.

Safety vs. Liveness (mit konkreten Beispielen)

Safety heißt „nichts Schlimmes passiert“. Beispiel: In einem replizierten Key‑Value‑Store dürfen nie zwei verschiedene Werte für denselben Log‑Index committed werden. Oder: Ein Lock‑Service darf niemals denselben Lock gleichzeitig an zwei Clients vergeben.

Liveness heißt „etwas Gutes passiert irgendwann“. Beispiel: Wenn eine Mehrheit der Repliken verfügbar ist und das Netzwerk schließlich Nachrichten liefert, vervollständigt sich eine Schreibanfrage. Oder: Eine Lock‑Anfrage bekommt irgendwann Ja oder Nein (keine unendliche Wartezeit).

Safety verhindert Widersprüche; Liveness vermeidet dauerhafte Stillstände.

Invarianten: Ihre unverhandelbaren Bedingungen

Eine Invariante ist eine Bedingung, die in jedem erreichbaren Zustand immer gelten muss. Beispiele:

- „Jeder Log‑Index hat höchstens einen committed Wert."

- „Die Term‑Nummer eines Leaders nimmt nie ab."

Wenn eine Invariante durch einen Crash, Timeout, Retry oder Partition verletzt werden kann, war sie nie wirklich durchgesetzt.

Was ein Beweis hier bedeutet

Ein Beweis ist ein Argument, das alle möglichen Ausführungen abdeckt, nicht nur den normalen Fall. Sie denken über jede Situation nach: Nachrichtenverlust, Duplikate, Umordnung; Knotenabstürze und Neustarts; konkurrierende Leader; Clients, die wiederholen.

Spezifikationen verhindern überraschendes Verhalten

Eine klare Spezifikation definiert Zustand, erlaubte Aktionen und erforderliche Eigenschaften. Das verhindert vage Anforderungen wie „das System soll konsistent sein“, die zu widersprüchlichen Erwartungen führen können. Spezifikationen zwingen dazu, zu sagen, was bei Partitionen passiert, was „commit“ bedeutet und worauf sich Clients verlassen können — bevor die Produktion Ihnen die harte Lehrstunde erteilt.

Vom Theorie zur Praxis: Modellierung mit TLA+

Eine von Lamports praktischsten Lektionen ist: Sie können (und sollten oft) ein verteiltes Protokoll auf höherer Ebene als Code entwerfen. Bevor Sie sich um Threads, RPCs und Retry‑Schleifen kümmern, können Sie die Regeln des Systems aufschreiben: welche Aktionen erlaubt sind, welcher Zustand sich ändern darf und was niemals passieren darf.

Wofür TLA+ gut ist

TLA+ ist eine Spezifikationssprache und ein Model‑Checking‑Toolkit für nebenläufige und verteilte Systeme. Sie schreiben ein einfaches, mathematisch anmutendes Modell des Systems — Zustände und Übergänge — plus die Eigenschaften, die Ihnen wichtig sind (z. B. „höchstens ein Leader" oder „ein committed Eintrag verschwindet nie").

Der Model‑Checker durchsucht dann mögliche Interleavings, Nachrichtenverzögerungen und Ausfälle, um ein Gegenbeispiel zu finden: eine konkrete Schrittfolge, die Ihre Eigenschaft bricht. Statt endloser Diskussionen bekommen Sie ein ausführbares Argument.

Ein Fehler, den ein Modell finden kann

Betrachten Sie einen „Commit“-Schritt in einem replizierten Log. Im Code ist es leicht, versehentlich zwei verschiedene Knoten dazu zu bringen, zwei verschiedene Einträge an demselben Index unter seltenen Zeitpunkten committed zu markieren.

Ein TLA+‑Modell kann eine Spur aufdecken wie:

- Knoten A committed Eintrag X bei Index 10 nach einer Quorum‑Antwort.

- Knoten B (mit veralteten Daten) bildet ebenfalls ein Quorum und committed Eintrag Y bei Index 10.

Das ist ein doppelter Commit — eine Safety‑Verletzung, die in Produktion vielleicht nur selten auftritt, aber im Modell schnell sichtbar wird. Ähnliche Modelle fangen oft verlorene Updates, doppelte Anwendungen oder „ack, aber nicht dauerhaft“ ein.

Wann sich Modellieren lohnt

TLA+ ist am wertvollsten für kritische Koordinationslogik: Leader‑Election, Mitgliedschaftsänderungen, konsensähnliche Abläufe und jedes Protokoll, in dem Ordnung und Fehlerbehandlung zusammenspielen. Wenn ein Bug Daten beschädigen oder manuelle Wiederherstellung erfordern würde, ist ein kleines Modell meist günstiger als späteres Debugging.

Wenn Sie intern mit diesen Ideen arbeiten, ist ein praktischer Workflow: schreiben Sie eine leichte Spezifikation (auch informell), implementieren Sie das System und generieren Sie Tests aus den Invarianten der Spezifikation. Plattformen wie Koder.ai können hier helfen, indem sie den Build‑Test‑Loop beschleunigen: Sie beschreiben gewünschtes Ordering/Konsensverhalten in natürlicher Sprache, iterieren an Service‑Scaffolding (React‑Frontends, Go‑Backends mit PostgreSQL oder Flutter‑Clients) und behalten „was niemals passieren darf" sichtbar beim Ausliefern.

Praktische Schlussfolgerungen für Aufbau und Betrieb verlässlicher Systeme

Finanziere deine Experimente

Erhalte Credits, indem du teilst, was du auf Koder.ai baust, oder Teamkollegen einlädst, es auszuprobieren.

Lamports großes Geschenk an Praktiker ist eine Denkweise: Behandle Zeit und Ordnung als Daten, die du modellierst, nicht als Annahmen, die du von der Wand‑Uhr erbst. Diese Denkweise wird zu Gewohnheiten, die Sie sofort anwenden können.

Theorie in alltägliche Engineering‑Praktiken übersetzen

Wenn Nachrichten verzögert, dupliziert oder in falscher Reihenfolge ankommen können, entwerfe jede Interaktion so, dass sie unter diesen Bedingungen sicher bleibt.

- Idempotenz als Standard: Machen Sie „nochmal ausführen" harmlos. Verwenden Sie Idempotency‑Keys für Zahlungen, Provisioning oder jeden Write, den Sie retryen könnten.

- Retries mit Deduplikation: Retries sind nötig, aber ohne Deduplikation entstehen Doppel‑Writes. Verfolgen Sie Request‑IDs und speichern Sie „bereits verarbeitet“-Marker.

- At‑least‑once‑Delivery + exactly‑once‑Effekte: Akzeptieren Sie, dass das Netz zweimal liefern kann; sorgen Sie dafür, dass Ihre Zustandsänderungen es nicht tun.

Seien Sie vorsichtig mit Timeouts und Uhren

Timeouts sind keine Wahrheit; sie sind Policy. Ein Timeout sagt nur „ich habe nicht rechtzeitig geantwortet“, nicht „die andere Seite hat nicht gehandelt“. Zwei konkrete Folgen:

- Behandeln Sie ein Timeout nicht als definitive Fehlermeldung. Entwerfen Sie Kompensationen und Reconciliation‑Pfade.

- Vermeiden Sie, lokale Uhren zu verwenden, um Ereignisse über Knoten hinweg anzuordnen. Nutzen Sie Sequenznummern, monotone Zähler oder explizite kausale Metadaten (z. B. „dieses Update ersetzt Version X").

Observability, die Kausalität respektiert

Gute Debugging‑Werkzeuge kodieren Ordnung, nicht nur Zeitstempel.

- Trace‑IDs überall: Propagieren Sie Korrelation/Trace‑IDs durch jeden Hop und jede Log‑Zeile.

- Kausale Hinweise in Logs: Loggen Sie Nachrichten‑IDs, Parent‑Request‑IDs und „welche Version ich für aktuell hielt“, als Sie entschieden haben.

- Deterministische Replays: Zeichnen Sie Eingaben (Befehle) auf, damit Sie Verhalten abspielen und bestätigen können, ob ein Bug timing‑abhängig oder logisch ist.

Designfragen, bevor Sie ausliefern

Bevor Sie eine verteilte Funktion hinzufügen, fordern Sie Klarheit mit einigen Fragen:

- Was passiert, wenn dieselbe Anfrage zweimal verarbeitet wird?

- Welche Reihenfolge brauchen wir wirklich (falls überhaupt) und wo wird sie durchgesetzt?

- Welche Ausfälle sind „sicher" (kein falscher Zustand) vs. „laut" (sichtbar für Nutzer) vs. „stumm" (versteckte Korruption)?

- Wie sieht der Wiederherstellungspfad nach einem partiellen Ausfall oder Network Split aus?

- Was werden wir loggen, um die happened‑before‑Geschichte in Produktion rekonstruieren zu können?

Diese Fragen brauchen keinen Doktortitel — nur die Disziplin, Ordnung und Korrektheit als erstklassige Produktanforderungen zu behandeln.

Fazit und empfohlene nächste Schritte

Lamports bleibendes Geschenk ist eine Denkweise, die Ihnen hilft, klar zu denken, wenn Systeme keine Uhr teilen und nicht automatisch zustimmen, „was passiert ist“. Anstatt perfekter Zeit hinterherzujagen, verfolgen Sie Kausalität (was was beeinflusst haben könnte), repräsentieren sie mit logischer Zeit (Lamport‑Timestamps) und — wenn das Produkt eine einzige Historie verlangt — bauen Sie Agreement (Konsens), sodass jede Replika dieselbe Sequenz von Entscheidungen anwendet.

Dieser Faden führt zu einer praktischen Engineering‑Haltung:

Erst spezifizieren, dann bauen

Schreiben Sie die Regeln auf, die Sie brauchen: was niemals passieren darf (Safety) und was schließlich passieren muss (Liveness). Implementieren Sie dann gegen diese Spezifikation und testen Sie das System unter Verzögerungen, Partitionen, Retries, duplizierten Nachrichten und Knoten‑Neustarts. Viele „mysteriöse Ausfälle" sind in Wahrheit fehlende Aussagen wie „eine Anfrage kann zweimal verarbeitet werden" oder „Leader können sich jederzeit ändern".

Konzentriert weiterlernen

Wenn Sie tiefer gehen wollen, ohne in Formalismus zu ertrinken:

- Lesen Sie Lamports „Time, Clocks, and the Ordering of Events in a Distributed System", um happened‑before zu verinnerlichen.

- Überfliegen Sie „Paxos Made Simple" für die Sicherheitsintuition: Sobald ein Wert gewählt ist, kann Fortschritt ihn nicht widersprechen.

- Schauen Sie einen TLA+‑Intro‑Talk und modellieren Sie ein winziges Protokoll (z. B. einen Lock‑Service oder ein Register mit zwei Repliken) und prüfen Sie es.

Machen Sie eine praktische Übung

Wählen Sie eine Komponente, für die Sie verantwortlich sind, und schreiben Sie einen einseitigen „Failure Contract": Was nehmen Sie über Netzwerk und Storage an, welche Operationen sind idempotent, und welche Ordnungs‑Garantien geben Sie?

Wenn Sie diese Übung konkreter machen wollen, bauen Sie einen kleinen „Ordering‑Demo"‑Dienst: eine Request‑API, die Befehle an ein Log anhängt, einen Hintergrundworker, der sie anwendet, plus eine Admin‑Ansicht, die Kausalitäts‑Metadaten und Retries zeigt. Auf Koder.ai können Sie schnell iterieren — insbesondere, wenn Sie schnelle Scaffolds, Deployment/Hosting, Snapshots/Rollback für Experimente und Source‑Code‑Export wollen, sobald Sie zufrieden sind.

Gut gemacht reduzieren diese Ideen Ausfälle, weil weniger Verhalten implizit bleibt. Sie vereinfachen auch das Denken: Sie hören auf, über Zeit zu streiten, und fangen an zu beweisen, was Reihenfolge, Agreement und Korrektheit konkret für Ihr System bedeuten.