25. Juli 2025·8 Min

Wie LLMs einfache Ideen in Full‑Stack‑Apps verwandeln

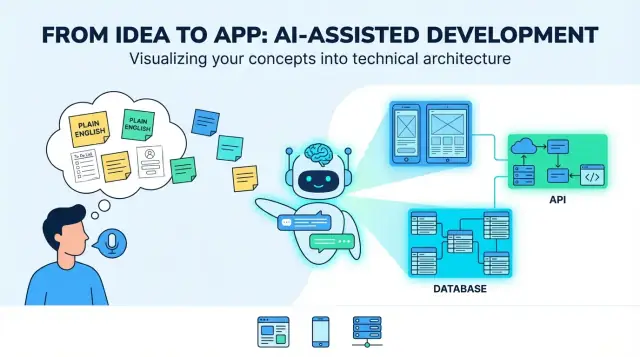

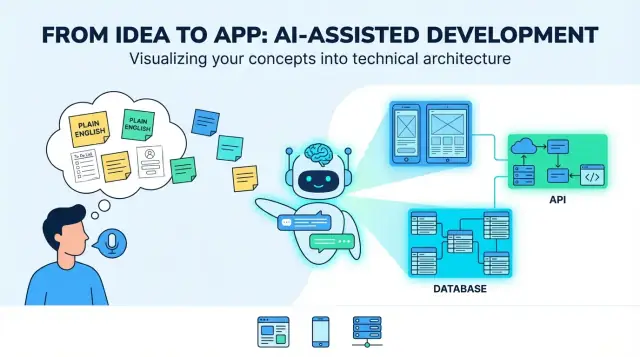

Wie LLMs einfache Produktideen in Web-, Mobile‑ und Backend‑Apps übersetzen: Anforderungen, UI‑Flows, Datenmodelle, APIs, Tests und Deployment.

Wie LLMs einfache Produktideen in Web-, Mobile‑ und Backend‑Apps übersetzen: Anforderungen, UI‑Flows, Datenmodelle, APIs, Tests und Deployment.

Eine „in einfachem Englisch formulierte Produktidee“ beginnt meist als Mischung aus Absicht und Hoffnung: für wen sie gedacht ist, welches Problem sie löst und wie Erfolg aussieht. Es können ein paar Sätze sein („eine App zum Buchen von Hundeführern“), ein grober Workflow („Kunde anfragt → Walker nimmt an → Zahlung“), und ein paar Must‑Haves („Push‑Benachrichtigungen, Ratings“). Das ist genug, um über eine Idee zu sprechen — aber nicht genug, um zuverlässig zu bauen.

Wenn Leute sagen, ein LLM könne eine Idee „übersetzen“, bedeutet das nützliches Folgendes: unscharfe Ziele in konkrete, testbare Entscheidungen verwandeln. Die „Übersetzung“ ist nicht bloß Umformulierung — sie fügt Struktur hinzu, damit Sie prüfen, hinterfragen und umsetzen können.

LLMs eignen sich gut dafür, einen ersten Entwurf der Kernbausteine zu liefern:

Das typische „Endergebnis“ sieht wie ein Blueprint für ein Full‑Stack‑Produkt aus: eine Web‑UI (oft für Admins oder Desktop‑Schwerpunkte), eine Mobile‑UI (für Nutzer unterwegs), Backend‑Services (Auth, Business‑Logik, Notifications) und Datenspeicherung (Datenbank plus Datei/Media‑Speicher).

LLMs können Ihre Produkt‑Trade‑offs nicht zuverlässig auswählen, weil die richtigen Antworten vom Kontext abhängen, den Sie möglicherweise nicht dokumentiert haben:

Behandle das Modell als System, das Optionen und Standardwerte vorschlägt, nicht als letzte Wahrheit.

Die größten Fehlerquellen sind vorhersehbar:

Das eigentliche Ziel der „Übersetzung“ ist, Annahmen sichtbar zu machen — damit Sie sie bestätigen, überarbeiten oder zurückweisen können, bevor sie sich in Code verfestigen.

Bevor ein LLM aus „Baue mir eine App für X“ Screens, APIs und Datenmodelle macht, brauchen Sie ein Produktbrief, das genug Spezifikationen enthält, um darauf zu designen. Dieser Schritt verwandelt unscharfe Absicht in ein gemeinsames Ziel.

Formulieren Sie die Problemstellung in ein oder zwei Sätzen: wer hat ein Problem, welches und warum ist es wichtig. Fügen Sie dann messbare Erfolgskriterien hinzu.

Beispiel: „Die Zeit reduzieren, die eine Klinik benötigt, um Folge‑Termine zu vereinbaren.“ Metriken könnten durchschnittliche Planungszeit, No‑Show‑Rate oder % der Patienten sein, die per Self‑Service buchen.

Listen Sie die primären Nutzer (nicht jede Person, die mit dem System in Berührung kommen könnte). Geben Sie jeder Rolle eine Hauptaufgabe und ein kurzes Szenario.

Eine nützliche Prompt‑Vorlage: „Als [Rolle] möchte ich [etwas tun], damit [Nutzen].“ Streben Sie 3–7 Kern‑Use‑Cases an, die das MVP beschreiben.

Constraints sind der Unterschied zwischen einem sauberen Prototyp und einem auslieferbaren Produkt. Fügen Sie hinzu:

Seien Sie explizit, was in der ersten Version enthalten ist und was verschoben wird. Eine einfache Regel: MVP‑Features müssen die primären Use‑Cases Ende‑zu‑Ende ohne manuelle Workarounds unterstützen.

Wenn Sie wollen, fassen Sie das als einseitiges Briefing zusammen und behalten es als „Quelle der Wahrheit“ für die nächsten Schritte (Anforderungen, UI‑Flows und Architektur).

Eine Plain‑English‑Idee ist meist ein Mix aus Zielen („hilf Leuten, Klassen zu buchen“), Annahmen („Nutzer melden sich an“) und vager Reichweite („mach es einfach“). Ein LLM ist hier nützlich, weil es unordentliche Eingaben in überprüfbare Anforderungen umwandeln kann.

Beginnen Sie damit, jeden Satz als User Story zu formulieren. Das zwingt zur Klarheit über wer was warum braucht:

Wenn eine Story keine Nutzerrolle oder keinen Nutzen nennt, ist sie wahrscheinlich noch zu vage.

Gruppieren Sie Stories zu Features und kennzeichnen Sie jedes als must‑have oder nice‑to‑have. Das verhindert Scope‑Drift bevor Design und Engineering beginnen.

Beispiel: „Push‑Benachrichtigungen“ können nice‑to‑have sein, während „Buchung stornieren“ meist must‑have ist.

Fügen Sie unter jeder Story einfache, testbare Regeln hinzu. Gute Akzeptanzkriterien sind spezifisch und beobachtbar:

LLMs neigen zur Darstellung des „Happy Path“, also bitte ausdrücklich nach Edge‑Cases fragen wie:

Dieses Requirements‑Bundle wird zur Quelle der Wahrheit, um spätere Outputs (UI‑Flows, APIs, Tests) zu bewerten.

Eine Plain‑English‑Idee wird erst dann baubar, wenn sie zu Nutzerreisen und Bildschirmen mit klarer Navigation wird. In diesem Schritt geht es nicht um Farben — es geht darum, was Menschen tun können, in welcher Reihenfolge und was Erfolg bedeutet.

Beginnen Sie mit den Pfaden, die am wichtigsten sind. Für viele Produkte strukturieren sie sich so:

Das Modell kann diese Flows als Schritt‑für‑Schritt‑Sequenzen entwerfen. Ihre Aufgabe ist zu bestätigen, was optional oder zwingend ist und wo Nutzer sicher aussteigen und wieder einsteigen können.

Fordern Sie zwei Deliverables an: ein Screen‑Inventar und eine Navigationskarte.

Ein guter Output benennt Bildschirme konsistent (z. B. „Order Details“ vs „Order Detail“), definiert Einstiegspunkte und enthält Empty‑States (keine Ergebnisse, keine gespeicherten Elemente).

Übersetze Anforderungen in Formularfelder mit Regeln: erforderlich/optional, Formate, Limits und benutzerfreundliche Fehlermeldungen. Beispiel: Passwortregeln, Zahlungsadressformate oder „Datum muss in der Zukunft liegen.“ Achte darauf, dass Validierung sowohl inline (während des Tippens) als auch beim Absenden erfolgt.

Beziehe lesbare Textgrößen, guten Kontrast, vollständige Tastaturbedienbarkeit im Web und Fehlermeldungen, die erklären, wie man das Problem behebt, mit ein. Jedes Formularfeld braucht ein Label und die Fokusreihenfolge muss sinnvoll sein.

Eine „Architektur" ist der Bauplan der App: welche Teile existieren, wofür jeder Teil verantwortlich ist und wie sie miteinander kommunizieren. Wenn ein LLM eine Architektur vorschlägt, ist Ihre Aufgabe sicherzustellen, dass sie einfach genug ist, um jetzt gebaut zu werden, und klar genug, um später zu wachsen.

Für die meisten neuen Produkte ist ein einzelnes Backend (Monolith) der richtige Start: ein Code‑Basis, ein Deployment, eine Datenbank. Schneller zu bauen, leichter zu debuggen und günstiger im Betrieb.

Ein modularer Monolith ist oft der Sweetspot: weiterhin ein Deploy, aber klar organisierte Module (Auth, Billing, Projects usw.) mit sauberen Grenzen. Eine Service‑Aufspaltung verzögern Sie, bis echter Druck entsteht — z. B. hoher Traffic, ein Team braucht unabhängige Deploys oder ein Systemteil skalieren sich anders.

Wenn das LLM sofort „Microservices“ vorschlägt, verlangen Sie eine Begründung mit konkreten Bedürfnissen, nicht hypothetischen Zukunftsszenarien.

Eine gute Architektur‑Skizze benennt die Essentials:

Das Modell sollte außerdem angeben, wo jedes Teil lebt (Backend vs Mobile vs Web) und wie Clients mit dem Backend interagieren (meist REST oder GraphQL).

Architektur bleibt vage, wenn Sie nicht die Basics festlegen: Backend‑Framework, Datenbank, Hosting und Mobile‑Ansatz (native vs Cross‑Platform). Bitten Sie das Modell, diese als „Annahmen“ aufzuschreiben, damit alle wissen, worauf entworfen wird.

Statt großer Rewrites bevorzugen Sie kleine „Escape Hatches": Caching für heiße Reads, eine Queue für Background Jobs und stateless App‑Server, damit Sie später Instanzen hinzufügen können. Die besten Architekturvorschläge erklären diese Optionen und halten v1 gleichzeitig einfach.

Produktideen sind voller Nomen: „Users“, „Projects“, „Tasks“, „Payments“, „Messages“. Datenmodellierung ist der Schritt, bei dem ein LLM diese Nomen in ein gemeinsames Bild verwandelt: was gespeichert werden muss und wie Dinge miteinander verbunden sind.

Beginnen Sie mit den Schlüsselentitäten und fragen: was gehört zu was?

Beispiel:

Definieren Sie dann Beziehungen und Constraints: Kann eine Task ohne Project existieren? Können Kommentare editiert werden? Können Projekte archiviert werden und was passiert mit Tasks, wenn ein Projekt gelöscht wird?

Das Modell schlägt als Nächstes ein erstes Schema (SQL‑Tabellen oder NoSQL‑Collections) vor. Halten Sie es einfach und fokussiert auf Entscheidungen, die Verhalten beeinflussen.

Ein typischer Entwurf könnte enthalten:

Wichtig: Legen Sie Statusfelder, Zeitstempel und Unique‑Constraints früh fest (z. B. eindeutige E‑Mail). Diese Details treiben später UI‑Filter, Benachrichtigungen und Reporting.

Die meisten echten Apps brauchen klare Regeln, wer was sehen kann. Ein LLM sollte Ownership explizit machen (owner_user_id) und Memberships/Rollen modellieren. Für Multi‑Tenant‑Produkte (viele Firmen in einem System) führen Sie eine tenant/organization‑Entität ein und hängen tenant_id an alles, was isoliert werden muss.

Definieren Sie außerdem, wie Berechtigungen durchgesetzt werden: per Rolle (Admin/Member/Viewer), per Ownership oder kombiniert.

Entscheiden Sie, was protokolliert und was gelöscht werden muss. Beispiele:

Diese Entscheidungen verhindern unangenehme Überraschungen bei Compliance, Support oder Abrechnungsfragen.

APIs sind der Ort, an dem die Versprechen Ihrer App zu realen Aktionen werden: „mein Profil speichern“, „meine Bestellungen anzeigen“, „Listings durchsuchen“. Ein guter Output beginnt bei Nutzeraktionen und verwandelt sie in eine kleine, klare Menge von Endpunkten.

Listen Sie die Hauptobjekte (z. B. Projects, Tasks, Messages). Für jedes definieren Sie, was Nutzer tun können:

Das mappt typischerweise auf Endpunkte wie:

POST /api/v1/tasks (create)GET /api/v1/tasks?status=open&q=invoice (list/search)GET /api/v1/tasks/{taskId} (read)PATCH /api/v1/tasks/{taskId} (update)DELETE /api/v1/tasks/{taskId} (delete)Create a task: Der Nutzer sendet Titel und Fälligkeitsdatum.

POST /api/v1/tasks

{

"title": "Send invoice",

"dueDate": "2026-01-15"

}

Die Response gibt den gespeicherten Datensatz (inklusive servergenerierter Felder) zurück:

201 Created

{

"id": "tsk_123",

"title": "Send invoice",

"dueDate": "2026-01-15",

"status": "open",

"createdAt": "2025-12-26T10:00:00Z"

}

Lassen Sie das Modell konsistente Fehler produzieren:

Für Retries empfehlen sich Idempotency‑Keys bei POST und klare Hinweise wie „retry after 5 seconds."

Mobile Clients aktualisieren langsam. Verwenden Sie einen versionierten Basis‑Pfad (/api/v1/...) und vermeiden Sie Breaking Changes:

GET /api/version)Security ist keine Aufgabe für später. Wenn ein LLM Ihre Idee in App‑Specs überführt, wollen Sie sichere Defaults explizit haben — damit die erste generierte Version nicht versehentlich angreifbar ist.

Bitten Sie das Modell, eine primäre Login‑Methode und ein Fallback zu empfehlen sowie Abläufe für Problemfälle (Zugriffsverlust, verdächtige Logins). Übliche Optionen:

Spezifizieren Sie Session‑Handling (kurzlebige Access Tokens, Refresh Tokens, Geräte‑Logout) und ob MFA unterstützt wird.

Authentifizierung identifiziert Nutzer; Autorisierung limitiert Zugriff. Fordern Sie ein klares Muster:

project:edit) für flexible ProdukteEin guter Output enthält Beispielsregeln wie: „Nur Projekt‑Owner können ein Projekt löschen; Collaborators können editieren; Viewer können kommentieren."

Lassen Sie das Modell konkrete Schutzmaßnahmen aufzählen, nicht nur generische Versprechen:

Fordern Sie außerdem eine Threat‑Baseline: CSRF/XSS‑Schutz, sichere Cookies und sichere Dateiuploads, falls relevant.

Standardmäßig so wenig Daten wie möglich erfassen: nur was das Feature wirklich braucht, und nur so lange wie nötig.

Lassen Sie das LLM verständliche Texte entwerfen für:

Bei Analytics drängen Sie auf Opt‑Out (oder Opt‑In, wo nötig) und dokumentieren das in den Einstellungen und Policy‑Seiten.

Ein gutes LLM kann Ihre Anforderungen in einen brauchbaren Testplan übersetzen — wenn Sie es zwingen, alles an Akzeptanzkriterien zu verankern, statt allgemeiner Aussagen.

Geben Sie dem Modell Ihre Feature‑Liste und Akzeptanzkriterien, dann lassen Sie es Tests pro Kriterium generieren. Ein solider Output enthält:

Wenn ein Test nicht auf ein konkretes Kriterium zurückgeführt werden kann, ist er wahrscheinlich Rauschen.

LLMs können auch Fixtures vorschlagen, die reale Nutzung abbilden: unsaubere Namen, fehlende Felder, Zeitzonen, langer Text, flaky Netzwerke, „fast‑duplikate“.

Bitten Sie um:

Fügen Sie eine mobile Checkliste hinzu:

LLMs sind gut darin, Test‑Skelette zu erstellen, aber prüfen Sie:

Behandle das Modell als schnellen Testautor, nicht als endgültige QA‑Abnahme.

Ein Modell kann viel Code generieren, aber Nutzer profitieren erst, wenn er sicher ausgeliefert wird und Sie sehen, was nach dem Launch passiert. Dieser Schritt beschreibt wiederholbare Releases: dieselben Schritte jedes Mal, mit möglichst wenigen Überraschungen.

Richten Sie eine einfache CI‑Pipeline ein, die bei jedem Pull Request und Merge in den Main‑Branch läuft:

Selbst wenn das LLM den Code geschrieben hat, zeigt CI, ob nach Änderungen noch alles funktioniert.

Nutzen Sie drei Umgebungen mit klaren Zwecken:

Konfiguration sollte über Environment‑Variablen und Secrets gehandhabt werden (nicht hartkodiert). Eine gute Regel: Wenn das Ändern eines Wertes einen Code‑Änderung erfordert, ist er wahrscheinlich falsch konfiguriert.

Für eine typische Full‑Stack‑App:

Planen Sie drei Signale:

Hier wird aus KI‑unterstützter Entwicklung Betrieb: Sie erzeugen nicht nur Code, Sie betreiben ein Produkt.

LLMs können eine vage Idee in etwas verwandeln, das wie ein vollständiger Plan aussieht — aber polierte Prosa kann Lücken verbergen. Die häufigsten Fehler sind vorhersehbar und können mit ein paar Gewohnheiten vermieden werden.

Die meisten schwachen Outputs lassen sich auf vier Ursachen zurückführen:

Geben Sie dem Modell konkrete Materialien:

Fordern Sie Checklisten pro Deliverable. Beispiel: Anforderungen sind nicht „done“, bis sie Akzeptanzkriterien, Fehlerzustände, Rollen/Berechtigungen und messbare Erfolgskriterien enthalten.

LLM‑Outputs driften, wenn Specs, API‑Notizen und UI‑Ideen in getrennten Threads leben. Pflegen Sie ein lebendes Dokument (auch einfach eine Markdown‑Datei), das verlinkt:

Beim erneuten Prompten fügen Sie den neuesten Auszug ein und sagen: „Aktualisiere nur Abschnitt X und Y; alles andere unverändert lassen."

Wenn Sie während der Implementierung iterieren, hilft ein Workflow, der schnelle Iterationen unterstützt, ohne Nachvollziehbarkeit zu verlieren. Tools mit Planungs‑Modus, Snapshots und Source‑Code‑Export sind hier besonders nützlich.

So kann „LLM‑Translation" End‑to‑End aussehen — plus die Checkpoints, an denen ein Mensch verlangsamten und echte Entscheidungen treffen sollte.

Plain‑English‑Idee: „Ein Pet‑Sitting‑Marktplatz, wo Besitzer Anfragen posten, Sitters sich bewerben und Zahlungen nach Abschluss freigegeben werden."

Ein LLM kann daraus einen ersten Entwurf machen:

POST /requests, GET /requests/{id}, POST /requests/{id}/apply, GET /requests/{id}/applications, POST /messages, POST /checkout/session, POST /jobs/{id}/complete, POST /reviews.Das ist nützlich — aber nicht „fertig“. Es ist ein strukturiertes Proposal, das validiert werden muss.

Produktentscheidungen: Was macht eine Bewerbung gültig? Kann ein Besitzer einen Sitter direkt einladen? Wann gilt eine Anfrage als „filled“? Diese Regeln beeinflussen jeden Screen und Endpoint.

Security & Privacy‑Review: Bestätigen Sie Role‑Based‑Access (Besitzer dürfen nicht Chats anderer Besitzer lesen), schützen Sie Zahlungen und definieren Sie Daten‑Retention (z. B. Chat‑Löschung nach X Monaten). Fügen Sie Abuse‑Kontrollen hinzu: Rate Limits, Spam‑Prevention, Audit‑Logs.

Performance‑Tradeoffs: Entscheiden Sie, was schnell und skalierbar sein muss (Search/Filter, Chat). Das beeinflusst Caching, Pagination, Indexierung und Background Jobs.

Nach einem Pilot fragen Nutzer eventuell nach „Anfrage wiederholen“ oder „Stornieren mit Teilrückerstattung“. Dieses Feedback fließt als aktualisierte Anforderungen zurück, betroffene Flows werden regeneriert/gepatched und Tests sowie Security‑Checks wiederholt.

Dokumentieren Sie das „Warum“, nicht nur das „Was": zentrale Business‑Regeln, Permission‑Matrix, API‑Contracts, Fehlercodes, DB‑Migrations und ein kurzes Runbook für Releases und Incident‑Response. Das hält generierten Code auch nach sechs Monaten noch verständlich.

In diesem Kontext bedeutet „Translation“, eine vage Idee in konkrete, prüfbare Entscheidungen zu überführen: Rollen, Nutzerreisen, Anforderungen, Datenmodelle, APIs und Erfolgskriterien.

Es ist nicht bloßes Umformulierungen — es macht Annahmen explizit, damit Sie sie bestätigen oder ablehnen können, bevor gebaut wird.

Ein praktischer erster Entwurf umfasst:

Behandle das als Draft-Blueprint, den du prüfst, nicht als endgültiges Spec.

Weil ein LLM nicht zuverlässig deine realen Randbedingungen und Trade-offs kennt, müssen Menschen weiterhin entscheiden:

Nutze das Modell, um Optionen vorzuschlagen — dann triff bewusste Entscheidungen.

Gib dem Modell genug Kontext, um gegen ihn zu entwerfen:

Wenn du das nicht einem Kollegen geben könntest, damit er das Gleiche versteht, ist es noch nicht bereit.

Konzentriere dich darauf, Ziele in User Stories + Akzeptanzkriterien zu verwandeln.

Ein starkes Paket hat typischerweise:

Das wird deine "Source of Truth" für UI, APIs und Tests.

Fordere zwei Deliverables an:

Überprüfe dann:

Für die meisten v1‑Produkte ist ein Monolith oder modularer Monolith der richtige Startpunkt.

Wenn das Modell sofort zu Microservices rät, fordere eine Begründung mit konkreten Anforderungen (Traffic, unabhängige Deploys, unterschiedliche Skalierbarkeit). Bevorzuge stattdessen "Escape Hatches":

Halte v1 einfach zu liefern und leicht zu debuggen.

Lass das Modell klar ausbuchstabieren:

Datenentscheidungen beeinflussen UI‑Filter, Benachrichtigungen, Reporting und Sicherheit.

Bestehe auf Konsistenz und mobil‑freundlichem Verhalten:

/api/v1/...)POST‑RequestsVermeide Breaking Changes; füge optionale Felder hinzu und halte eine Deprecation‑Periode ein.

Lass das Modell einen Plan entwerfen und überprüfe ihn anhand der Akzeptanzkriterien:

Fordere realistische Fixtures: Zeitzonen, lange Texte, beinahe Duplikate, flaky Netzwerke. Betrachte generierte Tests als Ausgangspunkt, nicht als finale QA.

Du definierst Verhalten, nicht Visuals.