02. Aug. 2025·8 Min

Andrew S. Tanenbaums MINIX: Kernel-Design klar vermitteln

Lerne, wie Andrew S. Tanenbaum MINIX gebaut hat, um OS-Internals zu lehren, und was sein Mikrokernel-Ansatz über Kernel-Struktur und Design-Tradeoffs erklärt.

Lerne, wie Andrew S. Tanenbaum MINIX gebaut hat, um OS-Internals zu lehren, und was sein Mikrokernel-Ansatz über Kernel-Struktur und Design-Tradeoffs erklärt.

MINIX ist ein kleines, lehrorientiertes Betriebssystem, das Andrew S. Tanenbaum erschaffen hat, um das „Innenleben“ eines Betriebssystems verständlich zu machen. Es versucht nicht, Benchmarks zu gewinnen oder auf Millionen Laptops zu landen. Es will lesbar, testbar und erklärbar sein — damit du Kernel-Design studieren kannst, ohne dich in einer riesigen Codebasis zu verlieren.

Das Studium von Kerneln zahlt sich aus, selbst wenn du nie vorhast, einen zu schreiben. Im Kernel werden grundlegende Entscheidungen über Performance (wie schnell Arbeit erledigt wird) und Zuverlässigkeit (wie gut das System Fehler übersteht) getroffen. Sobald du verstehst, wofür ein Kernel verantwortlich ist — Scheduling, Speicher, Gerätezugriff und Sicherheitsgrenzen — beginnst du, alltägliche technische Fragen anders zu betrachten:

Dieser Artikel nutzt MINIX als klares, strukturiertes Beispiel für Kernel-Architektur. Du lernst die Schlüsselkonzepte und die dahinterliegenden Tradeoffs, mit einfachen Erklärungen und minimalem Fachjargon.

Du brauchst keine tiefe Mathematik und keine theoretischen Modelle auswendig zu lernen. Stattdessen baust du ein praktisches mentales Modell auf, wie ein OS in Teile aufgeteilt ist, wie diese Teile kommunizieren und was du gewinnst (und verlierst) bei unterschiedlichen Designs.

Wir behandeln:

Am Ende solltest du jedes Betriebssystem anschauen und schnell die zugrunde liegenden Designentscheidungen erkennen — und was sie implizieren.

Andrew S. Tanenbaum ist eine der einflussreichsten Stimmen in der Betriebssystem-Ausbildung — nicht weil er einen kommerziellen Kernel gebaut hätte, sondern weil er für optimales Lernen von Kernen optimiert hat. Als Professor und Autor weit verbreiteter OS-Lehrbücher behandelte er ein Betriebssystem als Lehrinstrument: etwas, das Studierende lesen, durchdenken und modifizieren können sollten, ohne sich zu verlieren.

Viele reale Betriebssysteme sind unter Druck entstanden, der Anfängern nicht hilft: Performance-Tuning, Abwärtskompatibilität, große Hardware-Matrizen und jahrelang aufgebaute Features. Tanenbaums Ziel mit MINIX war anders. Er wollte ein kleines, verständliches System, das Kern-OS-Ideen sichtbar macht — Prozesse, Speicherverwaltung, Dateisysteme und Interprozesskommunikation — ohne dass Studierende durch Millionen Zeilen Code waten müssen.

Die „durchschaubare“ Denkweise ist wichtig. Wenn du ein Konzept von einem Diagramm bis zum tatsächlichen Source verfolgen kannst, hörst du auf, den Kernel als Magie zu behandeln, und beginnst, ihn als Design zu betrachten.

Tanenbaums Lehrbucherklärungen und MINIX verstärken sich gegenseitig: Das Buch liefert das mentale Modell, das System den konkreten Beweis. Studierende können ein Kapitel lesen, dann die entsprechende Mechanik in MINIX finden und sehen, wie die Idee in der Praxis aussieht — inklusive Datenstrukturen, Nachrichtenflüssen und Fehlerbehandlung.

Diese Kombination macht Aufgaben praktisch. Anstatt nur theoretische Fragen zu beantworten, können Lernende eine Änderung implementieren, ausführen und die Konsequenzen beobachten.

Ein Lehrbetriebssystem priorisiert Klarheit und Einfachheit, mit verfügbarer Quelle und stabilen Schnittstellen, die zu Experimenten einladen. MINIX ist bewusst so gestaltet, dass Neulinge ihn lesen und verändern können — und dennoch realistisch genug, um die Tradeoffs zu lehren, die jeder Kernel treffen muss.

Bis Mitte/Ende der 1980er Jahre verbreiteten sich UNIX-Ideen an Universitäten: Prozesse, Dateien als Streams, Pipes, Berechtigungen und die Vorstellung, ein Betriebssystem als zusammenhängendes Konzept zu studieren — nicht nur als Blackbox eines Anbieters.

Das Problem war praktisch. Die UNIX-Systeme auf dem Campus waren entweder zu teuer, rechtlich eingeschränkt oder zu groß und unübersichtlich, um Studierenden quelloffen übergeben zu werden. Für einen Kurs, der Kernel-Design lehren sollte, brauchte man etwas, das Studierende innerhalb eines Semesters tatsächlich kompilieren, starten und verstehen konnten.

MINIX wurde als Lehrbetriebssystem gebaut, das UNIX-Vertrautheit vermittelt und gleichzeitig bewusst klein bleibt. Diese Kombination ermöglichte es Lehrenden, Standard-OS-Themen (Systemaufrufe, Prozessverwaltung, Dateisysteme, Geräte-I/O) zu unterrichten, ohne Studierende zuerst in eine völlig fremde Umgebung einführen zu müssen.

Auf hoher Ebene zielte MINIX auf Kompatibilität in den für das Lernen wichtigen Punkten:

read() auf“ bis zu „Bytes kommen von der Platte“ zurückverfolgen könnenDie bestimmenden Einschränkungen von MINIX waren kein Zufall — sie waren Absicht.

Das „Problem“, das MINIX löste, war also nicht einfach „noch ein UNIX machen“. Es war: ein UNIX-ähnliches System zu bauen, optimiert fürs Lernen — kompakt, verständlich und nah genug an realen Schnittstellen, dass die Lektionen übertragbar sind.

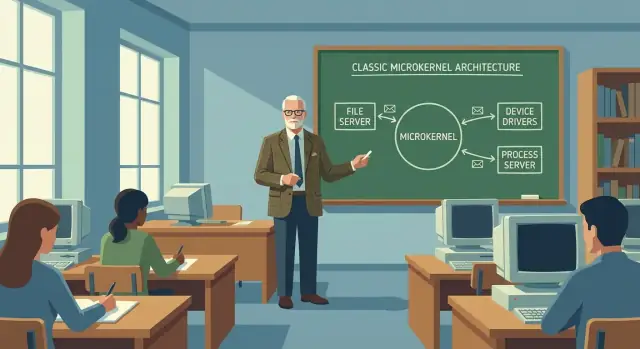

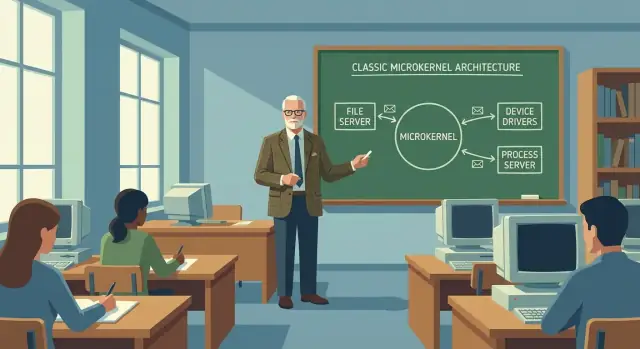

Ein Mikrokernel ist ein Kernel, der absichtlich klein bleibt. Anstatt jede Betriebssystemfunktion in einen privilegierten Block zu packen, behält er nur das Nötigste im Kernel-Modus und verschiebt die meisten anderen Aufgaben in normale User-Space-Programme.

Einfach gesagt: Der Mikrokernel ist der dünne Schiedsrichter, der Regeln durchsetzt und Nachrichten weitergibt, statt das ganze Team zu sein.

Der MINIX-Mikrokernel behält eine kurze Liste von Verantwortlichkeiten, die wirklich volle Hardware-Privilegien benötigen:

Dieser kleine Kern ist leichter zu lesen, zu testen und zu durchdenken — genau das, was man von einem Lehrbetriebssystem erwartet.

Viele Komponenten, die man umgangssprachlich „das OS“ nennt, laufen in MINIX als separate User-Space-Server:

Diese gehören weiterhin zum Betriebssystem, verhalten sich aber wie gewöhnliche Programme mit begrenzten Rechten. Wenn eines abstürzt, ist es weniger wahrscheinlich, dass es die ganze Maschine mitreißt.

In einem monolithischen Kernel würde das Dateisystem einen Treiber mit einem direkten Funktionsaufruf innerhalb desselben privilegierten Codepfads aufrufen. In MINIX sendet der Dateisystem-Server typischerweise eine Nachricht an einen Treiber-Server.

Das verändert die Designsicht: Du definierst Schnittstellen („welche Nachrichten gibt es, welche Daten tragen sie, was bedeuten Antworten“) statt interne Datenstrukturen über den ganzen Kernel zu teilen.

Der Mikrokernel-Ansatz kauft dir Fehlerisolation und klarere Grenzen, aber er bringt Kosten mit sich:

MINIX ist wertvoll, weil du diese Tradeoffs direkt sehen kannst — ein kleiner Kern, klare Schnittstellen und eine Architektur, die die Konsequenzen sichtbar macht.

MINIX ist leichter nachzuvollziehen, weil es klare Grenzen zwischen was vertrauenswürdig sein muss und was wie ein normales Programm behandelt werden kann zieht. Anstatt den größten Teil des OS-Codes in einen großen Kernel zu packen, teilt MINIX Verantwortlichkeiten auf mehrere Komponenten auf, die über wohl definierte Schnittstellen kommunizieren.

Auf hoher Ebene ist MINIX organisiert in:

Diese Aufteilung demonstriert Trennung der Verantwortlichkeiten: jedes Teil hat eine engere Aufgabe, und Studierende können einen Teil studieren, ohne das gesamte OS mental laden zu müssen.

Wenn ein Programm etwas wie „lies aus dieser Datei“ aufruft, läuft die Anfrage typischerweise so ab:

MINIX macht eine nützliche Unterscheidung: Der Kernel bietet überwiegend Mechanismen (die Werkzeuge: Scheduling-Primitiven, Nachrichtenübermittlung), während Policies (die Regeln: wer was bekommt, wie Dateien organisiert werden) in Servern leben. Diese Trennung hilft Lernenden zu sehen, wie das Ändern von Regeln nicht den vertrauenswürdigsten Kern neu schreiben muss.

Ein Mikrokernel verschiebt den Großteil der „OS-Arbeit“ in separate Prozesse (wie Dateisysteme, Gerätetreiber und Server). Das funktioniert nur, wenn diese Teile zuverlässig miteinander kommunizieren können. In MINIX ist diese Konversation die Nachrichtenübermittlung, und sie ist zentral, weil sie Kernel-Design zu einer Übung in Schnittstellen macht statt in verborgenem gemeinsamen Zustand.

Auf hoher Ebene bedeutet Nachrichtenübermittlung, dass eine Komponente eine strukturierte Anfrage an eine andere sendet — „öffne diese Datei“, „lies diese Bytes“, „gib mir die aktuelle Zeit“ — und eine strukturierte Antwort erhält. Anstatt interne Funktionen direkt aufzurufen oder gemeinsam genutzten Speicher zu manipulieren, muss jedes Subsystem einen definierten Kanal verwenden. Dieser Unterschied ist der Lehrgewinn: Du kannst auf eine Grenze zeigen und sagen: „Alles über diese Grenze läuft per Nachricht.“

Synchrones Messaging ist wie ein Telefonanruf: der Sender wartet, bis der Empfänger die Anfrage bearbeitet und antwortet. Es ist einfach zu durchdenken, weil der Fluss linear ist.

Asynchrones Messaging ist eher wie E-Mail: du schickst eine Anfrage und arbeitest weiter, Antworten kommen später. Das kann die Reaktionsfähigkeit und Nebenläufigkeit verbessern, aber Studierende müssen jetzt ausstehende Anfragen, Reihenfolgen und Timeouts verfolgen.

IPC fügt Overhead hinzu: Daten verpacken, Kontextwechsel, Berechtigungsprüfung und Kopieren oder Mapping von Puffern. MINIX macht diese Kosten sichtbar, was Studierenden hilft zu verstehen, warum einige Systeme monolithische Designs bevorzugen.

Andererseits wird das Debuggen oft einfacher. Wenn Fehler an klaren Nachrichten-Grenzen auftreten, kann man Anfragen und Antworten protokollieren, Sequenzen reproduzieren und isolieren, welcher Server fehlerhaft war — ohne den Kernel als eine große Blackbox zu behandeln.

Klare IPC-Schnittstellen erzwingen diszipliniertes Denken: welche Eingaben sind erlaubt, welche Fehler können auftreten und welcher Zustand ist privat. Studierende lernen, Kernel so zu entwerfen wie Netzwerke: Verträge zuerst, Implementierung danach.

MINIX wird für Studierende „real“, wenn es aufhört, nur Diagramme zu sein, und in lauffähige Arbeit übergeht: Prozesse, die blockieren, Scheduler, die unter Last wechseln, und Speichergrenzen, die man tatsächlich erreichen kann. Das sind die Teile, die ein Betriebssystem physisch fühlbar machen.

Ein Prozess ist der Container des OS für ein laufendes Programm: sein CPU-Zustand, sein Adressraum und seine Ressourcen. In MINIX lernst du schnell, dass „ein Programm läuft“ nicht eine einzelne Sache ist — es ist ein Bündel verfolgter Zustände, das der Kernel starten, pausieren, fortsetzen und stoppen kann.

Das ist wichtig, weil nahezu jede OS-Policy (wer als Nächstes läuft, wer auf was zugreifen darf, was bei Fehlern passiert) in Begriffen von Prozessen ausgedrückt wird.

Scheduling ist das Regelwerk für CPU-Zeit. MINIX macht Scheduling greifbar: wenn viele Prozesse laufen wollen, muss das OS eine Reihenfolge und ein Zeitfenster wählen. Kleine Entscheidungen zeigen sich in sichtbaren Ergebnissen:

In einem Mikrokernel-System beeinflusst Scheduling auch die Kommunikation: wenn ein Service-Prozess verzögert ist, fühlen sich alle langsamer an, die auf seine Antwort warten.

Speichermanagement entscheidet, wie Prozesse RAM bekommen und was sie berühren dürfen. Es ist die Grenze, die verhindert, dass ein Prozess den anderen überschreibt.

In MINIXs Architektur ist speicherbezogene Arbeit aufgeteilt: der Kernel erzwingt niedrigstufigen Schutz, während höherwertige Policies in Diensten leben können. Diese Trennung macht einen zentralen Lehrpunkt deutlich: Enforcement vom Entscheiden zu trennen macht das System leichter analysierbar — und sicherer zu ändern.

Wenn ein User-Space-Dienst abstürzt, kann MINIX oft den Kernel und den Rest des Systems am Leben halten — Ausfälle werden eingedämmt. In einem monolithischen Design kann derselbe Fehler in privilegiertem Code den gesamten Kernel abstürzen lassen.

Dieser einzelne Unterschied verbindet Designentscheidungen mit Ergebnissen: Isolation verbessert die Sicherheit, kann aber Overhead und Koordinationskomplexität erhöhen. MINIX lässt dich diese Abwägung fühlen, nicht nur darüber lesen.

Kernel-Debatten klingen oft wie ein Boxkampf: Mikrokernel gegen monolithisch, wähle eine Seite. MINIX ist hilfreicher, wenn du es als Denkwerkzeug benutzt. Es zeigt, dass Kernel-Architektur ein Spektrum von Entscheidungen ist, nicht die Suche nach einer einzig „richtigen“ Antwort.

Ein monolithischer Kernel behält viele Dienste in einem privilegierten Raum — Gerätetreiber, Dateisysteme, Netzwerk und mehr. Ein Mikrokernel hält den privilegierten „Kern“ klein (Scheduling, grundlegendes Speichermanagement, IPC) und betreibt den Rest als separate User-Space-Prozesse.

Diese Verschiebung ändert die Tradeoffs:

Allzwecksysteme akzeptieren oft einen größeren Kernel zugunsten von Performance und Kompatibilität (viele Treiber, viele Workloads). Systeme, die Zuverlässigkeit, Wartbarkeit oder starke Trennung priorisieren (einige Embedded- und sicherheitsfokussierte Designs), wählen eher eine mikrokernel-nähere Struktur. MINIX lehrt, die Wahl anhand der Ziele zu begründen, nicht aus Ideologie.

Gerätetreiber sind eine der häufigsten Ursachen für Systemabstürze oder unvorhersehbares Verhalten. Sie sitzen an einer schwierigen Grenze: sie brauchen tiefen Hardwarezugang, reagieren auf Interrupts und Timing-Feinheiten und enthalten oft viel herstellerspezifischen Code. In einem traditionellen monolithischen Kernel kann ein fehlerhafter Treiber Kernel-Speicher überschreiben oder eine Sperre halten — und so das ganze System lahmlegen.

MINIX verwendet einen Mikrokernel-Ansatz, bei dem viele Treiber als separate User-Space-Prozesse laufen anstatt als privilegierter Kernel-Code. Der Mikrokernel behält nur das Nötigste (Scheduling, grundlegendes Speichermanagement und IPC) und Treiber kommunizieren über wohl definierte Nachrichten.

Der Lehrnutzen ist sofort: Du kannst auf einen kleineren „vertrauenswürdigen Kern“ zeigen und zeigen, wie alles andere — Treiber eingeschlossen — über Schnittstellen statt über versteckte gemeinsame Speichertricks interagiert.

Wenn ein Treiber isoliert läuft:

Es verwandelt „der Kernel ist Magie“ in „der Kernel ist eine Menge Verträge“.

Isolation ist nicht umsonst. Stabile Treiber-Schnittstellen zu entwerfen ist schwer, Nachrichtenübermittlung verursacht mehr Overhead als direkte Funktionsaufrufe, und Debugging wird verteilt („liegt der Fehler im Treiber, im IPC-Protokoll oder im Server?“). MINIX macht diese Kosten sichtbar — so lernen Studierende, dass Fehlerisolation eine bewusste Abwägung ist, kein Schlagwort.

Die berühmte MINIX-vs-Linux-Diskussion wird oft als Persönlichkeitskonflikt erinnert. Nützlicher ist es, sie als architektonische Debatte zu sehen: Wofür sollte ein Betriebssystem optimieren, wenn es gebaut wird, und welche Kompromisse sind akzeptabel?

MINIX wurde primär als Lehrbetriebssystem konzipiert. Seine Struktur zielt darauf ab, Kernel-Ideen im Unterricht sichtbar und prüfbar zu machen: kleine Komponenten, klare Grenzen und nachvollziehbares Verhalten.

Linux verfolgte ein anderes Ziel: ein praktisches System zu schaffen, das Menschen nutzen, schnell erweitern und auf echter Hardware performant betreiben konnten. Diese Prioritäten begünstigen andere Designentscheidungen.

Die Debatte ist wertvoll, weil sie zeitlose Fragen erzwingt:

Aus Tanenbaums Perspektive lernst du, Schnittstellen, Isolation und die Disziplin zu achten, den Kernel klein genug zu halten, um ihn zu verstehen.

Vom Linux-Weg lernst du, wie reale Beschränkungen Designs prägen: Hardware-Unterstützung, Entwicklungstempo und die Vorteile, früh etwas Nützliches auszuliefern.

Ein verbreiteter Mythos ist, dass die Debatte „bewiesen“ habe, eine Architektur sei immer überlegen. Das tat sie nicht. Sie machte klar, dass Bildungsziele und Produktziele unterschiedlich sind und dass kluge Ingenieure aus verschiedenen Beschränkungen ehrlich argumentieren können. Das ist die Lektion, die bleibt.

MINIX wird oft weniger wie ein „Produkt" gelehrt und mehr wie ein Laboringstrument: Du nutzt es, um Ursache und Wirkung in einem echten Kernel zu beobachten, ohne in irrelevanter Komplexität zu ertrinken. Ein typischer Kurszyklus durchläuft drei Aktivitäten — lesen, ändern, verifizieren — bis du Intuition aufgebaut hast.

Studierende beginnen meist damit, eine einzelne Systemaktion von Anfang bis Ende nachzuverfolgen (z. B. „ein Programm fragt das OS, eine Datei zu öffnen" oder „ein Prozess geht schlafen und wacht später auf"). Ziel ist es nicht, Module auswendig zu lernen, sondern zu erkennen, wo Entscheidungen getroffen werden, wo Daten validiert werden und welche Komponente wofür zuständig ist.

Eine praktische Technik ist, einen Einstiegspunkt zu wählen (einen Syscall-Handler, eine Scheduler-Entscheidung oder eine IPC-Nachricht) und ihm zu folgen, bis das Ergebnis sichtbar ist — etwa ein zurückgegebener Fehlercode, ein geänderter Prozesszustand oder eine Nachrichtenantwort.

Gute Einstiegsaufgaben sind eng umrissen:

Der Schlüssel ist, Änderungen zu wählen, die leicht zu durchdenken und schwer zufällig erfolgreich sind.

„Erfolg" heißt, vorhersagen zu können, was deine Änderung bewirken wird, und das dann mit reproduzierbaren Tests zu bestätigen (und bei Bedarf Logs an Nachrichten-Grenzen zu verwenden). Lehrende bewerten oft die Erklärung ebenso wie den Patch: was du geändert hast, warum es funktionierte und welche Tradeoffs eingeführt wurden.

Verfolge zuerst einen Pfad end-to-end, dann erweitere auf angrenzende Pfade. Wenn du zu früh zwischen Subsystemen springst, sammelst du Details, ohne ein brauchbares mentales Modell aufzubauen.

Der bleibende Wert von MINIX ist nicht, dass du seine Komponenten auswendig lernst — es trainiert dich, in Grenzen zu denken. Sobald du internalisiert hast, dass Systeme aus Verantwortlichkeiten mit expliziten Schnittstellen bestehen, beginnst du, versteckte Kopplungen (und Risiken) in jeder Codebasis zu sehen.

Erstens: Struktur schlägt Cleverness. Wenn du ein Kasten-Diagramm zeichnen kannst, das auch einen Monat später noch Sinn macht, bist du schon vorne.

Zweitens: Schnittstellen sind der Ort, an dem Korrektheit lebt. Wenn Kommunikation explizit ist, kannst du über Fehlermodi, Berechtigungen und Performance nachdenken, ohne jede Zeile Code zu lesen.

Drittens: Jedes Design ist ein Tradeoff. Schneller ist nicht immer besser; einfacher ist nicht immer sicherer. MINIXs Lehrfokus bringt dir bei, den getroffenen Tradeoff zu benennen — und ihn zu verteidigen.

Nutze diese Denkweise beim Debuggen: Statt Symptome zu jagen, frage „Welche Grenze wurde falsch überschritten?“ Verifiziere dann Annahmen an der Schnittstelle: Eingaben, Ausgaben, Timeouts und Fehlerbehandlung.

Nutze es bei Architektur-Reviews: Liste Verantwortlichkeiten auf und frage, ob eine Komponente zu viel über eine andere weiß. Wenn das Ersetzen eines Moduls fünf andere Komponenten berührt, ist die Grenze wahrscheinlich falsch.

Das ist auch ein hilfreiches Modell für moderne „vibe-coding"-Workflows. Zum Beispiel in Koder.ai kannst du eine App im Chat beschreiben und die Plattform generiert ein React-Frontend, ein Go-Backend und eine PostgreSQL-Datenbank. Der schnellste Weg zu guten Resultaten ist überraschend MINIX-ähnlich: Verantwortlichkeiten vorher definieren (UI vs API vs Daten), die Verträge explizit machen (Endpoints, Nachrichten, Fehlerfälle) und sicher mit Planungsmodus sowie Snapshots/Rollback iterieren, während du Grenzen verfeinerst.

Wenn du das Modell vertiefen willst, studiere als Nächstes:

Du musst kein Kernel-Ingenieur sein, um von MINIX zu profitieren. Die zentrale Gewohnheit ist einfach: Entwirf Systeme als kooperierende Teile mit expliziten Verträgen — und bewerte Entscheidungen anhand der Tradeoffs, die sie erzeugen.

MINIX ist bewusst klein und „einsichtig“ gestaltet, sodass man ein Konzept von einem Diagramm bis zum echten Quellcode verfolgen kann, ohne sich durch Millionen Zeilen zu wühlen. Dadurch werden Kernaufgaben des Kernels — Scheduling, Speicherprotektion, IPC und Gerätezugriff — leichter zu studieren und innerhalb eines Semesters zu verändern.

Ein Lehrbetriebssystem optimiert Klarheit und Experimentierfreude statt maximaler Performance oder breiter Hardwareunterstützung. Das bedeutet meist eine kleinere Codebasis, stabile Schnittstellen und eine Struktur, die dazu einlädt, Teile des Systems zu lesen, zu ändern und zu testen, ohne sich zu verlieren.

Der Mikrokernel beschränkt sich auf die wirklich privilegierten Mechanismen im Kernel-Modus, zum Beispiel:

Alles andere (Dateisysteme, Treiber, viele Dienste) läuft als user-space Prozesse.

In einem Mikrokernel-Design laufen viele OS-Komponenten als separate user-space Prozesse. Anstatt interne Kernel-Funktionen direkt aufzurufen, senden Komponenten strukturierte IPC-Nachrichten wie „lies diese Bytes“ oder „schreibe diesen Block“ und warten auf eine Antwort (oder bearbeiten sie später). Das erzwingt explizite Schnittstellen und reduziert versteckten gemeinsamen Zustand.

Ein typischer Ablauf ist:

read).Dies end-to-end nachzuvollziehen ist eine gute Methode, ein praktisches mentales Modell aufzubauen.

Eine übliche Einteilung ist:

MINIX macht diese Trennung sichtbar, sodass man Policies im Userspace ändern kann, ohne den vertrauenswürdigen Kernel-Kern neu schreiben zu müssen.

Synchrones Messaging bedeutet, dass der Sender auf eine Antwort wartet (einfachere Kontrollflüsse, leichter nachvollziehbar). Asynchrones Messaging erlaubt dem Sender, weiterzuarbeiten und Antworten später zu bearbeiten (mehr Nebenläufigkeit, aber man muss Reihenfolge, Timeouts und ausstehende Anfragen verwalten). Beim Lernen sind synchrone Flüsse oft leichter end-to-end nachzuverfolgen.

Mikrokernel bieten typischerweise:

Aber sie zahlen oft:

MINIX ist wertvoll, weil man beide Seiten in einem realen System beobachten kann.

Treiber enthalten oft hardware-spezifischen Code und sind eine häufige Fehlerquelle. Wenn Treiber als user-space Prozesse laufen:

Der Preis sind mehr IPC-Aufrufe und die Notwendigkeit sorgfältig gestalteter Treiber-Schnittstellen.

Ein praktikabler Lernablauf ist:

Kleine Änderungen machen es leichter, Ursache und Wirkung zu lernen statt an einem großen, unübersichtlichen Patch zu scheitern.