Warum MySQL zur Grundlage des frühen Webs wurde

MySQL wurde zur Standarddatenbank des frühen Webs aus einem einfachen Grund: Es passte zu dem, was Websites damals brauchten — strukturierte Daten schnell speichern und abrufen, auf bescheidener Hardware laufen und für kleine Teams leicht zu betreiben sein.

Es war zugänglich. Man konnte es schnell installieren, aus gängigen Programmiersprachen verbinden und eine Seite zum Laufen bringen, ohne einen spezialisierten Datenbankadministrator einzustellen. Diese Kombination aus „gut genug Performance“ und geringem Betriebsaufwand machte MySQL zur Default-Wahl für Startups, Hobbyprojekte und wachsende Unternehmen.

Was „Skalieren“ hier tatsächlich bedeutet

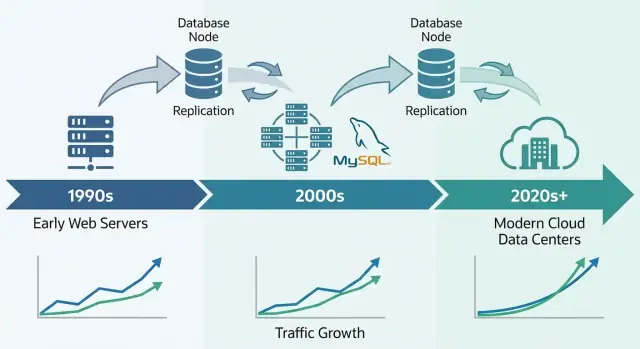

Wenn Leute sagen, MySQL habe „skaliert“, meinen sie meist eine Mischung aus:

- Traffic-Wachstum: mehr gleichzeitige Nutzer und mehr Abfragen pro Sekunde.

- Datenwachstum: Tabellen, die von Tausenden auf Millionen oder Milliarden Zeilen wachsen.

- Zuverlässigkeitserwartungen: online bleiben bei Abstürzen, Deploys und Hardwareausfällen.

- Kostenrestriktionen: das Erreichen des Obigen ohne nur Enterprise-Budgets.

Frühe Web-Firmen brauchten nicht nur Geschwindigkeit; sie brauchten vorhersehbare Performance und Verfügbarkeit bei kontrollierten Infrastrukturkosten.

Die Kernhebel, die wir wieder betrachten werden

Die Skalierungsgeschichte von MySQL ist vor allem eine Geschichte praktischer Kompromisse und wiederholbarer Muster:

- Schema- und Query-Design (was du speicherst, wie du joinst, was du vermeidest)

- Indexe (der Unterschied zwischen „funktioniert in dev“ und „funktioniert in Produktion“)

- Caching (nicht für jeden Seitenaufruf die DB treffen)

- Replikation und Read-Replicas (Lese-Last verteilen)

- Sharding/Partitionierung (Daten splitten, wenn eine einzelne DB nicht mehr mithält)

Umfang dieses Artikels

Dies ist ein Rundgang durch die Muster, die Teams nutzten, um MySQL unter realem Web-Traffic performant zu halten — kein vollständiges MySQL-Handbuch. Ziel ist zu erklären, wie die Datenbank den Bedürfnissen des Webs entsprach und warum dieselben Ideen noch heute in großen Produktionssystemen auftauchen.

Die LAMP-Ära: Wie Einfachheit MySQL verbreitete

MySQLs Durchbruch war eng verknüpft mit dem Aufstieg von Shared Hosting und kleinen Teams, die Web-Apps schnell bauten. Es ging nicht nur darum, dass MySQL „gut genug“ war — es passte zu der Art, wie das frühe Web deployed, gemanagt und bezahlt wurde.

Warum LAMP zu frühem Hosting passte

LAMP (Linux, Apache, MySQL, PHP/Perl/Python) funktionierte, weil es mit dem Standardserver übereinstimmte, den sich die meisten leisten konnten: eine einzelne Linux-Box, auf der Webserver und Datenbank nebeneinander liefen.

Hosting-Anbieter konnten dieses Setup als Vorlage nutzen, Installationen automatisieren und günstig anbieten. Entwickler konnten fast überall dieselbe Basiskonfiguration erwarten, was Überraschungen beim Wechsel von lokalem Development zur Produktion reduzierte.

Einfachheit als Verbreitungsstrategie

MySQL war unkompliziert zu installieren, zu starten und zu verbinden. Es sprach vertrautes SQL, hatte einen einfachen Kommandozeilen-Client und integrierte sich sauber in die damals populären Sprachen und Frameworks.

Genauso wichtig war das Betriebsmodell: ein Hauptprozess, ein paar Konfigurationsdateien und klare Fehlerzustände. Das machte es realistisch, dass Generalisten (Sysadmins, oft Entwickler) eine Datenbank ohne Spezialausbildung betreiben konnten.

Open Source entfernte Lizenzhindernisse. Ein Studentenprojekt, ein Hobbyforum und eine kleine Business-Site konnten dieselbe Engine nutzen wie größere Firmen.

Dokumentation, Mailinglisten und später Online-Tutorials erzeugten Momentum: mehr Nutzer bedeuteten mehr Beispiele, mehr Tools und schnellere Problemlösungen.

Die frühen Workloads, die MySQL gut bediente

Die meisten frühen Seiten waren leseintensiv und relativ einfach: Foren, Blogs, CMS-Seiten und kleine E‑Commerce-Kataloge. Diese Apps brauchten typischerweise schnelle Lookups nach ID, aktuelle Beiträge, Nutzerkonten und einfache Suche oder Filter — genau die Art von Workload, die MySQL auf bescheidener Hardware effizient handhaben konnte.

Frühe Skalierungsbelastungen: Mehr Nutzer, mehr Reads, mehr Writes

Frühe MySQL-Deployments starteten oft als „ein Server, eine Datenbank, eine App“. Das funktionierte für ein Hobbyforum oder eine kleine Firmenwebsite — bis die App populär wurde. Pageviews wurden zu Sessions, Sessions zu konstantem Traffic, und die Datenbank hörte auf, ein ruhiger Hintergrunddienst zu sein.

Warum Reads meist dominierten

Die meisten Web-Apps waren (und sind) leseintensiv. Eine Startseite, Produktliste oder Profilseite kann tausendmal angesehen werden für jede einzelne Aktualisierung. Dieses Ungleichgewicht prägte frühe Skalierungsentscheidungen: Wenn du Reads schneller machen oder komplett vermeiden konntest, konntest du viel mehr Nutzer bedienen, ohne alles neu schreiben zu müssen.

Der Haken: Auch leseintensive Apps haben kritische Writes. Anmeldungen, Käufe, Kommentare und Admin-Updates dürfen nicht verloren gehen. Mit wachsendem Traffic muss das System sowohl eine Flut von Reads als auch „must-succeed“-Writes gleichzeitig verarbeiten.

Die ersten Schmerzpunkte für Teams

Bei höherem Traffic wurden Probleme in einfachen Worten sichtbar:

- Langsame Abfragen: Eine Seite, die früher sofort geladen hat, „hing“, weil eine Berichtsanfrage zu viele Zeilen scannte.

- Table-Locks: In frühen Setups konnten Writes Reads (und umgekehrt) blockieren und Staus erzeugen.

- Begrenzter RAM: Indexe und heiße Daten passten nicht in den Speicher, daher griff der Server öfter auf die Festplatte zu — viel langsamer als RAM.

Sorgen früh trennen

Teams lernten, Verantwortlichkeiten zu trennen: die App macht Business-Logik, ein Cache fängt wiederholte Reads ab, und die Datenbank konzentriert sich auf akkurate Speicherung und essenzielle Abfragen. Dieses mentale Modell bereitete den Boden für Query-Tuning, bessere Indexe und das Skalieren mit Replikaten.

Storage-Engines: Der große Wendepunkt für Zuverlässigkeit

Ein einzigartiges Merkmal von MySQL ist, dass es nicht „eine“ Storage-Engine unter der Haube ist. Es ist ein Datenbankserver, der Daten mit unterschiedlichen Storage-Engines speichern und abrufen kann.

Was eine Storage-Engine tatsächlich tut

Auf hoher Ebene entscheidet eine Storage-Engine wie Zeilen auf die Platte geschrieben werden, wie Indexe gepflegt werden, wie Sperren funktionieren und was nach einem Absturz passiert. Dein SQL kann identisch aussehen, aber die Engine bestimmt, ob die DB eher wie ein schnelles Notizbuch oder wie ein Bankkonto funktioniert.

MyISAM vs. InnoDB (in einfachen Worten)

Lange Zeit nutzten viele MySQL-Setups MyISAM. Es war einfach und oft schnell für leseintensive Sites, hatte aber Nachteile:

- Locking: MyISAM verwendet häufig table-level locks. Ein Write kann andere Reads/Writes stärker blockieren.

- Abstürze: Nach unsauberen Shutdowns konnten MyISAM-Tabellen Reparaturen brauchen und jüngste Änderungen verlieren.

- Transaktionen: MyISAM unterstützt keine Transaktionen, also gibt es kein zuverlässiges „alles oder nichts“ bei mehrschrittigen Updates.

InnoDB kehrte diese Annahmen um:

- Locking: Row-level locking reduziert Blockaden, wenn viele Nutzer unterschiedliche Zeilen aktualisieren.

- Crash-Recovery: bessere Durability und automatische Wiederherstellung nach Fehlern.

- Transaktionen: Volle Transaktionsunterstützung, was vorhersehbareres App-Verhalten ermöglicht.

Warum InnoDB der Produktionsstandard wurde

Als Web-Apps von hauptsächlich lesen zu Login-, Warenkorb-, Zahlungs- und Messaging-Workloads wechselten, wurden Korrektheit und Recovery genauso wichtig wie Geschwindigkeit. InnoDB machte es realistisch, zu skalieren, ohne Angst, dass ein Neustart oder Traffic-Spike Daten beschädigt oder ganze Tabellen blockiert.

Die praktische Erkenntnis: Die Engine-Wahl beeinflusst sowohl Performance als auch Sicherheit. Es ist nicht nur eine Checkbox — dein Sperrmodell, das Verhalten bei Ausfällen und die App-Garantien hängen davon ab.

Indexe und Query-Design: Der erste Skalierungs-Multiplikator

Vor Sharding, Read-Replicas oder aufwändigem Caching kamen viele frühe MySQL-Gewinne von einer konsequenten Änderung: Queries vorhersehbar machen. Indexe und Query-Design waren der erste „Multiplikator“, weil sie reduzierten, wie viel Daten MySQL pro Anfrage berühren musste.

B-Tree-Indexe: schnelle Lookups vs Full-Table-Scans

Die meisten MySQL-Indexe basieren auf B-Trees. Denk an sie als ein geordnetes Verzeichnis: MySQL kann direkt an die richtige Stelle springen und ein kleines zusammenhängendes Datenstück lesen. Ohne passenden Index fällt der Server oft auf das Zeile-für-Zeile-Scannen zurück. Bei geringer Last ist das nur langsam; bei Scale wird es ein Verstärker — mehr CPU, mehr Platten-I/O, mehr Sperrzeiten und höhere Latenz für alles.

Query-Anti-Pattern, die bei Scale schaden

Einige Muster führten immer wieder zu „funktioniert in Staging“-Fehlern:

SELECT *: zieht unnötige Spalten, erhöht I/O und kann covering-index Vorteile zunichte machen.- Führende Wildcards:

WHERE name LIKE '%shoe' kann keinen normalen B-Tree-Index effektiv nutzen.

- Funktionen auf indizierten Spalten:

WHERE DATE(created_at) = '2025-01-01' verhindert oft Indexnutzung; besser sind Bereichsfilter wie created_at >= ... AND created_at < ....

Zwei Gewohnheiten skalierten besser als jeder einzelne clevere Trick:

- Führe

EXPLAIN aus, um zu verifizieren, dass der beabsichtigte Index verwendet wird und kein Scan stattfindet.

- Beobachte das Slow Query Log, um Regressionen beim Release zu entdecken, nicht Wochen später.

Indexe sollten reale Features abbilden

Entwirf Indexe nach dem Produktverhalten:

- Suche: ziehe Full-Text- oder Präfix-Strategien statt Wildcard-Scans in Betracht.

- Feeds: zusammengesetzte Indexe wie

(user_id, created_at) machen „neueste Items“ schnell.

- Checkout-Flows: Unique-Indexe auf Order-/Zahlungs-IDs verhindern Duplikate und beschleunigen Lookups.

Gutes Indexieren ist nicht „mehr Indexe“, sondern die richtigen wenige, die kritische Lese-/Schreibpfade abdecken.

Vertikale vs. horizontale Skalierung: Was sich ändert und warum

Caching und Replikate prototypen

Simuliere leseintensive Endpunkte und lass Koder.ai Dienste entwerfen, die für Cache-Keys und Replikate bereit sind.

Wenn ein MySQL-gestütztes Produkt langsamer wird, ist die erste große Entscheidung, ob man nach oben (vertikal) oder nach außen (horizontal) skaliert. Sie lösen unterschiedliche Probleme und verändern dein operatives Leben sehr unterschiedlich.

Vertikale Skalierung: der "größere Kasten"

Vertikal zu skalieren heißt, MySQL mehr Ressourcen auf einer Maschine zu geben: schnellere CPU, mehr RAM, besseren Speicher.

Das funktioniert oft überraschend gut, weil viele Engpässe lokal sind:

- CPU: komplexe Queries, Sorts, Joins und ineffiziente WHERE-Klauseln können Kerne auslasten.

- I/O: langsame Festplatten und zufällige Lese-/Schreibzugriffe dominieren, wenn Daten nicht in den Speicher passen.

- Buffer Pool / Memory: mit InnoDB kann mehr RAM heiße Daten und Indexe cachen und Plattenzugriffe reduzieren.

- Connection-Limits: zu viele gleichzeitige Verbindungen können Threads, Speicher und Kontextwechsel überlasten.

Vertikal skalieren ist meist der schnellste Gewinn: weniger bewegliche Teile, einfachere Fehlerzustände und wenig Änderungen an der Anwendung. Nachteilig ist, dass es eine Obergrenze gibt (Upgrades können Downtime oder riskante Migrationen erfordern).

Horizontale Skalierung: "mehr Kisten", mehr Koordination

Horizontal skalieren fügt Maschinen hinzu. Für MySQL heißt das typischerweise:

- Reads über Replikate verteilen

- Writes durch Datenaufteilung (Sharding) oder Umstrukturierung der Workflows aufteilen

Das ist schwieriger, weil Koordinationsprobleme hinzukommen: Replikationslag, Failover-Verhalten, Konsistenz-Trade-offs und mehr operatives Tooling. Deine Anwendung muss wissen, an welchen Server sie sich verbindet (oder du brauchst eine Proxy-Schicht).

Erwartungen setzen: nicht sofort sharden

Die meisten Teams brauchen Sharding nicht als ersten Schritt. Fange damit an herauszufinden, wo Zeit verbracht wird (CPU vs I/O vs Lock-Contention), behebe langsame Queries und Indexe und dimensioniere RAM/Storage richtig. Horizontales Skalieren lohnt, wenn eine einzelne Maschine trotz guter Tuning-Maßnahmen nicht mehr genug Schreibrate, Speicherplatz oder Verfügbarkeit liefert.

Replikation und Read-Replicas: Praktisches Read-Scaling

Replikation ist eine der praktischsten Methoden, mit denen MySQL-Systeme Wachstum bewältigten: statt eine DB alles tun zu lassen, kopierst du ihre Daten auf andere Server und verteilst die Arbeit.

Replikation einfach erklärt: Primary und Replicas

Denke an einen Primary (auch „Master“) als die DB, die Änderungen akzeptiert — INSERTs, UPDATEs, DELETEs. Ein oder mehrere Replicas (früher „Slaves“) ziehen diese Änderungen kontinuierlich und wenden sie an, um eine nahe-echtzeitliche Kopie zu halten.

Deine Anwendung kann dann:

- Writes an den Primary senden

- Viele Reads an die Replicas senden

Dieses Muster wurde üblich, weil Web-Traffic oft schneller in Richtung Read-heavy wächst als in Richtung Write-heavy.

Wofür Read-Replicas genutzt wurden

Read-Replicas dienten nicht nur dazu, Seiten schneller auszuliefern. Sie halfen auch, Arbeit zu isolieren, die den Haupt-Datenbankserver langsamer machen würde:

- Read-Scaling: Produktseiten, Feeds, Suchergebnisse und andere leseintensive Endpunkte

- Analytics und Reporting: lange laufende Abfragen auf einem Replica statt blockierendem Einfluss auf den Primary

- Backups: logische Dumps oder Backup-Tools gegen ein Replica laufen lassen, um Produktionslast zu schonen

Welche Kompromisse du akzeptieren musst

Replikation ist kein Freifahrtschein. Das häufigste Problem ist Replikationslag — Replicas können während Traffic-Spitzen Sekunden oder länger hinterherhinken.

Das führt zur App-Ebene-Frage: read-your-writes Konsistenz. Wenn ein Nutzer ein Profil aktualisiert und du sofort von einem Replica liest, sieht er möglicherweise alte Daten. Viele Teams lösen das, indem sie für „frische“ Ansichten vom Primary lesen oder ein kurzes Fenster („read from primary after write“) nutzen.

Replikation ist nicht gleich Failover

Replikation kopiert Daten; sie sorgt nicht automatisch dafür, dass du bei Ausfällen online bleibst. Failover — ein Replica promoten, Traffic umleiten und sicherstellen, dass die App sich neu verbindet — ist eine separate Fähigkeit, die Tooling, Tests und klare Betriebsabläufe erfordert.

Grundlagen der Hochverfügbarkeit: Online bleiben bei Ausfällen

Von der Idee zum funktionierenden CRUD

Verwandle Entitäten in Formulare, APIs und Datenbanktabellen, ohne alles manuell zu verdrahten.

Hochverfügbarkeit (HA) sind Praktiken, die deine App am Laufen halten, wenn ein DB-Server abstürzt, eine Netzwerkverbindung ausfällt oder Wartung nötig ist. Ziele sind simpel: Downtime reduzieren, Wartung sicher machen und Wiederherstellung planbar statt improvisiert.

Die häufigsten HA-Muster

Frühe MySQL-Deployments starteten oft mit einem Primary. HA fügte typischerweise eine zweite Maschine hinzu, damit ein Ausfall nicht lange Downtime bedeutete.

- Primary–Standby (aktiv–passiv): ein Server bedient Traffic; ein Standby ist bereit, zu übernehmen.

- Mehrknoten-Cluster: mehrere DB-Knoten arbeiten zusammen, um den Dienst verfügbar zu halten, meist mit strengeren Regeln für Writes.

- Automatisiertes Failover: Monitoring erkennt Primary-Ausfall und promotet einen Standby, während die App-Zielfestlegung aktualisiert wird.

Automatisierung hilft, erhöht aber auch die Anforderungen: das Team muss der Erkennungslogik vertrauen und „Split-Brain“ (zwei Server halten sich für Primary) verhindern.

RPO und RTO, einfach erklärt

Zwei Metriken machen HA-Entscheidungen messbar:

- RPO (Recovery Point Objective): wie viele Daten du verlieren darfst. Wenn ein Replica 10 Sekunden hinterherhinkt, ist dein RPO bis zu ~10 Sekunden.

- RTO (Recovery Time Objective): wie lange du down sein darfst. Das umfasst Erkennung, Promotion und App-Reconnect-Zeit.

Operative Grundlagen, die HA real machen

HA ist nicht nur Topologie — es ist Praxis.

Backups müssen routinemäßig sein, aber der Schlüssel sind Restore-Tests: Kannst du wirklich schnell auf einen neuen Server wiederherstellen? Schema-Änderungen sind ebenfalls wichtig. Große Tabellenänderungen können Writes blockieren oder Queries verlangsamen. Sichere Ansätze: Änderungen in ruhigen Zeiten, Online-Schema-Change-Tools verwenden und immer einen Rollback-Plan haben.

Gut gemacht verwandelt HA Ausfälle von Notfällen in geplante, geprobte Ereignisse.

Caching-Strategien, die MySQL unter Web-Last schnell hielten

Caching war eine der einfachsten Methoden, mit denen frühe Web-Teams MySQL reaktionsfähig hielten, als der Traffic stieg. Die Idee ist klar: Bitte wiederholte Anfragen aus etwas schnellerem als der Datenbank bedienen und MySQL nur treffen, wenn nötig. Richtig eingesetzt reduziert Caching die Lese-Last drastisch und lässt plötzliche Spitzen wie eine sanfte Steigung statt einen Ansturm wirken.

Die üblichen Cache-Ebenen

Application/Object-Cache speichert „Stücke“ von Daten, die dein Code oft abfragt — Nutzerprofile, Produktdetails, Berechtigungsprüfungen. Statt dieselbe SELECT-Hundertmal pro Minute auszuführen, liest die App ein vorkalkuliertes Objekt per Key.

Page- oder Fragment-Cache speichert gerendertes HTML (ganze Seiten oder Teile wie eine Sidebar). Besonders effektiv für Content-lastige Sites mit vielen Besuchern, die dieselben Seiten ansehen.

Query-Result-Caching bewahrt das Ergebnis einer bestimmten Abfrage (oder eine normalisierte Version davon). Auch wenn du nicht auf SQL-Ebene cachest, kannst du „das Ergebnis dieses Endpunkts“ mit einem Key cachen.

Teams nutzen In-Memory-KV-Stores, HTTP-Caches oder Framework-internes Caching. Das Werkzeug ist weniger wichtig als konsistente Keys, TTLs und klare Ownership.

Die schwierige Aufgabe: Cache-Invalidation

Caching tauscht Aktualität gegen Geschwindigkeit. Manche Daten dürfen etwas veraltet sein (News, View-Counts). Andere nicht (Bestellsummen, Berechtigungen). Gewöhnliche Optionen:

- Zeitbasiertes Auslaufen (einfach, erlaubt kurze Veralterung)

- Ereignisbasierte Invalidierung (präziser, leichter falsch zu implementieren)

Wenn Invalidierung fehlschlägt, sehen Nutzer veraltete Inhalte. Ist sie zu aggressiv, verliert man den Nutzen und MySQL wird wieder belastet.

Warum Caching Spitzen glättet

Bei Traffic-Spitzen fangen Caches wiederholte Reads ab, während MySQL sich auf „echte Arbeit“ konzentriert (Writes, Cache-Misses, komplexe Queries). Das reduziert Queueing, verhindert, dass Slowdowns sich ausbreiten, und kauft Zeit, um sicher zu skalieren.

Sharding und Partitionierung: Wenn eine DB nicht mehr reicht

Es gibt einen Punkt, an dem „größere Hardware“ und sorgfältiges Tuning keinen Spielraum mehr bieten. Wenn eine einzelne MySQL-Instanz die Schreiblast, Datengröße oder Wartungsfenster nicht mehr bewältigen kann, denkt man über Datenaufteilung nach.

Partitionierung vs. Sharding (und warum sie verschieden sind)

Partitionierung teilt eine Tabelle in kleinere Stücke innerhalb derselben MySQL-Instanz (z. B. nach Datum). Sie kann Löschungen, Archivierung und manche Abfragen beschleunigen, aber sie erhöht nicht die CPU-, RAM- oder I/O-Grenzen dieser einen Maschine.

Sharding teilt Daten über mehrere MySQL-Server auf. Jeder Shard hält eine Teilmenge der Zeilen, und deine Anwendung (oder eine Routing-Schicht) entscheidet, wohin eine Anfrage geht.

Wann Sharding notwendig wird

Sharding taucht meist auf, wenn:

- Writes den Primary sättigen, selbst nach Indexing, Query-Fixes und Caching

- Datenwachstum Backups, Restores und Schema-Änderungen zu langsam macht

- "Noisy Neighbors" unvorhersehbare Latenz für alle anderen verursachen

Übliche Shard-Keys

Ein guter Shard-Key verteilt Traffic gleichmäßig und hält die meisten Anfragen auf einem Shard:

- user_id: üblich für Consumer-Apps; hält Nutzerdaten zusammen

- tenant_id: ideal für SaaS; starke Isolation zwischen Kunden

- Geografie: nützlich für Latenz und Datenresidenz, kann aber Hotspots erzeugen

Die wirklichen Kosten

Sharding tauscht Einfachheit gegen Skalierbarkeit:

- Cross-Shard-Queries werden schwieriger (oft Fan-Out + Aggregation)

- Cross-Shard-Transactions sind eingeschränkt; viele Teams wechseln zu eventual-consistency-Mustern

- Migrationen und Rebalancing sind operativ aufwändig (Ranges verschieben, Routing aktualisieren)

Ein gestaffelter Ansatz (bevor du commitest)

Starte mit Caching und Read-Replicas, um Druck vom Primary zu nehmen. Isoliere dann die schwersten Tabellen oder Workloads (manchmal nach Feature oder Service). Erst danach sharden — idealerweise so, dass du Shards schrittweise hinzufügen kannst, statt alles auf einmal neu zu designen.

Betrieb in großem Maßstab: Monitoring, Wartung und Incidents

MySQL-Lektionen in Code umwandeln

Beschreibe deine App und Koder.ai erstellt ein React- und Go-Gerüst, das du verfeinern kannst.

MySQL in einer viel genutzten Umgebung zu betreiben, ist weniger eine Frage cleverer Features als disziplinierter Betriebsabläufe. Die meisten Ausfälle beginnen nicht mit einem dramatischen Fehler — sie beginnen mit kleinen Signalen, die niemand rechtzeitig verband.

Was Teams wirklich überwachen

Bei Scale sagen die meisten Teams, dass die "großen vier" Signale Probleme früh vorhersagen:

- Query-Latenz (p50/p95/p99): steigende Tail-Latenz ist wichtiger als Mittelwerte.

- Locks und Lock-Waits: Spitzen können auf heiße Zeilen, fehlende Indexe oder lange Transaktionen hindeuten.

- Replikationslag: Lag verwandelt Read-Scaling in veraltete Reads und kann Failovers brechen.

- Plattenwachstum und I/O-Pressure: Platten füllen sich, aber I/O-Sättigung schmerzt meist zuerst.

Gute Dashboards liefern Kontext: Traffic, Error-Rates, Connection-Counts, Buffer-Pool-Hit-Rate und Top-Queries. Ziel ist Veränderung zu erkennen — nicht Normalwerte auswendig zu lernen.

Warum langsame Queries nur unter echter Last auftauchen

Viele Queries sehen in Staging okay aus und auch in Produktion während ruhiger Zeiten. Unter Last verhält sich die DB anders: Caches helfen nicht mehr, parallele Requests verstärken Lock-Contention, und eine leicht ineffiziente Abfrage kann viel mehr Reads, temporäre Tabellen oder größere Sorts auslösen.

Darum verlassen sich Teams auf Slow Query Log, Query-Digests und Produktions-Histogramme statt Einzelbenchmarks.

Wartung ohne Überraschungen

Sichere Change-Praktiken sind bewusst unspektakulär: Migrations in kleinen Chargen, Indexe hinzufügen mit minimalen Sperren, Explain-Pläne überprüfen und realistische Rollbacks bereit halten (manchmal ist der Rollback "Deployment stoppen und Failover"). Änderungen sollten messbar sein: Vorher/Nachher Latenz, Lock-Waits und Replikationslag.

Incident-Grundlagen: Diagnostizieren, Abmildern, Verhindern

Während eines Incidents: Impact bestätigen, größten Verursacher identifizieren (Query, Host, Tabelle), dann mildern — Traffic drosseln, ausufernde Queries killen, temporären Index hinzufügen oder Reads/Writes verschieben.

Danach: dokumentieren, Alerts für frühe Signale hinzufügen und die Behebung reproduzierbar machen, damit derselbe Fehler nicht nächste Woche zurückkommt.

Warum MySQL heute noch riesige Systeme antreibt

MySQL bleibt für viele moderne Produktionssysteme die Default-Wahl, weil es zur Struktur alltäglicher Anwendungsdaten passt: viele kleine Reads und Writes, klare transaktionale Grenzen und vorhersehbare Queries. Deshalb passt es immer noch gut zu OLTP-lastigen Produkten wie SaaS, E‑Commerce, Marktplätzen und Multi-Tenant-Plattformen — insbesondere wenn Daten um echte Geschäftsobjekte modelliert und Transaktionen fokussiert gehalten werden.

Ein modernes MySQL sieht anders aus als "altes MySQL"

Das heutige MySQL-Ökosystem profitiert von Jahren harter Lektionen, die in bessere Defaults und sicherere Betriebsgewohnheiten eingeflossen sind. In der Praxis verlassen sich Teams auf:

- InnoDB als Standard-Storage-Engine mit starker Crash-Recovery und transaktionalen Garantien

- Verbesserte Performance-Features (bessere Optimizer, schnellere Replikationsoptionen, vorhersehbareres Concurrency-Verhalten)

- Observability, die leichter aktivierbar ist: Slow Query Logs, Performance Schema, Metrics-Exporter und Dashboards, die echte Engpässe hervorheben

- Automation rund um Schema-Änderungen, Backups und Failover — sodass Skalierung nicht von heldenhaftem manuellem Eingreifen abhängt

Managed MySQL senkt die operative Steuer

Viele Firmen betreiben MySQL inzwischen als Managed Service, bei dem der Anbieter Routineaufgaben wie Patching, automatisierte Backups, Verschlüsselung, Point-in-Time-Recovery und gängige Skalierungsschritte übernimmt (größere Instanzen, Read-Replicas, Storage-Wachstum). Du behältst die Kontrolle über Schema, Queries und Datenzugriffs-Muster — verbringst aber weniger Zeit mit Wartungsfenstern und Recovery-Drills.

Diese Muster in moderne App-Delivery einbringen

Ein Grund, warum das "MySQL-Skalierungs-Playbook" noch relevant ist: Es ist selten nur ein Datenbankproblem — es ist ein Architekturproblem der Anwendung. Entscheidungen wie Read/Write-Separation, Cache-Keys und Invalidierung, sichere Migrationen und Rollback-Pläne funktionieren am besten, wenn sie zusammen mit dem Produkt entworfen werden, nicht erst während eines Incidents draufgesetzt.

Wenn du neue Services baust und diese Entscheidungen früh festlegen möchtest, kann ein vibe-coding Workflow helfen. Zum Beispiel kann Koder.ai eine Plain‑Language-Spezifikation (Entitäten, Traffic‑Erwartungen, Konsistenzbedürfnisse) nehmen und ein App-Scaffold erzeugen — typischerweise React im Web und Go-Services — während du die Datenebenen-Entwürfe behältst. Planning Mode, Snapshots und Rollback sind besonders nützlich, wenn du an Schemata und Deployments iterierst, ohne jede Migration zu einem Hochrisiko-Event zu machen.

Wenn du die Koder.ai-Tarife (Free, Pro, Business, Enterprise) erkunden willst, siehe /pricing.

MySQL heute auswählen (anforderungsorientierte Checkliste)

Wähle MySQL, wenn du brauchst: starke Transaktionen, ein relationales Modell, ausgereiftes Tooling, vorhersehbare Performance und einen großen Arbeitsmarkt an Fachkräften.

Ziehe Alternativen in Betracht, wenn du brauchst: massive Write-Fan-Outs mit flexiblen Schemata (einige NoSQL-Systeme), global konsistente Multi-Region-Writes (spezialisierte verteilte Datenbanken) oder Analytics-zentrierte Workloads (spaltenorientierte Data Warehouses).

Die praktische Schlussfolgerung: Starte bei den Anforderungen (Latenz, Konsistenz, Datenmodell, Wachstumsrate, Team-Fähigkeiten) und wähle das einfachste System, das sie erfüllt — und oft ist das immer noch MySQL.