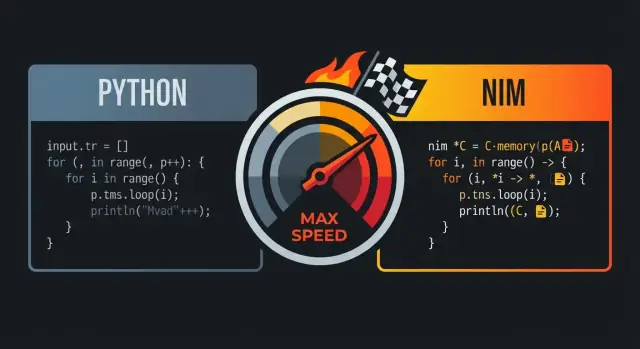

Warum Nim mit Python und C verglichen wird

Nim wird oft mit Python und C verglichen, weil es die Mitte zwischen beiden anstrebt: Code, der sich wie eine hochsprachige Skriptsprache liest, der aber zu schnellen nativen Executables kompiliert wird.

Das Kernversprechen: Lesbarkeit plus Geschwindigkeit

Auf den ersten Blick wirkt Nim häufig „pythonesk“: saubere Einrückung, klare Kontrollflüsse und eine expressive Standardbibliothek, die zu klaren, kompakten Programmen einlädt. Der entscheidende Unterschied ist, was nach dem Schreiben passiert—Nim ist darauf ausgelegt, in effizienten Maschinencode zu münden, statt in einer schweren Laufzeitumgebung zu laufen.

Für viele Teams ist genau diese Kombination der Punkt: Man kann Code schreiben, der dem Prototypen in Python ähnelt, und ihn trotzdem als einzelnes natives Binary ausliefern.

Für wen das relevant ist

Dieser Vergleich spricht besonders an:

- Python-Entwickler, die an Performance-Grenzen stoßen (CPU-intensive Aufgaben, enge Schleifen, Datenverarbeitung)

- Produktteams, die schnelle Iteration ohne eine langsame Laufzeit möchten

- Ingenieure, die die Geschwindigkeit von C schätzen, aber nicht bei jedem Alltagscode die niedrige Abstraktionsebene wollen

„C-ähnliche Performance“ heißt nicht, dass jedes Nim-Programm automatisch handoptimiertem C entspricht. Es bedeutet, dass Nim für viele Workloads konkurrenzfähigen Code erzeugen kann—insbesondere dort, wo Overhead ins Gewicht fällt: numerische Schleifen, Parsen, Algorithmen und Dienste mit vorhersehbarer Latenz.

Die größten Gewinne siehst du typischerweise, wenn du Interpretations-Overhead entfernst, Allokationen minimierst und heiße Code-Pfade einfach hältst.

Erwartungen: Geschwindigkeit hängt von Entscheidungen ab

Nim wird keinen ineffizienten Algorithmus „retten“, und du kannst trotzdem langsamen Code schreiben, wenn du exzessiv allokierst, große Datenstrukturen kopierst oder das Profiling ignorierst. Das Versprechen ist, dass die Sprache dir einen Weg von lesbarem zu schnellem Code bietet, ohne alles in ein anderes Ökosystem umschreiben zu müssen.

Das Ergebnis: eine Sprache, die sich freundlich wie Python anfühlt, aber nahe „an der Hardware“ operiert, wenn Performance tatsächlich wichtig ist.

Python-ähnliche Syntax: lesbarer Code ohne Laufzeit-Overhead

Nim wird oft als „Python-ähnlich“ beschrieben, weil der Code aussieht und fließt wie bekannt: Einrückungsbasierte Blöcke, minimale Interpunktion und eine Präferenz für lesbare, hochsprachige Konstrukte. Der Unterschied ist, dass Nim statisch typisiert und kompiliert ist—du erhältst die saubere Oberfläche, ohne eine Laufzeitsteuer zu bezahlen.

Einrückungsbasierte Blöcke und klare Struktur

Wie Python verwendet Nim Einrückung zur Blockdefinition, was Kontrollflüsse in Reviews und Diffs leicht scanbar macht. Du brauchst nicht überall geschweifte Klammern, und selten Klammern, außer sie erhöhen die Klarheit.

let limit = 10

for i in 0..<limit:

if i mod 2 == 0:

echo i

Diese visuelle Einfachheit ist wichtig, wenn du performance-empfindlichen Code schreibst: Du verlierst weniger Zeit mit Syntax und mehr damit, die Absicht auszudrücken.

Vertraute Bausteine: Schleifen, Slices, Strings

Viele Alltagskonstrukte entsprechen dem, was Python-Nutzende erwarten.

- Schleifen:

for-Schleifen über Bereiche und Kollektionen fühlen sich natürlich an.

- Slices: Sequenzen und Strings unterstützen Slice-ähnliche Operationen.

- Strings: String-Verarbeitung ist unkompliziert, mit einer Standardbibliothek für praktische Arbeit.

let nums = @[10, 20, 30, 40, 50]

let middle = nums[1..3] # slice: @[20, 30, 40]

let s = "hello nim"

echo s[0..4] # "hello"

Der Unterschied zu Python ist, was unter der Haube passiert: Diese Konstrukte werden zu effizientem nativen Code kompiliert, statt von einer VM interpretiert zu werden.

Statische Typisierung, die nicht im Weg steht

Nim ist stark statisch typisiert, setzt aber stark auf Type Inference, sodass du nicht überall verbose Typannotationen schreiben musst.

var total = 0 # inferred as int

let name = "Nim" # inferred as string

Wenn du explizite Typen möchtest (für öffentliche APIs, Klarheit oder performance-sensible Grenzen), unterstützt Nim das sauber—ohne es überall aufzuzwingen.

Hilfreiche Compiler-Fehlermeldungen und Warnungen

Ein großer Teil von „lesbarem Code“ ist, ihn sicher warten zu können. Nims Compiler ist in nützlichen Aspekten strikt: Er meldet Typkonflikte, ungenutzte Variablen und fragwürdige Konversionen früh, oft mit umsetzbaren Hinweisen. Dieser Feedback-Loop hilft, Code Python-einfach zu halten und gleichzeitig von Compile-Zeit-Korrektheitsprüfungen zu profitieren.

Wenn dir Pythons Lesbarkeit gefällt, wird sich Nims Syntax wie zuhause anfühlen. Der Unterschied ist, dass der Compiler deine Annahmen validiert und dann schnelle, vorhersehbare native Binaries erzeugt—ohne deinen Code in Boilerplate zu verwandeln.

Wie Nim kompiliert: vom Quellcode zu nativen Binaries

Nim ist eine kompilierte Sprache: du schreibst .nim-Dateien, und der Compiler erzeugt eine native ausführbare Datei, die du direkt starten kannst. Der häufigste Weg ist über Nims C-Backend (es kann auch C++ oder Objective-C anvisieren), wobei Nim-Code in Backend-Quellcode übersetzt und anschließend von einem Systemcompiler wie GCC oder Clang kompiliert wird.

Was „native Binary“ wirklich bedeutet

Eine native Binary läuft ohne Sprach-Virtual-Machine und ohne einen Interpreter, der zur Laufzeit deinen Code Schritt für Schritt ausführt. Das ist ein wesentlicher Grund, warum Nim hochsprachig wirken kann und trotzdem viele Laufzeitkosten vermeidet, die mit Bytecode-VMs oder Interpretern verbunden sind: Startzeit ist typischerweise kurz, Funktionsaufrufe sind direkt und heiße Schleifen können nahe an der Hardware laufen.

Möglichkeiten zur Whole-Program-Optimierung

Weil Nim Ahead-of-Time kompiliert, kann die Toolchain über das ganze Programm optimieren. In der Praxis ermöglicht das bessere Inlining, Dead-Code-Elimination und Link-Time-Optimierungen (abhängig von Flags und deinem C/C++-Compiler). Das Ergebnis sind oft kleinere, schnellere Executables—besonders im Vergleich zum Ausliefern einer Laufzeit plus Code.

Typischer Workflow: kompilieren, ausführen, ausliefern

Während der Entwicklung iterierst du meist mit Befehlen wie nim c -r yourfile.nim (kompilieren und ausführen) oder nutzt verschiedene Build-Modi für Debug vs Release. Beim Ausliefern verteilst du das erzeugte Executable (und ggf. benötigte dynamische Bibliotheken, falls du sie verlinkst). Es gibt keinen separaten „Interpreter deployen“-Schritt—dein Output ist bereits ein Programm, das das OS ausführen kann.

Compile-Zeit-Power: Arbeit, die vor der Ausführung erledigt wird

Einen der größten Geschwindigkeitsvorteile bringt Nim dadurch, dass es bestimmte Arbeiten während der Kompilierung erledigen kann (CTFE). Einfach gesagt: Statt etwas bei jedem Programmlauf zu berechnen, lässt du den Compiler es einmal beim Bauen berechnen und in die Binary einbacken.

Warum Kompilierzeit-Arbeit wichtig ist

Laufzeit-Performance wird oft durch „Setup-Kosten“ aufgefressen: Tabellen aufbauen, bekannte Formate parsen, Invarianten prüfen oder Werte vorcomputen, die sich nicht ändern. Wenn diese Ergebnisse aus Konstanten ableitbar sind, kann Nim diese Arbeit in die Kompilierzeit verschieben.

Das bedeutet:

- kürzere Startzeit (kein „Warm-up“)

- weniger Allokationen und Branches zur Laufzeit

- einfachere Laufzeit-Pfade (häufig leichter für den Compiler zu optimieren)

Praktische Beispiele

Erzeugen von Lookup-Tabellen. Wenn du eine Tabelle für schnelle Zuordnungen brauchst (z. B. ASCII-Zeichenklassen oder eine kleine Hashmap bekannter Strings), kannst du die Tabelle zur Kompilierzeit erzeugen und als konstantes Array speichern. Das Programm führt dann O(1)-Lookups ohne Setup aus.

Frühe Validierung von Konstanten. Liegt eine Konstante außerhalb eines gültigen Bereichs (Portnummer, fester Puffer, Protokollversion), kannst du den Build scheitern lassen, statt einen fehlerhaften Binary auszuliefern.

Vorberechnen abgeleiteter Konstanten. Masken, Bitmuster oder normalisierte Konfigurations-Defaults lassen sich einmal berechnen und überall wiederverwenden.

Ein Hinweis zur Lesbarkeit: halte es verständlich

Kompilierzeit-Logik ist mächtig, bleibt aber Code, den jemand verstehen muss. Bevorzuge kleine, gut benannte Helfer; kommentiere, warum etwas zur Kompilierzeit statt zur Laufzeit geschieht. Teste Compile-Zeit-Helfer genauso wie normale Funktionen—sonst werden Optimierungen zu schwer zu debuggenden Build-Fehlern.

Nim-Makros sind am besten als „Code, der Code schreibt“ während der Kompilierung zu verstehen. Statt Reflexion zur Laufzeit zu betreiben (und die Kosten bei jedem Ausführen zu tragen), kannst du spezialisierten, typbewussten Nim-Code einmal generieren und dann den schnellen Binary ausliefern.

Boilerplate entfernen (und Laufzeit-Checks reduzieren)

Ein häufiger Einsatz ist das Ersetzen repetitiver Muster, die sonst den Code aufblähen oder pro Aufruf Overhead erzeugen würden. Beispiele:

- Generiere Serialisierungs-/Deserialisierungsfunktionen statt Feld-für-Feld-Implementierung

- Erzeuge Validierungscode aus einem kompakten Schema anstatt vieler verstreuter

if-Checks

- Baue optimierten Dispatch (Mapping von Befehlen auf Handler) ohne Laufzeit-Lookups

Da das Makro in normalen Nim-Code expandiert, kann der Compiler trotzdem inline, optimieren und tote Branches entfernen—die Abstraktion verschwindet oft im finalen Executable.

Domänenspezifische Syntax ohne eigenen Compiler

Makros ermöglichen leichte DSL-ähnliche Syntax. Teams nutzen das, um Absichten klar auszudrücken:

- Schnelle Parser: deklarative Grammatikbeschreibung, Makro erzeugt dichten Parsercode

- Serialisierer: Felder/Tags/Formatregeln spezifizieren, Packing/Unpacking generieren

- Mini-DSLs für Routing, SQL-Building oder Konfigurationszuordnungen

Gut eingesetzt liest sich die Aufrufstelle wie Python—sauber und direkt—während sie zu effizienten Schleifen und zeigersicheren Operationen kompiliert.

Makros wartbar halten

Metaprogrammierung kann unübersichtlich werden, wenn sie zu einer versteckten Sprache im Projekt wird. Einige Leitlinien:

- Dokumentiere, was das Makro generiert, und zeige ein kleines Beispiel des expandierten Codes

- Halte Makros eng gefasst: löse ein klares Problem statt zum „Framework“ zu werden

- Bevorzuge Generics/Templates wenn sie ausreichen; Makros nur bei wirklichem AST-Transformationsbedarf

Mobilen Client hinzufügen

Erstelle eine Flutter-Begleit-App für deinen Nim-Service, basierend auf einer Chat-Spezifikation.

Nims Standard-Speicherverwaltung ist ein wichtiger Grund, warum es sich „pythonesk“ anfühlen kann und gleichzeitig wie eine Systemsprache verhält. Statt eines klassischen tracing-GCs verwendet Nim typischerweise ARC (Automatic Reference Counting) oder ORC (Optimized Reference Counting).

ARC/ORC vs. tracing GC (hochlevel)

Eine tracing-GC arbeitet in Stößen: sie stoppt normale Arbeit, läuft über Objekte und entscheidet, was freigegeben werden kann. Das ist ergonomisch, aber die Pausen sind schwer vorhersehbar.

Mit ARC/ORC wird Speicher meist freigegeben, sobald die letzte Referenz verschwindet. In der Praxis führt das zu konsistenteren Latenzen und macht es einfacher nachzuvollziehen, wann Ressourcen freigegeben werden (Speicher, Dateideskriptoren, Sockets).

Vorhersagbares Speicherverhalten reduziert „überraschende“ Slowdowns. Wenn Allokationen und Freigaben kontinuierlich und lokal passieren—statt in gelegentlichen globalen Aufräumzyklen—lässt sich das Timing eines Programms besser kontrollieren. Das ist wichtig für Spiele, Server, CLI-Tools und alles, was responsiv bleiben muss.

Es hilft auch dem Compiler: Sind Lebenszeiten klarer, kann der Compiler Daten manchmal in Registern oder auf dem Stack halten und zusätzliche Verwaltung vermeiden.

Stack vs Heap, Lebenszeiten, Kopieren vs Verschieben

Vereinfacht gesagt:

- Stack-Werte sind kurzlebig und billig zu erzeugen; sie verschwinden, wenn ein Scope endet.

- Heap-Werte leben länger und können über Scopes geteilt werden; ihre Allokation ist teurer.

Nim erlaubt es, hochsprachigen Code zu schreiben und trotzdem auf Lebenszeiten zu achten. Achte darauf, ob du große Strukturen kopierst (Daten duplizierst) oder verschiebst (Ownership ohne Duplizieren überträgst). Vermeide versehentliche Kopien in engen Schleifen.

Praktische Tipps, unnötige Allokationen zu vermeiden

Wenn du „C-ähnliche Geschwindigkeit“ willst, ist die schnellste Allokation die, die nicht stattfindet:

- Puffer (für Strings, Sequenzen, IO) wiederverwenden statt ständig neu zu erstellen

- In-place-Updates in heißen Pfaden bevorzugen

- Daten mit vorgegebener Kapazität inkrementell aufbauen

Diese Gewohnheiten passen gut zu ARC/ORC: weniger Heap-Objekte bedeuten weniger Reference-Count-Traffic und mehr Zeit für tatsächliche Arbeit.

Datenstrukturen und Layout: Geschwindigkeit durch Einfachheit

Nim kann hochsprachig wirken, aber Performance hängt oft von einer niedrigen Ebene ab: was alloziert wird, wo es liegt und wie es im Speicher angeordnet ist. Wenn du die richtigen Formen für deine Daten wählst, bekommst du Geschwindigkeit „kostenlos“, ohne unleserlichen Code.

Wertetypen vs ref: wo Allokationen passieren

Die meisten Nim-Typen sind standardmäßig Wertetypen: int, float, bool, enum und auch einfache object-Werte. Wertetypen leben typischerweise inline (oft auf dem Stack oder eingebettet in andere Strukturen), was Speicherzugriffe eng und vorhersehbar hält.

Wenn du ref verwendest (z. B. ref object), erzeugst du eine zusätzliche Indirektion: der Wert liegt meist auf dem Heap und wird über einen Zeiger manipuliert. Das ist nützlich für geteilte, langlebige oder optionale Daten, kann aber in heißen Schleifen Overhead durch Pointer-Dereferenzierung erzeugen.

Faustregel: Bevorzuge plain object-Werte für performance-kritische Daten; nutze ref, wenn du wirklich Referenzsemantik brauchst.

seq und string: praktisch, aber kostenbewusst

seq[T] und string sind dynamische, vergrößerbare Container. Sie sind großartig für Alltagsarbeit, können aber Allokationen und Reallokationen beim Wachsen verursachen. Kostenschemata, auf die du achten solltest:

- Anhängen kann gelegentlich eine Resize auslösen (Kopieren vorhandener Elemente)

- Viele kleine

seqs oder Strings erzeugen viele separate Heap-Blöcke

Wenn du Größen kennst: vorauffüllen (newSeq, setLen) und Puffer wiederverwenden, um Churn zu vermeiden.

Warum Layout wichtig ist: einfaches CPU-Cache-Modell

CPUs sind am schnellsten, wenn sie kontiguousen Speicher lesen können. Ein seq[MyObj], bei dem MyObj ein plain Wertobjekt ist, ist typischerweise cache-freundlich: Elemente liegen nebeneinander.

Ein seq[ref MyObj] dagegen ist eine Liste von Zeigern zu verstreuten Heapblöcken; Iteration darüber bedeutet Springen im Speicher, was langsamer ist.

Praktische Ratschläge für heiße Pfade

Für enge Schleifen und performance-sensitive Stellen:

- Bevorzuge

array (fixed-size) oder seq von Wertobjekten

- Halte häufig benutzte Felder zusammen in einem

object

- Vermeide „Pointer-Ketten“ (

ref in ref), wenn nicht nötig

Diese Entscheidungen halten Daten kompakt und lokal—genau das, was moderne CPUs mögen.

Abstraktionen, die wegkompilieren

React-Dashboard hinzufügen

Mach aus deinem CLI oder Service ein simples Web-Dashboard, das du mit deinem Team teilst.

Ein Grund, warum Nim hochsprachig wirkt ohne hohen Laufzeitpreis, ist, dass viele nette Sprachfeatures so gestaltet sind, dass sie in geradlinigen Maschinencode übergehen. Du schreibst ausdrucksvollen Code; der Compiler senkt ihn zu dichten Schleifen und direkten Aufrufen ab.

Was „Zero-Cost-Abstraktion“ in Nim heißt

Eine Zero-Cost-Abstraktion macht Code leichter lesbar oder wiederverwendbar, fügt aber keine zusätzliche Arbeit zur Laufzeit hinzu im Vergleich zur handgeschriebenen Low-Level-Variante.

Ein anschauliches Beispiel ist eine Iterator-ähnliche API zum Filtern von Werten, die letztlich immer noch als einfache Schleife im finalen Binary auftaucht.

proc sumPositives(a: openArray[int]): int =

for x in a:

if x > 0:

result += x

Auch wenn openArray flexibel und hochsprachig wirkt, kompiliert das typischerweise in einen einfachen indizierten Speicherzugriff (kein Python-Objekt-Overhead). Die API ist angenehm, aber der erzeugte Code ist nahe der offensichtlichen C-Schleife.

Inlining, Generics und Spezialisierung (in einfachen Worten)

Nim inlinet kleine Prozeduren aggressiv, wenn es hilft, sodass Aufrufe verschwinden und der Körper in den Aufrufer eingefügt wird.

Mit Generics schreibst du eine Funktion für mehrere Typen; der Compiler spezialisiert sie für jeden tatsächlich verwendeten Typ. Das liefert oft Code, der so effizient ist wie handgeschriebene, typ-spezifische Funktionen—ohne dass du Logik duplizieren musst.

„Schöne APIs“, die trotzdem zu dichten Schleifen werden

Muster wie kleine Helfer (mapIt, filterIt-Utilities), spezielle Typen und Bereichsprüfungen können optimiert werden, wenn der Compiler hindurchsehen kann. Das Endergebnis ist oft eine einzelne Schleife mit minimalen Branches.

Die große Warnung: Abstraktionen, die Allokationen erzwingen

Abstraktionen sind nicht mehr „kostenlos“, wenn sie Heap-Allokationen oder versteckte Kopien erzeugen. Wiederholt neue Sequenzen zurückzugeben, temporäre Strings in inneren Schleifen zu bauen oder große Closures zu capturen kann Overhead bringen.

Faustregel: Wenn eine Abstraktion pro Iteration allokiert, kann sie die Laufzeit dominieren. Bevorzuge stack-freundliche Daten, Pufferwiederverwendung und achte auf APIs, die stillschweigend seqs oder strings in heißen Pfaden erzeugen.

Interoperabilität mit C: Ökosysteme und Geschwindigkeit wiederverwenden

Ein praktischer Grund, warum Nim hochsprachig wirkt und trotzdem schnell bleibt, ist die direkte Aufrufbarkeit von C. Anstatt eine robuste C-Bibliothek neu zu schreiben, kannst du ihre Header in Nim beschreiben, die kompilierte Bibliothek linken und die Funktionen fast wie native Nim-Procs aufrufen.

Wie Nims C-FFI (grober Überblick) aussieht

Nims Foreign Function Interface beruht darauf, die gewünschten C-Funktionen und -Typen zu beschreiben. In vielen Fällen:

- deklarierst du die C-Symbole in Nim mit

importc (exakter C-Name), oder

- verwendest Tools, die Nim-Deklarationen aus C-Headern generieren

Danach linkt der Nim-Compiler alles in dasselbe native Binary, sodass der Aufruf-Overhead minimal ist.

Warum das wichtig ist: Wiederverwenden statt neu schreiben

So erhältst du Zugriff auf ausgereifte Ökosysteme: Kompression (zlib), Kryptoprimitive, Bild-/Audio-Codecs, Datenbankclients, OS-APIs und performancekritische Utilities. Du behältst Nims lesbare, Python-ähnliche Struktur für App-Logik und delegierst die schwere Arbeit an bewährtes C.

Fallen: Ownership und Konversionen

FFI-Bugs entstehen meist durch unterschiedliche Erwartungen:

- Ownership-Regeln: Wer alloziert und wer freed? Gibt eine C-Funktion einen Zeiger zurück, den du freigeben musst, brauchst du einen klaren Freigabepfad in Nim. Hält C einen Zeiger auf Speicher, den du übergeben hast, muss dieser Speicher weiterleben.

- Strings und Puffer: Nim-Strings sind keine C-Strings. Die Konversion zu

cstring ist einfach, aber du musst Nullterminierung und Lifetime sicherstellen. Für Binärdaten sind ptr uint8/Längenpaare oft vorzuziehen.

C-APIs sicher und testbar einhüllen

Ein gutes Muster ist eine kleine Nim-Wrapper-Schicht, die:

- idiomatische Nim-Procs und Typen exponiert,

- Konversionen und Fehlerbehandlung zentralisiert,

- rohe Zeiger hinter RAII-ähnlichen Helfern (

defer, Destruktoren) verbirgt, wo sinnvoll.

Das erleichtert Unit-Tests und reduziert die Chance, dass Low-Level-Details in den Rest des Codes „leaken".

Nim kann sich „von Haus aus“ schnell anfühlen, aber die letzten 20–50% hängen oft davon ab, wie du baust und misst. Die gute Nachricht: Nims Compiler bietet Performance-Kontrollen auf eine zugängliche Weise, auch wenn du kein System-Experte bist.

Wichtige Build-Modi

Für echte Performance-Vergleiche vermeide Debug-Builds. Starte mit einem Release-Build und füge Checks nur beim Debugging hinzu.

nim c -d:release --opt:speed myapp.nim

nim c -d:danger --opt:speed myapp.nim

nim c -d:release --opt:speed --passC:-march=native myapp.nim

Eine einfache Regel: Nutze -d:release für Benchmarks und Produktion, und -d:danger nur wenn du durch Tests abgesichert bist.

Profiling-Workflow: erst messen, dann optimieren

Ein praktischer Ablauf:

- End-to-end messen (Wall-Clock, Speicher, Durchsatz). Tools wie

hyperfine oder einfach time reichen oft.

- Hotspots finden. Nim unterstützt eingebautes Profiling (

--profiler:on) und spielt gut mit externen Profilern (Linux perf, macOS Instruments, Windows-Tools), weil du native Binaries erzeugst.

- Die heißesten 1–2 Funktionen optimieren, dann erneut messen. Wenn das Hotspot wandert, ist das Fortschritt.

Beim Einsatz externer Profiler kompiliere mit Debug-Info, um lesbare Stacktraces und Symbole zu bekommen:

nim c -d:release --opt:speed --debuginfo myapp.nim

Mikro-Optimierungen, die du meiden solltest

Es ist verführerisch, winzige Details vorzuziehen (manuelles Loop-Unrolling, Ausdrücke umstellen, „clevere" Tricks) bevor du Daten hast. In Nim kommen die größeren Gewinne meist von:

- besserem Algorithmus,

- Reduktion von Allokationen und Kopien,

- verbessertem Datenlayout (kontiguous statt verstreut),

- Reduzierung von Overhead in kritischen Schleifen.

CI-freundliche Benchmarks und Regressionschecks

Performance-Regressions lassen sich am einfachsten früh beheben. Ein leichter Ansatz ist eine kleine Benchmark-Suite (z. B. via Nimble-Task nimble bench) in CI auf einem stabilen Runner. Speichere Baselines (z. B. als JSON) und lasse den Build fehlschlagen, wenn Schlüsselmetriken über ein erlaubtes Delta driften. So bleibt „heute schnell" nicht plötzlich „nächsten Monat langsam".

Wo Nim glänzt (und wo nicht)

Bauen und Credits verdienen

Verdiene Credits, indem du deine Projekte mit Koder.ai teilst oder Kollegen einlädst.

Nim ist stark, wenn du Code willst, der wie eine hochsprachige Sprache liest, aber als einzelnes, schnelles Executable ausgeliefert wird. Es belohnt Teams, die Performance, einfache Deploys und geringe Abhängigkeiten schätzen.

Gute Einsatzfälle

Nim glänzt in „produktähnlicher" Software—Dingen, die du kompilierst, testest und verteilst:

- CLIs und Entwickler-Tools: ein natives Binary ausliefern, schneller Start, niedriger Startup-Overhead.

- Netzwerktools und Dienste: guter Durchsatz und vorhersehbare Latenz bei gut lesbarem Code.

- Game-Tooling und Pipelines: Asset-Konverter, Build-Tools, Editoren und Automation, wo Geschwindigkeit wichtig ist, aber C/C++-Komplexität vermieden werden soll.

Fälle, in denen Vorsicht geboten ist

Nim ist weniger ideal, wenn dein Erfolg von Laufzeit-Dynamik abhängt mehr als von kompilierter Performance:

- Starke dynamische Plugin-Systeme: viele zur Laufzeit geladene/entladene Drittanbieter-Extensions können friction erzeugen.

- Schnelle One-Off-Skripte: wenn dein Workflow „edit, run immediately, throw away" ist, sind Python oder Shell oft schneller für kleine Aufgaben.

Team-Erwägungen

Nim ist zugänglich, hat aber eine Lernkurve.

- Stimmt früh Stilkonventionen ab (Modulaufbau, Fehlerbehandlung, Namensgebung), damit nicht „jeder Nim anders schreibt".

- Onboarding planen: Pairing und ein kleines interness Guide helfen mehr als lange Docs.

- Sei realistisch bei Ecosystem-Lücken: es gibt Bibliotheken, aber nicht so umfangreich wie in Python.

Ein Pilotprojekt-Ansatz

Wähle ein kleines, messbares Projekt—z. B. das Umschreiben eines langsamen CLI-Schritts oder eines Netzwerktools. Definiere Erfolgsmetriken (Laufzeit, Speicher, Build-Zeit, Deploy-Size), liefere an eine kleine interne Zielgruppe und entscheide anhand der Ergebnisse, nicht des Hypes.

Wenn deine Nim-Arbeit eine Produktoberfläche braucht—Admin-Dashboard, Benchmark-Runner-UI oder API-Gateway—können Tools wie Koder.ai helfen, diese Teile schnell hochzuziehen. Du kannst eine React-Frontend und ein Go+Postgres-Backend „vibe-coden" und dein Nim-Binary per HTTP integrieren: den performance-kritischen Kern in Nim, das drumherum schnell gebaut.

Praktische Checkliste: Python-ähnlichen Code mit C-Geschwindigkeit

Nim verdient seinen Ruf „Python-ähnlich aber schnell", indem es lesbare Syntax mit einem optimierenden nativen Compiler, vorhersehbarer Speicherverwaltung (ARC/ORC) und Augenmerk auf Datenlayout und Allokationen kombiniert. Wenn du die Geschwindigkeitsvorteile willst ohne, dass dein Code in low-level Spaghetti ausartet, nutze diese Checkliste als wiederholbaren Workflow.

Speed-first Checkliste (ohne Klarheit zu opfern)

- Kompiliere bewusst: nutze Release-Builds für echte Messungen.

- Starte mit

-d:release und erwäge --opt:speed.

- Aktiviere Link-Time-Optimierungen, wenn passend (

--passC:-flto --passL:-flto).

- Wähle Datenstrukturen bewusst: einfache, zusammenhängende Repräsentationen bevorzugen.

seq[T] ist toll, aber enge Schleifen profitieren oft von Arrays, openArray und dem Vermeiden unnötiger Resizes.- Halte heiße Daten klein und eng beieinander; weniger Pointer = weniger Cache-Misses.

- Allokationsbewusst programmieren: ARC/ORC hilft, kann aber Arbeit, die du erzeugst, nicht entfernen.

- Puffer wiederverwenden, mit

newSeqOfCap vorallokieren, temporäre Strings in Schleifen vermeiden.

- Achte auf versteckte Kopien bei Slicing oder Konkatenation.

- Lass Abstraktionen wegkompilieren: schreibe sauberen Code und verifiziere ihn.

- Bevorzuge Iteratoren/Templates für Ausdruckskraft, bestätige aber das Inlining in Release-Builds.

- Messen bevor du „optimierst": profiliere, um echte Hotspots zu finden.

- Falls du neu beim Profiling bist, siehe /blog/performance-profiling-basics.

Nächste Schritte: beweis es auf deiner Maschine

- Mach ein kleines Benchmark: wähle eine Funktion mit realer Arbeit (Parsen, Filtern, Mathematik) und vergleiche Debug vs Release Builds.

- Ship ein reales Feature: implementiere ein kleines Modul Ende-zu-Ende und optimiere nur den heißen Pfad (nicht die gesamte Codebasis).

Wenn du noch zwischen Sprachen abwägst, hilft /blog/nim-vs-python, die Trade-offs einzuordnen. Für Teams, die Tooling- oder Support-Optionen evaluieren, kannst du auch /pricing prüfen.