Definieren Sie die Aufgabe des Assistenten und den MVP‑Scope

Eine „persönliche Assistenz‑App“ kann alles sein — von einer aufgebohrten To‑Do‑Liste bis zu einem Tool, das Kalenderkonflikte verhandelt und E‑Mails formuliert. Wenn Sie die Aufgabe nicht präzise definieren, bauen Sie am Ende eine Chat‑Demo, die beeindruckt, aber montags niemandem hilft.

Beginnen Sie damit, Ihre Zielgruppe und deren wiederkehrenden Schmerzpunkt zu benennen. Ein Gründer möchte vielleicht schnelle Meeting‑Vorbereitung und Nachfassaktionen; eine Studentin braucht Studienpläne und Notizaufnahme; ein Operations‑Manager möchte Task‑Triage und tägliche Statuszusammenfassungen. Je klarer die Zielgruppe, desto einfacher ist die Entscheidung, welche Tools Ihr Assistent braucht — und welche er absolut nicht braucht.

Wählen Sie 1–2 Journeys, die Wert beweisen

Ihr MVP sollte in einer einzelnen kurzen Sitzung ein nützliches Ergebnis liefern. Eine praktische Regel ist: der Nutzer erhält innerhalb von 60–120 Sekunden nach Öffnen der App einen Nutzen.

Zwei zuverlässige erste Journeys sind:

- Erfassen → Organisieren: Eine Aufgabe/Notiz mit Kontext hinzufügen, bestätigen, dass sie richtig gespeichert wurde, und sie dann in einer einfachen Liste sehen.

- Zusammenfassen → Entscheiden: Aus gespeicherten Items einen Tagesplan/eine Zusammenfassung erzeugen und dem Nutzer erlauben, zu akzeptieren, zu bearbeiten oder neu zu terminieren.

Beobachten Sie, was fehlt: langwieriges Onboarding, komplizierte Einstellungen oder tiefe Integrationen. Sie können trotzdem ein „Assistenten“-Gefühl simulieren, indem die Interaktion konversationell wirkt, die zugrunde liegenden Aktionen aber deterministisch bleiben.

Setzen Sie Nicht‑Ziele (und schreiben Sie sie auf)

Viele Assistenz‑Apps scheitern, weil sie am ersten Tag alles machen wollen: Spracheingabe, volle E‑Mail‑Sync, Schreibzugriff auf Kalender, autonome mehrstufige Aktionen und komplexe Agenten‑Setups. Legen Sie explizite Nicht‑Ziele für das MVP fest — keine Spracheingabe, keine bidirektionale E‑Mail‑Integration, keine autonome Hintergrundausführung und kein Cross‑Device‑Sync über einfache Konten hinaus. Das hält das Produkt ehrlich und reduziert früh Sicherheits‑ und Datenschutzrisiken.

Wählen Sie Erfolgsmetriken, die zur Aufgabe passen

Messen Sie das MVP nicht an der „Anzahl der Chats“. Messen Sie Ergebnisse:

- Time‑to‑first‑useful‑result: wie schnell Nutzer eine gespeicherte Aufgabe oder eine verwendbare Zusammenfassung erhalten.

- Qualität: wie oft extrahierte Aufgaben/Daten korrekt sind und wie oft Nutzer nachbearbeiten.

- Retention: ob Nutzer am nächsten Tag zurückkehren, um zu erfassen oder zu überprüfen.

Wenn Sie mit Vibe‑Coding auf einer Plattform wie Koder.ai arbeiten, machen klare Journeys und Metriken die Build‑Geschwindigkeit real: Sie können die ersten React/Flutter‑Screens und die Go/PostgreSQL‑Endpoints um zwei Kernschleifen herum planen und dann mithilfe von Snapshots und Rollback iterieren, wenn Änderungen die Ergebnisse nicht verbessern.

Produktdesign: UX‑Flows, die sich wie ein Assistent anfühlen

Eine persönliche Assistenz‑App gewinnt oder verliert am Gefühl der Interaktion. Nutzer sollten spüren, dass die App Absicht versteht, den nächsten hilfreichen Schritt anbietet und sich zurückhält, wenn sie nur eine schnelle Antwort wollen.

Beginnen Sie mit alltäglichen Aktionen des Assistenten

Die meisten Assistenten gewinnen Vertrauen, indem sie wenige Kernaufgaben zuverlässig erledigen: Anfragen verstehen, „Gedächtnis“ speichern (Präferenzen und leichte Profilfakten), Aufgaben und Erinnerungen managen und schnelle Zusammenfassungen erzeugen (Notizen, Meetings oder längere Nachrichten). Produktdesign macht diese Fähigkeiten offensichtlich, ohne die App in ein Labyrinth zu verwandeln.

Eine nützliche Regel: Jede Assistenten‑Fähigkeit sollte sowohl (1) einen konversationellen Pfad haben (z. B. „erinnere mich morgen um 9“) als auch (2) eine sichtbare UI‑Oberfläche zur Überprüfung und Bearbeitung (eine Erinnerungs‑Liste, die man überfliegen kann).

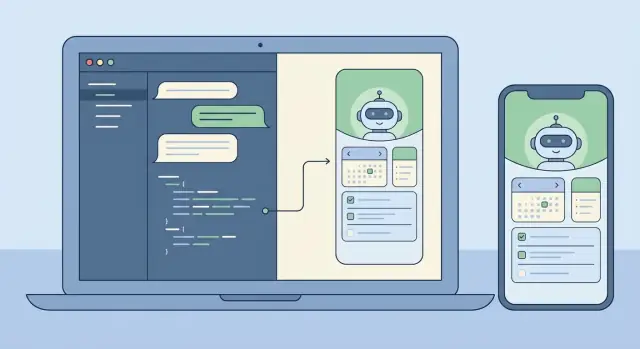

Wählen Sie einen Interaktionsstil: Chat‑first vs UI‑first

Chat‑first funktioniert am besten, wenn Ihre Zielgruppe Geschwindigkeit und Flexibilität schätzt: ein Composer, Nachrichtenverlauf und ein paar smarte Shortcuts.

UI‑first mit Chat als Helfer eignet sich besser, wenn Nutzer viele Items verwalten und Struktur brauchen. In diesem Modell öffnet die App in einer „Tasks“‑ oder „Today“‑Ansicht, und Chat ist ein kontextuelles Werkzeug für Änderungen (z. B. „verschiebe alles, was heute fällig ist, auf morgen").

Sie müssen nicht für immer wählen, aber treffen Sie früh eine Standard‑Startseite und ein Standard‑Mentalmodell.

Entwerfen Sie Sicherheit in den Flow (bestätigen + rückgängig)

Assistenten führen oft Aktionen aus, die unwiderruflich wirken: eine Notiz löschen, eine Nachricht senden, etwas absagen oder viele Aufgaben gleichzeitig bearbeiten. Behandeln Sie diese als riskant. Die UX sollte einen klaren Bestätigungsschritt mit einer in klarem, einfachem Text formulierten Zusammenfassung dessen, was passieren wird, verwenden, plus eine sofortige Rückgängig‑Option nach Abschluss.

Ein starkes Muster ist: Vorschau → Bestätigen → Ausführen → Rückgängig. In der Vorschau entdecken Nutzer Fehler („An Alex senden?“ „12 Aufgaben löschen?“).

Skizzieren Sie die minimale Menge an Screens

Halten Sie die erste Version klein und kohärent. Ein praktisches Minimum ist: Onboarding (was die App kann + Berechtigungen), Chat, Tasks/Erinnerungen, Memory (was gespeichert ist, mit Bearbeiten/Löschen), Einstellungen (Benachrichtigungen, Ton, Datenschutz) und eine leichte History/Audit‑Ansicht.

Wenn Sie Vibe‑Coding verwenden (z. B. Koder.ai), lassen sich diese Screens sauber auf ein MVP abbilden, das Sie schnell erzeugen und dann anhand echter Flows wie „Aufgabe erfassen“, „Erinnerung setzen“ und „Fehler rückgängig machen“ verfeinern können.

Prompting und Verhaltensdesign (ohne Überengineering)

Ein guter Assistent wirkt konsistent, vorhersehbar und sicher — mehr wie eine hilfreiche Kollegin als ein zufälliger Textgenerator. Das erreichen Sie schneller, wenn Sie Prompting einfach, geschichtet und testbar halten.

Verwenden Sie eine klare Nachrichten‑Hierarchie

Behandeln Sie Ihre Prompts als drei Schichten, jede mit unterschiedlichem Zweck:

- System‑Instruktionen definieren Identität und Nicht‑Verhandelbares (Ton, Sicherheit, Datenschutzhaltung, Umgang mit Unsicherheit).

- Developer‑Regeln definieren Produktverhalten (unterstützte Funktionen, Tool‑Nutzungsregeln, Ausgabeformat‑Verträge, was geloggt wird).

- User‑Messages sind die sich ändernden Anfragen.

Diese Trennung verhindert, dass eine Nutzeranweisung („ignorier vorherige Instruktionen“) versehentlich das Verhalten überschreibt, das Ihr Assistent einhalten muss.

Ihr Assistent wirkt vertrauenswürdiger, wenn er genau weiß, wann er handeln darf und wann er fragen muss. Entscheiden Sie, welche Operationen Lesezugriff sind (sicher automatisch, z. B. Notizen durchsuchen), welche Schreibaktionen sind (Aufgaben erstellen/aktualisieren, Erinnerungen planen) und welche unwiderruflich oder teuer sind (Daten löschen, externe Dienste kontaktieren, Informationen teilen).

Für Schreib‑ und irreversible Aktionen verlangen Sie eine Bestätigung: das Modell schlägt einen Aktionsplan vor und wartet dann auf ausdrückliche Genehmigung.

Bevorzugen Sie strukturierte Ausgaben für Aktionen

Wenn das Modell eine Aufgabe oder Erinnerung erstellen muss, ist Fließtext fragil. Nutzen Sie JSON‑„Action‑Objects“ und validieren Sie sie vor der Ausführung. Fordern Sie Felder wie action, title, due_at, priority und timezone und lehnen Sie ab oder fragen Sie nach, wenn etwas fehlt. So bleibt Ihr Backend deterministisch, auch wenn die Formulierungen des Modells variieren.

Fügen Sie leichte Leitplanken hinzu

Guardrails müssen nicht kompliziert sein. Ergänzen Sie eine kurze Richtlinie für sensible Anfragen (Selbstverletzung, illegale Aktivitäten, Zugriff auf private Daten) und definieren Sie Ablehnungs‑Muster, die dennoch hilfreich wirken: anerkennen, ablehnen und sichere Alternativen anbieten. Weisen Sie das Modell an, „Ich weiß es nicht“ zu sagen, wenn Informationen fehlen, und statt zu raten eine klärende Frage zu stellen.

Bauen Sie eine kleine Prompt‑Bibliothek

Statt eines Mega‑Prompts behalten Sie eine kleine Menge wiederverwendbarer Verhaltensweisen, die Ihr Assistent intern „aufrufen“ kann: ein Gespräch in nächste Schritte zusammenfassen, einen Plan mit Annahmen und offenen Fragen entwerfen, eine Anfrage auf fehlende Details prüfen, eine Nachricht in einem bestimmten Ton umschreiben und Aufgaben/Events in JSON extrahieren. Das ist der Sweetspot: konsistentes Verhalten, einfaches Testen und keine prompt‑Spaghetti.

Ein persönlicher Assistent wirkt „smart“, wenn er zwei Dinge gut kann: natürlich sprechen und zuverlässige Aktionen ausführen. Der schnellste Weg ist, Konversation (LLM‑Reasoning) von Ausführung (Tools, die Ihre echten Systeme aufrufen) zu trennen.

Zwei praktikable Muster

Für ein MVP starten Sie mit einem einzigen LLM + Tools‑Muster: ein Modell erhält die Nutzer‑Nachricht, entscheidet, ob es in Text antwortet oder ein Tool aufruft, und liefert dann ein Ergebnis zurück. Das ist einfacher zu debuggen und reicht oft für Task‑Capture, Notizsuche und Erinnerungen.

Mit wachsender Komplexität wird ein Koordinator + Spezialisten‑Agenten‑Muster nützlich. Ein Koordinator interpretiert die Anfrage und delegiert an Spezialisten (z. B. ein Tasks‑Agent vs. ein Notes‑Agent), jeweils mit engeren Instruktionen und weniger Tools. Das reduziert versehentliche Tool‑Nutzung und verbessert Konsistenz, wenn Sie Integrationen hinzufügen.

Tools sind kleine, deterministische APIs, die der Assistent aufrufen kann. Halten Sie Tool‑Inputs strikt und Outputs strukturiert, damit Sie sie validieren und protokollieren können.

Gängige Tools sind: Aufgabe erstellen/aktualisieren/abschließen, Notizsuche (Schlüsselwort + Zeitfilter), Erinnerungsplanung (Zeit, Kanal, Wiederholung), Präferenzabfrage (Zeitzone, Arbeitszeiten), optional Agenda‑Lesen (bei Kalenderintegration) und Audit‑Event‑Schreibungen.

Planungsmodus vor der Ausführung

Fügen Sie vor der Ausführung einen expliziten Planungsmodus ein: das Modell schreibt einen kurzen Plan und wählt dann Tools aus, um ihn auszuführen. Planung hilft bei mehrstufigen Anfragen wie „Verschiebe meine Projektaufgaben auf nächste Woche und erinnere mich am Montag“, wo der Assistent Annahmen (Zeitzone, was als „Projektaufgaben“ zählt) bestätigen sollte, bevor er handelt.

Aktionsfreigabe, um Überraschungen zu vermeiden

Jedes Tool, das Nebeneffekte verursacht (Aufgaben erstellen, Erinnerungen senden, Daten ändern), sollte ein Action‑Approval‑Gate durchlaufen. In der Praxis schlägt das Modell einen Aktionsentwurf vor (Tool‑Name + Parameter + erwartetes Ergebnis) und Ihre App bittet den Nutzer um Bestätigung oder Bearbeitung. Dieser einzelne Checkpoint reduziert unbeabsichtigte Änderungen deutlich und macht den Assistenten vertrauenswürdig.

Wenn Sie eine Vibe‑Coding‑Plattform wie Koder.ai verwenden, können Sie diese Architektur schnell implementieren, indem Sie Tool‑Schnittstellen, Koordinator‑Logik und Approval‑UI als separate, testbare Komponenten erstellen — und dann per Snapshots und Rollback verfeinern.

Memory und Kontext: Was speichern, was abrufen

Ein persönlicher Assistent wirkt „smart“, wenn er sich an das Richtige erinnert und den Rest vergisst. Die Kunst besteht darin, zu trennen, was das Modell für Kohärenz braucht, von dem, was Sie für den Nutzer speichern. Wenn Sie alles speichern, erhöhen Sie Datenschutzrisiko und Retrieval‑Rauschen. Wenn Sie nichts speichern, wird der Assistent repetitiv und brüchig.

Kurzzeit‑ vs. Langzeitgedächtnis

Behandeln Sie die letzte Konversation als Kurzzeitgedächtnis: ein rollierendes Fenster der letzten Turns plus das aktuelle Nutzerziel. Fassen Sie aggressiv zusammen, damit Sie nicht unnötige Token‑Kosten zahlen oder frühere Fehler verstärken.

Langzeitgedächtnis ist für Fakten, die Sitzungen überdauern sollten: Präferenzen, stabile Profildetails, Aufgaben und Notizen, die der Nutzer wiederfinden möchte. Speichern Sie diese zuerst als strukturierte Daten (Tabellen, Felder, Zeitstempel) und verwenden Sie Freitext‑Snippets nur, wenn sich etwas nicht sauber abbilden lässt.

Was sich zu speichern lohnt

Ein praktischer Startpunkt ist, Informationen zu speichern, die entweder vom Nutzer verfasst oder vom Nutzer genehmigt wurden: Profil und Präferenzen (Zeitzone, Arbeitszeiten, Ton, Standard‑Erinnerungen), Aufgaben und Projekte (Status, Fälligkeit, Wiederholung, Priorität), Notizen und Highlights (Entscheidungen, Verpflichtungen, wichtiger Kontext) sowie Tool‑Ergebnisse plus Audit‑Trail.

Konversations‑Highlights sind wichtiger als volle Transkripte. Statt alles zu speichern, was gesagt wurde, bewahren Sie dauerhafte Fakten wie: „Nutzer bevorzugt prägnante Zusammenfassungen“, „Flug nach NYC ist am Freitag“, „Budget‑Limit ist $2.000“.

Retrieval, das sich sofort (und vorhersehbar) anfühlt

Planen Sie Retrieval nach menschlicher Suchlogik: Schlüsselwörter, Zeitbereiche, Tags und „kürzlich geändert“. Verwenden Sie zuerst deterministische Filter (Datum, Status, Tags) und fügen Sie semantische Suche auf Notizkörpern hinzu, wenn die Anfrage unscharf ist.

Um Halluzinationen zu vermeiden, sollte der Assistent nur auf das zurückgreifen, was er tatsächlich abgerufen hat (Record‑IDs, Zeitstempel) und eine klärende Frage stellen, wenn nichts Relevantes gefunden wurde.

Nutzerkontrollen und Vertrauen

Machen Sie Memory transparent. Nutzer sollten sehen können, was gespeichert ist, es bearbeiten, exportieren und löschen — besonders Langzeitfakten. Wenn Sie mit einem Vibe‑Coding‑Workflow wie Koder.ai bauen, formt ein frühes „Memory Settings“‑Screen sowohl UX als auch Ihr Datenmodell.

Frontend‑Build: Web (React) und Mobile (Flutter)

Mit Snapshots iterieren

Speichere einen Arbeitszustand vor größeren Änderungen an Prompt, Tools oder UI.

Ein persönlicher Assistent lebt oder stirbt durch die Oberfläche. Wählen Sie den Stack basierend darauf, wo Menschen die App tatsächlich nutzen: Web ist oft der schnellste Weg zur „Daily‑Driver“‑Nützlichkeit, während Mobile sich auszahlt, wenn Benachrichtigungen, Spracheingabe und On‑the‑Go‑Erfassung wichtig sind.

Ein praktischer Ansatz ist, mit React für die Web‑UI zu starten (schnelle Iteration, einfache Bereitstellung) und dasselbe Interaktionsmodell in Flutter abzubilden, sobald die Kernschleife des Assistenten funktioniert.

Eine Chat‑UI, die sich wie ein Produkt verhält (nicht wie eine Demo)

Behandeln Sie Chat als strukturierte Konversation, nicht nur Textblasen. Unterstützen Sie mehrere Nachrichtentypen, damit Nutzer verstehen, was passiert und was Sie von ihnen erwarten: Nutzer‑Messages, Assistenten‑Replies (inklusive gestreamtem Text), Tool‑Aktionen („Creating task…“), Bestätigungen (approve/deny), Fehler (mit Retry‑Optionen) und System‑Hinweise (offline, Rate‑Limits, eingeschränkte Fähigkeit).

In React können gestreamte Antworten den Assistenten reaktionsschneller wirken lassen; halten Sie das Rendering effizient: fügen Sie Deltas an, vermeiden Sie komplettes Re‑Rendering des Transkripts und erhalten Sie Scroll‑Verhalten, das Nutzern das Lesen älterer Nachrichten ermöglicht.

„Denken“‑Zustände ohne interne Details offenzulegen

Nutzer brauchen Feedback, nicht Ihre internen Prompts oder Tool‑Ketten‑Details. Verwenden Sie neutrale Indikatoren wie „Arbeite daran“ oder „Prüfe Ihre Notizen“ und zeigen Sie nur nutzersichere Meilensteine (gestartet, wartet auf Bestätigung, fertig). Das wird noch wichtiger, wenn Sie Multi‑Agent‑Workflows hinzufügen.

Einstellungen, die Verhalten steuerbar machen

Fügen Sie früh eine Einstellungsseite hinzu, auch wenn sie einfach ist. Lassen Sie Leute Ton (professionell vs locker), Ausführlichkeit (kurz vs detailliert) und Datenschutzoptionen (Chats speichern, Aufbewahrungsdauer, ob Memory‑Funktionen aktiviert sind) steuern. Diese Optionen reduzieren Überraschungen und helfen bei Compliance‑Anforderungen.

Wenn Sie Vibe‑Coding mit Koder.ai verwenden, können Sie sowohl die React‑Web‑UI als auch die Flutter‑Screens aus demselben Produkt‑Intent erzeugen und dann schnell an Gesprächskomponenten, Streaming und Einstellungen iterieren, ohne in UI‑Plumbing stecken zu bleiben.

Backend‑Fundamente: APIs, Auth und deterministische Ausführung

Eine persönliche Assistenz wirkt im UI magisch, aber auf dem Backend wird sie vertrauenswürdig. Ziel ist, chatgetriebenes Verhalten vorhersehbar zu machen: das Modell kann Aktionen vorschlagen, aber Ihr Server entscheidet, was tatsächlich passiert.

APIs, die Nutzer‑Intent abbilden

Übersetzen Sie Assistenten‑Fähigkeiten in eine kleine Menge stabiler Endpunkte. Halten Sie Chat als Einstiegspunkt und bieten Sie explizite Ressourcen für alles, was der Assistent verwalten kann. Zum Beispiel kann der Assistent eine Aufgabe entwerfen, aber der finale create‑task‑Aufruf sollte eine normale API‑Anfrage mit striktem Schema sein.

Eine kompakte Oberfläche, die gut skaliert, umfasst Chat (Senden/Empfangen plus optionale Tool‑Requests), Tool‑Execution (ausgeführte genehmigte Tools und strukturierte Ergebnisse), Tasks CRUD (mit serverseitiger Validierung), Präferenzen und Job/Status‑Endpoints für lang laufende Arbeiten.

Auth und Sessions: früh entscheiden

Authentifizierung ist am einfachsten früh hinzuzufügen und schmerzhaft nachträglich. Definieren Sie, wie eine Nutzersitzung dargestellt wird (Tokens oder Server‑Sessions) und wie Anfragen scopebar sind (User‑ID, Org‑ID für Teams). Entscheiden Sie, was der Assistent „still“ tun darf und was Re‑Authentifizierung oder Bestätigung erfordert.

Wenn Sie Tiers planen (Free/Pro/Business/Enterprise), erzwingen Sie Berechtigungen bereits an der API‑Schicht (Rate‑Limits, Tool‑Verfügbarkeit, Export‑Rechte), nicht in Prompts.

Lang laufende Jobs: Queue, nicht blockieren

Zusammenfassungen großer Inhalte, Importe oder mehrstufige Agenten‑Workflows sollten asynchron laufen. Antworten Sie schnell mit einer Job‑ID und bieten Sie Fortschrittsupdates (queued → running → partial results → completed/failed). Das hält Chat responsiv und vermeidet Timeouts.

Deterministische Ausführung: Modelle schlagen vor, Server entscheidet

Behandeln Sie Modell‑Outputs als untrusted Input. Validieren und säubern Sie alles: strikte JSON‑Schemas für Tool‑Aufrufe, Ablehnung unbekannter Felder, Typ/Range‑Prüfungen, serverseitige Datum/Zeitzonen‑Normalisierung und Logging von Tool‑Requests/Ergebnissen für Audit‑Zwecke.

Plattformen wie Koder.ai können das Scaffolding beschleunigen (Go‑APIs, PostgreSQL‑Backing, Snapshots/Rollback), aber das Prinzip bleibt: der Assistent darf in der Konversation kreativ sein, das Backend bleibt langweilig, strikt und zuverlässig.

Datenmodell in PostgreSQL: Tasks, Notes und Auditability

Bestätigen und Rückgängig hinzufügen

Führe Vorschau-Bestätigungs-Rückgängig-Abläufe ein, damit Aktionen nie überraschend wirken.

Ein persönlicher Assistent wirkt „smart“, wenn er zuverlässig erinnert, erklären kann, was er getan hat, und Fehler rückgängig macht. Ihr PostgreSQL‑Schema sollte das von Anfang an unterstützen: klare Kernentitäten, explizite Provenienz (woher jedes Item stammt) und auditfreundliche Zeitstempel.

Kernentitäten modellieren (und warum)

Beginnen Sie mit einer kleinen Menge Tabellen, die Nutzererwartungen abbilden: users, conversations/messages, tasks/reminders, notes und (optional) embeddings für Retrieval bei größerem Maßstab. Trennen Sie tasks/notes von messages: messages sind das rohe Transkript; tasks/notes sind die strukturierten Outcomes.

Provenienz: „Welche Nachricht hat das erstellt?“

Behandeln Sie Provenienz als erstklassiges Feature. Wenn das LLM eine Anfrage in eine Aufgabe umwandelt, speichern Sie eine source_message_id auf tasks/notes, erfassen Sie, wer es erstellt hat (user, assistant oder system) und hängen Sie eine tool_run_id an, wenn Sie Tools/Agenten verwenden. Das macht Verhalten erklärbar („Erstellt aus Ihrer Nachricht am Dienstag um 10:14“) und beschleunigt das Debugging.

Audit‑freundliche Felder und Soft‑Delete

Verwenden Sie konsistente Spalten über Tabellen hinweg: created_at, updated_at und häufig deleted_at für Soft‑Deletes. Soft‑Delete ist besonders nützlich, weil Nutzer oft rückgängig machen wollen und Sie Daten für Compliance oder Troubleshooting bewahren müssen.

Erwägen Sie unveränderliche Identifikatoren (uuid) und eine append‑only Audit‑Log‑Tabelle für Schlüsselerereignisse (task erstellt, Fälligkeitsdatum geändert, Erinnerung ausgelöst). Das ist einfacher, als Historie aus geänderten Zeilen rekonstruieren zu müssen.

Migrationen und Schema‑Evolution

Assistentenverhalten ändert sich schnell. Planen Sie Migrationen früh: versionieren Sie Ihr Schema, vermeiden Sie destruktive Änderungen und bevorzugen Sie additive Schritte (neue Spalten, neue Tabellen). Wenn Sie Vibe‑Coding mit Koder.ai nutzen, koppeln Sie Snapshots/Rollback an Datenbank‑Migrationsdisziplin, damit Sie iterieren können, ohne Datenintegrität zu verlieren.

CREATE TABLE tasks (

id uuid PRIMARY KEY,

user_id uuid NOT NULL,

title text NOT NULL,

status text NOT NULL,

due_at timestamptz,

source_message_id uuid,

created_by text NOT NULL,

created_at timestamptz NOT NULL DEFAULT now(),

updated_at timestamptz NOT NULL DEFAULT now(),

deleted_at timestamptz

);

Testen und Evaluieren: Machen Sie es zuverlässig

Zuverlässigkeit ist der Unterschied zwischen einer coolen Demo und einem Assistenten, dem Leute echte Arbeit anvertrauen. Das Schwierige ist: Nutzeranfragen sind selten ordentlich: kurz, emotional, inkonsistent und oft ohne Schlüsseldetails. Ihre Teststrategie sollte diese Realität widerspiegeln.

Erstellen Sie ein Testset, das dem echten Leben ähnelt

Sammeln (oder schreiben) Sie eine kleine, aber repräsentative Menge Anfragen: kurze Nachrichten, vage Anweisungen, Tippfehler, widersprüchliche Einschränkungen und Last‑Minute‑Änderungen. Einschließen: Happy Paths (klare Aufgabenerstellung, Notizaufnahme) und Edge Paths (fehlende Daten, mehrdeutige Pronomen, mehrere Personen mit demselben Namen, Anfragen, die Berechtigungen implizieren).

Bewahren Sie diese Beispiele als Ihren goldenen Satz auf. Führen Sie ihn bei jeder Änderung an Prompts, Tools oder Agentenlogik aus.

Definieren Sie „gut“ (über richtige Antworten hinaus)

Für Assistenz‑Apps geht Korrektheit über den finalen Text hinaus. Bewerten Sie, ob die richtige Aktion ausgeführt wurde, ob bei Bedarf nach Bestätigung gefragt wurde und ob erfundene Tool‑Ergebnisse vermieden wurden.

Ein praktisches Rubric prüft: Aufgaben‑Korrektheit, Bestätigungs‑Verhalten (besonders vor Löschungen/Sends/Ausgaben), halluzinierte Aktionen (Behauptung der Ausführung ohne Tool‑Run), Tool‑Disziplin (benutzt Tools wenn nötig; vermeidet unnötige Aufrufe) und Wiederherstellung (klare Fehler‑ und Retry‑Handhabung).

Jeder Prompt‑Tweak kann Verhalten überraschend verschieben. Behandeln Sie Prompts wie Code: versionieren Sie sie, führen Sie den goldenen Satz aus und vergleichen Sie Ergebnisse. Wenn Sie mehrere Agenten einsetzen (Planer/Executor), testen Sie jede Phase—viele Fehler beginnen als Planungsfehler, der sich ausbreitet.

Beim Hinzufügen eines neuen Tools oder Ändern eines Tool‑Schemas fügen Sie gezielte Regressionsfälle hinzu (z. B. „erstelle eine Aufgabe für nächsten Freitag“ sollte weiterhin Daten konsistent auflösen). Wenn Ihr Workflow Snapshots und Rollback unterstützt, nutzen Sie sie, um bei sinkender Evaluationsqualität schnell zurückzugehen.

Instrumentierung ohne Geheimnisse zu leaken

Loggen Sie Tool‑Aufrufe, redigierte Argumente, Timings und Fehlergründe, damit Sie beantworten können: „Was hat das Modell zu tun versucht?“ und „Warum ist es fehlgeschlagen?“ Redigieren Sie Tokens, persönliche Daten und Message‑Inhalte standardmäßig und speichern Sie nur, was zum Debuggen nötig ist — oft reichen ein gehashter User‑ID, Tool‑Name, hohes Intent‑Label und Fehlerklasse.

Gut gemacht verwandelt Testen Iteration in eine kontrollierte Schleife: Sie können schneller vorankommen, ohne Vertrauen zu zerstören.

Sicherheit, Datenschutz und Compliance

Eine persönliche Assistenz‑App wird schnell zu einem Container für sensible Inhalte: Kalender, Standorte, Nachrichten, Dokumente und allerlei Notizen, die Nutzer nicht teilen wollten. Behandeln Sie Datenschutz als Produktfeature, nicht als Checkliste. Minimieren Sie, was Sie sammeln und was Sie an ein LLM senden. Wenn eine Funktion keine gesamte Chat‑Historie benötigt, speichern/senden Sie sie nicht; wenn eine Anfrage mit einer kurzen Zusammenfassung beantwortet werden kann, senden Sie nur die Zusammenfassung.

Datenminimierung, Aufbewahrung und Nutzerkontrollen

Definieren Sie Retention von Anfang an: was Sie speichern (Tasks, Notes, Präferenzen), warum und wie lange. Machen Sie Löschung real und nachprüfbar: Nutzer sollten einzelne Notizen, einen ganzen Workspace und hochgeladene Dateien löschen können. Erwägen Sie einen „vergesslichen Modus“ für sensible Gespräche, in dem Sie keine Inhalte persistieren — nur minimale Metadaten für Abrechnung und Missbrauchs‑Prävention.

Secrets, Tokens und Verschlüsselung

Versenden Sie API‑Schlüssel niemals an den Client. Bewahren Sie Provider‑Keys und Tool‑Credentials auf dem Server, rotieren Sie sie und scope sie pro Umgebung. Verschlüsseln Sie Daten in Transit (TLS) und at rest (Datenbank und Backups). Für Session‑Tokens verwenden Sie kurze Laufzeiten und Refresh‑Flows; speichern Sie Hashes, wo möglich, und vermeiden Sie standardmäßiges Logging von rohen Prompts oder Tool‑Outputs.

Geografische Hosting‑ und Compliance‑Anforderungen

Einige Nutzer benötigen Datenresidenz (bestimmte Länder/Regionen), besonders Arbeitsplatz‑Assistenten. Planen Sie regionsbewusste Bereitstellung früh: halten Sie Nutzerdaten in einer regionskonformen Datenbank und vermeiden Sie cross‑region Pipelines, die Inhalte still kopieren. Koder.ai läuft global auf AWS und kann Anwendungen in spezifischen Ländern hosten, was Residenz‑ und grenzüberschreitende Übertragungsanforderungen vereinfachen kann, falls nötig.

Missbrauchsschutz und Prompt‑Injection‑Verteidigungen

Assistenten sind Magneten für Missbrauch: Scraping, Credential‑Stuffing und „bring das Modell dazu, Geheimnisse zu verraten“‑Angriffe. Eine praktische Basis umfasst Rate‑Limits und Quotas, Erkennung verdächtiger Aktivitäten, strikte Tool‑Berechtigungen (Allow‑List + serverseitige Validierung), Prompt‑Injection‑Hygiene (behandle externen Text als untrusted; isolier ihn von System‑Regeln) und Audit‑Logs für Tool‑Ausführungen und Datenzugriffe.

Das Ziel ist vorhersehbares Verhalten: das Modell kann Aktionen vorschlagen, aber Ihr Backend entscheidet, was erlaubt ist.

Deployment, Monitoring und sicheres Iterieren

Deine Kern-Tabellen modellieren

Beginne mit Aufgaben, Notizen und Audit-Logs mit klaren Herkunftsfeldern.

Das Ausliefern einer persönlichen Assistenz‑App ist kein einzelner Launch‑Moment. Es ist ein Zyklus: klein ausliefern, reales Nutzungsverhalten beobachten, Verhalten straffen und wiederholen — ohne Vertrauen zu brechen. Weil Assistenten‑Verhalten sich durch Prompt‑Tweaks oder neue Tool‑Integrationen ändern kann, brauchen Sie Deployment‑Disziplin, die Konfiguration und Prompts wie Produktionscode behandelt.

Schrittweise ausliefern mit Feature‑Flags

Gehen Sie davon aus, dass jede neue Fähigkeit auf unerwartete Weise fehlschlagen kann: Zeitzonen‑Bugs, Memory, das falsche Detail speichern, oder ein Modell, das kreativer wird als gewünscht. Feature‑Flags erlauben es, neue Tools und Memory‑Verhalten nur einer kleinen Nutzergruppe (oder internen Accounts) freizugeben, bevor Sie breitlaunchen.

Eine einfache Strategie: jedes Tool integrieren hinter einem Gate, Memory‑Writes getrennt von Reads freischalten, Planungsmodus‑Ausgaben nur für Tester aktivieren, einen „Safe Mode“ anbieten, der Tool‑Aufrufe deaktiviert (nur Lese‑Kontext), und prozentuale Rollouts für riskante Änderungen.

Rollback ist obligatorisch: Snapshots von Prompts und Konfiguration

Traditionelle Apps rollen Binaries zurück; Assistenten‑Apps müssen Verhalten zurückrollen können. Behandeln Sie System‑Prompts, Tool‑Schemas, Routing‑Regeln, Sicherheits‑Policies und Memory‑Filter als versionierbare Deployables. Bewahren Sie Snapshots, um schnell zuletzt bekannte gute Verhaltensweisen wiederherzustellen.

Das ist besonders wertvoll, wenn Sie schnell mit Vibe‑Coding iterieren: Koder.ai unterstützt Snapshots und Rollback, was zu Assistenten passt, bei denen kleine Textänderungen große Produktwirkungen haben können.

Bereitstellungsstrategie und Custom Domains

Wenn Sie eine White‑Label‑Assistenz (für Teams oder Kunden) anbieten, planen Sie Custom‑Domains früh. Das beeinflusst Auth‑Callbacks, Cookie/Session‑Einstellungen, Rate‑Limits pro Tenant und wie Sie Logs/Daten trennen. Selbst für eine einzelne Marke definieren Sie Umgebungen (dev/staging/prod), damit Sie Tool‑Berechtigungen und Model‑Einstellungen sicher testen können.

Überwachen Sie, was zählt: Zuverlässigkeit, Geschwindigkeit und Kosten

Assistenten‑Monitoring ist Teil Produkt‑Analytics, Teil Betrieb. Verfolgen Sie Latenz und Fehler, aber auch Verhaltenssignale wie Kosten pro Konversation, Tool‑Aufruf‑Frequenz und Tool‑Fehlerquote. Kombinieren Sie Metriken mit stichprobenartigen Konversations‑Audits, damit Sie sehen, ob Änderungen Outcomes verbessert haben — nicht nur Durchsatz.

Schneller bauen mit Vibe‑Coding (Beispiel: Koder.ai‑Workflow)

Vibe‑Coding lohnt sich am meisten, wenn Sie einen echten Prototyp brauchen — nicht nur eine Präsentation. Für eine persönliche Assistenz‑App heißt das meist: eine Chat‑UI, ein paar Kernaktionen (Aufgabe erfassen, Notiz speichern, Erinnerung planen) und ein Backend, das deterministisch bleibt, auch wenn das LLM kreativ ist. Eine Vibe‑Coding‑Plattform komprimiert die Zeit bis zur ersten funktionierenden Version, indem sie Ihre Produktbeschreibung in laufende Screens, Routes und Services übersetzt.

Ein praktischer Koder.ai‑ähnlicher Workflow

Beginnen Sie damit, den Assistenten in einfacher Sprache im Chat zu beschreiben: für wen er ist, was er tun kann und was „fertig“ für das MVP bedeutet. Iterieren Sie in kleinen Schritten.

Erzeugen Sie zuerst eine React‑Weboberfläche (Konversationsansicht, Composer, ein leichtes „Tools used“‑Panel und eine einfache Einstellungen‑Seite), dann eine Flutter‑Mobile‑Version, sobald die Flows stimmen.

Erzeugen Sie anschließend ein Go‑Backend mit PostgreSQL: Authentifizierung, eine minimale API für Konversationen und Tool‑Endpoints (create task, list tasks, update task). Halten Sie das LLM‑Verhalten als dünne Schicht: System‑Instruktionen, Tool‑Schema und Guardrails. Iterieren Sie dann Prompts und UI gemeinsam: wenn der Assistent eine falsche Annahme trifft, passen Sie den Behavior‑Text an und fügen Sie einen Bestätigungsschritt in die UX ein.

Features, die beim schnellen Iterieren zählen

Priorisieren Sie Beschleuniger, die Experimente sicher halten: Planungsmodus (vorschlagen bevor angewendet wird), Snapshots und Rollback (schnelle Wiederherstellung bei schlechten Iterationen), Deployment und Hosting mit Custom Domains (schneller Stakeholder‑Zugriff) und Source‑Code‑Export (volle Eigentümerschaft und späterer Pipeline‑Umzug).

Nächste Schritte Checkliste

Bevor Sie über das MVP hinaus skalieren, legen Sie fest:

- Ein einseitiges MVP‑Spec (3–5 Nutzeraufgaben, Nicht‑Ziele, Erfolgskriterien)

- Ihre Tool‑Liste (was der Assistent per API tun darf)

- Ein kleines Evaluationsset (20–50 Szenarien + erwartete Outcomes)

- Einen Deployment‑Plan (Umgebungen, Secrets, Rollback‑Strategie, Monitoring)

Mit dieser Struktur kann Koder.ai (koder.ai) ein praktischer Weg sein, vom Konzept zu einer funktionierenden React/Go/PostgreSQL‑(und später Flutter‑)Assistenz zu kommen — schnell, testbar und reversibel.