Was Prompt-Klarheit bedeutet (und warum sie wichtig ist)

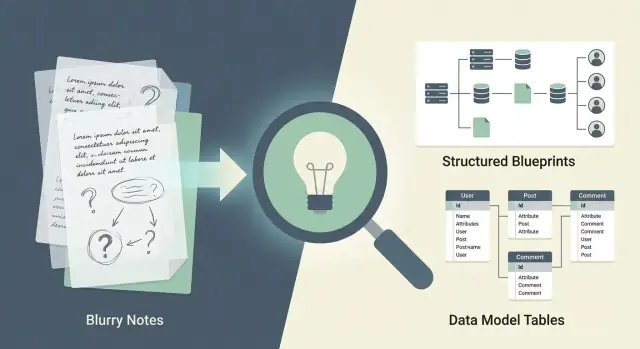

„Prompt-Klarheit“ heißt, dass du formulierst, was du willst, so dass wenig Raum für konkurrierende Interpretationen bleibt. In Produktbegriffen sieht das nach klaren Ergebnissen, Nutzern, Einschränkungen und Erfolgskriterien aus. In Ingenieursbegriffen wird daraus explizite Anforderungen: Eingaben, Ausgaben, Datenregeln, Fehlerverhalten und nicht-funktionale Erwartungen (Performance, Sicherheit, Compliance).

Die Kettenreaktion: Prompt → Code

Ein Prompt ist nicht nur Text, den du einer KI oder einem Teamkollegen gibst. Er ist der Samen des gesamten Builds:

- Prompt drückt Intent aus (welches Problem wir lösen und warum).\n- Anforderungen übersetzen Intent in testbare Aussagen.\n- Designentscheidungen verwandeln Anforderungen in Architekturentscheidungen (Services, Grenzen, APIs, Datenspeicher).\n- Code implementiert diese Entscheidungen – inklusive der dabei getroffenen Annahmen.

Ist der Prompt präzise, neigen die nachgelagerten Artefakte dazu, sich zu decken: weniger Diskussionen über „was meinten wir“, weniger Last-Minute-Änderungen und weniger Überraschungen bei Randfällen.

Warum Mehrdeutigkeit teuer ist

Mehrdeutige Prompts zwingen Menschen (und KI), Lücken mit Annahmen zu füllen – und diese Annahmen stimmen selten über Rollen hinweg. Die eine Person versteht unter „schnell“ Sub-Sekunden-Antworten; eine andere meint „schnell genug“ für einen Wochenbericht. Die eine Person zählt „Kunde“ auch Trial-Benutzer dazu; eine andere schließt sie aus.

Diese Diskrepanzen erzeugen Nacharbeit: Designs werden nach Beginn der Implementierung überarbeitet, Datenmodelle müssen migriert werden, APIs bekommen breaking changes, und Tests erfassen nicht die echten Akzeptanzkriterien.

Klarheit hilft, ist aber kein Zauber

Klare Prompts erhöhen die Wahrscheinlichkeit für saubere Architektur, korrekte Datenmodelle und wartbaren Code erheblich — sie garantieren es aber nicht. Du brauchst weiterhin Reviews, Abwägungen und Iteration. Der Unterschied ist, dass Klarheit diese Gespräche konkret (und günstiger) macht, bevor Annahmen sich in technische Schulden verfestigen.

Wie Klarheit die Architekturqualität beeinflusst

Wenn ein Prompt vage ist, füllt das Team (menschlich oder KI) Lücken mit Annahmen. Diese Annahmen verfestigen sich zu Komponenten, Servicegrenzen und Datenflüssen — oft bevor jemand bemerkt, dass überhaupt eine Entscheidung getroffen wurde.

Unklare Prompts schaffen fehlpassende Grenzen

Fehlt im Prompt die Aussage wer was besitzt, driftet die Architektur zu „was gerade funktioniert“. Du siehst ad-hoc-Services, die für eine einzelne Ansicht oder eine dringende Integration gebaut wurden, ohne stabiles Verantwortlichkeitsmodell.

Beispiel: Ein Prompt wie „Füge Abonnements hinzu“ kann stillschweigend Abrechnung, Berechtigungen und Kundenstatus in ein einziges Sammelmodul mischen. Später berührt jedes neue Feature dieses Modul, und die Grenzen spiegeln nicht mehr das echte Domänenmodell.

Frühe Entscheidungen sind teuer zurückzudrehen

Architektur ist pfadabhängig. Sobald du Grenzen gewählt hast, hast du auch entschieden:

- wo Validierung stattfindet

- wo Geschäftsregeln ausgeführt werden

- wie Daten dupliziert oder geteilt werden

Wenn der ursprüngliche Prompt Einschränkungen nicht klärte (z. B. „muss Rückerstattungen unterstützen“, „mehrere Pläne pro Konto“, „Prorationsregeln“), baust du vielleicht ein vereinfachtes Modell, das sich nicht erweitern lässt. Das spätere Beheben bedeutet oft Migrationen, Vertragsänderungen und erneutes Testen von Integrationen.

Klarheit reduziert Auswahlmöglichkeiten

Jede Klarstellung reduziert einen Designbaum von möglichen Lösungen. Das ist gut: weniger „vielleicht“-Pfade heißt weniger zufällige Architekturen.

Ein präziser Prompt macht nicht nur die Implementierung einfacher — er macht Trade-offs sichtbar. Sind Anforderungen explizit, kann das Team Grenzen bewusst wählen (und dokumentieren, warum), anstatt sie aus der ersten Interpretation zu übernehmen, die kompiliert hat.

Häufige Symptome von Mehrdeutigkeit

Prompt-Mehrdeutigkeit zeigt sich schnell:

- Scope Creep („Während wir schon dabei sind, kann es auch…?“)

- fragile Integrationen (Partner verlassen sich auf undokumentiertes Verhalten)

- duplizierte Logik (gleiche Regeln mehrfach implementiert)

- unklare Ownership (niemand weiß, wo eine Regel hingehört)

Klare Prompts garantieren keine perfekte Architektur, aber sie erhöhen deutlich die Wahrscheinlichkeit, dass die Systemstruktur das echte Problem widerspiegelt — und wartbar bleibt, wenn es wächst.

Vom Prompt zu Systemgrenzen und Verantwortlichkeiten

Klare Prompts helfen nicht nur, „eine Antwort zu bekommen“ — sie zwingen dich zu erklären, wofür das System verantwortlich ist. Das ist der Unterschied zwischen einer sauberen Architektur und einem Haufen Features, die sich nicht entscheiden können, wo sie hingehören.

Ziele und Nicht-Ziele definieren Servicegrenzen

Wenn dein Prompt ein Ziel nennt wie „Benutzer können Rechnungen innerhalb von 30 Sekunden als PDF exportieren“, deutet das sofort auf dedizierte Verantwortlichkeiten (PDF-Generierung, Job-Tracking, Storage, Benachrichtigungen). Ein Nicht-Ziel wie „keine Echtzeit-Zusammenarbeit in v1“ verhindert, dass du frühzeitig Websockets, Shared Locks und Konfliktbehandlung einführst.

Sind Ziele messbar und Nicht-Ziele explizit, kannst du schärfere Linien ziehen:

- Was synchron sein muss (UI wartet) vs. asynchron (Hintergrund-Worker)

- Welche Daten stark konsistent sein müssen vs. „eventually ok“

- Was in einen separaten Service gehört vs. ein Modul innerhalb der API

Mappe Akteure und Workflows auf Komponenten

Ein guter Prompt identifiziert Akteure (Kunde, Admin, Support, automatischer Scheduler) und die Kernworkflows, die sie auslösen. Diese Workflows lassen sich sauber auf Komponenten abbilden:

- UI: Formulare, Dashboards, Upload/Download, Statusansichten

- API: Validierung, Orchestrierung, Policy Enforcement, Aggregation

- Worker: lang laufende Tasks, Retries, Batch-Verarbeitung

- Storage: Source-of-truth-Tabellen, File/Object-Storage, Audit-Logs

Querschnittsanforderungen, die du upfront benennen solltest

Prompts übersehen oft die „überall“-Anforderungen, die Architektur dominieren: Authentifizierung/Autorisierung, Auditing, Ratenbegrenzungen, Idempotenz, Retries/Timeouts, PII-Handhabung und Observability (Logs/Metriken/Traces). Werden diese nicht spezifiziert, werden sie inkonsistent implementiert.

Kurze Checkliste: Ist dein Prompt architekturmäßig vollständig?

- Klare Ziele + explizite Nicht-Ziele

- Akteure und Top-Workflows aufgelistet

- Erwartete Skalierung/Latenz und Fehlererwartungen

- Datenverantwortung (Source of Truth) und Aufbewahrungsregeln

- Querschnittsbelange: Auth, Auditing, Rate Limits, Retries

- „Done“-Kriterien (Akzeptanzkriterien) für jeden Workflow

Prompt-Klarheit und Datenmodell-Korrektheit

Ein Datenmodell gerät oft weit bevor jemand SQL schreibt in Schwierigkeiten — nämlich dann, wenn der Prompt vage Nomen verwendet, die „offensichtlich“ klingen. Wörter wie customer, account und user können mehrere reale Bedeutungen haben, und jede Interpretation erzeugt ein anderes Schema.

Wie vage Nomen unordentliche Schemata erzeugen

Wenn der Prompt sagt „speichere Kunden und ihre Konten“, stehen schnell Fragen im Raum, die der Prompt nicht beantwortet:

- Ist ein customer eine Person, ein Unternehmen oder beides?

- Ist ein account ein Billing-Profil, Login, Bankkonto oder ein Abonnement?

- Ist ein user gleichbedeutend mit einem Kunden oder ein Mitarbeiter, der Kunden verwaltet?

Ohne Definitionen kompensieren Teams durch nullable Spalten, Allzweck-Tabellen und überladene Felder wie type, notes oder metadata, die nach und nach zu „wo wir alles reinpacken“ werden.

Präzise Definitionen verbessern Keys, Beziehungen und Constraints

Klare Prompts verwandeln Nomen in explizite Entitäten mit Regeln. Zum Beispiel: „Ein Customer ist eine Organisation. Ein User ist ein Login, das zu einer Organisation gehören kann. Ein Account ist ein Billing-Account pro Organisation.“ Jetzt kannst du sicher entwerfen:

- Keys:

customer_id vs. user_id sind nicht austauschbar

- Beziehungen: one-to-many vs. many-to-many sind definiert, nicht geraten

- Constraints: Eindeutigkeit (Email pro Org), Pflichtfelder, gültige Zustände

Datenlebenszyklus verhindert „unsterbliche“ Datensätze

Prompt-Klarheit sollte auch Lifecycle abdecken: wie Datensätze erstellt, aktualisiert, deaktiviert, gelöscht und aufbewahrt werden. „Kunden löschen“ kann Hard-Delete, Soft-Delete oder rechtliche Aufbewahrung mit eingeschränktem Zugriff bedeuten. Das upfront zu benennen vermeidet gebrochene Foreign Keys, verwaiste Daten und inkonsistente Reports.

Einheitliche Benennung und Vermeiden überladener Felder

Verwende konsistente Namen für dasselbe Konzept über Tabellen und APIs hinweg (z. B. immer customer_id, nie manchmal org_id). Bevorzuge das Modellieren unterschiedlicher Konzepte gegenüber überladenen Spalten — trenne billing_status von account_status, anstatt ein mehrdeutiges status für fünf Dinge zu benutzen.

Was du für starke Datenmodelle spezifizieren solltest

Ein Datenmodell ist nur so gut wie die Details, die du vorab lieferst. Sagt ein Prompt nur „speichere Kunden und Bestellungen“, bekommst du wahrscheinlich ein Schema, das für eine Demo funktioniert, aber in realen Situationen scheitert (Duplikate, Importe, partielle Datensätze).

Kerneinheiten und Identifikatoren

Nenne die Entitäten ausdrücklich (z. B. Customer, Order, Payment) und definiere, wie jede identifiziert wird.

- Primäre Identifikatoren: UUID, Email, Kontonummer oder zusammengesetzter Key?

- Externe Identifikatoren: Werden Daten aus anderen Systemen synchronisiert (z. B. CRM-ID)? Können mehrere externe IDs existieren?

- Eindeutigkeitsregeln: Ist Email global eindeutig, pro Tenant oder nicht eindeutig?

Zustände, Transitionen und Lifecycle-Regeln

Viele Modelle brechen, weil Zustand nicht spezifiziert wurde. Kläre:

- Erlaubte Zustände (Draft → Submitted → Paid → Refunded)

- Transitionen, die erlaubt sind und was sie auslöst

- Ob Zustände änderbar sind (kann „Paid“ zurückgesetzt werden?) und wie Änderungen auditiert werden

Formuliere, was vorhanden sein muss und was fehlen darf.

Beispiele:

- Pflicht- vs. optionale Felder (z. B. Telefon optional, Rechnungsadresse Pflicht)

- Feld-Constraints (Min/Max-Längen, erlaubte Zeichen)

- Validierungszeitpunkt (on create, on update oder an Workflow-Meilensteinen)

Zeit, Währung, Locale und Zeitzone

Spezifiziere das früh, um versteckte Inkonsistenzen zu vermeiden.

- Zeitstempel in UTC speichern? Originalzeitzone zusätzlich speichern?

- Währung als ISO 4217 (USD/EUR) mit kleinsten Einheiten? Rundungsregeln?

- Lokale Formatierung vs. normalisierte Speicherung

Randfälle: Duplikate, Merges, Importe, partielle Daten

Reale Systeme müssen mit unordentlicher Realität umgehen. Kläre, wie mit folgendem umgegangen wird:

- Duplikaterkennung und Merge-Regeln (welche Felder „gewinnen“, was wird erhalten)

- Importierte Datensätze mit fehlenden Feldern (als „unvollständig“ zulassen?)

- Konfligierende Updates aus mehreren Quellen und Audit-Anforderungen

API-Verträge: Wo Prompt-Klarheit schnell zahlt

API-Verträge sind einer der schnellsten Orte, um den Nutzen von Prompt-Klarheit zu sehen: Sind Anforderungen explizit, wird das API schwerer missbrauchbar, leichter zu versionieren und weniger wahrscheinlich Auslöser für breaking changes.

Breaking Changes verhindern durch Spezifizität

Vage Prompts wie „füge einen Endpoint zum Aktualisieren von Bestellungen hinzu“ lassen Raum für inkompatible Interpretationen (partielle vs. vollständige Updates, Feldnamen, Default-Werte, Async vs. Sync). Klare Contract-Anforderungen erzwingen Entscheidungen früh:

- Welche Felder sind schreibbar, Pflicht oder unveränderlich

- Ob Updates

PUT (ersetzen) oder PATCH (teilweise) sind

- Regeln zur Abwärtskompatibilität (z. B. „neue Felder müssen optional sein; Bedeutung bestehender Felder nie ändern“)

Fehlerbehandlung: Mache Fehlermodi Teil des Designs

Definiere, wie „gute Fehler“ aussehen. Mindestens spezifizieren:

- Statuscodes pro Szenario (400 Validierung, 401/403 Auth, 404 nicht gefunden, 409 Konflikte, 429 Rate Limit)

- Einen konsistenten Fehlerkörper (Maschinencode, lesbare Nachricht, feldspezifische Details, Korrelation/Request-ID)

- Retry-Erwartungen: welche Fehler sicher wiederholbar sind und empfohlene Backoff-Strategien

Ambiguität hier erzeugt Client-Bugs und unterschiedliche Performance. Lege Regeln fest:

- Pagination-Stil (Cursor vs. Offset), Limits und Garantien für stabile Sortierung

- Unterstützte Filter und Typen (Exact Match, Bereiche, Enums)

- Sortierfelder und Standard-Sortierung

- Idempotenz für Writes (Idempotency-Keys, Dedupe-Fenster, Verhalten bei doppelten Requests)

Dokumentiere mit Beispielen und Constraints

Füge konkrete Request/Response-Beispiele und Beschränkungen (Min/Max-Längen, erlaubte Werte, Datumsformate) hinzu. Ein paar Beispiele verhindern oft mehr Missverständnisse als eine Seite Prosa.

Wartbarkeit: Die langfristigen Kosten von Ambiguität

Vage Prompts erzeugen nicht nur „falsche Antworten“. Sie erzeugen versteckte Annahmen — kleine, undokumentierte Entscheidungen, die sich über Codepfade, Datenfelder und API-Antworten ausbreiten. Das Ergebnis ist Software, die nur unter den Annahmen des Erbauers funktioniert und bricht, sobald reale Nutzung abweicht.

Versteckte Annahmen werden zu brüchigem Code

Wenn ein Prompt Lücken lässt (z. B. „Unterstütze Rückerstattungen“ ohne Regeln), füllen Teams diese Lücken an unterschiedlichen Stellen unterschiedlich: Ein Service interpretiert Rückerstattung als Umkehrbuchung, ein anderer als separate Transaktion, ein dritter erlaubt partielle Rückerstattungen ohne Constraints.

Klare Prompts reduzieren Guesswork, indem sie Invarianten festlegen („Rückerstattungen innerhalb von 30 Tagen erlaubt“, „partielle Rückerstattungen erlaubt“, „Bestand wird bei digitalen Gütern nicht wieder aufgefüllt“). Diese Aussagen treiben vorhersehbares Verhalten durch das System.

Klarheit macht Code und Tests einfacher

Wartbare Systeme sind leichter erklärbar. Prompt-Klarheit unterstützt:

- Lesbaren Code: weniger defensive Branches, weil Eingaben und Zustände definiert sind.

- Einfachere Tests: Testfälle spiegeln Akzeptanzkriterien statt „was-wenn“-Szenarien.

- Sicherere Refactors: Ist Verhalten spezifiziert, kannst du Interna ändern und die Outcomes verifizieren.

Verwendest du KI-unterstützte Entwicklung, helfen präzise Anforderungen dem Modell, konsistente Implementierungen statt plausibel-aber-inkonsistenter Fragmente zu erzeugen.

Operability: Logging und Metriken sind keine optionalen Details

Wartbarkeit umfasst das Betreiben des Systems. Prompts sollten Observability-Erwartungen spezifizieren: was geloggt werden muss (und was nicht), welche Metriken wichtig sind (Error-Raten, Latenz, Retries) und wie Fehler angezeigt werden. Ohne das entdecken Teams Probleme oft erst, wenn Kunden sie bemerken.

Wartbarkeitssignale, auf die du achten solltest

Ambiguität zeigt sich oft als niedrige Kohäsion und hohe Kopplung: ungelöste Verantwortlichkeiten, „Helper“-Module, die überall zugreifen, und Verhalten, das je nach Aufrufer variiert. Klare Prompts fördern kohäsive Komponenten, schmale Schnittstellen und vorhersehbare Outcomes — und machen spätere Änderungen günstiger. Zur praktischen Durchsetzung siehe /blog/review-workflow-catch-gaps-before-building.

Beispiele: Vorher/Nachher für bessere Prompts

Vage Prompts erzeugen keine vage Texte allein — sie treiben Designs in Richtung „generisches CRUD“-Default. Ein klarerer Prompt erzwingt frühe Entscheidungen: Grenzen, Datenverantwortung und was in der DB wahr sein muss.

Vorher: vager Prompt

"Design a simple system to manage items. Users can create, update, and share items. It should be fast and scalable, with a clean API. Keep history of changes."

Was ein Builder (Mensch oder KI) nicht zuverlässig ableiten kann:

- Was ist ein „Item“ (Felder, Lifecycle, Einzigartigkeit)?

- Was bedeutet „teilen“ (öffentlicher Link vs. bestimmte Benutzer vs. Teams)?

- Was ist mit „History“ gemeint (vollständige Snapshots vs. Diffs, wer hat was geändert, Aufbewahrung)?

Danach: klarerer Prompt mit Einschränkungen

"Design a REST API for managing generic items with these rules: items have title (required, max 120), description (optional), status (draft|active|archived), tags (0–10). Each item belongs to exactly one owner (user). Sharing is per-item access for specific users with roles viewer|editor; no public links. Every change must be auditable: store who changed what and when, and allow retrieving the last 50 changes per item. Non-functional: 95th percentile API latency < 200ms for reads; write throughput is low. Provide data model entities and endpoints; include error cases and permissions."

Jetzt ändern sich Architektur- und Schemaentscheidungen sofort:

- Architektur: ein dedizierter Authorization-Komponent (Rollenchecks) und ein Audit Log-Write-Path; kein Bedarf für komplexes Caching, wenn Writes niedrig sind.

- Schema:

items, item_shares (Many-to-Many mit Rolle) und item_audit_events (append-only). status wird zum Enum; Tags wandern wahrscheinlich in eine Join-Tabelle, um die 10-Tag-Grenze durchzusetzen.

Schnelle Übersetzungstabelle

| Mehrdeutiger Ausdruck | Konkretisierte Version |

|---|

| „Share items“ | „Share mit bestimmten Nutzern; Rollen viewer/editor; keine öffentlichen Links" |

| „Keep history“ | „Speichere Audit-Events mit Actor, Timestamp, geänderten Feldern; die letzten 50 abrufbar" |

| „Fast and scalable" | „p95 Latenz < 200ms; niedrige Schreiblast; Haupt-Workload definieren" |

| „Clean API" | „Liste der Endpunkte + Request/Response-Formen + Berechtigungsfehler" |

Ein praktisches Prompt-Template für bessere Designs

Ein klarer Prompt muss nicht lang sein — er muss strukturiert sein. Ziel ist, genug Kontext zu liefern, damit Architektur- und Datenmodellentscheidungen offensichtlich werden, nicht geraten.

Copy/paste-Template

1) Goal

- What are we building, and why now?

- Success looks like: <measurable outcome>

2) Users & roles

- Primary users:

- Admin/support roles:

- Permissions/entitlements assumptions:

3) Key flows (happy path + edge cases)

- Flow A:

- Flow B:

- What can go wrong (timeouts, missing data, retries, cancellations)?

4) Data (source of truth)

- Core entities (with examples):

- Relationships (1:N, N:N):

- Data lifecycle (create/update/delete/audit):

- Integrations/data imports (if any):

5) Constraints & preferences

- Must use / cannot use:

- Budget/time constraints:

- Deployment environment:

6) Non-functional requirements (NFRs)

- Performance: target latency/throughput, peak load assumptions

- Uptime: SLA/SLO, maintenance windows

- Privacy/security: PII fields, retention, encryption, access logs

- Compliance: (if relevant)

7) Risks & open questions

- Known unknowns:

- Decisions needed from stakeholders:

8) Acceptance criteria + Definition of Done

- AC: Given/When/Then statements

- DoD: tests, monitoring, docs, migrations, rollout plan

9) References

- Link existing internal pages: /docs/<...>, /pricing, /blog/<...>

Wie man es effektiv nutzt

Fülle erst die Abschnitte 1–4 aus. Wenn du die Kernentitäten und die Source of Truth nicht benennen kannst, driftet das Design meist in „was die API zurückgibt“, was später zu chaotischen Migrationen und unklarer Zuständigkeit führt.

Bei NFRs vermeide vage Wörter („schnell“, „sicher“). Ersetze sie durch Zahlen, Schwellenwerte und explizite Datenhandhabungsregeln. Schon eine grobe Schätzung (z. B. „p95 < 300ms für Reads bei 200 RPS") ist handlungsorientierter als Schweigen.

Für Akzeptanzkriterien nimm mindestens einen negativen Fall (z. B. invalid input, permission denied) und einen operativen Fall (z. B. wie Fehler angezeigt werden). Das hält das Design an realem Verhalten orientiert, nicht an Diagrammen.

Koder.ai: Klare Prompts in konsistente Builds verwandeln

Prompt-Klarheit zählt noch mehr, wenn du mit KI End-to-End baust — nicht nur Snippets generierst. In einem vibe-coding-Workflow (Prompts steuern Requirements, Design und Implementierung) können kleine Ambiguitäten in Schemaentscheidungen, API-Verträge und UI-Verhalten hineinwachsen.

Koder.ai ist für diesen Entwicklungsstil gedacht: Du kannst einen strukturierten Prompt im Chat iterieren, Planning Mode nutzen, um Annahmen und offene Fragen explizit zu machen, und dann einen funktionierenden Web/Backend/Mobile-App-Stack liefern (React Web, Go + PostgreSQL Backend, Flutter Mobile). Praktische Features wie Snapshots und Rollback erlauben sicheres Experimentieren, und Source Code Export erhält Team-Ownership.

Teilst du Prompts mit Teamkollegen, führt das Behandeln des Prompt-Templates als lebende Spezifikation (und Versionierung zusammen mit der App) häufig zu saubereren Grenzen und weniger unbeabsichtigten Breaking Changes.

Review-Workflow: Lücken erkennen, bevor gebaut wird

Ein klarer Prompt ist nicht „fertig“, wenn er lesbar ist. Er ist fertig, wenn zwei unterschiedliche Personen aus ihm in etwa dasselbe System entwerfen würden. Ein leichter Review-Workflow hilft, Mehrdeutigkeiten früh zu finden — bevor sie sich in Architekturänderungen, Schema-Umschreibungen und API-Breaks verwandeln.

Schritt 1: Read-back (2 Minuten)

Lass eine Person (PM, Engineer oder KI) den Prompt als: Ziele, Nicht-Ziele, Eingaben/Ausgaben und Einschränkungen zusammenfassen. Vergleiche diese Zusammenfassung mit deiner Absicht. Jede Abweichung ist eine Anforderung, die nicht explizit war.

Schritt 2: Lasse fehlende Fragen auftauchen

Bevor gebaut wird, liste „Unbekanntes, das das Design ändert“. Beispiele:

- Wer ist die Source of Truth für ein Feld (User vs System vs externes API)?

- Was passiert, wenn Daten fehlen, spät kommen, dupliziert oder falsch sind?

- Was sind Performance- oder Skalierungserwartungen (grobe Zahlen)?

Schreibe die Fragen direkt in den Prompt als kurze „Open questions“-Sektion.

Schritt 3: Führe eine Annahmenliste — und konvertiere sie

Annahmen sind okay, aber nur wenn sie sichtbar sind. Für jede Annahme wähle eine von drei Optionen:

- Entscheidung: mache sie explizit (z. B. „Email ist pro User eindeutig; Änderungen erfordern Verifikation").

- TODO: markiere sie als verfolgten Follow-up mit Owner und Zeitplan (z. B. „TODO: Aufbewahrungsregel mit Legal vor Launch bestätigen").

Schritt 4: Iteriere in kleinen Zyklen

Statt eines riesigen Prompts: 2–3 kurze Iterationen: Grenzen klären, dann Datenmodell, dann API-Contract. Jeder Durchgang sollte Ambiguität entfernen, nicht Scope hinzufügen.

Schnelle Abnahme-Checkliste (PM + Engineer)

- Erfolgsmetriken und Akzeptanzkriterien sind geschrieben

- Nicht-Ziele sind explizit

- Systemgrenzen und Verantwortlichkeiten sind benannt

- Schlüsselentitäten/Felder und Ownership sind definiert

- Fehlerfälle und Randfälle sind beschrieben

- Annahmen sind Entscheidungen oder TODOs geworden

Häufige Fehler und wie man sie behebt

Auch starke Teams verlieren Klarheit auf kleine, wiederholbare Weisen. Die gute Nachricht: Die meisten Probleme sind leicht zu erkennen und zu beheben, bevor Code geschrieben wird.

Killer der Klarheit

Vage Verben verbergen Designentscheidungen. Wörter wie „support“, „handle“, „optimize“ oder „make it easy“ sagen nicht, wie Erfolg aussieht.

Unbestimmte Akteure schaffen Ownership-Lücken. „Das System benachrichtigt den Nutzer“ wirft Fragen auf: Welche Komponente, welcher Nutzertyp, über welchen Kanal?

Fehlende Constraints führen zu unbeabsichtigter Architektur. Wenn du Skalierung, Latenz, Datenschutzregeln, Audit-Bedürfnisse oder Deployment-Grenzen nicht nennst, rät die Implementierung — und du bezahlst später.

Nicht die Implementierung über-spezifizieren

Eine häufige Falle ist, Tools und Interna vorzuschreiben („Use microservices“, „Store in MongoDB“, „Use event sourcing“), wenn du eigentlich ein Outcome meinst („unabhängige Deploys“, „flexibles Schema“, „Audit-Trail“). Nenne warum du etwas willst, dann messbare Anforderungen.

Beispiel: Statt „Use Kafka" schreibe „Events müssen 7 Tage dauerhaft sein und replaybar, um Projektionen neu aufzubauen."

Widersprüche früh vermeiden

Widersprüche treten oft als „muss in Echtzeit sein“ plus „Batch ist ok“ oder „keine PII gespeichert“ plus „E-Mails an Nutzer senden und Profile anzeigen“ auf. Löse das durch Priorisierung (must/should/could) und durch Akzeptanzkriterien, die sich nicht gegenseitig ausschließen.

Antipatterns und Fixes

-

Antipattern: „Onboarding einfach machen."

Fix: „Neue Nutzer schließen Onboarding in <3 Minuten ab; max 6 Felder; Save-and-resume unterstützt."

-

Antipattern: „Admins können Accounts verwalten."

Fix: Definiere Aktionen (suspend, reset MFA, change plan), Berechtigungen und Audit-Logging.

-

Antipattern: „Sichere hohe Performance."

Fix: „P95 API-Latenz <300ms bei 200 RPS; Graceful Degradation bei Ratelimits."

-

Antipattern: Gemischte Begriffe („customer", „user", "account").

Fix: Füge ein kleines Glossar hinzu und halte dich konsistent daran.

Checkliste und nächste Schritte

Klare Prompts helfen nicht nur einem Assistenten, dich zu verstehen. Sie reduzieren Rate of Guessing — was sich unmittelbar in saubereren Systemgrenzen, weniger Überraschungen im Datenmodell und APIs, die sich leichter weiterentwickeln lassen, zeigt. Ambiguität wird zur Nacharbeit: ungeplante Migrationen, Endpunkte, die nicht zu echten Workflows passen, und immer wiederkehrende Wartungsaufgaben.

Einseitige Checkliste, die du wiederverwenden kannst

Verwende dies, bevor du eine Architektur, ein Schema oder ein API-Design anfragst:

- Ziel: Welches Nutzerergebnis soll eintreten? Wie sieht „done“ aus?

- Scope: Was ist drin, was ist außen, was kann warten?

- Akteure & Einstiegspunkte: Wer startet den Flow (User, Admin, System Job)?

- Kernworkflows: 2–5 Happy-Path-Schritte plus Top-Fehlerfälle.

- Datendefinitionen: Wichtige Entitäten, Pflichtfelder, IDs und Beziehungen.

- Constraints: Performance-Ziele, Datenschutzregeln, Retention, Audit-Bedürfnisse.

- Integrationen: Externe Systeme, Events, Queues und Ownership-Grenzen.

- API-Erwartungen: Inputs/Outputs, Fehlerverhalten, Idempotenz, Pagination.

- Akzeptanzkriterien: Testbare Aussagen (inkl. Randfälle).

- Nicht-Ziele: Explizit definieren, was das System nicht tun soll.

- Annahmen: Was du für wahr hältst, aber noch nicht verifiziert hast.

- Offene Fragen: Alles, was vor dem Bauen beantwortet werden muss.

Nächste Schritte

- Wähle ein echtes Feature, das diese Woche geplant ist.

- Schreibe einen Prompt mithilfe der obigen Checkliste.

- Generiere zwei Designs: eines aus deinem „alten“ Prompt, eines aus dem geklärten Prompt.

- Vergleiche die Ergebnisse entlang dreier Blickwinkel: Systemgrenzen, Datenmodell und API-Vertrag.

- Behalte den geklärten Prompt als Teil deiner Spezifikation (er wird zur lebenden Dokumentation).

Wenn du mehr praktische Muster willst, durchsuche /blog oder unterstützende Guides in /docs.