Wie „sauberere Architektur“ in KI-unterstützter Arbeit aussieht

„Sauberere Architektur“ in diesem Beitrag meint nicht ein bestimmtes Framework oder ein perfektes Diagramm. Es bedeutet, dass du das System einfach erklären kannst, es ändern kannst, ohne unzusammenhängende Teile zu brechen, und Verhalten ohne heroische Tests verifizieren kannst.

Eine praktische Definition: Klarheit, Modularität, Testbarkeit

Klarheit heißt, der Zweck und die Struktur des Systems sind aus einer kurzen Beschreibung ersichtlich: was es tut, wer es nutzt, welche Daten es verarbeitet und was es niemals tun darf. In KI-unterstützter Arbeit bedeutet Klarheit auch, dass das Modell Anforderungen so wiedergeben kann, dass du diese abnickst.

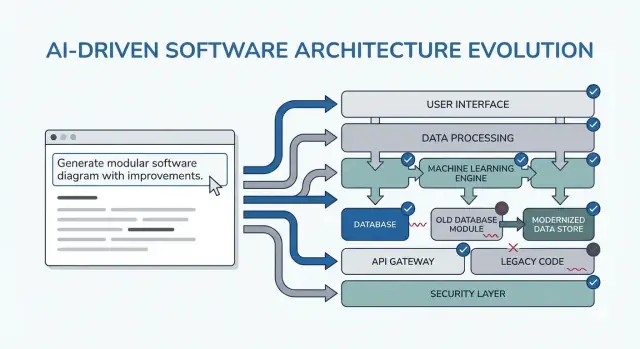

Modularität heißt, Verantwortlichkeiten haben klare Grenzen. Jedes Modul hat eine Aufgabe, Inputs/Outputs und minimale Kenntnis der Interna anderer Module. Wenn die KI Code generiert, verhindert Modularität, dass Geschäftsregeln wild über Controller, UI und Datenzugriff verteilt werden.

Testbarkeit bedeutet, die Architektur macht „beweise, dass es funktioniert“ günstig. Geschäftsregeln sind ohne komplettes System testbar, Integrationstests fokussieren auf wenige Verträge anstatt jeden Codepfad.

Warum Überarbeitungen passieren (und warum KI sie verstärken kann)

Überarbeitungen entstehen meist nicht durch „schlechten Code“ — sie entstehen durch fehlende Zwänge, vagen Umfang und versteckte Annahmen. Beispiele:

- Eine Funktion wurde für einen Nutzertyp gebaut, später entdeckt man drei Rollen mit unterschiedlichen Berechtigungen.

- Performance-, Audit-Logging- oder Aufbewahrungsregeln kommen spät hinzu.

- Eine externe API verhält sich anders als erwartet und zwingt zu Änderungen überall.

KI kann dieses Fehlermuster beschleunigen, weil sie überzeugende Ergebnisse schnell liefert — so baut man leicht auf wackeligen Grundlagen auf.

Was du von den Mustern in diesem Leitfaden erwarten solltest

Die folgenden Muster sind Vorlagen zum Anpassen, keine Zaubersprüche. Ihr eigentliches Ziel ist, die richtigen Gespräche früh zu erzwingen: Zwänge klären, Optionen vergleichen, Annahmen dokumentieren und Verträge definieren. Wenn du dieses Nachdenken überspringst, füllt das Modell die Lücken gerne selbst — und du bezahlst später dafür.

Wo diese Muster in deinen Workflow passen

Du nutzt sie über den gesamten Delivery-Zyklus hinweg:

- Planung: Anforderungen und Erfolgskriterien schärfen

- Design: Grenzen, Datenflüsse und Verträge wählen

- Codierung: Verantwortlichkeiten getrennt halten, während die Implementierung wächst

- Review: Risiken und Fehlanpassungen erkennen, bevor sie zu Überarbeitungen werden

Wenn du einen vibe-coding-Workflow verwendest (das System wird per Chat generiert und iteriert), sind diese Checkpoints noch wichtiger. Beispielsweise kannst du in Koder.ai einen „Planungsmodus“-Loop laufen lassen, um Anforderungen und Verträge zu fixieren, bevor du React/Go/PostgreSQL-Code generierst, und dann Snapshots/Rollbacks nutzen, um sicher zu iterieren, wenn sich Annahmen ändern — ohne jede Änderung zur Überarbeitung zu machen.

Wie du Prompting-Muster nutzt, ohne mehr Arbeit zu schaffen

Prompting-Muster sind dann am wertvollsten, wenn sie Entscheidungschaos reduzieren. Der Trick ist, sie als kurze, wiederholbare Checkpoints zu verwenden — bevor du coden, während du designst und bei Reviews — sodass die KI Artefakte produziert, die du wiederverwenden kannst, und nicht extra Text, durch den du dich wühlen musst.

Wann Muster einsetzen

Vor dem Coden: einen „Alignment“-Loop durchführen, um Ziele, Nutzer, Zwänge und Erfolgskriterien zu bestätigen.

Während des Designs: Muster verwenden, die explizite Trade-offs erzwingen (z. B. Alternativen, Risiken, Datengrenzen) bevor implementiert wird.

Während der Review: eine Checklist-Anfrage nutzen, um Lücken zu finden (Edge Cases, Monitoring, Security, Performance), solange Änderungen noch günstig sind.

Du erhältst bessere Ergebnisse mit einem kleinen, konsistenten Input-Bündel:

- Ziele: was „fertig“ bedeutet (Latenzziele, UX-Ergebnisse, Kostengrenzen)

- Nutzer: Rollen, Kern-Workflows und Top-Pain-Points

- Zwänge: Tech-Stack, Deadlines, Compliance/Sicherheitsanforderungen

- Daten & Integrationen: Quellen, Eigentümer, APIs, Drittanbieterabhängigkeiten

Wenn du etwas nicht weißt, sag es explizit und bitte die KI, Annahmen aufzulisten.

Statt „erkläre das Design“ fordere Artefakte an, die du in Docs oder Tickets einfügen kannst:

- Ein Entscheidungsprotokoll (Optionen → Pro/Contra → gewählt → warum)

- Eine Tabelle von Komponenten mit Verantwortlichkeiten und Grenzen

- Eine Checkliste für Zuverlässigkeit und Tests

- Eine einfache Diagrammbeschreibung (z. B. Mermaid-Text), die du später rendern kannst

Iteriere in kleinen Schleifen mit Akzeptanzkriterien

Mache 10–15-Minuten-Loops: Prompt → Überfliegen → Nachschärfen. Enthalte immer Akzeptanzkriterien (was wahr sein muss, damit das Design akzeptabel ist) und lass die KI sich selbst daran prüfen. Das verhindert endlose Redesigns und macht die Muster in den nächsten Abschnitten schnell anwendbar.

Muster 1: Anforderungen klären, bevor ein Design entsteht

Die meisten „Architektur-Überarbeitungen“ entstehen nicht durch schlechte Diagramme — sie entstehen, weil das Richtige für das falsche (oder unvollständige) Problem gebaut wurde. Wenn du ein LLM früh nutzt, fordere nicht zuerst eine Architektur an. Bitte es, Unklarheiten offenzulegen.

Die Prompt-Bewegung: Ungewissheiten in eine Checkliste verwandeln

Nutze das Modell als Requirements-Interviewer. Ziel ist eine kurze, priorisierte Spezifikation, die du bestätigen kannst, bevor Komponenten entworfen, Datenbanken gewählt oder APIs festgelegt werden.

Hier ist eine Copy-Paste-Vorlage, die du wiederverwenden kannst:

You are my requirements analyst. Before proposing any architecture, do this:

1) Ask 10–15 clarifying questions about missing requirements and assumptions.

- Group questions by: users, workflows, data, integrations, security/compliance, scale, operations.

2) Produce a prioritized scope list:

- Must-have

- Nice-to-have

- Explicitly out-of-scope

3) List constraints I must confirm:

- Performance (latency/throughput targets)

- Cost limits

- Security/privacy

- Compliance (e.g., SOC2, HIPAA, GDPR)

- Timeline and team size

4) End with: “Restate the final spec in exactly 10 bullets for confirmation.”

Context:

- Product idea:

- Target users:

- Success metrics:

- Existing systems (if any):

Woran du die Ausgabe erkennen solltest

Du willst Fragen, die Entscheidungen erzwingen (nicht generisches „erzähle mehr“), plus eine Must-Have-Liste, die tatsächlich innerhalb deines Zeitplans fertigstellbar ist.

Behandle die „10 Bullets“-Wiederholung als Vertrag: füge sie in dein Ticket/PRD ein, hol dir ein kurzes Ja/Nein von Stakeholdern und gehe erst dann zur Architektur über. Dieser Schritt verhindert die häufigste Ursache für späte Refactors: Funktionen zu bauen, die nie wirklich erforderlich waren.

Muster 2: Zuerst User Journeys, dann technische Entscheidungen

Wenn du mit Tools beginnst („Sollten wir Event Sourcing verwenden?“), entwirfst du oft für die Architektur statt für den Nutzer. Ein schnellerer Weg zu sauberer Struktur ist, die KI zuerst die User Journeys in einfacher Sprache beschreiben zu lassen und erst danach diese Journeys in Komponenten, Daten und APIs zu übersetzen.

Einfaches Journey-first Prompt-Template

Benutze dies als Startvorlage:

- Rollen: user / admin / system

- Kernaktionen: was jede Rolle erreichen möchte

- Randfälle: was schiefgehen kann (ungültige Eingaben, fehlende Berechtigungen, partielle Abschlüsse)

Dann fordere:

-

“Beschreibe den Schritt-für-Schritt-Ablauf für jede Aktion in einfacher Sprache.”

-

“Gib eine einfache Zustandsdiagramm-Beschreibung oder Zustandsliste (z. B. Draft → Submitted → Approved → Archived).”

-

“Liste Non-Happy-Path-Szenarien: Timeouts, Retries, Duplicate Requests, Cancellations und invalid inputs.”

Journeys in Entscheidungen überführen (ohne vorzupreschen)

Wenn die Flows klar sind, lass die KI sie auf technische Entscheidungen abbilden:

- Wo brauchen wir Validation vs Business Rules?

- Welche Schritte benötigen Idempotenz (sichere Retries)?

- Welche Daten müssen gespeichert werden, was kann abgeleitet werden und was braucht eine Auditspur?

Erst danach bitte um einen Architektur-Sketch (Services/Module, Grenzen und Verantwortlichkeiten), der direkt an die Flow-Schritte gebunden ist.

Flows in testbare Akzeptanzkriterien umwandeln

Lass die KI abschließend jede Journey in testbare Akzeptanzkriterien umwandeln:

- „Given/When/Then für jeden Schritt und Fehlerfall.“

- „Was soll das System zurückgeben oder anzeigen?“

- „Was soll geloggt werden, und was soll einen Retry vs. eine Nutzerfehlermeldung auslösen?“

Dieses Muster reduziert Überarbeitungen, weil die Architektur aus dem Nutzerverhalten wächst — nicht aus Annahmen über Technologie.

Muster 3: Annahmen-Log, um unerwartete Überarbeitungen zu verhindern

Die meisten Architektur-Überarbeitungen entstehen nicht durch „schlechtes Design“ — sie entstehen durch versteckte Annahmen, die sich als falsch herausstellen. Wenn du ein LLM nach einer Architektur fragst, füllt es oft Lücken mit plausiblen Vermutungen. Ein Annahmen-Log macht diese Vermutungen früh sichtbar, solange Änderungen noch günstig sind.

Was du das Modell tun lassen solltest

Ziel ist eine klare Trennung zwischen Fakten, die du geliefert hast und Annahmen, die es erfunden hat.

Nutze dieses Prompt-Muster:

Template prompt

“Before proposing any solution: list your assumptions. Mark each as validated (explicitly stated by me) or unknown (you inferred it). For each unknown assumption, propose a fast way to validate it (question to ask, metric to check, or quick experiment). Then design based only on validated assumptions, and call out where unknowns could change the design.”

Halte es kurz, damit es tatsächlich genutzt wird:

- Assumption: …

- Status: validated / unknown

- Why it matters: welche Entscheidung sie beeinflusst

- How to validate: Frage, Check oder Spike

- If wrong, likely change: was du redesignen würdest

„Was würde deine Antwort ändern?“-Trigger

Füge eine Zeile hinzu, die das Modell seine Kipppunkte nennen lässt:

- “List 5 triggers: what would change your answer? (z. B. Nutzerzahl, Latenzziele, Compliance-Anforderungen, Datenaufbewahrung).”

Dieses Muster wandelt Architektur in eine Reihe konditionaler Entscheidungen: du erhältst nicht nur ein Diagramm, sondern eine Karte dessen, was bestätigt werden muss, bevor du dich festlegst.

Muster 4: Mehrere Architekturen vergleichen, bevor man sich entscheidet

Plane, bevor du baust

Nutze den Planungsmodus, um Anforderungen in klare Verträge zu überführen, bevor Code erzeugt wird.

KI-Tools sind gut darin, eine einzelne „beste“ Lösung zu produzieren — oft ist das nur die erste plausible Option. Eine sauberere Architektur entsteht, wenn du früh einen Vergleich erzwingst, solange Änderungen noch günstig sind.

Das Kern-Prompt-Template

Formuliere ein Prompt, das mehrere Architekturen und eine strukturierte Tradeoff-Tabelle verlangt:

Propose 2–3 viable architectures for this project.

Compare them in a table with criteria: complexity, reliability, time-to-ship, scalability, cost.

Then recommend one option for our constraints and explain why it wins.

Finally, list “what we are NOT building” in this iteration to keep scope stable.

Context:

- Users and key journeys:

- Constraints (team size, deadlines, budget, compliance):

- Expected load and growth:

- Current systems we must integrate with:

Warum das Rewrites reduziert

Ein Vergleich zwingt das Modell (und dich), versteckte Annahmen offenzulegen: wo State liegt, wie Services kommunizieren, was synchron sein muss und was verzögert werden kann.

Die Kriterien-Tabelle verhindert Debatten wie „Microservices vs Monolith“ auf rein Meinungsbasis. Sie verankert die Entscheidung an dem, was euch tatsächlich wichtig ist — schnell ausliefern, Betriebsaufwand reduzieren oder Zuverlässigkeit erhöhen.

Empfehlung und Grenzen fordern

Akzeptiere nicht „es kommt darauf an“. Fordere eine klare Empfehlung und die spezifischen Zwänge, die sie optimiert.

Bestehe außerdem auf „was wir nicht bauen“. Beispiele: „Kein Multi-Region Failover“, „Kein Plugin-System“, „Keine Echtzeit-Benachrichtigungen“. Das verhindert, dass Architektur stillschweigend wächst, um Features zu unterstützen, die ihr noch nicht committed habt — und vermeidet Überraschungs-Überarbeitungen, wenn sich der Umfang ändert.

Muster 5: Modularitätsgrenzen und Verantwortlichkeits-Prompts

Die meisten Überarbeitungen passieren, weil Grenzen vage sind: alles „berührt alles“ und eine kleine Änderung wirkt sich im ganzen Code aus. Dieses Muster zwingt mit Prompts zu klarer Modulverantwortung, bevor über Frameworks oder Klassendiagramme debattiert wird.

Die Kernidee

Bitte die KI, Module und Verantwortlichkeiten zu definieren und was ausdrücklich nicht dazugehört. Fordere danach Schnittstellen (Inputs/Outputs) und Abhängigkeitsregeln, nicht einen Bauplan oder Implementierungsdetails.

Copy-Paste-Prompt-Template

Verwende das, wenn du ein neues Feature skizzierst oder einen unordentlichen Bereich refaktorierst:

- Context: <ein kurzer Absatz zum Produkt/Feature>

- Goal: Schlage eine modulare Architektur mit 4–8 Modulen vor.

-

Liste Module mit:

- Zweck (1 Satz)

- Verantwortlichkeiten (3–5 Bullets)

- Nicht-Verantwortlichkeiten („behandelt NICHT…“) (2–3 Bullets)

-

Definiere für jedes Modul nur Schnittstellen:

- Inputs (Events/Requests/Daten)

- Outputs (Responses/Events/Nebenwirkungen)

- Öffentliche API-Oberfläche (Funktionsnamen oder Endpunkte ok; keine internen Klassen)

-

Abhängigkeitsregeln:

- Erlaubte Abhängigkeiten (A → B)

- Verbotene Abhängigkeiten (A ↛ C) mit Begründung

- Wo gemeinsame Typen leben (und was niemals geteilt werden darf)

-

Future change test: Gegeben diese wahrscheinlichen Änderungen: <liste 3>, zeige, welches einzelne Modul jede Änderung aufnehmen sollte und warum.

Wie „gute“ Ausgabe aussieht

Ziel sind Module, die du einem Teamkollegen in unter einer Minute beschreiben kannst. Wenn die KI ein „Utils“-Modul vorschlägt oder Geschäftslogik in Controllern platziert, hake nach: „Verschiebe Entscheidungsfindung in ein Domain-Modul und halte Adapter dünn.“

Am Ende hast du Grenzen, die künftige Anforderungen überstehen — weil Änderungen ein klares Zuhause haben und Abhängigkeitsregeln versehentliche Kopplungen verhindern.

Muster 6: Daten- & API-Verträge zuerst (Integrations-Rework vermeiden)

Integrationsüberarbeitungen entstehen selten durch „schlechten Code“ — meist durch unklare Verträge. Wenn Datenmodell und API-Formen spät entschieden werden, füllt jedes Team (oder Modul) Lücken unterschiedlich aus und die nächste Iteration besteht im Replizieren und Abgleichen.

Beginne damit, Verträge zu prompten, bevor du über Frameworks, Datenbanken oder Microservices sprichst. Ein klarer Vertrag wird zur gemeinsamen Referenz für UI, Backend und Datenpipelines.

Das contract-first Prompt

Verwende diesen frühen Prompt mit deinem KI-Assistenten:

- Template: „Beschreibe das Datenmodell, Ownership und Lifecycle für jede Entität“

Folge sofort mit:

- Fordere API-Verträge mit Beispielen (Requests, Responses, Error-Shapes)

- Füge Versionierung- und Rückwärtskompatibilitäts-Erwartungen hinzu

- Bitte um Validierungsregeln und Randfälle pro Feld

Wie „gute“ Ausgabe aussieht

Du willst konkrete Artefakte, nicht bloße Prosa. Zum Beispiel:

- Entität:

Subscription

- Owner: Billing service

- Lifecycle: created on checkout → active → past_due → canceled (soft-delete after 90 days)

- Source of truth: billing DB; other services cache read-only copies

Und eine API-Skizze:

POST /v1/subscriptions

{

"customer_id": "cus_123",

"plan_id": "pro_monthly",

"start_date": "2026-01-01"

}

201 Created

{

"id": "sub_456",

"status": "active",

"current_period_end": "2026-02-01"

}

422 Unprocessable Entity

{

"error": {

"code": "VALIDATION_ERROR",

"message": "start_date must be today or later",

"fields": {"start_date": "in_past"}

}

}

Versionierung und Kompatibilitätsregeln

Lass die KI Regeln formulieren wie: „Additive Felder sind ohne Version-Bump erlaubt; Umbenennungen erfordern /v2; Clients müssen unbekannte Felder ignorieren.“ Dieser Schritt verhindert stille Breaking-Changes — und die Überarbeitungen, die darauf folgen.

Muster 7: Failure Modes und Zuverlässigkeits-Checkliste

Mobile App per Chat bereitstellen

Verwandle deine Abläufe in eine Flutter‑Mobile‑App, ohne von vorne zu beginnen.

Architekturen werden umgeschrieben, wenn „Happy-Path“-Designs mit echtem Traffic, fehlerhaften Abhängigkeiten und unerwartetem Nutzerverhalten kollidieren. Dieses Muster macht Zuverlässigkeit zu einem expliziten Design-Output, nicht zu einer Nach-Live-Herausforderung.

Copy/Paste-Prompt-Template

Verwende dies mit deiner gewählten Architektur-Beschreibung:

List failure modes; propose mitigations; define observability signals.

Für jeden Failure Mode:

- Was löst ihn aus?

- Nutzerauswirkung (was erlebt der Nutzer)

- Minderung (Design + Betrieb)

- Retries, Idempotency, Rate Limits, Timeouts-Überlegungen

- Observability: Logs/Metriken/Traces + Alert-Grenzwerte

Was das Modell abdecken muss (nicht verhandelbar)

Nenne die Schnittstellen, die ausfallen können: externe APIs, DB, Queues, Auth-Provider und Background-Jobs. Dann verlange konkrete Entscheidungen:

- Retries: wann retryen, wie oft, Backoff-Strategie, welche Fehler retrybar sind

- Idempotenz: Idempotency-Keys, Dedupe-Fenster, und welcher State sicher erneut abgespielt werden kann

- Rate Limits: pro Nutzer/IP/Service-Limits, Nutzerkommunikation, serverseitiger Schutz

- Timeouts: pro Abhängigkeit, Gesamt-Request-Budget, und Cancellation-Propagation

Zuverlässigkeits-Checkliste

Beende das Prompt mit: „Gib eine einfache Checkliste zurück, die wir in 2 Minuten prüfen können.“ Eine gute Checkliste enthält Punkte wie: Abhängigkeits-Timeouts gesetzt, Retries begrenzt, Idempotenz für Create-/Charge-Aktionen implementiert, Backpressure/Rate-Limiting vorhanden, definierter Pfad für Graceful Degradation.

Observability an Nutzeraktionen binden

Fordere Events um Nutzer-Momente (nicht nur Systeminterna): „user_signed_up“, „checkout_submitted“, „payment_confirmed“, „report_generated“. Für jedes Event bitte um:

- Log-Felder (user_id, request_id, idempotency_key)

- Metriken (Erfolgsrate, Latenz p95/p99, Retry-Count)

- Traces (Spans pro Dependency-Call)

Das macht Zuverlässigkeit zu einem Design-Artefakt, das du prüfen kannst, bevor Code existiert.

Muster 8: MVP-Slice-Planung, um Über-Engineering zu vermeiden

Eine verbreitete Art, wie KI-unterstütztes Design Überarbeitungen erzeugt, ist das frühe Fördern „vollständiger“ Architekturen. Die Lösung: zwinge den Plan, mit der kleinsten nutzbaren Scheibe zu starten — eine, die Wert liefert, das Design validiert und spätere Optionen offenhält.

Das Prompt-Template

Verwende das, wenn die Lösung schneller wächst als die Anforderungen:

Template: „Schlage die kleinste nutzbare Scheibe vor; definiere Erfolgsmessungen; liste Follow-ups.“

Lass das Modell antworten mit:

- MVP-Slice: was enthalten ist, um etwas Reales zu liefern

- Erfolgsmessungen: wie du weißt, dass es funktioniert (nutzerseitig + technisch)

- Follow-ups: was warten kann, ohne das Lernen zu blockieren

Eine phasierte Roadmap verlangen (MVP → v1 → v2)

Füge hinzu: „Gib eine phasierte Roadmap: MVP → v1 → v2, und erkläre, welches Risiko jede Phase reduziert.“ So bleiben spätere Ideen sichtbar, ohne sie in die erste Version zu zwingen.

Beispielhafte Ergebnisse:

- MVP validiert den Kern-Workflow und einen dünnen End-to-End-Pfad.

- v1 härtet Zuverlässigkeit, fügt fehlende Must-Have-Usability hinzu.

- v2 erweitert die Breite (mehr Integrationen, erweiterte Rollen, Optimierungen).

Explizite Ausschlüsse verlangen, um Scope-Creep zu verhindern

Die mächtigste Zeile in diesem Muster ist: „Liste, was explizit für das MVP out-of-scope ist.“ Ausschlüsse schützen Architekturentscheidungen vor verfrühter Komplexität.

Gute Ausschlüsse sehen so aus:

- „Kein Multi-Region-Failover im MVP (Incidents loggen; für v2 planen).“

- „Kein Plugin-System (Grenzen sauber halten, aber fixe Module ausliefern).“

- „Nur ein Zahlungsanbieter; später abstrahieren, falls nötig.“

Den Plan in Tickets mit Abhängigkeiten umwandeln

Abschließend: „Wandle das MVP in Tickets um, jedes mit Akzeptanzkriterien und Abhängigkeiten.“ Das erzwingt Klarheit und entlarvt versteckte Kopplungen.

Eine solide Ticket-Aufteilung enthält typischerweise:

- Einen dünnen End-to-End „Happy Path“

- Minimales Datenmodell + API-Vertrag

- Basis-Fehlerbehandlung und Logging

- Einen Integrationspunkt (falls nötig) mit stub-Fallback

Wenn gewünscht, lass das Modell in eurem Team-Format ausgeben (z. B. Jira-Felder) und halte spätere Phasen als separates Backlog.

Klare Grenzen setzen

Definiere 4 bis 8 Module mit klaren Schnittstellen, damit Geschäftsregeln nicht überall durchdringen.

Eine einfache Methode, Architektur-Abdrift zu stoppen, ist, Klarheit durch Tests bevor du ein Design anforderst, zu erzwingen. Wenn du ein LLM bittest, zuerst Akzeptanztests zu schreiben, muss es Verhalten, Inputs, Outputs und Randfälle benennen. Das legt fehlende Anforderungen offen und treibt die Implementierung zu sauberen Modulgrenzen.

Copy/Paste-Prompt-Template

Nutze dies als „Gate“-Prompt, wenn du kurz davor bist, eine Komponente zu designen:

- Template: „Schreibe zuerst Akzeptanztests; dann schlage eine Implementierung vor. Du musst: (1) Annahmen auflisten, (2) Unit vs Integration Tests benennen, (3) Testdaten und Mocks vs reale Abhängigkeiten definieren, (4) eine Definition of Done enthalten.“

Test-Grenzen, die mit Modulen übereinstimmen

Folge mit: „Gruppiere die Tests nach Modulverantwortung (API-Layer, Domain-Logik, Persistence, externe Integrationen). Für jede Gruppe spezifizieren, was gemockt und was echt ist.“

Das drängt das LLM weg von verworrenen Designs, in denen alles alles berührt. Wenn es nicht erklären kann, wo Integrationstests beginnen, ist deine Architektur wahrscheinlich noch nicht klar.

Testdaten-Strategie: brittle Suites vermeiden

Fordere: „Schlage einen Testdaten-Plan vor: Fixtures vs Factories, wie Randfälle generiert werden und wie Tests deterministisch bleiben. Liste, welche Abhängigkeiten in-memory-Fakes nutzen können und welche einen echten Dienst in CI brauchen."

Oft entdeckst du, dass ein „einfaches“ Feature eigentlich einen Vertrag, Seed-Dataset oder stabile IDs braucht — besser, das jetzt zu finden als später während einer Überarbeitung.

Definition of Done (damit das Design shipped)

Beende mit einer leichten Checkliste:

- Tests bestehen (Unit + Integration) und sinnvolle Abdeckung von Fehlerfällen

- Minimale Docs: Nutzung, Konfiguration und kurzes Troubleshooting

- Monitoring/Alerts für Schlüssel-Failure-Modes

- Rollout-Plan (Feature-Flag, Migration-Schritte, Rollback)

Muster 10: Design-Review-Prompts, um Probleme früh zu fangen

Design-Reviews sollten nicht erst nach existierendem Code stattfinden. Mit KI kannst du eine „Pre-Mortem-Review“ auf deinen Architektur-Entwurf durchführen (auch nur ein paar Absätze oder ein Diagramm-in-Worten) und eine konkrete Liste von Schwächen bekommen, bevor sie zu Überarbeitungen führen.

Das Kern-Review-Template

Beginne mit einer direkten Reviewer-Haltung und zwinge zur Spezifikation:

Prompt: „Agier als Reviewer; liste Risiken, Inkonsistenzen und fehlende Details in diesem Design. Sei konkret. Wenn du etwas nicht beurteilen kannst, sage, welche Information fehlt.“

Füge deine Design-Zusammenfassung, Zwänge (Budget, Timeline, Team-Skills) und nicht-funktionale Anforderungen (Latenz, Verfügbarkeit, Compliance) bei.

Feedback in eine umsetzbare Punch-Liste verwandeln

Reviews scheitern, wenn Feedback vage ist. Bitte um eine priorisierte Liste von Fixes:

Prompt: „Gib mir eine priorisierte Punch-Liste. Für jeden Punkt: Severity (Blocker/High/Medium/Low), warum es wichtig ist, vorgeschlagene Lösung und den kleinsten Validierungsschritt.“

Das erzeugt handlungsbereite Tasks statt Debatten.

Rewrite-Risiko quantifizieren

Eine nützliche Forcierung ist eine einfache Bewertung:

Prompt: „Assign a rewrite risk score from 1–10. Explain the top 3 drivers. What would reduce the score by 2 points with minimal effort?"

Ziel ist nicht Präzision, sondern die Oberfläche der annähernd rewrite-anfälligsten Annahmen.

Mit einem „Diff-Plan“ abschließen

Vermeide, dass die Review Scope aufbläht:

Prompt: „Provide a diff plan: minimal changes needed to reach the target design. List what stays the same, what changes, and any breaking impacts."

Wenn du dieses Muster iterativ anwendest, entwickelt sich die Architektur in kleinen, reversiblen Schritten — während die großen Probleme früh entdeckt werden.

Eine Copy-Paste-Prompt-Pack und ein einfacher Workflow

Nutze dieses Pack als leichtgewichtigen Workflow, den du bei jedem Feature wiederholen kannst. Die Idee ist, Prompts zu ketten, sodass jeder Schritt ein Artefakt erzeugt, das der nächste wiederverwenden kann — so geht weniger Kontext verloren und es entstehen weniger Überraschungs-Überarbeitungen.

Der 6-Schritte-Workflow (diese Muster verketten)

- Anforderungen (klären + Zwänge)

- Architekturoptionen (2–3 Ansätze vergleichen)

- Grenzen (Module + Verantwortlichkeiten)

- Verträge (Daten + APIs)

- Tests (test-first Akzeptanz + wichtige Unit-Tests)

- Review (Failure-Modes + Design-Review-Checkliste)

In der Praxis implementieren Teams diese Kette oft als wiederholbares „Feature-Rezept“. Wenn du mit Koder.ai baust, lässt sich dieselbe Struktur sauber auf einen chatgetriebenen Build-Prozess abbilden: Sammle die Artefakte an einem Ort, generiere die erste funktionierende Scheibe und iteriere mit Snapshots, damit Experimente reversibel bleiben. Wenn das MVP bereit ist, kannst du Quellcode exportieren oder deployen/hosten mit einer Custom-Domain — praktisch, wenn du die Geschwindigkeit KI-gestützter Lieferung willst, ohne dich an eine einzige Umgebung zu binden.

Copy/Paste Prompt Pack (mit Guardrails)

SYSTEM (optional)

You are a software architecture assistant. Be practical and concise.

Guardrail: When you make a recommendation, cite the specific lines from *my input* you relied on by quoting them verbatim under “Input citations”. Do not cite external sources or general industry claims.

If something is unknown, ask targeted questions.

1) REQUIREMENTS CLARIFIER

Context: <product/system overview>

Feature: <feature name>

My notes: <paste bullets, tickets, constraints>

Task:

- Produce: (a) clarified requirements, (b) non-goals, (c) constraints, (d) open questions.

- Include “Input citations” quoting the exact parts of my notes you used.

2) ARCHITECTURE OPTIONS

Using the clarified requirements above, propose 3 architecture options.

For each: tradeoffs, complexity, risks, and when to choose it.

End with a recommendation + “Input citations”.

3) MODULAR BOUNDARIES

Chosen option: <option name>

Define modules/components and their responsibilities.

- What each module owns (and does NOT own)

- Key interfaces between modules

- “Input citations”

4) DATA & API CONTRACTS

For each interface, define a contract:

- Request/response schema (or events)

- Validation rules

- Versioning strategy

- Error shapes

- “Input citations”

5) TEST-FIRST ACCEPTANCE

Write:

- Acceptance criteria (Given/When/Then)

- 5–10 critical tests (unit/integration)

- What to mock vs not mock

- “Input citations”

6) RELIABILITY + DESIGN REVIEW

Create:

- Failure modes list (timeouts, partial failure, bad data, retries)

- Observability plan (logs/metrics/traces)

- Review checklist tailored to this feature

- “Input citations”

Wenn du eine tiefere Begleitung willst, siehe /blog/prompting-for-code-reviews. Wenn du Tools oder Team-Rollout evaluierst, ist /pricing ein praktischer nächster Schritt.