16. Okt. 2025·8 Min

REST vs. gRPC: Den richtigen API‑Stil für Ihre App wählen

Vergleiche REST und gRPC für reale Projekte: Leistung, Tooling, Streaming, Kompatibilität und Team-Fit. Nutze eine einfache Checkliste, um die Wahl sicher zu treffen.

Vergleiche REST und gRPC für reale Projekte: Leistung, Tooling, Streaming, Kompatibilität und Team-Fit. Nutze eine einfache Checkliste, um die Wahl sicher zu treffen.

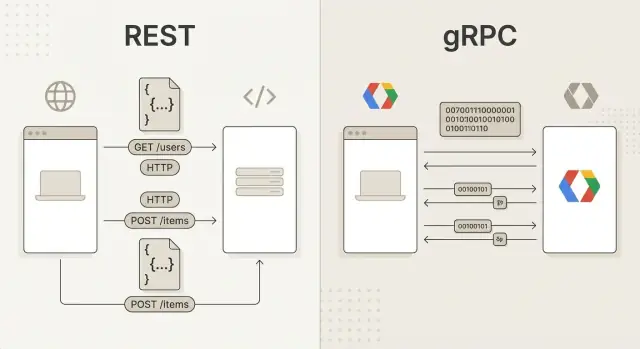

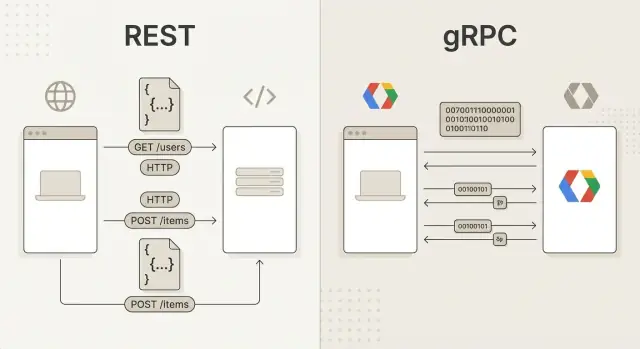

Wenn Leute REST und gRPC vergleichen, vergleichen sie im Grunde zwei verschiedene Arten, wie Software über ein Netzwerk „miteinander spricht“.

REST ist ein API-Designstil, der um Ressourcen aufgebaut ist—Dinge, die deine App verwaltet, wie Benutzer, Bestellungen oder Rechnungen. Du interagierst mit diesen Ressourcen über vertraute HTTP-Anfragen:

GET /users/123)POST /orders)Antworten sind häufig JSON, das leicht zu inspizieren ist und breite Unterstützung findet. REST wirkt oft intuitiv, weil es dem Webmodell entspricht—und weil du es mit einem Browser oder einfachen Tools testen kannst.

gRPC ist ein Framework für Remote Procedure Calls (RPC). Anstatt in „Ressourcen“ zu denken, denkst du in Methoden, die du auf einem anderen Dienst ausführen willst, wie CreateOrder oder GetUser.

Unter der Haube verwendet gRPC typischerweise:

.proto-Datei), die Client- und Servercode generieren kannDas Ergebnis fühlt sich oft an wie ein lokaler Funktionsaufruf—nur dass er irgendwo anders ausgeführt wird.

Dieser Leitfaden hilft dir bei der Auswahl anhand realer Zwänge: Leistungserwartungen, Client-Typen (Browser vs. Mobile vs. interne Dienste), Echtzeitbedarf, Team-Workflow und langfristige Wartbarkeit.

Es gibt keine Einheitslösung. Viele Teams nutzen REST für öffentliche oder Drittanbieter-APIs und gRPC für interne Service-zu-Service-Kommunikation—aber deine Einschränkungen und Ziele sollten die Wahl bestimmen.

Bevor du Funktionen vergleichst, kläre, wonach du optimierst. REST und gRPC können beide gut funktionieren, aber sie glänzen unter unterschiedlichen Bedingungen.

Beginne mit den Clients.

curl testen lassen, ist REST meist die sichere Default-Wahl.Im öffentlichen Internet achtest du auf Proxies, Caching-Layer und Kompatibilität mit verschiedenem Tooling. REST über HTTP ist breit unterstützt und navigiert Unternehmensnetzwerke oft vorhersehbarer.

Innerhalb eines privaten Netzwerks (oder zwischen Diensten auf derselben Plattform) kannst du gRPCs engere Protokolle und strukturiertere Kommunikation nutzen—insbesondere wenn du beide Enden kontrollierst.

Frage, wie „normaler Traffic“ aussieht:

Wenn du Streaming (Events, Fortschritts-Updates, kontinuierliche Feeds) brauchst, berücksichtige das früh. Du kannst Echtzeit-Verhalten mit REST-nahen Ansätzen bauen, aber gRPCs Streaming-Modell ist oft natürlicher, wenn beide Seiten es unterstützen.

Wähle, was dein Team sicher liefern und betreiben kann. Berücksichtige bestehende API-Standards, Debugging-Gewohnheiten, Release-Rhythmus und wie schnell neue Entwickler produktiv werden. Ein „bestes“ Protokoll, das Lieferung verlangsamt oder das Betriebsrisiko erhöht, ist für dein Projekt nicht das Beste.

Auf Protokollebene laufen REST und gRPC beide auf das hinaus: „ein Client ruft einen Server auf“, aber sie beschreiben diesen Aufruf unterschiedlich: REST zentriert sich auf HTTP-Ressourcen und Statuscodes, gRPC auf entfernte Methoden und ein striktes Schema.

REST-APIs laufen typischerweise über HTTP/1.1 und zunehmend auch HTTP/2. Die „Form“ eines REST-Aufrufs wird definiert durch:

/users/123)GET, POST, PUT, PATCH, DELETE200, 201, 400, 401, 404, 500 etc.Accept, Content-Type)Das typische Muster ist request/response: der Client sendet eine HTTP-Anfrage, der Server liefert eine Antwort mit Statuscode, Headern und Body (oft JSON).

gRPC verwendet immer HTTP/2, legt aber nicht „Ressourcen + Verben“ als primäres Interface offen. Stattdessen definierst du Services mit Methoden (wie CreateUser oder GetUser) und rufst diese als Remote Procedure Calls auf.

Neben der Nachrichtennutzlast unterstützt gRPC:

REST fragt: „Auf welche Ressource wirkst du, und welches HTTP-Verb passt?“

gRPC fragt: „Welche Methode rufst du auf, und welche typisierte Nachricht akzeptiert/returnt sie?“

Dieser Unterschied beeinflusst Namensgebung, Fehlerbehandlung (HTTP-Statuscodes vs. gRPC-Status) und wie Clients generiert werden.

.proto-Schema ist der Vertrag. Sie definiert Services, Methoden und stark typisierte Nachrichten, ermöglicht verlässliche Codegenerierung und klarere Kompatibilitätsregeln bei der Weiterentwicklung der API.Performance ist eines der häufigsten Argumente für gRPC—aber der Gewinn ist nicht automatisch. Die eigentliche Frage ist, welche Form von „Performance“ du brauchst: geringere Latenz pro Aufruf, höheren Durchsatz bei Last, niedrigere Bandbreitenkosten oder bessere Servereffizienz.

Die meisten REST-APIs verwenden JSON über HTTP/1.1. JSON ist leicht zu inspizieren, zu loggen und zu debuggen—das ist eine praktische Form von Effizienz für Teams.

Der Nachteil ist, dass JSON umfangreicher ist und mehr CPU für Parsing und Erzeugung benötigt, besonders bei großen Payloads oder häufigen Aufrufen. HTTP/1.1 kann zudem Verbindungs- und Anfrage-Overhead hinzufügen, wenn Clients viele parallele Anfragen stellen.

REST kann auch ein Performance-Vorteil in leseintensiven Architekturen sein: HTTP-Caching (über Header wie ETag und Cache-Control) kann wiederholte Anfragen drastisch reduzieren—insbesondere in Kombination mit CDNs.

gRPC nutzt typischerweise Protocol Buffers (binär) über HTTP/2. Das bedeutet in der Regel:

Diese Vorteile treten am deutlichsten in Service-zu-Service-Aufrufen mit hohem Anfragevolumen oder wenn große Datenmengen innerhalb eines Microservices-Systems bewegt werden, zutage.

Auf einem ruhigen System können REST und gRPC ähnlich schnell wirken. Die Unterschiede werden offensichtlich, wenn die Konkurrenz zunimmt.

Performance-Unterschiede sind am wichtigsten bei häufigen internen Aufrufen, großen Payloads, engen mobilen Bandbreitenbeschränkungen oder strengen SLOs.

Sie sind weniger relevant, wenn deine API von Datenbankzeit, Drittanbieteraufrufen oder menschlicher Nutzung dominiert wird (Admin-Dashboards, typische CRUD-Apps). In solchen Fällen überwiegen Klarheit, Cachebarkeit und Client-Kompatibilität möglicherweise die reine Protokolleffizienz.

Echtzeitfunktionen—Live-Dashboards, Chat, Zusammenarbeit, Telemetrie, Benachrichtigungen—hängen davon ab, wie deine API „andauernde“ Kommunikation handhabt, nicht nur Einmalanfragen.

REST ist grundlegend request/response: der Client fragt, der Server antwortet, die Verbindung endet. Du kannst Echtzeitverhalten damit entwickeln, aber normalerweise greifst du auf Muster rund um REST zurück:

(Für browserbasiertes Echtzeit ergänzen Teams oft REST mit WebSockets oder SSE; das ist ein separater Kanal mit eigenem Betriebsmodell.)

gRPC unterstützt mehrere Aufruftypen über HTTP/2, und Streaming ist ins Modell eingebaut:

Das macht gRPC zu einer starken Wahl, wenn du anhaltende, latenzarme Nachrichtenflüsse willst, ohne ständig neue HTTP-Anfragen aufzumachen.

Streaming eignet sich für:

Lang geöffnete Streams verändern den Betrieb:

Wenn „Echtzeit“ zentral für dein Produkt ist, kann gRPCs Streaming-Modell die Komplexität gegenüber Polling/Webhooks (und ggf. WebSockets) reduzieren.

Die Wahl zwischen REST und gRPC dreht sich nicht nur um Geschwindigkeit—dein Team arbeitet täglich mit der API. Tooling, Onboarding und wie sicher du ein Interface weiterentwickeln kannst, sind oft wichtiger als roher Durchsatz.

REST wirkt vertraut, weil es auf einfachem HTTP basiert und meist JSON spricht. Das bedeutet: Browser-Devtools, curl, Postman/Insomnia, Proxies und Logs, die keiner speziellen Viewer brauchen.

Wenn etwas kaputtgeht, ist Debugging oft unkompliziert: Spiel eine Anfrage im Terminal nach, prüfe Header und vergleiche Antworten. Diese Bequemlichkeit ist ein großer Grund, warum REST bei öffentlichen APIs und bei viel Ad-hoc-Testing verbreitet ist.

gRPC nutzt typischerweise Protocol Buffers und Codegenerierung. Statt Anfragen manuell zusammenzubauen, rufen Entwickler typisierte Methoden in ihrer Sprache auf.

Die Vorteile sind Typensicherheit und ein klarer Vertrag: Felder, Enums und Nachrichtenformen sind explizit. Das reduziert „stringly-typed“-Bugs und Ungereimtheiten zwischen Client und Server—besonders bei Service-zu-Service-Aufrufen.

REST ist schneller zu erlernen: „Sende eine HTTP-Anfrage an diese URL.“ gRPC verlangt, dass neue Teammitglieder .proto-Dateien, Codegen und oft andere Debugging-Workflows verstehen. Teams, die an starke Typisierung und geteilte Schemata gewöhnt sind, passen sich meist schneller an.

Bei REST/JSON basiert das Änderungsmanagement oft auf Konventionen (Felder hinzufügen, Endpunkte deprecaten, versionierte URLs). Bei gRPC/Protobuf sind Kompatibilitätsregeln formaler: Felder hinzufügen ist in der Regel sicher, aber Umbenennungen/Entfernungen oder Typänderungen können Konsumenten brechen.

In beiden Stilen verbessert sich Wartbarkeit, wenn du die API als Produkt behandelst: dokumentiere sie, automatisiere Vertragstests und veröffentliche eine klare Deprecation-Policy.

Die Entscheidung zwischen REST und gRPC hängt oft davon ab, wer deine API aufruft—und aus welchen Umgebungen.

REST über HTTP mit JSON ist breit unterstützt: Browser, Mobile-Apps, Kommandozeilen-Tools, Low-Code-Plattformen und Partner-Systeme. Wenn du eine öffentliche API baust oder Drittintegrationen erwartest, minimiert REST in der Regel Reibung, weil Konsumenten mit einfachen Anfragen beginnen und später bessere Tools übernehmen können.

REST passt auch natürlich zu Web-Einschränkungen: Browser handhaben HTTP gut, Caches und Proxies verstehen es, und Debugging ist mit gängigen Tools einfach.

gRPC glänzt, wenn du beide Enden kontrollierst (deine Services, interne Apps, Backend-Teams). Es nutzt HTTP/2 und Protocol Buffers, was für Performance und Konsistenz sorgen kann—aber nicht jede Umgebung kann es leicht übernehmen.

Browser unterstützen zum Beispiel keine „vollständigen“ nativen gRPC-Aufrufe direkt. Du kannst gRPC-Web verwenden, aber das fügt Komponenten und Einschränkungen hinzu (Proxies, spezielle Content-Types, anderes Tooling). Für Drittparteien kann die Forderung nach gRPC eine höhere Einstiegshürde sein als ein REST-Endpunkt.

Ein gängiges Muster ist, intern gRPC zu nutzen und extern REST über ein Gateway oder eine Übersetzungsschicht anzubieten. So können Partner vertrautes HTTP/JSON nutzen, während deine internen Systeme den stark typisierten Vertrag beibehalten.

Wenn deine Zielgruppe unbekannte Drittparteien enthält, ist REST meist die sichere Default-Wahl. Wenn die Zielgruppe hauptsächlich deine eigenen Dienste ist, passt gRPC oft besser.

Sicherheit und Betreibbarkeit sind oft der Punkt, an dem etwas, das in einer Demo schön aussieht, in Produktion kompliziert wird. REST und gRPC können beide sicher und beobachtbar sein, aber sie passen zu unterschiedlichen Infrastrukturmustern.

REST läuft typischerweise über HTTPS (TLS). Authentifizierung wird meist in Standard-HTTP-Headern transportiert:

Weil REST auf vertrauten HTTP-Semantiken basiert, lässt es sich leicht in vorhandene WAFs, Reverse Proxies und API-Gateways integrieren, die Pfade, Header und Methoden verstehen.

gRPC nutzt ebenfalls TLS, aber Authentifizierung wird häufig über Metadaten (Key/Value) übertragen. Gängige Maßnahmen sind:

authorization: Bearer …)Bei REST bieten viele Plattformen Out-of-the-Box Access-Logs, Statuscodes und Request-Timings. Du kommst weit mit strukturierten Logs und Standardmetriken wie Latenz-Percentiles, Fehlerraten und Durchsatz.

Bei gRPC ist Observability sehr gut, sobald instrumentiert, aber in manchen Stacks weniger „automatisch“, weil du nicht mit klaren URLs arbeitest. Priorisiere:

Gängige REST-Setups platzieren ein Ingress oder API-Gateway am Edge für TLS-Termination, Auth, Rate Limiting und Routing.

gRPC funktioniert ebenfalls hinter einem Ingress, aber du brauchst Komponenten, die HTTP/2 und gRPC-Features vollständig unterstützen. In Microservices-Umgebungen kann ein Service Mesh mTLS, Retries, Timeouts und Telemetrie für gRPC vereinfachen—besonders wenn viele interne Dienste miteinander kommunizieren.

Operative Zusammenfassung: REST integriert sich meist reibungsloser mit „Standard-Web“-Tooling, während gRPC punktet, wenn du Deadlines, Service-Identität und einheitliche Telemetrie für interne Aufrufe standardisieren willst.

Die meisten Teams wählen nicht REST oder gRPC abstrakt—sie wählen, was zur Form ihrer Nutzer, Clients und ihres Traffics passt. Diese Szenarien machen die Kompromisse klarer.

REST ist oft die „sichere“ Wahl, wenn deine API breit konsumierbar und leicht explorierbar sein muss.

Verwende REST, wenn du baust:

REST glänzt an den Rändern deines Systems: lesbar, oft cache-fähig und gut mit Gateways, Dokumentation und Standardinfrastruktur kombinierbar.

gRPC ist meist die bessere Wahl für Service-zu-Service-Kommunikation, wenn Effizienz und starke Verträge wichtig sind.

Wähle gRPC, wenn du hast:

In diesen Fällen reduzieren gRPCs binäre Kodierung und HTTP/2-Features oft Overhead und machen Performance vorhersehbarer, wenn der interne Traffic wächst.

Ein gängiges, praktisches Architektur-Muster ist:

Dieses Muster beschränkt gRPCs Kompatibilitätsanforderungen auf deine kontrollierte Umgebung und gibt internen Systemen die Vorteile typisierter Verträge und effizienter Aufrufe.

Einige Entscheidungen verursachen regelmäßig späteren Schmerz:

/doThing pressen und die Klarheit ressourcenorientierten Designs verlieren.Wenn du unsicher bist, nutze REST für externe APIs und setze gRPC dort ein, wo du nachweisen kannst, dass es hilft: innerhalb deiner Plattform, auf heißen Pfaden oder wo Streaming und strikte Verträge echten Mehrwert bringen.

Die Wahl zwischen REST und gRPC fällt leichter, wenn du bei den Konsumenten und ihren Aufgaben beginnst—nicht bei dem, was gerade trendy ist.

Frage:

Nutze das als Filter:

Wähle einen repräsentativen Endpunkt (nicht „Hello World") und implementiere ihn als:

Messe:

Wenn du schnell einen solchen Pilot machen willst, kann ein vibe-coding Workflow helfen: z. B. mit Tools wie Koder.ai skizzierst du eine kleine App und Backend aus einem Chat-Prompt und testest sowohl REST als auch gRPC intern. Weil Koder.ai reale Projekte generiert (React für Web, Go-Backends mit PostgreSQL, Flutter für Mobile), ist es ein praktischer Weg, nicht nur Protokoll-Benchmarks, sondern auch Developer Experience—Dokumentation, Client-Integration und Deployment—zu validieren. Funktionen wie Planungsmodus, Snapshots und Rollback sind beim Iterieren der API-Form hilfreich.

Dokumentiere die Entscheidung, die Annahmen (Konsumenten, Traffic, Streaming) und die Metriken, die du verwendet hast. Überprüfe die Entscheidung, wenn sich Anforderungen ändern (neue externe Konsumenten, höherer Durchsatz, Echtzeit-Funktionen).

Oft ja—insbesondere für Service-zu-Service-Aufrufe—aber nicht automatisch.

gRPC ist effizienter, weil es HTTP/2 (Multiplexing) und ein kompaktes Binärformat (Protocol Buffers) nutzt. Das kann CPU- und Bandbreitenbedarf gegenüber JSON-over-HTTP reduzieren.

Die realen Unterschiede hängen ab von:

Wenn Performance wichtig ist, benchmarke deine konkreten Endpunkte mit realistischen Daten.

Browser können kein „vollständiges“ natives gRPC direkt verwenden, weil sie nicht die nötigen HTTP/2-Features exposeen.

Optionen:

Bei Drittparteien- oder Browser-lastigen Clients ist REST meist die unkompliziertere Wahl.

gRPC ist auf Protobuf-Verträge, Codegenerierung und strikte Typisierung ausgelegt. Du kannst andere Formate senden, aber du verlierst viele Vorteile.

Protobuf hilft, wenn du klare Verträge, kleinere Payloads und konsistente Client-/Server-Implementierungen willst.

Für REST sind übliche Ansätze /v1/ im Pfad oder Versionierung via Header; halte Änderungen rückwärtskompatibel, wenn möglich.

Für gRPC/Protobuf:

REST ist normalerweise die Default-Wahl für öffentliche APIs, weil fast jeder Client sie mit einfachem HTTP und JSON aufrufen kann.

Wähle REST, wenn du erwartest:

curl/PostmangRPC passt oft besser, wenn du beide Enden der Verbindung kontrollierst und einen stark typisierten Vertrag willst.

Es ist eine gute Wahl für:

Nicht immer. gRPC gewinnt oft bei Payload-Größe und Verbindungseffizienz (HTTP/2-Multiplexing + Protobuf), aber die tatsächlichen End-to-End-Ergebnisse hängen von deinen Flaschenhälsen ab.

Benchmark mit realistischen Daten, denn Performance kann dominiert werden von:

REST unterstützt HTTP-Caching natürlich mit Headern wie Cache-Control und ETag, außerdem CDNs und gemeinsame Proxies.

gRPC ist normalerweise nicht auf die gleiche Weise cache-freundlich, weil Aufrufe methodenorientiert sind und von Standard-HTTP-Infrastruktur oft als nicht-cachebar behandelt werden.

Wenn Caching eine Schlüsselanforderung ist, ist REST in der Regel der einfachere Weg.

Browser können nicht direkt „nativen“ gRPC verwenden, weil ihnen die niedrigen HTTP/2-Features fehlen, die gRPC erwartet.

Gängige Optionen:

Für stark browserbasierte Clients ist REST meist die einfachere Default-Option.

gRPC ist auf ein .proto-Schema ausgelegt, das Dienste, Methoden und Nachrichtentypen definiert. Dieses Schema ermöglicht Codegenerierung und klare Kompatibilitätsregeln.

Technisch kannst du andere Encodings verwenden, aber du gibst viele Vorteile auf. Wenn du die Hauptvorteile von gRPC willst, behandle Protobuf als integralen Bestandteil.

REST kommuniziert Ergebnisse typischerweise über HTTP-Statuscodes (z. B. 200, 404, 500) und Antwortkörper.

gRPC liefert einen gRPC-Statuscode (wie OK, NOT_FOUND, UNAVAILABLE) plus optionale Fehlerdetails.

Praktischer Tipp: Standardisiere die Fehlerzuordnung früh (inkl. retryable vs. non-retryable), damit Clients sich konsistent verhalten.

Streaming ist in gRPC eine Kernfunktion mit eingebauter Unterstützung für:

REST ist primär request/response; „Echtzeit“ erfordert meist zusätzliche Muster wie Polling, Long Polling, Webhooks, WebSockets oder SSE.

Für REST sind übliche Praktiken:

/v1/...-Pfad oder HeaderFür gRPC/Protobuf:

Ja — das ist gängig:

Ein Gateway oder Backend-for-Frontend kann REST/JSON in gRPC/Protobuf übersetzen. So reduzierst du Client-Hürden und behältst gleichzeitig gRPCs Vorteile intern.