Was „beste Backend‑Sprache" wirklich bedeutet

„Beste Backend‑Sprache" ist meist die Kurzform für „die beste Passung für das, was ich baue, mit den Leuten und Beschränkungen, die ich habe.“ Eine Sprache kann perfekt für eine Backend‑Workload sein und eine schlechte Wahl für eine andere — selbst wenn sie populär, schnell oder beim Team beliebt ist.

Beginne damit, das echte Ziel zu benennen

Bevor du Node.js‑Backend vs Python‑Backend vs Java‑Backend (und so weiter) vergleichst, benenne die Aufgabe, die dein Backend erledigen muss:

- APIs für Mobile/Web: vorhersehbare Latenz, saubere API‑Entwurfsmuster, gute Observability

- Web‑Apps: schnelle Iteration, Templating, Hintergrundjobs, Integrationen

- Microservices: operative Konsistenz, Deploy‑Tooling, starke Verträge zwischen Diensten

- Daten‑schwere Dienste: Batch/Streaming, Speicherverhalten, DB‑ und Queue‑Integrationen

- Echtzeit‑Systeme: Nebenläufigkeitsmodell, Backpressure, WebSockets, Event‑getriebene Architektur

Verschiedene Ziele verschieben die Gewichtung zwischen Performance vs Produktivität. Eine Sprache, die Feature‑Lieferung für eine CRUD‑API beschleunigt, kann dich bei hochdurchsatzfähigen Streaming‑ oder latenzsensitiven Systemen bremsen.

Kläre Beschränkungen, die die „technisch beste" Option überstimmen können

Die Wahl einer Backend‑Programmiersprache wird oft eher durch Restriktionen als durch Features getroffen:

- Zeitplan: Kannst du in Wochen liefern oder ist das eine mehrjährige Plattform?

- Team‑Skills: Hast du heute Leute für Go/.NET, oder wäre das ein Lernprojekt?

- Hosting und Ops: Container‑first? Serverless? Windows‑only? Kostenlimits?

- Compliance & Security: Audit‑Anforderungen, Dependency‑Policies, Patch‑Rhythmus

- Bestehender Codebestand: Wiederverwendbare Bibliotheken, geteilte Modelle, Monorepo‑Praktiken und Integrationspunkte

Setze die richtige Erwartung

Es gibt nicht die eine beste Backend‑Sprache in 2026 — nur Trade‑offs. Ruby on Rails kann beim schnellen Produktaufbau punkten, Go bei operativer Einfachheit, Java bei reifen Ökosystemen und Enterprise‑Tooling, Node.js bei Echtzeit und Full‑Stack‑JavaScript.

Am Ende dieses Guides solltest du in der Lage sein, eine Sprache mit Selbstvertrauen zu wählen, indem du sie an Workload, Constraints und langfristiger Verantwortung misst — nicht an Hype oder Rankings.

Die Kernkriterien vor dem Vergleich

Die Wahl einer Backend‑Programmiersprache ist weniger „was ist am besten" als „was optimiert unsere konkreten Ergebnisse“. Bevor du Node.js‑ vs Python‑ oder Java‑ vs Go‑Backends vergleichst, formuliere die Kriterien explizit — sonst diskutierst du Präferenzen statt dass eine Entscheidung getroffen wird.

Eine praktikable Entscheidungsbasis

Fange mit einer kurzen Liste an, die du wirklich bewerten kannst:

- Time‑to‑market: wie schnell das Team eine stabile API liefern, iterieren und Bugs fixen kann.

- Runtime‑Performance: Latenz und Durchsatz unter erwarteter Last — nicht Microbenchmarks.

- Nebenläufigkeitsmodell: wie die Sprache viele gleichzeitige Anfragen, Hintergrundjobs, Streaming und I/O handhabt.

- Stabilität und Reife: Release‑Rhythmus, Rückwärtskompatibilität und wie oft „kleine Upgrades" zu Projekten werden.

Füge domänenspezifische Anforderungen hinzu (z. B. Echtzeit‑Features, schwere Datenverarbeitung oder strikte Compliance).

TCO schlägt „nur Entwickler‑Geschwindigkeit"

TCO ist der kombinierte Preis für Bau und Betrieb des Systems:

- Entwicklungsgeschwindigkeit: Scaffolding, Frameworks und wie viel Boilerplate das Team warten muss.

- Betrieb: Observability, Deploy‑Komplexität, Runtime‑Footprint und On‑Call‑Aufwand.

- Hiring & Ramp‑Up: Verfügbarkeit von Talenten für .NET, Go, Ruby on Rails etc.

- Maintenance: Lesbarkeit, Testbarkeit, Sicherheitsfeatures und Kosten von Refactors über Jahre.

Eine Sprache, die schnell zu prototypen ist, kann teuer werden, wenn sie zu häufigen Incidents oder schwer änderbarem Code führt.

Versteckte Beschränkungen, die still entscheiden

Manche Restriktionen sind nicht verhandelbar — besser, sie früh offen zu legen:

- Provider/Cloud‑Services: First‑Class SDKs, Auth‑Stacks, Managed Queues und Serverless‑Runtimes.

- Enterprise‑Standards: genehmigte Runtimes, Sicherheitsvorgaben und Audit‑Anforderungen.

- Legacy‑Systeme: vorhandene Bibliotheken, JVM/.NET‑Dependencies oder geteilter Code mit anderen Teams.

Gewichte Kriterien nach Business‑Prioritäten

Behandle nicht jedes Kriterium gleich. Wenn du den Markt validierst, gewichte Time‑to‑market höher. Wenn du eine langlebige interne Plattform baust, sind Wartbarkeit und operative Stabilität entscheidender. Ein einfaches gewichtetes Scoring hält das Gespräch ergebnisorientiert und macht Trade‑offs für API‑Entwicklung und darüber hinaus explizit.

Beginne bei Workload und Architektur

Bevor du Syntax oder Benchmarks vergleichst, schreibe auf, was dein Backend tun muss und wie es geformt wird. Sprachen wirken „am besten", wenn sie zur Workload und Architektur passen, die du tatsächlich baust.

Karte deine Workload‑Typen

Die meisten Backends sind ein Mix, aber das dominierende Muster zählt:

- CRUD‑APIs (typische Produkt‑Apps): Request/Response, Validierung, Auth, DB‑Reads/Writes.

- CPU‑gebundene Tasks: Bild/Video‑Verarbeitung, schwere Transforms, Verschlüsselung, komplexe Reports.

- I/O‑gebundene Dienste: Chat, Gateways, Aggregationsservices, Webhooks, viel Warten auf DB/3rd‑Party.

- Streaming & Echtzeit: Event‑Ingest, Log‑Pipelines, WebSocket‑Dienste, Near‑Realtime‑Analytics.

Wenn dein System überwiegend I/O‑gebunden ist, sind Nebenläufigkeitsprimitiven, Async‑Tooling und Ergonomie oft wichtiger als rohe Rechengeschwindigkeit. Bei CPU‑gebundenen Workloads rücken vorhersehbare Performance und einfache Parallelisierung in den Vordergrund.

Verstehe Traffic‑ und Zuverlässigkeitsanforderungen

Die Traffic‑Gestalt verändert die Sprachanforderungen:

- Spiky Traffic (Marketing‑Releases, Ticket‑Drops): schnelle Cold‑Starts, Autoscaling‑Verhalten, Ressourceneffizienz.

- Konstanter hoher Durchsatz: anhaltende Performance, Speicherverhalten und reife Observability.

Beachte außerdem globale Latenzerwartungen und das angestrebte SLA. Ein 99.9% API‑SLA mit engen p95‑Anforderungen treibt dich zu ausgereiften Runtimes, starkem Tooling und bewährten Deploy‑Mustern.

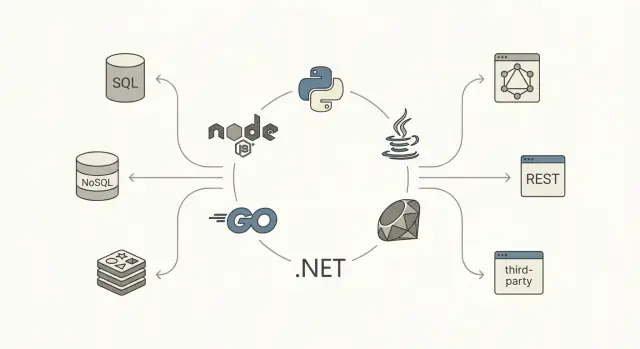

Sei spezifisch bezüglich Daten und Integration

Dokumentiere deinen Datenpfad:

- SQL vs NoSQL, Transaktionsbedarfe und Konsistenzanforderungen.

- Caching‑Layer (Redis/Memcached), Read‑Replicas und Analytics‑Pipelines.

Liste Integrationen auf: Third‑Party APIs, Messaging/Queues (Kafka, RabbitMQ, SQS) und Background Jobs. Wenn asynchrone Arbeit und Queue‑Consumer zentral sind, wähle ein Ökosystem, in dem Worker, Retries, Idempotenz‑Muster und Monitoring erstklassig sind — nicht nur nachträglich ergänzt.

Performance ist keine einzelne Zahl. Für Backends zerfällt sie meist in Latenz (wie schnell eine Anfrage beantwortet wird), Durchsatz (Requests pro Sekunde) und Ressourcennutzung (CPU, Speicher, teils Netzwerk/I/O). Sprache und Runtime beeinflussen alle drei — hauptsächlich durch Scheduling, Speicherverwaltung und Umgang mit blockierenden Operationen.

Latenz vs Durchsatz (und warum dein p95 zählt)

Eine Sprache, die in Microbenchmarks schnell wirkt, kann unter Last schlechte Tail‑Latenzen (p95/p99) liefern — oft wegen Contention, blockierender Calls oder Speicherdruck. Bei IO‑schweren Diensten kommen die größten Gewinne oft von weniger Wartezeit und besserer Nebenläufigkeit, nicht von ein paar Nanosekunden schnelleren Berechnungen.

Nebenläufigkeitsmodelle, die du tatsächlich spürst

Verschiedene Ökosysteme setzen unterschiedliche Ansätze:

- Async I/O (Event‑Loop): typisch für Node.js und zunehmend für Python/.NET/Java. Hervorragend bei hoher I/O‑Konkurrenz, aber CPU‑schwere Arbeit muss ausgelagert werden.

- Threads / Thread‑Pools: klassisch in Java und .NET. Einfaches Denkmodell, jedoch auf Pool‑Sättigung, Blocking und Context‑Switching achten.

- Goroutines: Go‑spezifisch leichtgewichtige Concurrency; trotzdem Awareness für Blocking‑Stellen, geteilten Zustand und Backpressure nötig.

- Actors / Message Passing: z. B. Akka (JVM), Orleans (.NET). Kapselt State, vereinfacht Nebenläufigkeit, bringt aber architektonischen Aufwand mit sich.

Garbage Collection und Speicherverhalten

GC‑verwaltete Runtimes steigern Produktivität, aber Allokationsrate und Heap‑Wachstum beeinflussen Tail‑Latenzen durch Pausen oder höheren CPU‑Aufwand für Collection. Du musst kein GC‑Experte sein — aber wissen, dass viele Allokationen und große Objekte bei Scale problematisch werden können.

Praktische Konsequenz: Messe deine kritischen Pfade

Implementiere oder prototype einige repräsentative Endpunkte und messe:

- p50/p95/p99‑Latenz unter realistischer Last

- Durchsatz bei akzeptablen Fehlerquoten

- CPU/Memory‑Profile während Spitzen

Behandle das als Engineering‑Experiment, nicht als Vermutung. Die Mischung aus I/O, Compute und Nebenläufigkeit in deiner Workload macht die „schnellste" Sprache in der Praxis oft anders aussehen.

Backend-Prototyp erstellen

Im Chat einen kleinen API-Prototyp erstellen und Latenz sowie Workflows testen.

Eine Backend‑Sprache funktioniert selten allein durch Syntax. Der Alltag wird durch das Ökosystem bestimmt: wie schnell Services gescaffoldet, Schemata entwickelt, Endpunkte gesichert, Änderungen getestet und sicher ausgeliefert werden.

Frameworks und „Standardpfade"

Suche Frameworks, die zu deinem Stil passen (minimal vs batteries‑included) und zu deiner Architektur (Monolith, modularer Monolith, Microservices). Ein gesundes Ökosystem hat meist mindestens eine verbreitete „Default"‑Option und solide Alternativen.

Achte auf die unscheinbaren Teile: reife ORMs oder Query‑Builder, verlässliche Migrationen, Auth‑/AuthZ‑Bibliotheken, Input‑Validierung und Hintergrundjob‑Tooling. Sind diese Stücke fragmentiert oder veraltet, reimplementieren Teams oft Basics und akkumulieren inkonsistente Muster zwischen Services.

Dependency‑Management und Release‑Rhythmus

Der beste Paketmanager ist der, den dein Team vorhersehbar bedienen kann. Beurteile:

- Wie Dependencies fixiert/gelockt werden (reproduzierbare Builds)

- Sicherheits‑Advisories und Audit‑Tooling

- SemVer‑Disziplin in populären Bibliotheken

- Upgrade‑Ergonomie (Breaking Changes, Deprecations, Migrationsanleitungen)

Prüfe auch den Release‑Rhythmus von Sprache und Framework. Schnelle Releases sind gut — wenn die Organisation mithalten kann. In regulierten Umgebungen oder bei vielen Services kann ein langsamerer LTS‑Rhythmus das Risiko reduzieren.

Observability und Debugging in Produktion

Moderne Backends brauchen erstklassige Observability. Stelle sicher, dass es reife Optionen für strukturiertes Logging, Metriken (Prometheus/OpenTelemetry), verteiltes Tracing und Profiling gibt.

Ein praktischer Test: Kannst du von „p95‑Latenz ist gestiegen" innerhalb weniger Minuten zur konkreten Endpoint‑/Query‑ oder Abhängigkeits‑Ursache kommen? Sprachen mit starken Profiling‑ und Tracing‑Integrationen sparen Jahr für Jahr erheblich Zeit.

Operativer Fit: Container, Serverless und Langläufer

Betriebliche Restriktionen sollten die Wahl beeinflussen. Manche Runtimes glänzen in Containern mit kleinen Images und schnellem Startup; andere bei langlaufenden Diensten mit vorhersehbarem Speicher. Wenn Serverless im Spiel ist, zählen Cold‑Start‑Charakteristika, Packaging‑Limits und Connection‑Management.

Baue vor der Entscheidung einen dünnen Vertical Slice und deploye ihn genau so, wie du ihn betreiben willst (z. B. in Kubernetes oder auf einer Function‑Plattform). Das ist oft aufschlussreicher als Framework‑Feature‑Listen zu lesen.

Wartbarkeit, Sicherheit und Developer Experience

Wartbarkeit bedeutet weniger „schönen Code" als wie schnell ein Team Verhalten ändern kann, ohne Produktion zu brechen. Die Sprache beeinflusst das durch Typsysteme, Tooling und die Konventionen des Ökosystems.

Statisch vs dynamisch: Refactoring und Zuverlässigkeit

Stark typisierte Sprachen (Java, Go, C#/.NET) machen große Refactors sicherer, weil der Compiler als zweiter Reviewer funktioniert. Felder umbenennen, Funktionssignaturen ändern oder Module splitten — der Compiler gibt sofortiges Feedback.

Dynamische Sprachen (Python, Ruby, Vanilla JS) sind sehr produktiv, aber Korrektheit hängt stärker von Konventionen, Testabdeckung und Laufzeitchecks ab. In diesen Umgebungen hilft oft „gradual typing": TypeScript für Node.js oder Typ‑Hints + Checker (mypy/pyright) für Python. Konsistenz ist entscheidend — halbtypisierter Code kann schlimmer sein als eine klare Entscheidung.

API‑Verträge: DTOs, Schemata und OpenAPI

Systeme scheitern oft an den Grenzen: Request/Response‑Formate, Event‑Payloads und DB‑Mappings. Ein wartbarer Stack macht Verträge explizit.

OpenAPI/Swagger ist der übliche Standard für HTTP‑APIs. Viele Teams koppeln es mit Schema‑Validation und DTOs, um „stringly‑typed" APIs zu vermeiden. Beispiele in der Praxis:

- Node.js: OpenAPI + Zod/Joi für Validation; DTOs via TypeScript‑Typen

- Python: FastAPI + Pydantic Modelle

- Java: Bean Validation + generierte DTOs aus OpenAPI

- .NET: FluentValidation + starke DTOs + OpenAPI‑Generierung

Code‑Generierung ist wichtig: Clients/Server/DTOs zu erzeugen reduziert Drift und verbessert Onboarding.

Ökosysteme unterscheiden sich darin, wie natürlich Testing in den Workflow passt. Node nutzt oft Jest/Vitest mit schnellem Feedback. Pythons pytest ist ausdrucksstark und exzellent für Fixtures. Java‑JUnit/Testcontainers eignet sich gut für Integrationstests. Gos eingebautes testing‑Paket fördert einfache Tests, .NETs xUnit/NUnit integriert gut mit IDEs und CI. Rubys RSpec ist meinungsstark und lesbar.

Eine praktische Regel: Wähle das Ökosystem, in dem es deinem Team am leichtesten fällt, Tests lokal auszuführen, Abhängigkeiten sauber zu mocken und Integrationstests ohne großen Aufwand zu schreiben.

Team‑Skills, Hiring‑Markt und langfristige Verantwortung

Die Wahl einer Backend‑Programmiersprache ist auch eine Personalentscheidung. Eine auf dem Papier „beste" Sprache kann teuer werden, wenn du niemanden findest, der sie betreuen kann.

Stimme die Sprache auf dein bestehendes Team ab

Erstelle ein Inventar der aktuellen Stärken: nicht nur wer Code schreibt, sondern wer Produktionsprobleme debuggt, Performance tuned, CI einrichtet, Incidents managed und PRs schnell reviewt.

Eine einfache Regel: bevorzuge Sprachen, die das Team operativ gut beherrscht, nicht nur schreiben kann. Wenn deine On‑Call‑Rotation bereits mit Observability, Deploys oder Nebenläufigkeitsbugs kämpft, kann ein neues Runtime‑Paradigma das Risiko erhöhen.

Hiring‑Verfügbarkeit: Region und Seniorität sind entscheidend

Der Arbeitsmarkt variiert stark nach Region und Erfahrungsniveau. In manchen Gegenden findest du viele Junior‑Node.js/ Python‑Entwickler, aber wenige Senior‑JVM‑Tuner oder erfahrene Go‑Ingenieure — oder umgekehrt.

Beim Bewerten von „Verfügbarkeit" schau auf:

- Lokal vs Remote: Kannst du remote in passenden Zeitzonen einstellen?

- Senioritätsverteilung: Brauchst du Senior‑Leads oder viele Mid‑Level‑Entwickler?

- Konkurrenzdruck: Wenn viele Firmen dieselben Profile suchen, verlängert sich Time‑to‑Fill und die Gehaltskosten steigen.

Lernkurve und Onboardingzeit

Selbst starke Entwickler brauchen Zeit, um in ein neues Ökosystem einzusteigen: Idiome, Frameworks, Testing‑Praktiken, Dependency‑Management und Deployment‑Tooling. Plane Onboarding in Wochen, nicht Tagen.

Praktische Fragen:

- Kann ein neuer Mitarbeiter in den ersten zwei Wochen eine sichere, reviewte Änderung ausliefern?

- Gibt es interne Templates (Service‑Skeletons, Logging, Auth, CI), die Varianz reduzieren?

- Gibt es genug erfahrene Reviewer, um Qualität beim Ramp‑Up hoch zu halten?

Langfristige Verantwortung (2–3 Jahre)

Auf schnelle Auslieferung optimieren kann nach hinten losgehen, wenn das Team den Stack nicht gerne pflegt. Berücksichtige Upgrade‑Rhythmus, Framework‑Churn und wie angenehm die Sprache fürs Testen, Refaktorieren und Debuggen ist.

Erwartest du Fluktuation, priorisiere Lesbarkeit, vorhersehbares Tooling und eine tiefe Maintainer‑Basis — Ownership hält länger als der erste Release.

Kurzer Vergleich: Node.js, Python, Java, Go, .NET, Ruby

Betriebseignung früh prüfen

Führe deinen Prototyp in einer gehosteten Umgebung aus, um Betriebsprobleme früh zu erkennen.

Node.js

Node.js glänzt bei I/O‑schweren APIs, Chat, Collaboration‑Tools und Echtzeit‑Features (WebSockets, Streaming). Häufiger Stack: TypeScript + Express/Fastify/NestJS, meist mit PostgreSQL/Redis und Queues.

Typische Fallen sind CPU‑gebundene Arbeit, die den Event‑Loop blockiert, Dependency‑Sprawl und inkonsistente Typisierung ohne TypeScript. Bei Performance‑Ansprüchen: schwere Berechnungen in Worker auslagern und striktes TypeScript + Linting verwenden.

Python

Python ist ein Produktivitätsleader, insbesondere für datennahe Backends mit Analytics, ML, ETL und Automation. Framework‑Wahl: Django (batteries‑included) oder FastAPI (modern, typisiert, API‑first).

Performance ist für viele CRUD‑Systeme meist ausreichend, aber Hot‑Paths können bei Scale teuer werden. Strategien: Async‑I/O, Caching, Auslagerung von Compute in spezialisierte Services oder schnellere Runtimes/Extensions.

Java

Java bleibt ein solides Default für Enterprise‑Systeme: reifes JVM‑Tooling, vorhersehbare Performance und ein tiefes Ökosystem (Spring Boot, Quarkus, Kafka, Observability). Operative Reife ist ein großer Vorteil — Teams wissen, wie man es deployed und betreibt.

Typische Einsatzfälle: hochdurchsatzfähige APIs, komplexe Domänen und regulierte Umgebungen, in denen Stabilität und LTS wichtig sind.

Go

Go passt zu Microservices und Netzwerkdiensten, wo Nebenläufigkeit und Einfachheit zählen. Goroutines erleichtern viele gleichzeitige Tasks, und die Standardbibliothek ist praktisch.

Trade‑offs: weniger „batteries‑included" Web‑Frameworks als bei Java/.NET, du schreibst mitunter mehr Plumbing (kann aber auch gewollt sein).

.NET

Modernes .NET (ASP.NET Core) ist exzellent für Enterprise‑APIs, mit starkem Tooling (Visual Studio, Rider), guter Performance und solider Windows/Linux‑Parität. Üblicher Stack: ASP.NET Core + EF Core + SQL Server/PostgreSQL.

Ruby

Ruby on Rails ist nach wie vor einer der schnellsten Wege, ein poliertes Web‑Produkt zu bauen. Skalierung erreichst du meist, indem du schwere Workloads in Hintergrundjobs/Services auslagerst.

Trade‑off ist die rohe Durchsatzleistung pro Instanz; typischerweise skaliert man horizontal und investiert früh in Caching und Job‑Queues.

Häufige Szenarien und passende Sprachen

Es gibt selten eine einzige „beste" Sprache — nur eine beste Passung für Workload, Team und Risikoprofil. Hier gängige Muster und Sprachen, die oft passen.

Startups, die schnell liefern (MVP → PMF)

Wenn Iterationsgeschwindigkeit und das Einstellen von Generalisten zählen, sind Node.js und Python häufige Picks. Node.js punktet, wenn das Team TypeScript‑Sharing zwischen Frontend und Backend will und API‑Entwicklung überwiegend I/O‑basiert ist. Python ist stark für datengetriebene Produkte, Scripting und frühe ML/Analytics‑Integrationen.

Ruby on Rails bleibt eine großartige „Feature‑Fabrik", wenn das Team erfahren ist und du eine konventionelle Web‑App mit viel CRUD und Admin‑UIs baust.

Hochdurchsatz‑APIs und nebenläufigkeitsintensive Dienste

Wenn Latenz, Durchsatz und vorhersagbarer Ressourcenverbrauch dominieren, ist Go oft die Default‑Wahl: schnelles Startup, simples Nebenläufigkeitsmodell und einfache Containerisierung. Java und .NET sind ebenfalls exzellent, vor allem wenn du ausgereiftes Profiling, JVM/CLR‑Tuning und bewährte Bibliotheken für verteilte Systeme brauchst.

Bei lang laufenden Verbindungen (Streaming, WebSockets) oder hohem Fan‑out priorisiere Laufzeitverhalten unter Last und operatives Tooling über rohe Microbenchmarks.

Für interne Tools kostet Entwicklerzeit meist mehr als Compute. Python, Node.js und .NET (in Microsoft‑schweren Umgebungen) gewinnen hier wegen schneller Lieferung, starker Bibliotheken und einfacher Integration mit vorhandenen Systemen.

Regulierte und Enterprise‑Umgebungen

In Compliance‑schweren Settings (Audit, Access Controls, lange Supportzyklen) sind Java und .NET oft die sichereren Optionen: etablierte Sicherheitspraktiken, Governance‑Muster und LTS‑Optionen. Das zählt, wenn „Wer darf eine Dependency freigeben?" genauso wichtig ist wie Performance vs Produktivität.

Monolith vs Microservices (und Sprachwahl)

Ein Monolith profitiert meist von einer einzigen Hauptsprache, um Onboarding und Wartung zu vereinfachen. Microservices erlauben mehr Vielfalt — aber nur, wenn Teams wirklich autonom sind und Plattform‑Tooling (CI/CD, Observability, Standards) stark ist.

Polyglotte Realität: wenn zwei Sprachen sinnvoll sind

Eine pragmatische Aufteilung ist üblich: z. B. Java/.NET/Go für Kern‑APIs und Python für Daten‑Pipelines. Vermeide Polyglottie „aus Vorliebe" zu früh; jede zusätzliche Sprache vervielfacht Incident‑Response, Security‑Review und Ownership‑Aufwand.

Ein praktisches Entscheidungsrahmenwerk und Scoring‑Matrix

Direktvergleiche durchführen

Vergleiche Stacks, indem du das gleiche Feature-Set zweimal baust – ohne wochenlange Einrichtung.

Mache die Sprachwahl zu einer Produktentscheidung: definiere Constraints, bewerte Optionen, validiere mit einem kleinen PoC. Das Ziel ist kein perfekter Pick, sondern eine verteidigbare Wahl, die du dem Team und zukünftigen Kandidaten erklären kannst.

Schritt 1: Muss‑ versus Nice‑to‑have

Erstelle zwei Listen:

- Must‑have Anforderungen (nicht verhandelbar): z. B. bestimmte Cloud/Runtime, Compliance, Team muss in 8 Wochen liefern, gRPC‑Support, Speicherlimits.

- Nice‑to‑have (verhandelbar): z. B. „Best‑in‑class DX", „größtes Ökosystem", „eleganteste Syntax".

Wenn eine Sprache ein Must‑have nicht erfüllt, fällt sie raus — keine endlose Debatte.

Schritt 2: Einfaches Scorecard (Gewichtung + 1–5 Punkte)

Erstelle eine kurze Matrix und sei konsistent:

| Kriterium | Gewicht (%) | Score (1–5) | Gewichteter Score |

|---|

| Performance & Nebenläufigkeits‑Fit | 20 | | |

| Ökosystem & Libraries (DB, Auth, Queues) | 20 | | |

| Developer‑Produktivität | 15 | | |

| Hiring & Langfristige Wartbarkeit | 15 | | |

| Operativer Fit (Deploy, Observability) | 15 | | |

| Sicherheit & Korrektheit (Typing, Tooling) | 15 | | |

Berechnung: Gewichteter Score = Gewicht × Score. Summiere pro Sprache. Halte die Kriterien auf ~5–7, damit die Zahlen aussagekräftig bleiben.

Schritt 3: Führe ein PoC durch, das reale Arbeit spiegelt

PoC‑Checklist (time‑boxe auf 1–3 Tage pro Sprache):

- Ein API‑Endpoint (Validation + Error‑Handling)

- Auth (wie ihr es wirklich nutzen wollt)

- DB‑CRUD + Migration

- Background‑Job/Queue‑Task

- Logging, Metriken und ein Trace

- Deployment in der Zielumgebung

Schritt 4: Definiere PoC‑Erfolgsmetriken

Bestimme vorab, was „gut" heißt:

- Latenz‑Ziel: z. B. p95 < 150ms für einen repräsentativen Endpoint

- Deploy‑Zeit: z. B. < 10 Minuten von sauberem Checkout bis Production‑Deploy

- Error‑Rate: z. B. < 0.1% in einem kleinen Lasttest mit realistischen Fehlern

- Dev‑Velocity: Zeit zur Implementierung der PoC‑Checklist + Anzahl harter Ecken

Bewerte die PoC‑Ergebnisse zurück in die Matrix und wähle die Option mit dem besten Total und den wenigsten Must‑Have‑Risiken.

Fallen vermeiden und die Wahl zukunftssicher machen

Fehlentscheidungen passieren oft, wenn die Wahl von außen nach innen getroffen wird — was gerade im Trend ist, was ein Talk gelobt hat oder was ein einzelner Benchmark zeigt.

Nicht für Hype optimieren

Ein Microbenchmark spiegelt selten deine echten Engpässe: DB‑Queries, Third‑Party‑APIs, Serialisierung oder Netzwerk‑Latenz. Betrachte „am schnellsten" als Ausgangsfrage, nicht als Urteil. Validier stattdessen mit einem dünnen PoC, das reale Datenpfade, Payload‑Größen und Nebenläufigkeitsprofile abbildet.

Auf operative Mismatches achten

Viele Teams wählen eine Sprache, die im Code produktiv wirkt, und bezahlen später in Produktion:

- Async‑Komplexität: manche Stacks machen non‑blocking einfach; andere erfordern Disziplin, um Deadlocks, Thread‑Starvation oder Async‑Spaghetti zu vermeiden.

- GC‑Tuning & Memory‑Verhalten: verwaltete Runtimes sind gut, aber du musst Heap‑Sizing, Pausenverhalten und Observability beherrschen.

- Deploy‑Constraints: Container‑Builds, Cold‑Starts, ARM vs x86, minimale Basis‑Images und Build‑Tooling können Deploys teuer machen.

Wenn deine Organisation das operative Modell nicht unterstützen kann, hilft die Sprache nicht.

Migration als Produkt planen, nicht als Rewrite

Zukunftssicher bedeutet oft nicht alles auf einmal umzuwerfen. Bevorzuge inkrementelle Migration:

- Starte neue Features als kleine Services oder Module und lasse den Core stabil.

- Nutze das Strangler‑Pattern: leite spezifische Endpunkte/Flows an die neue Implementierung, erweitere schrittweise.

- Halte geteilte Verträge (OpenAPI/JSON Schema/Protobuf) als Quelle der Wahrheit, um Cross‑Language‑Drift zu reduzieren.

Checkliste und nächste Schritte

- Definiere die Top‑3‑Constraints (Latenz, Durchsatz, Kosten, Compliance, Hiring).

- Prototyp mit realen Datenpfaden, dann Load‑Test.

- Verifiziere Ops‑Bereitschaft: CI/CD, Monitoring, Incident‑Response, Runtime‑Tuning.

- Wähle einen Migrationspfad (inkrementell > Rewrite) und sperre API‑Verträge.

- Führe einen 60–90 Tage Pilot durch, standardisiere danach Konventionen und Tooling.