Warum Laufzeit-Entscheidungen Backend-JavaScript prägen

Eine JavaScript-Laufzeit ist mehr als nur eine Möglichkeit, Code auszuführen. Sie ist ein Bündel von Entscheidungen über Performanceeigenschaften, eingebaute APIs, Sicherheitsdefaults, Packaging und Distribution sowie die täglichen Werkzeuge, auf die Entwickler angewiesen sind. Diese Entscheidungen bestimmen, wie Backend-JavaScript sich anfühlt: wie Sie Dienste strukturieren, Produktionsfehler debuggen und wie sicher Sie Änderungen ausliefern können.

Laufzeiten beeinflussen die Arbeit, nicht nur die Geschwindigkeit

Performance ist der offensichtliche Teil — wie effizient ein Server I/O, Concurrency und CPU-intensive Aufgaben handhabt. Aber Laufzeiten entscheiden auch, was Sie „umsonst“ bekommen. Haben Sie eine standardisierte Art, URLs zu fetchen, Dateien zu lesen, Server zu starten, Tests auszuführen, Code zu linten oder eine App zu bundlen? Oder setzen Sie diese Teile selbst zusammen?

Selbst wenn zwei Laufzeiten ähnliche JavaScript ausführen können, kann die Entwicklererfahrung dramatisch unterschiedlich sein. Packaging spielt ebenfalls eine Rolle: Modulsysteme, Dependency-Resolution, Lockfiles und Veröffentlichungsformen von Bibliotheken beeinflussen Build-Zuverlässigkeit und Sicherheitsrisiko. Tooling-Entscheidungen wirken sich auf die Einarbeitungszeit und die Kosten zur Wartung vieler Services über Jahre aus.

Entscheidungen und Kompromisse — keine Heldenverehrung

Die Geschichte wird oft um Individuen herum erzählt, aber hilfreicher ist es, sich auf Einschränkungen und Trade-offs zu konzentrieren. Node.js und Deno repräsentieren unterschiedliche Antworten auf dieselben praktischen Fragen: Wie führt man JavaScript außerhalb des Browsers aus, wie verwaltet man Abhängigkeiten und wie balanciert man Flexibilität gegen Sicherheit und Konsistenz?

Sie sehen, warum einige frühe Node.js-Entscheidungen ein riesiges Ökosystem ermöglichten — und was dieses Ökosystem im Gegenzug verlangte. Sie sehen auch, was Deno zu ändern versuchte und welche neuen Einschränkungen mit diesen Änderungen einhergehen.

Was Sie lernen werden und für wen das ist

Dieser Artikel behandelt:

- Die Ursprünge von Node.js und warum sein ereignisgetriebenes Modell für Backends wichtig war

- Die Ökosystemeffekte von npm und wie das Workflows und Risiken prägte

- Denos Ziele (inklusive Sicherheit und TypeScript-first-Ergonomie)

- Wie sich diese Laufzeitunterschiede im täglichen Ausliefern und Warten zeigen

Er richtet sich an Entwickler, Tech Leads und Teams, die eine Laufzeit für neue Services wählen wollen — oder die bestehenden Node.js-Code pflegen und evaluieren, ob Deno Teile ihres Stacks passt.

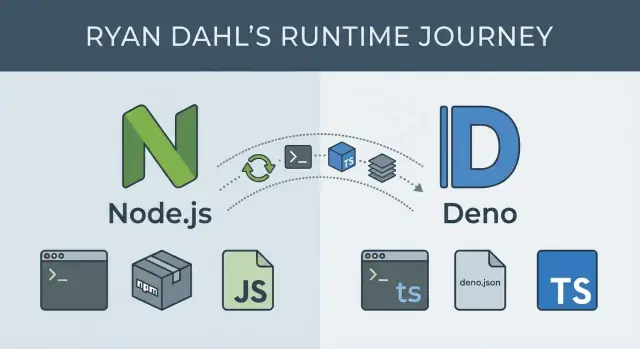

Ryan Dahl im Kontext: zwei Laufzeiten, zwei Zielsetzungen

Ryan Dahl ist vor allem bekannt für die Erstellung von Node.js (2009 veröffentlicht) und später für die Initiierung von Deno (2018 vorgestellt). Zusammen gelesen bilden die beiden Projekte eine öffentliche Chronik, wie sich Backend-JavaScript entwickelt hat — und wie sich Prioritäten verschieben, wenn reale Nutzung Trade-offs offenbart.

Node.js: JavaScript auf dem Server praktikabel machen

Als Node.js auftauchte, war die Serverentwicklung von Thread-per-Request-Modellen geprägt, die bei vielen gleichzeitigen Verbindungen Probleme hatten. Dahls frühe Fokussierung war pragmatisch: es praktisch machen, I/O-lastige Netzwerkserver in JavaScript zu bauen, indem Googles V8-Engine mit einem ereignisgesteuerten Ansatz und nicht-blockierendem I/O gepaart wurde.

Nodes Ziele waren pragmatisch: etwas Schnelles liefern, die Laufzeit klein halten und der Community die Lücken füllen lassen. Diese Betonung half Node beim schnellen Wachstum, setzte aber auch Muster, die später schwer zu ändern waren — besonders in Bezug auf Abhängigkeitskultur und Defaults.

Deno: Annahmen nach einem Jahrzehnt überdenken

Fast zehn Jahre später präsentierte Dahl „10 Things I Regret About Node.js“, in denen er Probleme auflistete, die er im ursprünglichen Design verankert sah. Deno ist der „zweite Entwurf“, geformt von diesen Bedauern, mit klareren Defaults und einer stärker meinungsgeprägten Entwicklererfahrung.

Anstatt zuerst maximale Flexibilität zu priorisieren, zielen Deno-Entscheidungen mehr auf sichere Ausführung, modernen Sprachsupport (TypeScript) und eingebautes Tooling, sodass Teams weniger Drittteile brauchen, nur um loszulegen.

Das übergreifende Thema bei beiden Laufzeiten ist nicht, dass eine „richtig“ sei — sondern dass Einschränkungen, Adoption und Rückblick denselben Menschen dazu bringen können, sehr unterschiedliche Ergebnisse zu optimieren.

Node.js-Grundlagen: Ereignisschleife, nicht-blockierendes I/O, reale Auswirkungen

Node.js führt JavaScript auf einem Server aus, aber die Kernidee dreht sich weniger um „JavaScript überall“ als darum, wie gewartet wird.

Die Ereignisschleife, einfach erklärt

Die meiste Backend-Arbeit ist Warten: eine DB-Abfrage, ein Dateizugriff, ein Netzwerkaufruf zu einem anderen Service. In Node.js ist die Ereignisschleife wie ein Koordinator, der diese Aufgaben im Blick behält. Wenn Ihr Code eine Operation startet, die Zeit braucht (z. B. eine HTTP-Anfrage), übergibt Node diese Wartearbeit an das System und macht sofort weiter.

Wenn das Ergebnis fertig ist, legt die Ereignisschleife einen Callback in die Queue (oder löst ein Promise), sodass Ihr JavaScript mit der Antwort fortfahren kann.

Nicht-blockierendes I/O und „single-threaded“ Concurrency

Node.js-JavaScript läuft in einem einzigen Hauptthread, das heißt ein Stück JS wird jeweils ausgeführt. Das klingt einschränkend, bis man erkennt, dass es darauf ausgelegt ist, kein „Warten“ in diesem Thread stattfinden zu lassen.

Nicht-blockierendes I/O bedeutet, Ihr Server kann neue Requests annehmen, während frühere noch auf Datenbank- oder Netzwerkantworten warten. Concurrency wird erreicht durch:

- Das Betriebssystem, das viele I/O-Operationen parallel handhabt

- Die Ereignisschleife, die die richtige Anfrage wieder aufnimmt, wenn ihr I/O fertig ist

Deshalb kann Node unter vielen gleichzeitigen Verbindungen „schnell“ wirken, obwohl Ihr JS im Hauptthread nicht parallel läuft.

Praktische Folgen: CPU-lastige Arbeit und Auslagerung

Node glänzt, wenn die meiste Zeit im Warten liegt. Schwierigkeiten entstehen, wenn Ihre App viel Zeit mit Berechnungen verbringt (Bildverarbeitung, groß angelegte Verschlüsselung, große JSON-Transformationen), weil CPU-intensive Arbeit den Single-Thread blockiert und alles verzögert.

Typische Optionen:

- Worker-Threads für CPU-intensive Aufgaben, die im Prozess bleiben müssen

- Auslagern der Berechnung an separate Services (Job-Queues, dedizierte Compute-Worker)

- Native Module oder externe Tools verwenden, wenn es passt

Wofür Node.js in der Regel gut geeignet ist

Node eignet sich besonders für APIs und Backend-for-Frontend-Server, Proxies und Gateways, Echtzeitanwendungen (WebSockets) und entwicklerfreundliche CLIs, bei denen schneller Start und ein reiches Ökosystem zählen.

Wofür Node.js optimiert hat — und was dafür eingetauscht wurde

Node.js wurde gebaut, um JavaScript als Serversprache praktikabel zu machen, besonders für Apps, die viel Zeit mit Netzwerk-Warten verbringen: HTTP-Anfragen, Datenbanken, Dateizugriffe und APIs. Die Kernwette war, dass Durchsatz und Reaktionsfähigkeit wichtiger sind als „ein Thread pro Request“.

Das Kerndesign: V8 + libuv + kleine Standardbibliothek

Node koppelt Googles V8-Engine (schnelle JS-Ausführung) mit libuv, einer C-Bibliothek, die Ereignisschleife und nicht-blockierendes I/O betriebssystemübergreifend handhabt. Diese Kombination erlaubte Node, single-process und ereignisgesteuert zu bleiben und trotzdem unter vielen gleichzeitigen Verbindungen gut zu performen.

Node wurde auch mit pragmatischen Core-Modulen ausgeliefert — namentlich http, fs, net, crypto und stream — sodass man reale Server bauen konnte, ohne auf Drittanbieterpakete zu warten.

Trade-off: Eine kleine Standardbibliothek hielt Node schlank, drängte aber Entwickler früher als in manchen anderen Ökosystemen zu externen Abhängigkeiten.

Von Callbacks zu async/await: Kraft mit Narben

Frühes Node setzte stark auf Callbacks, um „mach dies, wenn I/O fertig ist“ auszudrücken. Das passte natürlich zu nicht-blockierendem I/O, führte aber zu verschachteltem Code und komplizierten Fehlerbehandlungen.

Im Laufe der Zeit wechselte das Ökosystem zu Promises und schließlich async/await, was Code lesbarer machte, während das nicht-blockierende Verhalten erhalten blieb.

Trade-off: Die Plattform musste mehrere Generationen von Patterns unterstützen, und Tutorials, Bibliotheken und Team-Codebasen mischten oft Stile.

Abwärtskompatibilität: Stabilität, die große Aufräumarbeiten verlangsamt

Nodes Verpflichtung zur Abwärtskompatibilität machte es für Unternehmen sicher: Upgrades brechen selten alles über Nacht, und Core-APIs bleiben tendenziell stabil.

Trade-off: Diese Stabilität kann „saubere Brüche“ verzögern oder komplizieren. Manche Inkonsistenzen und Legacy-APIs bleiben, weil deren Entfernen bestehende Apps schädigen würde.

Native Addons: riesige Reichweite, mehr Komplexität

Nodes Fähigkeit, in C/C++ gebundenen Code aufzurufen, ermöglichte performancekritische Bibliotheken und Systemzugriffe via native Addons.

Trade-off: Native Addons können plattformspezifische Build-Schritte, knifflige Installationsfehler und Sicherheits-/Update-Aufwände einführen — besonders wenn Abhängigkeiten unterschiedlich über Umgebungen kompiliert werden.

Insgesamt optimierte Node darauf, Netzwerkdienste schnell auslieferbar zu machen und viel I/O effizient zu handhaben — bei gleichzeitiger Akzeptanz von Komplexität in Kompatibilität, Abhängigkeitskultur und langfristiger API-Evolution.

npm und das Node-Ökosystem: Macht, Komplexität und Risiko

npm ist ein großer Grund, warum Node.js sich schnell verbreitete. Es verwandelte „Ich brauche Webserver + Logging + Datenbanktreiber“ in ein paar Befehle, mit Millionen von Paketen bereit zum Einstecken. Für Teams bedeutete das schnellere Prototypen, geteilte Lösungen und gemeinsames Wissen.

Warum npm Node produktiv machte

npm senkte die Kosten, Backends zu bauen, indem es standardisierte, wie man Code installiert und veröffentlicht. Brauchen Sie JSON-Validierung, ein Datums-Helferlein oder einen HTTP-Client? Es gibt wahrscheinlich ein Paket — plus Beispiele, Issues und Community-Wissen. Das beschleunigt die Auslieferung, besonders wenn viele kleine Features unter Zeitdruck zusammengesetzt werden.

Abhängigkeitsbäume: wo der Schmerz beginnt

Der Trade-off ist, dass eine direkte Abhängigkeit Dutzende (oder Hunderte) indirekter Abhängigkeiten ziehen kann. Mit der Zeit stoßen Teams oft auf:

- Größe und Duplikation: Mehrere Versionen desselben Bibliothekstyps installieren sich, weil verschiedene Pakete unterschiedliche Ranges verlangen

- Operativer Ballast: Installs werden langsamer, CI-Caches wachsen, und „funktioniert auf meinem Rechner“ wird häufiger

- Supply-Chain-Risiko: Je größer der Tree, desto mehr hängt man von Maintainer:innen ab, die man nicht kennt — und desto attraktiver wird das Ziel für Übernahmen oder bösartige Updates

SemVer: Erwartungen vs. Realität

Semantic Versioning (SemVer) klingt beruhigend: Patch-Releases sind sicher, Minor-Releases fügen Features hinzu ohne zu brechen, Major-Releases können brechen. In der Praxis werden große Dependency-Graphs dieser Zusicherung nicht immer gerecht.

Maintainer veröffentlichen manchmal breaking changes unter Minor-Versions, Pakete werden aufgegeben oder ein „sicheres“ Update ändert Verhalten über eine tiefe transitive Abhängigkeit. Wenn Sie eine Sache aktualisieren, aktualisieren Sie möglicherweise viele.

Praktische Leitplanken, die funktionieren

Ein paar Gewohnheiten reduzieren das Risiko ohne die Entwicklung zu verlangsamen:

- Lockfiles (

package-lock.json, npm-shrinkwrap.json oder yarn.lock) verwenden und einchecken

- Kritische Abhängigkeiten pinnen oder eng einschränken, besonders sicherheitsrelevante

- Regelmäßig auditieren:

npm audit ist eine Basis; planen Sie regelmäßige Dependency-Reviews

- Bevorzugen Sie weniger, dafür bekannte Pakete statt vieler winziger; entfernen Sie nicht mehr genutzte Abhängigkeiten

- Automatisieren Sie Updates mit Bedacht (z. B. gebündelte PRs mit erforderlichen Tests vor Merge)

npm ist sowohl Beschleuniger als auch Verantwortung: Es macht schnelles Bauen möglich und verankert Dependency-Hygiene als integralen Teil der Backend-Arbeit.

Reduziere deine Build-Kosten

Erhalte Credits, indem du Inhalte über Koder.ai teilst oder Teammitglieder empfiehlst.

Node.js ist berühmt unmeinungsstark. Das ist eine Stärke — Teams können genau den Workflow zusammenstellen, den sie wollen — aber es bedeutet auch, dass ein „typisches“ Node-Projekt eigentlich eine Konvention aus Community-Gewohnheiten ist.

Wie Node-Projekte üblicherweise Skripte organisieren

Die meisten Node-Repos zentrieren sich um eine package.json mit Skripten, die wie ein Bedienfeld agieren:

dev / start um die App zu startenbuild um zu kompilieren oder zu bundlen (falls nötig)test um einen Test-Runner auszuführenlint und format um Code-Stil durchzusetzen- manchmal

typecheck wenn TypeScript im Spiel ist

Dieses Muster funktioniert gut, weil jedes Tool in Skripte verdrahtet werden kann und CI/CD dieselben Befehle ausführen kann.

Ein Node-Workflow wird häufig zu einer Sammlung separater Tools, die jeweils ein Stück lösen:

- Transpiler (TypeScript-Compiler, Babel) um moderne Syntax lauffähig zu machen

- Bundler (Webpack, Rollup, esbuild, Vite) um Code für Deployment oder Browser zu verpacken

- Linter/Formatter (ESLint, Prettier) für konsistenten Code

- Test-Runner (Jest, Mocha, Vitest) plus Assertion- und Mocking-Bibliotheken

Keines dieser Tools ist „falsch“ — sie sind mächtig, aber der Preis ist, dass Sie eine Toolchain integrieren, nicht nur Anwendungslogik schreiben.

Wo Reibung sichtbar wird

Weil Tools unabhängig evolvieren, stoßen Node-Projekte auf praktische Probleme:

- Konfigurationswucher: mehrere Config-Dateien (oder tief verschachtelte Optionen), die neue Teammitglieder lernen müssen

- Versions-Inkompatibilitäten: ein Plugin erwartet eine andere Major-Version des Linters, Bundlers oder TypeScript

- Umgebungsdrift: lokale Node-Versionen unterscheiden sich von CI oder Produktion und führen zu „funktioniert auf meinem Rechner“-Bugs

Mit der Zeit beeinflussten diese Schmerzpunkte neuere Laufzeiten — besonders Deno — so dass sie mehr Defaults (Formatter, Linter, Test-Runner, TypeScript-Support) ausliefern, damit Teams mit weniger beweglichen Teilen starten und nur bei klarem Nutzen Komplexität hinzufügen.

Warum Deno entstand: frühere Annahmen überdenken

Deno wurde als zweiter Versuch einer JavaScript/TypeScript-Serverlaufzeit geschaffen — eine, die einige frühe Node.js-Entscheidungen nach Jahren realer Nutzung in Frage stellt.

Ryan Dahl hat öffentlich reflektiert, was er anders gemacht hätte: Reibung durch komplexe Dependency-Trees, das Fehlen eines erstklassigen Sicherheitsmodells und die „angehängten“ Entwicklerergonomien, die mit der Zeit essentiell wurden. Denos Motivationen lassen sich so zusammenfassen: den Default-Workflow vereinfachen, Sicherheit als expliziten Teil der Laufzeit machen und die Plattform um Standards und TypeScript modernisieren.

„Secure by default“ in der Praxis

In Node kann ein Script typischerweise Netzwerk, Dateisystem und Umgebungsvariablen ohne Nachfrage nutzen. Deno kehrt dieses Default um. Standardmäßig läuft ein Deno-Programm mit keinen Zugriffsrechten.

Im Alltag bedeutet das, dass Sie Berechtigungen zur Laufzeit bewusst erteilen:

- Lesen eines Verzeichnisses erlauben:

--allow-read=./data

- Netzwerkzugriffe auf einen Host erlauben:

--allow-net=api.example.com

- Zugriff auf Umgebungsvariablen erlauben:

--allow-env

Das verändert Gewohnheiten: Sie denken darüber nach, was Ihr Programm können soll, Sie halten Berechtigungen in Produktion eng und sehen klarer, wenn Code versucht, etwas Unerwartetes zu tun. Es ist keine vollständige Sicherheitslösung (Code-Reviews und Supply-Chain-Hygiene bleiben nötig), aber es macht das Prinzip der geringsten Rechte zum Default.

URL-basierte Imports und ein anderes Dependency-Denken

Deno unterstützt Modulimporte über URLs, was das Dependency-Denken verändert. Anstatt Pakete in node_modules zu installieren, verweisen Sie direkt auf Code:

import { serve } from "https://deno.land/std/http/server.ts";

Das macht deutlicher, woher Code kommt und welche Version genutzt wird (häufig durch Pinning in der URL). Deno cached Remote-Module, sodass Sie nicht bei jedem Lauf neu herunterladen — trotzdem brauchen Sie eine Strategie für Versionierung und Updates, ähnlich wie bei npm.

Eine Alternative, kein universeller Ersatz

Deno ist nicht „Node.js, nur besser für jedes Projekt“. Es ist eine Laufzeit mit anderen Defaults. Node bleibt stark, wenn Sie auf das npm-Ökosystem, bestehende Infrastruktur oder etablierte Muster angewiesen sind.

Deno ist attraktiv, wenn Sie eingebautes Tooling, ein Berechtigungsmodell und einen standardisierteren, URL-zentrierten Modulansatz schätzen — besonders für neue Services, bei denen diese Annahmen von Anfang an passen.

Sicherheitsmodell: Deno-Berechtigungen vs. Node-Defaults

Teste riskante Änderungen sicher

Teste Änderungen und setze bei Bedarf mit Snapshots schnell zurück.

Ein zentraler Unterschied zwischen Deno und Node.js ist, was ein Programm „per Default“ darf. Node geht davon aus, dass ein ausgeführtes Script alles Zugriffen kann, die der User hat: Netzwerk, Dateien, Umgebungsvariablen. Deno kehrt diese Annahme um: Scripte starten ohne Berechtigungen und müssen explizit Zugriff anfordern.

Denos Berechtigungsmodell in einfachen Worten

Deno behandelt sensible Fähigkeiten wie durch Tore geschützte Funktionen. Sie gewähren sie zur Laufzeit (und können sie einschränken):

- Netzwerk (

--allow-net): Ob Code HTTP-Anfragen machen oder Sockets öffnen darf. Sie können es auf bestimmte Hosts einschränken (z. B. nur api.example.com).

- Dateisystem (

--allow-read, --allow-write): Ob Code Dateien lesen oder schreiben darf. Sie können es auf bestimmte Ordner begrenzen (z. B. ./data).

- Umgebung (

--allow-env): Ob Code Secrets und Konfiguration aus Umgebungsvariablen lesen darf.

Das verringert die „Blast Radius“ einer Abhängigkeit oder eines kopierten Snippets, weil es nicht automatisch auf Dinge zugreifen kann, die es nicht explizit darf.

Sicherere Defaults: Skripte und kleine Services

Für Einmalskripte reduzieren Denos Defaults versehentliche Exposition. Ein CSV-Parsing-Skript kann mit --allow-read=./input laufen und sonst nichts — selbst wenn eine Abhängigkeit kompromittiert wäre, könnte sie ohne --allow-net nicht „nach Hause telefonieren".

Für kleine Services können Sie explizit angeben, was benötigt wird. Ein Webhook-Listener könnte --allow-net=:8080,api.payment.com und --allow-env=PAYMENT_TOKEN bekommen, aber keinen Dateisystemzugriff, was das Risiko von Datenexfiltration reduziert.

Der Trade-off: Bequemlichkeit vs. expliziter Zugriff

Nodes Ansatz ist bequem: weniger Flags, weniger „warum schlägt das fehl?“-Momente. Denos Ansatz fügt Reibung hinzu — besonders am Anfang — weil Sie entscheiden und deklarieren müssen, was das Programm darf.

Diese Reibung kann ein Feature sein: Sie zwingt Teams, Absicht zu dokumentieren. Sie bedeutet aber auch mehr Setup und gelegentliches Debugging, wenn eine fehlende Berechtigung eine Anfrage oder Dateilesung blockiert.

Berechtigungen Teil von CI und Code-Review machen

Teams können Berechtigungen als Vertrag der App behandeln:

- Committen Sie den exakt genutzten Run-Befehl (inkl. Berechtigungen), damit „funktioniert auf meinem Rechner“ seltener ist

- Reviewen Sie Berechtigungsänderungen wie API-Änderungen: Wenn ein PR

--allow-env hinzufügt oder --allow-read weitet, fragen Sie nach dem Warum

- CI-Checks: Tests mit minimalen Berechtigungen laufen lassen und fehlschlagen, wenn unvorhergesehener Zugriff benötigt wird

Konsequent genutzt werden Denos Berechtigungen zu einer leichten Sicherheits-Checkliste, die direkt neben dem Run-Befehl lebt.

Deno behandelt TypeScript als erstklassigen Bürger. Sie können eine .ts-Datei direkt ausführen, und Deno übernimmt die Kompilierung im Hintergrund. Für viele Teams ändert das die „Form“ eines Projekts: weniger Setup-Entscheidungen, weniger bewegliche Teile und ein klarerer Weg vom neuen Repo zum funktionierenden Code.

TypeScript-first: Was sich ändert

Mit Deno ist TypeScript kein optionales Add-on, das zunächst eine separate Buildkette braucht. Sie konfigurieren nicht zuerst einen Bundler, verkabeln tsc und legen mehrere Skripte an, nur um lokal Code auszuführen.

Das heißt nicht, dass Types verschwinden — Typen bleiben wichtig. Aber die Laufzeit übernimmt häufige Friktionen (Ausführung, Cache des kompilierten Outputs und Abgleich von Laufzeitverhalten mit Type-Checks), sodass Projekte schneller einheitlich werden.

Deno bringt eine Sammlung von Tools mit, die viele Basics abdecken:

- Formatter (

deno fmt) für konsistenten Stil

- Linter (

deno lint) für Qualität und Korrektheit

- Test-Runner (

deno test) für Unit- und Integrationstests

Weil diese eingebaut sind, kann ein Team gemeinsame Konventionen übernehmen, ohne über „Prettier vs X“ oder „Jest vs Y“ zu debattieren. Konfiguration ist typischerweise zentral in deno.json, was Projekte vorhersehbarer macht.

Im Vergleich zu Node: Flexibilität mit zusätzlicher Montage

Node-Projekte können TypeScript und gutes Tooling genauso unterstützen — aber meist müssen Sie den Workflow selbst zusammenstellen: typescript, ts-node oder Build-Schritte, ESLint, Prettier und ein Test-Framework. Diese Flexibilität ist wertvoll, kann aber zu inkonsistenten Setups über Repositories hinweg führen.

Integrationspunkte: Editor-Support und Konventionen

Denos Language Server und Editor-Integrationen zielen darauf ab, Formatierung, Linting und TypeScript-Feedback über Maschinen hinweg einheitlich zu machen. Wenn alle dieselben eingebauten Befehle nutzen, schrumpfen „funktioniert auf meinem Rechner“-Probleme — besonders bei Formatierung und Lint-Regeln.

Module und Dependency-Management: unterschiedliche Wege zum Ausliefern

Wie Sie Code importieren, beeinflusst alles Weitere: Ordnerstruktur, Tooling, Veröffentlichung und wie schnell ein Team Änderungen reviewen kann.

Node.js: CommonJS zuerst, ESM später

Node entstand mit CommonJS (require, module.exports). Das war simpel und funktionierte gut mit frühen npm-Paketen, entspricht aber nicht dem Modulsystem, das Browser standardisierten.

Node unterstützt nun ES-Module (ESM) (import/export), doch viele reale Projekte leben in einer gemischten Welt: manche Pakete sind nur CJS, andere nur ESM, und Apps brauchen manchmal Adapter. Das zeigt sich in Build-Flags, Dateiendungen (.mjs/.cjs) oder package.json-Einstellungen ("type": "module").

Das Abhängigkeitsmodell ist typischerweise Paketname-Imports aufgelöst durch node_modules, mit Versionierung über ein Lockfile. Das ist mächtig, bedeutet aber auch, dass der Install-Schritt und der Dependency-Tree zum täglichen Debugging-Teil werden können.

Deno: ESM-first mit URL-Imports

Deno startete von der Annahme, dass ESM der Standard ist. Importe sind explizit und sehen oft wie URLs oder absolute Pfade aus, was reduziert, dass etwas „magisch“ aufgelöst wird.

Für Teams ist die größte Veränderung, dass Abhängigkeitsentscheidungen im Code-Review sichtbarer sind: eine Importzeile sagt oft genau, welche Quelle und Version genutzt wird.

Import-Maps: Importe lesbar und stabil machen

Import-Maps erlauben Aliasnamen wie @lib/ oder das Pinnen einer langen URL auf einen kurzen Namen. Teams nutzen sie um:

- lange versionierte URLs nicht überall zu wiederholen

- Upgrades zu zentralisieren (Map einmal ändern, nicht jede Datei)

- interne Modulgrenzen sauber zu halten

Sie sind besonders hilfreich bei Codebasen mit vielen geteilten Modulen oder wenn Sie konsistente Namen über Apps und Skripte wünschen.

Packaging und Distribution: Bibliotheken vs Apps vs Skripte

In Node werden Bibliotheken häufig zu npm gepublished; Apps werden mit node_modules deployed (oder gebundelt); Skripte greifen oft auf lokale Installs zurück.

Deno macht Skripte und kleine Tools leichter ausführbar (direkt mit Imports), während Bibliotheken ESM-Kompatibilität und klare Entry-Points betonen.

Eine einfache Entscheidungsanleitung

Wenn Sie eine Legacy-Node-Codebasis pflegen, bleiben Sie bei Node und führen ESM schrittweise ein, wo es Reibung verringert.

Für eine neue Codebasis wählen Sie Deno, wenn Sie von Anfang an ESM-first-Architektur und Import-Map-Kontrolle wollen; wählen Sie Node, wenn Sie stark auf bestehende npm-Pakete und ausgereiftes Node-spezifisches Tooling angewiesen sind.

Node.js vs Deno wählen: eine praktische Checkliste für Teams

Backend per Chat bereitstellen

Mach aus einer Backend-Idee per Chat mit Koder.ai einen funktionierenden Service.

Die Wahl der Laufzeit ist weniger Frage nach „besser“ als nach Passung. Der schnellste Weg ist, sich auf das zu einigen, was Ihr Team in den nächsten 3–12 Monaten ausliefern muss: wo es läuft, welche Bibliotheken Sie brauchen und wie viel betrieblichen Wandel Sie tragen können.

Eine schnelle Entscheidungs-Checkliste

Stellen Sie diese Fragen in dieser Reihenfolge:

- Team-Experience: Hat Ihr Team bereits starke Node.js-Kenntnisse und etablierte Patterns (Frameworks, Tests, CI-Templates)? Wenn ja, ist der Wechsel kostenintensiv.

- Deploy-Ziel: Deployen Sie auf Serverless-Plattformen, Containern, Edge-Runtimes oder On-Prem? Prüfen Sie erstens den First-Class-Support und lokale-zu-Prod-Parität.

- Ökosystem-Bedarf: Sind Sie auf bestimmte Pakete angewiesen (ORMs, Auth-SDKs, Observability-Agenten, Enterprise-Integrationen)? Prüfen Sie Reife und Wartungsstatus.

- Security-Posture: Brauchen Sie starke Guardrails für Skripte und Services, die Zugriff auf Dateien, Netzwerk und Umgebungsvariablen haben?

- Tooling-Erwartungen: Möchten Sie „bring your own tools“ oder eine Laufzeit, die mehr eingebaute Tools (Formatierung, Linting, Testing) liefert, um Setup-Drift zu reduzieren?

- Operative Einschränkungen: Welche Monitoring-, Debugging- und Incident-Response-Workflows laufen bereits? Ein Laufzeitwechsel kann die Fehlerdiagnose verändern.

Wenn Sie Laufzeiten evaluieren und gleichzeitig die Time-to-Delivery drücken müssen, kann es helfen, Laufzeitwahl und Implementierungsaufwand zu trennen. Plattformen wie Koder.ai erlauben Teams, schnell Prototypen zu bauen und zu deployen (mit Code-Export, wenn nötig), sodass Sie einen kleinen Node-vs-Deno-Pilot fahren können, ohne Wochen Setup zu investieren.

Häufige Szenarien, in denen Node.js die sicherere Wahl ist

Node gewinnt oft, wenn Sie bestehende Node-Services haben, ausgereifte Bibliotheken und Integrationen brauchen oder ein bewährtes Produktions-Playbook nachbilden müssen. Es ist auch stark, wenn Onboarding- und Hiring-Geschwindigkeit zählt, da viele Entwickler bereits Erfahrung haben.

Häufige Szenarien, in denen Deno gut passt

Deno passt oft für sichere Automatisierungsskripte, interne Tools und neue Services, bei denen Sie TypeScript-first-Entwicklung und ein einheitlicheres eingebautes Toolset mit weniger Drittanbieterentscheidungen schätzen.

Risiko reduzieren mit einem kleinen Pilot

Statt großem Rewrite wählen Sie einen eingeschränkten Use Case (Worker, Webhook-Handler, geplante Aufgabe). Definieren Sie Erfolgskriterien vorab — Buildzeit, Fehlerquote, Cold-Start-Performance, Aufwand für Sicherheitsprüfungen — und setzen Sie eine feste Zeitbox. Gelingt der Pilot, haben Sie eine wiederholbare Vorlage für breitere Adoption.

Adoption und Migration: Risiken minimieren, Workflows modernisieren

Migration ist selten ein Big-Bang. Die meisten Teams führen Deno scheibchenweise ein — dort, wo der Nutzen klar ist und der Blast Radius klein.

Wie Adoption praktisch aussieht

Gängige Startpunkte sind internes Tooling (Release-Skripte, Repo-Automatisierung), CLI-Utilities und Edge-Services (leichte APIs nahe am Benutzer). Diese Bereiche haben meist weniger Abhängigkeiten, klarere Grenzen und einfachere Performance-Profile.

Für Produktionssysteme ist partielle Adoption normal: den Kern-API-Service auf Node belassen und Deno für einen neuen Service, einen Webhook-Handler oder einen geplanten Job einführen. So lernen Sie, was passt, ohne die gesamte Organisation gleichzeitig zu zwingen.

Kompatibilitätschecks früh durchführen

Bevor Sie sich festlegen, validieren Sie ein paar Realitäten:

- Bibliotheken: Setzen Sie auf Node-only-Pakete, native Addons oder tiefe npm-Tooling-Abhängigkeiten?

- Runtime-APIs: Node-Globals und Module mappen nicht immer 1:1 zu Deno (und umgekehrt).

- Deploy-Plattform: Manche Hoster erwarten Node-Konventionen; prüfen Sie Support für Deno, Container oder Edge.

- Observability: Logging, Tracing und Error-Reporting sollten über Services hinweg gleich funktionieren.

Ein stufenweises Vorgehen, das Risiko senkt

Starten Sie mit einem dieser Pfade:

- Bauen Sie ein Deno-CLI, das Dateien liest/schreibt und interne APIs anruft.

- Liefern Sie einen isolierten Service mit engem Vertrag (ein Endpoint, ein Queue-Consumer).

- Fügen Sie geteilte Konventionen hinzu: Formatierung, Linting, Dependency-Policies und Sicherheitsreviews.

Fazit

Laufzeitentscheidungen ändern nicht nur Syntax — sie prägen Sicherheitsgewohnheiten, Tooling-Erwartungen, Profilanforderungen beim Hiring und wie Ihr Team Systeme über Jahre hinweg wartet. Betrachten Sie Adoption als Weiterentwicklung von Workflows, nicht als einmaliges Rewrite-Projekt.