10. Nov. 2025·8 Min

Schemaänderungen und Migrationen in KI-erstellten Systemen: Ein Leitfaden

Erfahren Sie, wie KI-erstellte Systeme Schemaänderungen sicher handhaben: Versionierung, abwärtskompatible Rollouts, Datenmigrationen, Tests, Observability und Rollback-Strategien.

Was „Schema“ in KI-erstellten Systemen bedeutet

Ein Schema ist einfach die gemeinsame Vereinbarung über die Form der Daten und was jedes Feld bedeutet. In KI-erstellten Systemen tritt diese Vereinbarung an mehr Orten auf als nur in Datenbanktabellen — und sie ändert sich häufiger, als Teams erwarten.

Schema ist nicht nur eine Datenbanksache

Auf mindestens vier Ebenen begegnet Ihnen ein Schema:

- Datenbanken: Tabellen-/Spaltennamen, Datentypen, Einschränkungen, Indizes und Beziehungen.

- APIs: Form von Anfrage/Antwort-JSON, erforderliche vs. optionale Felder, Enums, Fehlerformate, Paginierungs-Konventionen.

- Ereignisse und Nachrichten: Payloads, die über Streams, Queues und Webhooks gesendet werden (oft implizit durch Konsumenten versioniert).

- Konfigurationen und Verträge: Feature-Flags, Umgebungsvariablen, YAML/JSON-Konfigurationen und „versteckte Verträge“ wie Dateiformate und Namenskonventionen.

Wenn zwei Teile des Systems Daten austauschen, gibt es ein Schema — auch wenn niemand es aufgeschrieben hat.

Warum sich Schemas in KI-erstellten Systemen häufiger ändern

KI-generierter Code kann die Entwicklung drastisch beschleunigen, erhöht aber auch den Change-Volumen:

- Generierter Code spiegelt den aktuellen Prompt und Kontext wider, sodass kleine Prompt-Anpassungen Feldnamen, Verschachtelung, Defaults oder Validierungen ändern können.

- Anforderungen entwickeln sich schneller, wenn es billig ist, einen neuen Endpunkt oder Pipeline-Schritt zu deployen.

- Inkonsistente Konventionen (snake_case vs. camelCase,

idvs.userId) treten auf, wenn mehrere Generationen oder Refactorings über Teams hinweg stattfinden.

Das Ergebnis ist ein häufigeres „Contract Drift“ zwischen Produzenten und Konsumenten.

Wenn Sie einen vibe-coding-Workflow nutzen (z. B. Handler, DB-Zugriffsschichten und Integrationen per Chat generieren), lohnt es sich, Schema-Disziplin von Anfang an in diesen Workflow einzubauen. Plattformen wie Koder.ai helfen Teams, schnell zu arbeiten, indem sie React/Go/PostgreSQL- und Flutter-Apps aus einer Chat-Oberfläche generieren — aber je schneller Sie ausliefern, desto wichtiger ist es, Schnittstellen zu versionieren, Payloads zu validieren und Änderungen bewusst auszurollen.

Ziel dieses Leitfadens

Dieser Beitrag konzentriert sich auf praktische Wege, Produktion stabil zu halten und dennoch schnell zu iterieren: Abwärtskompatibilität bewahren, Änderungen sicher ausrollen und Datenmigrationen ohne Überraschungen durchführen.

Was wir nicht behandeln

Wir tauchen nicht tief in theorie-lastiges Modellieren, formale Methoden oder vendor-spezifische Features ein. Der Schwerpunkt liegt auf Mustern, die über Stacks hinweg anwendbar sind — egal, ob Ihr System handkodiert, KI-unterstützt oder überwiegend KI-generiert ist.

Warum Schemaänderungen bei KI-generiertem Code häufiger auftreten

KI-generierter Code lässt Schemaänderungen normal erscheinen — nicht weil Teams nachlässig sind, sondern weil die Eingaben zum System sich öfter verändern. Wenn das Verhalten Ihrer Anwendung teilweise durch Prompts, Modellversionen und generierten Glue-Code gesteuert wird, driftet die Datenform mit höherer Wahrscheinlichkeit über die Zeit.

Häufige Auslöser, die in der Praxis auftreten

Einige Muster sorgen wiederholt für Schema-Churn:

- Neue Produktfunktionen: Hinzufügen eines neuen Felds (z. B.

risk_score,explanation,source_url) oder Aufspalten eines Konzepts in mehrere Felder (z. B.addressinstreet,city,postal_code). - Änderungen in Model-Ausgaben: Ein neueres Modell kann detailliertere Strukturen, andere Enum-Werte oder leicht veränderte Namen liefern („confidence“ vs. „score“).

- Prompt-Updates: Prompt-Änderungen zur Qualitätsverbesserung können unbeabsichtigt Formatierung, Pflichtfelder oder Verschachtelung ändern.

Riskante Muster, die KI-Systeme brüchig machen

KI-generierter Code „funktioniert“ oft schnell, kann aber fragile Annahmen kodieren:

- Implizite Annahmen: Code geht stumm davon aus, dass ein Feld immer vorhanden, immer numerisch oder immer in einem bestimmten Bereich ist.

- Versteckte Kopplung: Ein Dienst verlässt sich auf interne Feldnamen oder Reihenfolgen eines anderen Dienstes statt auf eine definierte Schnittstelle.

- Undokumentierte Felder: Das Modell fängt an, eine neue Eigenschaft auszugeben, und nachgelagerter Code verlässt sich darauf, ohne dass jemand explizit zugestimmt hat, dass es Teil des Vertrags ist.

Warum KI die Änderungsfrequenz verstärkt

Code-Generierung fördert schnelles Iterieren: Sie regenerieren Handler, Parser und Datenbankzugriffsschichten, sobald sich Anforderungen ändern. Diese Geschwindigkeit ist nützlich, macht es aber auch einfach, kleine Schnittstellenänderungen wiederholt auszuliefern — manchmal ohne es zu bemerken.

Die sicherere Denkweise ist, jedes Schema als Vertrag zu behandeln: Datenbanktabellen, API-Payloads, Events und sogar strukturierte LLM-Antworten. Wenn ein Konsument davon abhängt, versionieren Sie es, validieren Sie es und ändern Sie es bewusst.

Arten von Schemaänderungen: Additiv vs. Breaking

Schemaänderungen sind nicht gleich. Die nützlichste erste Frage lautet: Werden bestehende Konsumenten ohne Änderungen weiterarbeiten? Wenn ja, ist es meist additiv. Wenn nein, ist es breaking — und benötigt einen koordinierten Rollout-Plan.

Additive Änderungen (in der Regel sicher)

Additive Änderungen erweitern das Bestehende, ohne die vorhandene Bedeutung zu ändern.

Gängige Datenbankbeispiele:

- Eine Spalte hinzufügen mit einem Default oder NULL erlauben (z. B.

preferred_language). - Eine neue Tabelle oder einen Index hinzufügen.

- Ein optionales Feld zu einem in einer Spalte gespeicherten JSON-BLOB hinzufügen.

Nicht-Datenbank-Beispiele:

- Ein neues Property in einer API-Antwort hinzufügen (Clients, die unbekannte Felder ignorieren, funktionieren weiter).

- Ein neues Event-Feld in einer Stream-/Queue-Nachricht hinzufügen.

- Einen neuen Feature-Flag-Wert hinzufügen, während das bestehende Verhalten als Default erhalten bleibt.

Additiv ist nur dann „sicher“, wenn ältere Konsumenten tolerant sind: Sie müssen unbekannte Felder ignorieren und dürfen neue Felder nicht verlangen.

Breaking-Änderungen (riskant)

Breaking-Änderungen verändern oder entfernen etwas, worauf Konsumenten bereits angewiesen sind.

Typische datenbankbezogene Breaking-Änderungen:

- Den Spaltentyp ändern (string → integer, Änderung der Timestamp-Genauigkeit).

- Ein Feld/Spalte umbenennen (alles, was den alten Namen liest, schlägt fehl).

- Eine Spalte/Tabelle löschen, die noch abgefragt wird.

Nicht-Datenbank Breaking-Änderungen:

- JSON-Felder in Request/Response umbenennen/entfernen.

- Bedeutung eines Feldes ändern (gleicher Feldname, andere Semantik).

- Webhook-Payload-Struktur ohne Versionserhöhung ändern.

Dokumentieren Sie immer die Auswirkungen auf Konsumenten

Vor dem Mergen dokumentieren Sie:

- Wer konsumiert es (Services, Dashboards, Datenpipelines, Partner).

- Kompatibilität (backward/forward und für wie lange).

- Fehlermodus (Parsing-Fehler, stille Datenkorruption, falsche Business-Logik).

Diese kurze „Impact-Notiz“ schafft Klarheit — besonders wenn KI-generierter Code Schemaänderungen implizit einführt.

Versionierungsstrategien für Schemas und Schnittstellen

Versionierung sagt anderen Systemen (und dem zukünftigen Sie): „Das hat sich geändert, und so riskant ist es.“ Das Ziel ist nicht Papierkram, sondern das Verhindern stiller Ausfälle, wenn Clients, Services oder Datenpipelines mit unterschiedlichen Geschwindigkeiten aktualisiert werden.

Ein semantisches Versionsdenken in Klartext

Denken Sie in Major / Minor / Patch-Begriffen, auch wenn Sie nicht literal 1.2.3 veröffentlichen:

- Major: Breaking-Änderung. Alte Konsumenten können ohne Anpassung fehlschlagen oder sich falsch verhalten.

- Minor: Sichere Ergänzung. Alte Konsumenten funktionieren weiter; neue Konsumenten können neue Fähigkeiten nutzen.

- Patch: Bugfix oder Klarstellung, die die Bedeutung nicht ändert.

Eine einfache Regel, die Teams schützt: Ändern Sie niemals stillschweigend die Bedeutung eines bestehenden Feldes. Wenn status="active" früher „zahlender Kunde“ bedeutete, verwenden Sie es nicht stillschweigend für „Konto existiert“. Fügen Sie ein neues Feld oder eine neue Version hinzu.

Versionierte Endpunkte vs. versionierte Felder

Praktisch haben Sie meist zwei Optionen:

1) Versionierte Endpunkte (z. B. /api/v1/orders und /api/v2/orders):

Gut, wenn Änderungen wirklich breaking oder weitreichend sind. Es ist klar, erzeugt aber Duplikation und kann zu langfristiger Wartung führen, wenn Sie mehrere Versionen parallel betreiben.

2) Versionierte Felder / additive Evolution (z. B. new_field hinzufügen, old_field beibehalten):

Gut, wenn Änderungen additiv möglich sind. Ältere Clients ignorieren Unbekanntes; neuere Clients lesen das neue Feld. Mit der Zeit deprecaten und entfernen Sie das alte Feld mit einem expliziten Plan.

Ereignis-Schemas und Registries

Für Streams, Queues und Webhooks sind Konsumenten oft außerhalb Ihrer Deployment-Kontrolle. Ein Schema-Registry (oder ein zentrales Schema-Katalog mit Kompatibilitätsprüfungen) hilft, Regeln wie „nur additive Änderungen erlaubt“ durchzusetzen und macht sichtbar, welche Produzenten und Konsumenten von welchen Versionen abhängen.

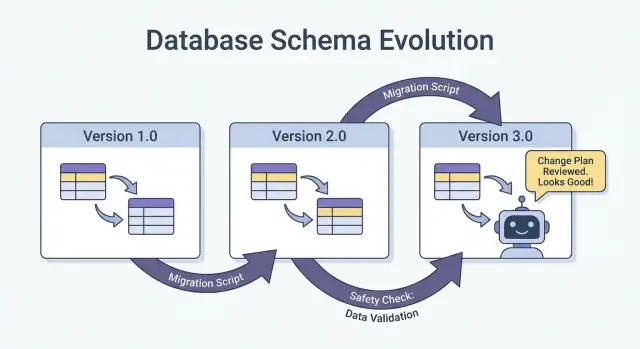

Sichere Rollouts: Erweitern/Rückbefüllen/Umschalten/Einschränken (Das zuverlässigste Muster)

Der sicherste Weg, Schemaänderungen zu deployen — besonders bei mehreren Services, Jobs und KI-generierten Komponenten — ist das Erweitern → Rückbefüllen → Umschalten → Einschränken-Muster. Es minimiert Ausfallzeiten und vermeidet „Alles-oder-Nichts“-Deployments, bei denen ein nachhängender Konsument die Produktion bricht.

Die vier Schritte (und warum sie funktionieren)

1) Erweitern: Führen Sie das neue Schema kompatibel nach hinten ein. Bestehende Leser und Schreiber sollten unverändert weiterarbeiten.

2) Rückbefüllen: Füllen Sie neue Felder für historische Daten (oder verarbeiten Sie Nachrichten erneut), sodass das System konsistent wird.

3) Umschalten: Aktualisieren Sie Schreiber und Leser, damit sie das neue Feld/Format verwenden. Das kann schrittweise geschehen (Canary, prozentualer Rollout), da das Schema beide Varianten unterstützt.

4) Einschränken: Entfernen Sie das alte Feld/Format erst, wenn Sie sicher sind, dass nichts mehr davon abhängt.

Zwei-Phasen- (Erweitern → Umschalten) und Drei-Phasen- (Erweitern → Rückbefüllen → Umschalten) Rollouts reduzieren Ausfallzeiten, weil sie enge Kopplung vermeiden: Schreiber können zuerst wechseln, Leser später, und umgekehrt.

Beispiel: Spalte hinzufügen, rückbefüllen, dann Pflicht machen

Angenommen, Sie möchten customer_tier hinzufügen.

- Erweitern: Fügen Sie

customer_tierals nullable mit DefaultNULLhinzu. - Rückbefüllen: Führen Sie einen Job aus, um Tiers für bestehende Zeilen zu berechnen.

- Umschalten: Aktualisieren Sie App und Pipelines, sodass sie immer

customer_tierschreiben, und bringen Sie Leser dazu, es zu bevorzugen. - Einschränken: Nach Monitoring machen Sie es NOT NULL (und entfernen optional Legacy-Logik).

Koordination: Schreiber und Leser müssen übereinstimmen

Behandeln Sie jedes Schema als Vertrag zwischen Produzenten (Schreibern) und Konsumenten (Lesern). In KI-erstellten Systemen ist das leicht zu übersehen, weil neue Codepfade schnell auftauchen. Machen Sie Rollouts explizit: dokumentieren Sie, welche Version was schreibt, welche Services beide Versionen lesen können und das genaue „Contract-Datum“, an dem alte Felder entfernt werden können.

Datenbankmigrationen: Wie man Daten ändert, ohne Produktion zu brechen

Kontrakte in Code umwandeln

Generiere APIs und DB‑Schichten und iteriere sicher mit versionierten Schnittstellen.

Datenbankmigrationen sind das „Handbuch“, um Produktionsdaten und -strukturen von einem sicheren Zustand in den nächsten zu überführen. In KI-erstellten Systemen sind sie noch wichtiger, weil generierter Code versehentlich annehmen kann, eine Spalte existiere, Felder inkonsistent umbenennt oder Constraints ändert, ohne vorhandene Zeilen zu berücksichtigen.

Migrationsdateien vs. Auto-Migrationen

Migrationsdateien (im Source-Control) sind explizite Schritte wie „Spalte X hinzufügen“, „Index Y erstellen“ oder „Daten von A nach B kopieren“. Sie sind auditierbar, reviewbar und können in Staging und Produktion reproduziert werden.

Auto-Migrationen (vom ORM/Framework generiert) sind praktisch für frühe Entwicklung und Prototyping, können aber riskante Operationen erzeugen (Spalten löschen, Tabellen neu aufbauen) oder Änderungen in einer ungewollten Reihenfolge ausführen.

Praktische Regel: Verwenden Sie Auto-Migrationen, um Änderungen zu entwerfen, aber konvertieren Sie alles, was Produktion berührt, in geprüfte Migrationsdateien.

Idempotenz und Reihenfolge

Machen Sie Migrationen dort, wo möglich, idempotent: Ein erneuter Lauf sollte Daten nicht korrumpieren oder halb scheitern. Bevorzugen Sie „create if not exists“, fügen Sie neue Spalten zunächst als nullable hinzu und schützen Sie Daten-Transformationen mit Prüfungen.

Halten Sie außerdem eine klare Reihenfolge ein. Jede Umgebung (lokal, CI, Staging, Prod) sollte die gleiche Migrationssequenz anwenden. „Beheben“ Sie Produktion nicht mit manuellem SQL, ohne es anschließend in einer Migration zu erfassen.

Lang laufende Migrationen ohne Table-Locking

Einige Schemaänderungen können Writes (oder sogar Reads) blockieren, wenn sie eine große Tabelle sperren. Auf hoher Ebene lässt sich das Risiko reduzieren durch:

- Nutzung von Online-/Lock-vermindernden Operationen, die Ihre Datenbank unterstützt (z. B. paralleles Erstellen von Indizes).

- Aufteilen von Änderungen in Schritte: Zuerst neue Strukturen hinzufügen, Rückbefüllung in Batches, dann Umschalten in der App.

- Planung schwerer Operationen in Traffic-armen Fenstern mit Timeouts und Monitoring.

Multi-Tenant- und Shard-Setups

Für Multi-Tenant-Datenbanken führen Sie Migrationen in einer gesteuerten Schleife pro Mandant aus, mit Fortschritts-Tracking und sicheren Retries. Für Shards behandeln Sie jeden Shard wie ein separates Produktionssystem: Rollen Sie Migrationen Shard-für-Shard aus, prüfen Sie die Gesundheit und fahren Sie fort. Das begrenzt den Blast-Radius und macht Rollbacks machbar.

Backfills und Reprocessing: Bestehende Daten aktualisieren

Ein Backfill ist, wenn Sie neue Felder (oder korrigierte Werte) für bestehende Datensätze befüllen. Reprocessing ist, wenn Sie historische Daten erneut durch eine Pipeline laufen lassen — typischerweise weil Business-Regeln geändert wurden, ein Bug behoben wurde oder ein Modell/Output-Format aktualisiert wurde.

Beides ist nach Schemaänderungen üblich: Es ist leicht, die neue Form für „neue Daten“ zu schreiben, aber Produktionssysteme hängen oft davon ab, dass auch die Daten von gestern konsistent sind.

Gängige Ansätze

Online-Backfill (in Produktion, schrittweise). Sie führen einen gesteuerten Job aus, der Datensätze in kleinen Batches aktualisiert, während das System live bleibt. Das ist für kritische Dienste sicherer, da Sie Last drosseln, pausieren und fortsetzen können.

Batch-Backfill (offline oder geplant). Sie verarbeiten große Mengen in Traffic-armen Fenstern. Das ist operativ einfacher, kann aber Spikes in der DB-Last erzeugen und länger brauchen, um Fehler zu beheben.

Lazy-Backfill bei Zugriff. Beim Lesen eines alten Datensatzes berechnet die Anwendung fehlende Felder und schreibt sie zurück. Das verteilt die Kosten über die Zeit und vermeidet einen großen Job, macht den ersten Zugriff aber langsamer und kann alte Daten lange unkonvertiert lassen.

In der Praxis kombinieren Teams das oft: Lazy-Backfill für den Long-Tail und einen Online-Job für die am häufigsten genutzten Daten.

Wie man einen Backfill validiert

Validierung sollte explizit und messbar sein:

- Counts: Wie viele Zeilen/Ereignisse sollten aktualisiert werden vs. wie viele wurden aktualisiert.

- Checksummen/Aggregate: Vergleichen Sie Summen (z. B. Beträge, distinct IDs) vor/nachher.

- Sampling: Stichprobenprüfung mit statistisch aussagekräftiger Größe, inklusive Randfälle.

Validieren Sie auch downstream-Effekte: Dashboards, Suchindizes, Caches und Exporte, die auf den aktualisierten Feldern beruhen.

Kosten, Dauer und Akzeptanzkriterien

Backfills tauschen Geschwindigkeit (schnelles Abschließen) gegen Risiko und Kosten (Last, Rechenzeit, operativer Overhead). Legen Sie Akzeptanzkriterien im Voraus fest: was „fertig“ bedeutet, erwartete Laufzeit, maximal erlaubte Fehlerrate und wie Sie vorgehen, wenn die Validierung fehlschlägt (pausieren, neu versuchen oder zurückrollen).

Schema-Evolution von Events und Nachrichten (Streams, Queues, Webhooks)

Event‑Schemata behutsam weiterentwickeln

Gestalte Event‑Payloads so, dass unbekannte Felder toleriert werden und Konsumenten nicht beeinträchtigt werden.

Schemas leben nicht nur in Datenbanken. Immer wenn ein System Daten an ein anderes sendet — Kafka-Topics, SQS/RabbitMQ-Queues, Webhook-Payloads oder sogar „Events“, die in Object Storage geschrieben werden — entsteht ein Vertrag. Produzenten und Konsumenten bewegen sich unabhängig, daher neigen diese Verträge eher dazu, zu brechen als die internen Tabellen einer App.

Der sicherste Default: Events rückwärtskompatibel entwickeln

Für Event-Streams und Webhook-Payloads bevorzugen Sie Änderungen, die alte Konsumenten ignorieren können und neue Konsumenten adaptieren.

Eine praktische Regel: Fügen Sie Felder hinzu, entfernen oder benennen Sie nicht um. Wenn Sie etwas deprecaten müssen, senden Sie es noch eine Weile weiter und dokumentieren Sie es als veraltet.

Beispiel: Ein OrderCreated-Event um optionale Felder erweitern.

{

"event_type": "OrderCreated",

"order_id": "o_123",

"created_at": "2025-12-01T10:00:00Z",

"currency": "USD",

"discount_code": "WELCOME10"

}

Ältere Konsumenten lesen order_id und created_at und ignorieren den Rest.

Consumer-getriebene Verträge (in Klartext)

Statt dass der Produzent raten muss, was andere bricht, veröffentlichen Konsumenten, worauf sie angewiesen sind (Felder, Typen, required/optional Regeln). Der Produzent validiert dann Änderungen gegen diese Erwartungen, bevor er sie ausliefert. Das ist besonders nützlich in KI-generierten Codebasen, wo ein Modell ein Feld „hilfreich“ umbenennen oder einen Typ ändern könnte.

Umgang mit „unbekannten Feldern“ sicher gestalten

Machen Sie Parser tolerant:

- Ignorieren Sie unbekannte Felder standardmäßig (scheitern Sie nicht nur, weil ein neuer Key auftaucht).

- Behandeln Sie neue Felder als optional, bis Sie sie wirklich benötigen.

- Loggen Sie unerwartete Felder auf niedriger Ebene, damit Sie Adoption-Probleme sehen, ohne Paging auszulösen.

Wenn Sie eine Breaking-Änderung brauchen, verwenden Sie einen neuen Event-Typ oder einen versionierten Namen (z. B. OrderCreated.v2) und betreiben Sie beide parallel, bis alle Konsumenten migriert sind.

KI-Ausgaben als Schema: Prompts, Modelle und strukturierte Antworten

Wenn Sie ein LLM in ein System einbinden, werden seine Ausgaben schnell zu einem De-facto-Schema — auch wenn niemand eine formelle Spezifikation geschrieben hat. Nachgelagerter Code nimmt an, „es gibt ein summary-Feld“, „die erste Zeile ist der Titel“ oder „Aufzählungen sind durch Bindestriche getrennt“. Diese Annahmen verfestigen sich und eine kleine Verschiebung im Modellverhalten kann sie genauso brechen wie eine Spaltenumbenennung.

Bevorzugen Sie explizite Struktur (und validieren Sie sie)

Statt „schönen Text“ zu parsen, fordern Sie strukturierte Outputs (typischerweise JSON) an und validieren Sie sie, bevor sie in den Rest Ihres Systems gelangen. Betrachten Sie das als Übergang von „best effort“ zu einem Vertrag.

Praktischer Ansatz:

- Definieren Sie ein JSON-Schema (oder ein getyptes Interface) für die Modellantwort.

- Lehnen Sie ungültige Antworten ab oder quarantänisieren Sie sie (nicht stillschweigend konvertieren).

- Loggen Sie Validierungsfehler, damit Sie sehen, was sich ändert.

Das ist besonders wichtig, wenn LLM-Antworten Datenpipelines, Automatisierung oder user-facing Content speisen.

Planen Sie für Model-Drift

Selbst mit demselben Prompt können Ausgaben über die Zeit schwanken: Felder fehlen, zusätzliche Keys erscheinen und Typen können wechseln ("42" vs 42, Arrays vs Strings). Behandeln Sie solche Ereignisse als Schema-Evolution.

Wirksame Gegenmaßnahmen:

- Machen Sie Felder optional, wo sinnvoll, und setzen Sie Defaults explizit.

- Erlauben Sie unbekannte Keys, aber ignorieren Sie sie sicher (außer Sie sind aus Compliance-Gründen strikt).

- Fügen Sie „Guardrails“-Checks hinzu (z. B. Pflichtfelder, Max-Längen, Enum-Werte).

Behandeln Sie Prompt-Änderungen wie API-Änderungen

Ein Prompt ist eine Schnittstelle. Wenn Sie ihn bearbeiten, versionieren Sie ihn. Behalten Sie prompt_v1, prompt_v2 und rollen Sie graduell aus (Feature-Flags, Canaries oder pro-Mandant-Toggles). Testen Sie mit einem festen Evaluationsset, bevor Sie Promotion durchführen, und lassen Sie ältere Versionen laufen, bis nachgelagerte Konsumenten adaptiert haben. Für mehr zu sicheren Rollout-Mechaniken verknüpfen Sie Ihren Ansatz mit /blog/safe-rollouts-expand-contract.

Tests und Validierung für Schemaänderungen

Schemaänderungen schlagen meist auf langweilige, teure Weise fehl: Eine neue Spalte fehlt in einer Umgebung, ein Konsument erwartet noch ein altes Feld oder eine Migration läuft auf leeren Daten, timet aber in Produktion aus. Testing wandelt diese „Überraschungen“ in vorhersehbare, behebbare Arbeit um.

Drei Testebenen (und was jede abfängt)

Unit-Tests schützen lokale Logik: Mapping-Funktionen, Serializer/Deserializer, Validatoren und Query-Builder. Wenn ein Feld umbenannt oder ein Typ geändert wird, sollten Unit-Tests nahe an dem Code fehlschlagen, der aktualisiert werden muss.

Integrationstests stellen sicher, dass Ihre App mit echten Abhängigkeiten funktioniert: dem realen Datenbank-Engine, einem echten Migrationstool und realen Nachrichtenformaten. Hier fangen Sie Probleme wie „das ORM-Modell änderte sich, aber die Migration nicht“ oder „der neue Index-Name kollidiert“.

End-to-End-Tests simulieren Nutzer- oder Workflow-Ergebnisse über Services hinweg: Daten erzeugen, migrieren, über APIs zurücklesen und prüfen, dass nachgelagerte Konsumenten sich weiterhin korrekt verhalten.

Vertragstests für Produzenten und Konsumenten

Schema-Evolution bricht oft an Grenzen: Service-zu-Service-APIs, Streams, Queues und Webhooks. Fügen Sie Contract-Tests hinzu, die auf beiden Seiten laufen:

- Produzenten beweisen, dass sie Events/Antworten ausgeben können, die dem vereinbarten Vertrag entsprechen.

- Konsumenten beweisen, dass sie während eines Rollouts sowohl alte als auch neue Versionen parsen können.

Migrationstests: Anwenden und Zurückrollen in frischen Umgebungen

Testen Sie Migrationen so, wie Sie sie deployen:

- Starten Sie von einem sauberen Datenbanksnapshot.

- Wenden Sie alle Migrationen in der Reihenfolge an.

- Verifizieren Sie, dass die App lesen/schreiben kann.

- Führen Sie ein Rollback (falls unterstützt) oder eine „down“-Migration aus und bestätigen Sie, dass der Zustand wieder funktionsfähig ist.

Fixtures für alte und neue Schema-Versionen

Halten Sie eine kleine Menge Fixtures bereit, die repräsentieren:

- Unter dem vorherigen Schema geschriebene Daten (Legacy-Zeilen/Ereignisse).

- Unter dem neuen Schema geschriebene Daten.

Diese Fixtures machen Regressionen offensichtlich, besonders wenn KI-generierter Code Feldnamen, Optionalität oder Formatierung subtil ändert.

Observability: Fehler früh erkennen

Baue und erhalte Belohnungen

Teile, was du gebaut hast, mit Koder.ai oder lade ein Teammitglied ein und verdiene Credits.

Schemaänderungen schlagen selten im Moment des Deployments laut fehl. Häufiger zeigen sich Probleme als langsames Ansteigen von Parsing-Fehlern, seltsamen „unbekannten Feld“-Warnungen, fehlenden Daten oder Hintergrundjobs, die ins Hintertreffen geraten. Gute Observability wandelt diese schwachen Signale in handlungsfähiges Feedback, solange Sie den Rollout noch pausieren können.

Was man während eines Rollouts überwachen sollte

Beginnen Sie mit den Basics (App-Gesundheit) und fügen Sie dann schema-spezifische Signale hinzu:

- Fehler: Anstiege bei 4xx/5xx, aber auch „weiche“ Fehler wie JSON-Parsing-Fails, fehlgeschlagene Deserialisierung und Retries.

- Latenz: p95/p99-Antwortzeiten und Queue-Verarbeitungszeit. Schemaänderungen können Joins, größere Payloads oder zusätzliche Validierung hinzufügen.

- Datenqualitäts-Signale: Anstieg der Null-Rate in wichtigen Spalten, plötzliche Abnahmen im Event-Volumen, neue Default-Werte, die zu oft erscheinen, oder Abweichungen zwischen alten und neuen Repräsentationen.

- Pipeline-Lag: Konsumenten-Lag in Streams/Queues, Webhook-Delivery-Backlog und Durchsatz von Migrationsjobs.

Der Schlüssel ist, Vorher vs. Nachher zu vergleichen und nach Client-Version, Schema-Version und Traffic-Segment (Canary vs. Stable) zu slicen.

Dashboards, die wirklich helfen

Erstellen Sie zwei Dashboard-Ansichten:

-

Anwendungs-Verhaltens-Dashboard

- Request-Rate, Error-Rate, Latenz (RED)

- Top-Ausnahmen (nach Message gruppiert)

- Validierungs-/Parsing-Fehleranzahl und -Prozentsatz

- Payload-Größenverteilung (um unerwartet große Nachrichten zu erkennen)

-

Migrations- und Hintergrundjob-Dashboard

- Fortschritt des Migrationsjobs (% erledigt), Zeilen pro Sekunde, ETA

- Fehler- und Retry-Rate

- Queue-Tiefe / Konsumenten-Lag

- Dead-Letter-Queue-Volumen (falls relevant)

Wenn Sie einen Erweitern/Einschränken-Rollout durchführen, fügen Sie ein Panel hinzu, das Lese-/Schreibezugriffe getrennt nach altem vs. neuem Schema zeigt, damit Sie sehen, wann es sicher ist, zur nächsten Phase überzugehen.

Alerts für schema-spezifische Fehler

Rufen Sie Pager bei Problemen, die darauf hindeuten, dass Daten fallen gelassen oder falsch interpretiert werden:

- Schema-Validierungsfehler-Rate über einer niedrigen Schwelle (oft schon \u003c0,1% ist aussagekräftig)

- Parsing-/Deserialisierungsfehler (insbesondere wenn sie sich auf einen Produzenten/Konsumenten konzentrieren)

- Unerwartete Felder / fehlende Pflichtfelder-Warnungen, die nach oben tendieren

- Migrationsjob gestoppt (keine Fortschritte für N Minuten) oder Lag wächst schneller als Durchsatz

Vermeiden Sie laute Alerts auf rohen 500ern ohne Kontext; koppeln Sie Alerts an den Schema-Rollout mit Tags wie Schema-Version und Endpoint.

Versionen loggen, damit Fehler schnell debuggt werden können

Während der Transition loggen und includieren Sie:

- Schema-Version (z. B.

X-Schema-VersionHeader, Nachrichten-Metadatenfeld) - Producer- und Consumer-App-Version

- Modellversion / Prompt-Version, wenn KI-Ausgaben strukturierte Daten speisen

Dieses Detail macht die Frage „Warum ist dieser Payload fehlgeschlagen?“ in Minuten statt Tagen beantwortbar — besonders wenn verschiedene Services (oder verschiedene KI-Modellversionen) gleichzeitig live sind.

Rollback, Wiederherstellung und Change-Management

Schemaänderungen scheitern auf zwei Arten: Die Änderung selbst ist fehlerhaft, oder das System darum herum verhält sich anders als erwartet (insbesondere wenn KI-generierter Code subtile Annahmen einführt). In jedem Fall braucht jede Migration eine Rollback-Story, bevor sie deployed wird — selbst wenn diese Story explizit „kein Rollback“ lautet.

Die Entscheidung „kein Rollback“ kann valide sein, wenn die Änderung irreversibel ist (z. B. Spalten löschen, Identifikatoren umschreiben oder destruktives Deduping). „Kein Rollback“ ist aber keine Abwesenheit eines Plans; es verschiebt den Plan hin zu Forward-Fixes, Wiederherstellungen und Containment.

Praktische Rollback-Optionen, die wirklich funktionieren

Feature-Flags / Config-Gates: Kapseln Sie neue Reader, Writer und API-Felder hinter einem Flag, damit Sie das neue Verhalten ohne Redeploy ausschalten können. Das ist besonders nützlich, wenn KI-generierter Code syntaktisch richtig, semantisch aber falsch sein könnte.

Dual-Write abschaltbar machen: Wenn Sie während eines Erweitern/Einschränken-Rollouts in beide Schemas schreiben, behalten Sie einen Kill-Switch. Das Abschalten des neuen Schreibpfads stoppt weitere Divergenz, während Sie untersuchen.

Reader zurücksetzen (nicht nur Writer): Viele Vorfälle entstehen, weil Konsumenten zu früh neue Felder oder Tabellen lesen. Machen Sie es einfach, Services auf die vorherige Schema-Version zurückzusetzen oder neue Felder zu ignorieren.

Grenzen der Umkehrbarkeit kennen

Einige Migrationen lassen sich nicht sauber rückgängig machen:

- Destruktive Transformationen (z. B. Hashing, verlustbehaftete Normalisierung).

- Löschen/Umbenennen ohne erhaltene Kopie.

- Backfills, die die „Quelle der Wahrheit“ überschreiben.

Für diese planen Sie Restore-from-Backup, Replay aus Events oder Neuberechnung aus Rohdaten — und verifizieren Sie, dass diese Inputs noch vorhanden sind.

Pre-Flight-Checklist (vor dem Shipping)

- Rollback-Entscheidung dokumentiert („revert“, „forward fix“ oder „no rollback + restore path").

- Klarer Stopp-Knopf: Flags und/oder Dual-Write-Disable-Switch.

- Backups/Snapshots verifiziert; Wiederherstellung mindestens einmal getestet.

- Migration ist idempotent; erneutes Ausführen korrumpiert nicht.

- Monitoring und Alerts für Fehlerquoten, Schema-Validierungsfehler und Lag.

- Ownership: Wer genehmigt, wer führt aus, wer ist on-call während des Rollouts.

Gutes Change-Management macht Rollbacks selten — und macht die Wiederherstellung langweilig, wenn sie doch nötig wird.

Wenn Ihr Team schnell mit KI-unterstützter Entwicklung iteriert, hilft es, diese Praktiken mit Werkzeugen zu koppeln, die sicheres Experimentieren unterstützen. Zum Beispiel bietet Koder.ai einen Planungsmodus für upfront-Change-Design und Snapshots/Rollback für schnelle Wiederherstellung, wenn eine generierte Änderung aus Versehen einen Vertrag verschiebt. Zusammen genutzt ermöglichen schnelle Code-Generierung und disziplinierte Schema-Evolution, schneller zu werden, ohne Produktion zum Testumfeld zu machen.