18. Mai 2025·8 Min

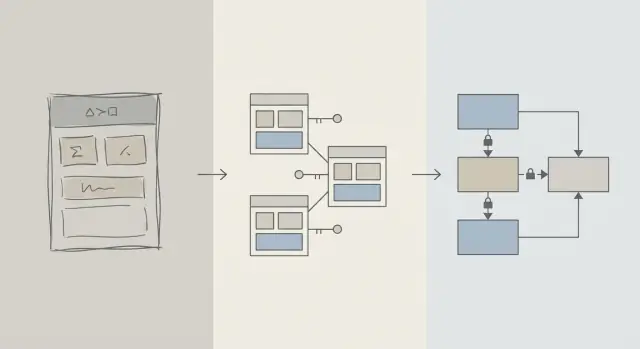

Schema-Design zuerst: Schnellere Apps statt frühe Query-Optimierung

Frühe Performance-Gewinne kommen meist vom besseren Schema-Design: die richtigen Tabellen, Keys und Constraints verhindern langsame Abfragen und teure Umbauten später.

Schema vs Query-Optimierung: Was wir meinen

Wenn sich eine App langsam anfühlt, ist der erste Impuls oft: „Fix the SQL.“ Dieser Drang ist verständlich: Eine einzelne Abfrage ist sichtbar, messbar und leicht zu beschuldigen. Sie können EXPLAIN ausführen, einen Index hinzufügen, einen JOIN anpassen und manchmal sofortige Verbesserungen sehen.

Aber am Anfang eines Produkts kommen Leistungsprobleme ebenso wahrscheinlich von der Form der Daten wie vom konkreten Abfragetext. Wenn das Schema Sie dazu zwingt, gegen die Datenbank zu kämpfen, wird Query-Tuning zu einem Whack-a-Mole-Zyklus.

Schema-Design (einfach erklärt)

Schema-Design ist, wie Sie Ihre Daten organisieren: Tabellen, Spalten, Beziehungen und Regeln. Es umfasst Entscheidungen wie:

- Welche „Dinge“ eine eigene Tabelle verdienen (Benutzer, Bestellungen, Events)

- Wie Tabellen sich zueinander verhalten (one-to-many, many-to-many)

- Was eindeutig oder verpflichtend sein muss (Constraints)

- Wie Sie Zustände und Historie darstellen (Timestamps, Status-Felder, Audit-Records)

Gutes Schema-Design sorgt dafür, dass die natürliche Art, Fragen zu stellen, auch die schnelle Art ist.

Query-Optimierung (einfach erklärt)

Query-Optimierung verbessert, wie Sie Daten abrufen oder aktualisieren: Abfragen umschreiben, Indizes hinzufügen, unnötige Arbeit reduzieren und Muster vermeiden, die große Scans auslösen.

Beides ist wichtig—die Reihenfolge ist wichtiger

Dieser Artikel sagt nicht „Schema gut, Queries schlecht.“ Es geht um die Reihenfolge: Bringen Sie zunächst die fundamentalen Datenmodell-Entscheidungen in Ordnung, dann optimieren Sie die Abfragen, die es wirklich brauchen.

Sie erfahren, warum Schema-Entscheidungen die frühe Performance dominieren, wie Sie erkennen, wann das Schema der eigentliche Flaschenhals ist, und wie Sie es sicher weiterentwickeln, während Ihre App wächst. Geschrieben für Produktteams, Gründer und Entwickler, die reale Anwendungen bauen—nicht nur für Datenbankspezialisten.

Warum Schema-Design die meiste frühe Performance bestimmt

Frühe Performance dreht sich selten um clevere SQL-Tricks—es geht darum, wie viele Daten die Datenbank gezwungen ist zu berühren.

Die Struktur bestimmt, wie viel gescannt wird

Eine Abfrage kann nur so selektiv sein, wie es das Datenmodell zulässt. Wenn Sie „status“, „type“ oder „owner“ in locker strukturierten Feldern speichern (oder über inkonsistente Tabellen verteilen), muss die Datenbank oft viel mehr Zeilen durchsuchen, um passende Datensätze zu finden.

Ein gutes Schema verengt den Suchraum ganz natürlich: klare Spalten, konsistente Datentypen und gut abgegrenzte Tabellen bedeuten, dass Abfragen früher filtern und weniger Seiten von Disk oder Speicher lesen.

Fehlende Keys erzeugen teure Arbeit

Wenn Primärschlüssel und Fremdschlüssel fehlen (oder nicht durchgesetzt werden), werden Beziehungen zu Vermutungen. Das verschiebt Arbeit in die Abfrage-Schicht:

- Joins werden größer, weil es keinen verlässlichen, indizierten Join-Pfad gibt.

- Filter werden komplexer, weil Sie Duplikate, NULLs und „beinahe passende“ Werte kompensieren.

Ohne Constraints sammelt sich schlechte Datenqualität an—und Abfragen werden mit wachsender Zeilenanzahl immer langsamer.

Indizes folgen dem Schema (und können nicht alles retten)

Indizes sind am nützlichsten, wenn sie vorhersehbare Zugriffspfade abdecken: Joins über Fremdschlüssel, Filter über gut definierte Spalten, Sortierungen nach häufig verwendeten Feldern. Wenn das Schema kritische Attribute in der falschen Tabelle speichert, Bedeutungen in einer Spalte mischt oder auf Textparsing setzt, können Indizes nicht helfen—Sie scannen und transformieren immer noch zu viel.

Standardmäßig schnell

Mit sauberen Beziehungen, stabilen Identifikatoren und sinnvollen Tabellenrändern werden viele Alltagsabfragen „von Haus aus“ schnell, weil sie weniger Daten berühren und einfache, indexfreundliche Prädikate verwenden. Query-Tuning wird dann ein Feinschliff—nicht ein ständiger Brandbekämpfungsprozess.

Die Realität in frühen Phasen: Veränderung ist konstant

Frühphasige Produkte haben selten „stabile Anforderungen“—sie führen Experimente durch. Features werden ausgeliefert, umgeschrieben oder fallen weg. Ein kleines Team jongliert Roadmap-Druck, Support und Infrastruktur mit wenig Zeit, alte Entscheidungen zu überdenken.

Was sich am häufigsten ändert

Es ist selten der SQL-Text, der zuerst ändert. Es sind die Bedeutungen der Daten: neue Zustände, neue Beziehungen, neue „ach, wir müssen auch noch…“-Felder und ganze Workflows, die beim Launch nicht vorgesehen waren. Dieser Wandel ist normal—und genau deshalb sind Schema-Entscheidungen früh so wichtig.

Warum das spätere Ändern des Schemas schwerer ist als das Ändern einer Abfrage

Eine Abfrage umzuschreiben ist meistens reversibel und lokal: Sie können ein Improvement shippen, messen und bei Bedarf zurückrollen.

Ein Schema umzuschreiben ist anders. Sobald Sie echte Kundendaten gespeichert haben, wird jede strukturelle Änderung zu einem Projekt:

- Migrationen, die Tabellen sperren oder Schreibvorgänge zu Spitzenzeiten verlangsamen

- Backfills, um neue Spalten zu füllen oder abgeleitete Daten neu aufzubauen

- Dual-writes oder Shadow-Tabellen, um die App während der Transition am Laufen zu halten

- Ausfallrisiko, wenn eine Änderung nicht online durchführbar ist

Selbst mit guten Tools führen Schema-Änderungen zu Koordinationskosten: App-Code-Updates, Sequenzierung von Deployments und Datenvalidierung.

Wie frühe Entscheidungen sich verstärken

Wenn die Datenbank klein ist, kann ein ungelenkes Schema „in Ordnung“ wirken. Wenn die Zeilen aber von Tausenden zu Millionen wachsen, erzeugt dasselbe Design größere Scans, schwerere Indizes und teurere Joins—und jedes neue Feature baut dann auf diesem Fundament auf.

Das frühe Ziel ist also nicht Perfektion. Es ist ein Schema zu wählen, das Veränderungen absorbiert, ohne bei jeder Produktlernerfahrung riskante Migrationen zu erzwingen.

Design-Grundlagen, die langsame Abfragen verhindern

Die meisten „langsame Abfrage“-Probleme am Anfang sind weniger SQL-Tricks als Mehrdeutigkeiten im Datenmodell. Wenn das Schema nicht klar macht, was ein Datensatz darstellt oder wie Datensätze sich zueinander verhalten, wird jede Abfrage teurer im Schreiben, Ausführen und Pflegen.

Beginnen Sie mit einer kleinen Menge Kern-Entitäten

Nennen Sie die wenigen Dinge, auf die Ihr Produkt nicht verzichten kann: Benutzer, Accounts, Bestellungen, Abonnements, Events, Rechnungen—was wirklich zentral ist. Definieren Sie dann Beziehungen explizit: one-to-many, many-to-many (meist mit einer Join-Tabelle) und Ownership (wer „enthält“ was).

Ein praktischer Check: Für jede Tabelle sollten Sie den Satz „Eine Zeile in dieser Tabelle repräsentiert ___.“ vervollständigen können. Wenn das nicht geht, mischt die Tabelle vermutlich Konzepte, was später komplexe Filter und Joins erzwingt.

Machen Sie Namensgebung und Ownership langweilig konsistent

Konsistenz verhindert versehentliche Joins und verwirrendes API-Verhalten. Wählen Sie Konventionen (snake_case vs camelCase, *_id, created_at/updated_at) und halten Sie sich daran.

Entscheiden Sie auch, wem ein Feld gehört. Zum Beispiel: Gehört billing_address zu einer Bestellung (Snapshot zum Zeitpunkt) oder zu einem Benutzer (aktuelles Default)? Beides kann gültig sein—aber das Vermischen ohne klare Absicht erzeugt langsame, fehleranfällige Abfragen, um „die Wahrheit“ herauszufinden.

Wählen Sie Datentypen, die der Realität entsprechen

Verwenden Sie Typen, die Laufzeit-Konvertierungen vermeiden:

- Verwenden Sie Timestamps mit klaren Zeitzonenregeln.

- Verwenden Sie

decimalfür Geldbeträge (nichtfloat). - Verwenden Sie Enums/Referenztabellen für bekannte Kategorien.

Wenn Typen falsch sind, kann die Datenbank nicht effizient vergleichen, Indizes werden weniger nützlich und Abfragen benötigen oft Casts.

Duplizieren Sie Fakten nicht ohne Plan

Dasselbe Faktum an mehreren Stellen zu speichern (z. B. order_total und sum(line_items)) erzeugt Drift. Wenn Sie einen abgeleiteten Wert cachen, dokumentieren Sie ihn, definieren Sie eine Quelle der Wahrheit und sorgen Sie für konsistente Updates (oft via Applikationslogik plus Constraints).

Keys und Constraints: Geschwindigkeit beginnt mit Datenintegrität

Eine schnelle Datenbank ist meist eine vorhersehbare Datenbank. Keys und Constraints machen Ihre Daten vorhersehbar, indem sie „unmögliche“ Zustände verhindern—fehlende Beziehungen, doppelte Identitäten oder Werte, die nicht das bedeuten, was die App denkt. Diese Sauberkeit beeinflusst die Performance direkt, weil die Datenbank bessere Annahmen bei der Query-Planung treffen kann.

Primärschlüssel: Jede Tabelle braucht eine stabile Identität

Jede Tabelle sollte einen Primärschlüssel (PK) haben: eine Spalte (oder kleines Spalten-Set), das eine Zeile eindeutig identifiziert und sich nie ändert. Das ist nicht nur Theorie—es erlaubt effiziente Joins, sicheres Caching und Referenzen auf Datensätze ohne Rätselraten.

Ein stabiler PK vermeidet teure Workarounds. Fehlt eine echte Identifikation, fangen Anwendungen an, Zeilen über E-Mail, Namen, Zeitstempel oder ein Bündel von Spalten „zu identifizieren“—das führt zu breiteren Indizes, langsameren Joins und Edge-Cases, wenn sich diese Werte ändern.

Fremdschlüssel: Integrität, die dem Optimierer hilft

Fremdschlüssel (FKs) erzwingen Beziehungen: orders.user_id muss auf ein existierendes users.id zeigen. Ohne FKs schleichen sich ungültige Referenzen ein (Bestellungen für gelöschte Benutzer, Kommentare für fehlende Posts), und jede Abfrage muss defensiv filtern, left-joinen und NULLs behandeln.

Mit FKs kann der Query-Planer Joins oft sicherer optimieren, weil die Beziehung explizit und garantiert ist. Sie sammeln außerdem seltener Waisenzeilen an, die Tabellen und Indizes aufblähen.

Constraints als Leitplanken für saubere, schnelle Daten

Constraints sind keine Bürokratie—sie sind Leitplanken:

- UNIQUE verhindert Duplikate, die die App zu zusätzlichen Lookups und Aufräumarbeiten zwingen. Beispiel: eine kanonische

users.email. - NOT NULL vermeidet Drei-Zustands-Logik und überraschende NULL-Handling-Pfade in Abfragen.

- CHECK hält Werte in einem bekannten Bereich (z. B.

status IN ('pending','paid','canceled')).

Sauberere Daten bedeuten einfachere Abfragen, weniger Fallback-Logik und weniger „nur für den Fall“-Joins.

Häufige Antipatterns, die bremsen

- Keine Fremdschlüssel: Später zahlen Sie mit Aufräumjobs und komplizierter Abfragelogik.

- Duplizierte E-Mail-Felder (z. B.

users.emailundcustomers.email): Sie bekommen widersprüchliche Identitäten und doppelte Indizes. - Freiform-Statusstrings: Tippfehler wie "Cancelled" vs "canceled" erzeugen versteckte Segmente, die Filter und Reporting brechen.

Wenn Sie früh Geschwindigkeit wollen, machen Sie es schwer, schlechte Daten zu speichern. Die Datenbank belohnt Sie mit einfacheren Plänen, kleineren Indizes und weniger Leistungsüberraschungen.

Normalisierung vs Denormalisierung: Ein praktisches Gleichgewicht

Arbeite mit deinem ganzen Team

Wähle einen passenden Plan – vom Solo-Build bis zu Business‑ und Enterprise‑Teams.

Normalisierung ist die einfache Idee: Jedes „Fakt“ hat genau einen Ort, damit Sie Daten nicht überall in der Datenbank duplizieren. Wenn derselbe Wert in mehrere Tabellen oder Spalten kopiert wird, werden Updates riskant—eine Kopie ändert sich, die andere nicht, und Ihre App zeigt widersprüchliche Antworten.

Normalisierung (Standard): ein Fakt, ein Zuhause

In der Praxis bedeutet Normalisierung, Entitäten so zu trennen, dass Updates sauber und vorhersehbar sind. Beispiel: Name und Preis eines Produkts gehören in eine products-Tabelle, nicht in jede Bestellzeile. Ein Kategoriename gehört in categories, referenziert durch eine ID.

Das reduziert:

- doppelte Daten (weniger Speicher, weniger Inkonsistenzen)

- Update-Fehler (einmal ändern, überall reflektiert)

- verwirrende „welcher Wert ist korrekt?“-Bugs

Wenn Über-Normalisierung schadet

Normalisierung kann übertrieben werden, wenn Sie Daten in zu viele kleine Tabellen aufspalten, die für alltägliche Seiten ständig gejoint werden müssen. Die Datenbank liefert möglicherweise weiterhin korrekte Ergebnisse, aber gängige Lesevorgänge werden langsamer und komplexer, weil jede Anfrage viele Joins benötigt.

Ein typisches frühes Symptom: Eine „einfache“ Seite (z. B. eine Bestellhistorie) erfordert 6–10 Joins, und die Performance hängt stark von Traffic und Cache-Wärme ab.

Praktischer Ansatz: Kernfakten normalisieren, heiße Reads denormalisieren

Ein sinnvolles Gleichgewicht ist:

- Kernfakten und Ownership normalisieren (Quelle der Wahrheit). Behalten Sie Produktattribute in

products, Kategorienamen incategoriesund Beziehungen über Fremdschlüssel. - Für die heißesten Reads gezielt denormalisieren—aber nur, wenn Sie den Nutzen erklären und wie die Konsistenz erhalten bleibt.

Denormalisierung bedeutet, bewusst ein kleines Stück Daten zu duplizieren, um eine häufige Abfrage günstiger zu machen (weniger Joins, schnellere Listen). Das Schlüsselwort ist vorsichtig: Jedes duplizierte Feld braucht einen Plan zur Aktualisierung.

Beispiel: Produkte, Kategorien und Bestellpositionen

Ein normalisiertes Setup könnte so aussehen:

products(id, name, price, category_id)categories(id, name)orders(id, customer_id, created_at)order_items(id, order_id, product_id, quantity, unit_price_at_purchase)

Beachten Sie den subtilen Gewinn: order_items speichert unit_price_at_purchase (eine Form der Denormalisierung), weil Sie historische Genauigkeit brauchen, selbst wenn sich der Produktpreis später ändert. Diese Duplikation ist absichtlich und stabil.

Wenn Ihr häufigster Screen „Bestellungen mit Artikelzusammenfassungen“ ist, könnten Sie product_name in order_items denormalisieren, um das Joinen mit products bei jeder Liste zu vermeiden—aber nur, wenn Sie bereit sind, es synchron zu halten (oder zu akzeptieren, dass es ein Snapshot zum Kaufzeitpunkt ist).

Index-Strategie folgt dem Schema, nicht umgekehrt

Indizes werden oft als magischer „Speed-Knopf“ behandelt, funktionieren aber nur gut, wenn die zugrundeliegende Tabellenstruktur Sinn macht. Wenn Sie Spalten noch umbenennen, Tabellen aufteilen oder ändern, wie Datensätze zueinander stehen, wird Ihre Index-Liste ebenfalls im Fluss sein. Indizes funktionieren am besten, wenn Spalten (und die Art, wie die App nach ihnen filtert/sortiert) stabil genug sind, dass Sie sie nicht jede Woche neu bauen müssen.

Beginnen Sie mit den Fragen, die Ihre App am meisten stellt

Sie müssen nicht perfekt vorhersagen, aber Sie brauchen eine kurze Liste der wichtigsten Abfragen:

- „Finde einen Benutzer per E-Mail.“

- „Zeige die letzten Bestellungen eines Kunden.“

- „Liste Rechnungen nach Status, neueste zuerst.“

Diese Aussagen übersetzen sich direkt in die Spalten, die einen Index verdienen. Wenn Sie diese nicht laut aussprechen können, ist es meist ein Problem der Schema-Klarheit—nicht der Indizierung.

Composite-Indizes, einfach erklärt

Ein Composite-Index deckt mehr als eine Spalte ab. Die Reihenfolge der Spalten ist wichtig, weil die Datenbank den Index effizient von links nach rechts verwenden kann.

Beispiel: Wenn Sie häufig nach customer_id filtern und dann nach created_at sortieren, ist ein Index auf (customer_id, created_at) meist nützlich. Die umgekehrte Reihenfolge (created_at, customer_id) hilft der gleichen Abfrage oft nicht so sehr.

Indexieren Sie nicht alles

Jeder zusätzliche Index hat Kosten:

- Langsamere Writes: Inserts/Updates müssen auch jeden Index aktualisieren.

- Mehr Speicher: Indizes können einen großen Teil der DB-Größe ausmachen.

- Mehr Komplexität: Zusätzliche Indizes erschweren Wartung und Tuning.

Ein sauberes, konsistentes Schema reduziert die „richtigen“ Indizes auf eine kleine Menge, die echten Zugriffsmustern entspricht—ohne stetige Schreib- und Speicherkosten.

Schreib-Performance: Die versteckten Kosten eines unordentlichen Schemas

Erzeuge Indizes für reale Abfragen

Beschreibe deine viel genutzten Endpunkte und erhalte Index‑Ideen, die zu Filtern und Sortierungen passen.

Langsame Apps werden nicht immer durch Reads gebremst. Viele frühe Performance-Probleme treten bei Inserts und Updates auf—User-Signups, Checkout-Flows, Background-Jobs—weil ein unordentliches Schema jede Änderung extra Arbeit macht.

Warum Writes teuer werden

Einige Schema-Entscheidungen vervielfachen heimlich die Kosten jeder Änderung:

- Breite Reihen: Dutzende (oder hunderte) Spalten in einer Tabelle führen zu größeren Reihen, mehr I/O und mehr Cache-Churn—auch wenn die meisten Spalten selten genutzt werden.

- Zu viele Indizes: Indizes beschleunigen Reads, aber jeder Insert/Update muss auch jeden Index aktualisieren.

- Trigger und Cascades: Trigger können Arbeit hinter einem einfachen

INSERTverstecken. Cascading-FKs sind korrekt und hilfreich, fügen aber auch Schreibzeit-Aufwand hinzu, der mit verwandten Daten mitwächst.

Read-heavy vs write-heavy: Wählen Sie Ihren Schmerz bewusst

Wenn Ihre Workload read-heavy ist (Feeds, Suchseiten), können Sie mehr Indizes und selektive Denormalisierung in Kauf nehmen. Wenn sie write-heavy ist (Event-Ingestion, Telemetrie, viele Bestellungen), priorisieren Sie ein Schema, das Writes einfach und vorhersehbar hält, und fügen Sie Read-Optimierungen nur dort hinzu, wo nötig.

Häufige frühe Muster, die Writes schaden

- Audit-Logs: Gut für Compliance, aber vermeiden Sie riesige Snapshots bei jedem Update.

- Event-Tabellen: Append-only-Tabellen skalieren gut, können aber aufblähen, wenn Sie redundante Payloads speichern.

- Soft Deletes: Praktisch, erhöhen aber die Indexgröße und können Updates/Abfragen verlangsamen, wenn nicht sorgfältig geplant.

Halten Sie Writes einfach und bewahren Sie gleichzeitig Historie

Ein praktischer Ansatz:

- Speichern Sie den „aktuellen Zustand“ in einer Tabelle und Historie in einer separaten append-only Tabelle.

- Halten Sie Historie-Zeilen narrow (nur was wirklich nötig ist: wer/ wann/ was geändert wurde).

- Fügen Sie Indizes zur Historie basierend auf realen Zugriffsmustern hinzu (meist

entity_id,created_at). - Vermeiden Sie Trigger für Auditing zuerst; bevorzugen Sie explizite Applikationsschreibvorgänge, damit die Kosten sichtbar und testbar sind.

Saubere Schreibpfade verschaffen Ihnen Luft—und machen spätere Query-Optimierung deutlich einfacher.

Wie ORMs und APIs Schema-Entscheidungen verstärken

ORMs lassen Datenbankarbeit mühelos erscheinen: Modelle definieren, Methoden aufrufen, Daten tauchen auf. Der Haken ist, dass ein ORM auch teure SQL-Muster verbergen kann, bis es weh tut.

ORMs: Komfort, der langsame Muster verbergen kann

Zwei häufige Fallen:

- Ineffiziente Joins: Ein scheinbar einfaches

.include()oder ein verschachtelter Serializer kann zu breiten Joins, doppelten Zeilen oder großen Sorts führen—besonders, wenn Beziehungen nicht klar definiert sind. - N+1-Queries: Sie holen 50 Datensätze und das ORM führt stillschweigend 50 weitere Abfragen aus, um zugehörige Daten zu laden. In der Entwicklung funktioniert es oft, unter echtem Traffic bricht es zusammen.

Ein gut gestaltetes Schema reduziert die Wahrscheinlichkeit, dass diese Muster entstehen, und macht sie leichter erkennbar, wenn sie doch auftreten.

Klare Beziehungen machen ORM-Nutzung sicherer

Wenn Tabellen explizite Fremdschlüssel, Unique-Constraints und NOT NULL-Regeln haben, kann das ORM sicherere Abfragen erzeugen und Ihr Code kann sich auf konsistente Annahmen verlassen.

Beispiel: Die Durchsetzung, dass orders.user_id existieren muss (FK) und dass users.email eindeutig ist, verhindert ganze Klassen von Edge-Cases, die sonst zu Anwendungs-Checks und zusätzlicher Abfragearbeit führen.

APIs machen Schema-Entscheidungen zum Produktverhalten

Ihr API-Design ist downstream vom Schema:

- Stabile IDs (und konsistente Key-Typen) vereinfachen URLs, Caching und Client-State.

- Paginierung funktioniert am besten, wenn Sie nach einer indizierten, monotonen Spalte ordnen können (oft

created_at+id). - Filtern wird vorhersehbar, wenn Spalten echte Attribute repräsentieren (nicht überladene Strings oder JSON-Blobs) und Constraints die Werte sauber halten.

Machen Sie es zu einem Workflow, nicht zu einer Notfallmission

Behandeln Sie Schema-Entscheidungen als erstklassige Engineering-Aufgabe:

- Verwenden Sie Migrationen für jede Änderung, überprüft wie Code (/blog/migrations).

- Führen Sie leichte „Schema-Reviews“ für neue Endpunkte ein: welche Tabellen, welche Keys, welche Constraints, welche Abfrageform.

- Loggen Sie in Staging ORM-Abfragen und markieren Sie N+1-Muster, bevor es in Produktion geht (/blog/orm-performance-checks).

Wenn Sie schnell mit einem chat-gesteuerten Entwicklungsworkflow bauen (z. B. eine React-App plus Go/PostgreSQL-Backend in Koder.ai generieren), hilft es, „Schema-Review“ früh in die Konversation zu bringen. Sie können schnell iterieren, aber Constraints, Keys und ein Migrationsplan sollten bewusst gesetzt sein—vor allem bevor Traffic kommt.

Frühe Warnsignale, dass das Schema der Flaschenhals ist

Manche Performance-Probleme sind weniger „schlechte SQL“ als vielmehr die Datenbank, die gegen die Form Ihrer Daten ankämpft. Wenn Sie dieselben Probleme über viele Endpunkte und Reports hinweg sehen, ist das oft ein Schema-Signal, kein Anlass für reines Query-Tuning.

Häufige Symptome

Langsame Filter sind klassisch. Wenn einfache Bedingungen wie „find orders by customer“ oder „filter by created date“ konstant träge sind, liegt die Ursache möglicherweise an fehlenden Beziehungen, nicht passenden Typen oder Spalten, die sich nicht effektiv indizieren lassen.

Ein weiteres Warnzeichen sind explodierende Join-Anzahlen: Eine Abfrage, die 2–3 Tabellen verbinden sollte, fädelt sich in 6–10 Tabellen, um eine einfache Frage zu beantworten (oft wegen über-normalisierter Lookups, polymorpher Muster oder „alles in einer Tabelle“-Designs).

Achten Sie auch auf inkonsistente Werte in Spalten, die wie Enums funktionieren sollten—insbesondere Status-Felder („active“, „ACTIVE“, „enabled“, „on“). Inkonsistenz zwingt defensive Abfragen (LOWER(), COALESCE(), OR-Ketten), die unabhängig von Tuning langsam bleiben.

Schema-Checkliste (schnell zu überprüfen)

- Fehlende Indizes auf Fremdschlüsseln (Joins werden bei wachsendem Tabellenumfang zu Full Scans).

- Falsche Datentypen (z. B. IDs als Strings, Daten als Text, Geld als Float).

- EAV-Tabellen (Entity–Attribute–Value) für Kerndaten: Anfangs flexibel, aber Filter/Sorts verwandeln sich in viele Joins und schwer zu indizierende Prädikate.

Einfache, tool-unabhängige Diagnosen

Starten Sie mit Reality-Checks: Zeilenanzahl pro Tabelle und Kardinalität von Schlüsselspalten (wie viele unterschiedliche Werte). Wenn eine „status“-Spalte 4 erwartete Werte haben sollte, Sie aber 40 finden, leckt das Schema bereits Komplexität aus.

Schauen Sie dann in Query-Pläne für Ihre langsamen Endpunkte. Wenn Sie wiederholt Seqential Scans auf Join-Spalten oder große Zwischenresultate sehen, sind Schema und Indizierung wahrscheinlich die Ursache.

Aktivieren und prüfen Sie schließlich Slow-Query-Logs. Wenn viele verschiedene Abfragen auf ähnliche Weise langsam sind (gleiche Tabellen, gleiche Prädikate), ist das meist ein strukturelles Problem, das auf Modellebene gelöst werden sollte.

Schema sicher weiterentwickeln, während Sie wachsen

Entwirf dein Schema im Chat

Verwandle Entitäten, Schlüssel und Constraints in ein PostgreSQL‑Schema, während du baust.

Frühe Schema-Entscheidungen überleben selten die erste Konfrontation mit echten Nutzern. Das Ziel ist nicht Perfektion—es ist, es zu ändern, ohne Produktion zu zerstören, Daten zu verlieren oder das Team eine Woche lang einzufrieren.

Ein leichtgewichtiger, wiederholbarer Änderungsprozess

Ein praktischer Workflow, der von Ein-Personen-Apps bis zu größeren Teams skaliert:

- Modellieren: Beschreiben Sie die neue Form (Tabellen/Spalten, Beziehungen und was Quelle der Wahrheit wird). Fügen Sie Beispiel-Datensätze und Edge-Cases hinzu.

- Migrieren: Fügen Sie neue Strukturen auf abwärtskompatible Weise hinzu (zuerst neue Spalten/Tabellen; vermeiden Sie sofortiges Entfernen oder Umbenennen).

- Backfill: Befüllen Sie neue Felder aus bestehenden Daten in Batches. Verfolgen Sie den Fortschritt, damit Sie fortsetzen können.

- Validieren: Fügen Sie Constraints erst hinzu, nachdem die Daten sauber sind (z. B. NOT NULL, Fremdschlüssel). Führen Sie Checks aus, die alte und neue Outputs vergleichen.

Feature-Flags und Dual-Writes (sparsam einsetzen)

Die meisten Schema-Änderungen benötigen keine komplexen Rollout-Muster. Bevorzugen Sie „expand-and-contract“: Schreiben Sie Code, der sowohl alt als auch neu lesen kann, und schalten Sie erst die Schreibseite um, wenn Sie sicher sind.

Verwenden Sie Feature-Flags oder Dual-Writes nur bei wirklich notwendiger schrittweiser Umstellung (hoher Traffic, lange Backfills oder mehrere Services). Wenn Sie dual schreiben, fügen Sie Monitoring hinzu, um Drift zu erkennen, und definieren Sie, welche Seite bei Konflikten gewinnt.

Rollbacks und Migrationstests, die die Realität abbilden

Sichere Rollbacks beginnen mit reversiblen Migrationen. Üben Sie den „Undo“-Pfad: Eine neue Spalte zu droppen ist einfach; überschriebenen Daten wiederherzustellen nicht.

Testen Sie Migrationen auf realistischen Datenmengen. Eine Migration, die auf einem Laptop 2 Sekunden dauert, kann in Produktion Tabellen für Minuten sperren. Nutzen Sie produktsimilar Row-Counts und Indizes und messen Sie die Laufzeit.

Hier helfen Plattform-Tools: Zuverlässige Deployments plus Snapshots/Rollback (und die Möglichkeit, Code zu exportieren) machen es sicherer, Schema und App-Logik gemeinsam zu iterieren. Wenn Sie Koder.ai benutzen, nutzen Sie Snapshots und Planungsmodus, bevor Sie Migrationen einführen, die sorgfältige Sequenzierung erfordern.

Dokumentieren Sie Entscheidungen für die nächste Person (inklusive Ihres zukünftigen Ichs)

Führen Sie ein kurzes Schema-Log: Was hat sich geändert, warum und welche Kompromisse wurden eingegangen. Verlinken Sie es in /docs oder im Repo-README. Fügen Sie Notizen hinzu wie „diese Spalte ist bewusst denormalisiert“ oder „Fremdschlüssel nach Backfill am 2025-01-10 hinzugefügt“, damit künftige Änderungen alte Fehler nicht wiederholen.

Wann Abfragen optimieren (und eine sinnvolle Reihenfolge der Schritte)

Query-Optimierung ist wichtig—aber sie zahlt sich am meisten aus, wenn Ihr Schema nicht gegen Sie arbeitet. Wenn Tabellen fehlende klare Keys haben, Beziehungen inkonsistent sind oder „one row per thing“ verletzt ist, können Sie Stunden in das Tuning von Abfragen stecken, die nächste Woche ohnehin umgeschrieben werden.

Eine praktische Prioritäten-Reihenfolge

-

Beheben Sie Schema-Blocker zuerst. Starten Sie mit allem, was korrektes Abfragen erschwert: fehlende Primärschlüssel, inkonsistente Fremdschlüssel, Spalten, die mehrere Bedeutungen mischen, duplizierte Quellen der Wahrheit oder Typen, die nicht zur Realität passen (z. B. Daten als Strings).

-

Stabilisieren Sie die Zugriffsmuster. Wenn das Datenmodell widerspiegelt, wie die App sich verhält (und wahrscheinlich in den nächsten Sprints verhält), wird Query-Tuning dauerhaft.

-

Optimieren Sie die Top-Abfragen—nicht alle Abfragen. Nutzen Sie Logs/APM, um die langsamsten und häufigsten Abfragen zu identifizieren. Ein Endpunkt, der 10.000-mal am Tag getroffen wird, bringt mehr als ein seltener Admin-Report.

Das 80/20 der frühen Query-Optimierung

Die meisten frühen Gewinne kommen von einer kleinen Menge Maßnahmen:

- Fügen Sie den richtigen Index für Ihre häufigsten Filter und Joins hinzu (und verifizieren Sie, dass er tatsächlich verwendet wird).

- Liefern Sie weniger Spalten zurück (vermeiden Sie

SELECT *, besonders bei breiten Tabellen). - Vermeiden Sie unnötige Joins—manchmal existiert ein Join nur, weil das Schema Sie zwingt, grundlegende Attribute „zu entdecken“.

Erwartungsmanagement: Es ist laufend, aber die Grundlagen stehen zuerst

Performance-Arbeit endet nie, aber das Ziel ist Vorhersagbarkeit. Mit einem sauberen Schema fügt jedes neue Feature inkrementelle Last hinzu; mit einem unordentlichen Schema fügt jedes Feature compound Verwirrung hinzu.

Checkliste für diese Woche

- Listen Sie die Top 5 langsamsten und Top 5 häufigsten Abfragen auf.

- Prüfen Sie für jede: Primärschlüssel vorhanden, Joins sind key-to-key, und Typen sind korrekt.

- Fügen Sie einen Index hinzu, der dem dominanten Filter/Sort entspricht.

- Ersetzen Sie

SELECT *in einem heißen Pfad. - Messen Sie neu und halten Sie eine einfache „Before/After“-Notiz für den nächsten Sprint.