Was „Secure by Default“ praktisch bedeutet

„Secure by default“ bedeutet, dass ein System im sichersten zumutbaren Zustand startet, ohne dass man sich durch Menüs kämpfen, lange Checklisten lesen oder schon wissen muss, was schiefgehen kann. Die Erstinstallation sollte exponierte Dienste minimieren, Berechtigungen einschränken und automatisch sicherere Optionen wählen. Man kann Dinge weiterhin öffnen — aber bewusst und mit offenen Augen.

Sichere Defaults sind eine Entscheidung, kein Häkchen

Ein Default ist der Weg, den die meisten Menschen gehen. Damit ist er eine Sicherheitskontrolle: Er prägt reale Ergebnisse stärker als jede optionale Härtungsanleitung. Wenn die Standardkonfiguration heimlich zusätzliche Netzwerkdienste aktiviert, großzügigen Dateizugriff gestattet oder riskante Features einschaltet, übernehmen viele Deployments dieses Risiko für lange Zeit.

OpenBSD wird in Sicherheitsdiskussionen häufig genannt, weil das Projekt diese Idee über Jahrzehnte als zentrales Entwicklungsziel behandelte: konservative Defaults liefern, Angriffsfläche reduzieren und riskantes Verhalten opt‑in machen. Dieser Fokus beeinflusste, wie viele Ingenieure über Betriebssysteme, Netzwerkdienste und Anwendungsdesign nachdenken.

Was Sie in diesem Artikel erwarten können

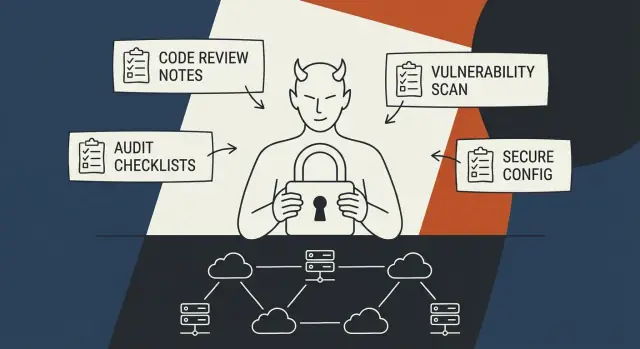

Wir sehen uns Praktiken an, die die „secure by default“‑Denkweise stützten, darunter:

- Defaults, die Exposition reduzieren (weniger hörende Dienste, engere Berechtigungen).

- Eine Auditing‑Kultur („lies den Code“ als Alltagsgewohnheit, nicht nur Slogan).

- Exploit‑Mitigations, die die Kosten für gängige Angriffe erhöhen.

- Prozess und Kultur — Standards, Reviews und manchmal scharfe Kanten, die Qualität erzwingen.

Prinzipien statt Persönlichkeiten

Theo de Raadts Rolle ist historisch bedeutsam, aber es geht hier nicht um Heroenverehrung. Nützlicher ist die Frage, wie ein Projekt Sicherheit von einer Nachgedanken‑Aufgabe in eine Reihe wiederholbarer Entscheidungen verwandelt: Entscheidungen, die sich in Defaults, Code‑Review‑Gewohnheiten und der Bereitschaft, "Nein" zu sagen, wenn Bequemlichkeit unnötiges Risiko schafft, zeigen.

Theo de Raadt und die Entstehung von OpenBSD

Theo de Raadt ist ein kanadischer Entwickler, bekannt für seinen langjährigen Fokus auf sorgfältige System‑Ingenieursarbeit innerhalb der BSD‑Familie. Vor OpenBSD war er eine zentrale Figur in frühen BSD‑on‑PC‑Bemühungen und gehörte in den frühen 1990ern zu den Mitbegründern von NetBSD. Das ist wichtig: Die BSDs waren keine „Apps“, sondern Betriebssysteme, die als vertrauenswürdige Fundamente gedacht waren.

Warum OpenBSD entstand

OpenBSD begann 1995, nachdem de Raadt das NetBSD‑Projekt verlassen hatte. Das neue Projekt hatte nicht das Ziel, Neuheiten zu jagen oder ein „BSD mit allem“ zu bauen. Es entstand, um ein System zu schaffen, in dem Korrektheit und Sicherheit explizite Prioritäten sind — selbst wenn das hieß, manchmal aus Bequemlichkeit „Nein“ zu sagen.

Von Anfang an steckte OpenBSD Energie in Dinge, die viele Projekte als unglamourös betrachten:

- Code auf unsichere Muster und subtile Bugs prüfen

- Defaults verschärfen, sodass eine frische Installation schwerer fehlkonfiguriert wird

- Features so entwerfen, dass sie über die Zeit gewartet und überprüft werden können

Andere Ziele als „Features zuerst"

Viele Betriebssysteme und Distributionen konkurrieren über Breite: mehr Treiber, mehr gebündelte Dienste, mehr Konfigurationsoptionen, schnellere Feature‑Lieferung. Das sind legitime Ziele und nützen Nutzern.

Die Entstehungsgeschichte von OpenBSD reflektiert eine andere Wette: dass ein kleineres, besser durchschaubares Basissystem — mit konservativen Defaults ausgeliefert — die Wahrscheinlichkeit sicherheitskritischer Fehler verringern kann.

Das macht andere Ansätze nicht „falsch“. Es bedeutet nur, dass sich Trade‑offs in Alltagsentscheidungen zeigen: ob ein Dienst standardmäßig aktiviert wird, ob man ein komplexes Subsystem akzeptiert oder ob ein Interface so umgestaltet wird, dass es schwerer falsch zu benutzen ist.

Sicherheitsziele vs. Sicherheitsresultate

OpenBSDs Gründungsideal war ein Sicherheitsziel: Sicherheit als Designbeschränkung behandeln, nicht als Nachsatz. Ziele sind jedoch nicht dasselbe wie Resultate. Reale Sicherheit misst sich über Jahre — durch gefundene Schwachstellen, wie schnell sie behoben werden, wie klar die Kommunikation ist und wie gut ein Projekt aus Fehlern lernt.

Die Kultur von OpenBSD wuchs aus dieser Prämisse: Software kann versagen, also entwerfe Defaults und Prozesse so, dass sie seltener versagen.

Defaults als Sicherheitskontrolle (nicht nur als Einstellung)

OpenBSD behandelt die „Standardinstallation“ als ein Sicherheitsversprechen: Ein frisches System sollte vernünftig sicher sein, bevor man eine Härtungsanleitung gelesen, eine Firewallregel hinzugefügt oder in obskuren Konfigdateien gesucht hat. Das ist kein Komfort — das ist eine Sicherheitskontrolle.

Bleiben die meisten Maschinen in der Praxis nahe an ihren Defaults (wie oft der Fall), dann sind die Defaults der Ort, an dem Risiko verhindert oder heimlich vervielfacht wird.

Ein secure‑by‑default‑Ansatz geht davon aus, dass neue Administratoren Fehler machen, beschäftigt sind oder veraltete Ratschläge befolgen. Das System zielt daher auf eine vertretbare Ausgangsbasis: minimale Exposition, vorhersehbares Verhalten und Konfigurationen, die nicht überraschen.

Wenn du etwas änderst, solltest du es bewusst tun — weil du einen Dienst brauchst — nicht weil das Basissystem ihn „hilfreich“ aktiviert hat.

Konservative Features, minimale Dienste

Eine praktische Ausprägung dieser Denkweise ist die vorsichtige Auswahl von Features und eine Neigung zu weniger netzwerkexponierten Diensten per Default. Jeder hörende Daemon ist ein neuer Platz für Bugs, Fehlkonfigurationen und vergessene Anmeldedaten.

OpenBSDs Defaults zielen darauf ab, die anfängliche Angriffsfläche klein zu halten, sodass der erste Sicherheitsgewinn daraus entsteht, nicht das laufen zu lassen, was man nicht angefragt hat.

Diese Konservativität reduziert auch die Anzahl der „Fuß‑Kanonen“ — mächtige Features, die leicht falsch genutzt werden können, wenn man lernt.

Dokumentation als Teil der Kontrolle

Defaults helfen nur, wenn Menschen sie verstehen und pflegen können. OpenBSDs Kultur betont klare Dokumentation und übersichtliche Konfigurationsdateien, damit Administratoren grundlegende Fragen schnell beantworten können:

- Was läuft?

- Warum läuft es?

- Wo ist es konfiguriert?

- Wie ändert man es am sichersten?

Diese Klarheit ist wichtig, weil Sicherheitsfehler oft operativ sind: ein unbeabsichtigt aktivierter Dienst, eine kopierte Konfiguration mit unsicheren Optionen oder die Annahme, „jemand anders hat es bereits gehärtet“. OpenBSD versucht, den sicheren Pfad einfach und offensichtlich zu machen — ab dem ersten Boot.

Auditing‑Kultur: „Read the code“ und systematische Reviews

OpenBSDs Sicherheitsruf beruht nicht nur auf cleveren Mitigations oder strikten Defaults — sondern auch auf einer Gewohnheit: Sicherheit verbessert sich, wenn Leute den Code wiederholt und bewusst lesen und hinterfragen.

„Read the code“ ist weniger ein Slogan als ein Workflow: das ausgelieferte Material reviewen, es weiter reviewen und Unklarheiten als Bug behandeln.

Wie Auditing jenseits von Korrekturlesen aussieht

Systematische Reviews sind mehr als bloßes Durchlesen auf offensichtliche Fehler. Sie beinhalten typischerweise:

- Threat‑Modeling in Klartext: Welche Eingaben kann ein Angreifer kontrollieren? Was passiert, wenn er die schlimmstmöglichen Daten zur schlimmstmöglichen Zeit schickt?

- API‑ und Interface‑Review: Sind Funktionen leicht falsch zu nutzen? Scheitern sie sicher? Sind Defaults konservativ?

- Bereinigung und Vereinfachung: Entfernen toten Codes, Grenzen verschärfen, implizites Verhalten reduzieren und Kontrollfluss leichter verständlich machen.

Ein zentrales Ziel von Audits ist oft, ganze Bug‑Klassen zu verhindern, nicht nur ein gemeldetes Problem zu beheben.

Hochwertige Ziele: wo Bugs sich verstecken

Audits konzentrieren sich auf Komponenten, die ungeprüfte Eingaben parsen oder risikoreiche Operationen handhaben. Typische Ziele sind:

- Parser und Dateiformate (alles, was komplexe, angreiferkontrollierte Daten liest)

- Kryptografie und Schlüsselverwaltung (insbesondere Fehlerpfade und Randfälle)

- Netzwerk‑Dämonen (Authentifizierung, Sitzungsmanagement, Protokoll‑Zustandsmaschinen)

Diese Bereiche kombinieren oft Komplexität mit Exposition — genau dort gedeihen subtile Verwundbarkeiten.

Tradeoffs und Grenzen

Kontinuierliches Code‑Review kostet Zeit und erfordert konzentrierte Expertise. Es kann Funktionsarbeit verlangsamen und ist keine Garantie: Reviewer übersehen Dinge, und neuer Code kann alte Fehler wieder einführen.

OpenBSDs Lektion ist praktisch statt magisch: Diszipliniertes Auditing reduziert Risiko deutlich, wenn es als andauernde Ingenieursarbeit behandelt wird, nicht als einmaliger "Security‑Pass".

Least Privilege und Privilegientrennung als Design‑Defaults

Sicherheit bedeutet nicht nur, Schutzmaßnahmen hinzuzufügen, nachdem etwas schiefgeht. OpenBSD förderte eine andere Haltung: gehe davon aus, dass Software Bugs haben wird, und entwerfe das System so, dass Bugs nur begrenzte Macht haben.

Least Privilege (einfach erläutert)

„Least Privilege“ heißt: Ein Programm (oder Nutzer) bekommt nur die Rechte, die es für seine Aufgabe braucht — und keine zusätzlichen. Wenn ein Webserver nur seine Konfiguration lesen und Dateien aus einem Verzeichnis ausliefern muss, sollte er nicht zusätzlich Berechtigung haben, alle Home‑Ordner zu lesen, Systemeinstellungen zu ändern oder Rohgeräte zuzugreifen.

Das ist wichtig, weil im Fall eines Fehlers (oder einer Ausnutzung) der Schaden durch die Rechte begrenzt wird, die die kompromittierte Komponente hat.

Privilegientrennung: nicht die Schlüssel an die Eingangstür geben

Netzwerkexponierte Programme bekommen ständig untrusted Input: Webanfragen, SSH‑Loginversuche, manipulierte Pakete.

Privilege Separation teilt ein Programm in kleinere Teile:

- Ein minimaler, eng kontrollierter „privilegierter“ Helfer, der sensible Aktionen ausführen kann.

- Ein oder mehrere unprivilegierte Prozesse, die riskantes Parsing und Netzwerk‑Handling übernehmen.

Selbst wenn ein Angreifer einen Fehler im internet‑sichtbaren Teil findet, erlangt er nicht automatisch Systemkontrolle — er landet in einem Prozess mit wenigen Rechten und weniger Eskalationswegen.

Sandboxing und Prozessisolation als Eindämmung

OpenBSD unterstützte diese Trennung durch zusätzliche Isolationstools (z. B. chroot‑Jails und andere OS‑Einschränkungen). Stell dir vor, ein riskanter Prozess arbeitet in einem verschlossenen Raum: Er kann seine enge Aufgabe erfüllen, darf sich aber nicht durchs ganze System bewegen.

Vorher/Nachher‑Modell

Vorher: ein großer Daemon läuft mit weitreichenden Rechten → kompromittiere ein Teil, kompromittiere das ganze System.

Nachher: kleine, getrennte Komponenten mit minimalen Rechten → kompromittiere ein Teil, erhalte nur eine begrenzte Eindringtiefe und stoße auf Barrieren.

Exploit‑Mitigations, die Erwartungen veränderten

Riskante Änderungen zurücksetzen

Nutze Snapshots und Rollbacks, um schnell wiederherzustellen, wenn eine Änderung versehentlich die Angriffsfläche vergrößert.

Viele reale Kompromisse begannen mit einer einfachen Fehlerklasse: Speicher‑Sicherheitsfehler. Buffer‑Overflows, Use‑After‑Free und ähnliche Fehler können einem Angreifer erlauben, Steuerdaten zu überschreiben und beliebigen Code auszuführen.

OpenBSD betrachtete diese Realität als praktisches Ingenieursproblem: Gehe davon aus, dass Bugs durchrutschen, und entwerfe das System so, dass ihre Ausnutzbarkeit schwieriger, lauter und unzuverlässiger ist.

Die Kosten der Ausnutzung erhöhen

OpenBSD half, Mitigations zu normalisieren, die viele heute als selbstverständlich erachten:

- W^X (Write XOR Execute): Speicherseiten sollten entweder schreibbar oder ausführbar sein, nicht beides. Das erschwert klassische "Shellcode einspeisen und dahin springen"‑Angriffe.

- ASLR (Address Space Layout Randomization): Randomisierung der Speicherorte von Code und Daten macht das Vorhersagen von Adressen für Return‑Oriented Programming schwerer.

- Stack‑Schutzmechanismen: Compiler‑ und Laufzeitverteidigungen (wie Stack‑Canaries) versuchen, Stack‑Smashing zu erkennen oder zu verhindern, bevor die Kontrolle über den Ablauf übernommen wird.

Diese Mechanismen sind keine magischen Schilde. Sie sind Tempolimits — oft sehr wirksame — die Angreifer dazu zwingen, mehr Schritte zu verketten, bessere Info‑Leaks zu benötigen oder mit geringerer Zuverlässigkeit zu arbeiten.

Defence in Depth, kein Freibrief

Die tiefere Lehre ist Defense‑in‑Depth: Mitigations kaufen Zeit, reduzieren Blast‑Radius und verwandeln manche Verwundbarkeit in einen Crash statt in eine Übernahme. Das ist operational wichtig, weil es das Fenster zwischen Entdeckung und Patchen verkleinern und verhindern kann, dass ein einzelner Fehler zum Totalausfall führt.

Aber Mitigations ersetzen nicht das Beheben von Schwachstellen. OpenBSDs Philosophie koppelte Exploit‑Resistenz mit unnachgiebigem Bug‑Fixing und Review: Ausnutzbarkeit heute erschweren und die grundlegenden Fehler morgen weiter eliminieren.

Kryptografie, Zufälligkeit und sichere Interfaces

OpenBSDs Sicherheitsruf baut nicht auf „mehr Crypto überall“. Er baut auf Korrektheit zuerst: weniger Überraschungen, klarere APIs und Verhalten, das man unter Druck nachvollziehen kann.

Diese Denkweise beeinflusst, wie Kryptografie integriert wird, wie Zufall generiert wird und wie Schnittstellen so gestaltet werden, dass unsichere Entscheidungen schwerer aus Versehen getroffen werden.

Korrektheit und klare APIs schlagen Cleverness

Ein wiederkehrendes OpenBSD‑Thema ist, dass Sicherheitsfehler oft als gewöhnliche Bugs beginnen: Parser‑Randfälle, mehrdeutige Flags, stilles Abschneiden oder „hilfreiche“ Defaults, die Fehler verdecken.

Das Projekt bevorzugt tendenziell kleinere, auditierbare Schnittstellen mit expliziten Fehlermodi, selbst wenn das bedeutet, langbestehendes Verhalten zu entfernen oder neu zu gestalten.

Klare APIs reduzieren auch "Konfigurationsfußkanonen". Wenn eine sichere Option ein Labyrinth von Schaltern erfordert, werden viele Deployments unsicher bleiben, trotz guter Absichten.

Konservative Kryptografie‑Entscheidungen

OpenBSDs Umgang mit Kryptografie ist konservativ: bewährte Primitive verwenden, sie sorgfältig integrieren und Legacy‑Verhalten vermeiden, das nur aus Abwärtskompatibilität existiert.

Das zeigt sich in Defaults, die starke Algorithmen bevorzugen, und in der Bereitschaft, ältere, schwächere Optionen eher zu deprecaten als beizubehalten. Ziel ist nicht, jede Cipher‑Option anzubieten, sondern den sicheren Pfad zur Normalität zu machen.

Zufälligkeit, Parsing und versteckte Komplexität

Viele reale Probleme lassen sich auf schwache Zufallswerte, unsicheres Parsing oder versteckte Komplexität in Konfigurationsschichten zurückführen.

Schwache Zufälligkeit kann selbst starke Kryptografie untergraben, daher behandeln secure‑by‑default‑Systeme Entropie und Zufallsschnittstellen als kritische Infrastruktur, nicht als Nachgedanken.

Unsicheres Parsing (von Schlüsseln, Zertifikaten, Konfigdateien oder Netzwerkinput) ist ein wiederkehrender Fehler; vorhersehbare Formate, strikte Validierung und sicheres String‑Handling reduzieren die Angriffsfläche.

Zuletzt ist "versteckte" Konfigurationskomplexität selbst ein Risiko: wenn Sicherheit von subtilen Reihenfolgeregeln oder undokumentierten Interaktionen abhängt, sind Fehler unvermeidlich. OpenBSD bevorzugt daher Interface‑Vereinfachung und Defaults, die nicht stillschweigend unsichere Legacy‑Verhalten übernehmen.

OpenSSH und die Verbreitung der OpenBSD‑Sicherheitsdenkweise

Fürs Teilen belohnt werden

Verdiene Credits, indem du Inhalte über Koder.ai erstellst oder andere zur Plattform einlädst.

OpenSSH ist eines der klarsten Beispiele dafür, wie sich OpenBSDs Sicherheitsphilosophie aus dem Projekt löste und anderswo zum Standard wurde.

Als SSH zum Standard für die entfernte Administration von Unix und Linux wurde, war die Frage nicht mehr „Soll man Remote‑Logins verschlüsseln?“ — sondern „Welche Implementation kann man vertrauensvoll überall betreiben?"

Vom SSH‑Fork zur Sicherheitsgrundlage

OpenSSH entstand, als die ursprüngliche freie SSH‑Implementation (SSH 1.x) Lizenzänderungen erfuhr und die Community eine permissiv verfügbare, aktiv gepflegte Alternative brauchte.

OpenBSD lieferte nicht nur Ersatz; es lieferte eine Version, die von seiner Kultur geprägt war: konservative Änderungen, klare Codebasis und eine Neigung zu sicherem Verhalten, ohne dass jeder Administrator ein Experte sein muss.

Das war breit wirksam, weil SSH in vielen Umgebungen auf dem sensibelsten Pfad liegt: privilegierter Zugang, Fleet‑Automatisierung und Notfallwiederherstellung. Eine Schwäche in SSH ist nicht „noch ein Bug“ — sie kann zu einem universellen Schlüssel werden.

Sichere Defaults ermöglichen sichere Remote‑Administration

OpenBSD betrachtete Remote‑Administration als workflow mit hohem Risiko.

OpenSSHs Konfiguration und unterstützte Features drängten Administratoren zu besseren Mustern: starke Kryptografie, vernünftige Authentifizierungsoptionen und Leitplanken, die unbeabsichtigte Exposition verringern.

So sieht "secure by default" in der Praxis aus: die Anzahl der Fußkanonen für einen unter Druck stehenden Operator reduzieren. Wenn du um 2 Uhr morgens per SSH in eine Produktionsmaschine gehst, zählen Defaults mehr als Policy‑Dokumente.

Portabilität ist, wie sich Sicherheitsideen verbreiten

OpenSSH wurde portiert — zu Linux, *BSDs, macOS und kommerziellen Unices — sodass OpenBSDs Sicherheitsentscheidungen (APIs, Konfigkonventionen, Härtungshaltungen) mit dem Code wanderten.

Auch Organisationen, die nie OpenBSD direkt betrieben, übernahmen seine Remote‑Access‑Annahmen, weil OpenSSH zum gemeinsamen Nenner wurde.

Operative Resultate, die man spürt

Der größte Effekt war nicht theoretisch: er zeigte sich in der täglichen Admin‑Praxis. Teams standardisierten auf verschlüsselte Remote‑Verwaltung, verbesserten schlüsselbasierte Workflows und erhielten ein gut geprüftes Werkzeug, das sie fast überall einsetzen konnten.

Mit der Zeit hob das die Messlatte dafür, was „normale“ sichere Administration bedeutet — und machte unsicheren Remote‑Zugang schwerer zu rechtfertigen.

Release‑Engineering, Patching und Vertrauen

„Secure by default" ist nicht nur ein Designziel — es ist ein Versprechen, das man jedes Mal einhält, wenn man etwas ausliefert.

OpenBSDs Ruf ruht stark auf diszipliniertem Release‑Engineering: vorhersehbare Releases, sorgfältige Changes und eine Neigung zu Klarheit statt Cleverness.

Defaults können am ersten Tag sicher sein, aber Nutzer erleben Sicherheit über Monate und Jahre hinweg durch Updates, Advisories und wie sicher sie Fixes anwenden können.

Patch‑Rhythmus und klare Advisories

Vertrauen wächst, wenn Updates regelmäßig sind und Kommunikation konkret. Ein gutes Sicherheitsadvisory beantwortet vier Fragen ohne Dramatik: Was ist betroffen? Was ist die Auswirkung? Wie behebe ich das? Wie kann ich es verifizieren?

OpenBSD‑artige Kommunikation vermeidet vage Schweregrade und konzentriert sich auf handlungsfähige Details — Versionsbereiche, Patch‑Referenzen und minimale Workarounds.

Verantwortungsvolle Disclosure‑Normen gehören auch dazu: Koordination mit Meldenden, klare Zeitpläne und Anerkennung von Forschern helfen, Fixes geordnet zu halten, ohne jede Schwachstelle zur Schlagzeile zu machen.

Release‑Engineering ist auch Risikomanagement. Je komplexer die Build‑ und Release‑Kette, desto mehr Gelegenheiten für Falschsignaturen, falsche Artefakte oder kompromittierte Abhängigkeiten.

Eine einfachere, gut verstandene Pipeline — reproduzierbare Builds, minimale bewegliche Teile, starke Signierungspraktiken und klare Herkunft — senkt die Wahrscheinlichkeit, das Falsche zu veröffentlichen.

Risiko ohne Hype kommunizieren

Vermeide Angst‑basierte Botschaften. Nutze klare Sprache, definiere, was "remote", "local" und "Privilege Escalation" bedeuten, und sei ehrlich über Unsicherheiten. Wenn du spekulieren musst, kennzeichne es.

Biete einen ruhigen "Mach das jetzt"‑Weg (Upgrade/Patch) und einen "Mach das als Nächstes"‑Weg (Konfigurationsreview, Monitoring). Wenn Release‑Prozesse, Patching und Kommunikation konsistent sind, lernen Nutzer, schnell zu aktualisieren — und dann bleibt "secure by default" ein dauerhaftes Vertrauen.

Kultur: Hohe Standards, Verantwortung und Reibung

OpenBSDs Sicherheitsruf ist nicht nur Ergebnis cleverer Mitigations — er entsteht auch durch Arbeitsweisen.

Das Projekt normalisierte die Idee, dass Sicherheit gemeinsame Verantwortung ist und dass "gut genug"‑Defaults (oder schlampige Patches) nicht akzeptabel sind, nur weil sie funktionieren.

Kulturelle Zutaten, die Sicherheit verankern

Einige Gewohnheiten zeigen sich wiederholt in sicheren Engineering‑Teams, und OpenBSD machte sie explizit:

- Hohe Standards als Basis: Code soll lesbar, konservativ und im besten Sinne langweilig sein.

- Schroffes Feedback und klare Verantwortung: Reviews konzentrieren sich auf Korrektheit und Risiko, nicht auf persönliche Präferenzen.

- Geteilte Verantwortung: Wenn etwas ausgeliefert wird, ist es „unser“ Problem — Reviewer und Maintainer sind Teil des Ergebnisses.

Wann starke Meinungen helfen — und wann sie schaden

Starke Meinungen können Sicherheit verbessern, indem sie graduellen Qualitätsverfall verhindern: riskante Abkürzungen werden früh hinterfragt, und vages Denken („das sollte okay sein") wird als Bug behandelt.

Gleichzeitig kann diese Intensität Beiträge hemmen, wenn sich Menschen unsicher fühlen, Fragen zu stellen oder Änderungen vorzuschlagen. Sicherheit profitiert von Überprüfung; Überprüfung braucht Beteiligung.

Review‑Gewohnheiten übernehmen, ohne den zwischenmenschlichen Stil zu kopieren

Du kannst die Mechanik einer fordernden Kultur übernehmen, ohne die Reibung 1:1 zu kopieren.

Praktische Rituale, die in den meisten Organisationen funktionieren:

- Pre‑Merge‑Gates: Mindestens eine unabhängige Review für sicherheitskritische Bereiche (Auth, Parsing, Crypto, Networking).

- Review‑Rotationen: Wöchentlich einen "Review‑Captain" zuweisen, um Queues zu bewegen und Wissen zu verbreiten.

- Leichtgewichtige Checklisten: Eine kurze, konsistente Liste (Input‑Validation, Fehlerbehandlung, Privilegienbegrenzung, Logging) an jeden PR anhängen.

- "Erkläre das Risiko"‑Kommentare: Reviewer fordern eine einseitige Zusammenfassung des Risikos, wenn Defaults oder Vertrauensgrenzen geändert werden.

Die Quintessenz: Sicherheit ist kein Feature, das man später anfügt. Es ist ein Standard, den man wiederholt, sichtbar und mit Prozessen durchsetzt, die die richtige Wahl zur einfachsten machen.

OpenBSD‑Lektionen auf moderne Systeme anwenden

Gezielt aus dem Chat entwickeln

Wandle deine Anforderungen im Chat in eine funktionierende Web-App um, ohne Sicherheitsentscheidungen zu überspringen.

OpenBSDs größter übertragbarer Gedanke ist kein konkretes Tool — es ist die Gewohnheit, Defaults als Teil deines Sicherheitsbildes zu behandeln.

Du kannst diese Denkweise überall anwenden, indem du "secure by default" in konkrete Entscheidungen übersetzt, die deine Organisation wiederholt trifft, nicht heldenhafte Aktionen nach einem Vorfall.

Prinzipien in umsetzbare Richtlinien verwandeln

Schreibe zwei kurze Richtlinien, die auditierbar und für Teams praktikabel sind:

- Secure‑Baseline‑Policy: Neue Dienste und Hosts müssen von einer genehmigten Basislinie starten (Ports geschlossen, Least Privilege, Logging an, Updates aktiviert). Ausnahmen brauchen explizite Verantwortlichkeit und ein Ablaufdatum.

- Change‑Policy für Exposition: Alles, was Exposition erhöht (öffnen eingehender Ports, öffentliche Buckets, weitere IAM‑Rechte), erfordert Review und wird als sicherheitsrelevante Änderung nachverfolgt.

So ersetzt du "denk daran zu härten" durch "es wird gehärtet ausgeliefert, es sei denn, jemand unterschreibt das Risiko".

Praktische "Secure Baseline"‑Checkliste

Als Ausgangspunkt für Endpoints und Services:

- Minimiere laufende Prozesse: Deaktiviere/entferne nicht benötigte Dienste, Agenten und Pakete. Wenn es nicht gebraucht wird, sollte es nicht hören.

- Default‑Deny Netzwerk: Host‑Firewall an; inbound nur für erforderliche Ports und Quellen erlauben.

- Least Privilege per Default: Service‑Accounts trennen; keine geteilten Admin‑User; keine langlebigen Access‑Keys.

- Privilegientrennung wo möglich: Komponenten als unterschiedliche Identitäten laufen lassen; mit systemd‑Sandboxing, Containern oder separaten Knoten isolieren.

- Sicheres Update‑Verhalten: Automatische Sicherheitsupdates, wo möglich; klare Wartungsfenster, wo nicht.

- Logging und Auditierbarkeit: Zentrale Logs, Zeit‑Sync und ein Minimum an Sicherheitsereignissen (Auth, Privilegienänderungen, Netzwerkpolicy‑Änderungen).

- Sichere Konfigurationsvorlagen: Versionskontrollierte Konfigurationen (IaC) mit Peer‑Review und Linting.

Metriken, die zeigen, ob Defaults besser werden

Wähle einige schwer zu manipulierende Zahlen:

- Exponierte Angriffsfläche: Anzahl öffentlich erreichbarer Dienste/Ports (Trend nach unten).

- Time‑to‑Patch: Medianzeit vom Release eines Security‑Updates bis zur Bereitstellung.

- Konfigurations‑Risiko‑Rate: Anzahl Befunde wie world‑writable Files, zu breite IAM‑Rollen, anonymer Storage‑Zugriff oder deaktiviertes TLS.

Anwendung außerhalb von OpenBSD: Linux, Cloud, Container

- Linux: Gehärtete Images standardisieren, Firewall‑Defaults (nftables/ufw) nutzen, Dienste nicht als Root laufen lassen und MAC‑Policies (SELinux/AppArmor) einsetzen, wo praktikabel.

- Cloud: Security Groups, IAM und Storage‑Policies als Code behandeln; private Netzwerke als Default; MFA und kurzlebige Credentials erzwingen.

- Container/Kubernetes: Als Non‑Root laufen lassen; Capabilities droppen; schreibgeschützte Root‑FS; Netzwerkpolicies einschränken; Basisimages minimal halten.

Der gemeinsame Nenner ist einfach: Mach die sichere Wahl zur einfachsten Wahl und mache riskante Entscheidungen sichtbar, reviewbar und reversibel.

Wie diese Denkweise in moderne "Vibe‑Coding"‑Workflows passt

Schnelle Build‑Zyklen können Sicherheit verbessern (weil Fixes schnell ausgerollt werden) oder Risiken unbeabsichtigt verstärken (weil unsichere Defaults schnell reproduziert werden). Wenn du LLM‑assistierte Workflows nutzt, behandle "secure by default" als Produktanforderung, nicht als Nachgedanken.

Beispiel: Beim Aufbau von Apps auf Koder.ai (einer Vibe‑Coding‑Plattform, die Web‑, Backend‑ und Mobile‑Apps aus Chat generiert) kannst du die OpenBSD‑Lehre anwenden, indem du deine Basis früh festlegst: Least‑Privilege‑Rollen, standardmäßig private Netzwerke und konservative Konfigurationsvorlagen. Koder.ais Planning‑Mode ist ein guter Ort, diese Disziplin früh zu erzwingen — definiere Bedrohungsgrenzen und Default‑Exposition, bevor die Implementierung beginnt.

Operativ helfen Features wie Snapshots und Rollbacks, "Defense in Depth" auf Deployment‑Ebene zu stärken: wenn eine Änderung versehentlich die Exposition erweitert (falsch konfigurierte Endpoint, zu offene Policy oder Debug‑Flag), kannst du schnell zurücksetzen und dann ein korrigiertes Default ausliefern. Und weil Koder.ai den Source‑Code‑Export unterstützt, kannst du die gleichen "Read the code"‑Auditing‑Gewohnheiten verwenden — behandle generierten Code wie jeden Produktionscode: reviewen, testen und härten.

Häufige Missverständnisse und ein ausgewogenes Fazit

"Secure by default" wird oft wiederholt, aber leicht missverstanden, was OpenBSD (und Theo de Raadts breitere Philosophie) tatsächlich demonstrierte.

Missverständnis #1: „Secure by default“ heißt unknackbar

Das tut es nicht. Kein allgemeines Betriebssystem kann "nicht gehackt werden" garantieren. Die reale Aussage ist praktischer: Eine frische Installation sollte aus einer defensiven Haltung starten — weniger riskante Dienste exponiert, sicherere Defaults und Features, die bei einem Fehler den Blast‑Radius begrenzen.

Diese Denkweise verlagert Arbeit früher im Lebenszyklus. Statt Nutzer zu bitten, unsichere Einstellungen zu finden und zu beheben, versucht das System, die sichere Wahl zur einfachsten zu machen.

Missverständnis #2: Sicherheit ist "kostenlos" und darf UX nie beeinträchtigen

Sicherheitsdefaults können etwas kosten: Bequemlichkeit, Kompatibilität oder Performance. Legacy‑Features zu deaktivieren, Berechtigungen zu verschärfen oder sicherere Kryptografie zu erzwingen, kann jemanden frustrieren, der das alte Verhalten braucht.

OpenBSDs Ansatz sagt implizit, dass etwas Reibung akzeptabel ist, wenn sie stillschweigende, weite Exposition verhindert. Der Trade‑off ist nicht "Sicherheit vs. Usability", sondern "wer trägt die Last": alle Nutzer per Default oder die Minderheit, die wirklich die unsicherere Option braucht.

Missverständnis #3: Einstellungen kopieren reicht und ergibt die gleichen Ergebnisse

Cargo‑Cult‑Security — Konfig‑Snippets ohne Verständnis für Threat‑Modelle, Deploy‑Kontext und operative Einschränkungen zu übernehmen — erzeugt oft fragile Systeme. Ein Härtungsflag, das auf einer Plattform hilft, kann Updates, Monitoring oder Recovery an anderer Stelle brechen.

Die tiefere Lehre ist die Methode: sorgfältige Defaults, kontinuierliche Review und die Bereitschaft, riskantes Verhalten zu entfernen, selbst wenn es populär ist.

Ein ausgewogenes Fazit

OpenBSDs Einfluss ist real: moderne Härtung, Auditing‑Gewohnheiten und Erwartungen an "sicherer von Haus aus" verdanken ihm viel.

Sein größter Beitrag ist vielleicht kultureller Natur — Sicherheit als Ingenieurdisziplin mit Standards, Wartung und Verantwortung zu behandeln, nicht als eine Liste von Schaltern, die man umlegt.