Was „Distributed SQL“ bedeutet (ohne Hype)

„Distributed SQL" ist eine Datenbank, die sich wie eine klassische relationale Datenbank anfühlt—Tabellen, Zeilen, Joins, Transaktionen und SQL—aber so gebaut ist, dass sie als Cluster über viele Maschinen (und oft über Regionen) läuft und sich trotzdem wie eine logische Datenbank verhält.

Diese Kombination ist wichtig, weil sie versucht, drei Dinge gleichzeitig zu liefern:

- SQL und relationale Modellierung: vertraute Schemas, Constraints und Query-Tools.

- Horizontales Skalieren: Knoten hinzufügen, um Kapazität zu erhöhen, statt „ein größeres Servergerät zu kaufen".

- Starke Konsistenz: Reads und Writes folgen klaren Transaktionsregeln, auch wenn Daten verteilt sind.

Zwischen klassischem RDBMS und NoSQL

Ein klassisches RDBMS (z. B. PostgreSQL oder MySQL) ist in der Regel am einfachsten zu betreiben, wenn alles auf einem Primary-Knoten liegt. Man kann Reads mit Replikaten skalieren, aber Writes und das Überleben regionaler Ausfälle erfordern normalerweise zusätzliche Architektur (Sharding, manuelles Failover, sorgfältige Anwendungslogik).

Viele NoSQL-Systeme gingen den umgekehrten Weg: zuerst Skalierung und Verfügbarkeit, manchmal auf Kosten der Konsistenz oder mit vereinfachten Abfragemodellen.

Distributed SQL sucht den Mittelweg: den relationalen Modell und ACID-Transaktionen beibehalten, aber Daten automatisch verteilen, um Wachstum und Ausfälle zu handhaben.

Was es zu lösen versucht

Verteilte SQL-Datenbanken sind für Probleme gebaut wie:

- Globale Anwendungen mit Nutzern in mehreren Regionen, bei denen Latenz und Verfügbarkeit wichtig sind.

- Hohe Verfügbarkeit, ohne komplexe manuelle Failover-Prozeduren.

- Wachstum über die Zeit, wenn man Kapazität schrittweise erweitern und eine einzige Datenbankoberfläche behalten möchte.

Deshalb werden Produkte wie Google Spanner, CockroachDB und YugabyteDB oft für Multi-Region-Bereitstellungen und Always-On-Services evaluiert.

Erwartungen setzen (es ist nicht der Default)

Distributed SQL ist nicht automatisch „besser“. Du nimmst mehr bewegliche Teile und andere Performance-Realitäten an (Netzwerk-Hops, Konsens, regionsübergreifende Latenz) im Tausch gegen Resilienz und Skalierbarkeit.

Wenn deine Workload auf eine einzelne gut verwaltete Datenbank mit einer einfachen Replikationskonfiguration passt, kann ein konventionelles RDBMS einfacher und billiger sein. Distributed SQL zahlt sich aus, wenn die Alternative benutzerdefiniertes Sharding, komplexes Failover oder Geschäftsanforderungen ist, die Multi-Region-Konsistenz und hohe Verfügbarkeit verlangen.

Wie Distributed SQL unter der Haube funktioniert

Distributed SQL soll sich wie eine vertraute SQL-Datenbank anfühlen, während es Daten über mehrere Maschinen (und oft Regionen) verteilt speichert. Die Herausforderung ist, viele Computer so zu koordinieren, dass sie sich wie ein verlässliches System verhalten.

Replikation + Konsens: wie Knoten sich einigen

Jedes Datenstück wird typischerweise auf mehreren Knoten kopiert (Replikation). Fällt ein Knoten aus, kann eine andere Kopie weiterhin Reads bedienen und Writes akzeptieren.

Um zu verhindern, dass Repliken auseinanderdriften, nutzen Distributed SQL-Systeme Konsens-Protokolle—meistens Raft (CockroachDB, YugabyteDB) oder Paxos (Spanner). Auf hoher Ebene bedeutet Konsens:

- Eine Replik agiert als „Leader“ für eine Gruppe von Repliken.

- Writes gehen an den Leader.

- Der Leader bestätigt den Write erst, nachdem die Mehrheit der Repliken ihn anerkannt hat.

Diese „Mehrheitsabstimmung" verleiht dir starke Konsistenz: sobald eine Transaktion committed ist, sehen andere Clients keine ältere Version der Daten mehr.

Sharding/Partitionierung: wo Daten leben

Keine Maschine kann alles halten, daher werden Tabellen in kleinere Stücke aufgeteilt, sogenannte Shards/Partitionen (Spanner nennt sie splits; CockroachDB nennt sie ranges; YugabyteDB nennt sie tablets).

Jede Partition wird (per Konsens) repliziert und auf bestimmten Knoten platziert. Die Platzierung ist nicht zufällig: du kannst sie durch Richtlinien beeinflussen (z. B. EU-Kundendaten in EU-Regionen halten oder heiße Partitionen auf schnelleren Knoten platzieren). Gute Platzierung reduziert netzwerkbedingte Trips und macht die Performance vorhersehbarer.

Transaktionen über Knoten hinweg (und warum das Latenz hinzufügt)

Bei einer Einzelknoten-Datenbank kann eine Transaktion oft lokal abgeschlossen werden. In Distributed SQL kann eine Transaktion mehrere Partitionen berühren—möglicherweise auf verschiedenen Knoten.

Sicheres Committen erfordert in der Regel zusätzliche Koordination:

- Sperren oder Validieren der beteiligten Partitionen

- Replizieren der Writes per Konsens (Mehrheitsbestätigungen)

- Finalisieren einer Commit-Entscheidung, sodass alle Teilnehmer einverstanden sind

Diese Schritte verursachen Netzwerk-Roundtrips, weshalb verteilte Transaktionen typischerweise Latenz hinzufügen—besonders wenn Daten Regionen überschreiten.

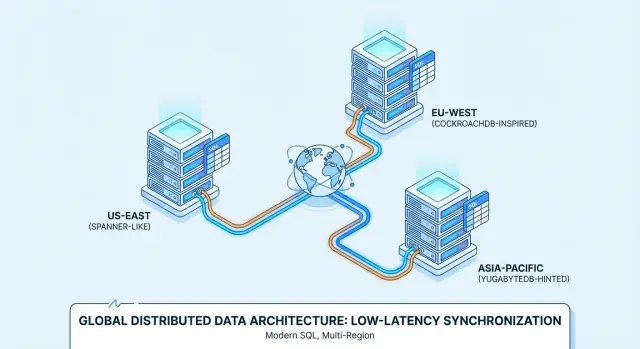

Multi-Region-Verhalten: lokalitätsbewusste Reads und Writes

Wenn Deployments Regionen überspannen, versuchen Systeme, Operationen „nah“ am Nutzer zu halten:

- Lokalitätsbewusste Reads können von nahen Repliken bedient werden, wenn das sicher ist.

- Lokalitätsbewusste Writes können zu Leadern in einer ausgewählten Region geleitet werden oder Leader in der Region der Hauptschreiber platzieren.

Das ist der Kern des Multi-Region-Abwägungsproblems: du kannst auf lokale Reaktionsfähigkeit optimieren, aber starke Konsistenz über große Entfernungen wird trotzdem Netzwerk-Kosten verursachen.

Wann du es wirklich brauchst (und wann nicht)

Bevor du zu Distributed SQL greifst, prüfe deine Basisanforderungen. Wenn du eine einzelne Primärregion, vorhersehbare Lasten und eine kleine Ops-Mannschaft hast, ist eine konventionelle relationale Datenbank (oder ein gemanagtes Postgres/MySQL) normalerweise der einfachste Weg, Features schnell auszuliefern. Mit Read-Replicas, Caching und sorgfältiger Schema-/Index-Arbeit lässt sich ein Single-Region-Setup oft weit dehnen.

Klare Auslöser: wann Distributed SQL sich lohnt

Distributed SQL ist ernsthaft zu erwägen, wenn einer oder mehrere der folgenden Punkte zutreffen:

- Du hast echte Nutzer in mehreren Regionen und möchtest die Datenbank nahe bei ihnen haben, ohne komplexes App-level-Sharding.

- Uptime-Anforderungen sind hoch (z. B. Überleben von Zonen-/Regionsausfällen) und eine einzelne Primärregion ist ein inakzeptables Risiko.

- Datenvolumen oder Schreibdurchsatz übersteigt vertikale Skalierung, und du willst horizontal skalieren bei Beibehaltung von SQL-Semantik.

- Du brauchst starke Konsistenz über Knoten/Regionen für Kerntransaktionen (Bestellungen, Salden, Reservierungen) ohne mehrere Systeme zu verknüpfen.

- Compliance erzwingt geografische Platzierung (Datenresidenz), aber du willst trotzdem eine logische Datenbank betreiben.

Anti-Auslöser: wann es meist nicht passt

Verteilte Systeme bringen Komplexität und Kosten. Sei vorsichtig, wenn:

- Dein Team klein ist und keine Zeit hat, neue Ausfallmodi und Betriebsabläufe zu lernen.

- Der Traffic niedrig oder sporadisch ist und du wahrscheinlich nicht bald aus einer Single-Region-Datenbank herauswächst.

- Du extrem enge Latenzbudgets für Single-Key-Writes hast und die Koordinations-Overheads der starken Konsistenz nicht tolerieren kannst.

- Deine Workload stark analytisch ist (große Scans, komplexe Reports). Dann ist es oft besser, OLTP und Analytics zu trennen.

Schnelle Entscheidungs-Checkliste

Wenn du zwei oder mehr Fragen mit „ja" beantworten kannst, lohnt sich eine Evaluierung von Distributed SQL:

- Brauchst du Multi-Region-Nutzer mit konsistenten Daten?

- Brauchst du automatisches Failover über Zonen/Regionen?

- Wird Skalierung zu einer wiederkehrenden Krise?

- Würde Sharding mehr Engineering-Aufwand erzeugen als die Datenbank selbst?

- Musst du Datenresidenz mit einem einheitlichen Betriebsmodell durchsetzen?

Konsistenz, Verfügbarkeit und Latenz: die Kerntradeoffs

Distributed SQL klingt oft nach „alles auf einmal bekommen“, aber reale Systeme zwingen zu Entscheidungen—insbesondere wenn Regionen nicht zuverlässig miteinander kommunizieren können.

CAP, erklärt für Produktentscheidungen

Denke an eine Netzwerktrennung als „die Verbindung zwischen Regionen ist unzuverlässig oder ausgefallen“. In diesem Moment kann eine Datenbank Priorität setzen auf:

- Konsistenz: alle sehen dieselbe, aktuelle Antwort (oder die Operation schlägt fehl).

- Verfügbarkeit: die App akzeptiert weiterhin Reads/Writes in jeder Region (auch wenn Antworten vorübergehend divergieren).

Distributed SQL-Systeme sind typischerweise darauf ausgelegt, Konsistenz für Transaktionen zu priorisieren. Das ist oft das, was Teams wollen—bis eine Partition bedeutet, dass bestimmte Operationen warten oder fehlschlagen müssen.

Starke Konsistenz (und warum Geld und Inventar wichtig sind)

Starke Konsistenz bedeutet: sobald eine Transaktion committed ist, liefert jeder folgende Read diesen committed Wert—kein „in einer Region hat es funktioniert, in einer anderen nicht". Das ist kritisch für:

- Zahlungen und Kontostände (verhindert Doppelbuchungen oder falsche Summen)

- Inventar/Reservierungen (verhindert Overselling des letzten Artikels)

Wenn dein Produktversprechen ist „wenn wir es bestätigen, ist es echt“, dann ist starke Konsistenz ein Feature, keine Luxusfunktion.

Read-your-writes und Isolation in realen Apps

Zwei praktische Verhaltensweisen sind wichtig:

- Read-your-writes: nachdem ein Nutzer sein Profil aktualisiert (oder eine Bestellung aufgegeben) hat, muss der nächste Bildschirm den neuen Zustand zeigen, nicht einen älteren Replika-Stand.

- Transaktionsisolation: definiert, wie konkurrierende Aktionen miteinander interagieren. Mit stärkerer Isolation vermeidest du subtile Fehler wie zwei Kunden, die denselben Sitz erfolgreich buchen.

Die Latenzkosten von regionsübergreifendem Konsens

Starke Konsistenz über Regionen erfordert gewöhnlich Konsens (mehrere Repliken müssen vor dem Commit zustimmen). Wenn Repliken Kontinente überspannen, wird die Lichtgeschwindigkeit zum Produktlimit: jeder regionsübergreifende Write kann Dutzende bis Hunderte Millisekunden hinzufügen.

Die Abwägung ist einfach: mehr geografische Sicherheit und Korrektheit bedeutet oft höhere Schreiblatenz, es sei denn, du wählst sorgfältig, wo Daten liegen und wo Transaktionen committen dürfen.

Spanner vs CockroachDB vs YugabyteDB: Ein praktischer Überblick

Google Spanner ist eine verteilte SQL-Datenbank, die primär als Managed Service auf Google Cloud angeboten wird. Sie ist für Multi-Region-Bereitstellungen konzipiert, wenn du eine einzige logische Datenbank mit über Knoten und Regionen replizierten Daten willst. Spanner unterstützt zwei SQL-Dialektoptionen—GoogleSQL (sein nativer Dialekt) und einen PostgreSQL-kompatiblen Dialekt—die Portabilität variiert je nach Wahl und genutzten Features.

CockroachDB ist eine verteilte SQL-Datenbank, die Teams vertraut erscheinen soll, die an PostgreSQL gewöhnt sind. Sie verwendet das PostgreSQL-Wire-Protocol und unterstützt einen großen Teil des PostgreSQL-ähnlichen SQL, ist jedoch kein Byte-für-Byte-Ersatz für Postgres (einige Extensions und Randfall-Verhalten unterscheiden sich). Du kannst sie als Managed Service (CockroachDB Cloud) oder selbst betreiben.

YugabyteDB ist eine verteilte Datenbank mit einer PostgreSQL-kompatiblen SQL-API (YSQL) und einer zusätzlichen Cassandra-kompatiblen API (YCQL). Wie CockroachDB wird sie oft von Teams evaluiert, die Postgres-ähnliche Entwicklungsergonomie wollen und gleichzeitig über Knoten und Regionen skalieren möchten. Verfügbar als Self-hosted oder Managed (YugabyteDB Managed), von Single-Region-HA bis hin zu Multi-Region-Setups.

Managed vs Self-hosted: was ändert sich

Managed-Services reduzieren typischerweise operativen Aufwand (Upgrades, Backups, Monitoring-Integrationen), während Self-hosting mehr Kontrolle über Networking, Instanztypen und physischen Datenstandort bietet. Spanner wird meist als Managed Service auf GCP genutzt; CockroachDB und YugabyteDB kommen oft sowohl Managed als auch Self-hosted vor, inklusive Multi-Cloud- und On-Prem-Optionen.

SQL-Kompatibilität in der Praxis

Alle drei sprechen „SQL“, aber die tägliche Kompatibilität hängt von der Dialektauswahl (Spanner), der Postgres-Feature-Abdeckung (CockroachDB/YugabyteDB) und davon ab, ob deine App auf spezifische Postgres-Extensions, Funktionen oder Transaktionssemantiken angewiesen ist.

Frühzeitiges Testen deiner Queries, Migrationen und ORM-Verhaltens zahlt sich aus—geh nicht davon aus, dass alles nahtlos austauschbar ist.

Anwendungsfall: Globales SaaS mit regionalen Nutzern

Theorie in Zahlen umsetzen

Wandle Artikelideen in eine messbare Benchmark‑App um, die du ausführen und optimieren kannst.

Ein klassischer Fit für Distributed SQL ist ein B2B-SaaS-Produkt mit Kunden in Nordamerika, Europa und APAC—z. B. Support-Tools, HR-Plattformen, Analytics-Dashboards oder Marktplätze.

Die geschäftliche Anforderung ist einfach: Nutzer wollen „lokale App“-Reaktionszeit, während das Unternehmen eine einzige logische Datenbank haben möchte, die immer verfügbar ist.

Datenresidenz und placement pro Mandant

Viele SaaS-Teams haben einen Mix aus Anforderungen:

- EU-Kunden erwarten, dass ihre Daten in der EU bleiben (GDPR, vertragliche Zusagen).

- Manche Kunden verlangen Speicherung im Land (z. B. Deutschland, Australien, Singapur).

- Andere kümmern sich nicht, wollen aber niedrige Latenz.

Distributed SQL kann das mit per-Tenant-Locality modellieren: Platziere die Primärdaten eines Tenants in einer bestimmten Region (oder einer Regionengruppe), während Schema und Abfragemodell für das gesamte System konsistent bleiben. So vermeidest du die Explosion zu „einer Datenbank pro Region“ und erfüllst trotzdem Residenzanforderungen.

Latenz minimieren: regionale Reads und Write-Platzierung

Um die App schnell zu halten, zielst du normalerweise auf:

- Regionale Reads: leseintensive Queries von Repliken nahe beim Nutzer bedienen.

- Write-Platzierung: setze den Write-Leader (oder die primäre Replikgruppe) in die Region, aus der die meisten Writes kommen.

Das ist wichtig, weil regionsübergreifende Roundtrips die wahrgenommene Latenz dominieren. Selbst bei starker Konsistenz sorgt gutes Locality-Design dafür, dass die meisten Anfragen nicht die interkontinentale Netzwerklatenz zahlen müssen.

Operative Realitäten

Die technischen Vorteile zählen nur, wenn der Betrieb handhabbar bleibt. Für globales SaaS plane für:

- Online-Schema-Änderungen, die Tabellen nicht regionsübergreifend blockieren.

- Tenant-Migrationen (einen Tenant mit minimaler Downtime in eine andere Region verschieben).

- Monitoring und Alerting für Replikations-Lags, Hotspots, langsame Queries und regionalen Incident-Status.

Richtig umgesetzt liefert Distributed SQL ein einheitliches Produkterlebnis, das dennoch lokal wirkt—ohne dein Engineering-Team in „den EU-Stack“ und „den APAC-Stack“ zu teilen.

Anwendungsfall: Finanz-Workflows und Ledger

Finanzsysteme sind Fälle, in denen „eventual consistency" echtes Geld kosten kann. Wenn ein Kunde eine Bestellung tätigt, eine Zahlung autorisiert wird und ein Saldo aktualisiert wird, müssen diese Schritte auf eine einzige Wahrheit kommen—sofort.

Starke Konsistenz ist wichtig, weil sie verhindert, dass zwei Regionen (oder zwei Services) jede für sich eine „vernünftige" Entscheidung treffen, die zusammen zu einem falschen Ledger führt.

Warum starke Konsistenz nicht verhandelbar ist

Im typischen Workflow—Bestellung anlegen → Mittel reservieren → Zahlung einziehen → Saldo/Ledger aktualisieren—willst du Garantien wie:

- Eine Bestellung kann nicht als „bezahlt" markiert werden, wenn die Zahlungseinziehung nicht erfolgreich war.

- Ein Saldo darf nicht negativ werden, weil zwei Transaktionen gegeneinander gerannt sind.

- Eine Rückerstattung darf nicht doppelt angewendet werden, weil zwei Worker denselben Job wiederholt haben.

Distributed SQL passt hier, weil es ACID-Transaktionen und Constraints über Knoten (und oft Regionen) hinweg bietet, sodass Ledger-Invarianten auch bei Ausfällen halten.

Idempotenz und „kein Doppelabbuchungs"-Muster

Zahlungsintegrationen sind retry-lastig: Timeouts, Webhook-Retries und Job-Reprocessing sind normal. Die Datenbank sollte helfen, Wiederholungen sicher zu machen.

Ein praktischer Ansatz kombiniert application-level idempotency keys mit datenbankseitig erzwingter Einzigartigkeit:

- Speichere einen

idempotency_key pro Kunde/Bezahlversuch.

- Füge eine Unique-Constraint auf

(account_id, idempotency_key) hinzu.

- Verpacke „Zahlungseintrag erstellen + Ledger-Einträge anwenden" in eine einzige Transaktion.

So wird ein zweiter Versuch zu einer harmlosen No-Op statt zu einer Doppelabbuchung.

Spitzenlasten handhaben, ohne Korrektheit zu opfern

Sales-Events und Payroll-Runs können plötzliche Schreibspitzen erzeugen (Authorizations, Captures, Transfers). Mit Distributed SQL kannst du durch Hinzufügen von Knoten die Schreibdurchsatzfähigkeit erhöhen und dabei dasselbe Konsistenzmodell beibehalten.

Wichtig ist, Hot-Keys zu planen (z. B. ein Händlerkonto mit aller Last) und Schema-Pattern zu verwenden, die Last verteilen.

Compliance, Audits und Aufbewahrung

Finanz-Workflows erfordern oft unveränderliche Audit-Trails, Nachvollziehbarkeit (wer/was/wann) und vorhersehbare Aufbewahrungsregeln. Selbst ohne spezifische Regulierung, rechne damit, dass du:

- append-only Ledger-Einträge brauchst,

- Zeitstempel und Zugriffskontrolle brauchst,

- Aufbewahrungs-/Archivierungsregeln brauchst, die Auditierbarkeit nicht untergraben.

Anwendungsfall: Inventar, Buchung und Reservierungen

Ohne Angst experimentieren

Teste riskante Schema‑Änderungen mit Snapshots und rolle zurück, wenn Tests fehlschlagen.

Inventar und Reservierungen wirken simpel, bis mehrere Regionen dasselbe knappe Gut bedienen: der letzte Konzertplatz, ein limitiertes Produkt oder ein Hotelzimmer für eine bestimmte Nacht.

Die Schwierigkeit ist nicht die Abfrage der Verfügbarkeit—sondern zu verhindern, dass zwei Personen fast gleichzeitig dasselbe Stück beanspruchen.

Wo Konflikte herkommen

In einem Multi-Region-Setup ohne starke Konsistenz kann jede Region kurzfristig glauben, dass Inventar verfügbar ist, basierend auf leicht veralteten Daten. Wenn zwei Nutzer in unterschiedlichen Regionen zur gleichen Zeit auschecken, können beide Transaktionen lokal akzeptiert werden und später bei der Reconciliation konfligieren.

So entsteht Oversell über Regionen hinweg: nicht weil das System „falsch" ist, sondern weil es für einen Moment divergente Wahrheiten zugelassen hat.

Distributed SQL wird oft gewählt, weil es ein einziges autoritatives Ergebnis für write-lastige Allokationen erzwingen kann—so wird „der letzte Platz" wirklich nur einmal vergeben, selbst wenn Anfragen aus verschiedenen Kontinenten kommen.

Konkrete Beispiele

- Sitzplatzbuchung: Zwei Nutzer klicken denselben Sitz. Mit starker Konsistenz committet nur eine Transaktion; die andere schlägt sofort fehl und die UI kann zum Aktualisieren auffordern.

- Limitierte Drops: 500 Artikel gehen live und Tausende versuchen Checkout. Du willst atomisches Decrement-and-Allocate, nicht erst Probeschritte mit späteren Rückerstattungen.

- Hotelreservierungen: Inventareinheit ist das room-night. Doppelbuchungen eines Datumsbereichs sind teuer und schwer rückgängig zu machen.

Muster, die gut mit Distributed SQL funktionieren

Hold + Confirm: Lege in einer Transaktion einen temporären Hold (Reservation) an, bestätige die Zahlung in einem zweiten Schritt.

Ablaufzeiten: Holds sollten automatisch verfallen (z. B. nach 10 Minuten), damit Inventar nicht blockiert wird, wenn ein Nutzer den Checkout abbricht.

Transactional Outbox: Wenn eine Reservierung bestätigt wird, schreibe eine „Event-to-Send"-Zeile in derselben Transaktion und liefere sie asynchron an E-Mail, Fulfillment oder Message-Bus—ohne ein „gebucht, aber keine Bestätigung gesendet"-Gap.

Die Quintessenz: Wenn dein Business sich keine Doppel-Allokation über Regionen hinweg leisten kann, werden starke Transaktionsgarantien zu einem Produktmerkmal, nicht zu einer rein technischen Nice-to-have-Funktion.

Anwendungsfall: Hohe Verfügbarkeit und Disaster Recovery

Hohe Verfügbarkeit (HA) ist ein guter Einsatzbereich für Distributed SQL, wenn Downtime teuer ist, unvorhergesehene Ausfälle inakzeptabel sind und du möchtest, dass Wartungsarbeiten unspektakulär ablaufen.

Das Ziel ist nicht „niemals ausfallen"—sondern klare SLOs zu erfüllen (z. B. 99,9% oder 99,99% Uptime), selbst wenn Knoten sterben, Zonen ausfallen oder du Upgrades durchführst.

„Always-on" in der Praxis: SLOs, Wartung, Ausfälle

Übersetze „always-on" in messbare Erwartungen: maximale monatliche Downtime, RTO und RPO.

Distributed SQL-Systeme können Reads/Writes durch viele häufige Ausfälle hindurch bedienen, aber nur wenn deine Topologie zu deinen SLOs passt und deine App transienten Fehlern (Retries, Idempotenz) robust begegnet.

Geplante Wartung ist ebenfalls wichtig. Rolling Upgrades und Instanzersetzungen sind einfacher, wenn die Datenbank Leadership/Replicas weg von betroffenen Knoten verlagern kann, ohne den gesamten Cluster offline zu nehmen.

Multi-Zone vs Multi-Region Redundanz

Multi-Zone-Deployments schützen vor einem AZ/Zone-Ausfall und vielen Hardwarefehlern, meist mit niedrigerer Latenz und Kosten. Sie sind oft ausreichend, wenn Compliance und Nutzerbasis hauptsächlich in einer Region sind.

Multi-Region-Deployments schützen vor einem kompletten Regional-Ausfall und unterstützen regionales Failover. Der Kompromiss ist höhere Schreiblatenz für stark konsistente Transaktionen, plus komplexere Kapazitätsplanung.

Failover-Erwartungen (und Game Days testen)

Gehe nicht davon aus, dass Failover instantan oder unsichtbar ist. Definiere, was „Failover" für deinen Service bedeutet: kurze Fehler-Spikes? read-only Perioden? ein paar Sekunden erhöhte Latenz?

Führe „Game Days" durch, um es zu beweisen:

- Kill einen Node, dann eine Zone; verifiziere SLO-Dashboards und Error-Budgets.

- Simuliere Netzwerkpartitionen und beobachte Leader/Replica-Verhalten.

- Probiere Region-Evakuierung und messe echtes RTO.

Replikation ist kein Backup

Selbst mit synchroner Replikation behalte Backups und übe Wiederherstellungen. Backups schützen vor Bedienerfehlern (schlechte Migrationsskripte, versehentliches Löschen), Anwendungsfehlern und Korruption, die sonst repliziert würde.

Validiere Point-in-Time-Recovery (wenn verfügbar), Wiederherstellungsgeschwindigkeit und die Fähigkeit, in eine saubere Umgebung zurückzusetzen, ohne Produktion zu berühren.

Anwendungsfall: Datenresidenz und Compliance-gesteuerte Architekturen

Datenresidenz-Anforderungen treten auf, wenn Gesetze, Verträge oder interne Regeln verlangen, dass bestimmte Datensätze innerhalb eines Landes oder einer Region gespeichert (und manchmal verarbeitet) werden.

Das kann für personenbezogene Daten, Gesundheitsinformationen, Zahlungsdaten, Regierungs-Workloads oder „kundeneigene" Datensätze gelten, bei denen der Vertrag vorgibt, wo Daten liegen dürfen.

Distributed SQL wird hier oft in Betracht gezogen, weil es eine einzige logische Datenbank ermöglichen kann, während die physische Platzierung von Daten in verschiedenen Regionen kontrolliert wird—ohne pro Geografie einen komplett separaten Application-Stack zu betreiben.

Warum Residenzregeln das Datenbankdesign ändern

Wenn ein Regulator oder Kunde verlangt, dass „Daten in der Region bleiben", reicht es nicht, nur niedrig-latente Repliken in der Nähe zu haben. Du musst vielleicht garantieren, dass:

- Die Primärkopie (oder alle Kopien) bestimmter Daten nur in zugelassenen Regionen gespeichert wird

- Backups und Snapshots denselben Regeln folgen

- Operatoren und Services außerhalb der Region keinen Zugriff auf Rohdaten haben

Das treibt Teams zu Architekturen, in denen Standort eine zentrale Designentscheidung ist, nicht ein nachträglicher Gedanke.

Pro-Kunden-Platzierung und Zugriffskontrollen (auf hohem Niveau)

Ein gängiges Muster im SaaS ist die per-Tenant-Datenplatzierung. Zum Beispiel: EU-Kunden-Daten sind an EU-Regionen gebunden, US-Kunden an US-Regionen.

Kombiniere typischerweise:

- Datenplatzierungsregeln (wo die Daten eines Tenants wohnen dürfen)

- Identity- und Access-Control (welche Dienste/Personen lesend darauf zugreifen können)

- Verschlüsselung und Key-Management (manchmal regiongebundene Schlüssel)

Ziel ist es, es schwer zu machen, aus Versehen Residenzregeln durch operativen Zugriff, Backup-Restore oder Replikation zu verletzen.

Rechtliche Anforderungen variieren—beziehe Rechtsberatung ein

Residenz- und Compliance-Pflichten unterscheiden sich stark je Land, Branche und Vertrag. Sie ändern sich auch über die Zeit.

Behandle Topologie als Teil deines Compliance-Programms und validiere Annahmen mit qualifizierter Rechtsberatung (und, wo relevant, mit Prüfern/Auditoren).

Wie Multi-Region-Topologie Reporting und Analytics beeinflusst

Residenzfreundliche Topologien können globale Business-Views verkomplizieren. Wenn Kundendaten absichtlich in getrennten Regionen bleiben, werden Analytics und Reporting oft:

- Regionale Reporting-Pipelines benötigen (Compute läuft dort, wo die Daten sind)

- Aggregierte Exporte verwenden (nur erlaubte Kennzahlen verlassen die Region)

- Höhere Latenz für regionsübergreifende Dashboards akzeptieren, weil globale Queries Regionen spannen oder auf replizierte/abgeleitete Datasets angewiesen sein müssen

Viele Teams trennen in der Praxis operationale Workloads (stark konsistent, residency-aware) von Analytics (regionale Warehouses oder streng geregelte aggregierte Datensätze), um Compliance handhabbar zu halten, ohne das tägliche Reporting zu verlangsamen.

Basis‑App ausliefern

Nutze Chat, um API und UI zu erstellen, und konzentriere dich auf Datenbank‑Abwägungen statt auf Boilerplate.

Distributed SQL kann dich vor schmerzhaften Ausfällen und regionalen Einschränkungen bewahren, aber es spart selten von vornherein Geld. Vorausplanung hilft, dafür zu sorgen, dass du nicht für unnötige "Versicherungen" zahlst.

Die Hauptkostentreiber

Die meisten Budgets teilen sich in vier Bereiche auf:

- Nodes (Compute): Du bezahlst dafür, mehrere Repliken online zu halten—oft 3+ pro Region—plus zusätzliche Kapazität für Failover. Multi-Region-Designs erfordern normalerweise mehr Headroom als Single-Region-Postgres.

- Storage: Replikation multipliziert die Datengröße. Ein 2 TB Dataset mit drei Repliken sind ~6 TB bevor Backups, Indexe und Overhead eingerechnet sind.

- Inter-Region-Traffic: Regionsübergreifende Replikation, Reads und Client-Traffic können eine relevante Kostenposition sein. Das ist oft die erste Überraschung, wenn man aktiv-aktiv fährt.

- Ops-Zeit: Selbst Managed-Angebote erfordern Arbeit: Schema- und Query-Tuning, Incident-Response, Kapazitätsplanung, Upgrade-Tests und Governance (insbesondere bei Residenz/Compliance).

Latenz-Einschätzung für reale Nutzer-Journeys

Distributed SQL-Systeme fügen Koordination hinzu—insbesondere für stark konsistente Writes, die ein Quorum brauchen.

Eine praktische Art, den Einfluss abzuschätzen:

- Wähle 2–3 Schlüssel-Journeys (Checkout, Booking, „Änderungen speichern").

- Zähle, wie viele Write-Transaktionen und Read-after-Write-Schritte im kritischen Pfad vorkommen.

- Für jeden Schritt, rechne mit einem regionsübergreifenden RTT, wo Koordination nötig ist. Wenn cross-region RTT 80–120 ms beträgt, können zwei sequentielle Schreibschritte 160–240 ms zur Gesamtzeit beitragen.

Das bedeutet nicht „mach es nicht", aber du solltest Journeys so gestalten, dass sequentielle Writes reduziert werden (Batching, idempotente Retries, weniger chatty Transactions).

Komplexität vs einfachere Alternativen

Wenn deine Nutzer größtenteils in einer Region sind, reicht oft ein Single-Region-Postgres mit Read-Replicas, guten Backups und getesteter Failover-Strategie—günstiger und einfacher.

Distributed SQL rechtfertigt die Mehrkosten, wenn du wirklich Multi-Region-Writes, strenge RPO/RTO oder residency-aware Platzierung brauchst.

Ein einfaches ROI-Rahmenwerk

Behandle die Ausgaben als Trade-off:

- Risikovermeidung: weniger umsatzrelevante Ausfälle, geringeres Datenverlust-Risiko, weniger globale Incident-Wochenenden.

- Umsatzschutz: höhere Conversion durch niedrigere Latenz für regionale Nutzer, bessere Enterprise-Position (SLA, Compliance).

- Ausgaben: Basiskosten für Cluster + Replikations-Overhead + Traffic + Engineering-Zeit.

Wenn der vermiedene Schaden (Downtime + Churn + Compliance-Risiko) größer ist als der laufende Aufpreis, ist das Multi-Region-Design gerechtfertigt. Wenn nicht, starte einfacher—und halte einen klaren Pfad zur Evolution offen.

Adoption-Checkliste und nächste Schritte

Distributed SQL einzuführen bedeutet weniger „Lift-and-Shift" einer Datenbank und mehr zu beweisen, dass deine spezifische Workload gut funktioniert, wenn Daten und Konsens über Knoten (und ggf. Regionen) verteilt sind. Ein leichter Plan hilft, Überraschungen zu vermeiden.

Ein fokussierter Proof-of-Concept (PoC)

Wähle eine Workload, die echten Schmerz repräsentiert: z. B. Checkout/Booking, Account-Provisioning oder Ledger-Posting.

Lege Erfolgskriterien vorher fest:

- Korrektheit: keine Doppelbuchungen, keine verlorenen Updates, vorhersehbares Transaktionsverhalten

- Latenz-SLOs: p50/p95 für die Top-3-Queries (inkl. cross-region-Zielen, falls relevant)

- Durchsatz: nachhaltige QPS bei Peaks + Sicherheitsmarge (oft 2–3×)

- Resilienz: Verhalten bei Node-Ausfall und (falls relevant) Region-Verlust

- Operativer Aufwand: Zeit zur Erkennung, Diagnose und Wiederherstellung eines simulierten Incidents

Wenn du beim PoC schneller vorankommen willst, baue eine kleine realistische App-Oberfläche (API + UI) statt nur synthetischer Benchmarks. Teams nutzen manchmal Tools wie Koder.ai, um einen leichtgewichtigen React + Go + PostgreSQL-Baseline-Stack via Chat zu erzeugen und dann die Datenbankschicht auf CockroachDB/YugabyteDB zu wechseln (oder sich mit Spanner zu verbinden), um Transaktionsmuster, Retries und Ausfallverhalten End-to-End zu testen. Der Punkt ist, den Loop von „Idee" zu „messbarer Workload" zu verkürzen.

Design-Checkliste (Probleme, die später beißen)

- Schema: Wähle Primary Keys, die Writes verteilen; vermeide sequentielle „heiße" Keys

- Indexes: Behalte nur nötige Indexe; verstehe die Write-Amplifikation durch sekundäre Indexe

- Partitionierung/Platzierung: Entscheide Partitionierungs-Keys (und Geo-/Zone-Platzierungsregeln) basierend auf Zugriffsprofilen

- Hotspots: Identifiziere „Celebrity Rows" (globale Counter, Single-Tenant-Tabellen) und redesign früh

- Migrations: Plane Online-Schema-Änderungen und Backfills; teste Rollback-Pfade

Operative Basics ab Tag Eins

Monitoring und Runbooks sind mindestens so wichtig wie SQL:

- Dashboards für Latenz, Retries, Contention, Replikations-/Konsens-Health, Disk und Compactions

- Incident-Runbooks: langsame Queries, Node-Restarts, fehlernde Repliken, ungleichmäßige Last

- Load-Tests, die Produktion nachbilden (Read/Write-Mix, Bursts, lange Transaktionen)

- Backups + Restore-Drills (inkl. Point-in-Time-Recovery wenn unterstützt)

Nächste Schritte

Starte mit einem PoC-Sprint, plane dann Zeit für ein Production-Readiness-Review und einen schrittweisen Cutover (Dual-Writes oder Shadow-Reads, wenn möglich).

Wenn du Hilfe beim Kostenscoping oder Tiers brauchst, siehe /pricing. Für praktische Walkthroughs und Migrationsmuster, durchsuche /blog.

Wenn du deine PoC-Ergebnisse, Architektur-Tradeoffs oder Migrations-Lessons dokumentierst, teile sie mit deinem Team (und ggf. öffentlich): Plattformen wie Koder.ai bieten oft Möglichkeiten, Credits für edukative Inhalte oder Empfehlungen zu verdienen, was Experimentierkosten ausgleichen kann, während du Optionen evaluierst.