Überblick: Warum OpenAIs Geschichte wichtig ist

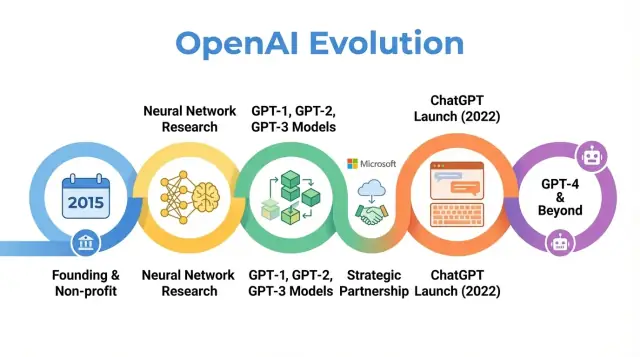

OpenAI ist ein KI‑Forschungs‑ und Bereitstellungsunternehmen, dessen Arbeit die Wahrnehmung künstlicher Intelligenz geprägt hat — von frühen Forschungsarbeiten bis zu Produkten wie ChatGPT. Zu verstehen, wie sich OpenAI entwickelt hat — von einem kleinen Nonprofit‑Labor 2015 zu einem zentralen Akteur in der KI‑Landschaft — erklärt, warum moderne KI heute so aussieht, wie sie aussieht.

OpenAIs Geschichte ist mehr als eine Abfolge von Modell‑Releases. Sie ist ein Fallbeispiel dafür, wie Mission, Anreize, technische Durchbrüche und öffentlicher Druck zusammenwirken. Die Organisation startete mit starkem Fokus auf offene Forschung und breiten Nutzen, restrukturierte sich, um Kapital anzuziehen, bildete eine enge Partnerschaft mit Microsoft und veröffentlichte Produkte, die Hunderten Millionen Menschen dienen.

Warum diese Geschichte wichtig ist

Die Nachverfolgung von OpenAIs Entwicklung beleuchtet mehrere breitere Trends in der KI:

-

Mission und Werte: OpenAI wurde mit dem erklärten Ziel gegründet, sicherzustellen, dass künstliche allgemeine Intelligenz allen Menschen zugutekommt. Wie diese Mission interpretiert und über die Zeit angepasst wurde, offenbart die Spannungen zwischen idealistischen Zielen und kommerziellen Zwängen.

-

Forschungsdurchbrüche: Der Weg von frühen Projekten zu Systemen wie GPT‑3, GPT‑4, DALL·E und Codex spiegelt einen breiteren Wandel hin zu groß angelegten Foundation‑Modellen wider, die viele aktuelle KI‑Anwendungen antreiben.

-

Governance und Struktur: Der Wechsel von einer reinen Nonprofit‑Organisation zu einer capped‑profit‑Einheit und die Schaffung komplexer Governance‑Mechanismen zeigen, wie neue Organisationsformen erprobt werden, um mächtige Technologien zu steuern.

-

Öffentliche Wirkung und Prüfung: Mit ChatGPT und weiteren Releases verlagerte sich OpenAI von einem hauptsächlich in KI‑Kreisen bekannten Forschungslabor zu einer Marke, die im öffentlichen Diskurs über Sicherheit, Alignment und Regulierung eine zentrale Rolle spielt.

Dieser Artikel begleitet OpenAIs Reise von 2015 bis zu den jüngsten Entwicklungen und zeigt, wie jede Phase breitere Verschiebungen in Forschung, Wirtschaft und Governance der KI widerspiegelt — und was das für die Zukunft des Feldes bedeuten könnte.

Gründung von OpenAI: Mission und frühes Team

Der KI‑Moment 2015

OpenAI wurde im Dezember 2015 gegründet, zu einer Zeit, in der maschinelles Lernen — insbesondere Deep Learning — rasch Fortschritte machte, aber noch weit von allgemeiner Intelligenz entfernt war. Bilderkennungs‑Benchmarks verbesserten sich, Sprachsysteme wurden besser, und Unternehmen wie Google, Facebook und Baidu investierten massiv in KI.

Unter Forschern und Technologieführern wuchs die Sorge, dass fortgeschrittene KI von einer Handvoll mächtiger Konzerne oder Staaten kontrolliert werden könnte. OpenAI entstand als Gegengewicht: eine Forschungsorganisation mit Fokus auf Langfrist‑Sicherheit und breite Verteilung der Vorteile von KI statt auf enges kommerzielles Interesse.

Mission: AGI zum Nutzen aller

Von Anfang an definierte OpenAI seine Mission in Bezug auf künstliche allgemeine Intelligenz (AGI), nicht nur als inkrementelle Fortschritte im Machine Learning. Die Kernformulierung lautete, dass OpenAI daran arbeiten würde, sicherzustellen, dass AGI, falls geschaffen, „der gesamten Menschheit zugutekommt.“

Diese Mission hatte mehrere konkrete Implikationen:

- Priorisierung von Sicherheitsforschung und langfristigen Alignment‑Fragen

- Verpflichtung, Forschung, Code und Erkenntnisse möglichst weitreichend zu teilen

- Vermeidung eines Winner‑take‑all‑Rennens durch Zusammenarbeit mit anderen Institutionen

Frühe Blogbeiträge und die Gründungscharta betonten sowohl Offenheit als auch Vorsicht: OpenAI würde viel veröffentlichen, aber auch die gesellschaftlichen Auswirkungen mächtiger Fähigkeiten abwägen.

Gründer, frühe Führung und Struktur

OpenAI begann als gemeinnütziges Forschungslabor. Die anfänglichen Finanzierungszusagen lagen bei rund 1 Milliarde US‑Dollar an zugesagten Mitteln, wobei es sich eher um langfristige Zusagen als um sofortige Einzahlungen handelte. Wichtige frühe Unterstützer waren Elon Musk, Sam Altman, Reid Hoffman, Peter Thiel, Jessica Livingston und YC Research sowie Unterstützung von Unternehmen wie Amazon Web Services und Infosys.

Das frühe Führungsteam vereinte Startup‑, Forschungs‑ und Betriebserfahrung:

- Sam Altman – Mitgründer und anfänglicher Vorsitzender des Vorstands (später CEO)

- Elon Musk – Mitgründer und früher Geldgeber, zunächst Vorstandsmitglied

- Greg Brockman – ehemaliger CTO von Stripe, kam als CTO und Mitgründer

- Ilya Sutskever – führender Deep‑Learning‑Forscher, kam als Chief Scientist

- Wojciech Zaremba und John Schulman – Mitgründer und wichtige Forschungsleiter

Diese Mischung aus Silicon‑Valley‑Unternehmertum und Spitzenforschung prägte OpenAIs frühe Kultur: hochgesteckte Ambitionen, die KI‑Grenzen zu verschieben, organisiert als missionsgetriebenes Nonprofit‑Labor mit Blick auf langfristige globale Wirkung statt kurzfristiger Kommerzialisierung.

Nonprofit‑Ära: Frühe Forschung und Open Science

Als OpenAI 2015 als Nonprofit‑Forschungslabor startete, war das öffentliche Versprechen einfach, aber ehrgeizig: Künstliche Intelligenz vorantreiben und so viel wie möglich mit der breiten Gemeinschaft teilen.

Standardmäßig offen

Die frühen Jahre waren geprägt von einer „open by default“‑Philosophie. Forschungsarbeiten wurden schnell veröffentlicht, Code meist freigegeben und interne Werkzeuge als öffentliche Projekte bereitgestellt. Die Idee war, dass beschleunigter wissenschaftlicher Fortschritt — und öffentliche Begutachtung — sicherer und nützlicher wäre als die Konzentration von Fähigkeiten in einem einzigen Unternehmen.

Gleichzeitig war Sicherheit bereits Teil der Debatte. Das Team erörterte, wann Offenheit Missbrauchsrisiken erhöhen könnte, und begann, Ideen für gestufte Veröffentlichungen und Policy‑Reviews zu skizzieren, auch wenn diese Konzepte damals noch informeller waren als spätere Governance‑Prozesse.

Leitende Forschungsbereiche

Die frühe wissenschaftliche Ausrichtung von OpenAI umfasste mehrere Kernbereiche:

- Reinforcement Learning (RL): Arbeiten an Agenten, die Spiele wie Dota 2 meistern und komplexe Steuerungsaufgaben lösen, trieben RL‑Algorithmen, Erkundungsmethoden und Skalierbarkeit voran.

- Robotik: Experimente mit Roboterhänden, die Manipulationsaufgaben lösen, zeigten, wie RL und Simulation in die physische Welt übertragen werden können.

- Unsupervised und self‑supervised Learning: Forschungen dazu, wie Modelle aus großen, unbeschrifteten Datensätzen lernen können, deuteten auf spätere Foundation‑Modelle hin.

Diese Projekte zielten weniger auf ausgereifte Produkte als darauf, auszuloten, was mit Deep Learning, Rechenressourcen und cleveren Trainingsregimen möglich ist.

Zwei der einflussreichsten Ergebnisse dieser Ära waren OpenAI Gym und Universe.

- OpenAI Gym bot eine gemeinsame Menge von RL‑Umgebungen und Benchmarks. Es standardisierte, wie Forscher Algorithmen verglichen, und senkte die Einstiegshürde für neue Labore und Studierende drastisch.

- Universe zielte darauf ab, Agenten in einer Vielzahl bestehender Software‑Umgebungen zu trainieren und zu bewerten, von Spielen bis zu Web‑Apps. Obwohl Universe schließlich eingestellt wurde, schärfte es das Interesse an allgemein einsetzbaren Agenten.

Beide Projekte spiegelten ein Engagement für geteilte Infrastruktur statt proprietären Vorteil wider.

Wahrnehmung durch Fachkollegen und Medien

In dieser Nonprofit‑Phase wurde OpenAI oft als missionsgetriebener Gegenpol zu den KI‑Labors großer Tech‑Konzerne dargestellt. Fachkollegen schätzten die Qualität der Forschung, die Verfügbarkeit von Code und Umgebungen sowie die Bereitschaft, sich an Sicherheitsdebatten zu beteiligen.

Die Berichterstattung hob die ungewöhnliche Kombination aus hochkarätigen Geldgebern, nicht‑kommerzieller Struktur und dem Versprechen, offen zu veröffentlichen, hervor. Dieser Ruf — als einflussreiches, offenes Forschungslabor mit Fokus auf langfristige Folgen — setzte Erwartungen, die spätere strategische Veränderungen stark beeinflussten.

Aufbau leistungsfähiger Modelle: Von GPT‑1 bis GPT‑3

Wendepunkt in OpenAIs Geschichte war die Entscheidung, sich auf große, transformerbasierte Sprachmodelle zu konzentrieren. Dieser Strategiewechsel verwandelte OpenAI vom primär forschungsorientierten Nonprofit in ein Unternehmen, das für Foundation‑Modelle bekannt ist, auf denen andere aufbauen.

GPT‑1 war nach heutigen Maßstäben bescheiden — 117 Millionen Parameter, trainiert auf dem BookCorpus — doch es lieferte einen entscheidenden Proof of Concept.

Statt separate Modelle für jede NLP‑Aufgabe zu trainieren, zeigte GPT‑1, dass ein einzelnes Transformer‑Modell mit einer einfachen Zielsetzung (Vorhersage des nächsten Wortes) mit minimaler Feinabstimmung auf Aufgaben wie Fragebeantwortung, Sentiment‑Analyse und Textual‑Entailment angepasst werden kann.

Für OpenAIs interne Roadmap bestätigte GPT‑1 drei Ideen:

- Skalierung ist entscheidend: Größere Modelle auf mehr Daten liefern überraschend allgemeine Verbesserungen.

- Pretraining + Fine‑Tuning kann aufgabenspezifische Systeme übertreffen.

- Transformer sind eine leistungsfähige Architektur für Sprache.

GPT‑2: Fähigkeiten und Missbrauchsbedenken (2019)

GPT‑2 verlängerte das gleiche Rezept erheblich: 1,5 Milliarden Parameter und ein viel größeres, aus dem Web abgeleitetes Datenset. Seine Ausgaben waren oft verblüffend kohärent — mehrabsätzige Artikel, fiktionale Geschichten und Zusammenfassungen, die auf den ersten Blick menschlich wirkten.

Diese Fähigkeiten weckten Bedenken wegen potenziellen Missbrauchs: automatisierte Propaganda, Spam, Belästigung und Fake News in großem Maßstab. Anstatt das vollständige Modell sofort zu veröffentlichen, verfolgte OpenAI eine gestufte Veröffentlichungsstrategie:

- Initiale Veröffentlichung eines kleineren Modells samt technischer Arbeit und Beispielen

- Fortgesetztes internes und externes Red‑Teaming zur Untersuchung von Missbrauchsszenarien

- Graduelle Freigabe größerer Versionen nach Risikobewertung

Dies war eines der ersten prominenten Beispiele dafür, dass OpenAI explizit Bereitstellungsentscheidungen an Sicherheits‑ und Gesellschaftsüberlegungen koppelte, und es prägte die spätere Haltung zu Offenlegung und Verantwortung.

GPT‑3: Skalierung, Generalität und die API (2020)

GPT‑3 skalierte erneut — dieses Mal auf 175 Milliarden Parameter. Statt sich hauptsächlich auf Fine‑Tuning pro Aufgabe zu stützen, zeigte GPT‑3 „few‑shot“ und sogar „zero‑shot“‑Fähigkeiten: Das Modell konnte oft eine neue Aufgabe allein aufgrund von Instruktionen und wenigen Beispielen im Prompt ausführen.

Diese Generalität veränderte, wie OpenAI und die Branche KI‑Systeme betrachteten. Statt vieler schmaler Modelle konnte ein großes Modell als allgemeine Engine dienen für:

- Werbetexte und Content‑Generierung

- Code‑Snippets und Autocomplete

- Fragebeantwortung, Chat und Suche

Wesentlich war die Entscheidung, GPT‑3 nicht Open‑Source zu stellen. Der Zugang erfolgte über eine kommerzielle API. Das markierte eine strategische Kehrtwende:

- Von der Veröffentlichung von Modellen zur Bereitstellung als gemanagten Dienst

- Vom reinen Forschungslabor zum Plattformanbieter mit zahlenden Kunden

- Von einmaligen Demos zur Schaffung eines Entwickler‑Ökosystems auf Basis von OpenAIs Modellen

GPT‑1 bis GPT‑3 zeichnen einen klaren Bogen in OpenAIs Geschichte: Skalierung von Transformern, Entdeckung emergenter Fähigkeiten, Auseinandersetzung mit Sicherheit und Missbrauch sowie Aufbau einer kommerziellen Grundlage, die spätere Produkte wie ChatGPT und die Weiterentwicklung zu GPT‑4 stützte.

Umstrukturierung der Organisation: OpenAI LP und das capped‑profit‑Modell

Schon 2018 waren OpenAIs Führungskräfte überzeugt, dass ein kleines, spendenfinanziertes Labor nicht ausreichen würde, um sehr große KI‑Systeme zu bauen und sicher zu steuern. Das Training von Frontier‑Modellen erforderte bereits Millionen an Dollar für Compute und Talent, mit klar steigenden Kosten. Um Top‑Forscher zu gewinnen, Experimente zu skalieren und langfristigen Zugang zu Cloud‑Infrastruktur zu sichern, brauchte OpenAI eine Struktur, die ernsthaftes Kapital anziehen konnte, ohne die ursprüngliche Mission aufzugeben.

Warum OpenAI LP geschaffen wurde

2019 gründete OpenAI OpenAI LP, eine neue „capped‑profit“ Kommanditgesellschaft. Ziel war es, große externe Investitionen zu ermöglichen und zugleich die Nonprofit‑Mission — dass AGI der gesamten Menschheit zugutekommt — an die Spitze der Entscheidungsfindung zu stellen.

Traditionelle Venture‑Startups sind letztlich den Aktionären verpflichtet, die unbeschränkte Renditen anstreben. OpenAIs Gründer befürchteten, dass dies Druck erzeugen würde, Profit vor Sicherheit, Offenheit oder vorsichtiger Bereitstellung zu priorisieren. Die LP‑Struktur war ein Kompromiss: Sie konnte equity‑ähnliche Interessen ausgeben und in großem Stil Kapital aufnehmen, jedoch unter anderen Regeln.

Funktionsweise des capped‑profit‑Modells

Im capped‑profit‑Modell können Investoren und Mitarbeitende Renditen auf ihre Anteile erzielen, jedoch nur bis zu einem festgelegten Vielfachen ihrer ursprünglichen Investition (für frühe Investoren oft mit Nennungen bis zu 100x, mit niedrigeren Caps in späteren Tranchen). Sobald diese Obergrenze erreicht ist, soll zusätzlicher Mehrwert an die gemeinnützige Mutter fließen, um gemäß ihrer Mission verwendet zu werden.

Das steht im starken Gegensatz zu typischen Startups, bei denen der Aktienwert theoretisch unbegrenzt wachsen kann und die Maximierung des Shareholder‑Value rechtlich und kulturell vorherrscht.

Beziehung zwischen Nonprofit und LP

Die Nonprofit‑Organisation behält die Kontrollbefugnis. Ihr Vorstand überwacht OpenAI LP und ist darauf ausgerichtet, die Interessen der Menschheit über die einzelner Investoren oder Mitarbeitender zu stellen.

Formal:

- Die Nonprofit‑Mutter hält die Kontrollmehrheit an OpenAI LP.

- Der Nonprofit‑Vorstand bestimmt Schlüsselpersonen der Führung und kann Entscheidungen, die der Mission widersprechen, prinzipiell überstimmen.

- Treuhänderische Pflichten orientieren sich an der Charta der Nonprofit‑Organisation, nicht an rein finanzieller Optimierung.

Dieses Governance‑Design soll OpenAI die Finanzierung und Einstellungsflexibilität eines kommerziellen Unternehmens geben und gleichzeitig missionelle Kontrolle sichern.

Debatten und Auswirkungen auf Finanzierung und Rekrutierung

Die Umstrukturierung löste innerhalb und außerhalb der Organisation Debatten aus. Befürworter argumentierten, es sei der einzige praktikable Weg, um die Milliarden zu sichern, die für Spitzenforschung nötig sind, und gleichzeitig Profitanreize zu begrenzen. Kritiker fragten, ob eine Struktur, die hohe Renditen ermöglicht, kommerziellen Druck wirklich effektiv abwehren könne und ob die Caps hoch genug oder klar durchsetzbar seien.

Praktisch öffnete OpenAI LP die Tür für große strategische Investitionen, am auffälligsten die von Microsoft, und erlaubte wettbewerbsfähige Vergütungspakete mit Upside‑Potential. Das wiederum ermöglichte es OpenAI, Forschungsteams zu vergrößern, Trainingsläufe für Modelle wie GPT‑3 und GPT‑4 zu erweitern und die Infrastruktur aufzubauen, um Systeme wie ChatGPT global zu betreiben — alles bei erhaltener formaler Governance‑Verknüpfung zu den Nonprofit‑Ursprüngen.

Strategische Partnerschaft mit Microsoft

Erstelle eine App per Chat

Mach aus einer in einfachen Worten beschriebenen Idee per Chat eine funktionierende App.

Die Investition 2019 und langfristige Vereinbarung

2019 kündigten OpenAI und Microsoft eine mehrjährige Partnerschaft an, die beide Unternehmen in der KI‑Landschaft neu ordnete. Microsoft investierte Berichten zufolge 1 Milliarde US‑Dollar, kombiniert aus Bargeld und Azure‑Cloud‑Guthaben, im Austausch dafür, bevorzugter kommerzieller Partner von OpenAI zu werden.

Der Deal entsprach OpenAIs Bedarf an enormen Rechenressourcen zum Trainieren immer größerer Modelle, während Microsoft Zugang zu Spitzentechnologie erhielt, um seine Produkte und die Cloud‑Plattform zu differenzieren. In den folgenden Jahren vertiefte sich die Beziehung durch zusätzliche Finanzierungen und technische Zusammenarbeit.

Azure als Cloud‑Rückgrat für OpenAI

OpenAI wählte Microsoft Azure als primäre Cloud‑Plattform aus mehreren Gründen:

- Skalierung und spezialisierte Hardware: Azure verpflichtete sich, spezialisierte Cluster mit Tausenden von GPUs (und später eigenen Beschleunigern) für groß angelegte Trainingsläufe bereitzustellen.

- Co‑Engineering: OpenAI‑Ingenieurinnen und ‑Ingenieure arbeiteten eng mit Azure‑Teams zusammen, um Netzwerk, Storage und Orchestrierung für große Sprachmodelle zu optimieren.

- Finanzielle Struktur: Investition und Cloud‑Guthaben senkten die Vorlaufkosten für Experimente, die anderswo prohibitiv teuer gewesen wären.

Das machte Azure zur Standardumgebung für Training und Serving von Modellen wie GPT‑3, Codex und später GPT‑4.

Gemeinsame Entwicklung von Supercomputing‑Infrastruktur

Die Partnerschaft führte zu einem der weltweit größten für KI ausgelegten Supercomputing‑Systeme, aufgebaut auf Azure für OpenAIs Workloads. Microsoft stellte diese Cluster als Aushängeschild für Azures KI‑Fähigkeiten dar, während OpenAI sie nutzte, um Modellgröße, Trainingsdaten und Experimentiergeschwindigkeit voranzutreiben.

Dieses gemeinsame Infrastrukturprojekt verwischte die Grenze zwischen „Kunde“ und „Partner“: OpenAI beeinflusste effektiv Azures KI‑Roadmap, und Azure wurde auf OpenAIs Bedürfnisse abgestimmt.

Lizenzen, Produkte und öffentliche Wahrnehmung

Microsoft erhielt exklusive Lizenzrechte an bestimmten OpenAI‑Technologien, namentlich GPT‑3. Dadurch konnte Microsoft OpenAI‑Modelle in seine Produkte einbetten — etwa in Bing, Office, GitHub Copilot und den Azure OpenAI Service — während andere Unternehmen Zugriff über OpenAIs eigene API erhielten.

Diese Exklusivität löste Debatten aus: Befürworter sahen darin die Finanzierung und Verbreitung, die nötig ist, um leistungsfähige KI sicher zu skalieren; Kritiker befürchteten eine Konzentration von Einfluss über Frontier‑Modelle bei einem großen Technologieunternehmen.

Gleichzeitig verschaffte die Partnerschaft OpenAI mainstream‑Sichtbarkeit. Microsofts Branding, Produktintegrationen und Vertriebskanäle trugen dazu bei, OpenAIs Systeme von Forschungsvorführungen zu Alltagswerkzeugen zu machen und prägten die öffentliche Wahrnehmung von OpenAI als unabhängiges Labor und zugleich wichtigen Microsoft‑Partner.

Durchbrüche jenseits von Text: DALL·E, CLIP und Codex

Mit der Verbesserung sprachbasierter Modelle ging OpenAI in neue Modalitäten über: Bilder und Code. Dieser Schritt erweiterte OpenAIs Einflussfelder von Schreiben und Dialog zu visueller Kreativität und Softwareentwicklung.

CLIP: Verbindung von Bild und Sprache

CLIP (Contrastive Language–Image Pretraining), vorgestellt Anfang 2021, war ein großer Schritt hin zu Modellen, die die Welt stärker wie Menschen verstehen.

Statt nur auf gelabelte Bilder zu trainieren, lernte CLIP aus Hunderten Millionen Bild‑Caption‑Paaren aus dem öffentlichen Web. Es wurde darauf trainiert, Bilder mit den wahrscheinlichsten Textbeschreibungen abzugleichen und von falschen Beschreibungen zu unterscheiden.

Das verlieh CLIP überraschend allgemeine Fähigkeiten:

- Erkennen von Objekten und Stilen ohne aufgabenspezifisches Training

- Befolgen von natürlichsprachlichen Prompts (z. B. „ein Foto einer getigerten Katze“) zur Klassifikation von Bildern

- Dienen als flexible visuelle Basis für andere Systeme

CLIP wurde zur Grundlage für spätere generative Bildarbeiten bei OpenAI.

DALL·E und DALL·E 2: Text‑zu‑Bild‑Kreativität

DALL·E (2021) setzte GPT‑ähnliche Architekturen auf Bilder an und erzeugte Bilder direkt aus Textprompts: „ein Sessel in Form einer Avocado“ oder „ein Schaufensterschild mit der Aufschrift ‚openai‘“. Es zeigte, dass Sprachmodelle auf kohärente, oft verspielte Bildausgaben erweitert werden können.

DALL·E 2 (2022) verbesserte Auflösung, Realismus und Steuerbarkeit erheblich. Es brachte Funktionen wie:

- Inpainting: Bearbeitung von Bildteilen per Text

- Outpainting: Erweiterung eines Bildes über seine ursprünglichen Grenzen hinaus

- Stil‑ und Kompositionssteuerung: Steuerung der Ausgabe mit detaillierten Prompts

Diese Systeme veränderten, wie Designer, Marketer, Künstler und Hobbyisten Ideen prototypisieren und verschoben Teile kreativer Arbeit hin zu iterativer, promptgetriebener Erkundung.

Codex und die Zukunft der Softwareentwicklung

Codex (2021) adaptierte die GPT‑3‑Familie für Quellcode und trainierte auf großen öffentlichen Codebasen. Es kann natürliche Sprache in funktionsfähige Code‑Snippets für Sprachen wie Python, JavaScript und viele andere übersetzen.

GitHub Copilot, aufgebaut auf Codex, brachte dies in Entwicklungswerkzeuge des Alltags. Entwickler bekamen ganze Funktionen, Tests und Boilerplate als Vorschläge und nutzten natürlichsprachliche Kommentare als Anleitung.

Für die Softwareentwicklung deutete Codex einen graduellen Wandel an:

- Weg vom Schreiben jeder einzelnen Zeile hin zum Überwachen und Verfeinern KI‑generierter Entwürfe

- Weg vom Auswendiglernen von Syntax hin zur Konzentration auf Architektur, Intention und Review

Zusammen zeigten CLIP, DALL·E und Codex, dass OpenAIs Ansatz über Text hinaus auf Vision und Code ausgeweitet werden kann und so Forschung auf Kunst, Design und Ingenieurswesen ausdehnt.

ChatGPT und das öffentliche Rampenlicht

Credits durch Empfehlungen erhalten

Lade Teammitglieder oder Freunde ein und sammle Credits durch Empfehlungen.

Start und explosive Verbreitung

OpenAI veröffentlichte ChatGPT als kostenlosen „research preview“ am 30. November 2022 in einem kurzen Blogpost und Tweet, statt in einer großen Produktkampagne. Das Modell basierte auf GPT‑3.5 und war für Dialog optimiert, mit Schutzmechanismen, die einige schädliche oder unsichere Anfragen ablehnen sollten.

Die Nutzung stieg nahezu sofort rasant an. Innerhalb weniger Tage meldeten sich Millionen Menschen an, und ChatGPT wurde einer der am schnellsten wachsenden Consumer‑Dienste überhaupt. Screenshots von Unterhaltungen fluteten soziale Medien, als Nutzer seine Fähigkeiten testeten, Essays zu schreiben, Code zu debuggen, E‑Mails zu verfassen und komplexe Themen einfach zu erklären.

Der Reiz von ChatGPT lag in seiner Vielseitigkeit statt in einem einzelnen Anwendungsfall.

Im Bildungsbereich nutzten Studierende es, um Texte zusammenzufassen, Übungsfragen zu generieren, wissenschaftliche Artikel zu übersetzen oder zu vereinfachen und schrittweise Erklärungen zu mathematischen oder naturwissenschaftlichen Problemen zu erhalten. Lehrkräfte experimentierten damit, Lehrpläne zu entwerfen, Bewertungsraster zu formulieren und differenzierte Lernmaterialien zu erstellen — zugleich debattierten Schulen über Zulassung und Regeln.

Im Berufsalltag baten Fachleute ChatGPT, E‑Mails, Marketing‑Texte und Berichte zu entwerfen, Präsentationen zu skizzieren, Code‑Snippets und Testfälle zu generieren und es als Brainstorming‑Partner für Produktideen oder Strategien zu nutzen. Freelancer und Kleinunternehmen setzten es besonders als kostengünstige Assistenz für Inhalte und Analysen ein.

Im Alltag wandten sich Menschen an ChatGPT für Reisepläne, Rezeptideen aus vorhandenen Zutaten, grundlegende rechtliche und medizinische Erläuterungen (mit dem Hinweis, professionelle Beratung einzuholen) und Hilfe beim Erlernen neuer Fähigkeiten oder Sprachen.

Vom kostenlosen Preview zu bezahlten Angeboten

Die anfängliche Research‑Preview war kostenlos, um Reibung zu minimieren und Feedback zu Fehlern, Missbrauch und fehlenden Fähigkeiten zu sammeln. Mit wachsender Nutzung standen OpenAI hohe Infrastrukturkosten gegenüber und die Nachfrage nach verlässlicherem Zugang stieg.

Im Februar 2023 führte OpenAI ChatGPT Plus ein, ein Abonnement mit schnelleren Antworten, priorisiertem Zugang bei hoher Auslastung und frühem Zugriff auf neue Funktionen und Modelle wie GPT‑4. Das schuf einen wiederkehrenden Umsatzstrom, während eine kostenlose Stufe für breiten Zugang erhalten blieb.

Im Laufe der Zeit kamen geschäftsorientierte Optionen hinzu: API‑Zugänge zu denselben Konversationsmodellen, Integrationswerkzeuge für Produkte und Workflows sowie Angebote wie ChatGPT Enterprise und Team‑Pläne für Organisationen mit höheren Sicherheits‑, Admin‑ und Compliance‑Anforderungen.

Debatten, Regulierung und ethische Bedenken

Die plötzliche Sichtbarkeit von ChatGPT verschärfte langjährige Debatten rund um KI.

Regulierungsbehörden sorgten sich um Datenschutz, Datenverarbeitung und Rechtskonformität, insbesondere in Regionen wie der Europäischen Union. Einige Behörden schränkten ChatGPT zeitweise ein oder leiteten Untersuchungen ein, um zu prüfen, ob Datenverarbeitung und Speicherung gesetzlichen Vorgaben entsprachen.

Bildungsinstitutionen sahen sich mit Plagiat und akademischer Integrität konfrontiert, da Studierende Texte und Hausaufgaben erzeugen konnten, die schwer zu erkennen waren. Das führte in einigen Schulen zu Verboten oder strengen Richtlinien, während andere Aufgabenstellungen entwickelten, die Prozess, mündliche Prüfungen oder Präsenzarbeit stärker betonten.

Ethiker und Forscher warnten vor Fehlinformationen, Überabhängigkeit auf KI für kritische Entscheidungen, Verzerrungen in Antworten und möglichen Auswirkungen auf kreative und wissensbasierte Arbeit. Fragen zu Trainingsdaten, Urheberrecht und den Rechten von Künstlern und Schreibern, deren Werke das Modellverhalten beeinflusst haben könnten, blieben strittig.

Für OpenAI markierte ChatGPT einen Wendepunkt: Die Organisation wandelte sich vom hauptsächlich forschungsorientierten Labor zu einem Unternehmen im Zentrum globaler Diskussionen darüber, wie leistungsfähige Sprachmodelle bereitgestellt, reguliert und in den Alltag integriert werden sollten.

GPT‑4 und die Weiterentwicklung der KI‑Fähigkeiten

Von GPT‑3.5 zu GPT‑4

OpenAI veröffentlichte GPT‑4 im März 2023 als einen bedeutenden Fortschritt gegenüber GPT‑3.5, dem Modell, das ChatGPT zunächst antrieb. GPT‑4 verbesserte Schlussfolgerungsfähigkeit, das Befolgen komplexer Anweisungen und Kohärenz über längere Dialoge hinweg. Es wurde deutlich besser im Umgang mit nuancierten Prompts, etwa beim Erklären von Rechtsklauseln, Zusammenfassen technischer Arbeiten oder beim Erstellen von Code aus vagen Anforderungen.

Im Vergleich zu GPT‑3.5 reduzierte GPT‑4 viele offensichtliche Fehlerquellen: Es erfand seltener Quellenangaben, ging mit Randfällen in Mathematik und Logik zuverlässiger um und lieferte konsistentere Ausgaben bei wiederholten Anfragen.

Multimodalität und Benchmark‑Leistungen

GPT‑4 brachte multimodale Fähigkeiten: Neben Text konnte es in einigen Konfigurationen auch Bilder als Eingabe verarbeiten. Das ermöglicht Anwendungsfälle wie das Beschreiben von Diagrammen, Lesen handschriftlicher Notizen, Interpretieren von UI‑Screenshots oder Analysieren von Fotos zur Extraktion strukturierter Informationen.

Auf standardisierten Benchmarks übertraf GPT‑4 frühere Modelle deutlich. Es erreichte nahezu Top‑Prozent‑Platzierungen bei simulierten Berufsprüfungen wie der Anwaltsprüfung, dem SAT und verschiedenen Advanced‑Placement‑Tests. Auch bei Coding‑ und Reasoning‑Benchmarks verbesserte es sich, was stärkere Fähigkeiten in Sprachverständnis und Problemlösung widerspiegelt.

Ökosystem‑Auswirkung und verbleibende Herausforderungen

GPT‑4 wurde schnell zum Kern von OpenAIs API und antrieb eine neue Welle von Drittanbieterprodukten: KI‑Co‑Piloten in Produktivitätssuiten, Coding‑Assistenten, Kundensupport‑Tools, Bildungsplattformen und vertikale Anwendungen in Recht, Finanzen und Gesundheitswesen.

Trotz dieser Fortschritte halluziniert GPT‑4 weiterhin, kann auf unsichere oder voreingenommene Outputs gebracht werden und besitzt kein wirkliches Verständnis oder stets aktuelles Faktenwissen. OpenAI investierte stark in Alignment‑Forschung für GPT‑4 — etwa durch RLHF, Red‑Teaming und systemweite Sicherheitsregeln — betont aber, dass sorgfältige Bereitstellung, Monitoring und fortlaufende Forschung nötig bleiben, um Risiken und Missbrauch zu managen.

Sicherheit, Alignment und Governance bei OpenAI

Schon in den frühen Jahren stellte OpenAI Sicherheit und Alignment in den Mittelpunkt seiner Mission, nicht als Nachgedanke zu Produktstarts. Die Organisation erklärt konstant, dass ihr Ziel darin besteht, hochleistungsfähige KI‑Systeme zu bauen, die mit menschlichen Werten übereinstimmen und so bereitgestellt werden, dass sie allen Menschen zugutekommen — nicht nur Aktionären oder frühen Partnern.

Die OpenAI‑Charta und erklärte Prioritäten

2018 veröffentlichte OpenAI das OpenAI Charter, das seine Prioritäten formalisiert:

- Eine breit nützliche AGI entwickeln und Einsätze vermeiden, die der Menschheit schaden könnten.

- Mit anderen Forschungs‑ und Politikinstitutionen in Sicherheitsfragen kooperieren.

- Bereit sein, andere Projekte zu unterstützen, wenn sie näher an einer sicheren AGI sind als OpenAI selbst.

Die Charta dient als Governance‑Kompass und prägt Entscheidungen zu Forschungsrichtungen, Veröffentlichungstempo und externen Partnerschaften.

Sicherheits‑, Policy‑ und Red‑Teaming‑Strukturen

Mit wachsender Modellkompetenz baute OpenAI dedizierte Sicherheits‑ und Governance‑Funktionen neben den Kernforschungsteams auf:

- Alignment‑ & Safety‑Forschungsteams untersuchen, wie Modelle so gestaltet werden können, dass sie auch unter Druck oder adversarialem Prompting menschlichen Intentionen folgen.

- Policy‑ und Governance‑Teams analysieren gesellschaftliche Auswirkungen, legen verantwortliche Bereitstellungsrichtlinien fest und interagieren mit Regierungen und Norm‑Gremien.

- Red‑Teaming‑Programme beziehen interne Spezialisten und externe Expertinnen und Experten ein, um Modelle vor der Veröffentlichung auf Missbrauchspotenzial, Verzerrungen, Sicherheitslücken und anderweitig schädliches Verhalten zu testen.

Diese Gruppen beeinflussen Launch‑Entscheidungen, Zugriffsstufen und Nutzungsrichtlinien für Modelle wie GPT‑4 und DALL·E.

Techniken: RLHF und darüber hinaus

Ein prägendes technisches Vorgehen ist Reinforcement Learning from Human Feedback (RLHF). Menschliche Bewerter prüfen Modellantworten, ordnen sie nach Präferenz und trainieren ein Belohnungsmodell. Das Hauptmodell wird dann so optimiert, dass es Antworten generiert, die näher an menschlich bevorzugtem Verhalten liegen, wodurch toxische, voreingenommene oder unsichere Ausgaben reduziert werden.

Im Lauf der Zeit hat OpenAI RLHF mit weiteren Techniken kombiniert: systemweite Sicherheitsrichtlinien, Inhaltsfilter, domänenspezifisches Fine‑Tuning und Monitoring‑Werkzeuge, die riskante Nutzung einschränken oder markieren können.

Externe Zusammenarbeit und öffentliche Rahmenwerke

OpenAI hat an öffentlichen Sicherheitsrahmen teilgenommen, wie freiwillige Verpflichtungen gegenüber Regierungen, Modell‑Reporting‑Praktiken und Standards zur Sicherheit von Frontier‑Modellen. Es hat mit Akademikerinnen, zivilgesellschaftlichen Organisationen und Sicherheitsexpertinnen an Evaluierungen, Red‑Teaming und Audits zusammengearbeitet.

Diese Kooperationen, kombiniert mit formalen Dokumenten wie der Charta und sich entwickelnden Nutzungsrichtlinien, bilden das Fundament von OpenAIs Ansatz zur Governance immer leistungsfähigerer KI‑Systeme.

Kontroversen, Kritik und interne Spannungen

Schnell eine mobile App erstellen

Entwirf aus einer Nutzerstory eine Flutter‑App und passe Flows und die UI an.

OpenAIs rascher Aufstieg wurde begleitet von Kritik und internen Spannungen, oft bezogen auf die Frage, wie stark die Organisation noch ihrer ursprünglichen Mission verpflichtet ist, breite und sichere Vorteile zu schaffen.

Von „Open“ Science zu geschlossenen Modellen

Anfangs betonte OpenAI offene Veröffentlichung und Teilen. Mit wachsender Leistungsfähigkeit von GPT‑2, GPT‑3 und GPT‑4 verlagerte sich die Praxis hin zu eingeschränkten Veröffentlichungen, API‑Zugängen und weniger technischen Details.

Kritiker argumentierten, dies widerspreche dem durch den Namen „OpenAI“ implizierten Versprechen. Befürworter innerhalb der Organisation hielten dem entgegen, dass das Zurückhalten kompletter Modellgewichte und Trainingsdetails notwendig sei, um Missbrauchsrisiken und Sicherheitsprobleme zu mindern.

OpenAI reagierte mit Sicherheitsgutachten, Systemkarten und Policy‑Dokumenten, hielt aber Kernmodellgewichte proprietär. Das wird als Balanceakt zwischen Offenheit, Sicherheit und Wettbewerbsdruck präsentiert.

Macht, Daten und Kommerzialisierung

Mit der Vertiefung der Partnerschaft mit Microsoft — Integration von Modellen in Azure und Produkte wie Copilot — äußerten Beobachter Bedenken wegen Konzentration von Compute, Daten und Entscheidungsgewalt.

Kritiker fürchten, dass wenige Unternehmen Kontrolle über die fortschrittlichsten General‑Purpose‑Modelle und die dahinterstehende Infrastruktur haben. Andere sehen in der starken Kommerzialisierung (ChatGPT Plus, Enterprise‑Angebote, exklusive Lizenzen) eine Abkehr von der ursprünglichen Nonprofit‑Mission, Vorteile breit zu teilen.

Die Führung von OpenAI argumentiert, dass Einnahmen nötig seien, um teure Forschung zu finanzieren, während die capped‑profit‑Struktur und die Charta Menscheninteressen über reinen Shareholder‑Value stellen sollen. Zusätzlich wurden Programme wie kostenlose Zugangsstufen, Forschungspartnerschaften und einige Open‑Source‑Werkzeuge eingeführt, um öffentlichen Nutzen zu demonstrieren.

Führungsspannungen und prominente Abgänge

Interne Auseinandersetzungen über Geschwindigkeit, Offenheit und Priorisierung von Sicherheit traten wiederholt zutage.

Dario Amodei und andere verließen 2020 das Unternehmen, um Anthropic zu gründen, und nannten unterschiedliche Ansichten zu Sicherheit und Governance als Grund. Spätere Rücktritte von Schlüsselpersonen aus dem Sicherheitsbereich, etwa Jan Leike im Jahr 2024, betonten öffentlich die Sorge, dass kurzfristige Produktziele langfristiger Sicherheitsarbeit Vorrang hätten.

Der sichtbarste Bruch ereignete sich im November 2023, als der Vorstand CEO Sam Altman kurzzeitig des Amtes enthob mit der Begründung eines Vertrauensverlusts. Nach starkem Mitarbeiterprotest und Verhandlungen unter Einbeziehung von Microsoft und anderen Akteuren kehrte Altman zurück, der Vorstand wurde neu besetzt, und OpenAI kündigte Governance‑Reformen an, darunter ein neues Komitee für Sicherheit und Schutz.

Diese Episoden verdeutlichten, dass die Organisation noch immer ringt mit dem Spannungsfeld zwischen schneller Bereitstellung, kommerziellem Erfolg und der Verantwortung für Sicherheit und breiten Nutzen.

OpenAIs sich wandelnde Rolle in der Zukunft der KI

OpenAI hat sich von einem kleinen, forschungsorientierten Nonprofit zu einem zentralen Infrastruktur‑Anbieter für KI entwickelt und beeinflusst, wie neue Werkzeuge gebaut, reguliert und wahrgenommen werden.

Statt nur Modelle zu veröffentlichen, betreibt OpenAI nun eine Plattform, die von Startups, Unternehmen und Einzelentwicklern genutzt wird. Über APIs für Modelle wie GPT‑4, DALL·E und künftige Systeme ist OpenAI:

- Eine technische Grundlage für Produkte in Gesundheitswesen, Bildung, Entwicklerwerkzeugen und kreativen Branchen

- Ein Referenzpunkt für Benchmarks, Best Practices und Sicherheitsfeatures, die andere Labs übernehmen oder kritisieren

Diese Plattformrolle bedeutet, dass OpenAI nicht nur Forschung vorantreibt — es setzt auch Standards dafür, wie Millionen Menschen erstmals leistungsfähige KI erleben.

Forschung, Industrie und Politik prägen

OpenAIs Arbeit treibt Wettbewerber und Open‑Source‑Gemeinschaften dazu, neue Modelle, Trainingsmethoden und Sicherheitsansätze zu entwickeln. Dieser Wettbewerb beschleunigt Fortschritt und schärft zugleich Debatten über Offenheit, Zentralisierung und Kommerzialisierung von KI.

Regierungen und Regulierer orientieren sich zunehmend an OpenAIs Praktiken, Transparenzberichten und Alignment‑Forschung, wenn sie Regeln für Bereitstellung, Sicherheitsevaluationen und verantwortliche Nutzung entwerfen. Öffentliche Diskussionen über ChatGPT, GPT‑4 und künftige Systeme prägen stark, wie Gesellschaften Risiken und Nutzen von KI wahrnehmen.

Offene Fragen: Macht, Gerechtigkeit, Verantwortlichkeit

Mit zunehmender Leistungsfähigkeit der Modelle werden ungelöste Fragen zur Rolle OpenAIs wichtiger:

- Wie konzentriert sollte die Kontrolle über Frontier‑Modelle sein?

- Wer erhält frühen oder bevorzugten Zugang — und zu welchen Konditionen?

- Wie werden Trainingsdaten, Umweltauswirkungen und externe Sicherheitsaudits reguliert?

- Welche Pflichten hat OpenAI gegenüber Menschen und Staaten, die keine Kundinnen oder Kunden sind, aber von den Technologien betroffen sind?

Diese Fragen entscheiden darüber, ob künftige KI‑Systeme bestehende Ungleichheiten verstärken oder helfen, sie zu reduzieren.

Wie man sich heute mit OpenAI auseinandersetzen kann

Entwickler und Unternehmen können:

- Auf OpenAIs APIs aufbauen und eigene Sicherheitschecks, Red‑Teaming und Monitoring implementieren

- OpenAIs Modelle mit Open‑Source‑Tools kombinieren, um Abhängigkeiten von einem Anbieter zu reduzieren

- Sich an Feedback‑Programmen, Policy‑Konsultationen und Forschungspartnerschaften beteiligen, wo möglich

Einzelpersonen können:

- Lernen, wie Modelle funktionieren, welche Grenzen sie haben und wie Daten genutzt werden

- KI‑Werkzeuge kritisch nutzen — Ausgaben überprüfen, nicht blind vertrauen und schädliches Verhalten melden

OpenAIs zukünftiger Einfluss hängt nicht nur von internen Entscheidungen ab, sondern davon, wie Regierungen, Wettbewerber, Zivilgesellschaft und Nutzerinnen und Nutzer sich engagieren, kritisieren und Rechenschaft von den Systemen verlangen, die es entwickelt.