24. Nov. 2025·8 Min

Von Figma zu Produktionscode: Wie KI Design‑Lücken schließt

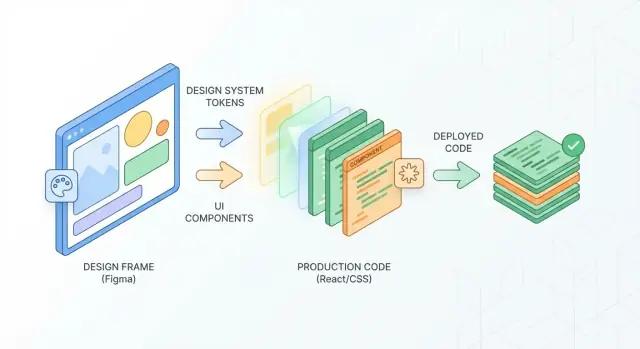

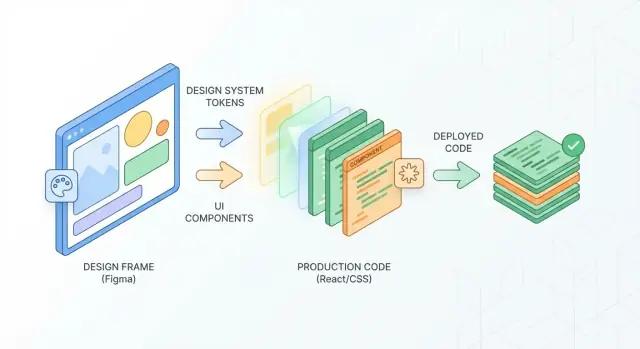

Erfahrt, wie KI Figma‑Designs in produktionsbereiten Code überführt, indem Komponenten, Tokens und Specs gemappt werden — weniger Nacharbeit, schnellere Releases.

Erfahrt, wie KI Figma‑Designs in produktionsbereiten Code überführt, indem Komponenten, Tokens und Specs gemappt werden — weniger Nacharbeit, schnellere Releases.

„Figma zu Produktion“ wird oft als „irgendwelches CSS exportieren und deployen“ missverstanden. In Wirklichkeit umfasst produktionsreifes UI responsives Verhalten, interaktive Zustände, echte Daten, Barrierefreiheit, Performance‑Einschränkungen und die Integration in ein Designsystem. Ein Design kann in einem statischen Frame perfekt aussehen und trotzdem dutzende Implementierungsentscheidungen offenlassen.

Ein Frontend‑Build muss Design‑Absicht in wiederverwendbare Komponenten, Tokens (Farben, Typografie, Abstände), Layoutregeln über Breakpoints hinweg und Randfälle wie langen Text, leere Zustände, Ladevorgänge und Fehler übersetzen. Zudem braucht es konsistente Interaktionsdetails (Hover, Focus, Pressed), Tastaturunterstützung und vorhersehbares Verhalten in verschiedenen Browsern.

Die Lücke ist nicht nur ein Tool‑Problem — es fehlt oft Information oder sie ist mehrdeutig:

Jede ungelöste Design‑Entscheidung wird zu einem Gespräch, einem PR‑Kommentar oder — schlimmer — zu Nacharbeit nach QA. Diese Nacharbeit führt oft zu Bugs (Layout‑Regressionen, fehlende Fokus‑Ringe) und lässt das UI inkonsistent wirken.

KI reduziert die repetitiven Teile beim Überbrücken der Lücke: Frames auf vorhandene UI‑Komponenten abbilden, Token‑Inkonsistenzen markieren, Abstand und Typografie gegen Regeln prüfen und klarere Handoff‑Dokumente generieren (Props, Zustände, Akzeptanzkriterien). Sie ersetzt kein Urteilsvermögen, kann aber Mismatches früh erkennen und die Implementierung näher an der Design‑Absicht halten.

In der Praxis zeigen sich die größten Gewinne, wenn die KI an eure realen Produktionsbedingungen angeschlossen ist — eure Komponenten‑APIs, Tokens und Konventionen — damit sie kompatiblen Output erzeugt, der zu eurer Art passt, UI auszuliefern.

„Produktionscode“ heißt weniger: Pixel perfekt abbilden, vielmehr: UI ausliefern, das euer Team sicher warten kann. Wenn KI beim Konvertieren von Figma zu Code hilft, verhindert Klarheit über das Ziel viele Frustrationen.

Ein Screen‑Export kann richtig aussehen und trotzdem eine Sackgasse sein. Produktionsarbeit zielt auf wiederverwendbare UI‑Komponenten (Buttons, Inputs, Cards, Modals), die sich zu vielen Screens zusammensetzen lassen.

Wenn ein generiertes Layout nicht als bestehende Komponenten (oder eine kleine Anzahl neuer Komponenten) ausdrückbar ist, ist es nicht produktionsreif — es ist ein Prototyp‑Snapshot.

Definiert eure Messlatte in Begriffen, die alle prüfen können:

KI kann die Implementierung beschleunigen, aber sie kann eure Konventionen nicht erraten, es sei denn, ihr legt sie fest (oder gebt Beispiele).

Es bedeutet nicht:

Eine kleine, bewusste Abweichung, die Konsistenz und Wartbarkeit wahrt, ist oft besser als eine perfekte Replik, die die langfristigen Kosten erhöht.

KI arbeitet am besten, wenn Figma wie ein System strukturiert ist:

Button/Primary, Icon/Close).Bevor ihr an eine KI‑unterstützte Frontend‑Implementierung übergebt:

KI „sieht“ eine Figma‑Datei nicht wie eine Person. Sie liest Struktur: Frames, Gruppen, Layer, Constraints, Text‑Styles und die Beziehungen zwischen ihnen. Ziel ist es, diese Signale in etwas zu übersetzen, das Entwickler zuverlässig implementieren können — oft als wiederverwendbare Komponenten plus klare Layoutregeln.

Eine robuste KI‑Pipeline beginnt damit, Wiederholungen und Absicht zu finden. Wenn mehrere Frames dieselbe Hierarchie teilen (Icon + Label, gleiche Polsterung, gleiche Eckradien), kann die KI sie als dasselbe Muster markieren — selbst wenn Namen inkonsistent sind.

Sie sucht außerdem nach typischen UI‑Signaturen:

Je besser eure Designsystem‑Ausrichtung, desto sicherer kann die KI diese Elemente klassifizieren.

Eine „Button“ zu interpretieren ist hilfreich; es auf eure Button‑Komponente abzubilden, spart aber die echte Zeit. KI vergleicht typischerweise Eigenschaften (Größe, Typografie, Farbtoken‑Nutzung, Varianten) und schlägt dann einen Komponenten‑Namen und Props vor.

Zum Beispiel könnte ein Primary‑Button werden zu:

Buttonvariant="primary", size="md", iconLeft, disabledWenn die KI auf bestehende Komponenten abbilden kann, vermeidet ihr Einmal‑UI‑Code und haltet das Produkt konsistent.

Figma enthält bereits Layout‑Absicht durch Auto Layout, Constraints und Abstände. Die KI nutzt das, um folgendes abzuleiten:

Fehlen Constraints, muss die KI manchmal aus visueller Nähe raten — hilfreich, aber weniger vorhersehbar.

Über Code‑Vorschläge hinaus kann KI entwicklerfreundliche Ausgaben erzeugen: Messungen, Typografie‑Details, Farbverweise, Komponentennutzungshinweise und Randfälle (leerer Zustand, langer Textumbruch). Denkt daran, einen Frame in eine Checkliste zu verwandeln, gegen die ein Developer bauen kann — ohne Specs für jeden Screen manuell zu schreiben.

KI generiert UI‑Code schneller, wenn eure Figma‑Datei vorhersehbar ist. Ziel ist nicht, „für die Maschine zu designen“ auf Kosten der Kreativität — sondern Mehrdeutigkeiten zu entfernen, damit Automatisierung sichere Annahmen treffen kann.

Die meisten KI‑Tools leiten Absicht aus Layer‑Namen, Hierarchie und wiederholten Mustern ab. Wenn ein Button Rectangle 12 in Frame 8 heißt, muss das Tool raten, ob es ein Button, eine Card oder eine dekorative Form ist. Klare Struktur macht Raten zu Matching.

Eine gute Regel: Wenn ein Entwickler fragen würde „was ist das?“, wird die KI es auch tun.

Verwendet eine konsistente Struktur:

Web, iOS, Marketing)Checkout, Onboarding)Checkout — Payment)Für wiederverwendbares UI vertraut auf Komponenten + Varianten:

Button, Input, Cardsize=md, state=hover, tone=primaryBlue Button 2Flattening und Masking sind okay — aber „Mystery Layers“ nicht. Löscht versteckte Reste, ungenutzte Gruppen und duplizierte Formen. Bevorzugt Auto Layout gegenüber manuellen Abständen und vermeidet pro‑Instanz Overrides, die stillschweigend Padding, Radius oder Schriftstile verändern.

Wenn etwas wirklich einzigartig sein muss, benennt es klar (z. B. Promo banner (one-off)), damit es nicht fälschlich als Systemkomponente behandelt wird.

Für Icons nutzt ein einheitliches Quellformat (SVG empfohlen) und konsistente Benennung (icon/chevron-right). Text in Icons nicht outlinen.

Bei Bildern markiert die Absicht: Hero image (cropped), Avatar (circle mask). Gebt Seitenverhältnisse und Safe‑Crop‑Hinweise, wenn nötig.

Komplexe Illustrationen behandelt ihr als Assets: einmal exportieren, Versionen speichern und konsistent referenzieren, damit KI nicht versucht, aufwändige Vektor‑Illustrationen als UI‑Shapes neu zu bauen.

Design‑Tokens sind die benannten, wiederverwendbaren Entscheidungen hinter einer UI — sodass Designer und Entwickler dasselbe meinen, ohne über Pixel zu streiten.

Ein Token ist ein Label plus ein Wert. Statt „benutze #0B5FFF“ sagt ihr color.primary. Statt „14px mit 20px Zeilenhöhe“ sagt ihr font.body.sm. Übliche Token‑Familien sind:

Der Vorteil ist nicht nur Konsistenz — sondern Geschwindigkeit. Wenn ein Token sich ändert, aktualisiert das System alles auf einmal.

Figma‑Dateien enthalten oft eine Mischung aus beabsichtigten Styles und Einmalwerten, die während der Iteration entstehen. KI‑Tools können Frames und Komponenten scannen und Token‑Kandidaten vorschlagen, indem sie ähnliche Werte clustern. Beispielsweise erkennt sie, dass #0B5FFF, #0C5EFF und #0B60FF wahrscheinlich dasselbe „Primary Blue“ sind und empfiehlt einen kanonischen Wert.

Sie kann Bedeutung aus der Verwendung ableiten: Die Farbe, die für Links über mehrere Screens verwendet wird, ist wahrscheinlich link, während eine Farbe, die nur in Error‑Bannern auftaucht, danger heißen sollte. Ihr legt die Namen fest, aber die KI reduziert das mühsame Audit.

Kleine Inkonsistenzen sind der schnellste Weg, ein Designsystem zu zerstören. Eine praktische Regel: Wenn zwei Werte bei normaler Zoomstufe visuell ununterscheidbar sind, sollten sie wahrscheinlich nicht beide existieren. KI kann Nahe‑Duplikate markieren und zeigen, wo sie vorkommen, so dass Teams konsolidieren können, ohne zu raten.

Tokens helfen nur, wenn sie in Einklang bleiben. Behandelt sie als gemeinsame Quelle der Wahrheit: ändert Tokens absichtlich (mit kurzem Changelog) und propagiert die Änderungen in Figma und Code. Manche Teams prüfen Token‑Änderungen genauso wie Komponenten‑Änderungen — leichtgewichtig, aber konsistent.

Wenn ihr bereits ein System habt, verlinkt eure Token‑Updates an denselben Workflow wie Komponenten‑Updates (siehe /blog/component-mapping-and-reuse-at-scale).

Skalierende UI‑Lieferung ist weniger ein „Figma zu Code konvertieren“-Problem als ein „die richtigen Komponenten immer auf dieselbe Weise abbilden“-Problem. KI hilft am meisten, wenn sie zuverlässig aus der Designdatei auf vorhandenen Code‑Bestand abgleichen kann — inkl. Namen, Varianten und Verhalten.

Gebt der KI stabile Anker: konsistente Komponentennamen, klare Varianteneigenschaften und eine vorhersehbare Bibliotheksstruktur. Wenn diese Anker existieren, kann die KI ein Mapping vorschlagen wie:

Button mit Eigenschaften size, intent, state + "<Button size=\"sm\" variant=\"primary\" disabled />" + \nDas ist der Punkt, wo Design‑Tokens und Komponenten‑APIs aufeinandertreffen. Wenn eure Code‑Komponente variant="danger" erwartet, aber Figma intent="error" nutzt, kann die KI die Inkonsistenz markieren und eine Übersetzungsschicht (oder Namensänderung) vorschlagen, damit Mapping kein Ratespiel wird.

Im Scale sind die teuersten Bugs „fast richtige“ Komponenten: Der Default‑Zustand sieht korrekt aus, aber Edge‑Zustände fehlen oder sind inkonsistent. KI kann eure Bibliothek scannen und Lücken hervorheben wie:

Nützlich ist nicht nur eine Warnung — sondern eine konkrete To‑Do: „Füge state=loading zur Button‑Variante hinzu und dokumentiere Abstand + Spinner‑Ausrichtung."

KI kann Nahe‑Duplikate erkennen, indem sie Struktur (Padding, Typografie, Radius) vergleicht und Wiederverwendung empfiehlt: „Dieser ‚Primary CTA‘ ist zu 95% identisch mit Button/primary/lg — benutzt die bestehende Komponente und überschreibt nur die Icon‑Platzierung.“ Das hält UI konsistent und verhindert, dass sich langsam One‑Off‑Stile einschleichen.

Eine praktische Regel, die KI helfen kann durchzusetzen:

Wenn ihr diese Regeln einmal dokumentiert, kann die KI sie wiederholt anwenden — Entscheidungen werden so von Debatten zu überprüfbaren Empfehlungen.

Gute Handoff‑Dokumentation heißt nicht „mehr schreiben“, sondern die richtigen Details in einem Format, das Entwickler schnell nutzen können. KI hilft, Design‑Absicht in klare Tasks, Akzeptanzkriterien und Implementationsnotizen zu überführen, die natürlich in euren bestehenden Workflow passen.

Statt Messungen und Verhaltensnotizen manuell zu kopieren, lasst KI task‑fertigen Text aus einem ausgewählten Frame/ einer Komponente generieren:

Beispiel‑Akzeptanzkriterien, die KI entwerfen kann (die ihr dann verfeinert):

KI ist am nützlichsten, wenn sie konsequent die „kleinen“ Regeln extrahiert, die die größten Abweichungen verursachen:

Lasst die KI diese als konzise Implementationshinweise an die Komponente/den Frame hängen — kurz genug zum Überfliegen, spezifisch genug zum Coden.

Dokumentation funktioniert nur, wenn Leute sie finden können.

Ziel: weniger Klärungs‑Threads, schnellere Schätzungen und weniger „matcht fast das Design“ UI.

Barrierefreiheit sollte kein separater „Compliance‑Sprint“ nach dem Build sein. Wenn ihr KI zusammen mit Figma und eurer Komponentenbibliothek verwendet, könnt ihr Barrierefreiheits‑ und Kern‑UX‑Regeln in fortlaufende Guardrails verwandeln — während Designs sich noch ändern und bevor Code ausgeliefert wird.

KI eignet sich gut als schneller Reviewer, der Figma mit bekannten Standards (WCAG‑Basics, Plattformkonventionen, eurem Pattern‑Set) vergleicht. Praktische Checks sind z. B.:

Diese Checks funktionieren am besten, wenn die KI euer Designsystem kennt. Wenn z. B. eine TextField‑Komponente auf eine echte Input‑Komponente im Code abgebildet ist, kann die KI geforderte Zustände (Label, Help‑Text, Error‑State, Disabled, Focus) prüfen und warnen, wenn ein Design ein „kundenspezifisches Input‑Aussehen“ ohne die nötige Semantik nutzt.

Ziel ist kein langer Report — sondern eine kurze Liste von Änderungen, die Designer und Entwickler sofort umsetzen können. Gute KI‑Tools verknüpfen jedes Problem mit einem konkreten Node in Figma (Frame, Komponente‑Instanz oder Variante) und schlagen kleinste praktikable Korrekturen vor, z. B.:

TextField/Error‑Variante und füge einen Error‑Message‑Platzhalter hinzu."Führt ein leichtgewichtiges Gate ein: Designs dürfen nicht als „ready for implementation“ markiert werden, bevor wichtige Accessibility/UX‑Checks bestanden sind, und PRs dürfen nicht gemerged werden, wenn die implementierte UI regressiert. Wenn Guardrails früh und häufig laufen, wird Barrierefreiheit zu einem routinemäßigen Qualitätsmerkmal — nicht zur Last‑Minute‑Herausforderung.

KI beschleunigt die Implementierung, macht es aber auch leichter, kleine Inkonsistenzen schnell auszuliefern. Die Lösung ist, „Design‑Fidelity“ wie jedes andere Qualitätsziel zu behandeln: messbar, automatisiert und auf der richtigen Ebene geprüft.

Visuelle Diffs sind der direkteste Weg, Drift zu entdecken. Nachdem eine Komponente oder Seite implementiert wurde, erzeugt man Screenshots in einer kontrollierten Umgebung (gleiche Viewport‑Größen, geladene Fonts, deterministische Daten) und vergleicht sie mit einem Baseline.

KI kann helfen durch:

Die meisten „wirkt leicht anders“ Bugs kommen aus wenigen wiederkehrenden Quellen: Abstands‑Skalen, Schriftstile und Farbwerte. Statt auf eine komplette Seitenprüfung zu warten, validiert diese auf der kleinsten Einheit:

Wenn KI an eure Design‑Tokens angebunden ist, kann sie Mismatches bereits beim Schreiben des Codes markieren, nicht erst nach der QA.

Seiten‑QA ist langsam und laut: Eine kleine Komponenten‑Abweichung kann sich über viele Screens ausbreiten. Komponenten‑Checks machen Fidelity skalierbar — einmal korrigieren, überall profitieren.

Ein nützliches Muster sind „Komponenten‑Snapshots + Contract‑Tests“: Snapshots fangen visuelle Drift ein, während kleine Checks bestätigen, dass Props, Zustände und Token‑Nutzung konsistent bleiben.

Nicht jede Abweichung ist ein Bug. Plattform‑Constraints (Font‑Rendering, native Controls, responsive Reflow, Performance‑Tradeoffs) erzeugen legitime Unterschiede. Vereinbart Toleranzen vorab — z. B. Subpixel‑Rundung oder Font‑Anti‑Aliasing — und legt Ausnahmen in einem kurzen Entscheidungslog fest, das von euren Handoff‑Doken verlinkt ist (z. B. /docs/ui-qa). So bleiben Reviews auf echte Regressionen statt in Pixel‑Debatten stecken.

KI ist am nützlichsten, wenn man sie wie einen Teamkollegen mit begrenztem Auftrag behandelt, nicht als Ersatz für Design‑Urteil oder Engineering‑Verantwortung. Die folgenden Muster helfen Teams, Geschwindigkeit ohne Verlust der Konsistenz zu erreichen.

Vor der Entwicklung: Nutzt KI, um die Datei vorzubereiten: fehlende Zustände identifizieren, inkonsistente Abstände, unlabeled Komponenten und Token‑Verstöße. Das ist der schnellste Gewinn, weil es Nacharbeit verhindert.

Während der Entwicklung: Nutzt KI als Implementierungsassistent: Erzeugt einen ersten UI‑Code aus ausgewählten Frames, schlagt Komponentenzuordnungen aus eurer Bibliothek vor und entwerft CSS/Token‑Mappings. Entwickler müssen weiterhin echte Daten, Routing und State einbauen.

Nach der Entwicklung: Nutzt KI zur Validierung: Vergleicht Screenshots mit Figma, markiert visuelle Diffs, prüft zugängliche Namen/Kontrast und bestätigt Token‑Nutzung. Behandelt das wie einen automatisierten Reviewer, der „Paper‑Cuts“ früh findet.

Die verlässlichste Aufstellung ist Designer + Developer + Reviewer:

KI unterstützt jede Rolle, ersetzt aber nicht die finale Verantwortlichkeit.

Definiert leichtgewichtige Genehmigungsregeln:

Schreibt diese Regeln einmal auf und verlinkt sie in euren Team‑Docs (z. B. /design-system/governance).

Drift entsteht, wenn das Modell Abstände, Farben oder Komponenten erfindet, die „nah genug“ sind. Reduziert das durch:

Wenn KI nur mit den Lego‑Bausteinen eures Systems bauen kann, bleibt Output konsistent — selbst bei hoher Geschwindigkeit.

Den Rollout von KI‑unterstütztem „Figma zu Produktionscode“ behandelt ihr am besten wie jede Prozessänderung: klein anfangen, messen, dann ausweiten.

Wählt einen Feature‑Bereich mit klaren UI‑Grenzen (z. B. Einstellungsseite, ein Onboarding‑Step oder eine einzelne Dashboard‑Card). Vermeidet für den ersten Lauf Kernnavigation oder stark zustandsbehaftete Flows.

Definiert Erfolgsmessgrößen vorab, z. B.:

Bevor ihr etwas generiert, stimmt euch auf eine kleine Basis ab:

Ziel ist nicht Vollständigkeit — sondern Konsistenz. Schon ein Dutzend gut definierter Komponenten verhindert die meisten „fast richtig“ Ergebnisse.

Behandelt KI‑Output als Entwurf. Dokumentiert in jedem Pilot‑PR:

Macht daraus eine kurze Checkliste neben euren Handoff‑Doks und aktualisiert sie wöchentlich.

Wenn der Pilot stabil ist, weitet ihr nach Feature‑Teams aus — nicht durch „überall anschalten“. Stellt ein Template‑Repo oder ein „Golden Path“ Beispiel bereit und eine zentrale Stelle, um Learnings zu sammeln (Seite im /blog oder internes Wiki). Wenn ihr Tools evaluiert, haltet Procurement‑Hürden niedrig mit klaren Vergleichen und Budgethinweisen (/pricing).

Wenn ihr diesen Ansatz testen wollt, ohne eure Pipeline sofort umzubauen: Plattformen wie Koder.ai helfen Teams, schnell von Chat zu funktionierenden Web‑Apps zu kommen — besonders, wenn ihr auf ein Designsystem standardisiert und Output mit echten Komponenten und Tokens erwarten könnt. Koder.ai unterstützt React‑Frontends mit Go + PostgreSQL Backends (und Flutter für Mobile) und ist eine praktische Umgebung, um Design‑zu‑Produktion‑Workflows Ende‑zu‑Ende zu validieren, inklusive Iteration, Deployment und Quellcode‑Export.

Prüft eine Figma‑Datei auf Token‑Nutzung, stimmt Benennungen mit euren Code‑Variablen ab und mapped 5–10 Kernkomponenten Ende‑zu‑Ende. Das reicht, um spürbare Verbesserungen zu sehen.

Es umfasst mehr als nur visuelle Stile:

Ein statischer Frame kann all diese Entscheidungen nicht allein kodieren.

„Produktionsfertig“ bedeutet vor allem Wartbarkeit und Wiederverwendbarkeit, nicht perfekte Pixel. Eine teamfreundliche Definition umfasst in der Regel:

Pixelgenaue Exporte, die Stile duplizieren und Werte hardcoden, erhöhen oft die langfristigen Kosten.

Fangt mit einer überprüfbaren Checkliste an, die das Team leicht verifizieren kann:

KI hilft am meisten bei sich wiederholenden und prüfungsintensiven Aufgaben:

Sie ist ein Multiplikator für Konsistenz, ersetzt aber keine technischen Entscheidungen.

KI liest Struktur und Beziehungen, nicht „Intent“ so wie Menschen. Sie verlässt sich auf:

Sind diese Signale schwach (zufällige Namen, detached Instanzen, manuelle Abstände), muss die KI raten — und das Ergebnis wird unvorhersehbarer.

Priorisiert Vorhersagbarkeit:

Das macht die Generierung von „Best Guess“ zu „verlässlichem Mapping“.

Token-Drift ist, wenn „nah genug“ Werte eingeschlichen werden (z. B. 12px vs. 13px Abstände, nahezu identische Blautöne). Das ist teuer, weil:

KI kann Nahe‑Duplikate markieren und zeigen, wo sie vorkommen, aber das Team muss die Konsolidierungsentscheidung treffen.

Eine praktische Aufteilung:

KI kann vorschlagen, welcher Weg passt, aber ihr solltet eine schriftliche Regel durchsetzen, damit Entscheidungen konsistent bleiben.

Nutzt KI, um aufgabenfertigen Text an ein Frame/Komponente zu binden:

Fügt die Ausgabe in Tickets und PR‑Templates ein, damit Reviewer immer dieselben Anforderungen prüfen.

Behandelt es als kontinuierliches Guardrail, nicht als späte Prüfung:

Macht Ergebnisse umsetzbar: jedes Problem sollte auf eine bestimmte Komponente/Frame verweisen und eine kleinste praktikable Korrektur vorschlagen.

Wenn ihr es nicht messen könnt, werdet ihr darüber in PRs streiten.