Warum die Idee der gespeicherten Programme wichtig ist

Im Kern der modernen Informatik steht eine einfache Frage: Was machte es möglich, dass eine Maschine viele verschiedene Aufgaben erfüllt, ohne jedes Mal umgebaut werden zu müssen? Frühe elektronische Rechner konnten zwar schnell rechnen, aber um die Aufgabe zu ändern, musste oft physisch an der Maschine verändert werden. Die Idee der gespeicherten Programme ist der Wendepunkt, der Computer wirklich programmierbar machte.

Die gespeicherte Programmidee, einfach gesagt

Ein speicherprogrammierter Computer legt die Anweisungen für eine Aufgabe (das Programm) im gleichen internen Speicher ab wie die Daten, an denen das Programm arbeitet. Statt Hardware umzustecken oder Schaltfelder neu zu konfigurieren, lädt man einen neuen Instruktionssatz in den Speicher und führt eine andere Aufgabe aus.

Das klingt heute banal, war aber ein tiefgreifender Wandel:

- Der Computer wird zu einem Allzweckwerkzeug, nicht zu einer Einzweckmaschine.

- Programme werden zu Information — etwas, das man bearbeiten, speichern, kopieren und teilen kann.

- Softwareentwicklung wird praktisch: man kann Anweisungen schreiben, testen und verbessern, ohne die Maschine neu aufzubauen.

Was dieser Artikel behandelt (und warum es noch Relevanz hat)

Das ist keine bloße historische Fußnote. Das Konzept erklärt, warum „Software“ als etwas Eigenständiges neben „Hardware“ existiert und warum ein Update heute neue Funktionen bringen kann, ohne die Chips auszutauschen.

In den folgenden Abschnitten betrachten wir die Probleme der frühen Rechner, was die gespeicherte‑Programm‑Lösung änderte, die Personen und Dokumente, die die Idee klärten (einschließlich des berühmten EDVAC‑Berichts), und wie der Begriff „von‑Neumann‑Architektur“ zu einem weit verbreiteten Entwurfsmodell wurde.

Ein kurzer Hinweis zur Zuschreibung

Obwohl John von Neumanns Name stark mit gespeicherten Programmen verbunden ist, wird die Anerkennung auf ein breiteres Team und eine ganze Epoche verteilt. Viele Forscher näherten sich ähnlichen Ideen, während sie die ersten praktischen elektronischen Computer bauten. Dieser Artikel behält diesen Kontext bei, weil das Verständnis der Teamleistung erklärt, wie sich die Idee so rasch verbreiten und zum Standardmodell werden konnte.

Vor der Idee der gespeicherten Programme: Wenn eine Aufgabenänderung Verkabelung bedeutete

Vor der gespeicherten‑Programm‑Idee „liefen“ viele frühe Computer nicht im heutigen Sinn. Sie rechneten zwar beeindruckend, aber das Sagen, was zu tun ist, bedeutete häufig, die Maschine physisch zu verändern.

„Hardware‑Programmierung“ in der Praxis

Eine verbreitete Methode waren Stecktafeln, Patchkabel und Schaltfelder. Bediener verbanden Steckkontakte, stellten Schalterreihen ein und passten manchmal Timing‑Elemente an, damit Signale in der richtigen Reihenfolge ankamen. Das „Programm“ war kein Datei‑Ladevorgang, sondern ein temporäres Verdrahtungsschema.

Dieses Vorgehen funktionierte, hatte aber versteckte Kosten: jede neue Aufgabe war ein kleines Ingenieursprojekt. Wollte man die Reihenfolge von Operationen ändern (addieren, multiplizieren, vergleichen, Schleifen), musste man vielleicht Dutzende oder Hunderte Verbindungen verschieben. Ein falsch gestecktes Kabel konnte subtile Fehler verursachen, weil die Logik über Hardwareverbindungen verteilt und nicht als lesbare Schritte dokumentiert war.

Warum das Wechseln von Aufgaben teuer war

Umkonfigurieren konnte Stunden oder Tage dauern, besonders wenn die Maschine dafür abgeschaltet, neu verkabelt und getestet werden musste. Das führte zu geringer Flexibilität: Maschinen waren oft längere Zeit für einen bestimmten Berechnungstyp verplant, weil ein Wechsel so störend war.

Ein einfaches Beispiel

Stellen Sie sich eine Maschine vor, die für die Berechnung von ballistischen Tabellen eingerichtet ist — lange, repetitive Rechnungen mit einer festen Formel. Wollte man dieselbe Maschine danach für die Aufbereitung statistischer Ergebnisse einer Volkszählung einsetzen, war das kein schnelles „Programm editieren und erneut ausführen“. Ablaufreihenfolge, Zwischenspeicher und bedingte Prüfungen konnten sich unterscheiden und erforderten ein vollständiges Neudesign der Stecktafel und erneute Verifikation.

Genau aus dieser Welt sollte der speicherprogrammierte Computer ausbrechen.

Der speicherprogrammierte Computer, einfach erklärt

Ein speicherprogrammierter Computer ist eine Maschine, in der die Anweisungen (das Programm) im gleichen Arbeits‑Speicher liegen wie die Daten, mit denen das Programm arbeitet. Anders gesagt: der Rechner trennt nicht zwischen „was zu tun ist“ und „worauf gearbeitet wird“ — beides sind Bit‑Muster im Speicher.

Was „Speicher“ hier bedeutet

Als die Pioniere vom Speicher sprachen, meinten sie das schnelle, direkt nutzbare interne Speichersystem — das, was wir heute am ehesten mit RAM vergleichen. Es ist der Ort, von dem die CPU schnell lesen und in den sie schreiben kann, während sie läuft.

Das unterscheidet sich vom langfristigen Speicher wie Festplatten oder SSDs. Solche Laufwerke sind gut zum Aufbewahren von Dateien bei ausgeschaltetem Gerät, aber sie sind nicht das unmittelbare Notizblatt, von dem die CPU konstant die nächste Anweisung holt oder Zwischenergebnisse aktualisiert.

Die zentrale Konsequenz: Aufgabe ändern, ohne die Maschine zu ändern

Sobald Anweisungen im Speicher liegen, wird das Umschalten von Aufgaben deutlich einfacher: man lädt ein neues Programm in den Speicher und führt es aus, ohne umzubauen, umzustecken oder mechanisch neu zu konfigurieren. Dieselbe Allzweckmaschine kann morgens Löhne berechnen und nachmittags ballistische Aufgaben übernehmen — weil das „Wie“ der Aufgabe nur ein anderer Satz von Bits ist, den man ersetzen kann.

Eine alltägliche Analogie

Stellen Sie sich eine Küche vor, in der Rezept und Zutaten im gleichen Vorratsschrank aufbewahrt werden. Der Koch (die CPU) geht wiederholt in den Schrank (Speicher), liest den nächsten Rezeptschritt (die Anweisung) und holt oder ändert Zutaten (Daten).

Möchten Sie ein anderes Gericht, müssen Sie die Küche nicht umbauen. Sie tauschen nur das Rezept — und benutzen dieselben Arbeitsflächen, den Ofen und die Utensilien.

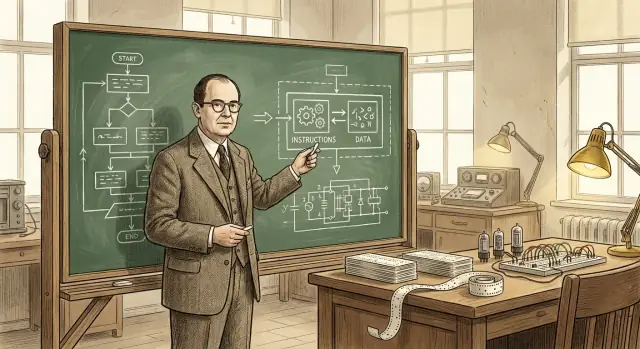

John von Neumanns Rolle (und warum sein Name blieb)

John von Neumann „erfand“ den Computer nicht allein, und er entwickelte die Idee der gespeicherten Programme nicht im Alleingang. Was er jedoch sehr wirkungsvoll tat, war, ein vielversprechendes Konzept in eine klar formulierte, weithin verbreitete Entwurfsvorlage zu gießen, auf die andere Ingenieure und Labore aufbauen konnten.

Ein bedeutender Beitrag — und ein ungewöhnlich guter Kommunikator

Von Neumann war in Kriegs‑ und Nachkriegsprojekten der Rechenmaschinen beratend tätig, half Teams und schärfte die logische Struktur früher Entwürfe. Er hatte ein Talent, komplexe technische Entscheidungen klar und organisiert zu erklären. Das war wichtig, weil die Entwicklung elektronischer Rechner schnell voranschritt und mehrere Gruppen gleichzeitig ähnliche Probleme lösten.

Außerdem verfasste und verbreitete er einflussreiche Beschreibungen, wie ein Computer Programm‑Instruktionen im gleichen Speicher wie Daten halten kann. Diese klare Darstellung erleichterte es anderen, die Idee zu diskutieren, zu lehren und nachzubauen.

Warum sein Name an der Architektur kleben blieb

Namen bleiben oft an der Person haften, deren Darstellung zum Referenzpunkt wird — nicht unbedingt an der ersten Person mit einer Idee. Von Neumanns Ausarbeitungen wurden breit gelesen, kopiert und zitiert, sodass spätere Leser die Organisation der gespeicherten Programme natürlich mit ihm assoziierten.

Diese Zuschreibung vereinfacht die Geschichte: „von‑Neumann‑Architektur“ zu sagen ist leichter, als alle Beitragenden und Berichte aufzuzählen. Dabei verliert man jedoch leicht den differenzierten Blick auf die tatsächlichen Abläufe.

Ein Gemeinschaftswerk, kein Einzelereignis

Die frühe elektronische Datenverarbeitung war eine kooperative Anstrengung von Mathematikern, Ingenieuren und Programmierern. Die gespeicherte‑Programm‑Idee reifte durch Diskussionen, Entwürfe, Prototypen und Revisionen in mehreren Teams. Von Neumanns bleibende Rolle war es, die Idee zu kristallisieren und zu verbreiten — ihre Verbreitung zu beschleunigen — nicht, sie allein erfunden zu haben.

EDVAC (Electronic Discrete Variable Automatic Computer) war eines der frühen Nachkriegsprojekte, das über „Einzelmaschinen“ hinausgehen wollte. Mindestens ebenso wichtig wie die Hardware war die Entscheidung, die Entwurfsprinzipien schriftlich festzuhalten und damit teilbar zu machen. Damals war Rechnerbau noch eng mit experimenteller Ingenieursarbeit verknüpft — Wissen lebte in Laborheften, Meetings und den Köpfen weniger Spezialisten. Ein Bericht konnte diese verstreuten Einsichten in eine Form bringen, die andere Teams diskutieren, kritisieren und wiederverwenden konnten.

Der First Draft of a Report on the EDVAC (häufig schlicht „EDVAC‑Bericht“) legte die gespeicherte‑Programm‑Idee konzeptuell dar: Ein Computer sollte Programm‑Instruktionen im gleichen internen Speicher wie Daten halten. Der Speicher ist nicht nur ein Ort, um Zahlen während einer Berechnung temporär zu halten — er enthält auch die Schritte, die der Maschine sagen, was als Nächstes zu tun ist.

Diese Darstellung macht aus einem Computer weniger ein festes Zweckgerät und mehr eine allgemeine Maschine, die durch Ändern des Speicherinhalts „umprogrammiert“ werden kann. Statt das System neu zu verkabeln, lädt man eine andere Instruktionsfolge.

Warum das für andere wichtig war

Über das Konzept hinaus half der Bericht, die gemeinsame Sprache für Rechner zu standardisieren: Speicher, Steuerwerk, Rechenwerk und Ein/Ausgabe als getrennte funktionale Teile, die zusammenarbeiten. Eine geteilte Begrifflichkeit und eine weit verbreitete Beschreibung erklärten nicht nur EDVAC — sie gaben der ganzen Fachwelt ein gemeinsames Denkmodell zum Bauen, Vergleichen und Verbessern speicherprogrammierter Computer.

Gemeinsame Anerkennung: Das Team hinter frühen speicherprogrammierten Überlegungen

Die Frage „Wer hat den speicherprogrammierten Computer erfunden?“ lädt fast zwangsläufig zu einer Ein‑Namen‑Antwort ein — aber Wissenschaft und Technik funktionieren selten so. Ideen entwickeln sich oft parallel, werden durch Diskussionen geschärft und überzeugend, wenn sie in Hardware demonstriert werden.

Wichtige Mitwirkende und parallele Arbeiten

John von Neumann ist eng mit der Idee verbunden, doch die frühe Arbeit umfasste viele Personen und Gruppen:

- J. Presper Eckert und John Mauchly (ENIAC/EDVAC‑Arbeit): zentral für den ingenieurmäßigen Vorstoß zu praktischen elektronischen Rechnern und verbesserten Entwürfen.

- Herman Goldstine: wichtiger Organisator und Vermittler zwischen Mathematikern und Ingenieuren sowie Schlüsselfigur bei Dokumentation und Verbreitung von Ideen.

- Arthur Burks: trug zur frühen logischen Gestaltung bei und lieferte später Berichte zur Formalisierung dieser Architekturen.

- Alan Turing: verfasste einflussreiche Vorüberlegungen zu universeller Berechenbarkeit und programmgesteuerten Maschinen.

- Maurice Wilkes (EDSAC) sowie Frederic Williams & Tom Kilburn (Manchester): zeigten in frühen Demonstrationen und mit Fortschritten im Speicher, dass speicherprogrammierte Systeme praktisch funktionieren konnten.

Warum „wer hat es erfunden“ kompliziert ist

Ein speicherprogrammierter Computer ist kein einzelner Geistesblitz. Er vereint (1) die konzeptionelle Einsicht, dass Anweisungen wie Daten im Speicher liegen können, (2) das Ingenieurwissen zum Bau zuverlässiger Speicher‑ und Steuerwerke und (3) Programmierpraktiken, die das Design nutzbar machen. Verschiedene Personen trugen zu verschiedenen Teilen bei.

Vorslagen versus Umsetzung

Ein weiterer Grund für die gemeinsame Anerkennung: Einen Vorschlag zu machen ist nicht dasselbe wie eine Maschine zu bauen, die zuverlässig Tag für Tag läuft. Berichte und Diskussionen machten das Konzept klarer; Prototypen und Produktionssysteme bewiesen die Umsetzbarkeit. Eine sorgfältige Geschichte würdigt beide Arten von Beiträgen, ohne einen simplen „Erfinder“ zu verlangen.

Was man unter „von‑Neumann‑Architektur“ versteht

Wenn Leute von „von‑Neumann‑Architektur“ sprechen, meinen sie meist ein einfaches, oft gelehrtes Modell, wie ein speicherprogrammierter Computer organisiert ist. Es ist kein Markenname oder eine einzelne historische Maschine — sondern eine praktische Bezeichnung für ein Grundkonzept, das in vielen Computern wiederkehrt.

Das übliche Blockdiagramm: CPU, Speicher und Ein/Ausgabe

Konzeptionell sieht das Modell so aus:

- CPU (Central Processing Unit): der Arbeiter, der Operationen ausführt.

- Speicher: der Ort, an dem der Computer sowohl Programm‑Instruktionen als auch die Daten hält, mit denen das Programm arbeitet.

- Ein/Ausgabe (I/O): Wege hinein und heraus — Tastatur, Festplatte, Bildschirm, Netzwerk, Sensoren usw.

Der Kernpunkt: Die CPU hat keinen separaten physischen Ort für „das Programm“ und „die Zahlen“. Sie holt alles aus dem Speicher.

Wie Instruktionen ablaufen: fetch–decode–execute

Die CPU arbeitet ein Programm ab, indem sie meist eine Schleife durchläuft, die man als fetch–decode–execute beschreibt:

- Fetch: die nächste Instruktion aus dem Speicher lesen.

- Decode: interpretieren, was die Instruktion verlangt (addieren, vergleichen, laden, speichern, springen …).

- Execute: die Aktion ausführen, oft mit Lesen/Schreiben von Speicher oder Interaktion mit I/O.

Die Beschreibung ist vereinfacht, fasst aber das Wesentliche: Das Programm ist eine Folge von im Speicher abgelegten Instruktionen, die die CPU schrittweise abarbeitet.

Warum „Instruktionen und Daten im gleichen Speicher“ mächtig ist

Instruktionen und Daten im selben Speicher zu haben macht einen Computer auf praktische Weise allgemein nutzbar:

- Um das Verhalten zu ändern, ändert man meist das Programm im Speicher, nicht die Verdrahtung.

- Programme können Instruktionen als Information behandeln — sie kopieren, laden oder sogar verändern sie (auch wenn moderne Systeme dies aus Sicherheitsgründen oft einschränken).

- Werkzeuge wie Assembler, Compiler und Betriebssysteme werden einfacher, weil „ein Programm“ einfach eine weitere Art gespeicherter Information ist.

Ein nützlicher Begriff, kein Anspruch auf alleinige Erfindung

„Von‑Neumann‑Architektur“ ist am besten als Kurzbezeichnung für das speicherprogrammierte Modell mit CPU, gemeinsamem Instruktions‑/Datenspeicher und I/O zu verstehen — stark mit von Neumanns klaren Erklärungen verbunden, auch wenn viele am Entstehen der Idee beteiligt waren.

Von‑Neumann vs. Harvard: Zwei Wege, Instruktionen und Daten zu organisieren

Man spricht oft, als seien „von‑Neumann“ und „Harvard“ konkurrierende Philosophien. Tatsächlich sind es zwei praktische Möglichkeiten, wie Instruktionen und Daten angeordnet werden, damit der Rechner sie abrufen kann.

Von‑Neumann‑Stil: ein Speicher, geteilter Weg

In einem von‑Neumann‑Design leben Instruktionen und Daten im gleichen Speicher und laufen meist über denselben Pfad zur CPU.

Das ist konzeptionell einfach: Programm‑Bytes liegen direkt neben Zahlen, Texten und Bildern. Es macht allgemeines Rechnen unkompliziert — Software lässt sich mit denselben Mechanismen wie Daten laden, ändern und speichern.

Der Nachteil: Wenn Instruktionen und Daten sich die „Straße“ teilen, konkurrieren sie um Bandbreite. (Man spricht hier manchmal vom „Bottleneck“.)

Harvard‑Stil: getrennte Speicher (und oft getrennte Wege)

Eine Harvard‑Architektur trennt Instruktions‑ von Datenspeicher, oft mit separaten Pfaden für jeden.

Diese Trennung erleichtert es, die nächste Instruktion zu holen, während gleichzeitig Daten gelesen oder geschrieben werden — nützlich in kleinen, voraussehbaren Systemen. Ein typisches Beispiel sind viele Microcontroller, bei denen der Programmcode in Flash liegt und Variablen in RAM.

Warum viele reale Systeme beide Ideen mischen

Moderne CPUs wirken für Software oft wie von‑Neumann‑Maschinen (ein einheitlicher Adressraum), nutzen intern aber Harvard‑ähnliche Tricks. Ein Beispiel sind getrennte Instruktions‑ und Daten‑Caches (I‑Cache und D‑Cache). Für das Programm fühlt es sich wie ein einziger Speicher an, die Hardware kann jedoch Code und Daten effizienter holen.

Merke: Es gibt keinen universellen Sieger. Von‑Neumann betont Einfachheit und Flexibilität; Harvard betont Trennung und Durchsatz. Viele Systeme kombinieren beides, um Programmierbarkeit, Kosten, Energieverbrauch und Geschwindigkeit auszubalancieren.

Wie gespeicherte Programme modernes Programmieren ermöglichten

Ein speicherprogrammierter Computer lädt einen Instruktionssatz aus dem Speicher, führt ihn aus und kann später einen anderen laden. Dieser Wandel machte Software wiederverwendbar und teilbar: Ein Programm konnte einmal geschrieben, gespeichert, kopiert, verbessert und verteilt werden, ohne die Hardware zu berühren.

Von „dieser Maschine“ zu „jeder Aufgabe"

Wenn das Programm im Speicher liegt, kann dieselbe physische Maschine viele verschiedene Aufgaben erledigen, indem man einfach die Instruktionen austauscht. Das ist die praktische Bedeutung von „Allzweck“: eine Maschine, viele Programme. Der Computer ist nicht durch einen einzigen Workflow definiert, sondern wird zur Plattform.

Ein aktuelles Beispiel ist Ihr Laptop, der E‑Mail, Spiele und Tabellenkalkulationen ausführt — alles dieselbe Grundidee: die Hardware bleibt, die Programme wechseln.

Warum das echte Programmierwerkzeuge ermöglichte

Sobald Instruktionen wie Daten behandelt werden, wird es möglich, Software‑Schichten zu bauen, die das Schreiben von Software erleichtern:

- Assembler erlauben mnemonische statt numerische Codes.

- Compiler übersetzen höherwertige Sprachen in Maschineninstruktionen und machen Programme leichter wartbar.

- Betriebssysteme verwalten das Laden von Programmen, die gemeinsame Nutzung von Speicher und Geräten sowie die Planung, damit mehrere Programme koexistieren.

Diese Werkzeuge beruhen auf der Annahme, dass Programme gespeichert, bewegt und manipuliert werden können wie andere Daten. So wurde Software zu einem Ökosystem statt zu einem einmaligen Artefakt.

Ein nützlicher Blick zurück: gespeicherte Programme ermöglichten Compiler und OS, die bessere Entwicklerwerkzeuge erlaubten — heute sehen wir weitere Abstraktionsebenen, bei denen man eine Anwendung in natürlicher Sprache beschreiben und Tools daraus produktiven Code erzeugen lassen kann. Zum Beispiel ist Koder.ai eine Plattform, bei der man Web‑, Backend‑ oder Mobile‑Apps per Chat‑Interface erstellt und auf LLMs sowie agentenbasierten Workflows setzt, um schneller von der Idee zum lauffähigen Code zu kommen.

Das Ergebnis bleibt derselbe positive Kreislauf: gespeicherte Programme machten bessere Werkzeuge möglich, bessere Werkzeuge ermöglichten ehrgeizigere Programme — und verwandelten Computer in flexible, allgemeine Maschinen.

Die bekannte Einschränkung: der „von‑Neumann‑Flaschenhals"

Die Idee der gespeicherten Programme machte Computer flexibel, brachte aber auch eine praktische Einschränkung ans Licht, über die man bis heute spricht: den sogenannten „von‑Neumann‑Flaschenhals“. Bildlich gesprochen ist es ein Stau auf der Straße zwischen CPU (Arbeiter) und Speicher (Lager).

Ein Stau zwischen CPU und Speicher

In einem typischen speicherprogrammierten Entwurf liegen Instruktionen und Daten im Speicher. Die CPU holt eine Instruktion, dann die benötigten Daten, schreibt Ergebnisse zurück — häufig über denselben Verbindungsweg. Kann dieser Weg nicht genug Information schnell genug transportieren, bleibt die CPU oft untätig, obwohl sie rechnen könnte.

Warum sowohl Geschwindigkeit als auch Bandbreite zählen

Zwei Faktoren prägen diesen Flaschenhals:

- Speicherlatenz (Geschwindigkeit): wie lange es dauert, bis das erste Byte nach einer Anforderung ankommt.

- Speicherbandbreite: wie viel Information pro Sekunde bewegt werden kann.

Eine CPU kann Milliarden von Operationen pro Sekunde durchführen, aber wenn der Speicher nicht genug Daten liefert, bestimmt der langsamste Schritt die Leistung: das Ein‑ und Ausliefern der Bytes.

Übliche Abmilderungen (keine Wundermittel)

In der Praxis nutzen Rechner mehrere Techniken, um die Auswirkungen zu verringern:

- Caches: kleiner, schneller Speicher nahe der CPU, der kürzlich verwendete Instruktionen/Daten bereithält.

- Prefetching: Vorladen von vermuteten zukünftigen Daten.

- Parallelität: mehrere Dinge gleichzeitig tun (mehrere Kerne, Überlappung von Speicherzugriffen und Berechnung).

Diese Maßnahmen beseitigen den Flaschenhals nicht, sorgen aber dafür, dass die CPU mehr arbeitet und weniger wartet.

Wo Sie die Idee in heutigen Computern sehen

Die gespeicherte‑Programm‑Idee ist kein Museumsexponat — sie ist das Fundament der Flexibilität moderner Geräte. Ihre Geräte müssen nicht „umverdrahtet“ werden, um Neues zu tun; sie laden einfach andere Instruktionen in den Speicher und führen diese aus.

Telefone, Laptops und Server: derselbe Trick

Auf einem Smartphone lädt das Betriebssystem beim Antippen eines App‑Icons den Code (Instruktionen) vom dauerhaften Speicher in den Arbeitsspeicher, und die CPU führt ihn aus. Auf einem Laptop passiert dasselbe, wenn Sie einen Browser öffnen, ein Dokument bearbeiten oder ein Spiel starten. Auf Servern ist es noch offensichtlicher: Tausende wechselnder Workloads laufen auf derselben Hardware — Webanfragen, Datenbankabfragen, Hintergrundjobs — ohne Hardwareänderung.

Viele der Funktionen, die wie „Hardware“ wirken (Routing, Video‑Decoding, Fotoverbesserung, Energiemanagement), werden oft per Firmware und Systemsoftware aktualisiert — neue Instruktionen, gleiches Gerät.

Interpreter und virtuelle Maschinen führen weiterhin gespeicherte Instruktionen aus

Sprachen wie Python und JavaScript laufen oft über einen Interpreter oder eine VM. Der Quellcode wird in strukturierte Formen (Bytecode oder interne Instruktionen) übersetzt, die im Speicher abgelegt und schrittweise ausgeführt werden. JVM, .NET, WebAssembly‑Runtimes und Browser‑Engines folgen diesem Muster: Instruktionen werden als Datenstrukturen geladen, bewegt und ausgeführt.

Ein Sicherheitshinweis: wenn Daten zu Instruktionen werden

Weil Instruktionen „nur“ Information sind, versuchen Angreifer manchmal, bösartigen Code als Daten einzuschleusen — klassisches Code‑Injection. Schutzmechanismen wie Speicher‑Schutz, Code‑Signing und nicht‑ausführbare Speicherregionen verhindern, dass unzuverlässige Daten als ausführbare Instruktionen gehandhabt werden.

Das alles führt zurück zum zentralen Versprechen der gespeicherten Programme: Flexibilität durch Software — neues Verhalten auf derselben Hardware.

Wichtige Erkenntnisse und Lektüreempfehlungen

Wichtige Erkenntnisse

- Ein speicherprogrammierter Computer hält Programm‑Instruktionen im gleichen beschreib‑ und löschbaren Speicher wie Daten, sodass man das Verhalten durch Ändern des Speichers statt durch Umbau ändern kann.

- Die Bezeichnung „von‑Neumann‑Architektur“ bezieht sich meist auf eine praktische Organisation (CPU + Speicher + Ein/Ausgabe) mit gemeinsamem Instruktions‑ und Datenspeicher und nicht auf den Anspruch, ein einzelner Mensch habe alles erfunden.

- Frühe Überlegungen zu gespeicherten Programmen waren Teamarbeit: EDVAC‑Diskussionen und ‑Berichte halfen, die Idee klar zu formulieren, und mehrere Projekte zeigten die technische Umsetzbarkeit.

- Gespeicherte Programme machten modernes Programmieren möglich, weil sie wiederverwendbaren Code, Bibliotheken, Compiler und Betriebssysteme ermöglichten — alles basierend auf der Annahme, dass Software Daten sind, die die Maschine laden und ausführen kann.

Kurze Fragen, um eine Architektur zu erkennen

Wenn Sie einen Rechner betrachten (oder ein Datenblatt lesen), helfen diese Fragen, das Grundmodell zu erkennen:

- Wo werden Instruktionen zur Laufzeit gespeichert: im gleichen Speicher wie Daten oder getrennt?

- Teilen Instruktionen und Daten denselben Bus/Pfad, oder gibt es getrennte Wege (wie bei Harvard‑Designs)?

- Kann das System Code verändern oder erzeugen und anschließend ausführen (klassische Fähigkeit speicherprogrammierter Systeme), oder ist der Code fest/isoliert?

- Wird „Programmspeicher“ als Flash/ROM beschrieben, während „Datenspeicher“ RAM ist (ein Hinweis auf Harvard‑Trennung bei vielen Mikrocontrollern)?

Empfohlene nächste Lektüren

- Bücher: Herman H. Goldstines The Computer from Pascal to von Neumann; allgemeine Übersichten zur Rechnergeschichte, die ENIAC/EDVAC/IAS behandeln.

- Museen: Computer History Museum; Science Museum (Sammlung zur Datenverarbeitung); Smithsonian (Technologiegeschichte).

- Archive und Fachzeitschriften: IEEE‑ und ACM‑Geschichtsartikel (inklusive Oral‑Histories) sowie Universitätsarchive mit frühen Computerunterlagen.

Wenn Sie mehr leicht zugängliche Beiträge wie diesen möchten, stöbern Sie in /blog.

Hinweis: Wenn Sie moderne Wege ausprobieren, Instruktionen in laufende Systeme zu überführen — sei es durch direktes Programmieren oder chatgesteuerte Build‑Plattformen wie Koder.ai — dokumentieren Sie, was Sie lernen. Koder.ai bietet außerdem ein Earn‑Credits‑Programm für veröffentlichte Inhalte und Empfehlungen, das eine praktische Finanzierung für weitere Experimente und Tutorials sein kann.