Was „Vibe Coding“ vs. „Production Hardening“ wirklich bedeutet

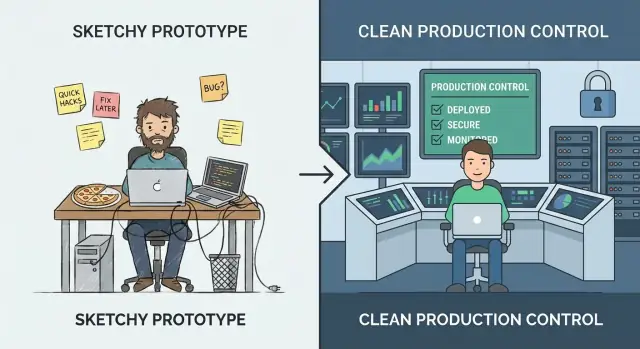

„Vibe-Coding“ ist die Phase, in der Geschwindigkeit vor Präzision geht. Du experimentierst, lernst, was Nutzer tatsächlich wollen, und probierst Ideen aus, die vielleicht nicht mal die Woche überleben. Das Ziel ist Erkenntnis: einen Workflow validieren, einen Wertversprechen beweisen oder bestätigen, dass die benötigten Daten überhaupt existieren. In diesem Modus sind raue Kanten normal — manuelle Schritte, schwache Fehlerbehandlung und Code, der darauf optimiert ist, schnell „funktionierend“ zu sein.

„Production-Hardening“ ist anders. Es geht darum, Verhalten unter realer Nutzung vorhersehbar zu machen: unordentliche Eingaben, Teilausfälle, Spitzenlast und Menschen, die Dinge tun, die du nicht erwartet hast. Hardening bedeutet weniger neue Features hinzufügen, sondern Überraschungen reduzieren — damit das System kontrolliert ausfällt, sauber wiederherstellt und für die nächste Person, die es betreiben muss, verständlich bleibt.

Zu früh vs. zu spät umschalten

Wenn du zu früh härtest, kannst du das Lernen verlangsamen. Du investierst möglicherweise in Skalierbarkeit, Automation oder polierte Architektur für eine Produktrichtung, die sich nächste Woche ändert. Das ist teuer und kann ein kleines Team blockieren.

Wenn du zu spät härtest, erzeugst du Risiko. Die gleichen Abkürzungen, die für eine Demo ok waren, werden zu kundenwirksamen Vorfällen: Dateninkonsistenz, Sicherheitslücken und Ausfallzeiten, die Vertrauen beschädigen.

Du musst dich nicht für eines für immer entscheiden

Ein praktischer Ansatz ist, weiter zu experimentieren und gleichzeitig die „dünne Taille“ des Systems zu härten: die wenigen Schlüsselpfade, die zuverlässig sein müssen (Signup, Zahlungen, Daten-Schreibvorgänge, kritische Integrationen). An den Randfunktionen kannst du weiterhin schnell iterieren — lass nur nicht zu, dass Prototyp-Annahmen die Teile bestimmen, auf die echte Nutzer jeden Tag angewiesen sind.

Hier spielen auch Tooling-Entscheidungen eine Rolle. Plattformen, die für schnelles Iterieren gebaut sind, können dir helfen, im „Vibe“-Modus zu bleiben, ohne die Möglichkeit zu verlieren, später zu professionalisieren. Zum Beispiel ist Koder.ai so konzipiert, dass es Vibe-Coding per Chat für Web-, Backend- und Mobile-Apps erleichtert, unterstützt aber auch Source-Export, Deployment/Hosting, Custom Domains und Snapshots/Rollback — Funktionen, die direkt zur „dünnen Taille“-Mentalität passen (schnell liefern, aber kritische Pfade schützen und schnell wiederherstellen).

Ein einfaches Reifegradmodell: Von Demo zu verlässlich

Vibe-Coding glänzt, wenn du schnell lernen willst: funktioniert diese Idee überhaupt? Der Fehler ist, anzunehmen, dieselben Gewohnheiten hielten sich, wenn echte Menschen (oder echte Geschäftsprozesse) vom Ergebnis abhängen.

Die Phasen, die Teams meist durchlaufen

Eine nützliche Einteilung, um zu entscheiden, was gehärtet werden sollte:

- Idea: Machbarkeit erkunden; wegwerfbarer Code ist ok.

- Demo: Klickbarer oder ausführbarer Proof; Erfolg ist „es zeigt das Konzept“.

- Pilot: Ein kleiner, realer Workflow; Erfolg ist „es hilft einigen Leuten zuverlässig“.

- Beta: Breitere Zugänglichkeit; Erfolg ist „es funktioniert meist, mit Support“.

- Production: Standardwerkzeug für eine Aufgabe; Erfolg ist „es ist verlässlich, sicher und wartbar“.

Wie sich Anforderungen ändern, wenn Ergebnisse zählen

Wenn du dich rechts bewegst, verschiebt sich die Frage von „Funktioniert es?“ zu „Können wir ihm vertrauen?“ Das bringt Erwartungen wie vorhersehbare Performance, klare Fehlerbehandlung, Auditierbarkeit und die Möglichkeit, Änderungen zurückzunehmen. Es zwingt dich auch, Ownership zu definieren: Wer ist verantwortlich, wenn etwas kaputtgeht?

Die Kostenkurve, die niemand liebt

Bugs, die in Idea/Demo behoben werden, sind billig, weil du Code änderst, auf den sich niemand verlässt. Nach dem Launch kann derselbe Bug Supportzeit, Datenbereinigung, Kundenabwanderung oder verpasste Deadlines auslösen. Hardening ist kein Perfektionismus — es reduziert den Blast-Radius unvermeidlicher Fehler.

„Produktion“ ist nicht nur kundenseitig

Ein internes Tool, das Rechnungen auslöst, Leads routet oder Zugriffe steuert, ist bereits Produktion, wenn das Geschäft davon abhängt. Wenn ein Ausfall Arbeit stoppt, Daten offenlegt oder finanzielles Risiko schafft, behandle es wie Produktion — selbst wenn nur 20 Leute es nutzen.

Signale, dass du die Prototyp-Phase hinter dir gelassen hast

Ein Prototyp darf fragil sein. Er beweist eine Idee, eröffnet ein Gespräch und hilft dir, schnell zu lernen. Ab dem Moment, in dem echte Leute ihn nutzen, steigen die Kosten von „Quick Fixes“, und die Risiken verschieben sich von ärgerlich zu geschäftsrelevant.

Die deutlichsten Signale

Dein Publikum ändert sich. Wenn die Nutzerzahl stetig steigt, du zahlende Kunden hinzugewonnen hast oder Verträge mit Verfügbarkeits-/Antwortzeit-Erwartungen unterschrieben wurden, experimentierst du nicht mehr — du lieferst einen Service.

Die Daten werden sensibler. An dem Tag, an dem dein System PII (Namen, E-Mails, Adressen), Finanzdaten, Zugangsdaten oder private Dateien berührt, brauchst du stärkere Zugriffskontrollen, Audit-Trails und sichere Defaults. Ein Prototyp kann „sicher genug für eine Demo“ sein. Reale Daten dürfen das nicht.

Nutzung wird routinemäßig oder geschäftskritisch. Wenn das Tool Teil des täglichen Workflows wird — oder Ausfälle Bestellungen, Reporting, Onboarding oder Support blockieren — sind Ausfallzeiten und seltsame Randfälle nicht mehr akzeptabel.

Andere Teams sind von deinen Ausgaben abhängig. Wenn interne Teams Prozesse um deine Dashboards, Exporte, Webhooks oder APIs bauen, wird jede Änderung potenziell zum Breaking Change. Du spürst den Druck, Verhalten konsistent zu halten und Änderungen zu kommunizieren.

Ausfälle werden wiederkehrend. Ein stetiger Strom von „es ist kaputt“-Meldungen, Slack-Pings und Support-Tickets ist ein starkes Indiz, dass du mehr Zeit mit Reagieren als mit Lernen verbringst. Das ist dein Signal, in Stabilität statt in Features zu investieren.

Ein schneller Bauch-Check

Wenn eine einstündige Störung peinlich wäre, näherst du dich der Produktion. Wenn sie teuer wäre — verlorene Umsätze, gebrochene Versprechen oder beschädigtes Vertrauen — dann bist du bereits dort.

Entscheide nach Risiko, nicht nach Gefühlen

Wenn ihr darüber streitet, ob die App „bereit“ ist, stellt ihr die falsche Frage. Die bessere Frage lautet: Was kostet es, falsch zu liegen? Production-Hardening ist kein Ehrenabzeichen — es ist eine Reaktion auf Risiko.

Definiere „Ausfall“ in klaren Begriffen

Schreibe auf, wie ein Ausfall für dein System aussieht. Häufige Kategorien:

- Downtime: Der Dienst ist gar nicht nutzbar

- Falsche Ergebnisse: Er läuft, liefert aber falsche Ausgaben (oft schlimmer als Downtime)

- Langsame Reaktionen: Nutzer brechen Aufgaben ab, Automatisierungen laufen aus, Supportanfragen steigen

Sei konkret. „Suche braucht 12 Sekunden für 20 % der Nutzer bei Peak“ ist handlungsfähig; „Performance-Probleme“ nicht.

Schätze den geschäftlichen Impact (auch grob)

Du brauchst keine exakten Zahlen — nutze Bereiche.

- Umsatz: verlorene Verkäufe, verpasste Renewals, SLA-Strafen

- Churn und Vertrauen: Nutzer kommen nach schlechter Erfahrung nicht zurück

- Produktivitätsverlust: Interne Teams blockiert, manuelle Workarounds häufen sich

- Compliance: Prüfungsbefunde, Vertragsverletzungen, Berichtspflichten

Wenn die Auswirkung schwer zu quantifizieren ist, frage: Wer wird gerufen? Wer entschuldigt sich? Wer zahlt?

Liste die größten Risiken, die ihr tragt

Die meisten Prototype‑zu‑Production‑Fehler fallen in einige Cluster:

- Datenverlust oder -korruption (keine Backups, unsichere Migrationen, schwache Zugriffskontrollen)

- Sicherheitsvorfall (geleakte Tokens, zu breite Berechtigungen, exponierte Endpunkte)

- Falsche Automatisierung (LLM-Aktionen oder Skripte, die in großem Maßstab falsche Änderungen durchführen)

Rangfolge nach Wahrscheinlichkeit × Auswirkung. Das wird deine Hardening‑Roadmap.

Wähle ein „gut genug“-Zuverlässigkeitsziel für deine Stufe

Vermeide Perfektion. Wähle ein Ziel, das zu den aktuellen Einsätzen passt — z. B. „Verfügbarkeit während Geschäftszeiten“, „99 % Erfolg für Kern‑Workflows“ oder „Wiederherstellung innerhalb 1 Stunde“. Wenn Nutzung und Abhängigkeit wachsen, erhöhe die Anforderungen gezielt statt in Panik zu reagieren.

Produktionsreife beginnt mit Ownership und Scope

„Hardening für Produktion“ scheitert oft aus einem einfachen Grund: Niemand kann sagen, wer das System End‑to‑End verantwortet, und niemand kann sagen, was „fertig“ bedeutet.

Bevor du Rate Limits, Load Tests oder einen neuen Logging‑Stack hinzufügst, sichere zwei Basics: Ownership und Scope. Sie verwandeln ein offenes Engineering‑Projekt in eine handhabbare Menge von Verpflichtungen.

Nenne einen Owner (End‑to‑End)

Schreibe auf, wer das System End‑to‑End besitzt — nicht nur den Code. Der Owner ist verantwortlich für Verfügbarkeit, Datenqualität, Releases und Nutzerauswirkungen. Das heißt nicht, dass die Person alles macht; es heißt, sie trifft Entscheidungen, koordiniert Arbeit und stellt sicher, dass jemand parat ist, wenn etwas schiefgeht.

Wenn Ownership geteilt ist, nenne trotzdem einen Primärverantwortlichen: eine Person/Team, das „ja/nein“ sagen kann und Prioritäten konsistent hält.

Definiere kritische Pfade zuerst

Identifiziere primäre Nutzerreisen und kritische Pfade. Das sind Flows, bei denen ein Fehler echten Schaden anrichtet: Signup/Login, Checkout, Nachricht senden, Datenimport, Berichtserstellung usw.

Sobald du kritische Pfade hast, kannst du selektiv härten:

- Setze Zuverlässigkeitsziele für diese Pfade zuerst.

- Entscheide, welche Daten niemals verloren gehen dürfen.

- Wähle die wenigen Metriken, die „funktionierend“ definieren.

Setze Scope, um endloses Härten zu vermeiden

Dokumentiere, was jetzt im Scope ist vs. später, um endloses Härten zu vermeiden. Produktionsreife ist nicht „perfekte Software“; es ist „sicher genug für dieses Publikum, mit bekannten Grenzen.“ Sei explizit, was du noch nicht unterstützt (Regionen, Browser, Spitzenlast, Integrationen).

Starte mit einem Runbook‑Skelett

Erstelle ein leichtgewichtiges Runbook‑Skelett: wie deployen, rollbacken, debuggen. Halte es kurz und brauchbar für 2 Uhr morgens — eine Checkliste, wichtige Dashboards, übliche Ausfallmodi und Ansprechpartner. Du kannst es im Laufe der Zeit erweitern, aber du kannst es während deines ersten Vorfalls nicht improvisieren.

Zuverlässigkeit: Mach das System unter Last vorhersehbar

Zuverlässigkeit bedeutet nicht, Ausfälle unmöglich zu machen — es bedeutet, Verhalten vorhersehbar zu machen, wenn etwas schiefgeht oder die Last steigt. Prototypen „laufen oft auf meiner Maschine“, weil Traffic gering ist, Eingaben freundlich sind und niemand denselben Endpoint gleichzeitig überlastet.

Setze Guardrails für jede Anfrage

Beginne mit langweiligen, aber wirksamen Verteidigungen:

- Eingabevalidierung an den Grenzen (API, UI‑Formulare, Webhook‑Payloads). Lehne fehlerhafte Daten früh mit einer klaren Fehlermeldung ab.

- Timeouts überall, wo du etwas Langsames oder Externes aufrufst (DBs, Drittanbieter‑APIs, Queues). Ein fehlender Timeout verwandelt ein kleines Hüpferchen in einen Stau.

- Retries, mit Bedacht: nur für sichere Operationen, mit exponentiellem Backoff + Jitter und begrenzten Versuchen. Blinde Retries können Ausfälle verschlimmern.

- Circuit Breaker, um aufzuhören, Abhängigkeiten anzurufen, die ausfallen, und automatisch wieder zu stabilisieren.

Sicher und sichtbar fehlschlagen

Wenn das System die volle Aufgabe nicht erledigen kann, sollte es immer noch das sicherste erledigen. Das kann bedeuten, einen gecachten Wert zu liefern, eine nicht‑kritische Funktion zu deaktivieren oder eine „versuche es später erneut“-Antwort mit einer Request‑ID zurückzugeben. Bevorzuge graceful degradation gegenüber stillen Teil‑Writes oder verwirrenden generischen Fehlern.

Nebenläufigkeit und Idempotenz sind keine Option

Unter Last passieren doppelte Requests und überlappende Jobs (Doppelklicks, Netzwerk‑Retries, Queue‑Redeliveries). Entwirf dafür:

- Mache Schlüsselaktionen idempotent (die gleiche Anfrage zweimal ergibt dasselbe Ergebnis).

- Nutze Locks oder optimistische Nebenläufigkeitskontrolle, wo nötig, um Race‑Conditions zu verhindern.

Schütze Datenintegrität

Zuverlässigkeit umfasst „keine Daten korruptieren“. Nutze Transaktionen für mehrstufige Schreibvorgänge, füge Constraints (Unique Keys, Foreign Keys) hinzu und pflege Migrationsdisziplin (rückwärtskompatible Änderungen, getestete Rollouts).

Erzwinge Ressourcenlimits

Setze Limits für CPU, Speicher, Connection Pools, Queue‑Größen und Request‑Payloads. Ohne Limits kann ein lauter Mandant — oder eine schlechte Query — alles ausdünsten.

Sicherheit: Die Mindestanforderung vor realen Nutzern

Security‑Hardening bedeutet nicht, den Prototyp in eine Festung zu verwandeln. Es bedeutet, einen Mindeststandard zu erfüllen, bei dem ein normaler Fehler — ein exponierter Link, ein geleakter Token, ein neugieriger Nutzer — nicht zu einem kundenwirksamen Vorfall wird.

Trennung: dev, staging, prod

Wenn du „eine Umgebung“ hast, hast du einen Blast‑Radius. Richte getrennte dev/staging/prod Setups mit minimal geteilten Secrets ein. Staging sollte der Produktion ähnlich genug sein, um Probleme zu zeigen, darf aber keine Produktions‑Zugangsdaten oder sensiven Daten wiederverwenden.

Authentifizierung und Autorisierung (AuthN/AuthZ)

Viele Prototypen enden bei „Login funktioniert“. Produktion erfordert least privilege:

- Definiere klare Rollen (z. B. Admin, Support, Standard‑User) und erzwinge Grenzen serverseitig.

- Sperre interne Tools und Admin‑Endpunkte ab.

- Halte Audit‑Trails für sensible Aktionen (Login, Passwort‑Reset, Rollenänderung, Exporte, Löschungen). Du brauchst keine perfekte Analyse — nur genug, um „wer hat was wann getan?“ beantworten zu können.

Geheimnisverwaltung: Keys raus aus Code und Logs

Verschiebe API‑Keys, Datenbankpasswörter und Signatur‑Secrets in einen Secrets‑Manager oder sichere Environment‑Variablen. Sorge dann dafür, dass sie nicht auslaufen:

- Drucke Tokens nicht in Anwendungs‑Logs.

- Vermeide, Secrets an Client‑Code zu senden.

- Rotieren jede Anmeldeinformation, die jemals in ein Repo committed wurde.

Frühe Prioritäten bei Bedrohungen

Du erzielst am meisten Wert, wenn du einige gängige Fehler modi adressierst:

- Injection (SQL/Command): parameterisierte Queries und sichere Bibliotheken verwenden.

- Broken Access Control: Berechtigungen bei jeder Anfrage prüfen, nicht nur in der UI.

- Datenexposition: Verschlüsselung in Transit, standardmäßig nur notwendige Daten zurückgeben und breitflächige Exporte vermeiden.

Patch‑Plan für Abhängigkeiten

Lege fest, wer Updates besitzt und wie oft du Dependencies und Basisimages patchst. Ein einfacher Plan (wöchentliche Prüfung + monatliche Upgrades, dringende Fixes innerhalb von 24–72 Stunden) ist besser als „machen wir später“.

Testen: Fehler finden, bevor Kunden sie sehen

Testing wandelt „funktioniert auf meiner Maschine“ in „funktioniert weiter für Kunden“. Ziel ist nicht perfekte Coverage — Ziel ist Vertrauen für Verhaltensweisen, deren Bruch am teuersten wäre: Abrechnung, Datenintegrität, Berechtigungen, Schlüssel‑Workflows und alles, was nach Deployment schwer zu debuggen ist.

Eine Testpyramide, die zur Realität passt

Eine praktische Pyramide sieht meist so aus:

- Unit‑Tests für reine Logik (schnell, viele davon)

- Integrationstests für Grenzfälle (DB, Queues, Drittanbieter hinter Mocks)

- E2E‑Tests für einige kritische Nutzerreisen (langsam, keep minimal)

Wenn deine App hauptsächlich API + DB ist, setzte stärker auf Integrationstests. Ist sie UI‑lastig, halte eine kleine Menge E2E‑Flows, die zeigen, wie Nutzer wirklich Erfolg (und Misserfolg) erleben.

Regressions‑Tests dort, wo es weh tut

Wenn ein Bug Zeit, Geld oder Vertrauen kostet, füge sofort einen Regressions‑Test hinzu. Priorisiere Verhaltensweisen wie „ein Kunde kann nicht auschecken“, „ein Job belastet doppelt“ oder „ein Update korruptiert Datensätze“. So wächst ein Sicherheitsnetz um die risikoreichsten Bereiche statt Tests überall zu verteilen.

Wiederholbare Integrationstests mit Seed‑Daten

Integrationstests sollten deterministisch sein. Nutze Fixtures und Seed‑Daten, sodass Testläufe nicht vom lokalen DB‑Zustand eines Entwicklers abhängen. Setze den Zustand zwischen Tests zurück und halte Testdaten klein, aber repräsentativ.

Du brauchst noch kein komplettes Lasttest‑Programm, aber schnelle Performance‑Checks für Schlüssendendpunkte und Background‑Jobs sind sinnvoll. Ein einfacher schwellenwertbasierter Smoke‑Test (z. B. p95 Antwortzeit unter X ms bei kleiner Parallelität) fängt offensichtliche Regressionen früh ab.

Automatisiere Checks im CI

Jede Änderung sollte automatisierte Gates durchlaufen:

- Linting und Formatierung

- Typprüfungen (falls anwendbar)

- Unit‑ + Integrationstest‑Suite

- Basis‑Security‑Scans (Dependency/Vulnerabilty‑Checks)

Wenn Tests nicht automatisch laufen, sind sie optional — und die Produktion wird das schließlich zeigen.

Observability: Wissen, was passiert, ohne zu raten

Wenn ein Prototyp kaputtgeht, kannst du oft „einfach nochmal versuchen“. In Produktion verwandelt sich dieses Raten in Ausfallzeiten, Churn und lange Nächte. Observability verkürzt die Zeit von „es fühlt sich falsch an“ zu „hier ist genau, was sich geändert hat, wo und wer betroffen ist“.

Starte mit Logs, die echte Fragen beantworten

Logge das, was wichtig ist, nicht alles. Du willst genug Kontext, um ein Problem zu reproduzieren, ohne sensible Daten auszudumpen.

- Füge eine Request‑ID zu jeder Anfrage hinzu und trage sie durch das System.

- Ergänze Nutzer-/Session‑IDs sicher (gehashte oder interne IDs; niemals rohe Passwörter, Zahlungsdaten oder Secrets).

- Zeichne Ergebnisse auf: Erfolg/Fehler, Statuscodes und aussagekräftige Fehlgründe.

Eine gute Regel: jedes Error‑Log sollte offensichtlich machen, was fehlgeschlagen ist und was als Nächstes zu prüfen ist.

Messe die „Golden Signals"

Metriken geben einen Live‑Puls. Mindestens solltest du die Golden Signals tracken:

- Latenz (wie langsam)

- Fehler (wie kaputt)

- Traffic (wie viel)

- Sättigung (wie nahe an Kapazität)

Diese Metriken helfen zu unterscheiden, ob mehr Nutzer da sind oder etwas schief läuft.

Tracing, wenn Requests Grenzen überschreiten

Wenn eine Nutzeraktion mehrere Services, Queues oder Drittanbieter‑Aufrufe auslöst, verwandelt Tracing ein Rätsel in eine Timeline. Selbst grundlegendes verteiltes Tracing zeigt, wo Zeit verbracht wird und welche Abhängigkeit ausfällt.

Alerts sollten handlungsfähig, nicht laut sein

Alert‑Spam gewöhnt Menschen an das Ignorieren. Definiere:

- Welche Bedingungen Paging verdienen (nutzerseitiger Impact)

- Wer ist on‑call und welche Reaktionszeiten gelten

- Was „gut“ aussieht (Schwellen, die an SLAs/SLOs gebunden sind)

Ein Dashboard, das die drei großen Fragen beantwortet

Baue ein einfaches Dashboard, das sofort beantwortet: Ist es down? Ist es langsam? Warum? Wenn es das nicht kann, ist es Zierde — keine Operations‑Ausrüstung.

Release und Betrieb: Änderungen ohne Drama ausrollen

Hardening betrifft nicht nur Codequalität — es geht auch darum, wie du das System änderst, sobald Leute darauf vertrauen. Prototypen tolerieren „push to main und hoffen“. Produktion nicht. Release‑ und Betriebspraktiken machen Releases zu Routine statt zu Hochrisiko‑Events.

Builds und Deploys standardisieren (CI/CD)

Mach Builds und Deploys wiederholbar, skriptbar und langweilig. Eine einfache CI/CD‑Pipeline sollte: Checks laufen lassen, das Artefakt auf dieselbe Weise bauen, jedes Mal in eine bekannte Umgebung deployen und genau aufzeichnen, was sich geändert hat.

Der Gewinn ist Konsistenz: Du kannst ein Release reproduzieren, zwei Versionen vergleichen und „läuft auf meinem Rechner“‑Überraschungen vermeiden.

Feature‑Flags, um sicher zu deployen

Feature‑Flags erlauben, Deploy (Code in Prod bringen) von Release (für Nutzer aktivieren) zu trennen. So kannst du kleine Änderungen häufig ausliefern, schrittweise freischalten und schnell wieder abschalten, falls etwas schiefgeht.

Halte Flags diszipliniert: klar benennen, Besitzer setzen und entfernen, wenn das Experiment vorbei ist. Permanente „mystery flags“ werden selbst zum Betriebsrisiko.

Definiere Rollback — und übe es

Eine Rollback‑Strategie ist nur real, wenn du sie getestet hast. Entscheide, was „Rollback“ für dein System bedeutet:

- Re‑deploieren der vorherigen Version?

- Feature‑Flag deaktivieren?

- Forward‑fix bereitstellen?

- Daten aus Backups wiederherstellen (langsam, riskant, manchmal notwendig)?

Probiere es in einer sicheren Umgebung; miss die Dauer und dokumentiere die Schritte. Wenn ein Experte, der im Urlaub ist, nötig ist, ist es keine Strategie.

Wenn eine Plattform sichere Rücknahmen unterstützt, nutze sie. Beispielsweise können Koder.ai‑Snapshots und Rollback‑Workflows das „Bluten stoppen“ zu einer erstklassigen, wiederholbaren Aktion machen, während du schnell iterierst.

Versioniere APIs und protokolliere Datenänderungen

Sobald andere Systeme oder Kunden von deinen Schnittstellen abhängen, brauchen Änderungen Schutzmaßnahmen.

Für APIs: Versionierung einführen (auch einfach /v1) und ein Changelog veröffentlichen, damit Konsumenten wissen, was sich ändert und wann.

Für Daten/Schemata: Behandle Änderungen als Releases. Bevorzuge rückwärtskompatible Migrationen (Felder hinzufügen, bevor alte entfernt werden) und dokumentiere sie zusammen mit Anwendungsreleases.

Kapazitätsgrundlagen: Quoten, Rate Limits, Skalierungsgrenzen

„Gestern ging noch alles“ bricht oft, weil Traffic, Batch‑Jobs oder Kundennutzung gewachsen sind.

Setze grundlegenden Schutz und Erwartungen:

- Quoten und Rate Limits, damit ein Tenant/Nutzer das System nicht überwältigt

- Klare Skalierungsgrenzen (CPU, Queue‑Tiefe, Antwortlatenz), die Aktionen auslösen

- Ein leichtgewichtiger Plan, was passiert, wenn Limits erreicht werden (Throttling, Load Shedding oder Skalieren)

Gutes Release‑ und Betriebsdisziplin macht Ausliefern sicher — auch bei hoher Geschwindigkeit.

Vorfälle: Für den ersten schlechten Tag vorbereiten

Vorfälle sind unvermeidlich, sobald reale Nutzer von deinem System abhängen. Der Unterschied zwischen „ein schlechter Tag“ und „geschäftsbedrohender Tag“ ist, ob du vorher entschieden hast, wer was tut, wie kommuniziert wird und wie gelernt wird.

Eine leichte Incident‑Checkliste

Halte das als kurzes Dokument, das jeder findet (Slack‑Pin, README‑Link, /runbooks). Eine praktische Checkliste deckt meist ab:

- Identifizieren: Impact bestätigen, Startzeit, betroffene Nutzer, Symptome

- Mitigieren: Blutung stoppen (Rollback, Feature Flag, Skalieren, Failover)

- Kommunizieren: Ein Owner postet Updates in festem Takt (z. B. alle 15–30 Minuten) intern und ggf. für Kunden

- Lernen: Erfasse, was passiert ist, solange es frisch ist; plane ein Postmortem

Postmortems ohne Schuld

Schreibe Postmortems mit Fokus auf Fixes, nicht Schuld. Gute Postmortems liefern konkrete Follow‑Ups: fehlender Alert → Alert hinzufügen; unklare Ownership → On‑Call zuweisen; riskantes Deploy → Canary‑Schritt ergänzen. Halte den Ton sachlich und mache Beitrag einfach.

Wiederkehrende Probleme in Engineering‑Arbeit verwandeln

Führe Wiederholungen explizit: derselbe Timeout jede Woche ist kein „Pech“, sondern ein Backlog‑Item. Pflege eine Liste wiederkehrender Probleme und mache daraus geplante Arbeit mit Ownern und Deadlines.

Vorsichtig mit SLAs/SLOs

Definiere SLAs/SLOs erst, wenn du sie messen und einhalten kannst. Ohne konsistentes Monitoring und jemanden, der die Reaktion verantwortet, fang mit internen Zielen und Basis‑Alerts an, und formaliere Versprechen später.

Eine praktische Entscheidungs‑Checkliste und nächste Schritte

Du musst nicht alles auf einmal härten. Du musst die Teile härten, die Nutzer, Geld oder deinen Ruf verletzen können — und den Rest flexibel halten, damit du weiter lernen kannst.

Jetzt unbedingt härten (kritische Pfade)

Wenn eines dieser Elemente in der Nutzerreise vorkommt, behandle es als „Produktionspfad“ und härte es vor der Erweiterung des Zugriffs:

- Auth & Berechtigungen: Login, Passwort‑Reset, Rollenprüfungen, Konto‑Löschung.

- Geld & Verpflichtungen: Abrechnung, Rückerstattungen, Tarifwechsel, Checkout, Rechnungen.

- Datenintegrität: Schreibvorgänge an Primärdaten, Idempotenz, Migrationen, Backups/Wiederherstellung.

- Nutzerseitige Zuverlässigkeit: Request‑Timeouts, Retries, Rate‑Limits, Graceful Degradation.

- Sicherheitsbasics: Geheimnisbehandlung, Least‑Privilege, Eingabevalidierung, Audit‑Trail für sensible Aktionen.

- Betriebliche Basics: Monitoring für Schlüssel‑SLIs (Fehlerquote, Latenz, Sättigung), Alerts, die einen Menschen page‑en, Runbooks für Top‑Ausfallmodi.

Kann vorerst vibey bleiben

Halte diese Punkte leichter, solange du Product–Market‑Fit suchst:

- Interne Tools, die von einem kleinen, geschulten Team genutzt werden.

- Experimente und wegwerfbare Prototypen hinter Feature‑Flags.

- UI‑Politur, die Kernworkflows nicht ändert.

- Nicht‑kritische Automationen mit einfachen manuellen Fallbacks.

Führe einen zeitlich begrenzten Hardening‑Sprint durch

Versuche 1–2 Wochen, fokussiert nur auf den kritischen Pfad. Exit‑Kriterien sollten konkret sein:

- Top‑Nutzerflüsse haben Basis‑Tests und einen wiederholbaren Testlauf.

- Dashboards + Alerts existieren für die wichtigen Flows.

- Rollback oder sicherer Deploy‑Pfad ist bewiesen (auch wenn manuell).

- Bekannte Risiken sind dokumentiert mit Owner und Mitigationsplan.

Einfache Go/No‑Go‑Gates

- Launch‑Gate (begrenzter Zugang): „Wir erkennen Fehler schnell, stoppen die Blutung und schützen Daten.“

- Expansion‑Gate (mehr Nutzer/Traffic): „Wir können vorhersehbare Laststeigerungen handhaben und von einem schlechten Deploy ohne Helden retten.“

Eine nachhaltige Kadenz

Um zwischen Chaos und Über‑Engineering zu vermeiden, wechsle:

- Experiment‑Wochen: schnell lernen und ausliefern.

- Stabilisierungs‑Wochen: Zuverlässigkeits-/Sicherheits-/Test‑Schulden aus Experimenten abbauen.

Wenn du eine Einseiter‑Version willst, mach die obigen Bullets zu einer Checkliste und überprüfe sie bei jedem Launch oder jeder Ausweitung des Zugriffs.