Warum grobe Erstversionen so häufig sind

Eine „grobe Erstversion“ ist nicht dasselbe wie sorglose Qualität. Es ist ein Produkt, das gut genug funktioniert, damit echte Menschen es ausprobieren können, aber noch Features fehlen, Workflows holprig sind und viel Raum zur Verbesserung bleibt. Der Unterschied ist die Absicht: grob bedeutet fokussiert und begrenzt; sorglos bedeutet unzuverlässig und unsicher.

Perfektion ist am Anfang selten, weil vieles davon, was „perfekt“ bedeutet, erst bekannt wird, wenn Nutzer mit dem Produkt interagieren. Teams können raten, welche Funktionen wichtig sind, welche Formulierungen passen oder wo Menschen hängen bleiben — doch Vermutungen sind oft falsch. Selbst erfahrene Macher entdecken regelmäßig, dass das wirkliche Problem, das Kunden gelöst haben wollen, leicht anders ist als angenommen.

Grob heißt nicht „Müll verschicken"

Der Zweck eines unvollkommenen Starts ist Lernen, nicht das Senken von Standards. Eine gute grobe Erstversion respektiert trotzdem den Nutzer:

- Sie löst ein klares Problem Ende-zu-Ende.\

- Sie ist stabil genug, sodass Ausfälle die Ausnahme sind, nicht die Regel.\

- Sie setzt ehrliche Erwartungen darüber, was enthalten ist (und was nicht).

Wenn Teams eine Lern-vor-Auslieferung-Mentalität annehmen, behandeln sie die erste Version nicht mehr wie eine Abschlussprüfung, sondern wie einen Feldtest. Dieser Perspektivwechsel macht es leichter, den Umfang zu beschränken, früher zu veröffentlichen und auf Beweise statt auf Meinungen zu reagieren.

In den nächsten Abschnitten siehst du praktische Beispiele — etwa MVP-ähnliche Releases und Early-Adopter-Programme — sowie Leitplanken, um häufige Fehler zu vermeiden (z. B. wie man eine harte Grenze zwischen „unvollkommen“ und „unbenutzbar“ zieht und wie man Feedback einfängt, ohne in endlose Sonderanforderungen gezogen zu werden).

Unsicherheit ist am Anfang am höchsten

Früh in der Produktentwicklung ist Sicherheit oft eine Illusion. Teams können detaillierte Spezifikationen und Roadmaps schreiben, aber die größten Fragen lassen sich nicht im Konferenzraum beantworten.

Was du wirklich nicht vorher wissen kannst

Bevor echte Nutzer dein Produkt anfassen, vermutest du über:

- Wer die wirklich motivierten Nutzer sind (und welche „idealen Kunden“-Beschreibungen Wunschdenken sind)\

- Reale Arbeitsabläufe: wie Menschen die Aufgabe heute erledigen, was sie nicht ändern werden und was sie bereit sind, an Software auszulagern\

- Preisbereitschaft: was in Interviews fair klingt vs. was die Kreditkarte hervorholt\

- Akquisekanäle: wo Aufmerksamkeit bezahlbar ist, welche Botschaften ankommen und was ignoriert wird

Du kannst all das recherchieren, aber nicht bestätigen, ohne Nutzung.

Warum Pläne ohne Nutzungsdaten scheitern

Traditionelle Planung geht davon aus, dass du Bedürfnisse vorhersagen, Features priorisieren und zu einem bekannten Ziel bauen kannst. Frühphasenprodukte sind voller Unbekannter, also basiert der Plan auf Annahmen. Wenn diese Annahmen falsch sind, verpasst du nicht nur ein Datum — du baust das falsche Produkt effizient.

Deshalb sind frühe Releases wichtig: Sie verwandeln Debatten in Evidenz. Nutzungsdaten, Support-Tickets, Abwanderung, Aktivierungsraten und sogar „wir haben es probiert und gestoppt“ sind Signale, die klären, was real ist.

„Nice-to-have“-Funktionen verbergen oft Annahmen

Eine lange Liste von Verbesserungen kann sich kundenorientiert anfühlen, enthält aber oft vergrabene Wetten:\

- „Nutzer wollen Dashboards“ setzt voraus, dass Nutzer das Tool häufig prüfen.\

- „Rollen und Berechtigungen“ setzt Mehrbenutzerannahmen vom ersten Tag an voraus.\

- „Integrationen mit allem“ setzt voraus, dass Wechselkosten dein größtes Hindernis sind.

Baust du das zu früh, verpflichtest du dich zu Annahmen, bevor du sie validiert hast.

Validiertes Lernen: Fortschritt, dem du vertrauen kannst

Validiertes Lernen bedeutet, dass das Ziel einer frühen Version nicht ist, fertig auszusehen — es ist, Unsicherheit zu reduzieren. Eine grobe Erstversion ist dann erfolgreich, wenn sie dir etwas Messbares über Nutzerverhalten, Wert und Bereitschaft zur Fortsetzung beibringt.

Dieses Lernen wird zur Grundlage für die nächste Iteration — eine, die auf Evidenz statt auf Hoffnung beruht.

Lerngeschwindigkeit schlägt Baugeschwindigkeit

Teams behandeln Fortschritt oft als „mehr Funktionen ausgeliefert“. Aber früh geht es nicht darum, schnell zu bauen — es geht darum, schnell zu lernen. Eine grobe Erstversion, die echte Nutzer erreicht, verwandelt Annahmen in Beweise.

Kurze Feedbackzyklen verändern alles

Wenn du früh veröffentlichst, schrumpfen Feedbackschleifen von Monaten auf Tage. Anstatt zu debattieren, was Nutzer möglicherweise tun, siehst du, was sie tatsächlich tun.

Ein typisches Muster:

- Monate des Ratens: lange Anforderungsdokumente, perfekte Designs, Edge-Cases für Probleme, die niemand bestätigt hat.\

- Tage echten Feedbacks: eine kleine Version launchen, beobachten, wo Leute hängen bleiben, und mit Klarheit anpassen.

Diese Geschwindigkeit wirkt verstärkend. Jeder kurze Zyklus entfernt Unsicherheit und verhindert, dass du „das falsche gut baust“.

Messbares Lernen

„Lernen“ ist kein vages Gefühl. Selbst einfache Produkte können Signale verfolgen, die zeigen, ob die Idee funktioniert:\

- Activation: Erreichen Menschen den ersten bedeutenden Moment (z. B. ein Projekt anlegen, einen Teamkollegen einladen, eine Aufgabe abschließen)?\

- Retention: Kommen sie nächste Woche ohne Nachhilfe zurück?\

- Support-Tickets und Fragen: Was verwirrt Nutzer wiederholt? Was fordern sie in ihren eigenen Worten an?

Diese Metriken validieren nicht nur — sie weisen auf die nächste Verbesserung mit höherer Zuversicht als interne Meinungen.

Schnell, aber niemals rücksichtslos

Schnelligkeit heißt nicht, Sicherheit oder Vertrauen zu ignorieren. Frühe Releases müssen Nutzer vor Schaden schützen:\

- Sei klar darüber, was das Produkt tut und was nicht.\

- Vermeide Features, die sensible Daten offenlegen oder finanzielles/rechtliches Risiko schaffen.\

- Füge grundlegende Schutzmaßnahmen hinzu (Berechtigungen, Backups, klares Rückgängig), bevor du „Growth-Hacks“ ansetzt.

Baue fürs Lernen zuerst — und schütze gleichzeitig die Nutzer — so wird die grobe Erstversion ein bewusstes Zwischenschritt, kein Glücksspiel.

MVPs: kleine Releases, die die riskanteste Idee testen

Ein MVP (Minimum Viable Product) ist die kleinste Version deines Produkts, die testen kann, ob ein zentrales Versprechen für echte Menschen wertvoll ist. Es ist nicht „die erste Version von allem“. Es ist der kürzeste Weg, eine hochriskante Frage zu beantworten, z. B.: Wird das jemand nutzen? Dafür bezahlen? Seine Routine dafür ändern?

Was ein MVP ist — und was nicht

Ein MVP ist ein fokussiertes Experiment, das du ausliefern, daraus lernen und verbessern kannst.

Ein MVP ist nicht:

- Ein glänzendes Demo, das echte Nutzung vermeidet\

- Ein „halb kaputtes“ Release, das Nutzer frustriert\

- Ein Paket an Features, das das Lernen verzögert

Das Ziel ist viable: Die Erfahrung sollte Ende-zu-Ende für eine enge Nutzergruppe funktionieren, auch wenn der Umfang klein ist.

Verschiedene Produkte können denselben Wert auf unterschiedliche Weise testen:\

- Concierge-MVP: Du lieferst den Wert manuell (High-Touch) an wenige Nutzer. Gut, um Bedürfnisse und Zahlungsbereitschaft zu verstehen.\

- „Manuell im Hintergrund“ (Wizard-of-Oz): Nutzer sehen eine einfache Oberfläche, die Arbeit wird manuell oder mit provisorischen Tools erledigt. Gut, um Nachfrage vor Automatisierung zu validieren.\

- Produkt mit begrenzten Features: Du baust nur den Kernworkflow, der den Hauptnutzen beweist, und lässt bewusst „Nice-to-haves“ weg. Gut, wenn die Interaktion selbst Software braucht.

Beginne mit der riskantesten Annahme

Der MVP-Umfang sollte zu deiner größten Unsicherheit passen. Wenn das Risiko Nachfrage ist, priorisiere reale Nutzung und Zahlungssignale. Wenn das Risiko Ergebnis ist, fokussiere darauf, dass du zuverlässig Ergebnisse liefern kannst — selbst wenn der Prozess manuell bleibt.

Eine praktische Unterstützung für diesen Ansatz ist eine Toolchain, die die Setup-Kosten minimiert. Zum Beispiel erlaubt eine Vibe-Coding-Plattform wie Koder.ai, Web-, Backend- oder Mobile-Apps per Chat zu prototypisieren, dann Quellcode zu exportieren und zu deployen — nützlich, wenn du ein echtes Ende-zu-Ende-MVP willst, ohne einen langen Engineering-Zyklus vor der Validierung einzuleiten.

Der Unterschied zwischen „unvollkommen“ und „unbenutzbar"

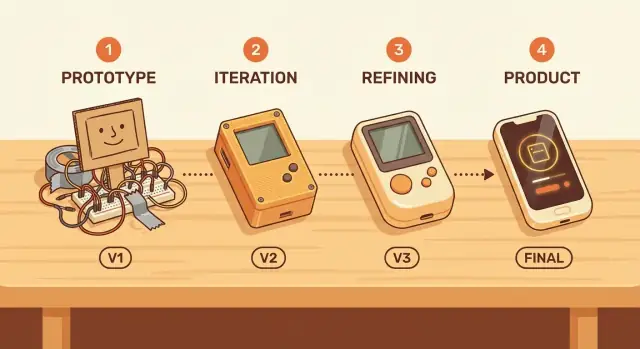

Eine grobe Erstversion kann trotzdem ein großartiger Start sein — wenn sie einer bestimmten Person hilft, eine bestimmte Aufgabe zu erledigen. „Gut genug“ ist kein universeller Standard; es hängt von der Job-to-be-done des Nutzers ab. Die Reise vom Prototyp zum Produkt funktioniert am besten, wenn diese Aufgabe klar definiert ist (z. B.: „eine Rechnung in unter zwei Minuten senden“ oder „eine Datei sicher mit einem Link teilen").

Eine einfache Qualitätsgrenze: zuverlässig für die Kernaufgabe

Ein unvollkommener Start darf klein und etwas umständlich sein. Er darf nicht unzuverlässig bei dem sein, was er verspricht.

Eine praktische Mindestqualität für ein MVP:

- Die Kernaufgabe funktioniert Ende-zu-Ende, jedes Mal, ohne manuelle Korrekturen.\

- Fehler sind verständlich (keine mysteriösen Ausfälle).\

- Nutzer können sich erholen (Undo, Retry oder klare nächste Schritte).

Wenn der Kernfluss zusammenbricht, können Early Adopters kein nützliches Feedback geben — weil sie nie den Moment erreichen, in dem das Produkt Wert liefert.

Trade-offs: weniger Funktionen, mehr Klarheit

„Schnell ausliefern“ geht oft schief, wenn Teams die falschen Dinge streichen. Weniger Features ist in Ordnung; weniger Klarheit nicht. Ein Minimal Viable Product sollte bevorzugen:

- Weniger Optionen, dafür klarere Defaults\

- Einfache Onboarding-Erfahrung statt langer Feature-Liste\

- Ein gut definierter Anwendungsfall statt fünf teilweise unterstützter

Das macht Iteration schneller, weil Feedback sich auf das Wesentliche konzentriert und nicht auf Verwirrung.

Selbst in einem frühen Release sollten Zugänglichkeit und grundlegende Performance nicht als „Nice-to-haves“ behandelt werden. Wenn Text nicht lesbar ist, Aktionen nicht per Tastatur abgeschlossen werden können oder Seiten zu lange laden, testest du nicht Produkt-Markt-Fit — du testest die Geduld der Leute. Kontinuierliche Verbesserung beginnt mit einer Basis, die die Zeit und Bedürfnisse der Nutzer respektiert.

Product-Market-Fit finden erfordert echte Nutzung

Dein MVP-Budget strecken

Erhalte Credits, wenn du teilst, was du gebaut hast, oder andere empfiehlst, Koder.ai auszuprobieren.

Product-Market-Fit (PMF) lässt sich einfach erklären: Nutzer würden dein Produkt wirklich vermissen, wenn es verschwinden würde. Nicht „sie mögen die Idee“, nicht „sie klickten die Ankündigung“, sondern echte Abhängigkeit — etwas, das sie in ihre Routine eingebaut haben.

Warum du PMF nicht von innen vorhersagen kannst

Teams sind voreingenommen gegenüber eigenen Annahmen. Du kennst die Roadmap, verstehst Edge-Cases und kannst dir den Zukunftswert ausmalen. Kunden kaufen aber nicht deine Absicht — sie erfahren, was heute existiert.

Interne Meinungen leiden außerdem unter „Stichprobe = Leute wie wir“. Kollegen, Freunde und frühe Tester teilen oft deinen Kontext. Echte Nutzung bringt die unordentlichen Zwänge, die du nicht simulieren kannst: Zeitdruck, konkurrierende Alternativen und Null-Toleranz für verwirrende Abläufe.

Frühe Signale, dass PMF entsteht

Achte auf Verhalten, das zeigt, dass das Produkt ein wiederkehrendes Problem löst:\

- Wiederkehrende Nutzung: Leute kommen ohne Erinnerungen zurück, und die Nutzung hält an, wenn der Neuheits-Effekt nachlässt.\

- Empfehlungen: Nutzer empfehlen es ungefragt, weil es sie nützlich aussehen lässt.\

- Zahlungsbereitschaft: Nicht nur „ich würde bezahlen“, sondern tatsächlich bezahlen, upgraden oder einen bedeutenden Kompromiss eingehen.

Überinterpretiere Vanity-Metriken nicht

Frühe Zahlen können täuschen. Sei vorsichtig bei:\

- Pageviews und Anmeldungen, die nicht in Aktivierung übersetzt werden\

- Kostenlose Trial-Spitzen, die von Neugier oder Promotionen getrieben sind\

- Soziale Interaktion, die Interesse am Thema, nicht am Produkt signalisiert

Eine grobe Erstversion ist wertvoll, weil sie dich schnell zu diesen Realitätstests bringt. PMF ist kein Ergebnis eines Meetings — es ist ein Muster, das du beobachtest, wenn echte Nutzer das Produkt nutzen.

Early Adopters tolerieren keine groben Kanten, weil sie Vergnügen an Fehlern haben — sie tun es, weil der Nutzen für sie ungewöhnlich hoch ist. Sie sind die Menschen mit einem starken, häufigen Problem, die aktiv nach einer Lösung suchen. Wenn deine grobe Erstversion einen großen Schmerzpunkt (wenn auch unvollkommen) beseitigt, tauschen sie Politur gegen Fortschritt.

Warum Early Adopters Unvollkommenheiten akzeptieren

Early Adopters sind oft:\

- Sie investieren Zeit oder Geld in umständliche Alternativen (Tabellen, manuelle Checks, Copy-Paste-Workflows)\

- Sie erleben das Problem intensiver als durchschnittliche Nutzer\

- Sie sind bereit, Aufwand zu investieren, wenn es früher Erleichterung bringt

Wenn das „Davor“ schmerzhaft genug ist, fühlt sich ein halb fertiges „Danach“ wie ein Sieg an.

Wie du die richtigen Early Adopters findest

Suche dort, wo der Schmerz bereits diskutiert wird: Nischen-Slack/Discord-Gruppen, Subreddits, Branchenforen und berufliche Communities. Ein weiteres Signal: Leute, die eigene Hacks gebaut haben (Templates, Skripte, Notion-Boards) — sie sagen dir, dass sie ein besseres Tool brauchen.

Ziehe auch „angrenzende“ Nischen in Betracht — kleinere Segmente mit derselben Kernaufgabe, aber weniger Anforderungen. Die sind oft leichter zuerst zu bedienen.

Erwartungen offen kommunizieren

Sei explizit darüber, was enthalten ist und was nicht: was das Produkt heute kann, was experimentell ist, was fehlt und welche Probleme Nutzer erwarten dürfen. Klare Erwartungen verhindern Enttäuschung und erhöhen Vertrauen.

Schnelle Feedbackkanäle erstellen

Mach Feedback einfach und unmittelbar: ein kurzes In-App-Prompt, eine Reply-to-E-Mail-Adresse und ein paar geplante Calls mit aktiven Nutzern. Frag nach Spezifischem: was sie versucht haben, wo sie stecken geblieben sind und was sie stattdessen getan haben. Diese Details verwandeln frühe Nutzung in eine fokussierte Roadmap.

Einschränkungen können zu besseren Entscheidungen führen

Setze dein MVP schneller um

Baue eine grobe Erstversion an einem Tag statt in einem Quartal – mit chatgesteuerter App-Erstellung.

Einschränkungen haben einen schlechten Ruf, zwingen aber oft zu klarerem Denken. Wenn Zeit, Budget oder Teamgröße begrenzt sind, kannst du Unsicherheit nicht durch das Hinzufügen von Funktionen lösen. Du musst entscheiden, was am wichtigsten ist, Erfolg definieren und etwas ausliefern, das das Kernversprechen beweist (oder widerlegt).

Einschränkungen schaffen Einfachheit

Eine enge Einschränkung wirkt wie ein Filter: Wenn eine Funktion nicht hilft, das Hauptversprechen zu validieren, wartet sie. So entstehen einfache, klare Lösungen — weil das Produkt um eine Aufgabe gebaut ist, die es gut erfüllt, und nicht um zehn Aufgaben, die es schlecht erfüllt.

Das ist besonders nützlich, wenn du noch rätst, was Nutzer wirklich wollen. Je mehr du den Umfang einschränkst, desto einfacher ist es, ein Ergebnis einer Änderung zuzuordnen.

„Nice-to-haves“ können das echte Problem verschleiern: Die Wert proposition ist noch nicht scharf. Wenn Nutzer vom simpelsten Produkt nicht begeistert sind, beheben zusätzliche Features das selten — sie fügen nur Lärm hinzu. Ein funktionsreiches Produkt kann überladen wirken und trotzdem die Grundfrage unbeantwortet lassen: „Warum sollte ich das nutzen?“

Praktische Beispiele für validierungsgetriebene Einschränkungen

Einige einfache, einschränkungsfreundliche Wege, die riskanteste Idee zu testen:

- Landingpage-Test: Eine klare Aussage und ein Call-to-Action (Warteliste, Demo-Anfrage, Vorbestellung). Konvertieren Nutzer nicht, hast du etwas gelernt, ohne das Produkt zu bauen.\

- Prototyp statt Plattform: Ein klickbarer Prototyp kann prüfen, ob der Ablauf Sinn macht, bevor du in Engineering investierst.\

- Single-Feature-Tool: Viele Produkte starten als ein scharfes Werkzeug (ein Bericht, eine Automation, ein Button), zu dem Menschen wiederkehren.

„Nein“ sagen schützt den Fokus

Behandle „Nein“ als Produktfertigkeit. Sag nein zu Funktionen, die die aktuelle Hypothese nicht unterstützen, nein zu zusätzlichen Nutzersegmenten bevor ein Segment funktioniert, und nein zu Politur, die Entscheidungen nicht verändert. Einschränkungen machen diese „Neins“ leichter — und halten dein frühes Produkt ehrlich bezüglich dessen, was es wirklich liefert.

Der Fall des Überbauens vermeiden

Überbauen passiert, wenn ein Team die erste Version wie das endgültige Urteil behandelt. Anstatt die Kernidee zu testen, wird das Produkt zu einem Bündel von „Nice-to-haves“, die sich sicherer anfühlen als ein klares Ja/Nein-Experiment.

Warum Teams überbauen

Angst ist der größte Treiber: Angst vor negativem Feedback, Angst, unprofessionell zu wirken, Angst, dass ein Wettbewerber polierter erscheint.

Vergleich heizt das an. Wenn du dich an reifen Produkten misst, ist es leicht, deren Feature-Set zu kopieren, ohne zu bemerken, dass sie diese Features über Jahre der Nutzung verdient haben.

Interne Politik kann das weiter antreiben. Zusätzliche Features werden zum Weg, mehrere Stakeholder zufriedenzustellen („füge das hinzu, damit Sales es pitcht“, „füge das hinzu, damit Support nicht meckert“), selbst wenn nichts davon beweist, dass das Produkt gewünscht wird.

Die versteckten Kosten: versunkene Kosten verlangsamen Wandel

Je mehr du baust, desto schwieriger wird es, die Richtung zu ändern. Das ist der Effekt versunkener Kosten: Sobald Zeit, Geld und Stolz investiert sind, verteidigen Teams Entscheidungen, die eigentlich neu bewertet werden sollten.

Übergebaute Versionen schaffen teure Verpflichtungen — komplexen Code, schwereres Onboarding, mehr Edge-Cases, mehr Dokumentation, mehr Meetings. Dann fühlt sich selbst offensichtliche Verbesserung riskant an, weil sie all diese Investitionen bedroht.

Wie grobe Versionen verschwendete Arbeit reduzieren

Eine grobe Erstversion begrenzt deine Optionen positiv. Indem du den Umfang klein hältst, lernst du früher, ob die Idee wertvoll ist, und vermeidest das Polieren von Funktionen, die nicht wichtig sind.

Eine einfache Regel hilft:

Baue das Kleinste, das eine Frage beantwortet.

Beispiele für „eine Frage":

- Werden Menschen diese Aufgabe erledigen, wenn wir manuelle Hilfe entfernen?\

- Bevorzugen Nutzer Option A oder B, wenn sie wählen müssen?\

- Ist dieses Problem dringend genug, dass jemand morgen zurückkommt?

Wenn dein „MVP" diese Frage nicht klar beantworten kann, ist es wahrscheinlich nicht minimal — es ist einfach frühe Phase des Überbaus.

Risiken des frühen Veröffentlichens — und wie man sie managt

Früh veröffentlichen ist nützlich, aber nicht kostenlos. Eine grobe Erstversion kann echten Schaden anrichten, wenn du die Risiken ignorierst.

Die häufigsten Risiken

Die größten Risiken fallen meist in vier Bereiche:

- Vertrauen und Glaubwürdigkeit: Ein fehlerhaftes erstes Erlebnis kann den Eindruck entstehen lassen, das Produkt sei schlampig oder unzuverlässig.\

- Sicherheit und Datenschutz: Früher Code hat oft Lücken — besonders bei Authentifizierung, Berechtigungen und Datenverarbeitung.\

- Datenverlust: Wenn Nutzer Zeit investieren und Daten verschwinden, kommen sie vielleicht nie zurück.\

- Schlechter erster Eindruck: Verwirrendes Onboarding oder unklarer Nutzen führt zu „Ich kapier's nicht“-Abwanderung.

Praktische Maßnahmen, die dich voranbringen

Du kannst Schaden reduzieren, ohne alles zu verlangsamen:

- Kennzeichne es klar: „Beta“ oder „Preview“ setzt Erwartungen. Sage, was bereit ist und was nicht.\

- Zugriff begrenzen: Starte mit einer kleinen Gruppe (Nur-Einladungen, Warteliste oder ein spezifisches Kundensegment), damit Fehler eingedämmt werden.\

- Backups und Undo: Selbst einfache Schutzmaßnahmen — Exportoptionen, Versionsverlauf oder nächtliche Backups — schützen Nutzer vor dem schlimmsten.\

- Klare Supportwege: Eine sichtbare Hilfs-E-Mail/Chat und schnelle Reaktionszeiten können wackelige Momente retten und Goodwill aufbauen.

Wenn du eine Plattform verwendest, um schnell zu veröffentlichen, achte auf Sicherheitsfeatures, die frühe Iteration unterstützen. Beispielsweise bietet Koder.ai Snapshots und Rollback (damit du dich von einem schlechten Release erholen kannst) und unterstützt Deployment/Hosting — nützlich, wenn du schnell vorankommen willst, ohne jede Änderung zu einem Hochrisikoereignis zu machen.

Gestaffelte Rollouts und Feature Flags (einfach erklärt)

Statt alles auf einmal für alle freizugeben, mache einen gestaffelten Rollout: zuerst 5 % der Nutzer, dann 25 %, dann 100 %, während du Vertrauen gewinnst.

Ein Feature-Flag ist ein einfacher Schalter, mit dem du ein neues Feature an- oder ausschaltest, ohne alles neu zu deployen. Wenn etwas kaputtgeht, schaltest du es aus und lässt den Rest laufen.

Wann du nicht früh veröffentlichen solltest

Teste nicht in Produktion, wenn die Einsätze hoch sind: sicherheitsrelevante Features, rechtliche/Compliance-Anforderungen, Zahlungen oder sensible Personendaten oder alles, was kritische Zuverlässigkeit erfordert (z. B. medizinisch, Notfall, Kernfinanzen). In diesen Fällen validiere mit Prototypen, internen Tests und kontrollierten Piloten bevor du öffentlich gehst.

Frühes Feedback in stetige Verbesserung verwandeln

Teste ein mobiles MVP

Validiere die Nachfrage mit einem Flutter-Mobile-MVP, ohne monatelange Einrichtung.

Eine grobe Erstversion zu veröffentlichen ist nur nützlich, wenn du echte Reaktionen in bessere Entscheidungen umwandelst. Das Ziel ist nicht „mehr Feedback“ — es ist ein beständiger Lernzyklus, der das Produkt klarer, schneller und leichter bedienbar macht.

Was du messen solltest (damit du nicht rätst)

Beginne mit wenigen Signalen, die zeigen, ob Leute tatsächlich Wert erhalten:\

- Activation: Welcher Prozentsatz erreicht den „Aha“-Moment (z. B. erstes Projekt, Team einladen, etwas veröffentlichen)?\

- Time-to-value: Wie lange dauert es bis zum ersten Ergebnis?\

- Retention: Wer kommt nach einem Tag/Woche/Monat zurück?\

- Churn-Gründe: Das Warum hinter Kündigungen oder Abbrüchen (Preis, fehlende Funktion, Verwirrung, schlechte Passung)

Diese Metriken helfen, Neugier von echtem Erfolg zu trennen.

Qualitatives Feedback, das die Zahlen erklärt

Zahlen sagen dir was passiert ist. Qualitatives Feedback sagt dir warum.

Nutze eine Mischung aus:

- Kurzen Interviews mit neuen Nutzern (15 Minuten genügen)\

- Leichten Umfragen nach Schlüsselaktionen („Was war verwirrend?“ „Was hat dich fast gestoppt?“)\

- Support-Logs und Chat-Transkripten (oft das ehrlichste Feedback)

Erfasse die genauen Formulierungen der Nutzer. Diese Worte sind Treibstoff für besseres Onboarding, klarere Buttons und einfachere Preisseiten.

Feedback in eine umsetzbare Roadmap verwandeln

Mach keine To‑Do-Liste aus jeder Anfrage. Gruppiere Input in Themen, priorisiere nach Impact (wie sehr es Aktivierung/Retention verbessert) und Aufwand (wie schwer die Umsetzung ist). Eine kleine Änderung, die einen großen Verwirrungspunkt beseitigt, schlägt oft ein großes neues Feature.

Verknüpfe Learnings mit einem regelmäßigen Release-Rhythmus — wöchentlich oder zweiwöchentlich — damit Nutzer Fortschritt sehen und du mit jeder Iteration Unsicherheit reduzierst.

Ein praktisches Framework: unvollkommen starten und erfolgreich sein

Eine grobe Erstversion funktioniert, wenn sie absichtlich grob ist: Sie konzentriert sich darauf, eine Schlüsselfrage zu beweisen oder zu widerlegen, und ist trotzdem verlässlich genug, dass echte Menschen sie ausprobieren.

Schritt 1: Wähle ein einziges Kernversprechen

Formuliere einen Satz, der erklärt, welche Aufgabe dein Produkt für einen Nutzer übernimmt.

Beispiele:

- „Freelancern helfen, in unter 2 Minuten eine Rechnung zu senden.“\

- „Teams ermöglichen, die Verkäufe von gestern auf einem Bildschirm zu sehen.“

Wenn dein MVP dieses Versprechen nicht klar halten kann, ist es nicht bereit — egal wie poliert die UI ist.

Schritt 2: Setze eine klare Qualitätsgrenze (unvollkommen, nicht unbenutzbar)

Entscheide, was wahr sein muss, damit Nutzer dem Erlebnis vertrauen.

Checkliste:

- Kernversprechen: Welches eine Ergebnis garantierst du?\

- Qualitätsgrenze: Was würde es gebrochen oder riskant wirken lassen (falsche Summen, Datenverlust, verwirrender Checkout usw.)?\

- Erfolgsmessgrößen: Welche Zahlen zeigen, dass es funktioniert (Aktivierungsrate, Wiederkehr, Time-to-value, Retention nach 7 Tagen)?

Schritt 3: Definiere den kleinsten Test, der dich etwas lehrt

Reduziere den Umfang, bis du schnell veröffentlichen kannst ohne den Test zu schwächen. Eine gute Regel: Streiche Features, die die Entscheidung nach dem Launch nicht verändern.

Frag dich:

- Was ist die riskanteste Annahme?\

- Was ist der schnellste Weg, sie mit echter Nutzung zu validieren?

Wenn die Implementierung dein Engpass ist, erwäge eine Toolchain, die den Weg von Idee → funktionierender Software verkürzt. Zum Beispiel kann Koder.ai eine React-Web-App, ein Go + PostgreSQL-Backend oder eine Flutter-Mobile-App aus einer chat-gesteuerten Spezifikation generieren und dir erlauben, den Code zu exportieren, wenn du bereit bist, das Repository zu übernehmen — nützlich, um schneller echte Nutzertests zu erreichen.

Schritt 4: Führe eine kurze Feedback-Schleife aus

Veröffentliche für eine kleine, spezifische Gruppe und sammle Feedback in zwei Kanälen:

- Verhalten: Was sie tatsächlich tun (Abbrüche, Wiederholungen, Time-to-value)\

- Gespräche: 10–15-minütige Calls oder kurze Umfragen, die sich auf das Ergebnis, nicht auf Meinungen konzentrieren

Zeitplanvorschlag (für einen ~3000-Wörter-Artikel-Plan)

- Woche 1: Kernversprechen + Qualitätsgrenze wählen, 3–5 User-Stories sammeln\

- Woche 2: Nur das bauen, was nötig ist, um das Versprechen einmal zu liefern\

- Woche 3: Release für Early Users, messen, Interviews durchführen\

- Woche 4: Erfahrung um das tatsächlich Genutzte herum verbessern; Unbenutztes entfernen

Handlungsaufforderung

Nimm dir heute fünf Minuten: Schreib dein Kernversprechen, liste deine Qualitätsgrenze und umkreise die eine riskanteste Annahme. Schneide dann dein MVP so weit zurecht, dass es diese Annahme in den nächsten 2–3 Wochen testen kann.

Wenn du mehr Vorlagen und Beispiele möchtest, schau dir verwandte Beiträge unter /blog an.