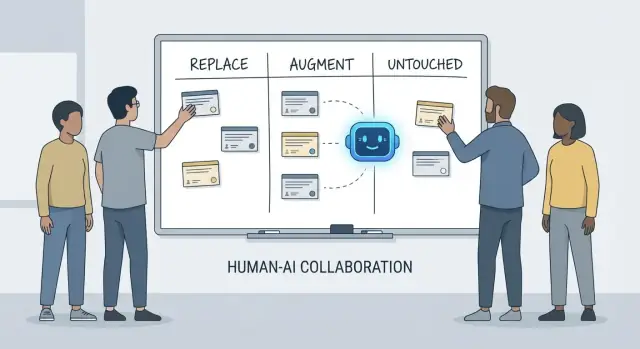

Ersetzen, Ergänzen, Unberührt: Ein einfaches Framework

Gespräche darüber, was „KI mit Entwicklern macht“, werden schnell verwirrend, weil wir oft Werkzeuge mit Verantwortlichkeiten vermischen. Ein Werkzeug kann Code erzeugen, ein Ticket zusammenfassen oder Tests vorschlagen. Eine Verantwortung ist das, wofür das Team noch rechenschaftspflichtig ist, wenn die Vorschläge falsch sind.

Dieser Artikel nutzt ein einfaches Framework — Ersetzen, Ergänzen, Unberührt — um die tägliche Arbeit in realen Teams mit Deadlines, Legacy-Code, Produktionsvorfällen und Stakeholdern, die zuverlässige Ergebnisse erwarten, zu beschreiben.

Was „Ersetzen“ bedeutet (und was nicht)

Ersetzen bedeutet, dass die KI die Aufgabe meist Ende-zu-Ende mit klaren Guardrails erledigen kann und die menschliche Rolle sich auf Überwachung und Stichprobenprüfung verlagert.

Beispiele sind oft abgegrenzte Arbeiten: Boilerplate erzeugen, Code zwischen Sprachen übersetzen, repetitive Testfälle entwerfen oder erste Dokumentationen erstellen.

Ersetzen heißt nicht „keine menschliche Verantwortung“. Wenn die Ausgabe Produktion bricht, Daten leakt oder Standards verletzt, liegt die Verantwortung weiterhin beim Team.

Was „Ergänzen“ bedeutet

Ergänzen heißt, die KI macht einen Entwickler schneller oder gründlicher, aber sie beendet die Arbeit nicht zuverlässig ohne menschliches Urteil.

Das ist der häufige Fall im professionellen Engineering: du bekommst nützliche Entwürfe, alternative Ansätze, schnelle Erklärungen oder eine Shortlist wahrscheinlicher Bugs — aber ein Entwickler entscheidet, was richtig, sicher und passend fürs Produkt ist.

Was „Unberührt“ bleibt

Unberührt heißt, die Kernverantwortung bleibt menschlich geführt, weil sie Kontext, Abwägungen und Rechenschaft erfordert, die sich nicht gut in Prompts pressen lassen.

Denke an: Anforderungen aushandeln, systemweite Randbedingungen wählen, Vorfälle managen, Qualitätsmaßstäbe setzen und Entscheidungen treffen, wenn es keine einzige „richtige“ Antwort gibt.

Warum Verantwortlichkeiten die Analyse-Einheit sind

Werkzeuge ändern sich schnell. Verantwortlichkeiten ändern sich langsam.

Statt zu fragen „Kann eine KI diesen Code schreiben?“, frage „Wer besitzt das Ergebnis?“ Diese Perspektive hält die Erwartungen an Genauigkeit, Zuverlässigkeit und Verantwortung — Dinge, die wichtiger sind als beeindruckende Demos.

Was wir unter „Entwicklerverantwortlichkeiten“ verstehen

Wenn Leute fragen, was KI in der Entwicklung „ersetzt“, meinen sie oft Aufgaben: eine Funktion schreiben, Tests generieren, Dokumentation entwerfen. Teams liefern jedoch keine isolierten Aufgaben — sie liefern Ergebnisse. Darum sind Entwicklerverantwortlichkeiten wichtig.

Das übliche Bündel an Verantwortlichkeiten

Der Job eines Entwicklers umfasst typischerweise mehr als reine Kodierzeit:

- Lieferung: eine vage Idee in funktionierende Software verwandeln, die pünktlich ausgeliefert wird.

- Qualität: Korrektheit, Wartbarkeit und Vermeidung von Regressionen.

- Sicherheit & Datenschutz: sichere Defaults, Datenhandling und Bedrohungsbewusstsein.

- Betrieb: Services am Laufen halten, Ausfallmodi verstehen und auf Vorfälle reagieren.

- Kommunikation: Abstimmung mit Produkt, Design, Support und anderen Ingenieuren.

Diese Verantwortlichkeiten ziehen sich durch den gesamten Lebenszyklus — von „was sollen wir bauen?“ bis „ist es sicher?“ bis „was passiert um 3 Uhr morgens, wenn es ausfällt?"

Warum es mehr ist als eine Checkliste

Jede Verantwortung besteht aus vielen kleinen Entscheidungen: welche Edge-Cases sind wichtig, welche Metriken zeigen Gesundheit, wann wird Scope gekappt, ob ein Fix sicher ausrollbar ist, wie ein Trade-off Stakeholdern erklärt wird. KI kann bei der Ausführung von Teilen dieser Arbeit helfen (Code entwerfen, Tests vorschlagen, Logs zusammenfassen), aber Verantwortung bedeutet, das Ergebnis zu besitzen.

Wo Handoffs scheitern

Ausfälle passieren oft an Übergabepunkten:

- „QA wird das auffangen“ (aber niemand hat definiert, was Qualität bedeutet).

- „Security wird reviewen“ (aber das Design hat bereits riskante Entscheidungen festgelegt).

- „Ops kümmert sich darum“ (aber der Service wurde nicht betreibbar gebaut).

Wenn Ownership unklar ist, fällt Arbeit in die Lücken.

Entscheidungsrechte: Wer entscheidet vs. wer führt aus

Eine nützliche Art, über Verantwortlichkeiten zu sprechen, sind Entscheidungsrechte:

- Wer entscheidet über Anforderungen, Trade-offs und akzeptables Risiko?

- Wer führt aus Implementierung und Verifikation?

KI kann Ausführung beschleunigen. Die Entscheidungsrechte — und die Verantwortung für Ergebnisse — brauchen aber weiterhin einen menschlichen Namen dahinter.

Arbeit, die KI oft ersetzen kann (mit Guardrails)

KI-Code-Assistenten sind dann besonders nützlich, wenn die Arbeit vorhersehbar, gering risikobehaftet und leicht verifizierbar ist. Sie sind wie ein schneller Junior-Kollege: perfekt für den ersten Entwurf, benötigen aber klare Anleitungen und sorgfältige Prüfungen.

In der Praxis nutzen einige Teams zunehmend „Vibe-Coding“-Plattformen (wie Koder.ai), um diese ersetzbaren Brocken zu beschleunigen: Gerüste erzeugen, CRUD-Flows verdrahten und erste UI- und Backend-Entwürfe aus Chat-Anweisungen erstellen. Der Schlüssel bleibt gleich: Guardrails, Review und klare Ownership.

Niedrigrisiko-Boilerplate

Viel Entwicklerzeit fließt in Projekt-Scaffolding und das Zusammensetzen von Komponenten. KI kann oft erzeugen:

- Starter-Dateien und -Ordner (Controller, Routen, DTOs)

- repetitiven „Glue-Code“ zwischen Schichten

- einfache CRUD-Endpunkte, die einem etablierten Muster folgen

Die Guardrail hier ist Konsistenz: stelle sicher, dass es zu deinen bestehenden Konventionen passt und keine neuen Muster oder Abhängigkeiten erfindet.

Mechanische Refactors und Migrationen

Wenn eine Änderung überwiegend mechanisch ist — Symbol umbenennen im ganzen Code, Reformatierung oder ein unkomplizierter API-Update — kann KI die Arbeit beschleunigen.

Behandle es dennoch wie einen Bulk-Edit: führe die komplette Test-Suite aus, scanne Diffs auf unbeabsichtigte Verhaltensänderungen und vermeide, dass die KI über das angeforderte Refactoring hinaus „verbessert“.

Dokumentationsentwürfe (Review erforderlich)

KI kann READMEs, Inline-Kommentare und Changelog-Einträge aus Code und Commit-Notizen entwerfen. Das kann Klarheit beschleunigen, aber auch übermäßig selbstbewusste Ungenauigkeiten erzeugen.

Beste Praxis: KI für Struktur und Formulierung nutzen, dann jede Aussage verifizieren — besonders Setup-Schritte, Konfigurationsdefaults und Edge-Cases.

Basis-Testgenerierung als Ausgangspunkt

Für gut spezifizierte, pure Funktionen können KI-generierte Unit-Tests erste Coverage liefern und an Edge-Cases erinnern. Die Guardrail ist Ownership: du entscheidest, was wichtig ist, ergänzt Assertions, die echte Anforderungen widerspiegeln, und stellst sicher, dass Tests aus den richtigen Gründen fehlschlagen.

Zusammenfassungen von Threads und Logs

Bei langen Slack-Threads, Tickets oder Incident-Logs kann KI sie in prägnante Notizen und Action-Items verwandeln. Halte es fundiert, indem du den vollständigen Kontext lieferst und dann Schlüsselfakten, Zeitstempel und Entscheidungen vor dem Teilen verifizierst.

Arbeit, die KI hauptsächlich ergänzt: Schneller, aber nicht fertig

KI-Code-Assistenten sind am besten, wenn du schon weißt, was du willst, und Hilfe beim Umsetzen brauchst. Sie reduzieren die Zeit fürs Tippen und liefern Kontext, ersetzen aber nicht Ownership, Verifikation und Urteilsvermögen.

Umsetzung beschleunigen (starker erster Entwurf)

Bei klarer Spezifikation — Inputs, Outputs, Edge-Cases und Constraints — kann KI eine brauchbare Startimplementierung entwerfen: Boilerplate, Mapping, API-Handler, Migrationen oder ein einfacher Refactor. Der Gewinn ist Momentum: schnell etwas Laufbares.

Der Haken ist, dass der erste Entwurf oft subtile Anforderungen verpasst (Fehlersemantik, Performance-Constraints, Backwards-Compatibility). Behandle ihn wie einen Praktikantenentwurf: nützlich, aber nicht autoritativ.

Optionen vorschlagen — mit zu validierenden Trade-offs

Wenn du zwischen Ansätzen wählst (z. B. Caching vs. Batching, optimistisch vs. pessimistisch Sperren), kann KI Alternativen und Vor- und Nachteile aufzeigen. Das ist hilfreich fürs Brainstorming, aber diese Abwägungen müssen gegen die Realitäten deines Systems validiert werden: Traffic-Muster, Konsistenzanforderungen, operative Beschränkungen und Teamkonventionen.

Codeverständnis und Navigation im Codebase

KI ist gut darin, unbekannten Code zu erklären, Muster zu erkennen und „Was macht das?“ in verständliche Sprache zu übersetzen. Kombiniert mit Suchwerkzeugen kann es helfen zu beantworten: „Wo wird X benutzt?“ und eine Impact-Liste wahrscheinlicher Aufrufstellen, Konfigurationen und Tests zu generieren.

Developer-Ergonomie: Bessere Feedback-Loops

Erwarte praktische Qualitätsverbesserungen: klarere Fehlermeldungen, kleine Beispiele und sofort einfügbare Snippets. Sie reduzieren Reibungsverluste, ersetzen aber nicht sorgfältige Reviews, lokale Läufe und gezielte Tests — besonders bei Änderungen, die Nutzer oder Produktion betreffen.

Produktverständnis und Anforderungen: weiterhin menschlich geführt

KI kann helfen, Anforderungen zu schreiben und zu verfeinern, aber sie kann nicht zuverlässig entscheiden, was gebaut werden sollte oder warum es wichtig ist. Produktverständnis wurzelt in Kontext: Geschäftszielen, Nutzerproblemen, organisatorischen Zwängen, Edge-Cases und den Kosten eines Fehlers. Diese Inputs leben in Gesprächen, Historie und Rechenschaft — Dinge, die ein Modell zusammenfassen, aber nicht wirklich besitzen kann.

Verschwommene Ziele in Baubares übersetzen

Frühe Anfragen klingen oft wie „Mach das Onboarding einfacher“ oder „Reduziere Support-Tickets.“ Die Aufgabe eines Entwicklers ist, das in klare Anforderungen und Akzeptanzkriterien zu übersetzen.

Diese Übersetzung ist größtenteils menschliche Arbeit, weil sie gezielte Fragen und Urteilsvermögen benötigt:

- Welches Nutzersegment optimieren wir, und welches Verhalten soll sich ändern?

- Was zählt als „fertig“ und wie messen wir es?

- Welche Einschränkungen sind unverhandelbar (Datenschutz, Performance, Deadlines)?

KI kann mögliche Metriken vorschlagen oder Akzeptanzkriterien entwerfen, aber sie weiß nicht, welche Constraints real sind, sofern sie nicht benannt werden — und sie wehrt sich nicht, wenn eine Anforderung sich selbst widerspricht.

Trade-offs und Erwartungsmanagement

Anforderungsarbeit ist der Ort, an dem unangenehme Trade-offs sichtbar werden: Zeit vs. Qualität, Geschwindigkeit vs. Wartbarkeit, neue Features vs. Stabilität. Teams brauchen eine Person, die Risiken explizit macht, Optionen vorschlägt und Stakeholder auf die Konsequenzen einschwört.

Ein gutes Spec ist nicht nur Text; es ist ein Entscheidungsprotokoll. Es sollte testbar und implementierbar sein, mit klaren Definitionen (Inputs, Outputs, Edge-Cases, Failure-Modes). KI kann die Struktur liefern, aber die Verantwortung für Korrektheit — und dafür zu sagen „das ist mehrdeutig, wir brauchen eine Entscheidung“ — bleibt bei Menschen.

Systemdesign und Architekturentscheidungen

Systemdesign ist der Moment, in dem „was bauen wir?“ zu „womit bauen wir es und wie verhält es sich, wenn etwas schiefgeht?“ wird. KI kann helfen, Optionen zu explorieren, aber sie kann die Konsequenzen nicht tragen.

Eine Architektur wählen, die zur Realität passt

Zwischen Monolith, modularen Monolithen, Microservices, Serverless oder Managed-Plattformen zu wählen ist kein Quiz mit einer richtigen Antwort. Es ist ein Fit-Problem: erwartete Skalierung, Budgetlimits, Time-to-Market und die Fähigkeiten des Teams.

Ein Assistent kann Muster zusammenfassen und Referenzarchitekturen vorschlagen, aber er weiß nicht, dass dein Team wöchentlich On-Call rotiert, dass Hiring langsam ist oder dass dein Datenbankvertrag nächsten Quartal ausläuft. Solche Details entscheiden oft über Erfolg oder Misserfolg einer Architektur.

Abwägungen explizit machen

Gute Architektur besteht hauptsächlich aus Trade-offs: Einfachheit vs. Flexibilität, Performance vs. Kosten, Geschwindigkeit heute vs. Wartbarkeit später. KI kann schnell Pro-/Contra-Listen erstellen, was nützlich ist — besonders zur Dokumentation von Entscheidungen.

Was sie nicht leisten kann, ist Prioritäten zu setzen, wenn Trade-offs weh tun. Beispiel: „Wir akzeptieren leicht langsamere Reaktionszeiten, um das System einfacher und betreibbarer zu halten“ ist eine Geschäftsentscheidung, keine rein technische.

Grenzen, Datenverantwortung und Fehlermodi

Service-Grenzen definieren, wer welche Daten besitzt und was bei Teilausfällen passiert, erfordert tiefes Produkt- und Betriebswissen. KI kann Fehlermodi brainstormen („Was, wenn der Zahlungsanbieter ausfällt?“), aber Menschen müssen das erwartete Verhalten, Kundenkommunikation und Rollback-Pläne entscheiden.

APIs, die nutzbar bleiben

API-Design ist Vertragsgestaltung. KI kann Beispiele generieren und Inkonsistenzen aufspüren, aber du musst Versionierung, Rückwärtskompatibilität und Langzeitunterstützung entscheiden.

Entscheiden, nichts zu bauen (oder zu löschen)

Vielleicht die wichtigste Architekturentscheidung ist „Nein sagen“ — oder eine Funktion löschen. KI kann Opportunitätskosten oder politische Risiken nicht messen. Teams sollten das tun — und tun es auch.