Beginnen Sie mit dem Problem: Welche manuelle Arbeit wollen Sie erfassen?

Bevor Sie Bildschirme skizzieren oder eine Datenbank wählen: klären Sie, was genau Sie messen wollen. Ziel ist nicht „alles festhalten, was Mitarbeitende tun“. Es geht darum, manuelle Arbeit zuverlässig genug zu erfassen, um zu entscheiden, was zuerst automatisiert wird—auf Basis von Belegen, nicht Meinungen.

Definieren Sie die manuelle Arbeit in einfachen Worten

Schreiben Sie die wiederkehrenden Tätigkeiten auf, die derzeit von Hand erledigt werden (Copy/Paste zwischen Systemen, Neu‑Eingabe von Daten, Dokumentprüfungen, Einholung von Genehmigungen, Abgleich von Tabellen). Beschreiben Sie für jede Tätigkeit:

- Was sie auslöst (eine neue Bestellung, eine E‑Mail, eine wöchentliche Frist)

- Wie „fertig“ aussieht (eingereicht, geprüft, bezahlt, versandt)

- Wo sie stattfindet (welche Tools, Ordner, Postfächer)

Wenn Sie es nicht in zwei Sätzen beschreiben können, mischen Sie wahrscheinlich mehrere Workflows.

Identifizieren Sie die Zielnutzer (und ihre Anreize)

Eine Tracking‑App ist dann erfolgreich, wenn sie allen dient, die mit der Arbeit zu tun haben – nicht nur der Person, die den Bericht haben will.

- Operatoren / Frontline‑Mitarbeiter: brauchen schnelles Logging mit minimaler Unterbrechung.

- Team‑Leads: brauchen Sichtbarkeit auf Engpässe und Ausnahmen.

- Manager: brauchen Priorisierungssignale für Automatisierung und Personalplanung.

- Finanzen: brauchen glaubwürdige Zahlen für Kosten, ROI und Budget.

- IT / Automatisierungsteam: braucht saubere Eingaben, um Automationen sicher zu bauen.

Erwarten Sie unterschiedliche Motivationen: Operatoren wollen weniger Admin‑Aufwand, Manager wollen Planbarkeit, IT will stabile Anforderungen.

Entscheiden Sie, welche Ergebnisse Sie messen

Tracking ist nur nützlich, wenn es an Ergebnisse gekoppelt ist. Wählen Sie eine kleine Menge, die Sie konsistent berechnen können:

- Eingesparte Zeit: Basiswert manuelle Minuten pro Aufgabe, dann Vergleich nach Änderungen.

- Fehlerreduktion: Nachbearbeitungen, Korrekturen, fehlgeschlagene Prüfungen.

- Durchlaufzeit: vom Auslöser bis zur Fertigstellung, inkl. Wartezeiten.

- Compliance / Prüfbarkeit: Nachweis, dass erforderliche Schritte passiert sind (wer, was, wann).

Klären Sie, was die App nicht ist

Definieren Sie Grenzen früh, damit Sie nicht aus Versehen ein Monster bauen.

Diese App ist typischerweise kein:

- Vollständiger ERP‑Ersatz

- Umfassendes Ticketing‑System

- Workforce‑Monitoring‑Tool

Sie kann diese Systeme ergänzen — und manchmal einen schmalen Ausschnitt ersetzen — wenn das explizit beabsichtigt ist. Wenn Sie bereits Tickets nutzen, könnte Ihre Tracking‑App einfach strukturierte „manuelle Aufwands“‑Daten an bestehenden Einträgen anfügen (siehe /blog/integrations).

Wählen Sie die Workflows und legen Sie den Scope fest

Der Erfolg einer Tracking‑App steht und fällt mit Fokus. Wenn Sie versuchen, jede „beschäftigende“ Tätigkeit zu erfassen, sammeln Sie Rauschen, frustrieren Nutzer und wissen am Ende trotzdem nicht, was zuerst zu automatisieren ist. Starten Sie mit kleinem, explizitem Scope, der sich konsistent messen lässt.

Wählen Sie die ersten 3–5 Workflows

Wählen Sie Workflows, die häufig, wiederholbar und bereits schmerzhaft sind. Ein guter Start deckt verschiedene Arten manuellen Aufwands ab, z. B.:

- Copy/Paste zwischen Systemen (z. B. CRM → Tabelle → E‑Mail)

- Dateneingabe und Umformatierung (z. B. Rechnungen, Kundenaktualisierungen)

- Genehmigungen (Rabatte, Rückerstattungen, Zugriffsanfragen)

- Abgleiche (Zahlungen, Inventurprüfungen)

- Reporting (wöchentliche Status‑Updates, manuell zusammengestellt)

Definieren Sie, was als „manuelle Arbeit“ zählt

Formulieren Sie eine einfache Definition, die alle gleich anwenden können. Beispiel: „Jeder Schritt, bei dem eine Person Informationen bewegt, prüft oder transformiert, ohne dass das System dies automatisch erledigt.“ Fügen Sie Beispiele und einige Ausschlüsse hinzu (z. B. Kundenanrufe, kreative Texte, Beziehungsarbeit), damit nicht alles geloggt wird.

Setzen Sie Grenzen, um Scope Creep zu vermeiden

Seien Sie explizit, wo der Workflow beginnt und endet:

- Eingeschlossene (und ausgeschlossene) Abteilungen/Teams

- Regionen und Kanäle (Telefon, E‑Mail, persönlich)

- Beteiligte Systeme (und Systeme, die Sie vorerst nicht integrieren)

Stimmen Sie ein Messfenster ab

Entscheiden Sie, wie Zeit erfasst wird: pro Aufgabe, pro Schicht oder pro Woche. „Pro Aufgabe“ liefert das beste Automatisierungs‑Signal, aber „pro Schicht/Woche“ kann ein praktisches MVP sein, wenn Aufgaben zu fragmentiert sind. Wichtig ist Konsistenz, nicht Präzision.

Kartieren Sie den aktuellen Prozess, bevor Sie etwas entwerfen

Bevor Sie Felder, Screens oder Dashboards wählen: bekommen Sie ein klares Bild davon, wie die Arbeit heute wirklich abläuft. Eine leichte Prozesskarte deckt auf, was Sie verfolgen sollten und was Sie ignorieren können.

Erstellen Sie eine einfache Workflow‑Karte

Starten Sie mit einem einzelnen Workflow und schreiben Sie ihn in eine gerade Linie:

Auslöser → Schritte → Übergaben → Ergebnis

Bleiben Sie konkret. „Anfrage landet im gemeinsamen Postfach“ ist besser als „Intake passiert“. Notieren Sie für jeden Schritt, wer ihn macht, welches Tool verwendet wird und was „fertig“ heißt. Wenn es Übergaben gibt (Sales → Ops, Ops → Finance), heben Sie diese hervor — an Übergaben geht Arbeit oft verloren.

Halten Sie fest, wo Verzögerungen und Nacharbeit passieren

Ihre Tracking‑App sollte Reibung sichtbar machen, nicht nur Aktivität. Markieren Sie im Flow:

- Warten auf fehlende Infos (Kundendaten, Anhänge, Bestätigung)

- Genehmigungen (wer genehmigt, wie lange, was abgelehnt wird)

- Systemzugriffs‑Beschränkungen (Permissions, Queues, Rate‑Limits)

- Rework‑Schleifen (Aufgabe geht an einen vorherigen Schritt zurück)

Diese Verzögerungspunkte werden später wertvolle Felder (z. B. „blocked reason“) und Prioritäten für Automatisierung.

Identifizieren Sie Quellen der Wahrheit

Listen Sie Systeme, auf die sich Leute verlassen: E‑Mail‑Threads, Tabellen, Ticketing‑Tools, Shared Drives, Legacy‑Apps, Chatnachrichten. Wenn mehrere Quellen abweichen, notieren Sie, welche als maßgeblich gilt. Das ist essentiell für spätere Integrationen und vermeidet doppelte Dateneingabe.

Dokumentieren Sie Variabilität und Ausnahmen

Manuelle Arbeit ist oft unordentlich. Notieren Sie typische Gründe für Abweichungen: spezielle Kundenvorgaben, fehlende Dokumente, regionale Regeln, Einmalgenehmigungen. Sie müssen nicht jede Edge‑Case modellieren — erfassen Sie die Kategorien, die erklären, warum Aufgaben länger dauerten oder zusätzliche Schritte brauchten.

Entwerfen Sie die Daten, die Sie erfassen müssen (ohne Overkill)

Der Erfolg hängt davon ab, ob Leute Arbeit schnell protokollieren können und gleichzeitig nutzbare Daten entstehen. Ziel ist nicht „alles sammeln“, sondern gerade genug Struktur, um Muster zu erkennen, Impact zu quantifizieren und wiederholte Probleme in Automatisierungs‑Kandidaten zu verwandeln.

Beginnen Sie mit einer kleinen, wiederverwendbaren Menge Entitäten

Halten Sie Ihr Kern‑Datenmodell einfach und konsistent teamübergreifend:

- Work Item: die verarbeitete Einheit (Bestellung, Anfrage, Ticket, Anspruch). Falls vorhanden, eine externe Referenz‑ID.

- Prozess und Schritt: wo die Arbeit sitzt (z. B. „Rückerstattungen“ → „Beleg prüfen“). Schritte zeigen Engpässe, ohne komplexe Analysen.

- Task: eine einzelne Einheit manueller Arbeit zu einem Zeitpunkt (oft verknüpft mit Work Item + Schritt).

- Zuständiger: wer es gemacht hat (optional Team/Rolle).

- System: welche Tools beteiligt waren (CRM, Tabelle, E‑Mail, Portal).

- Beweis (optional): Anhänge oder Links zu Screenshots/Dateien für Audits.

Diese Struktur unterstützt tägliches Logging und spätere Analysen, ohne Nutzer zu einem langen Fragebogen zu zwingen.

Erfassen Sie Zeit auf eine freundliche, geringe Reibung verursachende Weise

Zeit ist entscheidend für Priorisierung, darf aber nicht aufwendig sein:

- Start/Stop‑Timer für fokussierte Arbeit.

- Manuelle Einträge, wenn Aufgaben in kurzen Stücken passieren.

- Batch‑Bearbeitung für repetitive Aktionen („hab das 12× heute gemacht").

Wenn Zeit wie „Kontrolle“ wirkt, sinkt die Akzeptanz. Positionieren Sie sie als Mittel zur Beseitigung von Mehrarbeit, nicht zur Überwachung.

Erfassen Sie das „Warum manuell“ mit leichten Kategorien

Fügen Sie ein Pflichtfeld hinzu, das erklärt, warum die Arbeit nicht automatisiert war:

- Fehlende Integration

- Vorschrift/Compliance‑Anforderung

- Unklare Regeln / Edge‑Cases

- Tool‑Limitierungen oder schlechte UX

Dropdown + optionaler Kommentar: das Dropdown macht Berichte möglich, die Notiz liefert Kontext bei Ausnahmen.

Speichern Sie strukturierte Outcomes (damit Logs handlungsfähig werden)

Jeder Task sollte mit einigen konsistenten Ergebnissen enden:

- Status (abgeschlossen, blockiert, eskaliert)

- Fehlertyp (falls relevant)

- Rework‑Zähler (0, 1, 2+)

- Abschlussnotiz (kurz, optional)

Mit diesen Feldern quantifizieren Sie Verschwendung (Rework), identifizieren Fehlermodi (Fehlertypen) und bauen ein glaubwürdiges Automatisierungs‑Backlog aus realer Arbeit, nicht aus Gefühlen.

Wenn das Anlegen eines Arbeitseintrags länger dauert als die Aufgabe selbst, springen Leute ab – oder geben unbrauchbare Angaben ein. Ihr UX‑Ziel: minimale nützliche Angaben mit niedrigster Reibung erfassen.

Unverzichtbare Screens (einfach halten)

Starten Sie mit wenigen Bildschirmen, die den kompletten Zyklus abdecken:

- Task‑Intake: schnelle Möglichkeit, Arbeit hinzuzufügen (manuelle Eingabe oder „aus Vorlage erstellen").

- Arbeitswarteschlange: priorisierte Liste mit Filtern (neu, in Arbeit, blockiert, erledigt).

- Work‑Item‑Detail: Kontext, Status, Notizen und klare „nächste Aktion“.

- Zeit/Beweis‑Erfassung: Start/Stop‑Timer, schnelle Dauerangabe, Dateien anhängen oder Links einfügen.

- Reports: leichtgewichtige Ansicht von Volumen, verbrachter Zeit und Top‑Gründen/Outcomes.

Machen Sie es schnell: weniger Klicks, mehr Flow

Designen Sie für Geschwindigkeit statt Vollständigkeit. Bieten Sie Tastaturkürzel für häufige Aktionen (Item anlegen, Status ändern, speichern). Stellen Sie Vorlagen für wiederkehrende Arbeit bereit, damit Nutzer nicht immer dieselben Beschreibungen tippen.

Nutzen Sie In‑Place‑Editing und sinnvolle Voreinstellungen (z. B. aktueller Nutzer als Standard‑Assignee, „gestartet um“ beim Öffnen setzen).

Geführte Felder, die Daten standardisieren

Freitext ist nützlich, aggregiert aber schlecht. Ergänzen Sie geführte Felder, die Reportings zuverlässig machen:

- Dropdowns für Grund, Ergebnis, Fehlertyp und Kanal (E‑Mail/Chat/Telefon)

- Pflichtfelder nur dort, wo sie Mehrdeutigkeit verhindern – nicht „weil wir es können"

Barrierefreiheit, die Sie nicht überspringen sollten

Machen Sie die App lesbar und nutzbar für alle: hoher Kontrast, klare Labels (nicht nur Platzhalter), sichtbare Fokus‑Zustände für Tastaturnavigation und mobilfreundliche Layouts für schnelles Logging unterwegs.

Berechtigungen, Genehmigungen und Prüfbarkeit

Tracker schnell prototypen

Erstelle eine React-Webapp mit Go-API und PostgreSQL, ohne bei Null anzufangen.

Wenn Ihre App Automatisierungsentscheidungen steuern soll, müssen Menschen den Daten vertrauen. Vertrauen bricht, wenn jeder alles bearbeiten kann, Genehmigungen unklar sind oder Änderungen nicht nachvollziehbar sind. Ein einfaches Berechtigungsmodell plus leichtes Audit‑Trail löst die meisten Probleme.

Definieren Sie klare Rollen (und halten Sie sie einfach)

Starten Sie mit vier Rollen, die dem tatsächlichen Logging‑Verhalten entsprechen:

- Contributor: erfasst manuelle Arbeit (Zeit, Schritte, Beweise) und bearbeitet eigene Entwürfe.

- Reviewer/Approver: validiert Einträge, fordert Klarstellungen an, genehmigt oder lehnt ab.

- Manager: sieht Teamaktivität, löst Konflikte und kann genehmigen überschreiben.

- Admin: konfiguriert Workflows, Berechtigungen, Aufbewahrung und Integrationen.

Vermeiden Sie frühzeitig benutzerindividuelle Regeln; rollenbasierte Zugriffe sind leichter zu erklären und zu pflegen.

Bearbeitungsregeln nach Einreichung

Entscheiden Sie, welche Felder „Fakten“ und welche „Notizen“ sind, und sperren Sie die Fakten nach der Prüfung.

Praktischer Ansatz:

- Contributors können Entwürfe frei bearbeiten.

- Nach dem Einreichen dürfen Contributors nur nicht‑kritische Felder (z. B. Beschreibung) ändern, bis die Prüfung beginnt.

- Nach Genehmigung sollten Änderungen an Zeitangaben, Workflow/Status, Kosten oder Beweisen auf Reviewer/Manager beschränkt und idealerweise begründet werden.

So bleiben Reports stabil und Korrekturen dennoch möglich.

Audit‑Trail, der „wer hat was geändert?“ beantwortet

Führen Sie ein Aktivitätsprotokoll für Schlüsselereignisse: Statuswechsel, Zeitänderungen, Genehmigungen/Ablehnungen, hinzugefügte/entfernte Beweise und Berechtigungsänderungen. Speichern Sie mindestens: Akteur, Zeitstempel, alter Wert, neuer Wert und (optional) kurzen Kommentar.

Machen Sie das Protokoll auf jedem Datensatz sichtbar (z. B. ein „Aktivität“‑Tab), damit Streitfragen nicht in Slack‑Archäologie enden.

Aufbewahrung und Umgang mit Beweisen

Legen Sie Aufbewahrungsregeln früh fest: wie lange Logs und zugehörige Beweise (Bilder, Dateien, Links) aufbewahrt werden. Viele Teams wählen 12–24 Monate für Logs und kürzere Fristen für große Anhänge.

Wenn Sie Uploads erlauben, behandeln Sie sie als Teil der Audit‑Story: Versionierung von Dateien, Protokoll für Löschungen und rollenbasierte Zugriffsbeschränkungen. Das ist wichtig, wenn ein Eintrag Basis für ein Automatisierungsprojekt wird.

Technische Architektur für ein praktisches MVP

Ein praktisches MVP soll leicht zu bauen, leicht zu ändern und langweilig zu betreiben sein. Ziel ist nicht, Ihre zukünftige Automatisierungsplattform vorherzusagen, sondern manuelle Arbeit zuverlässig mit minimaler Reibung zu dokumentieren.

Ein einfacher, skalierbarer Baseline‑Aufbau

Beginnen Sie mit einer übersichtlichen Struktur:

- Web‑Client (Browser‑UI)

- API (Business‑Logik + Validierung)

- Datenbank (strukturierte Datensätze)

- Dateispeicher (Screenshots, PDFs, exportierte E‑Mails)

Diese Trennung hält die UI schnell iterierbar, während die API die Quelle der Wahrheit bleibt.

Wählen Sie bewährte Komponenten

Nutzen Sie einen Stack, den Ihr Team schnell liefern kann und der starke Community‑Unterstützung hat. Häufige Kombinationen:

- Frontend: React oder Vue

- Backend: Node (Express/Nest), Django oder Rails

- Datenbank: Postgres

- Dateispeicher: S3‑kompatibler Speicher (oder Managed‑Äquivalent)

Vermeiden Sie exotische Technik am Anfang — Ihr größtes Risiko ist Produktunsicherheit, nicht Performance.

Wenn Sie das MVP beschleunigen wollen, ohne sich in eine Sackgasse zu manövrieren, kann eine Low‑Code‑Plattform wie Koder.ai helfen: vom geschriebenen Spec zu einer funktionierenden React‑App mit Go‑API und PostgreSQL per Chat, mit Option, den Quellcode zu exportieren, zu deployen und per Snapshots zurückzurollen. Das ist besonders nützlich für interne Tools, deren Anforderungen sich nach dem ersten Pilot schnell ändern.

Definieren Sie die API um Nutzeraktionen herum

Entwerfen Sie Endpunkte, die spiegeln, was Nutzer tun, nicht wie Ihre Tabellen heißen. Typische „Verb‑förmige“ Fähigkeiten:

- Ein Work Item erstellen (Task/Case)

- Zeit protokollieren (Start/Stop oder Dauer + Notiz)

- Beweise anhängen (Datei‑Upload + kurze Beschreibung)

- Status ändern (z. B. New → In Progress → Done)

So können Sie später Clients (Mobile, Integrationen) einfacher unterstützen, ohne Ihre Kernlogik neu zu schreiben.

POST /work-items

POST /work-items/{id}/time-logs

POST /work-items/{id}/attachments

POST /work-items/{id}/status

GET /work-items?assignee=me&status=in_progress

Planen Sie CSV‑Import/Export von Anfang an

Frühe Nutzer fragen fast immer: „Kann ich vorhandene Daten hochladen?“ und „Kann ich meine Daten herausbekommen?“ Bieten Sie:

- CSV‑Import für Migration oder Bulk‑Erstellung

- CSV‑Export für Reporting, Audits und Vertrauen

Das reduziert Nach‑Eingabe, beschleunigt Onboarding und verhindert, dass Ihr MVP wie eine Dead‑End‑Lösung wirkt.

Integrationen, die Logging‑Aufwand reduzieren

Sorgenfrei iterieren

Ändere sicher, während dein Pilot läuft – mit Snapshots und Rollback.

Wenn Ihre App davon abhängt, dass Menschen sich an alles erinnern, wird die Nutzung mit der Zeit nachlassen. Ein pragmatischer Weg: starten Sie mit manueller Eingabe (so ist der Workflow klar) und ergänzen Sie nur dort Konnektoren, wo sie wirklich Aufwand sparen — besonders bei hohem Volumen und repetitiver Arbeit.

Wo Integrationen am meisten helfen

Suchen Sie nach Schritten, an denen Teams bereits Spuren hinterlassen. Häufige „niedrigschwellige“ Integrationen:

- E‑Mail‑Ingestion: Nachrichten an eine spezielle Adresse weiterleiten, um ein Work Item zu erstellen/aktualisieren.

- Tabellen: Zeilen importieren (oder synchronisieren) aus bestehenden Sheets.

- Slack/Teams: kurze Erinnerungen („Ergebnis protokollieren“) und Status‑Benachrichtigungen bei Genehmigung/Umschichtung.

- Webhooks: Events von anderen Tools empfangen (Formular‑Absendungen, Ticket‑Updates, Zahlungsausfälle) und automatisch einen Entwurf anlegen.

Verwenden Sie eindeutige Identifikatoren, um Verknüpfungen herzustellen

Integrationen werden schnell unübersichtlich, wenn Sie Items nicht zuverlässig matchen können. Erzeugen Sie einen eindeutigen Identifier (z. B. MW-10482) und speichern Sie externe IDs daneben (E‑Mail‑Message‑ID, Tabellen‑Row‑Key, Ticket‑ID). Zeigen Sie diese ID in Benachrichtigungen und Exporten, damit alle dieselbe Referenz nutzen.

Planen Sie partielle Automatisierung (nicht Alles‑oder‑Nichts)

Ziel ist nicht, Menschen sofort zu ersetzen, sondern Tippaufwand zu reduzieren und Nacharbeit zu vermeiden.

Füllen Sie Felder per Integration vor (Anfragender, Betreff, Zeitstempel, Anhänge), aber lassen Sie menschliche Korrektur zu, damit der Log die Realität widerspiegelt. Eine E‑Mail kann Kategorie und geschätzten Aufwand vorschlagen; die Person bestätigt dann die tatsächlich aufgewendete Zeit und das Ergebnis.

Gute Regel: Integrationen erstellen standardmäßig Entwürfe, Menschen müssen „bestätigen und absenden“, bis die Zuordnung zuverlässig ist.

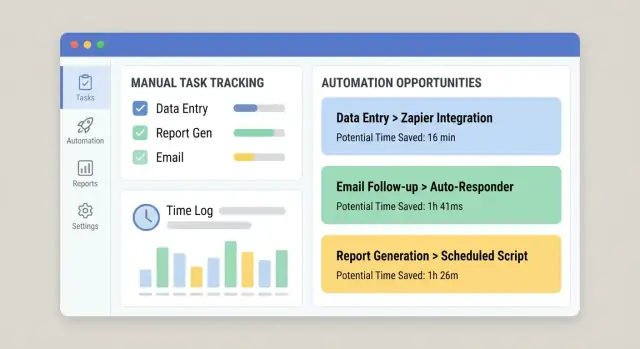

Logs in ein Automatisierungs‑Backlog verwandeln

Das Tracking ist nur dann wertvoll, wenn es zu Entscheidungen führt. Ziel der App sollte sein, rohe Logs in eine priorisierte Liste von Automatisierungs‑Chancen zu wandeln — Ihr „Automatisierungs‑Backlog“ — das sich leicht in einem wöchentlichen Ops‑ oder Verbesserungs‑Meeting prüfen lässt.

Erstellen Sie vertrauenswürdige Scoring‑Kriterien

Starten Sie mit einem einfachen, erklärbaren Score, damit Stakeholder nachvollziehen, warum etwas oben landet. Praktische Kriterien:

- Volumen: wie oft es vorkommt (pro Tag/Woche/Monat)

- Zeit pro Task: Median Minuten pro Abschluss (nicht das Maximum)

- Fehlerquote: wie oft Rework, Korrekturen oder Eskalationen auftreten

- Geschäftsimpact: Kosten, Kundenwirkung, Compliance‑Risiko, SLA‑Verstöße

- Machbarkeit: Regelklarheit, Systemzugang, Stabilität der Eingaben, Anzahl Ausnahmen

Machen Sie den Score neben den zugrunde liegenden Zahlen sichtbar, damit er kein Black‑Box‑Ergebnis ist.

Generieren Sie ein „Automatisierungs‑Backlog“ aus realer Aktivität

Bieten Sie eine Ansicht, die Logs in wiederkehrende „Work Items“ gruppiert (z. B. „Kundendaten in System A aktualisieren, anschließend in System B bestätigen“). Rangieren Sie automatisch nach Score und zeigen Sie:

- Gesamt zeitaufwand (letzte 30/90 Tage)

- Frequenz‑Trends

- Top‑Teams/Rollen

- Häufige Fehlerpunkte (wo Nutzer „blockiert“ markierten oder Rework vermerkte)

Markieren Sie wiederkehrende Muster, um Automatisierbares zu finden

Machen Sie Tagging leicht: Ein‑Klick Tags wie System, Input‑Typ, Ausnahme‑Typ. Über Zeit zeigen sie stabile Muster (geeignet zur Automatisierung) gegenüber chaotischen Einzelfällen (besser für Training oder Prozessanpassungen).

Fügen Sie eine einfache ROI‑Schätzung hinzu

Eine einfache Formel reicht:

ROI (Zeit) = (gesparte Zeit × Häufigkeit) − Wartungsannahme

Für Wartung verwenden Sie eine fixe Monatsstunden‑Annahme (z. B. 2–6 Std./Monat), damit Teams Chancen konsistent vergleichen. So bleibt das Backlog auf Impact fokussiert, nicht auf Meinungen.

Reporting und Dashboards, die Menschen tatsächlich nutzen

Dashboards sind nur hilfreich, wenn sie echte Fragen schnell beantworten: „Woran verbringen wir Zeit?“, „Was bremst uns?“ und „Hat unsere letzte Änderung geholfen?“ Gestalten Sie Reports für Entscheidungen, nicht für Eitelkeitsmetriken.

Beginnen Sie mit leader‑gerechten Ansichten

Führungskräfte wollen meist keine Details, sondern klare Signale. Eine praktische Basis‑Übersicht enthält:

- Stunden, die auf manuelle Arbeit entfallen, aufgeschlüsselt nach Team, Workflow und Kategorie

- Top manuelle Prozesse (nach Gesamtzeit, Frequenz oder beidem)

- Zykluszeit (Start → Abschluss) und wo Zeit wartend verbracht wird

- Rework (wieder geöffnete Items, zurückgesendete Einträge, nachträgliche Änderungen)

Jede Karte sollte klickbar sein, damit man von einer Übersichtskennzahl direkt zum „was treibt das?“ kommt.

Zeigen Sie Trends und Vorher/Nachher‑Vergleiche

Eine einzelne Woche kann irreführend sein. Bauen Sie Trendlinien und einfache Datumsfilter (letzte 7/30/90 Tage) ein. Wenn Sie einen Workflow ändern — z. B. Integration hinzufügen oder Formular vereinfachen — machen Sie Vorher‑vs‑Nachher‑Vergleiche einfach.

Leichte Maßnahme: speichern Sie ein „Change‑Marker“ (Datum + Beschreibung) und zeigen Sie eine vertikale Linie in Charts, damit Verbesserungen leichter kausal zugeordnet werden können.

Vermeiden Sie irreführende Metriken

Tracking mischt harte Daten (Timestamps, Counts) und weichere Angaben (geschätzte Zeit). Kennzeichnen Sie Metriken deutlich:

- Gemessen: automatisch erfasst (Start/Endzeiten, Anzahl Items)

- Gemeldet: von Nutzern eingegeben (verbrachte Zeit, Grundcodes)

- Abgeleitet: berechnet (Durchlaufzeit, Rework‑Rate)

Wenn Zeit geschätzt ist, sagen Sie es in der UI. Ehrlich sein ist besser als falsch‑präzise aussehen.

Ermöglichen Sie Drill‑Down zu Work Items

Jedes Diagramm sollte „zeige mir die Datensätze“ unterstützen. Drill‑Down schafft Vertrauen und beschleunigt Aktionen: Nutzer filtern nach Workflow, Team und Zeitraum und öffnen dann die zugrunde liegenden Work Items, um Notizen, Übergaben und Blocker zu sehen.

Verknüpfen Sie Dashboards mit der „Automatisierungs‑Backlog“‑Ansicht, damit die größten Zeitfresser sofort in Kandidaten für Verbesserungen umgewandelt werden, solange der Kontext frisch ist.

Sicherheits‑ und Zuverlässigkeits‑Basics

Definiere deine ersten Workflows

Nutze den Planungsmodus, um 3–5 Workflows zu definieren, bevor du Bildschirme generierst.

Wenn Ihre App abbildet, wie Arbeit erledigt wird, sammelt sie schnell sensible Details: Kundennamen, interne Notizen, Anhänge und „wer hat was wann getan“. Sicherheit und Zuverlässigkeit sind keine Extras — ohne sie verlieren Sie Vertrauen (und Nutzung).

Schützen Sie Daten mit Least Privilege

Beginnen Sie mit rollenbasiertem Zugriff, der realen Verantwortlichkeiten entspricht. Die meisten Nutzer sollten nur eigene Logs oder die ihres Teams sehen. Beschränken Sie Admin‑Rechte auf wenige Personen und trennen Sie „Einträge bearbeiten“ von „Daten exportieren/genehmigen“.

Bei Datei‑Uploads: behandeln Sie jede Anlage als untrusted:

- Scannen Sie Uploads (oder nutzen Sie einen Provider, der das macht).

- Speichern Sie Dateien in privatem Object‑Storage, nicht auf dem Webserver‑Filesystem.

- Nutzen Sie kurzlebige signierte URLs zum Download.

Baseline‑Abwehrmaßnahmen

Sie brauchen kein Enterprise‑Security‑Set, aber die Basics müssen stimmen:

- Authentifizierung (SSO wenn möglich, sonst starke Passwörter + MFA)

- Rate‑Limiting bei Login und schreibintensiven Endpunkten

- Serverseitige Input‑Validierung für alle Felder, besonders Freitext und IDs

- Regelmäßige Backups mit getesteter Wiederherstellungsprozedur

Logging, das hilft (ohne Geheimnisse zu verraten)

Erfassen Sie Systemereignisse für Troubleshooting und Audits: Anmeldungen, Berechtigungsänderungen, Genehmigungen, Importjobs und fehlgeschlagene Integrationen. Halten Sie Logs strukturiert und durchsuchbar, aber speichern Sie keine Geheimnisse — schreiben Sie nie API‑Tokens, Passwörter oder vollständige Anhangsinhalte in Logs. Redacten Sie sensible Felder per Default.

Compliance‑Readiness (nur wenn relevant)

Wenn Sie PII verarbeiten, entscheiden Sie früh:

- Aufbewahrungsregeln (wie lange Logs/Anlagen bleiben)

- Export‑ und Löschprozesse für Zugriffsanfragen

- Wo Daten liegen und wer Zugriff hat

Diese Entscheidungen beeinflussen Schema, Berechtigungen und Backups — einfacher jetzt zu planen als später nachzurüsten.

Rollout‑Plan, Adoption und kontinuierliche Verbesserung

Eine Tracking‑App lebt von Adoption. Behandeln Sie den Rollout wie ein Produkt‑Release: klein anfangen, Verhalten messen und schnell iterieren.

Starten Sie mit einem fokussierten Pilot

Pilotieren Sie mit einem Team—am besten einem, das den Schmerz schon spürt und klare Workflows hat. Halten Sie Scope eng (ein bis zwei Work‑Typen), damit Sie Nutzer eng unterstützen und die App anpassen können, ohne die ganze Organisation zu stören.

Sammeln Sie während des Piloten Feedback in Echtzeit: einen Ein‑Klick „Das war schwierig“‑Button nach dem Logging plus ein wöchentliches 15‑Minuten Check‑In. Wenn die Nutzung stabil ist, erweitern Sie auf das nächste ähnliche Team.

Definieren Sie Erfolgsmetriken früh

Setzen Sie sichtbare Ziele, damit alle wissen, was „gut“ ist:

- % der erfassten Arbeit (Coverage)

- Datenqualität (z. B. ausgefüllte Pflichtfelder, weniger „Sonstiges“-Auswahlen)

- Verringerte manuelle Stunden (selbstberichtigt oder inferiert durch weniger Repeat‑Tasks)

Tracken Sie das in einem internen Dashboard und besprechen Sie es mit Team‑Leads.

Lernen im Tun leicht machen

Bieten Sie In‑App‑Hilfen, wo Nutzer zögern:

- Beispiele unter Feldern („Gute Beschreibung: ‘Rechnung #1842 abgleichen’“)

- Tooltips für Kategorien und Tags

- Kurzes Onboarding beim ersten Login (2–3 Schritte max.)

Verbesserung kontinuierlich und sichtbar halten

Setzen Sie einen Review‑Rhythmus (monatlich funktioniert gut), um zu entscheiden, was als Nächstes automatisiert wird und warum. Priorisieren Sie mit Log‑Daten: hohe Frequenz + hoher Zeitaufwand zuerst, mit klaren Verantwortlichen und erwarteter Wirkung.

Schließen Sie den Kreis, indem Sie Ergebnisse zeigen: „Weil Sie X protokolliert haben, haben wir Y automatisiert.“ Das ist der schnellste Weg, weitere Logs zu bekommen.

Wenn Sie schnell über Teams iterieren, überlegen Sie Tools, die Änderungen erlauben, ohne die App zu destabilisieren. Zum Beispiel unterstützt Koder.ai Planning Mode, mit dem Sie Scope und Flows skizzieren, bevor Sie Änderungen generieren; Snapshots/Rollback machen es sicherer, Felder, Workflows und Berechtigungen beim Pilotlernen anzupassen.