13. Mai 2025·8 Min

Wie man eine Web‑App für systemübergreifenden Datenabgleich baut

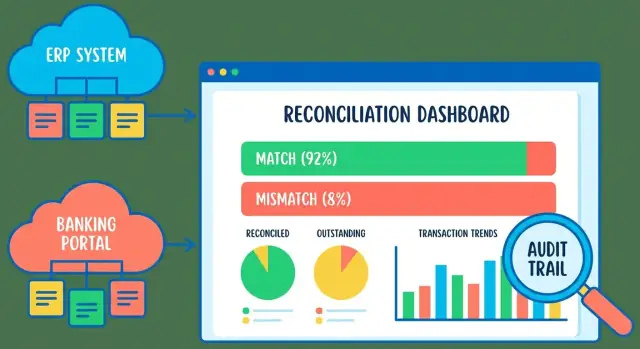

Erfahren Sie, wie Sie eine Web‑App planen, bauen und einführen, die Daten systemübergreifend abgleicht: Importe, Matching‑Regeln, Ausnahmeverwaltung, Prüfpfad und Reporting.

Was systemübergreifender Datenabgleich bedeutet

Abgleich (Reconciliation) ist der Vorgang, dieselbe geschäftliche Aktion in zwei (oder mehr) Systemen zu vergleichen, um sicherzustellen, dass sie übereinstimmen. Einfach gesagt hilft Ihre App den Anwendern, drei Fragen zu beantworten: was übereinstimmt, was fehlt und was sich unterscheidet.

Eine Web‑App für den Datenabgleich nimmt typischerweise Datensätze aus System A und System B (oft erstellt von unterschiedlichen Teams, Anbietern oder Integrationen), bringt sie mithilfe klarer Regeln zur Zuordnung von Datensätzen in Übereinstimmung und liefert dann Ergebnisse, die Menschen überprüfen und weiterverarbeiten können.

Häufige Anwendungsfälle für den Abgleich

Die meisten Teams fangen hier an, weil die Eingaben vertraut sind und der Nutzen sofort sichtbar wird:

- Zahlungen vs. Rechnungen: bestätigen, dass Kundenzahlungen den richtigen Rechnungen zugeordnet werden und Short‑Pays, Überzahlungen oder nicht angewiesene Zahlungen erkannt werden.

- Lieferungen vs. Bestellungen: prüfen, ob das Gelieferte der Bestellung entspricht, inklusive Teillieferungen und Rückständen.

- Lohnabrechnung vs. Stundenzettel: sicherstellen, dass eingereichte Stunden korrekt bezahlt wurden und fehlende Genehmigungen oder falsche Sätze auffallen.

All dies sind Beispiele für systemübergreifenden Datenabgleich: die Wahrheit ist verteilt, und Sie benötigen eine konsistente Möglichkeit, sie zu vergleichen.

Die wichtigsten Ausgaben, die Ihre App liefern sollte

Eine gute Datenabgleichs‑Web‑App vergleicht nicht nur — sie erzeugt Ergebnisse, die den weiteren Workflow antreiben:

- Abgeglichenen Einträge: Datensätze, die die App gemäß Ihrer Regeln sicher paaren (oder gruppieren) kann.

- Nicht zugeordnete Einträge: Datensätze, die in einem System vorhanden, im anderen jedoch (noch) nicht sind. Diese spiegeln häufig Timing‑Unterschiede, fehlende Daten oder Importprobleme wider.

- Anpassungen: dokumentierte Maßnahmen zur Lösung von Unterschieden — z. B. Ausbuchung einer kleinen Abweichung, Korrektur einer Referenz‑ID oder Aufteilung einer Zahlung auf mehrere Rechnungen.

Diese Ergebnisse fließen direkt in Ihr Abgleichs‑Dashboard, Berichte und nachgelagerte Exporte ein.

Woran Erfolg zu erkennen ist

Das Ziel ist nicht, einen perfekten Algorithmus zu bauen — sondern dem Geschäft zu helfen, Schleifen schneller zu schließen. Ein gut gestalteter Abgleichsprozess führt zu:

- Schnelleren Abschlüssen: weniger manuelle Tabellenkalkulationen und Hin‑und‑Her beim Wochen‑ oder Monatsabschluss.

- Weniger Fehlern: frühe Datenimport‑ und -validierung sowie Datenqualitätsprüfungen fangen Probleme, bevor sie zu Ausnahmen werden.

- Nachvollziehbaren Entscheidungen: jede Zuordnung und Anpassung ist später durch Genehmigungen und einen Prüfpfad erklärbar.

Wenn Nutzer schnell sehen können, was übereinstimmt, verstehen, warum etwas nicht übereinstimmt, und dokumentieren können, wie es gelöst wurde, läuft der Abgleich richtig.

Umfang, Datenquellen und Erfolgskriterien definieren

Bevor Sie Bildschirme entwerfen oder Zuordnungslogik schreiben, klären Sie, was "Abgleich" für Ihr Geschäft bedeutet und wer auf das Ergebnis angewiesen ist. Ein enger Scope verhindert endlose Edge‑Cases und hilft bei der Wahl des richtigen Datenmodells.

Quelle‑Systeme identifizieren (und deren Verantwortliche)

Listen Sie jedes beteiligte System auf und benennen Sie einen Owner, der Fragen beantworten und Änderungen freigeben kann. Typische Stakeholder sind Finance (Hauptbuch, Billing), Operations (Auftragsverwaltung, Lager) und Support (Rückerstattungen, Chargebacks).

Dokumentieren Sie für jede Quelle, was realistisch zugänglich ist:

- Wie Sie die Daten extrahieren (CSV‑Export, API, Datenbank‑View)

- Welche Felder verfügbar sind (IDs, Beträge, Daten, Status, Währung)

- Datenaktualität und bekannte Qualitätsprobleme (späte Updates, Duplikate)

Eine einfache gemeinsame "Systeminventar"‑Tabelle kann früh Wochen an Nacharbeit sparen.

Häufigkeit des Abgleichs und Volumen erwarten

Workflow, Performance‑Anforderungen und Benachrichtigungsstrategie hängen von der Frequenz ab. Entscheiden Sie, ob täglich, wöchentlich oder nur zum Monatsabschluss abgeglichen wird, und schätzen Sie die Volumen:

- Datensätze pro Lauf (z. B. 5.000 Rechnungen/Tag, 200.000 Zahlungen/Monat)

- Spitzenzeiten (Monatsabschluss, Aktionen)

- Wie lange Nutzer auf Ergebnisse warten können (Minuten vs. über Nacht)

Hier legen Sie auch fest, ob Near‑Realtime‑Imports oder geplante Batches nötig sind.

Erfolgskriterien, auf die sich alle einigen

Machen Sie Erfolg messbar, nicht subjektiv:

- Akzeptable Abweichungsrate (z. B. weniger als 0,5 % der Transaktionen erfordern Prüfung)

- Zeit zur Lösung von Ausnahmen (z. B. 80 % innerhalb von 2 Geschäftstagen geschlossen)

- Benötigte Reporting‑Outputs (Zusammenfassungen, Aging, Close‑Package‑Exporte)

Einschränkungen früh erfassen

Abgleichs‑Apps berühren oft sensible Daten. Notieren Sie Datenschutzanforderungen, Aufbewahrungsfristen und Genehmigungsregeln: wer kann Elemente als „gelöst“ markieren, Mappings bearbeiten oder Zuordnungen überschreiben. Wenn Genehmigungen nötig sind, planen Sie von Anfang an einen Prüfpfad, damit Entscheidungen bei Reviews und Monatsabschluss nachvollziehbar sind.

Ihre Daten verstehen und normalisieren

Bevor Sie Matching‑Regeln oder Workflows schreiben, klären Sie, wie ein "Datensatz" in jedem System aussieht — und wie er in Ihrer App aussehen soll.

Typische Datensatzstruktur

Die meisten Abgleichsdatensätze teilen einen vertrauten Kern, auch wenn Feldnamen abweichen:

- Identifikatoren: interne ID, externe Referenz, Rechnungs‑/Transaktionsnummer, Gegenpartei‑ID

- Daten: Transaktionsdatum, Buchungsdatum, Settlement‑Datum

- Beträge: brutto/netto, Steuern, Gebühren, Währung, Vorzeichen (Soll/Haben)

- Statusfelder: autorisiert/gebucht/storniert/erstattet, offen/geschlossen

- Referenzfelder: Verwendungszweck/Beschreibung, Batch‑ID, Bank‑Trace‑Nummer

Die unordentlichen Realitäten, auf die Sie sich einstellen müssen

Systemübergreifende Daten sind selten sauber:

- Fehlende oder unzuverlässige IDs (z. B. Kontoauszugszeilen ohne Rechnungsnummer)

- Unterschiedliche Datumsformate und Zeitzonen ("2025-12-01" vs. "12/1/25", lokale Zeit vs. UTC)

- Rundungs‑ und Genauigkeitsunterschiede (2 vs. 4 Dezimalstellen; unterschiedliche Steuer‑Rundungsregeln)

- Duplikate und Stornierungen (eine Belastung + eine separate Stornierung; wiederholte Exporte)

- Unterschiedliche Vorzeichen (ein System speichert Rückerstattungen negativ, ein anderes als eigene Typen)

Ein kanonisches internes Modell definieren

Erstellen Sie ein kanonisches Modell, das Ihre App für jede importierte Zeile speichert, unabhängig von der Quelle. Frühe Normalisierung hält die Matching‑Logik einfach und konsistent.

Standardisieren Sie mindestens:

- amount_minor (z. B. Cent) + currency

- normalized_date (ISO‑8601, dokumentierte Zeitzone)

- normalized_reference (trimmen, in Großschreibung, überflüssige Leerzeichen entfernen)

- source_system + source_record_id (für Nachvollziehbarkeit)

Feldzuordnung pro Quelle dokumentieren

Pflegen Sie eine einfache Mapping‑Tabelle im Repo, damit jeder sehen kann, wie Imports in das kanonische Modell übersetzt werden:

| Canonical field | Source: ERP CSV | Source: Bank API | Notes |

|---|---|---|---|

| source_record_id | InvoiceID | transactionId | Als String gespeichert |

| normalized_date | PostingDate | bookingDate | In UTC konvertieren |

| amount_minor | TotalAmount | amount.value | Mit 100 multiplizieren, konsistent runden |

| currency | Currency | amount.currency | Gegen erlaubte Liste validieren |

| normalized_reference | Memo | remittanceInformation | Großschreiben + Leerzeichen zusammenfassen |

Diese Normalisierungsarbeit zahlt sich später aus: Prüfer sehen konsistente Werte, und Ihre Matching‑Regeln sind leichter zu erklären und zu vertrauen.

Die Import‑Pipeline entwerfen (Dateien, APIs und Validierung)

Ihre Import‑Pipeline ist die Haustür zum Abgleich. Ist sie verwirrend oder inkonsistent, geben die Nutzer der Matching‑Logik die Schuld für Probleme, die eigentlich bei der Ingestion entstanden sind.

Mehrere Importmethoden unterstützen, ohne drei Systeme zu schaffen

Die meisten Teams beginnen mit CSV‑Uploads, weil sie universell und leicht auditierbar sind. Mit der Zeit fügt man geplante API‑Abfragen (Banken, ERP, Billing) und gegebenenfalls einen Datenbank‑Connector hinzu, wenn das Quellsystem nicht zuverlässig exportieren kann.

Wichtig ist, alles in einen internen Standardfluss zu bringen:

- Ingest (Upload/Pull/Connect)

- Validate (Struktur- und Business‑Regeln)

- Parse/normalize (Daten, Währung, Dezimalstellen, IDs)

- Persist (raw + parsed)

- Summarize (was passiert ist, was Aufmerksamkeit braucht)

Nutzer sollten ein einheitliches Importerlebnis haben, nicht drei separate Features.

Validierung, die schlechte Daten von „mysteriösen Abweichungen" fernhält

Validieren Sie früh und machen Sie Fehler handhabbar. Typische Prüfungen:

- Erforderliche Felder: Transaktionsdatum, Betrag, Währung, Referenz‑IDs

- Typen und Parsing: Datumsparsing (mit Zeitzonenannahmen), numerische Felder, Booleans

- Bereiche: negative Beträge erlaubt? Maximalwerte? sinnvolle Daten?

- Währungscodes: ISO‑Codes erzwingen, Tippfehler erkennen (z. B. “US$” vs. “USD”)

Trennen Sie harte Ablehnungen (kann nicht sicher importiert werden) von weichen Warnungen (importierbar, aber verdächtig). Weiche Warnungen können später in Ihren Ausnahme‑Workflow fließen.

Idempotente Importe: Neuhochladen muss sicher sein

Abgleichsteams laden Dateien ständig neu hoch — nach Mapping‑Korrekturen, Spaltenergänzungen oder Datumsbereichsänderungen. Ihr System sollte Neuimporte als normalen Vorgang behandeln.

Gängige Ansätze:

- Berechnen Sie einen Datei‑Fingerprint (Hash der Rohbytes) und lehnen Duplikate ab oder markieren sie als „bereits importiert“.

- Verwenden Sie einen Source‑Record‑Key (z. B. Kombination aus Quellsystem + externer Transaktions‑ID) und upserten.

- Wenn keine stabile externe ID existiert, generieren Sie einen deterministischen Schlüssel aus ausgewählten Feldern (Datum + Betrag + Gegenpartei + Referenz), und weisen Sie explizit auf Kollisionsrisiken hin.

Idempotenz ist nicht nur Duplikatevermeidung — sie schafft Vertrauen. Nutzer müssen sicher sein, dass „nochmal versuchen" die Situation nicht verschlimmert.

Rohdaten und geparste Datensätze für Nachvollziehbarkeit speichern

Bewahren Sie immer auf:

- Die Rohdaten (Datei, API‑Antwort‑Snapshot oder Extract‑Metadaten)

- Die geparsten/normalisierten Datensätze, mit denen Sie den Abgleich durchführen

Das beschleunigt Debugging ("Warum wurde diese Zeile abgelehnt?"), unterstützt Audits und Genehmigungen und ermöglicht das Reproduzieren von Ergebnissen, wenn Matching‑Regeln geändert werden.

Importzusammenfassungen, mit denen Nutzer arbeiten können

Nach jedem Import zeigen Sie eine klare Zusammenfassung:

- Gesamte Zeilen empfangen

- Akzeptierte Zeilen

- Abgelehnte Zeilen

- Top‑Ablehnungsgründe (mit Anzahl)

Ermöglichen Sie Nutzern, eine Datei „abgelehnte Zeilen“ herunterzuladen, die die Originalzeile plus eine Fehler‑Spalte enthält. Das macht Ihren Importer zu einem Self‑Service‑Datenqualitäts‑Tool und reduziert Support‑Anfragen erheblich.

Matching‑Regeln erstellen, denen Menschen vertrauen

Matching ist das Herz des systemübergreifenden Abgleichs: es bestimmt, welche Datensätze als "dasselbe" über Quellen hinweg gelten. Ziel ist nicht nur Genauigkeit, sondern Vertrauen. Prüfer müssen verstehen, warum zwei Datensätze verknüpft wurden.

Klare Matching‑Level verwenden

Ein praktisches Modell sind drei Level:

- Exact Match (stark): Schlüssel stimmen eindeutig und ohne Ambiguität überein.

- Fuzzy Match (wahrscheinlich): wahrscheinlich korrekt, sollte aber überprüfbar sein.

- No Match (unbekannt): nichts Belastbares gefunden; als Ausnahme behandeln.

Das vereinfacht den downstream Workflow: starke Matches auto‑schließen, wahrscheinliche Matches an die Prüfung geben, und Unbekannte eskalieren.

Zuerst Schlüssel definieren, dann sinnvolle Fallbacks

Beginnen Sie mit stabilen Identifikatoren, wenn vorhanden:

- Primärschlüssel: externe ID (Rechnungs‑ID, Transaktions‑ID, Bestellnummer).

Wenn IDs fehlen oder unzuverlässig sind, verwenden Sie definierte Fallbacks in einer Reihenfolge, z. B.:

- Datum + Betrag + Referenz

- Datum + Betrag + Gegenpartei

Machen Sie diese Reihenfolge explizit, damit das System konsistent reagiert.

Toleranzen handhaben, ohne Probleme zu verbergen

Reale Daten weichen ab:

- Rundung: erlauben Sie kleine Betragsdiffenzen (z. B. ±0,01 oder währungsspezifische Regeln).

- Zeitzonen: vergleichen Sie in einer kanonischen Zeitzone oder erlauben Sie ein definiertes Fenster (z. B. ±24 h für Zeitstempel).

- Partielle Lieferungen/Zahlungen: unterstützen Sie One‑to‑Many und Many‑to‑One Matches, wenn Summen übereinstimmen.

Regeln konfigurierbar, aber kontrolliert halten

Platzieren Sie Regeln hinter einer Admin‑Konfiguration (oder einer geführten UI) mit Guardrails: versionieren Sie Regeln, validieren Sie Änderungen und wenden Sie sie konsistent an (z. B. pro Periode). Vermeiden Sie Bearbeitungen, die historische Ergebnisse stillschweigend ändern.

Matches erklärbar machen

Pro Match protokollieren Sie:

- den Regelname/Version, die den Match erzeugt hat,

- die verglichenen Schlüssel und deren Werte,

- die angewandten Toleranzen (falls vorhanden),

- eine Match‑Score/Level.

Wenn jemand fragt „Warum wurde das zugeordnet?", soll die App auf einer Seite antworten können.

Workflow und Statusmodelle für den Abgleich aufbauen

Mit Snapshots und Rollback bereitstellen

Stellen und hosten Sie Ihre Abgleichs-App, und iterieren Sie anschließend mit Snapshots und Rollback.

Eine Abgleichs‑App funktioniert am besten, wenn sie Arbeit als Serie von Sessions (Runs) behandelt. Eine Session ist ein Container für „diesen Abgleichsversuch“, oft definiert durch einen Datumsbereich, eine Monatsperiode oder eine bestimmte Konto/Entität. Das macht Ergebnisse reproduzierbar und leicht vergleichbar („Was hat sich seit dem letzten Lauf geändert?“).

Ein einfaches, vertrauenswürdiges Statusmodell

Verwenden Sie eine kleine Menge an Status, die den tatsächlichen Arbeitsablauf widerspiegeln:

Imported → Matched → Needs review → Resolved → Approved

- Imported: Daten sind angekommen und haben die Basisvalidierung bestanden.

- Matched: das System hat einen sicheren Match gefunden (regelbasiert oder hoher Score).

- Needs review: zweifelhafte Matches, fehlende Datensätze oder Regelkonflikte.

- Resolved: ein Mensch hat eine Aktion vorgenommen, um die Differenz zu erklären.

- Approved: ein Reviewer bestätigt die Session (oder einen Teil, z. B. ein Konto).

Halten Sie Status an spezifische Objekte gebunden (Transaktion, Match‑Gruppe, Ausnahme) und rollen Sie sie auf Session‑Ebene hoch, damit Teams sehen können, „wie weit wir sind".

Manuelle Aktionen, die Prüfung praktikabel machen

Prüfer brauchen einige wenige, wirkungsvolle Aktionen:

- Match bestätigen, wenn der Vorschlag korrekt ist.

- Split/Merge, wenn ein Datensatz auf viele passt oder viele auf einen.

- Anpassung erstellen, um Gebühren, Timing‑Differenzen oder Korrekturen zu dokumentieren.

- Notiz hinzufügen, um das Warum zu erfassen, nicht nur das Was.

Stille Änderungen verhindern

Änderungen dürfen nie verschwinden. Protokollieren Sie, was sich geändert hat, wer es geändert hat und wann. Für Schlüsselaktionen (Match überschreiben, Anpassung erstellen, Betrag ändern) fordern Sie einen Grundcode und freien Textkontext.

Auf Zusammenarbeit auslegen

Abgleich ist Teamarbeit. Fügen Sie Zuweisungen (wer diese Ausnahme besitzt) und Kommentare für Handoffs hinzu, damit die nächste Person ohne erneute Untersuchung weitermachen kann.

Dashboard und Review‑Erlebnis gestalten

Eine Abgleichs‑App lebt oder stirbt danach, wie schnell Menschen sehen können, was Aufmerksamkeit braucht und wie sicher sie es lösen können. Das Dashboard sollte drei Fragen auf einen Blick beantworten: Was ist übrig? Was ist die Auswirkung? Was wird alt?

Mit einer „Status‑zuerst“ Übersicht beginnen

Platzieren Sie die handlungsrelevanten Metriken oben:

- Anzahl nach Status (Nicht zugeordnet, Vorschlag, Zur Prüfung, Gelöst, Ignoriert)

- Gesamtwert nicht zugeordneter Posten (und optional „risikobehafteter" Wert basierend auf Aging)

- Aging‑Buckets (z. B. 0–2 Tage, 3–7, 8–30, 30+), damit nichts stillschweigend blockiert

Bezeichnen Sie Metriken in Geschäftstermini, die Nutzer kennen (z. B. „Bank‑Seite" und „ERP‑Seite", nicht „Quelle A/B") und machen Sie jede Metrik klickbar, um die gefilterte Aufgabenliste zu öffnen.

Suche und Filter sollten sofort wirken

Prüfer sollten Work in Sekunden einschränken können mit schnellen Suche und Filtern wie:

- System/Quelle, Datumsbereich, Betragsspanne

- Status, Besitzer/Zuständiger, Ausnahmetyp

- High‑Value‑Schalter (z. B. „Top 50 nach Betrag anzeigen")

Als Standardansicht empfehlen sich „Meine offenen Posten“ zuerst, dann gespeicherte Sichten wie „Month‑end: Nicht zugeordnet > $1.000".

Datensatz‑Drilldown: Gegenüberstellung nebeneinander

Wenn jemand einen Eintrag anklickt, zeigen Sie beide Seiten der Daten nebeneinander mit hervorgehobenen Unterschieden. Fügen Sie die Matching‑Beweise in verständlicher Sprache hinzu:

- Wichtige Felder (Datum, Betrag, Referenz, Kunde/Lieferant)

- Angewandte Toleranzen (z. B. „Betrag innerhalb von $0.02")

- Verknüpfte Historie (vorherige Aktionen, Kommentare, Anhänge)

Massenaktionen für gängige Ergebnisse

Die meisten Teams lösen Probleme in Batches. Bieten Sie Bulk‑Aktionen wie Genehmigen, Zuweisen, Als Info anfordern und Liste exportieren an. Bestätigungsdialoge sollten explizit sein („Sie genehmigen 37 Posten mit insgesamt $84.210").

Ein gut gestaltetes Dashboard macht aus dem Abgleich einen planbaren täglichen Prozess und kein Suchspiel.

Rollen, Genehmigungen und Prüfpfad hinzufügen

Eine Abgleichs‑App ist nur so vertrauenswürdig wie ihre Kontrollen. Klare Rollen, leichte Genehmigungen und ein durchsuchbarer Prüfpfad verwandeln „wir denken, das stimmt" in „wir können das beweisen".

Rollen einfach (aber explizit) halten

Starten Sie mit vier Rollen und erweitern Sie nur bei Bedarf:

- Viewer: Nur Lesezugriff auf Dashboards, Berichte und Datensatzdetails.

- Reconciler: Kann Datensätze matchen/unmatchen, Notizen hinzufügen und Anpassungen vorschlagen.

- Approver: Kann hochwirksame Aktionen genehmigen oder ablehnen und Perioden schließen.

- Admin: Verwalten von Nutzern, Datenquellen, Konfiguration und Berechtigungsgrenzen.

Machen Sie Rollenfähigkeiten in der UI sichtbar (z. B. deaktivierte Buttons mit kurzem Tooltip). Das reduziert Verwirrung und verhindert unbeabsichtigtes "Shadow‑Admin"‑Verhalten.

Genehmigungs‑Gates für wirkungsvolle Aktionen

Nicht jeder Klick braucht eine Genehmigung. Konzentrieren Sie sich auf Aktionen, die finanzielle Auswirkungen haben oder Ergebnisse finalisieren:

- Erstellen von Anpassungen (z. B. Gebührenkorrekturen)

- Erfassen von Ausbuchungen oder manuellen Ausnahmen

- Markieren eines Abgleichs als final/geschlossen für eine Periode

Ein praktikables Muster ist ein Zweischritt‑Flow: Reconciler reicht ein → Approver prüft → System wendet an. Bewahren Sie den Vorschlag getrennt vom final angewendeten Change auf, um zeigen zu können, was angefragt und was ausgeführt wurde.

Einen vollständigen, nutzbaren Prüfpfad bauen

Protokollieren Sie Ereignisse als unveränderliche Einträge: wer hat gehandelt, wann, welches Entity/Record betroffen war und was sich geändert hat (vorher/nachher, wo relevant). Erfassen Sie Kontext: Dateiname der Quelle, Import‑Batch‑ID, Matching‑Regel‑Version und den Grund/Kommentar.

Bieten Sie Filter (Datum, Nutzer, Status, Batch) und Deep‑Links von Audit‑Einträgen zurück zum betroffenen Objekt.

Exportierbare Nachweise planen

Audits und Monatsabschluss benötigen oft Offline‑Belege. Unterstützen Sie das Exportieren gefilterter Listen und eines „Abgleichspakets“, das Zusammenfassungen, Ausnahmen, Genehmigungen und den Prüfpfad enthält (CSV und/oder PDF). Halten Sie Exporte konsistent mit dem, was Nutzer auf der /reports Seite sehen, um abweichende Zahlen zu vermeiden.

Umgang mit Ausnahmen, Fehlern und Benachrichtigungen

Backend schnell erstellen

Stellen Sie schnell Go-APIs und Postgres-Tabellen für Sessions, Matches und Exceptions bereit.

Abgleichs‑Apps leben oder sterben daran, wie sie reagieren, wenn etwas schiefläuft. Können Nutzer nicht schnell verstehen, was fehlgeschlagen ist und wie sie es beheben, greifen sie zu Tabellenkalkulationen.

Fehlermeldungen handlungsfähig machen

Für jede fehlgeschlagene Zeile oder Transaktion zeigen Sie eine klar verständliche "Warum‑Fehler"‑Meldung, die auf eine Lösung hinweist. Gute Beispiele:

- Fehlendes Pflichtfeld (z. B. Rechnungsnummer)

- Ungültige Währung/Format (z. B. „USD" mit nachgestelltem Leerzeichen)

- Duplikate (gleiche externe ID erscheint zweimal im selben Import)

Halten Sie die Meldung in der UI sichtbar (und exportierbar), nicht in Serverlogs versteckt.

Datenfehler von Systemfehlern trennen

Behandeln Sie "schlechte Eingabe" anders als "Systemproblem". Datenfehler sollten unter Quarantäne gestellt werden mit Hinweisen (welches Feld, welche Regel, welcher Erwartungswert). Systemfehler — API‑Timeouts, Auth‑Fehler, Netzwerkausfälle — sollten automatische Retries und Alerting auslösen.

Ein nützliches Muster ist die Unterscheidung von:

- Run‑Status (Succeeded / Succeeded with issues / Failed)

- Item‑Status (Matched / Unmatched / Needs review / Blocked by error)

Retry und Quarantäne

Für transiente Fehler implementieren Sie eine begrenzte Retry‑Strategie (z. B. Exponential Backoff, max. Versuche). Für defekte Datensätze schicken Sie sie in eine Quarantäne‑Warteschlange, in der Nutzer korrigieren und erneut verarbeiten können.

Halten Sie die Verarbeitung idempotent: Mehrfachausführen derselben Datei oder API‑Abfrage darf keine Duplikate erzeugen oder Beträge doppelt zählen. Speichern Sie Quellidentifikatoren und nutzen Sie deterministische Upsert‑Logik.

Benachrichtigungen ohne Oversharing

Benachrichtigen Sie Nutzer, wenn Läufe abgeschlossen sind und wenn Items Aging‑Schwellen überschreiten (z. B. "seit 7 Tagen nicht zugeordnet"). Halten Sie Benachrichtigungen leichtgewichtig und verlinken Sie zurück zur relevanten Ansicht (z. B. /runs/123).

Vermeiden Sie das Offenlegen sensibler Daten in Logs und Fehlermeldungen — zeigen Sie maskierte Identifikatoren und speichern Sie detaillierte Payloads nur in eingeschränkten Admin‑Tools.

Reporting, Exporte und Unterstützung beim Monatsabschluss

Abgleichsarbeit zählt erst, wenn sie geteilt werden kann: mit Finance für den Abschluss, mit Ops für Korrekturen und später mit Prüfern. Planen Sie Reporting und Exporte als erstklassige Features, nicht als Nachgedanken.

Operative Reports, die Teams tatsächlich verwenden

Operative Reports sollten helfen, offene Posten schnell zu reduzieren. Eine gute Basis ist ein Unresolved Items‑Report, filterbar und gruppierbar nach:

- Alter (z. B. 0–7, 8–30, 31–60, 60+ Tage)

- Wert / Auswirkung (Betrag, Menge oder Risikoscore)

- Besitzer (wer als Nächstes handeln muss)

- Kategorie (fehlender Datensatz, Duplikat, Betrag stimmt nicht, ungültige Referenz, Timing‑Differenz)

Machen Sie den Report drillable: Ein Klick auf eine Zahl führt Prüfer direkt zu den zugrunde liegenden Ausnahmen in der App.

Outputs für den Monatsabschluss

Der Abschluss braucht konsistente, reproduzierbare Outputs. Stellen Sie ein Period Close Package bereit, das enthält:

- Endgültige abgeglichene Summen pro System (und die "vereinbarte" Summe)

- Gepostete Anpassungen (manuelle Aktionen, Ausbuchungen, Umschichtungen)

- Eine Abweichungsübersicht: Startabweichung → während der Periode gelöst → verbleibende Abweichung

Hilfreich ist ein "Close Snapshot", damit Zahlen nach dem Export nicht mehr verändert werden, falls jemand weiterarbeitet.

Exporte für nachgelagerte Systeme

Exporte sollten langweilig und vorhersehbar sein. Verwenden Sie stabile, dokumentierte Spaltennamen und vermeiden Sie UI‑only Felder.

Überlegen Sie Standardexporte wie Matched, Unmatched, Adjustments und Audit Log Summary. Wenn Sie mehrere Konsumenten (Buchhaltungssysteme, BI‑Tools) unterstützen, behalten Sie ein einziges kanonisches Schema und versionieren Sie es (z. B. export_version). Dokumentieren Sie Formate auf einer Seite wie /help/exports.

Ein einfacher Gesundheits‑Überblick für den Abgleich

Fügen Sie eine leichte "Health"‑Ansicht hinzu, die wiederkehrende Quellenprobleme hervorhebt: Top‑Validierungsfehler, häufigste Ausnahme‑Kategorien und Quellen mit steigenden Nichtzuordnungsraten. Das verwandelt Abgleich von "Zeilen reparieren" in "Ursachen beheben".

Sicherheits-, Datenschutz‑ und Performance‑Basics

Abschlussbereite Exporte erstellen

Erstellen Sie vorhersagbare CSV-Exporte für gematchte, ungematchte, Anpassungen und Prüfungszusammenfassungen.

Sicherheit und Performance können in einer Abgleichs‑App nicht einfach "später ergänzt" werden, da Sie sensible finanzielle oder operative Daten verarbeiten und wiederholbare, hochvolumige Jobs laufen.

Authentifizierung, Zugriffskontrolle und Sessions

Starten Sie mit klarer Authentifizierung (SSO/SAML oder OAuth, wo möglich) und implementieren Sie Least‑Privilege‑Zugriff. Die meisten Nutzer sollten nur die Business Units, Konten oder Quellen sehen, für die sie verantwortlich sind.

Verwenden Sie sichere Sessions: kurzlebige Tokens, Rotation/Refresh wo relevant und CSRF‑Schutz für Browser‑Flows. Für Admin‑Aktionen (Matching‑Regeln ändern, Imports löschen, Status überschreiben) fordern Sie stärkere Prüfungen wie Re‑Authentifizierung oder Step‑Up‑MFA.

Sensible Daten schützen

Verschlüsseln Sie Daten überall in Transit (TLS für Web‑App, APIs, Dateiübertragungen). Für Verschlüsselung at‑rest priorisieren Sie die riskantesten Daten: Roh‑Uploads, exportierte Berichte und gespeicherte Identifikatoren (z. B. Kontonummern). Wenn vollständige DB‑Verschlüsselung nicht praktikabel ist, denken Sie über Feld‑Level‑Verschlüsselung für spezifische Spalten nach.

Legen Sie Aufbewahrungsregeln basierend auf Geschäftsanforderungen fest: wie lange Rohdateien, normalisierte Staging‑Tabellen und Logs behalten werden. Bewahren Sie das für Audits und Troubleshooting Nötige und löschen Sie den Rest nach Plan.

Performance‑Planung, die Nutzer zufriedenstellt

Abgleichsarbeit ist oft "burstig" (Monatsabschluss). Planen Sie:

- Indizes auf Schlüsseln, die für Filter und Matching genutzt werden (Daten, externe IDs, Konto, Betrag, Status)

- Paging überall — niemals tausende Zeilen auf einmal in einem Screen laden

- Hintergrundjobs für teure Arbeiten (Importe, Normalisierung, Matching, Rematching)

- Caching für Zusammenfassungs‑Counts und Dashboard‑Karten (aber Zeilen‑Daten live halten)

Schutz gegen Missbrauch und Unfälle

Fügen Sie Rate‑Limiting für APIs hinzu, um ausufernde Integrationen zu verhindern, und setzen Sie Dateigrößen‑/Zeilenlimits für Uploads durch. Kombinieren Sie das mit Validierung und idempotenter Verarbeitung, damit Retries keine Duplikate erzeugen oder Zahlen aufblähen.

Test, Deployment und laufende Wartung

Testing einer Abgleichs‑App ist nicht nur "läuft sie?" — sondern "vertrauen die Leute den Zahlen, wenn die Daten unordentlich sind?" Behandeln Sie Tests und Betrieb als Produktaufgabe, nicht als Nachgedanken.

Matching‑Logik mit Real‑World‑Edge‑Cases testen

Starten Sie mit einem kuratierten Datensatz aus der Produktion (anonymisiert) und bauen Sie Fixtures, die zeigen, wie Daten tatsächlich brechen:

- Duplikate (gleiche Rechnung doppelt gebucht, unterschiedliche IDs)

- Partials (gesplittete Zahlungen, Teillieferungen)

- Rundung und Währungsumrechnungen (1–2 Cent Unterschiede)

- Datumsdrift (Zeitzonenverschiebungen, Buchungsdatum vs. Transaktionsdatum)

- Nahe Matches (Tippfehler, abgeschnittene Referenzen)

Für jeden Fall testen Sie nicht nur das finale Match‑Ergebnis, sondern auch die Erklärung, die Prüfern angezeigt wird (warum es gematcht wurde, welche Felder zählten). Vertrauen entsteht hier.

End‑to‑end‑Tests für den gesamten Lebenszyklus

Unit‑Tests fangen Workflow‑Lücken nicht ein. Decken Sie End‑to‑End‑Flows ab:

Import → Validate → Match → Review → Approve → Export

Fügen Sie Idempotenz‑Checks hinzu: Das erneute Ausführen desselben Imports darf keine Duplikate erzeugen, und das erneute Ausführen eines Abgleichs sollte dieselben Ergebnisse liefern, sofern sich die Inputs nicht geändert haben.

Sicheres Deployment und Migrationen

Nutzen Sie Dev/Staging/Prod mit staging‑Datenvolumen, das der Produktion ähnelt. Bevorzugen Sie abwärtskompatible Migrationen (zuerst Spalten hinzufügen, backfillen, dann Leseschreibzugriff umstellen), sodass Deploys ohne Downtime möglich sind. Verwenden Sie Feature‑Flags für neue Matching‑Regeln und Exporte, um den Blast‑Radius zu begrenzen.

Monitoring und Wartung

Überwachen Sie Betriebskennzahlen, die Abschlusszeiten beeinflussen:

- Fehlgeschlagene Import/Match‑Jobs und Retry‑Counts

- Langsame Queries und Queue‑Backlogs

- Dauer von Abgleichsläufen und Zeit im Status „Warten auf Prüfung"

Planen Sie regelmäßige Reviews von False Positives/Negatives, um Regeln zu justieren, und fügen Sie bei jeder Änderung an Matching‑Verhalten Regressionstests hinzu.

Rollout‑Plan

Pilotieren Sie mit einer Datenquelle und einem Abgleichstyp (z. B. Bank vs. Ledger), holen Sie Prüferfeedback ein und erweitern Sie dann Quellen und Regelkomplexität. Falls Ihr Produkt unterschiedliche Pakete nach Volumen oder Connectoren anbietet, verlinken Sie Nutzer auf /pricing für Plan‑Details.

Schneller bauen mit Koder.ai (optional)

Wenn Sie schnell von der Spezifikation zu einem funktionierenden Abgleichsprototyp kommen möchten, kann eine Vibe‑Coding‑Plattform wie Koder.ai helfen, den Kernworkflow—Importe, Session‑Runs, Dashboards und rollenbasierten Zugriff—über einen chatgetriebenen Build‑Prozess aufzusetzen. Unter der Haube zielt Koder.ai auf gängige Produktionsstacks (React im Frontend, Go + PostgreSQL im Backend) und unterstützt Source‑Code‑Export sowie Deployment/Hosting. Das passt gut zu Abgleichs‑Apps, die klare Prüfpfade, wiederholbare Jobs und kontrollierte Regel‑Versionierung benötigen.