29. März 2025·8 Min

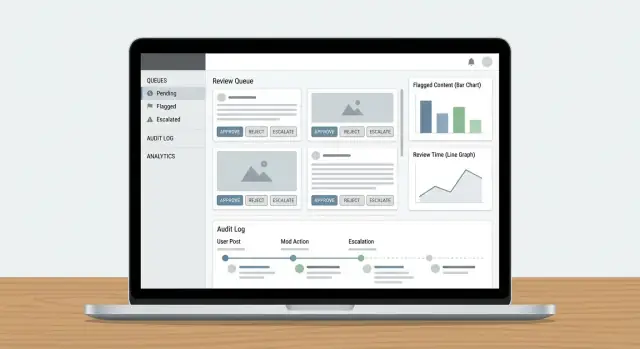

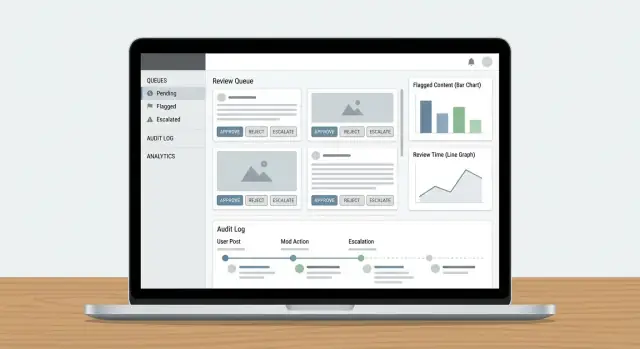

Eine Web‑App bauen, um Content‑Moderation‑Workflows auszuführen

Erfahren Sie, wie Sie eine Web‑App für Inhaltsmoderation entwerfen und bauen: Queues, Rollen, Policies, Eskalation, Audit‑Logs, Analytics und sichere Integrationen.

Erfahren Sie, wie Sie eine Web‑App für Inhaltsmoderation entwerfen und bauen: Queues, Rollen, Policies, Eskalation, Audit‑Logs, Analytics und sichere Integrationen.

Bevor Sie einen Moderations‑Workflow entwerfen, entscheiden Sie, was genau moderiert wird und wie „gut“ aussieht. Ein klarer Umfang verhindert, dass Ihre Moderations‑Queue mit Randfällen, Duplikaten und nicht relevanten Anfragen überläuft.

Schreiben Sie jede Inhaltsart auf, die Risiko oder Schaden für Nutzer schaffen kann. Häufige Beispiele sind nutzergenerierter Text (Kommentare, Posts, Bewertungen), Bilder, Videos, Livestreams, Profilfelder (Namen, Bios, Avatare), Direktnachrichten, Community‑Gruppen und Marketplace‑Listings (Titel, Beschreibungen, Fotos, Preise).

Notieren Sie auch Quellen: Nutzer‑Einreichungen, automatisierte Importe, Bearbeitungen bestehender Objekte und Meldungen durch andere Nutzer. So vermeiden Sie ein System, das nur für „neue Posts“ funktioniert und Bearbeitungen, Re‑Uploads oder DM‑Missbrauch übersieht.

Die meisten Teams balancieren vier Ziele:

Seien Sie explizit, welches Ziel in welchem Bereich vorrangig ist. Beispielsweise kann bei hoch‑severity Abuse die Geschwindigkeit vor perfekter Konsistenz priorisiert werden.

Listen Sie die vollständigen Outcomes auf, die Ihr Produkt braucht: genehmigen, ablehnen/entfernen, bearbeiten/redigieren, labeln/alterseinschränken, Sichtbarkeit einschränken, unter Prüfung stellen, an einen Lead eskalieren und Account‑Level Aktionen wie Verwarnungen, temporäre Sperren oder Bans.

Definieren Sie messbare Ziele: Median und 95‑Perzentil Review‑Zeit, Backlog‑Größe, Reversierungsrate bei Appeals, Policy‑Genauigkeit aus QA‑Stichproben und Prozentanteil hoch‑schwerer Items, die innerhalb eines SLA behandelt werden.

Beziehen Sie Moderatoren, Teamleads, Policy, Support, Engineering und Legal mit ein. Fehlende Abstimmung verursacht später Nacharbeit—insbesondere bei der Frage, was „Eskalation“ bedeutet und wer finale Entscheidungen trifft.

Bevor Sie Screens und Queues bauen, skizzieren Sie den vollständigen Lebenszyklus eines einzelnen Inhalts. Ein klarer Workflow verhindert „Mystery States“, die Reviewer verwirren, Benachrichtigungen unterbrechen und Audits erschweren.

Starten Sie mit einem einfachen, durchgehenden Zustandsmodell, das Sie in ein Diagramm und in Ihre Datenbank überführen können:

Submitted → Queued → In review → Decided → Notified → Archived

Halten Sie Zustände gegenseitig ausschließend und definieren Sie, welche Übergänge erlaubt sind (und von wem). Zum Beispiel: „Queued“ darf nur in „In review“ wechseln, wenn es zugewiesen wurde, und „Decided“ sollte unveränderlich sein, außer durch einen Appeal‑Flow.

Automatisierte Klassifizierer, Keyword‑Matches, Ratenbegrenzungen und Nutzer‑Meldungen sollten als Signale und nicht als Entscheidungen behandelt werden. Ein "human‑in‑the‑loop"‑Design hält das System ehrlich:

Diese Trennung erleichtert auch das spätere Verbessern von Modellen, ohne Policy‑Logik umzuschreiben.

Entscheidungen werden angefochten. Fügen Sie Erstklass‑Flows hinzu für:

Modellieren Sie Appeals als neue Review‑Events statt als Edit der Historie. So können Sie die vollständige Abfolge der Ereignisse erzählen.

Für Audits und Streitfälle definieren Sie, welche Schritte mit Zeitstempeln und Akteuren aufgezeichnet werden müssen:

Wenn Sie eine Entscheidung später nicht erklären können, sollten Sie annehmen, dass sie nicht stattgefunden hat.

Ein Moderationstool steht und fällt mit Zugriffskontrolle. Wenn jeder alles darf, bekommen Sie inkonsistente Entscheidungen, versehentliche Datenfreigaben und keine klare Verantwortlichkeit. Definieren Sie Rollen, die zur Arbeitsweise Ihres Trust‑&‑Safety‑Teams passen, und übersetzen Sie diese dann in Berechtigungen, die Ihre App durchsetzen kann.

Die meisten Teams benötigen eine kleine Menge klarer Rollen:

Diese Trennung verhindert „versehentliche Policy‑Änderungen“ und hält Policy‑Governance von der täglichen Durchsetzung getrennt.

Implementieren Sie rollenbasierte Zugriffskontrolle, sodass jede Rolle nur das bekommt, was sie braucht:

can_apply_outcome, can_override, can_export_data) statt nach Seite.Wenn Sie später neue Features (Export, Automatisierungen, Dritt‑Integrationen) hinzufügen, können Sie diese an Berechtigungen anhängen, ohne Ihre gesamte Organisationsstruktur neu zu definieren.

Planen Sie früh für mehrere Teams: Sprach‑Pods, regionsbasierte Gruppen oder getrennte Linien für verschiedene Produkte. Modellieren Sie Teams explizit und scopen Sie Queues, Content‑Sichtbarkeit und Zuweisungen nach Team. Das verhindert Cross‑Region Reviews und hält Workloads pro Gruppe messbar.

Admins müssen gelegentlich Nutzer impersonifizieren, um Zugriffsprobleme zu debuggen oder einen Reviewer‑Fehler zu reproduzieren. Behandeln Sie Impersonation als sensible Aktion:

Für irreversible oder hochriskante Aktionen fügen Sie eine Admin‑Genehmigung (oder Zweipersonen‑Review) hinzu. Diese kleine Reibung schützt vor Fehlern und Insider‑Missbrauch, hält aber die Routine‑Moderation schnell.

Queues machen Moderationsarbeit handhabbar. Anstatt einer einzigen endlosen Liste teilen Sie Arbeit in Queues auf, die Risiko, Dringlichkeit und Intent widerspiegeln—und machen es schwer, dass Items durchs Raster fallen.

Beginnen Sie mit einer kleinen Menge Queues, die zur Arbeitsweise Ihres Teams passen:

Halten Sie Queues wenn möglich gegenseitig ausschließend (ein Item sollte ein „Zuhause“ haben) und nutzen Sie Tags für sekundäre Attribute.

Innerhalb jeder Queue definieren Sie Scoring‑Regeln, die bestimmen, was oben landet:

Machen Sie Prioritäten im UI erklärbar („Warum sehe ich das?“), damit Reviewer die Reihenfolge vertrauen.

Verwenden Sie Claiming/Locking: wenn ein Reviewer ein Item öffnet, wird es ihm zugewiesen und anderen verborgen. Fügen Sie ein Timeout hinzu (z. B. 10–20 Minuten), damit verlassene Items in die Queue zurückkehren. Protokollieren Sie immer Claim‑, Release‑ und Completion‑Events.

Wenn das System Geschwindigkeit belohnt, wählen Reviewer vielleicht schnelle Fälle und überspringen schwierige. Gegenmaßnahmen:

Ziel ist konsistente Abdeckung, nicht nur hohe Durchsatzraten.

Eine Policy, die nur als PDF existiert, wird von jedem Reviewer anders interpretiert. Um Entscheidungen konsistent (und auditierbar) zu machen, übersetzen Sie Policy‑Text in strukturierte Daten und UI‑Auswahlen, die Ihr Workflow erzwingt.

Zerlegen Sie Policy in ein gemeinsames Vokabular, das Reviewer auswählen können. Eine nützliche Taxonomie enthält üblicherweise:

Diese Taxonomie bildet die Grundlage für Queues, Eskalation und Analytics.

Anstatt Reviewer jedes Mal eine Entscheidung frei formulieren zu lassen, bieten Sie Decision‑Templates an, die an Taxonomie‑Items gebunden sind. Ein Template kann vorausfüllen:

Templates machen den „Happy Path“ schnell, erlauben aber Ausnahmen.

Policies ändern sich. Speichern Sie Policies als versionierte Datensätze mit effective dates und protokollieren Sie, welche Version bei jeder Entscheidung angewandt wurde. Das verhindert Verwirrung, wenn ältere Fälle angefochten werden, und ermöglicht es, Ergebnisse Monate später zu erklären.

Freitext ist schwer zu analysieren und leicht zu vernachlässigen. Fordern Sie Reviewer auf, ein oder mehrere strukturierte Gründe (aus Ihrer Taxonomie) auszuwählen und optional Notizen hinzuzufügen. Strukturierte Gründe verbessern Appeals‑Handling, QA‑Sampling und Trend‑Reporting—ohne Reviewer zu langen Texten zu zwingen.

Ein Reviewer‑Dashboard ist dann erfolgreich, wenn es das „Suchen“ nach Informationen minimiert und selbstsichere, wiederholbare Entscheidungen maximiert. Reviewer sollten verstehen, was passiert ist, warum es wichtig ist und was als Nächstes zu tun ist—ohne fünf Tabs öffnen zu müssen.

Zeigen Sie nicht nur einen isolierten Post und erwarten Sie konsistente Ergebnisse. Präsentieren Sie ein kompaktes Kontext‑Panel, das häufige Fragen auf einen Blick beantwortet:

Halten Sie die Standardansicht knapp, mit Ausklappoptionen für tiefere Einsichten. Reviewer sollten selten das Dashboard verlassen müssen, um zu entscheiden.

Ihre Action‑Bar sollte Policy‑Outcomes abbilden, nicht generische CRUD‑Buttons. Häufige Muster:

Machen Sie Aktionen sichtbar und irreversible Schritte explizit (Bestätigung nur wenn nötig). Erfassen Sie einen kurzen Reason‑Code plus optionale Notizen für spätere Audits.

Hohe Volumina erfordern niedrige Reibung. Fügen Sie Tastenkürzel für Top‑Aktionen hinzu (approve, reject, next item, add label). Zeigen Sie ein Shortcut‑Cheat‑Sheet im UI an.

Für repetitive Queues (z. B. offensichtlicher Spam) unterstützen Sie Bulk‑Selection mit Schutzmechanismen: Vorschau des Counts, verpflichtender Reason‑Code und Protokollierung der Batch‑Aktion.

Moderation kann dazu führen, dass Menschen schädliches Material sehen. Fügen Sie Sicherheitsdefaults hinzu:

Diese Maßnahmen schützen Reviewer und erhalten gleichzeitig Genauigkeit und Konsistenz der Entscheidungen.

Audit‑Logs sind Ihre „Quelle der Wahrheit“, wenn jemand fragt: Warum wurde dieser Post entfernt? Wer hat den Appeal genehmigt? Hat das Modell oder ein Mensch entschieden? Ohne Nachvollziehbarkeit werden Untersuchungen zur Ratesache, und das Vertrauen der Reviewer leidet.

Für jede Moderationsaktion loggen Sie wer sie ausführte, was sich änderte, wann es geschah und warum (Policy‑Grund + Freitextnotizen). Ebenso wichtig: speichern Sie Before/After‑Snapshots der relevanten Objekte—Inhaltstext, Media‑Hashes, erkannte Signale, Labels und das finale Ergebnis. Wenn das Item sich ändern kann (Bearbeitungen, Löschungen), verhindern Snapshots, dass „der Datensatz“ driftet.

Ein praktikables Muster ist ein append‑only Event‑Record:

{

"event": "DECISION_APPLIED",

"actor_id": "u_4821",

"subject_id": "post_99102",

"queue": "hate_speech",

"decision": "remove",

"policy_code": "HS.2",

"reason": "slur used as insult",

"before": {"status": "pending"},

"after": {"status": "removed"},

"created_at": "2025-12-26T10:14:22Z"

}

(Den JSON‑Block nicht verändern; er bleibt als Beispiel unverändert.)

Neben Entscheidungen loggen Sie die Workflow‑Mechanik: claimed, released, timed out, reassigned, escalated und auto‑routed. Diese Events erklären „warum es 6 Stunden dauerte“ oder „warum dieses Item zwischen Teams gesprungen ist“ und sind essenziell, um Missbrauch zu erkennen (z. B. Reviewer, die nur einfache Fälle wählen).

Geben Sie Ermittlern Filter nach Nutzer, Content‑ID, Policy‑Code, Zeitraum, Queue und Aktionstyp. Bieten Sie Export in eine Case‑Datei mit unveränderlichen Zeitstempeln und Verweisen auf verwandte Items (Duplikate, Re‑Uploads, Appeals).

Setzen Sie klare Retention‑Windows für Audit‑Events, Snapshots und Reviewer‑Notizen. Dokumentieren Sie die Policy (z. B. 90 Tage für Routine‑Queue‑Logs, länger bei Legal‑Holds) und wie Redaction‑ oder Löschanfragen gespeicherte Beweise beeinflussen.

Ein Moderationstool ist nur nützlich, wenn es den Kreis schließt: Reports werden zu Review‑Tasks, Entscheidungen erreichen die richtigen Empfänger und nutzerbezogene Aktionen werden konsistent ausgeführt. An dieser Stelle scheitern viele Systeme—jemand räumt die Queue auf, aber sonst ändert sich nichts.

Behandeln Sie Nutzer‑Reports, automatische Flags (Spam/CSAM/Hash‑Matches/Toxicity‑Signale) und interne Eskalationen (Support, Community‑Manager, Legal) als dasselbe Kernobjekt: einen Report, der ein oder mehrere Review‑Tasks erzeugen kann.

Nutzen Sie einen einzigen Report‑Router, der:

Wenn Support‑Eskalationen Teil des Flusses sind, verlinken Sie diese direkt (z. B. /support/tickets/1234), damit Reviewer nicht kontextwechseln müssen.

Moderationsentscheidungen sollten template‑basierte Benachrichtigungen erzeugen: Inhalt entfernt, Verwarnung ausgesprochen, keine Aktion oder Account‑Maßnahme. Halten Sie Messaging konsistent und minimal—erklären Sie das Ergebnis, verweisen Sie auf die relevante Policy und geben Sie Appeal‑Anweisungen.

Operativ senden Sie Benachrichtigungen über ein Event wie moderation.decision.finalized, damit Email/In‑App/Push abonnieren können, ohne den Reviewer zu verlangsamen.

Entscheidungen erfordern oft Maßnahmen jenseits eines einzelnen Inhalts:

Machen Sie diese Aktionen explizit und reversibel, mit klaren Dauern und Gründen. Verlinken Sie jede Aktion zurück zur Entscheidung und zum zugrunde liegenden Report für Nachvollziehbarkeit und bieten Sie einen schnellen Weg zu Appeals, damit Entscheidungen ohne manuelle Aufklärung erneut geprüft werden können.

Ihr Datenmodell ist die „Quelle der Wahrheit“ dafür, was mit jedem Item passiert ist: was geprüft wurde, von wem, unter welcher Policy und mit welchem Ergebnis. Wenn Sie diese Schicht richtig gestalten, werden Queues, Dashboards, Audits und Analytics einfacher.

Vermeiden Sie, alles in einem Datensatz zu speichern. Ein praktisches Muster ist:

HARASSMENT.H1 oder NUDITY.N3, als Referenzen gespeichert, sodass Policies sich entwickeln können, ohne die Historie umzuschreiben.Das hält Policy‑Durchsetzung konsistent und macht Reporting klarer (z. B. „Top verletzte Policy‑Codes diese Woche").

Speichern Sie große Bilder/Videos nicht direkt in der Datenbank. Verwenden Sie Object‑Storage und speichern Sie nur Object‑Keys + Metadaten in der Content‑Tabelle.

Für Reviewer generieren Sie kurzlebige signed URLs, sodass Medien zugänglich sind, ohne öffentlich gemacht zu werden. Signed URLs erlauben außerdem Ablauf und Widerruf des Zugriffs.

Queues und Untersuchungen benötigen schnelle Lookups. Fügen Sie Indizes hinzu für:

Modellieren Sie Moderation als explizite Zustände (z. B. NEW → TRIAGED → IN_REVIEW → DECIDED → APPEALED). Speichern Sie State‑Transition‑Events (mit Zeitstempeln und Actor), damit Sie Items erkennen, die nicht vorankommen.

Eine einfache Absicherung: ein Feld last_state_change_at plus Alerts für Items, die ein SLA überschreiten, und ein Repair‑Job, der Items zurück in die Queue legt, die zu lange in IN_REVIEW hängen.

Trust & Safety‑Tools verarbeiten oft die sensibelsten Daten Ihres Produkts: nutzergenerierte Inhalte, Reports, Account‑IDs und manchmal rechtliche Anfragen. Behandeln Sie die Moderations‑App als hochriskantes System und designen Sie Sicherheit und Datenschutz von Anfang an mit ein.

Beginnen Sie mit starker Authentifizierung und engen Session‑Kontrollen. Für die meisten Teams bedeutet das:

Kombinieren Sie das mit rollenbasierter Zugriffskontrolle, sodass Reviewer nur sehen, was sie brauchen (z. B. eine Queue, eine Region oder ein Content‑Type).

Verschlüsseln Sie Daten in Transit (HTTPS überall) und at Rest (verwaltete DB/Storage‑Verschlüsselung). Konzentrieren Sie sich dann auf Exposure‑Minimierung:

Wenn Sie mit Einwilligungen oder speziellen Datenkategorien arbeiten, machen Sie diese Flags für Reviewer sichtbar und erzwingen Sie sie im UI (z. B. eingeschränkte Anzeige oder besondere Aufbewahrungsregeln).

Reporting‑ und Appeal‑Endpoints sind häufige Ziele für Spam und Missbrauch. Fügen Sie hinzu:

Machen Sie außerdem jede sensible Aktion nachvollziehbar mit einem Audit‑Trail (siehe /blog/audit-logs), damit Sie Reviewer‑Fehler, kompromittierte Accounts oder koordinierte Angriffe untersuchen können.

Ein Moderations‑Workflow wird nur besser, wenn Sie ihn messen können. Analytics sollten zeigen, ob Ihr Queue‑Design, Ihre Eskalationsregeln und Policy‑Durchsetzung konsistente Entscheidungen liefern—ohne Reviewer auszubrennen oder schädliche Inhalte lange stehen zu lassen.

Starten Sie mit einer kleinen Menge Metriken, die an Outcomes gebunden sind:

Stellen Sie diese in ein SLA‑Dashboard, damit Ops‑Leads sehen, welche Queues hinterherhinken und ob der Flaschenhals Personal, unklare Regeln oder ein Anstieg an Reports ist.

Uneinigkeit ist nicht immer schlecht—sie kann auf Randfälle hinweisen. Tracken Sie:

Nutzen Sie Ihr Audit‑Log, um jede Stichproben‑Entscheidung mit Reviewer, angewandter Regel und Beweis zu verknüpfen. Das schafft Erklärbarkeit für Coaching und bei der Bewertung, ob Ihr Dashboard‑UI zu inkonsistenten Ergebnissen führt.

Analytics sollten helfen, die Frage zu beantworten: „Womit haben wir zu tun, das unsere Policy nicht gut abdeckt?“ Achten Sie auf Cluster wie:

Übersetzen Sie diese Signale in konkrete Maßnahmen: Policy‑Texte überarbeiten, Entscheidungsbäume im Reviewer‑Dashboard hinzufügen oder Enforcement‑Presets anpassen (z. B. Standard‑Timeouts vs. Verwarnungen).

Behandeln Sie Analytics als Teil eines Human‑in‑the‑Loop‑Systems. Teilen Sie Queue‑Level‑Performance intern, aber gehen Sie mit individuellen Metriken vorsichtig um, um nicht Geschwindigkeit über Qualität zu incentivieren. Kombinieren Sie quantitative KPIs mit regelmäßigen Kalibrierungs‑Sessions und kleinen, häufigen Policy‑Updates—so verbessern sich Tooling und Team gemeinsam.

Ein Moderationstool scheitert meist an den Rändern: seltsame Posts, seltene Eskalationspfade und Momente, in denen mehrere Personen denselben Fall berühren. Behandeln Sie Test und Rollout als Produktarbeit, nicht als finale Checkliste.

Erstellen Sie ein kleines „Scenario‑Pack“, das echte Arbeit abbildet. Enthalten sein sollten:

Nutzen Sie produktsimilar Datenvolumen in Staging, um Queue‑Slowdowns und Pagination/Search‑Probleme früh zu erkennen.

Ein sicherer Rollout‑Pfad:

Shadow‑Mode ist besonders nützlich, um Policy‑Rules und Automatisierung zu validieren, ohne False‑Positives zu riskieren.

Schreiben Sie kurze, aufgabenorientierte Playbooks: „Wie einen Report verarbeiten“, „Wann eskalieren“, „Wie Appeals handhaben“ und „Was tun, wenn das System unsicher ist“. Trainieren Sie dann mit dem gleichen Scenario‑Pack, damit Reviewer die Flows üben, die sie später nutzen.

Planen Sie Wartung als kontinuierliche Aufgabe: neue Content‑Typen, geänderte Eskalationsregeln, periodisches QA‑Sampling und Kapazitätsplanung bei Queue‑Spitzen. Halten Sie einen klaren Release‑Prozess für Policy‑Änderungen, damit Reviewer sehen, was sich wann geändert hat—und Sie Änderungen mit Moderations‑Analytics korrelieren können.

Wenn Sie das als Web‑Applikation umsetzen, besteht ein großer Teil der Arbeit aus repetitiver Infrastruktur: RBAC, Queues, Zustandsübergänge, Audit‑Logs, Dashboards und das ereignisgesteuerte Kleben zwischen Entscheidungen und Benachrichtigungen. Koder.ai kann diesen Build beschleunigen, indem Sie den Moderations‑Workflow in einer Chat‑Schnittstelle beschreiben und eine funktionierende Grundlage erzeugen—gewöhnlich mit einem React‑Frontend und einem Go + PostgreSQL‑Backend.

Zwei praktische Einsatzweisen für Trust & Safety‑Tooling:

Sobald die Basis steht, können Sie den Quellcode exportieren, vorhandene Modell‑Signale als „Inputs“ anschließen und die Entscheidung des Reviewers als finale Autorität belassen—entsprechend der oben beschriebenen Human‑in‑the‑Loop‑Architektur.

Beginnen Sie damit, jede Inhaltsart aufzulisten, die Sie behandeln wollen (Posts, Kommentare, DMs, Profile, Listings, Medien) sowie jede Quelle (neue Einreichungen, Bearbeitungen, Importe, Nutzer‑Reports, automatisierte Flags). Definieren Sie dann, was außerhalb des Umfangs liegt (z. B. interne Admin-Notizen, systemgenerierte Inhalte), damit Ihre Queue nicht zum Auffangbecken wird.

Eine praktische Prüfung: Wenn Sie nicht den Inhaltstyp, die Quelle und das verantwortliche Team benennen können, sollte daraus wahrscheinlich noch keine Moderationsaufgabe entstehen.

Wählen Sie eine kleine Menge operativer KPIs, die sowohl Geschwindigkeit als auch Qualität widerspiegeln:

Setzen Sie Ziele pro Queue (z. B. High‑Risk vs. Backlog), damit Sie nicht unbeabsichtigt niedrige Prioritäten optimieren, während schädliche Inhalte warten.

Nutzen Sie ein einfaches, explizites Zustandsmodell und erzwingen Sie erlaubte Übergänge, zum Beispiel:

SUBMITTED → QUEUED → IN_REVIEW → DECIDED → NOTIFIED → ARCHIVEDMachen Sie Zustände mutually exclusive, und behandeln Sie „Decided“ als unveränderlich außer über einen Appeal/Re‑Review‑Flow. Das verhindert „Mystery States“, fehlerhafte Benachrichtigungen und schwer zu prüfende Änderungen.

Behandeln Sie automatisierte Systeme als Signale, nicht als finale Entscheidungen:

So bleibt die Policy‑Durchführung erklärbar und Sie können Modelle später verbessern, ohne Entscheidungslogik umzuschreiben.

Bauen Sie Appeals als erstklassige Objekte, die mit der ursprünglichen Entscheidung verlinkt sind:

Beginnen Sie mit einem kleinen, klaren RBAC‑Satz:

Verwenden Sie mehrere Queues mit klarer Verantwortlichkeit:

Priorisieren Sie innerhalb einer Queue mit erklärbaren Signalen wie Severity, Reach, unique Reporter und SLA‑Timern. Zeigen Sie im UI „Warum sehe ich das?“, damit Reviewer die Reihenfolge vertrauen und mögliche Manipulation erkennen.

Implementieren Sie Claiming/Locking mit Timeouts:

Das reduziert doppelte Arbeit und liefert Daten, um Bottlenecks oder Cherry‑Picking zu analysieren.

Übersetzen Sie Ihre Policy in eine strukturierte Taxonomie und Templates:

Das erhöht Konsistenz, macht Analytics sinnvoller und vereinfacht Audits sowie Appeals.

Protokollieren Sie alles, was nötig ist, um die Geschichte nachzuvollziehen:

Machen Sie Logs durchsuchbar nach Actor, Content‑ID, Policy‑Code, Queue und Zeitraum und definieren Sie Aufbewahrungsregeln (inkl. Legal‑Holds und wie Löschanfragen gespeicherte Beweise betreffen).

Protokollieren Sie stets, welche Policy‑Version ursprünglich angewandt wurde und welche Version beim Appeal gilt.

Ergänzen Sie dann Least‑Privilege‑Berechtigungen nach Fähigkeiten (z. B. can_export_data, can_apply_account_penalty), damit neue Features Ihr Zugriffsmodell nicht sprengen.