Was Sie bauen und warum es wichtig ist

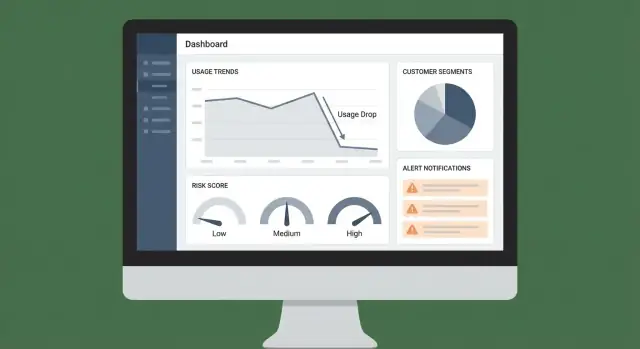

Dieses Projekt ist eine Web‑App, die Ihnen hilft, aussagekräftige Kundennutzungsrückgänge frühzeitig zu erkennen — bevor sie in Abwanderung (Churn) münden. Statt auf ein Verlängerungsgespräch zu warten, in dem ein Problem entdeckt wird, zeigt die App ein klares Signal (was sich geändert hat, wann und um wie viel) und fordert das richtige Team zur Reaktion auf.

Das Ziel: frühere Erkennung, bessere Bindung

Nutzungsrückgänge treten oft Wochen vor einer Kündigungsanfrage auf. Ihre App sollte diese Rückgänge sichtbar, erklärbar und handlungsfähig machen. Das praktische Ziel ist einfach: Churn reduzieren, indem Sie Risiko früher erfassen und konsistent reagieren.

Für wen das ist (und was jede Gruppe braucht)

Verschiedene Teams suchen in denselben Daten nach unterschiedlichen "Wahrheiten". Nutzerzentriertes Design verhindert, dass die App nur ein weiteres Dashboard wird.

- Customer Success braucht eine priorisierte Übersicht über Accounts, die Aufmerksamkeit benötigen, plus genug Kontext für aussagekräftige Erstansprache.

- Sales (insbesondere Account Manager) braucht verlängerungsfokussierte Risikoflaggen und Gesprächspunkte, die Expansion unterstützen oder Abwanderung verhindern.

- Produkt- und Analytics-Teams brauchen aggregierte Trends, die Reibungspunkte, Adoption-Lücken oder Features mit geringer Wirkung hervorheben.

Die Ergebnisse, die Sie liefern

Mindestens sollte die App liefern:

- Ein Customer‑Health‑Dashboard mit aktuellen Nutzungstrends und Risikoindikatoren

- Alerts, wenn ein Account eine sinnvolle Schwelle überschreitet (Abfall, Inaktivität oder Musteränderung)

- „Next‑best actions“, die vorschlagen, was als Nächstes zu tun ist (Nachricht, Anruf, Training, Fix oder interne Eskalation)

Das ist der Unterschied zwischen „Daten sind irgendwo verfügbar“ und „ein Workflow, dem Leute tatsächlich folgen“.

Wie Sie Erfolg messen

Definieren Sie Erfolg wie ein Produkt: mit Metriken.

- Precision: Wie viele der alarmierten Accounts waren tatsächlich gefährdet?

- Response time: Wie schnell reagiert das Team nach einem Signal?

- Business impact: Gerettete Verlängerungen, reduzierte Abwanderung oder geschützte Expansion

Wenn die App Entscheidungen verbessert und Aktionen beschleunigt, wird sie angenommen und amortisiert sich.

Definieren Sie Nutzungsrückgänge und die Kundeneinheit

Bevor Sie einen „Nutzungsrückgang“ erkennen können, brauchen Sie eine präzise Definition von Nutzung und eine konsistente Messeinheit. Es geht weniger um Analytics‑Jargon als darum, False Alarms zu vermeiden (oder echtes Risiko zu übersehen).

Was „Nutzung“ bedeuten sollte

Wählen Sie eine primäre Nutzungsmetrik, die echten Wert widerspiegelt. Gute Optionen hängen vom Produkt ab:

- Schlüssel‑Events: z. B. erstellte Reports, gesendete Nachrichten, abgeschlossene Deployments

- Sessions oder aktive Tage: sinnvoll, wenn viele Aktionen leichtgewichtig sind

- Minuten / Verbrauch: üblich bei Video, Calls, Compute oder API‑intensiven Tools

- Aktive Seats: Anzahl eindeutiger Nutzer, die sinnvolle Arbeit geleistet haben

Zielen Sie auf eine Metrik, die sich schwer „manipulieren“ lässt und eng mit Verlängerungsabsicht verbunden ist. Sie können später mehrere Metriken verfolgen, starten Sie aber mit einer, die Sie in einem Satz erklären können.

Die Kundeneinheit: Wer „fällt“ ab?

Definieren Sie die Entität, die Sie bewerten und alarmieren:

- Account/Workspace (am häufigsten bei B2B)

- Subscription (nützlich, wenn ein Unternehmen mehrere Pläne hat)

- Kohorte innerhalb eines Accounts (z. B. eine Abteilung), wenn die Adoption stark variiert

Diese Wahl beeinflusst alles: Aggregation, Dashboards, Ownership und Routing von Alerts.

Was als „Drop“ zählt

Setzen Sie Schwellen, die zum Kundenverhalten passen:

- Woche‑zu‑Woche‑Änderung (einfach und erklärbar)

- Rolling average vs. vorheriger rolling average (reduziert Rauschen)

- Saisonale Baselines (wichtig bei Wochentags/Wochenendmustern)

Entscheiden Sie auch Ihr Zeitfenster (täglich vs. wöchentlich) und wie viel Reporting‑Lag Sie tolerieren (z. B. „Alerts bis 9 Uhr am nächsten Tag“ vs. Echtzeit). Klare Definitionen verhindern Alert‑Fatigue und machen Scores vertrauenswürdig.

Wählen Sie Datenquellen und Integrationsansatz

Ihre App ist nur so zuverlässig wie die Eingaben, die sie überwacht. Bevor Sie Dashboards oder Scoring bauen, entscheiden Sie, welche Systeme „Nutzung“, „Wert“ und „Kundenkontext“ für Ihr Business definieren.

Wählen Sie die minimale Menge an Quellsystemen

Starten Sie mit einem eng gefassten Satz an Datenquellen, die Sie akkurat halten können:

- Product Events: Logins, Schlüssel‑Feature‑Aktionen, API‑Calls, genutzte Seats, Exporte — was auch immer mit Wert korreliert

- Billing/Subscriptions: Plan, Verlängerungsdatum, Zahlungsstatus, Upgrades/Downgrades, Trial‑Start/Ende

- CRM: Account‑Owner, Segment, Lifecycle‑Stadium, Vertragsbedingungen

- Support‑Tickets: Volumen, Schweregrad, Reaktionszeiten, ungelöste Probleme

- Status/Incident‑History: Ausfälle und Performance‑Degradierungen, die Nutzungsdips erklären können

Wenn Sie unsicher sind, priorisieren Sie Product Events + Billing; CRM/Support können Sie hinzufügen, sobald das Kernmonitoring funktioniert.

Entscheiden Sie, wie Daten ankommen (und wie oft)

Drei gängige Ingest‑Methoden, oft gemischt:

- Webhooks/Streaming für nahezu Echtzeit‑Product‑Events und Abo‑Änderungen

- Batch‑Importe (täglich/stündlich) für CRM und Support‑Tools, die keine Sekunde‑zu‑Sekunde‑Updates benötigen

- ETL/ELT‑Connectoren wenn Sie verwaltete Synchronisationen von Tools wie Salesforce/Zendesk wollen und Konsistenz über Eigenentwicklung stellen

Passen Sie die Kadenz an die Entscheidungen an, die Sie automatisieren wollen. Wenn Sie CSMs innerhalb einer Stunde nach einem plötzlichen Drop alarmieren möchten, kann das Event‑Ingest nicht „einmal täglich“ sein.

Identifiers korrekt definieren (oder alles bricht)

Nutzungsrückgänge werden pro Kundeneinheit (Account/Tenant) detektiert. Definieren und persistieren Sie Mappings früh:

- Account ID (tenant/workspace) als primärer Gruppierungsschlüssel

- User IDs mit Account‑Verknüpfung (Nutzer können Accounts wechseln — Historie tracken)

- Plan IDs / Subscription IDs mit Bezug auf Billing‑Perioden

Erstellen Sie eine zentrale Identity‑Mapping‑Tabelle/Service, sodass jede Integration auf denselben Account resolved.

Ownership und Zugriff vorher dokumentieren

Schreiben Sie auf, wer welches Dataset besitzt, wie es gepflegt wird und wer es sehen darf. Das vermeidet Blocker beim Launch, wenn Sie sensible Felder (Billing‑Details, Support‑Notizen) hinzufügen oder Metriken gegenüber Stakeholdern erklären müssen.

Modellieren Sie die Daten für Metriken, Signale und Historie

Ein gutes Datenmodell hält Ihre App schnell, erklärbar und leicht erweiterbar. Sie speichern nicht nur Events — Sie speichern Entscheidungen, Belege und eine Nachverfolgung dessen, was passiert ist.

Kern‑Entitäten (die "Quelle der Wahrheit")

Starten Sie mit ein paar stabilen Tabellen, auf die alles referenziert:

- accounts: account_id, name, plan, status, timezone, CSM owner

- users: user_id, account_id, role, created_at, last_seen_at

- subscriptions: account_id, start/end dates, MRR, seats, renewal date

- events: event_id, occurred_at, user_id, account_id, event_name, properties (JSON)

Halten Sie IDs systemübergreifend konsistent (CRM, Billing, Produkt), damit Joins ohne Ratespiel funktionieren.

Aggregation für Geschwindigkeit: tägliche Metriken und Feature‑Nutzung

Roh‑Events in jedem Dashboard‑View zu queryen, wird schnell teuer. Berechnen Sie stattdessen Snapshots wie:

- account_daily_metrics: account_id, date, active_users, sessions, key_actions, time_in_product

- account_feature_daily: account_id, date, feature_key, usage_count (oder Minuten, genutzte Seats, etc.)

Diese Struktur unterstützt sowohl High‑Level‑Health‑Ansichten als auch Feature‑Level‑Untersuchungen („Nutzung ist gefallen — wo genau?“).

Risiko‑Signale separat speichern (mit Evidenz)

Behandeln Sie Risikodetektion als eigenes Produkt-Output. Erstellen Sie eine risk_signals‑Tabelle mit:

- signal_type (z. B.

usage_drop_30d, no_admin_activity)

- severity (low/med/high)

- timestamp und lookback‑window

- evidence (Zahlen, Baselines, Links zu Metrik‑Zeilen)

So bleibt das Scoring transparent: Sie können zeigen, warum die App einen Account geflaggt hat.

Historie für Audits und Lernen tracken

Fügen Sie append‑only‑Historientabellen hinzu:

- health_score_history: account_id, computed_at, score, contributing_signals

- alert_history: triggered_at, channel, recipients, dedupe_key

- actions_taken: created_by, action_type, notes, outcome

Mit Historie können Sie fragen: „Wann stieg das Risiko?“, „Welche Alerts wurden ignoriert?“, „Welche Playbooks reduzierten tatsächlich Churn?"

Instrumentieren Sie Product Events und Data Quality Checks

Ihre App kann Nutzungsrückgänge nicht erkennen, wenn die zugrunde liegenden Events inkonsistent oder unvollständig sind. Dieser Abschnitt beschreibt, wie Event‑Daten zuverlässig genug für Dashboards, Alerts und Risk‑Signale werden.

Definieren Sie einen einfachen Tracking‑Plan

Starten Sie mit einer kurzen Liste von Verhaltensweisen, die Wert repräsentieren:

- Schlüsselaktionen (z. B. „Projekt erstellt“, „Teammitglied eingeladen“, „Report veröffentlicht")

- Feature‑Nutzung (welche Module wie oft genutzt werden)

- Friction‑Signale (Errors, fehlgeschlagene Zahlungen, Permission‑Denials)

- Performance‑Marker (langsame API‑Antworten, Seitenladezeiten, Timeouts)

Praktisch bleiben: Wenn ein Event keine Metrik, keinen Alert oder keinen Workflow antreibt, tracken Sie es noch nicht.

Standardisieren Sie das Event‑Schema

Konsistenz schlägt Kreativität. Verwenden Sie ein gemeinsames Schema für jedes Event:

- event_name (Verb + Objekt, z. B.

report_exported)

- timestamp (UTC)

- account_id und user_id (wo relevant erforderlich)

- properties (feature, plan, environment, error_code, latency_ms, etc.)

Dokumentieren Sie erforderliche Properties pro Event in einer leichten Tracking‑Spec, die Ihr Team in PRs reviewen kann.

Für kritische Events serverseitiges Tracking bevorzugen

Client‑seitiges Tracking ist nützlich, kann aber blockiert, verworfen oder dupliziert werden. Für wertvolle Events (Billing‑Änderungen, erfolgreiche Exporte, abgeschlossene Workflows) schicken Sie Events vom Backend, nachdem die Aktion bestätigt wurde.

Fügen Sie automatisierte Data‑Quality‑Checks hinzu

Behandeln Sie Datenprobleme wie Produkt‑Bugs. Fügen Sie Checks und Alerts für hinzu:

- Fehlende oder null account_id/user_id

- Duplikate (Idempotency‑Key)

- Clock‑Drift (Timestamps weit in der Zukunft/Vergangenheit)

- Plötzliche Volumenänderungen pro Event‑Typ (häufig durch einen kaputten Release)

Ein kleines Data‑Quality‑Dashboard plus ein täglicher Report an das Team verhindert stille Fehler, die Churn‑Risk‑Detektion untergraben.

Entwerfen Sie ein Customer‑Health‑ und Risikoscoring‑System

Nutzern zugänglich machen

Stelle deinen Prototyp bereit und hoste ihn, damit CS und Sales ihn mit echten Accounts testen können.

Ein guter Health‑Score sagt weniger „Churn perfekt vorhersagen“ als vielmehr „Mitarbeitern helfen, zu entscheiden, was als Nächstes zu tun ist“. Starten Sie simpel, machen Sie es erklärbar und entwickeln Sie es weiter, wenn Sie lernen, welche Signale wirklich mit Retention korrelieren.

Beginnen Sie bewusst mit regelbasiertem Scoring

Starten Sie mit einem kleinen Satz klarer Regeln, die CS, Sales oder Support verstehen und debuggen können.

Beispiel: „Wenn die wöchentliche aktive Nutzung um 40 % gegenüber dem 4‑Wochen‑Durchschnitt fällt, addiere Risikopunkte.“ Diese Vorgehensweise macht Debatten produktiv, weil Sie auf die exakte Regel und Schwelle zeigen können.

Fügen Sie gewichtete Signale hinzu, die realweltliches Risiko widerspiegeln

Sobald die Basisregeln funktionieren, kombinieren Sie mehrere Signale mit Gewichten. Häufige Inputs:

- Nutzungsabfall (Produktaktivität, Schlüssel‑Feature‑Adoption, API‑Calls)

- Seat‑Reduktion (entfernte Lizenzen, steigende inaktive Seats)

- Fehlgeschlagene Zahlungen (Invoice‑Fehler, Karten‑Declines, Überfälligkeit)

- Ticket‑Spikes (Support‑Volumen, Schwere, Time‑to‑Resolution)

Gewichte sollten Geschäftsimpact und Vertrauen widerspiegeln. Ein Zahlungsfehler kann mehr Gewicht bekommen als ein milder Nutzungsabfall.

Trennen Sie Leading‑ und Lagging‑Indikatoren

Behandeln Sie Leading‑Indikatoren (aktuelle Veränderung) anders als Lagging‑Indikatoren (langsam laufendes Risiko):

- Leading: Nutzungsänderung der letzten 7–14 Tage, plötzliche Error‑Spikes

- Lagging: Nähe zum Renewal‑Datum, langfristig niedrige Adoption

So kann Ihre App sowohl „Was hat sich diese Woche geändert?“ als auch „Wer ist strukturell gefährdet?“ beantworten.

Definieren Sie Score‑Bänder mit Aktionen

Übersetzen Sie den numerischen Score in Bänder mit Klartextdefinitionen:

- Healthy: stabile oder steigende Nutzung; keine kritischen Probleme

- Watch: signifikante negative Tendenz; beobachten und nudgen

- At risk: anhaltender Abfall oder kritische Signale; dringende Kontaktaufnahme

Verknüpfen Sie jedes Band mit einem Standard‑Nächsten‑Schritt (Owner, SLA, Playbook), damit der Score konsistente Nachverfolgung antreibt statt nur ein rotes Abzeichen im Dashboard zu sein.

Erkennen Sie Anomalien und sinnvolle Nutzungsänderungen

Anomalieerkennung ist nur nützlich, wenn sie widerspiegelt, wie Kunden Ihr Produkt tatsächlich nutzen. Ziel ist nicht, jede Abweichung zu markieren — sondern Änderungen zu entdecken, die Churn vorhersagen und menschliche Nachverfolgung rechtfertigen.

Baselines bauen, die der Realität entsprechen

Nutzen Sie mehr als eine Baseline, damit Sie nicht überreagieren:

- Eigene Historie des Accounts: diese Woche vs. letzte 4–8 Wochen

- Segment‑Durchschnitte: ähnliche Kunden (Tarifstufe, Branche, Größe, Region) vergleichen, um „quiet quitting“ zu erkennen

- Saisonalität: Vergleiche nach Wochentag/Monat ausrichten (z. B. Wochenenden, Monatsenden). Eine einfache Methode ist der Vergleich mit dem Durchschnitt desselben Wochentags über die letzten N Wochen.

Diese Baselines helfen zu unterscheiden, was „normal für sie“ ist und was „sich geändert hat“.

Plötzliche Abnahme vs. gradueller Rückgang

Behandeln Sie diese unterschiedlich, da die Gegenmaßnahmen verschieden sind:

- Abrupte Drops (z. B. −70 % Woche‑zu‑Woche, plötzliches Aussetzen wichtiger Events) deuten oft auf Breakage hin: Ausfälle, integrierte Dienste getrennt, Billing‑Änderungen, Nutzerabwanderung oder Berechtigungsprobleme.

- Graduelle Declines (z. B. −10 % pro Woche über einen Monat) weisen eher auf Wertverlust hin: sinkende Engagements, Champion weggegangen, Konkurrenztool, unvollständige Rollouts.

Ihre App sollte das Muster labeln, denn Playbooks und Owner unterscheiden sich.

False Alarms reduzieren

False Alarms zerstören Vertrauen. Fügen Sie Schutzmechanismen hinzu:

- Mindestaktivitätsschwellen: keine Alerts für Accounts mit zu geringer Basisnutzung (z. B. < 20 Schlüssel‑Events/Woche)

- Gnadenzeiten: Lücken nach Onboarding, Planwechseln, Feiertagen oder bekannten Incidents ignorieren

- Bestätigungsfenster: Drop muss 2–3 Tage anhalten (oder 1–2 Wochen bei seltenen Produkten)

Jede Flag erklärbar machen

Jedes Risikosignal sollte Belege enthalten: „warum geflaggt“ und „was sich geändert hat“. Hängen Sie an:

- verwendete Baseline (Historie/Segment/Saisonalität)

- Metrik und Zeitraum (z. B. „API‑Calls, letzte 7 Tage")

- Delta und Schwelle (z. B. "−62% vs prior 4‑week weekday avg")

- Top‑Treiber (z. B. "3/5 aktive Nutzer gestoppt", "Integration X sendet keine Events mehr")

Das verwandelt Alerts in Entscheidungen, nicht in Rauschen.

Bauen Sie die Web‑App UI: Dashboards und Account‑Views

Internes Tool schneller bereitstellen

Erzeuge ein React-UI und eine Go-API für Account‑Ansichten, Signal‑Logs und Aufgaben‑Nachverfolgung.

Eine gute UI verwandelt unübersichtliche Telemetrie in einen täglichen Workflow: „Wer braucht Aufmerksamkeit, warum und was tun wir als Nächstes?“ Halten Sie die ersten Bildschirme meinungsstark und schnell — die meisten Teams werden dort leben.

Dashboard‑Essentials

Ihr Dashboard sollte drei Fragen auf einen Blick beantworten:

- Trends: Ein einfaches Chart für die Gesamt‑Nutzung (und optional nach Schlüssel‑Feature) mit Woche‑zu‑Woche‑Änderung

- Top At‑Risk Accounts: Eine Rangliste mit aktuellem Health‑Score, größten negativen Deltas und stärksten Churn‑Signalen

- Letzte Alerts: Ein kompakter Feed, was ausgelöst wurde, wann und welcher Customer‑Unit betroffen ist

Machen Sie jede Zeile klickbar zur Account‑Ansicht. Bevorzugen Sie vertraute Tabellenmuster: sortierbare Spalten, fixierte Risiko‑Spalten und ein klares Last‑Seen‑Timestamp.

Account‑Seite: die komplette Story

Gestalten Sie die Account‑Ansicht um eine Timeline, damit ein CSM Kontext in Sekunden erfassen kann:

- Nutzungs‑Timeline mit Annotationen (Deploys, Planwechsel, Billing‑Events)

- Key‑Events (Activation‑Milestones, Feature‑Adoption, Support‑Eskalationen)

- Signal‑Log mit jedem Churn‑Risk‑Signal: Wert, Schwelle, Evaluierungszeitpunkt

- Notizen und Tasks damit Arbeit am Account bleibt und nicht in Tools verstreut wird

Fügen Sie ein internes Deep‑Link‑Pattern wie /accounts/{id} hinzu, damit Alerts Menschen zur exakten Ansicht routen.

Filter, Export und Teilen

Filter machen Dashboards handlungsfähig. Bieten Sie globale Filter für Plan, Segment, Branche, CSM‑Owner, Region und Lifecycle‑Stage und persistieren Sie Selektionen in der URL für teilbare Views.

Für Exporte erlauben Sie CSV‑Downloads aus Tabellen (unter Berücksichtigung der Filter) und „Link kopieren“‑Sharing für interne Übergaben — besonders von der At‑Risk‑Liste und dem Alert‑Feed.

Erstellen Sie Alerts, Benachrichtigungen und Routing

Alerts sind nur nützlich, wenn sie zur richtigen Person zur richtigen Zeit gelangen — und nicht dazu führen, dass alle sie ignorieren. Behandeln Sie Benachrichtigungen als Produktfunktion, nicht als Nachgedanken.

Definieren Sie Alert‑Trigger (was Aufmerksamkeit verdient)

Starten Sie mit wenigen Triggern, die klaren Aktionen zugeordnet sind:

- Score‑Schwellen: z. B. Health‑Score fällt unter 60 oder Churn‑Risk über 80

- Plötzliche Nutzungsabfälle: z. B. 40% Abfall Woche‑zu‑Woche bei einem Schlüssel‑Event

- Multi‑Signal‑Muster: z. B. Nutzungsabfall und Support‑Ticket‑Spike oder Feature‑Adoption stagniert 14 Tage

Nutzen Sie einfache Regeln zuerst, layern Sie später intelligente Logik (Anomalieerkennung) ein, wenn Sie den Basics vertrauen.

Wählen Sie Kanäle passend zur Arbeitsweise Ihres Teams

Wählen Sie einen Primär- und einen Backup‑Kanal:

- E‑Mail für Zusammenfassungen, Daily Digests und Stakeholder, die nicht im Chat leben

- Slack für zeitkritische Alerts, geroutet an #cs‑alerts oder eine dedizierte On‑Call‑Rotation

- In‑App Notifications für interne Tools, in denen CSMs arbeiten (ideal für „Work‑Queue“ Follow‑Ups)

Wenn Sie unsicher sind: Starten Sie mit Slack + In‑App Tasks. E‑Mail wird schnell laut.

Routing und Deduplizierung gegen Spam

Route Alerts basierend auf Account‑Ownership und Segment:

- Hat ein Account einen Owner, notify den CSM

- Bei High‑Value Accounts zusätzlich CS‑Leadership benachrichtigen

- Technische Signale (API‑Errors, Ingest‑Fehler) an Engineering/On‑Call schicken

Deduplizieren Sie, indem Sie wiederholte Alerts in einen Thread/Ticket gruppieren (z. B. „Nutzungsabfall besteht seit 3 Tagen“). Fügen Sie Cool‑Down‑Windows hinzu, damit nicht jede Stunde dasselbe gesendet wird.

Kontext liefern, damit Alerts handlungsfähig sind

Jeder Alert sollte beantworten: was sich geändert hat, warum es wichtig ist, was als Nächstes zu tun ist. Beinhaltet:

- Die verschobenen Metriken und die Baseline‑Vergleichswerte

- Den vermuteten Treiber (Feature, Workspace, Seat‑Gruppe, Region)

- Eine empfohlene nächste Aktion (z. B. „Check‑in E‑Mail schicken“ oder „Onboarding‑Abschluss prüfen")

- Einen direkten Link zur Account‑Ansicht:

/accounts/{account_id}

Wenn Alerts direkt zu einer klaren Aktion führen, werden Teams ihnen vertrauen und sie nutzen.

Automatisieren Sie Follow‑Up‑Workflows und Playbooks

Detektion ist nur nützlich, wenn sie zuverlässig die nächste beste Handlung auslöst. Automatisierte Follow‑Up‑Workflows verwandeln „wir sahen einen Drop“ in eine konsistente, nachverfolgbare Reaktion, die langfristig Retention verbessert.

Signale in Playbooks überführen

Mappen Sie jedes Signal auf ein einfaches Playbook. Halten Sie Playbooks meinungsstark und schlank, damit Teams sie tatsächlich nutzen.

Beispiele:

- Nutzungsabfall in einem Schlüssel‑Feature: Outreach‑E‑Mail + Angebot einer 15‑minütigen Working‑Session

- Neuer Admin aber kein Rollout: Enablement‑Nudge + Checkliste teilen

- Spike in Errors oder Latenz: Technischer Check‑In + Logs anfordern + internes Incident öffnen

Speichern Sie Playbooks als Templates: Schritte, empfohlene Messages, Pflichtfelder (z. B. „Root Cause“) und Exit‑Kriterien (z. B. „Nutzung für 7 Tage wieder auf Baseline").

Tasks erstellen, die nicht ignoriert werden können

Wenn ein Signal feuert, erzeugen Sie automatisch eine Aufgabe mit:

- Owner (CSM per Account oder Round‑Robin innerhalb einer Queue)

- Fälligkeitsdatum (je nach Schwere; z. B. High Risk innerhalb 4 Business‑Hours)

- Status‑Tracking (Open → In progress → Blocked → Done)

Fügen Sie jedem Task ein kurzes Kontextpaket bei: welche Metrik sich änderte, wann es begann, die zuletzt bekannte gesunde Periode und aktuelle Produkt‑Events. Das reduziert Rückfragen und beschleunigt den Erstkontakt.

Integrieren Sie dorthin, wo Teams bereits arbeiten

Zwingen Sie niemanden in einen neuen Tab. Puschen Sie Tasks/Notizen in bestehende Systeme und holen Sie Outcomes zurück in Ihre App.

Gängige Ziele: CRM und Support‑Tools (siehe /integrations/crm). Halten Sie den Workflow bidirektional: Wenn ein Task im CRM abgeschlossen wird, spiegeln Sie das im Health‑Dashboard wider.

Follow‑through messen (und sichtbar machen)

Automatisierung soll die Reaktionsqualität verbessern, nicht nur das Volumen. Tracken Sie:

- Time‑to‑contact vom Alert bis zur ersten Kontaktaufnahme

- Resolution‑Notes (Was wurde getan und warum)

- Outcome‑Tags (Recovered, Ongoing risk, Product issue, Customer downsized)

Reviewen Sie diese Metriken monatlich, um Playbooks zu verfeinern, Routing‑Regeln zu optimieren und herauszufinden, welche Aktionen tatsächlich Nutzung wiederherstellen.

Schneller prototypen mit Koder.ai (optional)

Wenn Sie schneller vom Spec zu einem internen Tool kommen wollen, kann eine Vibe‑Coding‑Plattform wie Koder.ai helfen, Dashboard, Account‑Views und Alert‑Workflow per Chat zu prototypen — und dann das reale Produktverhalten iterativ zu validieren. Koder.ai kann Full‑Stack‑Apps generieren (React Web, Go‑Services mit PostgreSQL), unterstützt Snapshots/Rollback und Source‑Code‑Export, und ist praktisch, um Datenmodell, Routing‑Regeln und UI‑Flow vor einer größeren Investition zu validieren.

Security, Privacy und Compliance‑Basics

Kosten ausgleichen, während du baust

Erhalte Credits, indem du zeigst, was du auf Koder.ai gebaut hast, oder Teamkollegen einlädst, es auszuprobieren.

Security‑ und Datenschutzentscheidungen lassen sich am einfachsten früh korrekt treffen — besonders wenn Ihre App Produkt‑Events, Account‑Kontext und Alerts zu Abwanderungsrisiko zusammenführt. Ziel ist einfach: Risiko reduzieren und gleichzeitig Teams genug Daten zum Handeln geben.

Datenminimierung: nur das sammeln, was nötig ist

Definieren Sie, was Monitoring erfordert. Wenn Ihre Nutzungs‑Erkennung mit Zählungen, Trends und Timestamps funktioniert, brauchen Sie wahrscheinlich keine Rohinhalte von Nachrichten, vollständige IP‑Adressen oder unstrukturierte Notizen.

Ein praktischer Ansatz ist das Speichern von:

- Account-/Workspace‑Identifiers (interne IDs)

- Event‑Typ + Timestamp

- Aggregierte Metriken (DAU, Feature‑Counts, API‑Calls)

- Minimale Nutzerreferenzen nur wenn nötig für Routing (z. B. interne User‑ID)

Ein enger Datensatz reduziert Compliance‑Aufwand, begrenzt Blast‑Radius und erleichtert Retention‑Policies.

Zugriffskontrolle und Auditierbarkeit

Usage‑Drop‑Dashboards werden oft cross‑funktional (CS, Support, Produkt, Leadership). Nicht jeder sollte dieselben Details sehen. Implementieren Sie RBAC mit klaren Regeln:

- Executives: Summary‑Views und Trends

- CSMs: Accounts, die sie besitzen, mit relevantem Drill‑down

- Support: operative Signale, nicht sensible Kunden‑Meta

- Admins: Integrationen und Konfiguration

Fügen Sie Audit‑Logs für sensible Aktionen hinzu (Datenexporte, Ändern von Alert‑Schwellen, Ansicht auf Account‑Details). Audit‑Logs helfen auch beim Debugging: „Wer hat was geändert, als Alerts laut wurden?"

Umgang mit PII: Hashing, Verschlüsselung und Retention

Behandeln Sie PII (Namen, E‑Mails, Telefonnummern) als optional. Falls für Benachrichtigungen nötig, ziehen Sie diese on‑demand aus dem CRM statt sie in die Monitoring‑DB zu kopieren.

Wenn Sie PII speichern:

- Verschlüsseln während der Übertragung (TLS) und verschlüsseln im Ruhezustand (DB‑Encryption)

- Erwägen Sie Hashing von Identifikatoren, die nur zum Joinen benötigt werden

- Definieren Sie Retention‑Policies (z. B. Roh‑Events 30–90 Tage, Aggregates 12–24 Monate)

- Sorgen Sie dafür, dass Backups denselben Regeln folgen (Retention, Zugriff)

Consent und Compliance (GDPR/CCPA) ohne Überversprechen

Dokumentieren Sie, was Sie sammeln, warum Sie es sammeln (Monitoring und Support) und wie lange Sie es aufbewahren. Formulieren Sie genau — vermeiden Sie Aussagen wie „vollständig compliant“, wenn kein formaler Review vorliegt.

Mindestens sollten Sie unterstützen:

- Datenzugriffs-/Löschanfragen (User‑level Daten löschen oder anonymisieren)

- Zweckbindung (Monitoring‑Daten nicht für fremde Profilierung verwenden)

- Vendor‑/Subprocessor‑Tracking (Analytics‑Tools, E‑Mail/SMS‑Provider)

Wenn Sie kundenseitige Docs veröffentlichen, verlinken Sie intern auf Ihre Richtlinien (z. B. /privacy, /security) und halten Sie diese im Einklang mit der tatsächlichen Systemfunktion.

Testing, Rollout und kontinuierliche Verbesserung

Eine Churn‑Risk‑App ist nicht nur „läuft sie?“ — sondern ob Teams den Signalen genug vertrauen, um zu handeln — und ob das System zuverlässig bleibt, während Produkt und Daten sich entwickeln.

Validieren mit historischen Daten (Backtesting)

Bevor Sie jemanden alarmieren, spielen Sie Regeln/Modelle über vergangene Perioden ab, deren Outcomes (verlängert, downgraded, churned) Sie bereits kennen. Das hilft bei der Feinabstimmung von Schwellen und verhindert laute Alerts.

Eine einfache Bewertung per Confusion‑Matrix:

- True Positives: geflaggte Accounts, die später churned/downgraded haben

- False Positives: geflaggte Accounts, die tatsächlich fine waren

- False Negatives: verpasste Accounts, die churned sind

- True Negatives: korrekt ignorierte Accounts

Konzentrieren Sie sich operational: False Positives reduzieren, damit CSMs Alerts nicht ignorieren, und False Negatives niedrig halten, damit echtes Risiko rechtzeitig erwischt wird.

Monitor the monitoring (Data‑Pipeline Checks)

Viele „Nutzungsabfälle" sind Datenprobleme. Fügen Sie leichtgewichtige Überwachung für jeden Pipeline‑Schritt hinzu:

- Freshness: Wann wurde diese Tabelle zuletzt aktualisiert?

- Fehlende Daten: plötzlicher Drop auf Null, fehlende Tenants oder partielle Ingests

- Job‑Failures: Retries, Schema‑Änderungen, API‑Rate‑Limits

Stellen Sie diese Probleme in einer internen Status‑Ansicht dar, damit Nutzer „Kunde hat Nutzung verloren“ von „Daten sind nicht angekommen“ unterscheiden können.

Phasenweiser Rollout

Starten Sie intern (Data/Ops + einige CSMs) und vergleichen Sie Alerts mit dem, was sie bereits wissen. Erweitern Sie die Gruppe, sobald Genauigkeit und Workflow stabil sind.

Messen Sie während des Rollouts Adoption: Alerts geöffnet, Time‑to‑Triaged, und ob Nutzer zur Account‑Ansicht klicken.

Feedback‑Schleifen bauen, die Ergebnisse verbessern

Geben Sie Nutzern eine Ein‑Klick‑Möglichkeit, einen Alert als False Positive, Known Issue oder Action Taken zu markieren. Speichern Sie dieses Feedback und überprüfen Sie es wöchentlich, um Regeln zu verfeinern, Gewichte anzupassen oder Ausnahmen hinzuzufügen (z. B. saisonale Kunden, geplante Downtimes).

So wird die App im Laufe der Zeit vom statischen Dashboard zu einem System, das aus der Realität Ihres Teams lernt.