Was eine Website für ein Produkt-Experimentprotokoll leistet

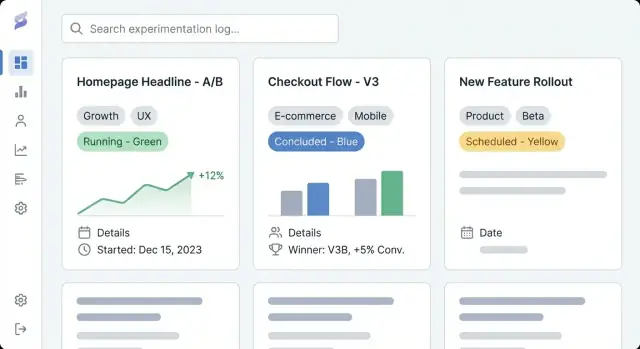

Eine Website für ein Produkt-Experimentprotokoll ist ein gemeinsamer Ort, um jedes Experiment Ihres Teams zu dokumentieren — A/B-Tests, Preisversuche, Anpassungen im Onboarding, Feature-Flags, E-Mail-Experimente und sogar „gescheiterte“ Ideen, die dennoch etwas gelehrt haben. Denken Sie daran als eine Kombination aus Experimenten-Repository und Produkt-Lernprotokoll: eine Aufzeichnung dessen, was Sie versucht haben, warum, was passiert ist und welche Entscheidung als Nächstes getroffen wurde.

Warum Teams so etwas nutzen

Die meisten Teams haben bereits Fragmente der Experimentverfolgung verstreut in Docs, Dashboards und Chats. Eine dedizierte Experimentverfolgungs-Website bündelt diese Artefakte in eine einzige, navigierbare Historie.

Die praktischen Ergebnisse sind:

- Sichtbarkeit: jeder kann schnell sehen, was gerade läuft, was verschickt wurde, was gestoppt wurde und was geplant ist — ohne in Tools suchen zu müssen.

- Wiederholbarkeit: Teams können Experiment-Templates wiederverwenden, vermeiden, dieselbe Hypothese erneut zu testen, und bewährte Methoden (Targeting, Metriken, Dauer) kopieren.

- Geteiltes Lernen: Ergebnisse und Kontext bleiben lange nach Projektende verfügbar, sodass neue Teammitglieder vergangene Entscheidungen verstehen und darauf aufbauen können.

Was Sie von diesem Leitfaden bekommen

Dieser Leitfaden konzentriert sich darauf, wie Sie eine Website bauen, die Experimentdokumentation einfach zu erstellen und einfach zu nutzen macht. Wir behandeln, wie Sie Struktur und Navigation planen, ein Datenmodell für Experiment-Einträge definieren (damit Einträge konsistent bleiben), lesbare Seitentemplates erstellen, Tagging und Suche für schnelle Auffindbarkeit einrichten und den richtigen Implementierungsansatz wählen (CMS vs. Custom-App).

Am Ende haben Sie einen klaren Plan für eine A/B-Test-Dokumentationsseite, die die tägliche Produktarbeit unterstützt — Hypothesen, Metriken und Ergebnisberichte sowie Entscheidungen erfassen, so dass sie durchsuchbar, vertrauenswürdig und langfristig nützlich sind.

Ziele, Zielgruppe und Zugriffsebene definieren

Bevor Sie Tools wählen oder Experiment-Templates entwerfen, klären Sie, warum dieses Experiment-Tracking-Portal existiert und wem es dient. Ein Produkt-Experimentprotokoll ist nur nützlich, wenn es zu der Weise passt, wie Ihre Teams tatsächlich Entscheidungen treffen.

Klare Ziele setzen (wie „gut" aussieht)

Schreiben Sie 2–4 messbare Ergebnisse für das Experiment-Repository auf. Übliche Erfolgskriterien sind:

- Schnellere Auffindbarkeit: Leute finden relevante A/B-Test-Dokumentation in Minuten, nicht Stunden.

- Weniger doppelte Tests: Teams sehen, was bereits ausprobiert wurde, und vermeiden das erneute Testen derselben Idee.

- Bessere Entscheidungen: konsistentere Metriken und Ergebnisberichte mit klaren Verknüpfungen zwischen Hypothesen, Änderungen und Ergebnissen.

Diese Ziele sollten später alles beeinflussen: welche Felder Sie in jedem Eintrag verlangen, wie strikt Ihr Workflow ist und wie ausgeprägt Tagging und Suche sein müssen.

Primäre Nutzer und ihre Bedürfnisse identifizieren

Listen Sie Ihre primären Zielgruppen und was sie im Produkt-Lernprotokoll tun müssen:

- Produkt: vergangene Experimente überblicken, Ergebnisse vergleichen, erfolgreiche Muster wiederverwenden.

- Design: nachvollziehen, welche Änderungen getestet wurden und warum; Screenshots oder Specs prüfen.

- Engineering: Implementierungsdetails, Guardrails und technische Einschränkungen bestätigen.

- Führung: Auswirkungen und Qualität der Erkenntnisse prüfen, ohne jedes Detail zu lesen.

- Support/Kundenkontakt: wissen, was sich geändert hat und was sie Nutzern sagen sollen.

Eine einfache Validierung: fragen Sie jede Gruppe: „Welche Frage wollen Sie in 30 Sekunden beantwortet haben?“ und stellen Sie sicher, dass Ihre Templates und das Seitenlayout das unterstützen.

Ein Zugriffsmodell wählen: intern, öffentlich oder gemischt

Entscheiden Sie früh, ob Ihr CMS für Experiment-Logs sein soll:

- Nur intern: am besten für sensible Metriken, Roadmap-Details oder Nutzerdaten.

- Öffentlich: nützlich für Transparenz und Recruiting, erfordert aber strengere Prüfung und Redaktion.

- Gemischt: ein privates internes Log plus eine kuratierte öffentliche Teilmenge.

Wenn Sie gemischten Zugriff wählen, definieren Sie, was in öffentlichen Einträgen erlaubt ist (z. B. keine Rohmetriken, anonymisierte Segmente, keine unreleasten Feature-Namen) und wer die Veröffentlichung genehmigt. Das vermeidet Nacharbeit, wenn Ihr Team Erkenntnisse extern teilen möchte.

Seitenstruktur und Navigation planen

Ein Produkt-Experimentprotokoll funktioniert nur, wenn Leute das richtige Experiment in unter einer Minute finden. Bevor Sie Tools wählen oder Bildschirme entwerfen, überlegen Sie, wie jemand Ihre Seite durchsuchen wird, wenn er nicht weiß, wonach er sucht.

Klare Top-Level-Navigation wählen

Halten Sie die Hauptnavigation begrenzt und vorhersehbar. Ein praktischer Anfang ist:

- Experimente (Ihr Experiment-Repository)

- Playbooks (How-to-Anleitungen, Templates, Checklisten)

- Metriken (Definitionen, Verantwortliche, Tracking-Hinweise)

- Teams (wer macht was)

Wenn „Metriken" zu schwer wirkt, können Sie es zunächst von Experimente aus verlinken und später erweitern.

Primäre Ordnungslogik festlegen

Entscheiden Sie die Hauptform der Browsing-Logik. Die meisten Produkt-Lernprotokolle funktionieren am besten mit einer primären Ansicht und dem Rest über Filter gesteuert:

- Nach Produktbereich (z. B. Checkout, Suche, Onboarding)

- Nach Funnel-Stufe (Akquisition → Aktivierung → Retention)

- Nach Team (Growth, Core, Mobile)

Wählen Sie das, was Ihre Stakeholder bereits in Gesprächen verwenden. Alles andere sind Tags (z. B. Plattform, Hypothesenthema, Segment, Experimenttyp).

URLs, Breadcrumbs und „Zurück zur Liste"-Pfade planen

Machen Sie URLs lesbar und stabil, damit sie in Slack und Tickets geteilt werden können:

/experiments/2025-12-checkout-free-shipping-threshold

Fügen Sie Breadcrumbs wie Experimente → Checkout → Free shipping threshold hinzu, um Sackgassen zu vermeiden und das Scannen intuitiv zu halten.

Eine leichte Inhaltsinventur erstellen

Listen Sie auf, was Sie am ersten Tag veröffentlichen wollen versus später: aktuelle Experimente, wichtige Playbooks, ein Kern-Metrik-Glossar und Teamseiten. Priorisieren Sie Einträge, die häufig referenziert werden (hochwirksame Tests, kanonische Experiment-Templates und Metrikdefinitionen, die in Ergebnisberichten verwendet werden).

Datenmodell für Experiment-Einträge entwerfen

Ein nützliches Produkt-Experimentprotokoll ist nicht nur eine Linkliste — es ist eine Datenbank von Erkenntnissen. Das Datenmodell ist die „Form" dieser Datenbank: was Sie speichern, wie Einträge sich verknüpfen und welche Felder vorhanden sein müssen, damit Experimente über die Zeit vergleichbar bleiben.

Kern-Inhaltstypen (was Sie speichern)

Beginnen Sie mit einer kleinen Menge an Inhaltstypen, die zur Arbeitsweise der Teams passen:

- Experiment: der Hauptdatensatz (was getestet wurde und was passiert ist).

- Metrik: eine definierte Messgröße, die Sie in mehreren Experimenten wiederverwenden (z. B. Aktivierungsrate, Churn, Umsatz pro Nutzer).

- Insight: eine wiederverwendbare Erkenntnis, die länger lebt als ein einzelner Test (z. B. „weniger Reibung in Schritt 2 erhöht Completion").

- Decision: was Sie nach den Ergebnissen entschieden haben (ship, iterate, rollback, archive).

Diese Trennung verhindert, dass jedes Experiment neue Metriknamen erfindet oder Entscheidungen in Freitext vergräbt.

Minimale Felder für jeden Experiment-Eintrag

Machen Sie den „minimal brauchbaren Eintrag" leicht auszufüllen. Mindestens verlangen Sie:

- Titel (klar, spezifisch)

- Hypothese (was Sie erwarteten und warum)

- Owner (eine verantwortliche Person)

- Startdatum / Enddatum (oder geplante Daten)

- Status (aus einer Standardliste)

Optional — aber oft wertvoll — sind Zielgruppe, Traffic-Allokation, Testtyp (A/B, multivariat) und Links zu Tickets oder Designs.

Ergebnisfelder, die das Lernen erfassen

Ergebnisse sind der Bereich, in dem Logs oft auseinanderfallen; standardisieren Sie sie:

- Primärmetrik (aus Ihrer Metriken-Liste ausgewählt)

- Impact (Richtung + Größe; Einheiten angeben)

- Konfidenz-Notizen (einfache Erklärung zur Sicherheit, Einschränkungen, Datenqualität)

- Unterstützende Belege (Screenshots, Charts oder eine kurze Zusammenfassung dessen, was geprüft wurde)

Wenn Sie Anhänge erlauben, behalten Sie einen konsistenten Platz für Screenshots bei, damit Leser wissen, wo sie suchen müssen.

Beziehungen und Status

Modellieren Sie Beziehungen explizit, damit Entdeckung und Reporting später funktionieren:

- Experimente ↔ Metriken (Primär + Sekundärmetriken)

- Experimente ↔ Features/Bereiche (welcher Teil des Produkts geändert wurde)

- Experimente ↔ Owner/Teams (Verantwortlichkeit und Routing)

Standardisieren Sie Statuswerte, damit Sortierung und Dashboards sinnvoll bleiben: proposed, running, concluded, shipped, archived. Das verhindert, dass „done", „complete" und „finished" zu drei verschiedenen Zuständen werden.

Seitentemplates erstellen, die Experimente lesbar machen

Gute Templates verwandeln „Jemandes Notizen" in ein gemeinsames Protokoll, das das ganze Unternehmen scannen, vertrauen und wiederverwenden kann. Das Ziel ist Konsistenz, ohne Autoren das Gefühl zu geben, Formulare ausfüllen zu müssen.

Experiment-Detailseite: empfohlene Abschnitte (in Reihenfolge)

Beginnen Sie mit den Informationen, die ein Leser braucht, um zu entscheiden, ob er weiterliest.

- Zusammenfassung (TL;DR): ein Absatz: was geändert wurde, wer betroffen war und das Ergebnis.

- Status und Kerndaten: Status, Owner, Team, Start/Enddaten, Link zum PRD/Ticket (

/docs/...) und Primärmetrik.

- Hypothese: eine einzelne testbare Aussage (vermeiden Sie vage Ziele wie „Engagement verbessern").

- Design: Varianten, Targeting, Allocation, Guardrails und Dauerannahmen.

- Ergebnisse: Primärmetrik zuerst, dann Sekundär-/Guardrail-Metriken, mit einer Interpretation in einfacher Sprache.

- Entscheidung: ship/iterate/rollback plus was sich im Produkt geändert hat.

- Learnings und Follow-ups: was gelernt wurde, offene Fragen und nächste Experimente.

- Appendix: Screenshots, SQL-Snippets, Rohcharts und Links.

Listen-Seite: Schnellscan-Felder und Controls

Ihre Index-Seite sollte wie ein Dashboard funktionieren. Fügen Sie Filter für Status, Team, Tag, Datumsbereich und Plattform hinzu; Sortierung nach zuletzt aktualisiert, Startdatum und (wenn quantifizierbar) Impact; und Schnellscan-Felder wie Status, Owner, Start/Enddatum und ein einzeiliger Ergebnis-Satz.

Templates für Konsistenz zwischen Teams

Erstellen Sie ein Standard-Template plus optionale Varianten (z. B. „A/B-Test", „Pricing-Test", „Onboarding-Experiment"). Befüllen Sie Überschriften, Beispieltexte und Pflichtfelder vor, damit Autor:innen nicht auf einer leeren Seite beginnen.

Mobilfreundlich und lesbar für lange Notizen

Verwenden Sie ein Einspalten-Layout, großzügigen Zeilenabstand und klare Typografie. Platzieren Sie Schlüsselfakten in einem Sticky-Summary-Block (wo sinnvoll) und machen Sie Tabellen horizontal scrollbar, damit Ergebnisse auf Handys lesbar bleiben.

Tagging und Taxonomie für schnelle Auffindbarkeit einrichten

Schnell eine interne Seite bereitstellen

Hoste dein Experiment-Log mit integrierter Bereitstellung, damit das Team sofort loslegen kann.

Ein Produkt-Experimentprotokoll ist nur nützlich, wenn Leute schnell relevante Erkenntnisse finden können. Tagging und Taxonomie verwandeln einen Haufen Experimentseiten in etwas, das Sie durchsuchen, filtern und wiederverwenden können.

Mit einer kleinen, vorhersehbaren Tagging-Strategie beginnen

Definieren Sie eine Handvoll Tag-Gruppen, die widerspiegeln, wie Ihr Team natürlich sucht. Eine praktische Basis ist:

- Produktbereich (z. B. Onboarding, Checkout, Notifications)

- Hypothesentyp (z. B. Friction reduction, Pricing sensitivity, Trust signal)

- Primärmetrik (z. B. Activation rate, Conversion rate, Retention)

- Segment (z. B. New users, SMB, Mobile-only)

Begrenzen Sie die Anzahl der Gruppen. Zu viele Dimensionen machen das Filtern verwirrend und fördern inkonsistentes Tagging.

Tag-Sprawl mit Namensregeln verhindern

Unkontrollierte Tags werden schnell zu „signup", „sign-up" und „registration" gleichzeitig. Erstellen Sie ein kontrolliertes Vokabular:

- Wählen Sie ein Format (Singular vs. Plural, Groß-/Kleinschreibung, Verwendung von Akronymen).

- Definieren Sie, wer neue Tags erstellen darf und wie sie genehmigt werden.

- Fügen Sie kurze Beschreibungen für mehrdeutige Tags hinzu (was sie bedeuten, wann verwendet werden).

Ein einfacher Ansatz ist eine „Tag-Registry"-Seite, die das Team pflegt (z. B. /experiment-tags) plus eine leichte Review während des Experiment-Ausfüllens.

Strukturierte Felder für das, was kein Freitext sein sollte

Tags sind gut für Discovery, aber einige Attribute sollten strukturierte Felder sein, um konsistent zu bleiben:

- Status (Proposed, Running, Shipped, Stopped)

- Team/Owner (aus einer Liste wählen)

- Experimenttyp (A/B, multivariat, Holdout)

Strukturierte Felder ermöglichen verlässliche Filter und Dashboards, während Tags Nuancen erfassen.

Cross-Links unterstützen: verwandte und ähnliche Experimente

Helfen Sie Lesern, zwischen verbundenen Arbeiten zu springen. Fügen Sie Abschnitte wie Verwandte Experimente (derselbe Feature- oder Metrik-Kontext) und Ähnliche Hypothesen (gleiche Annahme an anderer Stelle getestet) hinzu. Das kann zunächst manuell erfolgen und später automatisiert werden (Vorschläge basierend auf gemeinsamen Tags).

Zwischen CMS und Custom-App entscheiden

Diese Entscheidung setzt die Grenze dafür, wozu Ihr Experimentprotokoll werden kann. Ein CMS bringt Sie schnell zum Publizieren, während eine Custom-App das Log in ein eng integriertes Entscheidungssystem verwandeln kann.

Wann ein CMS ausreicht

Ein CMS passt, wenn Ihr Hauptbedarf konsistente, lesbare A/B-Test-Dokumentation mit leichter Struktur ist.

Verwenden Sie ein CMS, wenn Sie möchten:

- Einfaches Publizieren: Einträge wie Artikel erstellen, bearbeiten, prüfen und veröffentlichen

- Ein vertrautes Editor-Erlebnis für PMs, Designer und Marketer

- Eingebaute Berechtigungen (wer Entwürfe erstellt vs. wer prüft vs. wer veröffentlicht)

- Grundlegendes Tagging und Kategorien ohne komplexe Regeln

Typisches Muster: ein Headless-CMS (Inhalt im CMS, präsentiert von Ihrer Seite) kombiniert mit einem Static-Site-Generator. Das hält das Repository schnell, einfach zu hosten und freundlich für nicht-technische Beitragende.

Wann ein Custom-Build passt

Eine kundenspezifische Experiment-Tracking-App macht Sinn, wenn das Log direkt mit Produktdaten und internen Tools verbunden sein muss.

Erwägen Sie eine Custom-App, wenn Sie brauchen:

- Tiefe Integrationen (Feature Flags, Analytics-Tools, Data Warehouse, Ticketing)

- Erweiterte Suche und Filter (gespeicherte Ansichten nach Team, Metrik, Plattform, Konfidenzniveau)

- Workflow-Regeln (Pflichtfelder, Freigaben durch Area-Owner, automatische Statusänderungen)

- Automatisierte Metrik- und Ergebnisberichte (Ergebnisse ziehen statt Screenshots kopieren)

Wenn Sie das schnell prototypen wollen, kann eine vibe-coding-Plattform wie Koder.ai eine praktische Abkürzung sein: Sie können das Datenmodell (Experimente, Metriken, Entscheidungen), Seitentemplates und Workflows im Chat beschreiben und dann an einem funktionierenden React + Go + PostgreSQL App iterieren, inklusive Deployment/Hosting, Source-Export und Snapshots/Rollback für sichere Änderungen.

Ihre „Quelle der Wahrheit" definieren

Seien Sie explizit, wo Experimentiendaten leben:

- Wenn das CMS die Quelle der Wahrheit ist, sollten Ihre Analytics-Links und Ergebniszusammenfassungen auf den CMS-Eintrag verweisen.

- Wenn die Datenbank/App die Quelle der Wahrheit ist, sollte die Website eine Ansicht über strukturierte Datensätze sein, mit narrativem Kommentar optional in einem CMS.

Schreiben Sie das früh auf — sonst entstehen Duplikate in Docs, Tabellen und Tools und das Log verliert Vertrauen.

Tech-Stack und Hosting-Ansatz wählen

CMS oder individuell wählen

Prototyp: CMS-artiges Log versus individuelle App – wähle, was zu deinem Team passt.

Ihr Experimentprotokoll braucht keine exotische Technologie. Der beste Stack ist der, den Ihr Team sicher betreiben, absichern und ohne Reibung weiterentwickeln kann.

Static Site vs. Server-Rendered vs. Single-Page-App

Eine statische Seite (vorgebaute Seiten) ist oft die einfachste Wahl: schnell, günstig zu hosten und wartungsarm. Gut, wenn Einträge meist read-only sind und Updates über ein CMS oder Pull Requests erfolgen.

Eine server-gerenderte App passt, wenn Sie stärkere Zugriffskontrolle, dynamische Filter oder Team-spezifische Ansichten ohne komplexe Client-Logik brauchen. Hier lassen sich Berechtigungen leichter serverseitig erzwingen.

Eine Single-Page-App (SPA) wirkt sehr reaktiv für Filter und Dashboards, bringt aber Komplexität bei SEO, Auth und initialer Ladezeit. Wählen Sie sie nur, wenn Sie wirklich app-ähnliche Interaktionen brauchen.

Wenn Sie eine Custom-App bauen, entscheiden Sie außerdem, ob Sie eine konventionelle Build-Pipeline oder einen beschleunigten Ansatz möchten. Zum Beispiel kann Koder.ai die Kern-Scaffolding (React UI, Go API, PostgreSQL-Schema) aus einer Spezifikation generieren — hilfreich beim iterativen Ausarbeiten von Templates und Workflows mit mehreren Stakeholdern.

Hosting-Grundlagen, die Überraschungen verhindern

Priorisieren Sie Zuverlässigkeit (Uptime, Monitoring, Alerts) und Backups (automatisiert, getestete Wiederherstellungen). Halten Sie Umgebungs-Trennung: mindestens ein Staging, um Taxonomie-Änderungen, Template-Updates und Berechtigungsregeln vor Prod zu testen.

Authentifizierung und private Bereiche

Die meisten Teams benötigen irgendwann SSO (Okta, Google Workspace, Azure AD) sowie Rollen (Viewer, Editor, Admin) und private Bereiche für sensible Erkenntnisse (Umsatz, Nutzerdaten, rechtliche Hinweise). Planen Sie das früh, damit Sie später nicht umgestalten müssen.

Nutzen Sie Caching (CDN, Browser-Caching), halten Sie Seiten leichtgewichtig und optimieren Sie Medien (komprimierte Bilder, Lazy-Loading wo sinnvoll). Schnelle Seitenladezeiten sind wichtig — Nutzer werden ein Log, das sich langsam anfühlt, nicht regelmäßig nutzen.

Suche, Filter und gespeicherte Ansichten implementieren

Ein Produkt-Experimentprotokoll wird wirklich nützlich, wenn Leute „diesen einen Test" in Sekunden finden — ohne den genauen Titel zu kennen.

On-site Search vs. externer Suchdienst

On-site Search (im CMS oder App-DB) reicht oft, wenn Sie ein paar hundert Experimente, ein kleines Team und einfache Bedürfnisse haben (Suche in Titeln, Zusammenfassungen und Tags). Es ist leichter zu warten und vermeidet zusätzlichen Vendor-Aufwand.

Ein externer Suchdienst (z. B. Algolia/Elastic/OpenSearch) lohnt sich bei tausenden Einträgen, wenn Sie blitzschnelle Ergebnisse, Tippfehler-Toleranz und Synonyme brauchen (z. B. „checkout" = „purchase") oder avanciertes Ranking wollen. Externe Suche hilft auch, wenn Inhalte aus mehreren Quellen zusammenfließen (Docs + Log + Wiki).

Unverzichtbare Filter, die Arbeitsweise abbilden

Suche allein reicht nicht. Fügen Sie Filter hinzu, die reale Entscheidungsfragen abbilden:

- Status: proposed, running, paused, concluded, shipped, invalidated

- Datumsbereich: Start, Ende und zuletzt aktualisiert

- Owner und Team: wer schnell Antworten geben kann

- Tags: Feature-Bereich, Audience-Segment, Hypothesentyp

- Primärmetrik (und optional Guardrails): hilft, ähnliche Experimente zu vergleichen

Ermöglichen Sie kombinierbare Filter (z. B. „Concluded + Letzte 90 Tage + Growth Team + Activation Metrik").

Gespeicherte Ansichten, die Leute tatsächlich nutzen

Gespeicherte Ansichten verwandeln wiederkehrende Fragen in Ein-Klick-Antworten:

- Running now (Status = running)

- High impact (Lift über Schwelle oder Entscheidung = ship)

- Recently concluded (ended in last 30 days)

Erlauben Sie Teams, geteilte Views in der Navigation zu pinnen, und individuellen Nutzer:innen, eigene Views zu speichern.

Ergebnisse in der Listenansicht scannbar machen

Zeigen Sie in Suchergebnissen einen kurzen Snippet: Hypothese, Variante, Zielgruppe und die Headline-Ergebnis. Heben Sie gefundene Schlüsselwörter im Titel und der Zusammenfassung hervor und zeigen Sie ein paar Schlüssel-Felder (Status, Owner, Primärmetrik), damit Nutzer entscheiden können, ohne fünf Seiten zu öffnen.

Workflow, Ownership und Governance definieren

Ein großartiges Experiment-Tracking-Portal sind nicht nur Seiten und Tags — es ist ein geteilter Prozess. Klare Verantwortlichkeiten und ein leichter Workflow verhindern halbfertige Einträge, fehlende Ergebnisse und „mystery decisions" Monate später.

Rollen und Berechtigungen

Beginnen Sie damit, zu entscheiden, wer erstellen, bearbeiten, prüfen und veröffentlichen darf. Ein einfaches Modell funktioniert für die meisten Teams:

- Autoren (PMs, Analysten, Designer): Entwürfe erstellen und Ergebnisse aktualisieren

- Reviewer (Data/Analytics, Research, Engineering): Metriken, Instrumentierung und Interpretation verifizieren

- Approver (Produktlead oder Experimentation Council): Entscheidung und Rollout-Plan bestätigen

- Publisher (optional): finale Prüfung auf Formatierung und Redaktionen

Halten Sie Berechtigungen konsistent mit Ihren Zugriffsentscheidungen (intern vs. öffentlich vs. eingeschränkt). Wenn Sie private Experimente unterstützen, verlangen Sie einen expliziten Owner pro Eintrag.

Redaktionelle Checkliste (was „done" bedeutet)

Definieren Sie eine kurze Checkliste, die jedes Experiment vor der Veröffentlichung erfüllen muss:

- Hypothese ist spezifisch und falsifizierbar (was ändert sich, für wen, erwartete Richtung)

- Primärmetrik ist definiert (exakter Name, Quelle, Berechnungsfenster)

- Guardrails sind gelistet (z. B. Umsatz, Fehlerquote, Support-Tickets)

- Rollout-Entscheidung ist dokumentiert (ship, iterate, stop) mit Begründung

Diese Checkliste kann ein Pflichtteil Ihrer Experiment-Templates sein.

Versionsverlauf und Änderungsnotizen

Behandeln Sie Einträge wie lebende Dokumente. Aktivieren Sie Versionsverlauf und verlangen Sie kurze Änderungsnotizen für wesentliche Aktualisierungen (Metrikfix, Analysekorrektur, Entscheidungsumkehr). Das erhöht Vertrauen und erleichtert Audits.

Entscheiden Sie im Voraus, wie sensible Infos gespeichert werden:

- Redaktionen für Kundennamen, Partnerkonditionen oder Sicherheitsdetails

- Private Notizen nur für eine eingeschränkte Gruppe sichtbar

- Getrennte Seiten: öffentliche Zusammenfassung plus eingeschränkte „Analyse & Daten"-Seite

Governance muss nicht schwerfällig sein — sie muss nur explizit sein.

Analytics und datenschutzfreundliche Messung hinzufügen

Gib dem Log ein richtiges Zuhause

Schaffe ein sauberes Zuhause für dein Experiment-Repository mit einer eigenen Domain.

Ein Experiment-Tracking-Portal ist nur nützlich, wenn Leute finden, vertrauen und wiederverwenden, was drinsteht. Leichte Analytics zeigen, wo das Log funktioniert — und wo es leise versagt — ohne die Seite zur Überwachungsplattform zu machen.

Nutzung tracken, ohne zu viel zu sammeln

Starten Sie mit ein paar praktischen Signalen:

- Top-Suchen und Zero-Result-Suchen: wenn Leute wiederholt nach „pricing test" suchen und nichts finden, müssen Taxonomie oder Benennung verbessert werden.

- Meist angesehene Experimente und meist besuchte Tags: zeigen, worauf Teams Wert legen und welche Bereiche bessere Templates brauchen.

- Broken Links und 404s: Experiment-Logs referenzieren oft Specs, Dashboards oder Tickets; kaputte Links untergraben Vertrauen schnell.

Wenn Ihr Analytics-Tool es erlaubt, deaktivieren Sie IP-Logging und vermeiden Sie Nutzer-IDs. Bevorzugen Sie aggregierte, seitenbezogene Berichte.

Content-Health messen (Qualität, nicht Klicks)

Nutzungsmetriken allein sagen nicht, ob Einträge vollständig sind. Fügen Sie „Content-Health"-Checks hinzu, die das Repository überwachen:

- Fehlende Pflichtfelder (z. B. Hypothese, Primärmetrik, Entscheidung, Owner)

- Stale-Status (z. B. Running seit 90+ Tagen)

- Veraltete Outcomes (z. B. TBD nach einem Entscheidungstermin)

Das kann so einfach sein wie ein wöchentliches Report-Script gegen Ihr CMS/DB, das Einträge markiert. Ziel ist, Lücken sichtbar zu machen, damit Owner sie beheben.

Datenschutz-Grundlagen für Experiment-Einträge

Experimentbeschreibungen sollten fast nie personenbezogene Daten enthalten. Vermeiden Sie:

- Namen, E-Mails, User-IDs, Session-Replays, rohe Event-Logs

- Screenshots mit persönlichen Daten

Verlinken Sie zu aggregierten Dashboards statt Rohdaten einzubetten und speichern Sie sensible Analysen in genehmigten Systemen.

Eine klare Interpretations-Erklärung hinzufügen

A/B-Testergebnisse sind leicht aus dem Kontext heraus falsch zu lesen. Fügen Sie eine kurze Disclaimer-Notiz in Ihr Experiment-Template (und/oder Footer) ein, die besagt, dass:

- Ergebnisse von Population, Zeitrahmen und Instrumentierung abhängen

- Konfidenz-/Signifikanz-Schwellen je nach Team variieren

- Entscheidungen sich auf die dokumentierte Primärmetrik und Guardrails beziehen sollten

Das hält das Log ehrlich und reduziert fehlerhafte Übernahmen vergangener Ergebnisse.

Launch, Migration und laufende Wartung vorbereiten

Ein großartiges Experimentprotokoll ist nicht „fertig", wenn die Seite live geht. Der echte Wert zeigt sich, wenn Teams ihr vertrauen, es aktuell halten und Erkenntnisse auch in sechs Monaten noch finden können.

Bestehende Experimente migrieren (ohne Chaos)

Die meisten Teams starten mit Tabellen, Slides oder verstreuten Docs. Wählen Sie ein kleines Pilot-Set (z. B. Experimente des letzten Quartals) und mappen Sie jedes Quellfeld auf Ihr neues Template.

Wenn möglich, importieren Sie in Bulk: Tabellen als CSV exportieren und per Script oder CMS-Importer Einträge anlegen. Bei Dokumenten migrieren Sie zuerst Kerndaten (Ziel, Änderung, Ergebnisse, Entscheidung) und verlinken die Originaldatei für Detailbelege.

Qualitätscheck vor dem Launch

Führen Sie einen Konsistenz-Check durch, nicht Perfektion. Häufige Probleme:

- Duplikate oder beinahe identische Tags (z. B. onboarding vs. on-boarding)

- Fehlende Owner (jedes Experiment braucht eine namentliche Person, nicht nur „Team") und fehlende Daten

- Inkonsistente Statuswerte und unklare Outcomes

Das ist auch ein guter Moment, erforderliche Felder für als abgeschlossen markierte Einträge festzulegen.

Launch-Checkliste

Vor der Ankündigung verifizieren Sie:

- Berechtigungen: wer kann sehen, wer kann editieren, wer kann veröffentlichen

- Suchindexierung: Haupt-Experimente und Tags müssen auffindbar sein

- Redirects: ersetzen Sie ein altes Wiki, richten Sie Redirects ein, um Links zu erhalten

- Backups: automatisierte Backups und ein Restore-Test (auch ein einfacher) bestätigen

Post-Launch-Wartungsrhythmus

Setzen Sie eine leichte Routine: monatliche Bereinigung (stale Drafts, fehlende Ergebnisse) und vierteljährliche Taxonomie-Review (Tags zusammenführen, neue Kategorien bedacht hinzufügen).

Optionale nächste Schritte

Sobald die Grundlagen stabil sind, denken Sie an Integrationen: automatische Verknüpfungen zu Issue-Trackern oder Analytics-Kontext, damit jeder Eintrag zum genauen Dashboard verlinkt, das für Ergebnisberichte genutzt wurde.

Wenn Sie zu einer Custom-App weiterentwickeln, können Sie erst in einem „Planungsmodus" iterieren — Workflows, Pflichtfelder und Freigaberegeln schriftlich festhalten und dann implementieren. Plattformen wie Koder.ai unterstützen diesen iterativen Build-and-Refine-Zyklus (inkl. Deploys, Snapshots und Rollback), sodass Ihr Log reifen kann, ohne eine schwere Neuentwicklung.