Eine kurze Landkarte der JavaScript-Übernahme

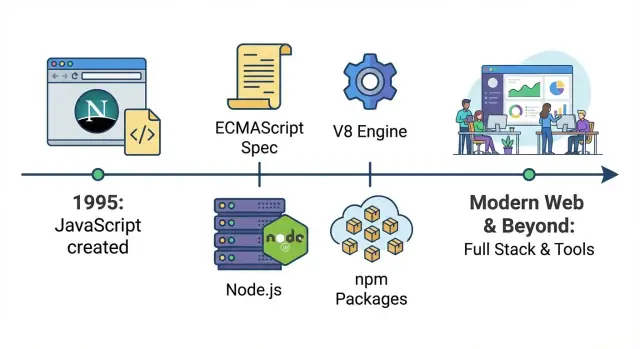

JavaScript begann als Mittel, um Webseiten etwas Interaktivität zu geben — kleine Skripte, die ein Formular validierten, ein Bild tauschten oder ein Dropdown zeigten. Dieser Leitfaden verfolgt, wie diese „kleine Hilfssprache“ zur unternehmensweiten Plattform wurde: dieselbe Kerntechnologie läuft heute in Benutzeroberflächen, Servern, Build-Systemen, Automatisierung und internen Tools.

Was „Standardsprache des Webs“ praktisch bedeutet

In praktisch-technischen Begriffen ist JavaScript die eine Sprache, die jeder Mainstream-Browser direkt ausführen kann. Wenn du Code an Benutzer verschickst, ohne dass sie etwas installieren müssen, ist JavaScript die universelle Option. Andere Sprachen können mitmischen — meist indem sie nach JavaScript kompiliert werden oder auf einem Server laufen — während JavaScript standardmäßig direkt am Ziel ausgeführt wird.

Die drei Epochen, die du sehen wirst

Erstens die Browser-Ära, in der JavaScript zum Standard wurde, um die Seite zu steuern: auf Klicks zu reagieren, das DOM zu manipulieren und schließlich reichhaltigere Erlebnisse zu ermöglichen, als das Web über statische Dokumente hinausging.

Zweitens die Backend-Ära, in der schnellere Engines und Node.js es praktikabel machten, JavaScript auf Servern auszuführen. Das öffnete eine gemeinsame Sprache für Frontend und Backend sowie ein Paket-Ökosystem, das Wiederverwendung beschleunigte.

Drittens die Business-Operations-Ära, in der JavaScript-Tooling zur „Klebe“-Technologie wurde: Build-Pipelines, Tests, Designsysteme, Dashboards, Automatisierungsskripte und Integrationen. Selbst Teams, die sich nicht als „JavaScript-Teams“ sehen, verlassen sich oft täglich auf JS-basierte Tools.

Was du von diesem Leitfaden erwarten kannst

Wir konzentrieren uns auf große Wendepunkte — Standardisierung, Performance-Sprünge, Node.js, npm und der Wechsel zu framework-getriebenen Apps — anstatt jede Bibliothek oder jeden Trend aufzuzählen.

Der Ursprung: Scripting im Browser

JavaScript wurde 1995 bei Netscape als einfache Möglichkeit geschaffen, Webseiten interaktiver zu machen, ohne einen Server-Roundtrip oder eine vollständige „Software-Installation“ zu benötigen. Brendan Eich baute die erste Version schnell; das ursprüngliche Ziel war bescheiden: Webautoren Formularfelder validieren, auf Button-Klicks reagieren und Seiten weniger statisch wirken lassen.

Ein Web aus kleinen Seiten und langsamen Maschinen

Frühe Beschränkungen des Webs formten, was JavaScript sein konnte. Computer waren langsamer, Browser rudimentär und die meisten Sites überwiegend Text mit ein paar Bildern. Skripte mussten leichtgewichtig und fehlertolerant sein — kleine Ausschnitte, die laufen konnten, ohne die Seite einzufrieren.

Weil Seiten einfach waren, sah frühes JavaScript oft aus wie „ein bisschen Logik“, die ins HTML gestreut war: prüfen, ob ein E‑Mail-Feld ein @ enthält, ein Alert zeigen oder ein Bild beim Hover über einen Link austauschen.

„Code in der Seite schreiben“ war ein großer Wandel

Davor zeigte eine Webseite hauptsächlich nur Inhalte. Mit JavaScript direkt in der Seite konnte sie sofort auf Nutzeraktionen reagieren. Selbst ein winziges Skript konnte:

- Eine Formularübermittlung stoppen, bis Pflichtfelder ausgefüllt sind

- Text auf der Seite nach einem Klick aktualisieren

- Kleine Berechnungen durchführen, ohne einen Server zu kontaktieren

Es war der Beginn, dass der Browser zum Anwendungs-Laufzeitraum wurde — nicht nur ein Dokumentenbetrachter.

Die frühen Schmerzen: inkonsistentes Verhalten

Der Nachteil war Unvorhersehbarkeit. Browser interpretierten JavaScript nicht immer gleich und APIs zur Interaktion mit der Seite (frühes DOM-Verhalten, Event-Modelle und Elementmethoden) variierten stark. Entwickler mussten unterschiedliche Codepfade schreiben, je nach Browser testen und akzeptieren, dass etwas auf einer Maschine funktionieren und auf einer anderen brechen konnte.

Browser-Wettbewerb und der Drang zu Standardisierung (ECMAScript)

Die „Browser-Kriege“ in einfachen Worten

Ende der 1990er und Anfang der 2000er Jahre lieferten Browser im Wettbewerb schnell neue Features aus. Netscape und Internet Explorer lieferten sich ein Wettrennen — nicht nur um Geschwindigkeit, sondern auch um JavaScript-Verhalten, DOM-APIs und proprietäre Erweiterungen.

Für Entwickler bedeutete das, dass dasselbe Skript in einem Browser funktionierte und im anderen nicht. Bugs traten auf, die nicht „dein Fehler“ waren: unterschiedliche Event-Modelle, fehlende Methoden und inkonsistente Edge-Cases. Eine Website auszuliefern bedeutete oft, zwei Versionen derselben Logik zu schreiben und Browser-Erkennungs-Hacks einzubauen.

ECMAScript: der Vertrag hinter JavaScript

Um das Chaos zu verringern, brauchte JavaScript eine gemeinsame Definition, die nicht von einem einzelnen Browser-Anbieter kontrolliert wurde. Diese Definition wurde ECMAScript — der Standard, der die Kernsprache beschreibt (Syntax, Typen, Funktionen, Objekte usw.).

Nützliches Modell:

- JavaScript ist das, was Browser (und später Server) ausführen.

- ECMAScript ist das Regelwerk, dem JavaScript-Engines folgen sollen.

Wie Standardisierung half (langsam)

Als Anbieter sich auf ECMAScript-Versionen einigten, wurde die Sprache über Browser hinweg vorhersehbarer. Inkompatibilitäten verschwanden nicht über Nacht — APIs außerhalb des Sprachkerns (wie Teile des DOM) variierten weiter — aber das Fundament stabilisierte sich. Mit der Zeit machten bessere Test-Suites und gemeinsame Erwartungen „funktioniert in meinem Browser“ weniger akzeptabel.

Warum alte Muster nie ganz verschwanden

Während ECMAScript sich weiterentwickelte, wurde Abwärtskompatibilität zur unverhandelbaren Zusage: alte Sites sollten weiterlaufen. Deshalb blieben Legacy-Muster — var, merkwürdige Gleichheitsregeln und Workarounds vor Modulen — im Ökosystem. Das Web konnte sich keinen harten Neuanfang leisten, also wuchs JavaScript durch Hinzufügen neuer Features statt durch Entfernen alter.

Ajax und der Aufstieg echter Webanwendungen

Vor Ajax verhielten sich die meisten Websites wie Papierformulare: Klick oder Formularabsendung → Browser lädt die ganze Seite neu → warten auf den Server, der HTML zurücksendet.

Ajax (Asynchronous JavaScript and XML, wobei JSON schnell die eigentliche Hauptrolle übernahm) änderte dieses Muster. Mit JavaScript konnte eine Seite Daten im Hintergrund vom Server anfordern und nur den Teil aktualisieren, der sich ändern musste — kein vollständiges Neuladen.

Teile einer Seite aktualisieren, ohne neu zu laden

Ajax ließ das Web eher wie ein interaktives Programm erscheinen. Eine Suchbox konnte Vorschläge beim Tippen zeigen. Ein Warenkorb konnte den Gesamtpreis sofort aktualisieren. Kommentare konnten erscheinen, nachdem du sie abgeschickt hattest, ohne dass die Seite komplett neu geladen wurde.

Das war nicht nur eine schönere Oberfläche — es verringerte Reibung. Nutzer ertrugen nicht länger für jede kleine Aktion „Klick → warten → Neuladen“.

Gmail-ähnliche Erlebnisse setzten neue Erwartungen

Produkte wie Gmail zeigten, dass der Browser App-ähnliche Interaktionen bewältigen kann: schnelle Postfach-Aktualisierungen, sofortiges Labeln, flüssige Navigation und weniger Unterbrechungen. Wenn Nutzer diese Reaktionsschnelligkeit einmal erlebt hatten, wurde sie zum erwarteten Standard für andere Seiten.

APIs + JSON machten den Browser zum ernsthaften Client

Ajax drängte Teams, „Daten“ von „Seite“ zu trennen. Statt bei jeder Interaktion eine komplette HTML-Seite zu senden, stellten Server zunehmend APIs bereit, die strukturierte Daten (meist JSON) zurückgaben. Der Browser — angetrieben von JavaScript — wurde ein echter Client, der Rendering, Interaktionen und Zustand verantwortet.

Der Kompromiss: mehr Logik wanderte ins Frontend

Der Nachteil war Komplexität. Mehr Anwendungslogik verlagert in den Browser: Validierung, UI-Zustand, Caching, Fehlerbehandlung und Performance-Sorgen. Das bereitete den Boden für schwereres Frontend-Tooling und schließlich komplette Single-Page-Applications, in denen der Server primär APIs liefert und das Frontend wie eine echte App agiert.

jQuery, das DOM und JavaScript zugänglich machen

Frühes JavaScript war nicht schwer, weil die Sprache unmöglich wäre — es war die Browserumgebung, die chaotisch war. DOM-Scripting bedeutete, mit unterschiedlichen Event-Modellen, inkonsistenten Element-APIs und Layout-Quirks zu jonglieren, die vom Browser des Nutzers abhingen. Selbst einfache Aufgaben wie „dieses Element finden und es ausblenden, wenn ein Button angeklickt wird“ konnten in einen Haufen Bedingungen und browser-spezifischer Workarounds ausarten.

Warum DOM-Scripting früher schmerzhaft war

Entwickler verbrachten viel Zeit damit, Kompatibilität zu bekämpfen statt Features zu bauen. Elemente auszuwählen unterschied sich je nach Browser, Events anzuhängen war nicht konsistent, und Styles zu manipulieren konnte unerwartet reagieren. Viele Teams vermieden schweren Client-Side-Code oder griffen zu Nicht-JS-Lösungen wie Flash für reichhaltigere Erlebnisse.

Wie jQuery alles einfacher wirken ließ

jQuerys großer Trick war simpel: eine kleine, lesbare API anbieten und browserübergreifende Unterschiede verstecken. Eine einheitliche Selektor-Syntax funktionierte fast überall, Event-Handling wurde vorhersehbar und gängige UI-Effekte waren mit einem Funktionsaufruf erreichbar. Statt zehn browser-spezifische Regeln zu lernen, lernte man „den jQuery-Weg“ und lieferte schnell Ergebnisse.

Diese Einfachheit wirkte kulturell: JavaScript wurde die erste Sprache, die viele Webentwickler lernten, weil sie der Weg zu sichtbarem, interaktivem Fortschritt war. Tutorials, Snippets und Plugins verbreiteten sich schnell; man konnte ein paar Zeilen kopieren und etwas Modernes ausliefern.

Als die Plugin-Ära verblasste, gewann JavaScript automatisch

Mit der Verbesserung der Browser und der abnehmenden Akzeptanz von Plugins (Sicherheitsprobleme, fehlende Mobilunterstützung und Performance-Probleme) wählten Teams zunehmend native Web-Technologien. jQuery half, diesen Übergang zu überbrücken: es senkte die Barriere für DOM-Programmierung, und als die Plattform reif wurde, kannte eine Generation bereits genug JavaScript, um die nächste Welle zu bauen.

Kosten senken mit verdienten Credits

Erhalte Credits, indem du Inhalte über Koder.ai erstellst oder andere Nutzer empfiehlst.

Jahrelang war JavaScripts größte Einschränkung nicht Syntax oder Features, sondern Geschwindigkeit. Frühe Seiten konnten langsame Ausführung tolerieren, weil Skripte klein waren: ein Formular validieren, ein Menü umschalten, etwas Interaktivität. Als Entwickler begannen, ganze Anwendungen im Browser zu bauen, wurde Performance zur Obergrenze.

Was V8 ist (und warum es wichtig war)

V8 ist Googles JavaScript-Engine, entwickelt für Chrome. Eine Engine liest JavaScript und führt es aus. V8s Durchbruch war, JavaScript weniger wie eine langsame interpretierte Skriptsprache zu behandeln und mehr wie Code, der zur Laufzeit aggressiv optimiert werden kann.

Kurz gesagt: V8 wurde deutlich besser darin, JavaScript schnell in Maschineninstruktionen zu übersetzen und heiße Codepfade beim Lernen neu zu optimieren. Das verringerte Verzögerungen, machte Animationen flüssiger und verkürzte die Zeit zwischen Nutzerklick und sichtbarer Reaktion.

Schnellere Ausführung ermöglichte größere Apps und reichhaltigere UIs

Als JavaScript schneller wurde, konnten Teams mehr Logik in den Browser verlagern, ohne dass die Nutzererfahrung zerbrach. Das veränderte, was noch „vernünftig“ erschien zu bauen:

- Komplexe Oberflächen (Inboxes, Dashboards, Editoren), die sich wie Desktop-Software verhielten

- Umfangreiche DOM-Updates, ohne die Seite einfrieren zu lassen

- Mehr Client-seitige Berechnung (Filtern, Sortieren, Rendering) statt Roundtrips zum Server

Performance machte nicht nur bestehende Sites schöner — sie erweiterte die Kategorie der Software, die das Web hosten konnte.

Die Rückkopplungsschleife, die alles beschleunigte

Eine wichtige Dynamik setzte ein:

Schnellere Engines → Entwickler schrieben mehr JavaScript → Nutzer verbrachten mehr Zeit in JS-lastigen Apps → Browser investierten noch mehr in Engines.

Im Konkurrenzkampf um Marktanteile wurde Geschwindigkeit zum Schlagwort. Reale Web-Apps fungierten als Benchmarks, und jede Verbesserung ermutigte Entwickler, weiter zu gehen.

Kontext: es war nicht nur V8

V8 war nicht allein. Mozillas SpiderMonkey (Firefox) und Apples JavaScriptCore (Safari) verbesserten sich ebenfalls rasant, jeweils mit eigenen Optimierungsstrategien. Wichtig ist nicht, welche Engine „gewann“ — sondern dass der Wettbewerb schnelle JavaScript-Ausführung zum Standard machte.

Sobald JavaScript schnell genug lief, um anspruchsvolle Oberflächen zuverlässig zu betreiben, hörte es auf, „nur eine Browser-Skriptsprache“ zu sein, und begann, wie eine Plattform auszusehen, auf die Teams setzen konnten.

Node.js: JavaScript zieht ins Backend

Node.js ist eine Laufzeit, die JavaScript außerhalb des Browsers ausführt. Anstatt JavaScript nur für Buttons, Formulare und Seiteninteraktionen zu schreiben, konnten Entwickler dieselbe Sprache nutzen, um Server, Kommandozeilen-Tools und Hintergrundjobs zu bauen.

Warum die Event-Loop-Architektur zu Servern passt

Node.js baut auf einer Event-Loop-Architektur auf: eine Art, viele wartende Vorgänge — Netzwerkanfragen, DB-Abfragen, Dateizugriffe — zu handhaben, ohne für jede Verbindung einen eigenen Thread zu starten.

Bei vielen Web-Workloads wartet der Server mehr, als er rechnet. Das Event-Loop-Modell machte es praktikabel, viele konkurrierende Anwender mit vergleichsweise einfachem Code zu bedienen, besonders für Apps, die „live“ wirken und häufige Updates brauchen.

Frühe Anwendungsfälle, die das Konzept bewiesen

Node.js gewann zuerst in Bereichen an Traktion, in denen Reaktionsfähigkeit zählte:

- Echtzeit-Chat- und Kollaborations-Apps (kontinuierlicher Nachrichten- und Updatefluss)

- Leichte APIs, die Frontend und Datenbank verbinden

- Developer-Tooling (Build-Skripte, lokale Server, Automatisierung), das von JavaScript überall profitierte

Auch wenn Teams Kernsysteme in anderen Sprachen betrieben, wurde Node.js oft zur Glue-Schicht: Bearbeitung von Anfragen, Orchestrierung von Systemaufrufen oder Betreiben interner Utilities.

Eine Sprache von Ende zu Ende

Der Wandel war so sehr kulturell wie technisch. Wenn Frontend und Backend beide JavaScript nutzen, können Teams Validierungsregeln, Datenmodelle und Teile der Business-Logik teilen. Entwickler müssen weniger zwischen Ökosystemen wechseln, was kleinen Teams hilft, schneller zu arbeiten, und großen Teams hilft, einheitliche Praktiken für Aufbau und Review von Code zu etablieren.

npm und das Ökosystem, das JavaScripts Reichweite skalierte

Prototyp in Stunden, nicht Wochen

Schnell einen klickbaren Prototypen erhalten und dann Screens und Verhalten per Chat verfeinern.

npm (Node Package Manager) ist der "App-Store" für JavaScript-Code. Anstatt alles neu zu schreiben — Datumsfunktionen, Routing, Testing, UI-Widgets — konnte ein Team ein Paket installieren und weitermachen. Dieser Workflow ("installieren, importieren, ausliefern") beschleunigte die Entwicklung und machte JavaScript größer als eine Sprache: ein gemeinsamer Werkzeugkasten.

Warum das Teilen von Paketen die Adoption beschleunigte

Nachdem Node.js JavaScript außerhalb des Browsers nützlich machte, gab npm Entwicklern eine Standardmöglichkeit, Module zu veröffentlichen und wiederzuverwenden. Eine kleine Bibliothek für ein Projekt konnte plötzlich Tausenden helfen. Das Ergebnis war kompoundierter Fortschritt: Jedes neue Paket machte das nächste Projekt schneller.

Open-Source-Bibliotheken senkten außerdem die Kosten für Experimente. Ein Startup konnte mit wenigen Leuten ein glaubwürdiges Produkt zusammensetzen, indem es Community-gepflegte Pakete für Logging, Auth-Hilfen, Build-Tools usw. nutzte.

Semver und Lockfiles (ohne Fachchinesisch)

Die meisten npm-Pakete folgen semantic versioning (semver), einer drei-teiligen Versionsnummer wie 2.4.1:

- Major (

2) kann inkompatible Änderungen beinhalten.

- Minor (

4) fügt in kompatibler Weise Features hinzu.

- Patch (

1) behebt Bugs.

Lockfiles (z. B. package-lock.json) zeichnen die exakt installierten Versionen auf, sodass jeder im Team — und der CI-Server — dasselbe Abhängigkeits-Set erhält. Das verhindert Überraschungen vom Typ „auf meinem Rechner funktioniert es" aufgrund kleiner Versionsunterschiede.

Die Kehrseite: Abhängigkeitswuchs und Wartung

Der Nachteil einfacher Installation ist leichter Übergebrauch. Projekte können Hunderte indirekter Abhängigkeiten anhäufen, was Update-Arbeit und Supply-Chain-Risiken erhöht. Manche Pakete werden ungewartet, sodass Teams ältere Versionen fixieren, Bibliotheken ersetzen oder selbst die Wartung übernehmen müssen. Das Ökosystem ermöglichte Tempo — machte aber auch Dependency-Hygiene zu einem echten Teil des Software-Lieferprozesses.

Frontends werden erwachsen: SPAs, Frameworks und geteilter Code

Frühe Websites setzten Seiten auf dem Server zusammen. Dann drehten Single-Page-Applications (SPAs) das Modell um: der Browser wurde zum "App-Runtime", holte Daten und rendert UI ohne komplettes Reload.

Dieser Wandel veränderte nicht nur Code — er veränderte Verantwortlichkeiten. Frontend-Arbeit ging von „diese Seite hübsch machen" dazu über, Routing, Zustand, Caching, Accessibility und Performance-Budgets zu verantworten. Designer, Backend-Ingenieure und Produktteams begannen, in Komponenten und Nutzerflüssen zu denken, nicht nur in Templates.

Frameworks machten Komplexität beherrschbar

Mit wachsenden SPAs wurde ad-hoc-JavaScript schnell schwer wartbar. React, Angular und Vue halfen, indem sie Muster zum Organisieren von UI-Komplexität boten:

- Komponentenbasierter Aufbau (UI als wiederverwendbare Bausteine)

- Vorhersehbares State-Management (weniger „wo hat sich dieser Wert geändert?“)

- Klarere Datenflüsse zwischen UI und APIs

Unterschiedliche Ökosysteme trafen unterschiedliche Entscheidungen, aber der große Gewinn waren gemeinsame Konventionen. Neue Entwickler konnten sich schneller zurechtfinden, weil das mentale Modell über Bildschirme und Features hinweg ähnlich war.

SSR und „universal“ Apps: Brücke zu schnellerer, besser entdeckbarer Sites

SPAs hatten manchmal Probleme mit der ersten Ladezeit und SEO, weil der Browser viel JavaScript herunterladen und ausführen musste, bevor Inhalte sichtbar wurden.

Server-Side Rendering (SSR) und "universal" Apps schlossen diese Lücke: die erste Ansicht auf dem Server rendern für schnelle Anzeige und Indexierung, dann im Browser "hydratisieren" für Interaktivität. Dieser Ansatz wurde bei Frameworks wie Next.js (React) und Nuxt (Vue) verbreitet, besonders für inhaltsreiche Seiten und E-Commerce.

Gemeinsamer Code veränderte, wie Unternehmen Produkte bauen

Sobald Front- und Backend JavaScript-freundlich waren, begannen Teams, Logik über die Stack-Grenze hinweg zu teilen:

- Validierungsregeln, die sowohl in Formularen als auch auf dem Server gelten

- Typen/Interfaces (oft via TypeScript), um API-Fehlanpassungen zu reduzieren

- Gemeinsame API-Clients und Fehlerbehandlung

Das Ergebnis: weniger duplizierte Regeln, schnellere Feature-Lieferung und eine stärkere Tendenz hin zu einer "einzigen Produktcodebasis"-Denkweise in Teams.

TypeScript und modernes JavaScript für größere Teams

Als JavaScript sich von „ein bisschen Browser-Scripting" zu geschäftskritischen Apps ausbreitete, begannen Teams, unter „JavaScript" eine ganze Familie verwandter Tools zu verstehen: moderne ECMAScript-Features, Build-Pipelines und oft TypeScript.

Warum TypeScript verbreitet wurde (auch wenn Leute „JavaScript" sagen)

TypeScript ist im Kern weiterhin JavaScript — es fügt nur ein Typensystem und einen Compiler-Schritt hinzu. Das macht die schrittweise Einführung einfach: man kann mit dem Tippen einiger problematischer Dateien beginnen, den Rest als plain .js belassen und am Ende eine gebündelte App ausliefern.

Deshalb sagen viele Teams, sie „schreiben JavaScript“, obwohl die Codebasis größtenteils .ts ist: die Laufzeit ist JavaScript, das Ökosystem ist JavaScript (npm-Pakete, Browser-APIs, Node.js) und TypeScripts Output ist JavaScript.

Wie Typen großen Teams helfen, schneller und sicherer zu arbeiten

Wenn eine Codebasis wächst, ist das Schwierigste nicht, neue Features zu schreiben, sondern alte sicher zu ändern. Typen wirken wie leichte Verträge:

- Wenn du eine Property umbenennst oder den Input einer Funktion änderst, markiert dein Editor und der Build jede Stelle, die du verpasst hast.

- Autocomplete wird genauer, Entwickler verbringen weniger Zeit beim Suchen in Docs und Code.

- Reviews werden leichter, weil viele „offensichtliche“ Fehler (falsche Argumentreihenfolge, fehlende Felder, null/undefined-Probleme) bereits vor dem Merge auffallen.

Der Kernnutzen ist Vertrauen: Teams können refactoren und Änderungen mit weniger Regressionen ausliefern.

Transpilation, einfach erklärt

Modernes JavaScript entwickelt sich schnell, aber nicht jeder Browser oder jede Umgebung unterstützt jedes Feature sofort. Transpilation ist einfach:

- Schreibe modernen Code (und TypeScript)

- Kompiliere ihn in breit kompatibles JavaScript, das überall läuft

So können Teams neue Syntax nutzen, ohne auf die Verbreitung in allen Geräten warten zu müssen.

Moderne Standards, die den Alltag verändert haben

Viele Features, die „modernes JavaScript" reifer erscheinen ließen, sind standardisierte Sprachverbesserungen:

- ES-Module (

import/export) für sauberen, wiederverwendbaren Code

- async/await für klarere asynchrone Logik statt tief verschachtelter Callbacks

- Laufende ECMAScript-Updates (bessere Objekt-/Array-Utilities, sichere Operatoren, verbesserte Iteration)

Zusammen mit TypeScript machten diese Standards JavaScript-Projekte skalierbar: leichter zu warten, einfacheres Onboarding und geringeres Risiko bei Änderungen.

Behalte die Kontrolle über deinen Code

Zuerst generieren, dann den Quellcode exportieren, wenn du volle Kontrolle willst.

JavaScript wurde nicht nur deshalb "unternehmensweit", weil es im Browser und auf Servern lief. Es wurde auch zur Sprache, mit der viele Teams ihre Arbeit "ausführen": bauen, testen, releasen und alltägliche Aufgaben automatisieren. Sobald das geschah, hörte JavaScript auf, nur eine App-Sprache zu sein, und wurde eine interne Betriebs-Schicht.

Mit komplexer werdenden Frontends brauchten Teams reproduzierbare Builds und verlässliche Prüfungen. JS-basierte Tools fühlten sich natürlich an, weil sie im selben Repo lebten und dasselbe Paket-Ökosystem nutzten.

Ein typisches Setup kann beinhalten:

- Build- und Bundling-Skripte, die produktionsreife Assets erzeugen

- Linting und Formatting, um Code lesbar zu halten

- Unit- und End-to-End-Tests, um Regressionen vor der Auslieferung abzufangen

- Kleine Automatisierungsskripte für Migrationen, Content-Processing oder Release-Notes

Weil diese Tools auf jedem Entwickler-Rechner und in CI laufen, verringern sie das "läuft nur auf meinem Laptop"-Problem.

In der Praxis macht diese "JavaScript-überall"-Toolchain moderne Vibe-Coding-Workflows möglich: wenn UI, Build und Deployment-Konventionen standardisiert sind, kannst du reale Anwendungen schnell generieren und iterieren. Plattformen wie Koder.ai nutzen genau diese Realität — sie lassen Teams eine App per Chat beschreiben und produzieren produktionsreife Projekte (oft React im Frontend) mit Source-Export, Deployment/Hosting, Custom Domains und Snapshots/Rollbacks für sicheres Iterieren.

Gemeinsamer Code in großem Maßstab: Monorepos und Designsysteme

Wachsende Unternehmen wechseln oft zu Monorepos, damit mehrere Apps eine gemeinsame Menge an Abhängigkeiten, Konfigurationen und Konventionen teilen können. So ist es einfacher, Komponentenbibliotheken, interne SDKs und Designsysteme zu pflegen—ohne Code zwischen Projekten zu kopieren.

Wenn eine Schaltfläche im Designsystem eine Accessibility-Korrektur bekommt, können alle Produkte sie per einzigem Version-Bump oder über ein geteiltes Paket übernehmen. JavaScript (und zunehmend TypeScript) macht dieses Teilen praktikabel, weil dieselben Komponenten Prototypen, Produktions-UIs und Dokumentation antreiben können.

CI/CD-Qualitätstore werden zum Standard

Sobald Linting, Tests und Builds standardisiert sind, werden sie zu Qualitätstoren in CI/CD-Pipelines: Merges werden blockiert, wenn Checks fehlschlagen, Releases werden automatisiert und Übergaben zwischen Teams reibungsloser. Das Ergebnis: weniger Tribal Knowledge, weniger Einzelprozesse und ein schnellerer Weg von Idee zu ausgeliefertem Feature.

Was JavaScript nicht gut kann (und wohin es sich bewegt)

JavaScript läuft heute fast überall — in Containern auf Kubernetes, als Serverless-Funktionen und zunehmend am Edge (CDNs und Edge-Runtimes). Diese Flexibilität ist ein großer Grund, warum Teams es standardisieren: eine Sprache, viele Deployment-Optionen.

Wo JavaScript an Grenzen stößt

JavaScript ist großartig für I/O-lastige Arbeit (APIs, Webserver, Event-Handling), kann aber an seine Grenzen stoßen, wenn es in "schwere Compute"-Territorien geschoben wird:

- Performance-Limits: JIT-kompiliertes JS kann schnell sein, ersetzt aber nicht immer low-level, vorhersehbare Performance. Latenz-sensitive Dienste können GC-Pausen erleben.

- Speichernutzung: Große Node.js-Prozesse können mehr Speicher verbrauchen als vergleichbare Dienste in für Backends optimierten Sprachen.

- Lang andauernde CPU-Arbeit: Videobearbeitung, große Datenverarbeitung, ML-Training und andere anhaltende CPU-Aufgaben gehören oft in spezialisierte Dienste (oder native Module), während JS eher orchestriert.

Sicherheit ist ein echter Kostenfaktor

Das npm-Ökosystem ist Stärke — und Supply-Chain-Risiko zugleich. Reife Teams behandeln Abhängigkeiten wie Drittanbieter: Versionen pinnen, automatische Audits, Abhängigkeitszahl minimieren und Review-Gates für neue Pakete durchsetzen. "Schnell hinzufügen" muss mit "sicher betreiben" ausbalanciert werden.

Warum das für Startups und Unternehmen wichtig ist

Für Startups reduziert JavaScript die Time-to-Market: geteilte Skills zwischen Front- und Backend, einfaches Hiring und unkompliziertes Deployment von Serverless bis Container, wenn der Traffic wächst. Für Enterprises bietet es Standardisierung — aber auch den Bedarf an Governance (Dependency-Hygiene, Build-Pipelines, Runtime-Richtlinien).

Ein praktisches Muster ist, JavaScript/TypeScript auf Produktlogik und User Experience zu konzentrieren, während performance- oder governance-kritische Teile in Sprachen wie Go oder Rust laufen. Hybride Stacks sind normal: z. B. React-Frontends mit Backends in Go und PostgreSQL für vorhersagbare Performance und Betriebssimplicity.

Was als Nächstes kommt

WebAssembly wird erweitern, was sinnvoll im Web und in Server-Runtimes ausführbar ist, und erlaubt, nahezu nativen Code neben JavaScript laufen zu lassen. Wahrscheinlich wird die Zukunft nicht sein, dass "JS alles ersetzt", sondern dass JS die Klebe-Schicht bleibt: Koordination von Diensten, die zunehmend TypeScript/JS mit Rust/Go/Python mischen, wo es passt.

Auf Workflow-Ebene geht die Entwicklung weniger um neue Syntax-Features als um kürzere Feedback-Schleifen: Planen, Generieren, Reviewen und Deployen schneller, ohne Kontrolle zu verlieren. Genau in diese Nische passen Tools wie Koder.ai gut — sie helfen Teams, von Idee zu funktionierender Web/Server/Mobile-App per Chat zu kommen, bieten aber weiterhin die Möglichkeit, den Code zu exportieren und selbst zu besitzen, wenn es Zeit ist, zu härten und zu skalieren.