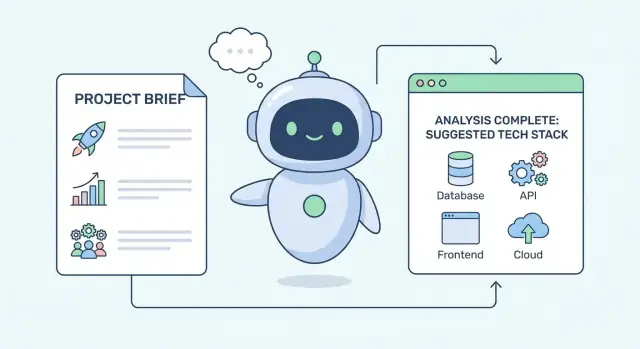

Was es bedeutet, dass KI einen Tech‑Stack „ableitet"

Ein Tech‑Stack ist einfach die Menge an Bausteinen, die du wählst, um ein Produkt zu bauen und zu betreiben. Konkret umfasst er in der Regel:

- Frontend: was Nutzer sehen und womit sie interagieren (Web‑ oder Mobile‑UI)

- Backend: serverseitige Logik und APIs

- Datenbank: wo Daten gespeichert und abgefragt werden

- Hosting/Deployment: wo die App läuft (Cloud, On‑Prem, Managed‑Plattformen)

- Tooling: Monitoring, CI/CD, Authentifizierung, Analytics, Tests und mehr

„Ableiten“ ist kein Gedankenlesen

Wenn eine KI einen Tech‑Stack „ableitet“, rät sie dir nicht dein Lieblings‑Framework. Sie führt strukturiertes Schließen durch: Sie nimmt, was du über deine Situation sagst, bildet eine Zuordnung zu üblichen Engineering‑Mustern und schlägt Stack‑Optionen vor, die sich unter ähnlichen Bedingungen bewährt haben.

Denk an sie wie an einen Entscheidungsassistenten, der Einschränkungen in technische Implikationen übersetzt. Zum Beispiel impliziert „wir müssen in 6 Wochen launchen“ oft die Wahl reifer Frameworks, Managed‑Services und weniger maßgeschneiderter Komponenten.

Die Kern‑Einschränkungen, die KI betrachtet

Die meisten Stack‑Empfehlungen beginnen mit einer kleinen Menge praktischer Einschränkungen:

- Skalierung und Performance: erwartete Nutzer, Traffic‑Spitzen, Latenzziele, Datenvolumen

- Speed to market: Deadlines, MVP vs. langfristige Plattform, Iterations‑Rhythmus

- Team‑Skills und Hiring: was eure Entwickler bereits können und was leicht zu rekrutieren ist

- Budget: Build vs. Buy, Cloud‑Kosten, Lizenzkosten, Betriebspersonal

- Compliance und Security: Datenresidenz, Prüfanforderungen, Verschlüsselung, Zugriffssteuerung

Erwartungen setzen

KI‑Empfehlungen sind am nützlichsten als Shortlists mit Abwägungen, nicht als finale Antworten. Gute Outputs erklären warum ein Stack passt (und wo er nicht passt), bieten machbare Alternativen und heben Risiken hervor, die mit deinem Team validiert werden sollten — denn Menschen behalten die Entscheidung und Verantwortung.

KI rät nicht aus einer einzigen Eingabe heraus. Sie arbeitet eher wie ein Interviewer: sie sammelt Signale, gewichtet sie und produziert dann eine kleine Menge plausibler Optionen — jeweils optimiert für unterschiedliche Prioritäten.

Produkt‑ und nutzerbezogene Anforderungen

Die stärksten Eingaben sind, was das Produkt tun muss und wie sich Nutzer damit fühlen sollen. Typische Signale sind:

- Produktziele (MVP‑Validierung vs. langfristige Plattform)

- Schlüssel‑Features (Realtime‑Kollaboration, Suche, Zahlungen, Dateiverarbeitung)

- Erwartetes Nutzeraufkommen und Wachstumskurve

- Latenz‑ und Reaktionsanforderungen (z. B. „muss sich sofort anfühlen“)

- Datensensitivität und Compliance‑Erwartungen (PII, HIPAA, SOC 2)

Diese Details lenken Entscheidungen wie „server‑rendered Webapp vs. SPA“, „relationale vs. dokumentenorientierte DB“ oder „queue‑basierte Verarbeitung vs. synchrone APIs“.

Kontext und Einschränkungen rund ums Bauen

Empfehlungen werden besser, wenn du die Situation um das Projekt herum beschreibst, nicht nur die Feature‑Liste:

- Bestehende Systeme zur Integration (ERP/CRM, Identity Provider, Data Warehouse)

- Bevorzugte Anbieter oder Cloud‑Verpflichtungen (AWS/GCP/Azure, bestimmte Managed‑Services)

- Deployment‑Umgebung (Kubernetes, Serverless, On‑Prem)

- Zeitplan und Release‑Sequenz (single Launch vs. gestaffelter Rollout)

Ein hartes Constraint (z. B. „muss On‑Prem laufen“) kann ansonsten starke Kandidaten ausschließen.

Team‑Signale, die Wartbarkeit beeinflussen

Stack‑Entscheidungen gelingen oder scheitern oft an denen, die bauen und betreiben. Nützliche Team‑Eingaben sind aktuelle Sprachen, ähnliche vergangene Projekte, Ops‑Reife (Monitoring/On‑Call) und Hiring‑Realitäten in deinem Markt.

Wie das Output aussehen sollte

Eine gute KI‑Antwort ist nicht ein „perfekter Stack“. Sie liefert 2–4 Kandidaten, jeweils mit:

- Warum er zur Einschränkung passt

- Wichtigen Trade‑offs und Risiken

- Was als Nächstes zu validieren ist (Benchmarks, Security‑Review, Spike)

Wenn du eine Vorlage suchst, um die Inputs zu teilen, siehe /blog/requirements-for-tech-stack-selection.

Von Einschränkungen zu Anforderungen: der Übersetzungsschritt

Bevor eine KI einen Tech‑Stack empfehlen kann, muss sie übersetzen, was du sagst, dass du willst, in das, was du tatsächlich brauchen wirst, um es zu bauen. Die meisten Projektbriefs beginnen mit unscharfen Zielen — „schnell“, „skalierbar“, „günstig“, „sicher“, „leicht wartbar“. Diese sind nützliche Signale, aber noch keine Anforderungen.

Vage Ziele in messbare Ziele verwandeln

KI wandelt Adjektive typischerweise in Zahlen, Schwellen und Betriebsannahmen um. Beispiele:

- „Schnelle App" → 95. Perzentil‑Antwortzeit (z. B. <300ms für Kernaktionen), Page‑Load‑Budget und akzeptable Spitzenlatenz

- „Wir müssen schnell liefern" → Release‑Cadence (wöchentlich vs. monatlich), Zeit bis zur ersten Version und Toleranz für technische Schulden

- „Skalierbar" → erwartete Nutzer, Spitzenanfragen/Sekunde, Wachstum und Datenvolumen über 6–18 Monate

Mit Zielgrößen wird die Stack‑Diskussion weniger zu Meinungen und mehr zu Abwägungen.

Harte Constraints von Präferenzen trennen

Ein großer Teil der Übersetzung besteht darin, Eingaben zu klassifizieren:

- Harte Constraints (Must‑have): Compliance‑Anforderungen, Datenresidenz, bestehende Vertragspartner, notwendige Integrationen, Verfügbarkeitsziele

- Präferenzen (Nice‑to‑have): „Microservices“, „trendiges Framework“, „Vendor‑Lock‑in vermeiden" (sofern nicht vertraglich)

Empfehlungen sind nur so gut wie diese Sortierung. Ein „Must“ schränkt Optionen ein; eine „Präferenz" beeinflusst nur die Rangfolge.

Fragen, was fehlt (und warum es wichtig ist)

Gute KI markiert fehlende Details und stellt kurze, wirkungsvolle Fragen, z. B.:

- Was sind eure stärksten Workflows und Spitzenzeiten?\n- Was ist das Ops‑Budget (People + Tooling), nicht nur Cloud‑Spend?\n- Welche Skills sind bereits im Team, und wen könnt ihr realistisch einstellen?\n- Welche Daten sind sensibel, und welche Audits gelten (falls vorhanden)?

Eine einseitige Constraint‑Übersicht bauen

Das Ergebnis dieses Schritts ist ein kompaktes „Constraint‑Profil“: messbare Ziele, Must‑haves und offene Fragen. Dieses Profil steuert spätere Entscheidungen — von Datenbankwahl bis Deployment — ohne euch zu früh auf ein konkretes Tool festzunageln.

Bei KI‑Empfehlungen sind „Skalierung“ und „Speed“ oft die ersten Filter. Diese Anforderungen schließen schnell Optionen aus, die für einen Prototyp funktionieren, aber unter realem Traffic scheitern.

Was „Skalierung" in Stack‑Begriffen bedeutet

KI zerlegt Skalierung typischerweise in konkrete Dimensionen:

- Nutzer und Request‑Volumen: durchschnittliche vs. Spitzenanfragen/Sekunde sowie Wachstumserwartungen

- Datenmenge: wie schnell Daten anfallen (Logs, Events, Dateien) und wie lange diese aufbewahrt werden müssen

- Read vs. Write‑Ratio: browse‑lastige Produkte brauchen andere Optimierungen als write‑lastige (z. B. Event‑Capture)

- Spitzenmuster: „den ganzen Tag stabil" ist einfacher als „10×‑Spitzen freitags" oder kampagnengetriebene Last

Diese Eingaben schränken ein, wie sehr du auf eine einzelne Datenbank bauen kannst, ob Caching früh nötig ist und ob Autoscaling ein Muss ist.

Geschwindigkeit: Latenz, Durchsatz und Echtzeitfunktionen

Performance ist keine einzelne Zahl. KI unterscheidet:

- Latenz (wie schnell sich eine Anfrage anfühlt) — beeinflusst CDNs, Caching, API‑Design

- Durchsatz (Anfragen/Jobs pro Minute) — beeinflusst Load‑Balancing und horizontales Scaling

- Hintergrundjobs (E‑Mails, Video‑Verarbeitung, Imports) — treibt den Stack zu Queues + Worker‑Mustern

- Echtzeit (Chat, Presence, Live‑Dashboards) — fügt oft WebSockets und Pub/Sub‑Komponenten hinzu

Wenn geringe Latenz kritisch ist, neigt die KI zu einfacheren Request‑Pfaden, aggressivem Caching und Managed‑Edge‑Delivery. Wenn Durchsatz und Hintergrundarbeit dominieren, priorisiert sie Job‑Queues und Worker‑Scaling.

Zuverlässigkeitsziele verengen die Optionen

Uptime‑Erwartungen und Recovery‑Bedürfnisse sind genauso wichtig wie Geschwindigkeit. Höhere Zuverlässigkeitsziele verschieben Empfehlungen häufig in Richtung:

- Managed‑Services (DBs, Queues) zur Reduktion operativer Risiken

- Redundanz über Zonen/Regionen hinweg

- Klare Backup/Restore‑ und Incident‑Response‑Workflows

Hohe Skalierung + strikte Speed‑Ziele + starke Zuverlässigkeitsanforderungen schieben den Stack oft früher in Richtung Caching, asynchroner Verarbeitung und Managed‑Infrastruktur.

Wie Team‑Fähigkeiten und Time‑to‑Market Empfehlungen steuern

Starte ein MVP mit bewährten Voreinstellungen

Erstelle eine React‑Webapp mit Go‑ und PostgreSQL‑Backend aus einem einzigen Chat.

Stack‑Empfehlungen klingen oft, als ob sie „beste Technologie“ optimieren. In der Praxis ist das stärkste Signal meist: was dein Team bauen, ausliefern und betreiben kann, ohne zu blockieren.

Vertrautheit schlägt theoretisch „besser"

Wenn deine Entwickler ein Framework gut kennen, wird die KI es typischerweise bevorzugen — selbst wenn eine Alternative leicht bessere Benchmarks hat. Vertraute Tools reduzieren Design‑Debatten, beschleunigen Code‑Reviews und minimieren subtile Fehler.

Beispiel: Ein Team mit viel React‑Erfahrung bekommt oft React‑basierte Empfehlungen (Next.js, Remix) statt eines „hippen" Frontends. Gleiches gilt für Backend‑Stacks: ein Node/TypeScript‑Team wird eher zu NestJS oder Express geraten als zu einem Sprachwechsel, der Monate Lernzeit kostet.

Time‑to‑Market begünstigt bewährte Defaults

Bei hohem Launch‑Druck empfiehlt die KI oft:

- Reife Frameworks mit starken Konventionen (weniger Architekturentscheidungen)\n- Templates/Starters, die Auth, Routing und Deployment abdecken\n- Managed‑Services, die Setup und Wartung reduzieren

Deshalb tauchen oft „langweilige" Optionen auf: sie haben vorhersehbare Pfade zur Produktion, gute Dokumentation und viele gelöste Probleme. Ziel ist nicht Eleganz, sondern mit möglichst wenigen Unbekannten ausliefern.

Tools zur Beschleunigung (z. B. Koder.ai) können hier nützlich sein: sie helfen Teams, aus Anforderungen funktionierende Web/Server/Mobile‑Gerüste zu erzeugen, während ein konventioneller Stack darunter bleibt (React für Web, Go + PostgreSQL für Backend/Data, Flutter für Mobile). Richtig eingesetzt ergänzen sie den Entscheidungsprozess — sie beschleunigen Prototypen und Erst‑Releases, ersetzen aber nicht die Validierung des Stacks gegen deine Einschränkungen.

Operativer Aufwand: self‑hosted vs. managed

KI schätzt auch eure Betriebsfähigkeit ein. Wenn keine dedizierte DevOps‑Person oder begrenzte On‑Call‑Bereitschaft besteht, verschieben sich Empfehlungen hin zu Managed‑Plattformen (managed Postgres, gehostetes Redis, managed Queues) und einfacheren Deployments.

Ein kleines Team kann selten Cluster babysitten, Secrets manuell rotieren und Monitoring von Grund auf bauen. Wenn die Einschränkungen das nahelegen, drängt die KI zu Services mit eingebauten Backups, Dashboards und Alerting.

Hiring und Onboarding sind wichtig

Stack‑Wahl beeinflusst dein zukünftiges Team. KI gewichtet Sprache‑Popularität, Lernkurve und Community‑Support, weil sie Hiring und Einarbeitungszeit beeinflussen. Ein weit verbreiteter Stack (TypeScript, Python, Java, React) gewinnt oft, wenn Wachstum, Freelancer oder häufiges Onboarding zu erwarten sind.

Wenn du tiefer einsteigen willst, wie Empfehlungen in konkrete Layer‑Entscheidungen münden, siehe /blog/mapping-constraints-to-stack-layers.

Entscheidungslogik: Abwägung von Trade‑offs und Prioritäten

Stack‑Empfehlungen sind keine „Best Practices“ aus der Schublade. Meist resultieren sie aus dem Scoring von Optionen gegen deine genannten Einschränkungen und der Wahl der Kombination, die heute am besten passt — auch wenn sie nicht perfekt ist.

Trade‑offs in eine Rangfolge verwandeln

Die meisten Entscheidungen sind Kompromisse:\n\n- Flexibilität vs. Einfachheit: hochgradig anpassbare Setups unterstützen ungewöhnliche Workflows, erhöhen aber Wartung und Onboarding‑Aufwand\n- Kosten vs. Kontrolle: Managed‑Services reduzieren Ops‑Aufwand, können aber Feintuning einschränken und Vendor‑Abhängigkeit erhöhen\n- Schnelligkeit vs. Sicherheit: schnell ausliefern bedeutet oft weniger Optimierung, während „Sicherheit“ strengere Tools, Tests und bewährte Komponenten favorisiert

KI stellt diese oft als Punktebewertungen dar. Sagst du „Launch in 6 Wochen mit kleinem Team“, werden Einfachheit und Geschwindigkeit höher gewichtet als langfristige Flexibilität.

Gewichtete Einschränkungen: was heute zählt

Ein praktisches Modell ist eine gewichtete Checkliste: Time‑to‑Market, Team‑Skill, Budget, Compliance, erwarteter Traffic, Latenzbedürfnisse, Datensensitivität und Hiring‑Realität. Jede Kandidatenkomponente (Framework, DB, Hosting) erhält Punkte dafür, wie gut sie passt.

Deshalb liefert dieselbe Produktidee unterschiedliche Antworten: die Gewichte ändern sich mit deinen Prioritäten.

Mehrere Pfade: MVP‑Stack vs. Scale‑Up‑Stack

Gute Empfehlungen enthalten oft zwei Wege:\n\n- MVP‑Pfad: Komplexität und Betriebsaufwand minimieren; mainstream Tools wählen, mit denen das Team sofort liefern kann\n- Scale‑Up‑Pfad: eine migrationsfreundliche Route planen (z. B. Caching hinzufügen, Services splitten, Message Queue einführen), sobald Last den Bedarf bestätigt

„Good enough“ mit expliziten Annahmen

KI kann „good enough" Entscheidungen mit Annahmen rechtfertigen: erwartetes Nutzeraufkommen, akzeptable Downtime, nicht verhandelbare Features und aufschiebbare Punkte. Wichtig ist Transparenz — wenn eine Annahme falsch ist, weißt du genau, welche Teile des Stacks zu überarbeiten sind.

Mapping: Einschränkungen auf Stack‑Layer (Frontend bis Data)

Eine nützliche Sicht ist, Empfehlungen als Layer‑Mapping zu verstehen. Statt zufällig Tools zu nennen, übersetzt das Modell jede Einschränkung (Speed, Team‑Skill, Compliance, Timeline) in Anforderungen für Frontend, Backend und Datenschicht — und schlägt erst dann konkrete Technologien vor.

Frontend: Web vs. Mobile (und was die UI leisten muss)

KI klärt meist zuerst wo Nutzer interagieren: Browser, iOS/Android oder beides.

Wenn SEO und schnelle Ladezeiten zählen (Marketing‑Sites, Marktplätze, Content‑Produkte), tendieren Web‑Empfehlungen zu Frameworks mit Server‑Rendering und guten Performance‑Budgets.

Ist Offline‑Fähigkeit zentral (Feldarbeit, Reisen, unzuverlässige Netze), verschiebt sich die Empfehlung zu nativen Apps (oder einer sorgfältig gestalteten PWA) mit lokalem Speicher und Sync.

Bei Realtime‑UIs (Kollaboration, Trading‑Dashboards) wird die Constraint „Effizientes Pushen von Updates" relevant, was State‑Management, WebSockets und Event‑Handling beeinflusst.

Backend: Monolith vs. Microservices, APIs und Hintergrundarbeit

Für Frühphasenprodukte empfiehlt KI oft einen modularen Monolithen: eine deploybare Einheit, klare interne Grenzen und eine einfache API (REST oder GraphQL). Die Constraint hier ist Time‑to‑Market und weniger bewegliche Teile.

Microservices treten auf, wenn Anforderungen unabhängige Skalierung, strikte Isolation oder viele Teams erfordern.

Hintergrundverarbeitung ist ein weiterer Schlüsselübersetzungsschritt. Wenn du E‑Mails, Videoverarbeitung, Berichtserzeugung, Billing‑Retries oder Integrationen hast, wird die KI typischerweise ein Job‑Queue + Worker‑Pattern vorschlagen, damit die user‑sichtbare API reaktionsfähig bleibt.

Datenschicht: die einfachste passende DB wählen, dann Spezialisten hinzufügen

Relationale Datenbanken werden meist empfohlen, wenn Transaktionen, Reporting und konsistente Geschäftsregeln nötig sind.

Dokumenten‑ oder Key‑Value‑Stores treten auf, wenn flexible Schemata, sehr hoher Write‑Durchsatz oder sehr schnelle Lookups wichtig sind.

Suche (z. B. für Filterung, Ranking, Toleranz gegenüber Tippfehlern) ist oft ein separater Bedarf; die KI empfiehlt eine Search‑Engine nur, wenn DB‑Queries die UX‑Anforderungen nicht mehr erfüllen.

Integrationen: Basics nicht neu erfinden

Bei Anforderungen an Zahlungen, Authentifizierung, Analytics, Messaging oder Notifications neigen Empfehlungen dazu, etablierte Dienste und Bibliotheken zu favorisieren statt alles selbst zu bauen — Zuverlässigkeit, Compliance und Wartungskosten zählen genauso wie Features.

Datenbank, Caching und Messaging: typische KI‑Begründung

Hol die Stack‑Entscheidung aus deinem Kopf

Nutze den Planungsmodus, um Anforderungen zu klären, bevor du etwas generierst.

Wenn eine KI eine DB empfiehlt oder Caching und Queues hinzufügt, reagiert sie meist auf drei Constraint‑Typen: wie konsistent die Daten sein müssen, wie spiky der Traffic ist und wie schnell das Team liefern will, ohne großen Betriebsoverhead zu erzeugen.

Relationale DB vs. Alternativen

Relationale DBs (z. B. Postgres) sind Standard, wenn Beziehungen (User → Orders → Invoices), starke Konsistenz und sichere Mehrschritt‑Updates benötigt werden. KI‑Modelle wählen relationale Systeme, wenn erwähnt wird:\n\n- Reporting und ad‑hoc Queries für Finanzen/Operations\n- Migrationen und sich entwickelnde Schemata\n- Transaktionen und „kein doppelter Charge"‑Garantien

Alternativen kommen ins Spiel, wenn sich die Constraints verschieben: Dokument‑DBs für schnell ändernde, verschachtelte Daten; Wide‑Column oder Key‑Value für ultra‑niedrige Latenz bei einfachen Zugriffsmustern.

Caching und Queues: wann sie wichtig sind

Caching (oft Redis oder ein Managed‑Cache) wird empfohlen, wenn wiederholte Lesezugriffe die DB belasten würden: populäre Produktseiten, Session‑Daten, Rate‑Limiting, Feature‑Flags. Wenn die Constraint „Traffic‑Spitzen“ oder „niedrige p95‑Latenz" ist, reduziert Caching die DB‑Last erheblich.

Queues und Hintergrundjobs werden vorgeschlagen, wenn Arbeit nicht innerhalb der User‑Request abgeschlossen werden muss: E‑Mails, PDF‑/Video‑Verarbeitung, Synchronisationen. Das erhöht Zuverlässigkeit und hält die App während Lastspitzen reaktionsfähig.

Storage für Dateien und Events

Für Nutzer‑Uploads und generierte Assets wählt die KI typischerweise Object‑Storage (S3‑Style), weil es günstiger, skalierbar ist und die DB schlank hält. Wenn Streams von Events (Clicks, Updates, IoT‑Signale) zu verarbeiten sind, kann ein Event‑Stream (Kafka/ PubSub‑Style) vorgeschlagen werden, um hohen Durchsatz und geordnete Verarbeitung zu gewährleisten.

Datensicherheit: Constraints, die „langweilige aber sichere" Picks erzwingen

Wenn Compliance, Auditfähigkeit oder Recovery‑Ziele genannt werden, beinhalten Empfehlungen meist automatisierte Backups, getestete Restore‑Prozesse, Migrationstools und strengere Zugriffskontrolle (Least‑Privilege‑Rollen, Secrets‑Management). Je stärker das „Datenverlust darf nicht auftreten"‑Kriterium ist, desto eher tendiert die KI zu Managed‑Services und etablierten Mustern.

Deployment, Security und Operations‑Einschränkungen

Ein Stack‑Vorschlag ist nicht nur „Welche Sprache und DB“. KI leitet auch ab, wie du das Produkt betreiben wirst: wo es gehostet wird, wie Updates geliefert werden, wie Incidents gehandhabt werden und welche Schutzmaßnahmen rund um Daten nötig sind.

Cloud und Hosting: Managed vs. Container vs. Serverless

Bei Fokus auf Geschwindigkeit und kleinem Team bevorzugt die KI oft Managed‑Plattformen (PaaS), weil sie operativen Aufwand reduziert: automatische Patches, einfachere Rollbacks und eingebautes Scaling. Wenn mehr Kontrolle nötig ist (kundenspezifisches Networking, spezialisierte Runtimes, viele Services), werden Container (oft mit Kubernetes oder einfacheren Orchestratoren) wahrscheinlicher.

Serverless eignet sich häufig für spiky oder unvorhersehbaren Traffic und wenn man vor allem für ausgeführte Zeit zahlt. Gute Empfehlungen weisen aber auch auf Trade‑offs hin: Debugging ist schwieriger, Cold‑Starts können für User‑sichtige Latenz relevant sein und die Kosten können steigen, wenn eine „günstige" Funktion ständig läuft.

Sicherheits‑ und Compliance‑Constraints

Wenn du PII, Audit‑Logs oder Datenresidenz erwähnst, empfiehlt KI typischerweise:\n\n- Starke Identity‑Access‑Kontrollen (Least‑Privilege, MFA)\n- Verschlüsselung in Transit und at‑rest\n- Zentralisiertes Audit‑Logging für sensible Aktionen\n- Region‑gebundenes Storage und Backups, wenn Daten lokal bleiben müssen

Das ist keine Rechtsberatung — sondern pragmatische Maßnahmen, um Risiken zu reduzieren und Reviews zu erleichtern.

Observability: was „bereit für Skalierung" wirklich bedeutet

„Bereit für Skalierung" heißt meist: strukturierte Logs, Basis‑Metriken (Latenz, Error‑Rate, Saturation) und Alerting, das an Nutzer‑Impact gekoppelt ist. KI empfiehlt oft das Dreigespann — Logging + Metrics + Tracing — damit du beantworten kannst: Was ging kaputt? Wer ist betroffen? Was hat sich geändert?

Kosten: planbare Ausgaben vs. Pay‑per‑Use

KI wägt ab, ob du planbare Monatskosten (reservierte Kapazität, Managed‑DBs vorgeplant) oder Pay‑per‑Use (Serverless, Autoscaling) bevorzugst. Gute Empfehlungen benennen „Surprise‑Bill“‑Risiken: laute Logs, ungebremste Background‑Jobs und Daten‑Egress, dazu einfache Limits und Budgets, um Kosten im Griff zu behalten.

Drei Beispiel‑Szenarien und empfohlene Stacks

Schnell vorankommen ohne Fortschritt zu gefährden

Experimentiere sicher mit Snapshots und Rollbacks, während du Anforderungen verfeinerst.

KI‑Empfehlungen sind meist „Best‑Fit unter diesen Einschränkungen“, nicht die eine richtige Antwort. Nachfolgend drei typische Szenarien als Option A / Option B mit expliziten Annahmen.

Beispiel 1: Kleines Team, enger Zeitplan, moderates Wachstum

Annahmen: 2–5 Ingenieure, Launch in 6–10 Wochen, stabiler, nicht riesiger Traffic (z. B. 10k–200k Nutzer/Monat), begrenzte Ops‑Kapazität.

Option A (Speed‑first, wenige bewegliche Teile):

Typische Empfehlung: React/Next.js (Frontend), Node.js (NestJS) oder Python (FastAPI) (Backend), PostgreSQL (DB) und eine Managed‑Plattform wie Vercel + Managed Postgres. Auth und E‑Mail werden oft gekauft (Auth0/Clerk, SendGrid), um Bauzeit zu sparen.

Wenn Zeit der wichtigste Faktor ist und du Starter‑Bündel vermeiden möchtest, kann eine Plattform wie Koder.ai helfen, schnell ein React‑Frontend plus Go + PostgreSQL‑Backend aus einem chatbasierten Spec aufzubauen, mit Optionen zum Export von Source‑Code und Deployment — nützlich für MVPs, die trotzdem Ownership wollen.

Option B (Team‑basiert, längere Laufzeit):

Hat das Team in einem Ökosystem viel Erfahrung, lautet die Empfehlung oft Standardisieren: Rails + Postgres oder Django + Postgres, plus eine minimale Queue (managed Redis) nur wenn Hintergrundjobs klar nötig sind.

Beispiel 2: High‑Traffic, niedrige Latenz

Annahmen: spiky Traffic, strikte Antwortzeiten, read‑intensive Workloads, globale Nutzer.

Option A (Performance mit bewährten Defaults):

KI fügt Schichten hinzu: CDN (Cloudflare/Fastly), Edge‑Caching für statische Inhalte, Redis für Hot Reads und Rate‑Limits, sowie eine Queue wie SQS/RabbitMQ für Async‑Arbeit. Backend könnte zu Go/Java wechseln für vorhersagbare Latenzen, während PostgreSQL mit Read‑Replicas erhalten bleibt.

Option B (Stack beibehalten, Ränder optimieren):

Wenn Hiring/Time gegen einen Sprachwechsel spricht, lautet die Empfehlung oft: aktuellen Backend‑Stack behalten, aber in Caching‑Strategie, Queue‑basierte Verarbeitung und DB‑Indexierung investieren, bevor ein Rewrite angegangen wird.

Beispiel 3: Regulierte oder sensible Daten

Annahmen: Compliance‑Anforderungen (HIPAA/SOC 2/GDPR‑ähnlich), Audits, strikte Zugriffskontrolle, Audit‑Logs.

Option A (reife Managed‑Services):

Gängige Picks sind AWS/Azure mit KMS‑Verschlüsselung, privatem Networking, IAM‑Rollen, zentralisiertem Logging und Managed‑DBs mit Audit‑Funktionen.

Option B (Self‑Host für Kontrolle):

Wenn Datenresidenz oder Vendor‑Regeln es erfordern, kann KI Kubernetes + PostgreSQL vorschlagen mit strikteren Betriebssteuerungen — allerdings mit dem Hinweis, dass das die laufenden Ops‑Kosten erhöht.

Grenzen, Risiken und wie man KI‑Empfehlungen validiert

KI kann einen kohärenten Tech‑Stack vorschlagen, aber sie rät aus partiellen Signalen. Betrachte das Ergebnis als strukturierte Hypothese — nicht als endgültige Lösung.

Übliche Limitationen

Erstens ist die Eingabe oft unvollständig. Wenn du kein Datenvolumen, Spitzenkonkurrenz, Compliance‑Bedürfnisse, Latenzziele oder Integrationsgrenzen nennst, füllt die Empfehlung Lücken mit Annahmen.

Zweitens ändern sich Ökosysteme schnell. Ein Modell kann ein Tool empfehlen, das kürzlich veraltet, akquiriert, anders bepreist oder vom Cloud‑Anbieter nicht mehr unterstützt wird.

Drittens sind manche Kontexte schwer zu kodifizieren: interne Politik, bestehende Verträge, On‑Call‑Reife deines Teams oder Migrationskosten. Diese Faktoren können Empfehlungen stark beeinflussen.

Popularitäts‑Bias (und wie man ihn ausbremst)

Viele KI‑Vorschläge neigen zu viel diskutierten Tools. Popularität ist nicht falsch, aber sie kann bessere Fits verdecken — besonders bei regulierten Branchen, engen Budgets oder ungewöhnlichen Workloads.

Gegensorge: Formuliere Constraints klar:\n\n- „Wir können dieses Jahr kein spezialisiertes Ops‑Team einstellen."\n- „Daten müssen in‑region und auditierbar bleiben."\n- „Wir brauchen planbare Kosten mehr als maximale Performance."\n

Klare Einschränkungen zwingen die Empfehlung, Trade‑offs zu begründen statt sich auf vertraute Namen zu verlassen.

Validierungsschritte, die teure Fehler vermeiden

Bevor du dich festlegst, führe leichte Prüfungen durch, die echte Risiken adressieren:\n\n1. Kleines Prototyping der riskantesten Pfade (Auth, Payments, Realtime)\n2. Load‑Tests mit realistischen Mustern, nicht nur synthetischen Benchmarks\n3. Kostenschätzung (Compute, Storage, Egress, Managed‑Services) für heute und dein 6–12‑Monate‑Ziel\n4. Security‑Review: Threat Model, Datenhandling, IAM, Secrets‑Management, Compliance

KI sicher nutzen: eine schriftliche Begründung aufbewahren

Bitte die KI um ein kurzes „Decision Record": Ziele, Einschränkungen, gewählte Komponenten, verworfene Alternativen und Auslöser für eine Änderung. Diese Begründung beschleunigt spätere Diskussionen und macht Upgrades weniger schmerzhaft.

Wenn du einen Build‑Beschleuniger (inkl. chatgesteuerte Plattformen wie Koder.ai) nutzt, wende dieselbe Disziplin an: Annahmen vorab festhalten, früh mit einer dünnen Produktschicht validieren und Sicherungsmaßnahmen wie Snapshots/Rollbacks und Source‑Code‑Export nutzen, damit Geschwindigkeit nicht zulasten von Kontrolle geht.