Was „Iteration“ bedeutet — und wo KI hineinpasst

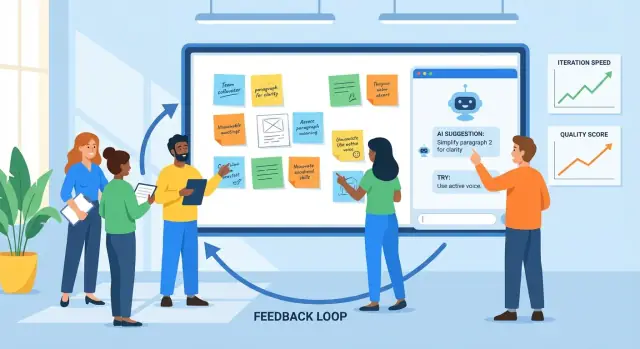

Iteration ist die Praxis, etwas zu erstellen, Feedback zu sammeln, es zu verbessern und den Zyklus zu wiederholen. Man begegnet ihr in Produktdesign (ein Feature ausliefern, Nutzung beobachten, verfeinern), Marketing (eine Botschaft testen, lernen, umformulieren) und Schreiben (Entwurf, Review, Bearbeitung).

Feedback ist jedes Signal, das zeigt, was funktioniert und was nicht: Nutzerkommentare, Support-Tickets, Bug-Reports, Umfrageantworten, Leistungsmetriken, Anmerkungen von Stakeholdern — sogar Ihr eigenes Bauchgefühl nach eigener Nutzung. Verbesserung ist das, was Sie anhand dieser Signale ändern, von kleinen Anpassungen bis zu größeren Redesigns.

Warum kürzere Zyklen wichtig sind

Kürzere Feedback-Zyklen führen meist aus zwei Gründen zu besseren Ergebnissen:

- Die Qualität verbessert sich schneller: Sie erwischen Missverständnisse und Fehler früh, bevor sie sich über weitere Seiten, Screens oder Releases ausbreiten.

- Geschwindigkeit steigt ohne Raten: Sie verbringen weniger Zeit mit abstrakten Debatten und mehr Zeit mit Lernen aus echten Daten.

Ein guter Iterationsrhythmus ist nicht „schnell vorwärts und alles kaputtmachen“. Er ist „in kleinen Schritten vorgehen und schnell lernen“.

Wo KI hilft (und wo nicht)

KI ist im Loop nützlich, wenn viele Informationen vorliegen und Sie Hilfe bei der Verarbeitung brauchen. Sie kann:

- Feedback aus vielen Quellen in Themen zusammenfassen

- wiederkehrende Beschwerden, verwirrende Formulierungen oder fehlende Details erkennen

- alternative Varianten (Texte, Layouts, Aufgabenformulierungen) vorschlagen

- als zweite Kontrollinstanz für Klarheit, Ton und Konsistenz dienen

Aber KI kann die Kernentscheidungen nicht ersetzen. Sie kennt Ihre Geschäftsziele, rechtliche Zwänge oder was für Ihre Nutzer „gut“ bedeutet nicht, sofern Sie das nicht definieren. Sie kann mit souveräner Tonalität Änderungen vorschlagen, die unpassend, riskant oder auf falschen Annahmen basieren.

Stellen Sie Erwartungen klar: KI unterstützt Urteilskraft. Ihr Team entscheidet weiterhin, was Priorität hat, was geändert wird, wie Erfolg aussieht — und validiert Verbesserungen mit echten Nutzern und echten Daten.

Der grundlegende Feedback-Loop: ein pragmatisches Modell

Iteration ist einfacher, wenn alle denselben Ablauf nutzen und wissen, was "fertig" bedeutet. Ein praktisches Modell ist:

Draft → Feedback → Überarbeiten → Prüfen → Veröffentlichen

Teams bleiben oft stecken, weil ein Schritt langsam ist (Reviews), unordentlich (Feedback über viele Tools verstreut) oder mehrdeutig (was genau soll geändert werden?). Gezielt eingesetzt kann KI an jedem Punkt Reibung reduzieren.

Schritt 1: Draft (zu etwas Vorzeigbarem kommen)

Das Ziel ist nicht Perfektion, sondern eine solide erste Version, auf die andere reagieren können. Ein KI-Assistent kann beim Gliedern, Generieren von Alternativen oder Auffüllen von Lücken helfen, sodass Sie schneller zu einer "reviewbaren" Fassung kommen.

Am hilfreichsten ist das bei der Umwandlung eines groben Briefings in einen strukturierten Entwurf und beim Erzeugen mehrerer Optionen (z. B. drei Überschriften, zwei Onboarding-Flows) zum Vergleich.

Schritt 2: Feedback (erfassen und verdichten)

Feedback kommt meist als lange Kommentare, Chat-Threads, Besprechungsnotizen und Support-Tickets. KI ist nützlich für:

- Zusammenfassung wiederkehrender Themen (was immer wieder erwähnt wird)

- Gruppierung von Feedback nach Thema (Preis, Onboarding, Ton, Bugs)

- Extraktion von Fragen und „muss-gefixt“-Punkten vs. „nice-to-haves"

Der Engpass, den Sie beseitigen: langsames Lesen und inkonsistente Interpretation dessen, was Reviewer meinten.

Schritt 3: Überarbeiten (Reaktionen in Änderungen verwandeln)

Hier verlieren Teams oft Zeit durch Nacharbeit: unklare Rückmeldungen führen zu Änderungen, die den Reviewer nicht zufriedenstellen, und die Schleife beginnt von vorn. KI kann konkrete Edit-Vorschläge liefern, überarbeiteten Text vorschlagen oder eine zweite Version erzeugen, die gezielt die wichtigsten Feedback-Themen adressiert.

Schritt 4: Prüfen (Qualität vor dem Release)

Vor der Veröffentlichung nutzen Sie KI als zweite Prüfinstanz: Führt die neue Version zu Widersprüchen, fehlenden Schritten, gebrochenen Anforderungen oder Tonabweichungen? Das Ziel ist nicht, die Arbeit zu "genehmigen", sondern offensichtliche Probleme früh zu entdecken.

Schritt 5: Veröffentlichen mit einer einzigen Quelle der Wahrheit

Iteration beschleunigt sich, wenn Änderungen an einem Ort leben: ein Ticket, ein Dokument oder eine PR-Beschreibung, die (1) die Feedback-Zusammenfassung, (2) die Entscheidungen und (3) die Änderungen dokumentiert.

KI kann helfen, diese "Single Source of Truth" zu pflegen, indem sie Update-Notizen formuliert und Akzeptanzkriterien mit den letzten Entscheidungen in Einklang hält. In Teams, die Software direkt bauen und ausliefern, können Plattformen wie Koder.ai diesen Schritt verkürzen, indem Planung, Implementierung und Deployment eng verbunden bleiben — so bleibt die narrative "Was hat sich geändert" nah am tatsächlichen Release.

Feedback sammeln: was KI gut verarbeiten kann

KI kann nur das verbessern, womit Sie sie füttern. Gute Nachrichten: Die meisten Teams haben bereits reichlich Feedback — es ist nur über verschiedene Orte verteilt und unterschiedlich formuliert. Ihre Aufgabe ist, es konsistent zu sammeln, damit KI es zusammenfassen, Muster erkennen und bei der Entscheidungsfindung helfen kann.

KI ist stark bei unordentlichen, textlastigen Inputs, darunter:

- Nutzerkommentare (in-App, Community-Posts, Chat)

- Support-Tickets und Chat-Transkripte

- offene Umfrageantworten

- App-Store- und Marktplatz-Bewertungen

- Sales-/CS-Call-Notizen und Besprechungszusammenfassungen

- Bug-Reports und Feature-Requests aus internen Teams

Sie brauchen keine perfekte Formatierung. Wichtig ist, die Originalworte und ein paar Metadaten (Datum, Produktbereich, Tarif usw.) zu erfassen.

Vom "Haufen Zitate" zu Themen und Pain Points

Nach dem Sammeln kann KI Feedback in Cluster gruppieren — Onboarding-Verwirrung, Reibung beim Start, fehlende Integrationen, langsame Performance — und zeigen, was am häufigsten wiederkehrt. Das ist wichtig, weil der lauteste Kommentar nicht immer das häufigste Problem ist.

Ein pragmatischer Ansatz ist, die KI zu bitten um:

- eine Themenliste mit kurzen Labels

- repräsentative Zitate pro Thema (zum Gegencheck)

- Häufigkeitssignale (z. B. „in 18 Tickets diese Woche erwähnt")

- Hinweise zur Auswirkung (wen es trifft und was es blockiert)

Kontext bewahren, damit Erkenntnisse relevant bleiben

Feedback ohne Kontext führt zu generischen Schlussfolgerungen. Hängen Sie leichtgewichtigen Kontext an jeden Eintrag, z. B.:

- Persona oder Kundentyp (Neunutzer, Admin, Power-User)

- das Ziel des Nutzers ("Bericht exportieren", "Team einladen")

- Einschränkungen (Gerät, Region, Tarif, Compliance-Anforderungen)

Schon wenige konsistente Felder machen Gruppierung und Zusammenfassungen der KI deutlich handlungsfähiger.

Datenschutz und Datenhandling-Grundlagen

Vor der Analyse: persönliche und sensible Informationen schwärzen: Namen, E-Mails, Telefonnummern, Adressen, Zahlungsdaten und vertrauliches Material in Gesprächsnotizen. Bevorzugen Sie Datenminimierung — teilen Sie nur, was für die Aufgabe nötig ist — und speichern Sie Roh-Exporte sicher. Wenn Sie Drittanbieter-Tools nutzen, klären Sie die Richtlinien zu Aufbewahrung und Training und schränken Sie den Zugriff auf das Dataset ein.

Rohes Feedback in klare, umsetzbare Erkenntnisse verwandeln

Rohes Feedback ist meist ein Haufen heterogener Inputs: Support-Tickets, App-Reviews, Umfragekommentare, Sales-Notizen und Slack-Threads. KI kann „unordentliche” Sprache in großem Maßstab lesen und helfen, daraus eine kurze Liste von Themen zu machen, an denen Sie wirklich arbeiten können.

1) Von verstreuten Kommentaren zu Kategorien

Füttern Sie die KI mit einer Charge Feedback (sensiblen Daten entfernt) und bitten Sie um Gruppierung in konsistente Kategorien wie Onboarding, Performance, Preisgestaltung, UI-Verwirrung, Bugs und Feature-Requests. Ziel ist keine perfekte Taxonomie, sondern eine gemeinsame Karte für Ihr Team.

Ein praktisches Ausgabeformat sieht so aus:

- Kategorie: Onboarding-Verwirrung

- Was Nutzer versuchen zu tun: Account verbinden, Daten importieren

- Beobachtete Blocker: „Konnt die Import-Schaltfläche nicht finden", „War mir nicht sicher, ob es funktioniert hat"

2) Prioritäten mit einer einfachen Rubrik ergänzen

Wenn Feedback gruppiert ist, bitten Sie die KI, einen Prioritätsscore vorzuschlagen, basierend auf einer von Ihnen geprüften Rubrik:

- Impact: Wie stark beeinflusst das den Nutzererfolg oder Umsatz?

- Frequenz: Wie oft kommt es in den Quellen vor?

- Aufwand: Wie schwer ist die Behebung (Zeit, Abhängigkeiten)?

- Risiko: Wie groß ist die Chance, etwas kaputt zu machen oder Compliance/Support-Probleme zu erzeugen?

Sie können es leichtgewichtig (Hoch/Mittel/Niedrig) oder numerisch (1–5) halten. Wichtig ist, dass die KI den ersten Entwurf liefert und Menschen Annahmen bestätigen.

3) Zusammenfassen ohne Nuancen zu verlieren (Belege behalten)

Zusammenfassungen werden gefährlich, wenn sie das "Warum" ausradieren. Ein sinnvolles Muster ist: Themenzusammenfassung + 2–4 repräsentative Zitate. Zum Beispiel:

„Ich habe Stripe verbunden, aber nichts hat sich geändert — wurde das synchronisiert?“

„Der Einrichtungsassistent hat einen Schritt übersprungen und ich wusste nicht, was ich als Nächstes tun sollte."

Zitate bewahren Ton und Kontext — und verhindern, dass das Team jedes Problem als identisch behandelt.

4) Auf Verzerrungen achten: Laut ist nicht gleich häufig

KI kann dramatische Sprache übergewichten oder wiederkehrende Kommentatoren, wenn Sie sie nicht anleiten. Bitten Sie sie zu unterscheiden zwischen:

- Volumenbasierte Signale (wie viele einzigartige Nutzer es erwähnen)

- Schweregradbasierte Signale (wie schlimm es ist, wenn es passiert)

Prüfen Sie das Ergebnis gegen Nutzungsdaten und Segmentierung. Eine Beschwerde von Power-Usern kann sehr wichtig sein — oder sie ist nur ein Nischen-Workflow. KI zeigt Muster, aber sie kann nicht entscheiden, was Ihre Nutzer repräsentiert ohne Ihren Kontext.

KI zum Generieren von Versionen nutzen, nicht nur für „die Antwort"

Vor dem Bauen planen

Bildschirme, Abläufe und Anforderungen skizzieren, bevor Code generiert wird, damit Änderungen kontrolliert bleiben.

Denken Sie an ein KI-Tool als Versionengenerator. Statt nach einer einzigen „besten“ Antwort zu fragen, fordern Sie mehrere plausible Entwürfe an, die Sie vergleichen, mischen und verfeinern können. Diese Haltung gibt Ihnen Kontrolle und beschleunigt die Iteration.

Das ist besonders mächtig bei Produktoberflächen (Onboarding-Flows, UI-Texte, Formulierungen in Feature-Spezifikationen). Wenn Sie z. B. intern oder für eine einfache Kunden-App in Koder.ai arbeiten, können Sie denselben "mehrere Versionen erzeugen"-Ansatz in der Planungs-Ansicht nutzen, um verschiedene Bildschirme, Flows und Anforderungen zu explorieren, bevor Sie sich festlegen — und Snapshots bzw. Rollbacks sorgen für Sicherheit bei schnellen Änderungen.

Grenzen angeben, damit Varianten vergleichbar sind

Wenn Sie einfach „schreib das für mich“ verlangen, erhalten Sie oft generische Ergebnisse. Besser: Definieren Sie Grenzen, damit die KI innerhalb dieser erkunden kann.

Geben Sie an:

- Zielgruppe + Absicht: „Neunutzer, die sich entscheiden sollen, sich anzumelden“ vs. „Bestehende Kunden, die Beruhigung brauchen".

- Ton: freundlich, direkt, formell, verspielt (einen wählen).

- Länge: z. B. „120–150 Wörter" oder „max. 3 Bullet Points".

- Format: E-Mail, Landing-Page-Headline, FAQ, Release-Note.

- Unveränderliche Fakten: Preise, Daten, Garantien, Produktbeschränkungen.

- Zu vermeidende Inhalte: verbotene Aussagen, heikle Formulierungen, Erwähnung von Wettbewerbern.

Mit Einschränkungen können Sie „Version A: knapp“, „Version B: empathischer“, „Version C: konkreter“ erzeugen, ohne Genauigkeit zu opfern.

Mehrere Optionen erzeugen, dann auswählen (oder kombinieren)

Fordern Sie 3–5 Alternativen in einem Durchgang an und machen Sie die Unterschiede deutlich: „Jede Version soll eine andere Struktur und einen anderen Einstiegssatz nutzen.“ Das erzeugt echten Kontrast und hilft zu erkennen, was fehlt und was wirkt.

Ein praktischer Workflow:

- Generieren Sie 3–5 Versionen.

- Wählen Sie die stärksten Teile aus (Einstieg aus A, Belege aus C, CTA aus B).

- Bitten Sie die KI, diese zu einem Entwurf zu verschmelzen, unter Beibehaltung Ihrer unveränderlichen Fakten.

Schnell-Checkliste: was ein „guter Entwurf" enthalten sollte

Bevor Sie einen Entwurf zur Prüfung oder zum Testen schicken, prüfen Sie, ob er hat:

- ein klares Ziel (was der Leser tun/verstehen soll)

- die wichtigsten Fakten intakt und konsistent

- einen konkreten, glaubwürdigen Grund zur Aufmerksamkeit (Nutzen + Beleg)

- eine primäre Handlungsaufforderung

- einfache Sprache mit minimalem Jargon

- keine unbelegten Versprechen oder vage Superlative

So ersetzt KI nicht das Urteil — sie beschleunigt die Suche nach einer besseren Version.

KI als Reviewer: Probleme früh erkennen

Vor dem Veröffentlichen eines Entwurfs — ob Produktspezifikation, Release-Note, Hilfsartikel oder Marketing-Page — kann ein KI-Tool als schneller „Erst-Reviewer“ fungieren. Ziel ist nicht, menschliches Urteil zu ersetzen, sondern offensichtliche Probleme aufzudecken, damit Ihr Team Zeit für die wirklich schwierigen Entscheidungen hat.

Wobei KI-unterstützte Reviews besonders helfen

KI-Reviews sind besonders nützlich für:

- Klarheit: lange Sätze, unklare Begriffe oder fehlender Kontext für neue Leser erkennen

- Konsistenz: Namensgebung (Feature-Labels, Groß-/Kleinschreibung), wiederholte Behauptungen und Widersprüche prüfen

- Ton: die Stimme an die Zielgruppe anpassen (freundlich, direkt, formell) und Formulierungen kennzeichnen, die defensiv oder vage wirken

- Vollständigkeit: fehlende Schritte, Randfälle, Voraussetzungen oder „was passiert als Nächstes" aufzeigen

Praktische Review-Prompts, die Sie wiederverwenden können

Fügen Sie Ihren Entwurf ein und bitten Sie um eine bestimmte Art von Kritik. Zum Beispiel:

- „Prüfe auf Lücken: Welche Fragen hat ein Erstnutzer noch?“

- „Markiere Annahmen: Wovon gehe ich über Produkt, Nutzer oder Workflow aus?"

- „Vereinfache: Schreib jeden Satz über 25 Wörter um, ohne die Bedeutung zu ändern."

- "Prüfe auf Inkonsistenzen: Liste Begriffe auf, die unterschiedlich verwendet werden."

Rollenbasierte Kritiken zur Erweiterung der Perspektive

Eine schnelle Möglichkeit, die Perspektive zu verbreitern, ist das Modell zu bitten, aus verschiedenen Rollen zu prüfen:

- „Als Kunde: was wirkt verwirrend oder riskant?“

- „Als Support: welche Tickets könnte das erzeugen?“

- „Als PM: welche Akzeptanzkriterien fehlen?“

- „Als Recht/Compliance: welche Aussagen müssen präziser formuliert werden?"

Sicherheits-Check: Fakten verifizieren

KI kann souverän Formulierungen kritisieren und dabei über Produktdetails falsch liegen. Behandeln Sie faktische Elemente — Preise, Verfügbarkeit von Features, Sicherheitsbehauptungen, Zeitpläne — als "zu verifizieren". Gewöhnen Sie sich daran, Behauptungen mit Quellen (Links zu Docs, Tickets oder Entscheidungen) zu kennzeichnen, damit die finale Version die Realität widerspiegelt und nicht eine plausibel klingende Vermutung.

Feedback in Edits, Tasks und Akzeptanzkriterien überführen

Rohes Feedback ist selten direkt implementierbar. Es ist oft emotional ("das fühlt sich falsch an"), gemischt ("ich mag es, aber...") oder unpräzise ("mach es klarer"). KI kann helfen, das in Arbeitspakete zu übersetzen — und das Original-Feedback beizufügen, damit Entscheidungen später begründbar sind.

Einfaches Template, das die KI ausfüllen kann

Bitten Sie die KI, jedes Feedback nach dieser Struktur umzuschreiben:

Problem → Beleg → Vorgeschlagene Änderung → Erfolgsmetrik

- Problem: Was funktioniert nicht?

- Beleg: Was hat der Nutzer gesagt/getan? Zitat, Screenshot-Referenz oder Zeitstempel.

- Vorgeschlagene Änderung: Was wird geändert (eine Änderung pro Item).

- Erfolgsmetrik: Woran messen Sie die Verbesserung (qualitativ oder quantitativ).

Das erzwingt Klarheit, ohne neue Anforderungen zu erfinden.

Vage Notizen in abgesteckte Tasks umwandeln

Beispiel-Input-Feedback:

„Die Checkout-Seite ist verwirrend und dauert zu lange."

KI-unterstützte Ausgabe (von Ihnen editierbar):

- Problem: Nutzer verstehen die Schritte nicht und brechen beim Checkout ab.

- Beleg: 6/20 Interviewten fragten "Was kommt als Nächstes?"; Analytics zeigen einen Abfall von 38 % zwischen Versand → Zahlung (10.–20. Dez).

- Vorgeschlagene Änderung: Progress-Indikator mit 3 Schritten hinzufügen und den Primärbutton von „Weiter" zu „Weiter zur Zahlung" umbenennen.

- Erfolgsmetrik: Drop-off von Versand → Zahlung innerhalb von 2 Wochen von 38 % auf ≤30 % reduzieren.

Dann wandeln Sie das in eine Aufgabe mit Abgrenzungen:

Task: Progress-Indikator hinzufügen + Button-Label im Checkout aktualisieren.

Out of scope: Zahlungsanbieter wechseln, komplettes Checkout-Redesign, alle Produkttexte neu schreiben.

Akzeptanzkriterien (testbar machen)

Nutzen Sie KI, um Akzeptanzkriterien zu entwerfen, und straffen Sie sie anschließend:

- Progress-Indikator erscheint auf Mobil- und Desktop-Ansichten.

- Schritte spiegeln den aktuellen Zustand (Versand, Zahlung, Review) wider.

- Button-Label wird auf Versand- und Zahlungsbildschirm aktualisiert.

- Keine Änderungen an Preisen, Steuern oder Zahlungsabwicklung.

Feedback nachvollziehbar halten

Speichern Sie immer:

- das Originalfeedback (Zitat/Call-Link/Ticket)

- die KI-transformierte Aufgabe

- die finale Entscheidung und die Begründung

Diese Nachvollziehbarkeit schützt Verantwortlichkeit, verhindert "die KI hat gesagt"-Entscheidungen und macht künftige Iterationen schneller, weil Sie sehen, was sich geändert hat — und warum.

Tests für Verbesserungen: Experimente, die KI beschleunigen kann

Iteration zur Gewohnheit machen

Als Team schneller werden, indem Entscheidungen, Builds und Releases an einem Ort gebündelt werden.

Iteration wird real, wenn Sie eine Änderung gegen ein messbares Ergebnis testen. KI kann helfen, kleine, schnelle Experimente zu entwerfen — ohne jede Verbesserung in ein Wochenprojekt zu verwandeln.

Ein praktisches Template ist:

- Hypothese: Wenn wir X ändern, dann verbessert sich Y weil Z.

- Varianten: Version A (aktuell) vs. Version B (eine gezielte Änderung).

- Erfolgsmetrik: Die eine Kennzahl, anhand derer Sie entscheiden (Open Rate, Aktivierungsrate, Conversion-Rate, Time-to-First-Action).

- Zielgruppe + Dauer: Wer es sieht und wie lange.

Bitten Sie die KI, 3–5 Kandidatenhypothesen basierend auf Ihren Feedback-Themen vorzuschlagen und sie in testbare Aussagen mit klaren Metriken umzuschreiben.

Schnelle Beispiele, die KI generieren kann (und die Sie testen)

E-Mail-Betreffzeilen (Metrik: Open Rate):

- A: „Ihr Wochenbericht ist fertig“

- B: „3 Erkenntnisse aus Ihrer Woche (2 Minuten Lesezeit)"

Onboarding-Nachricht (Metrik: Abschlussrate von Schritt 1):

- A: „Willkommen! Lassen Sie uns Ihr Konto einrichten."

- B: „Willkommen — fügen Sie Ihr erstes Projekt hinzu und sehen Sie Ergebnisse in unter 5 Minuten."

UI-Microcopy auf einem Button (Metrik: Klickrate):

- A: „Absenden"

- B: „Speichern und fortfahren"

KI erzeugt hier schnell mehrere plausible Varianten — unterschiedliche Töne, Längen und Wertversprechen — sodass Sie eine klare Änderung zum Testen auswählen können.

Leitplanken: machen Sie den Test interpretierbar

Schnelligkeit ist gut, aber halten Sie Experimente lesbar:

- Ändern Sie wenn möglich nur eine Variable. Eine Headline und Button und Layout auf einmal zu ändern, macht Ergebnisse uninterpretierbar.

- Behalten Sie eine Kontrolle. Version A immer behalten.

- Definieren Sie die Metrik, bevor Sie schauen. Sonst suchen Sie sich Erfolge zusammen.

Ergebnisse messen, nicht nur Eindrücke

KI kann sagen, was „besser klingt“, aber die Nutzer entscheiden. Nutzen Sie KI, um:

- Erfolgsschwellen vorzuschlagen (z. B. „Wir shiften zu B, wenn CTR um 5 %+ steigt")

- eine Ergebnis-Zusammenfassung-Vorlage zu entwerfen

- Erkenntnisse in die nächste Hypothese zu übersetzen

So lehrt jeder Test etwas — auch wenn die neue Version verliert.

Ergebnisse messen und aus jedem Zyklus lernen

Iteration funktioniert nur, wenn Sie feststellen können, ob die letzte Änderung geholfen hat. KI kann den Schritt „Messen → Lernen" beschleunigen, aber Disziplin bleibt nötig: klare Metriken, saubere Vergleiche und schriftliche Entscheidungen.

Wählen Sie Metriken, die zum Ziel passen

Wählen Sie eine kleine Menge an Kennzahlen, die Sie in jedem Zyklus prüfen, gruppiert nach dem, was Sie verbessern wollen:

- Conversion: Anmeldungen, Trial-Starts, Checkout-Abschlüsse, Klickrate auf eine Schlüssel-CTA

- Retention: 7-/30-Tage Rückkehrquote, Churn, Wiederkauf, Feature-Nutzung

- Time-to-complete: Onboarding-Dauer, Time-to-First-Value, Support-Lösungszeit

- Fehler/Qualität: fehlgeschlagene Übermittlungen, Bug-Reports, Rückerstattungsrate, QA-Defektanzahl

- Zufriedenheit: CSAT, NPS, App-Bewertungen, Sentiment in Support-Tickets

Der Schlüssel ist Konsistenz: Wenn Sie Metrik-Definitionen jeden Sprint ändern, lehren Sie sich nichts mit den Zahlen.

KI Ergebnisse zusammenfassen lassen — und aufzeigen, wo sich etwas verändert hat

Wenn Sie Experiment-Readouts, Dashboards oder CSV-Exporte haben, ist KI nützlich, um daraus eine Erzählung zu machen:

- zusammenfassen, was sich bewegt hat (und was nicht) in klarer Sprache

- auffällige Segmente hervorheben: neu vs. wiederkehrend, Gerätetyp, Traffic-Quelle, Region, Tarif, Power-User vs. Gelegenheitsnutzer

- überraschende Korrelationen nennen, die eine tiefere Analyse verdienen (z. B. Conversion insgesamt hoch, aber auf Mobile Safari gesunken)

Praktischer Prompt: fügen Sie Ihre Ergebnis-Tabelle ein und bitten Sie den Assistenten um (1) einen ein-Absatz-Summary, (2) die größten Segmentunterschiede und (3) Folgefragen zur Validierung.

Vorsicht vor falscher Gewissheit

KI kann Ergebnisse sehr sicher klingen lassen, auch wenn sie es nicht sind. Prüfen Sie immer:

- Stichprobengröße: Kleine Samples sind oft Rauschen.

- Saisonale/äußere Ereignisse: Feiertage, Promotions, Ausfälle, PR-Effekte.

- Mehrere simultane Änderungen: Wenn drei Dinge geändert wurden, ist unklar, was die Wirkung verursacht hat.

Ein leichtes Lern-Log führen

Nach jedem Zyklus eine kurze Notiz schreiben:

- Was sich geändert hat (Link zum Ticket oder Doc)

- Was passiert ist (Metriken + auffällige Segmente)

- Was wir denken, was es bedeutet (beste Erklärung)

- Was wir als Nächstes versuchen (eine konkrete Folge)

KI kann den Eintrag entwerfen, aber das Team bestätigt die Schlussfolgerung. Mit der Zeit wird dieses Log Ihr Gedächtnis — Sie wiederholen nicht dieselben Tests, sondern bauen auf Erfolgen auf.

Den Prozess wiederholbar machen: Workflows, die skalieren

In kürzeren Zyklen entwickeln

Feedback schneller in funktionierende Features verwandeln, indem Sie Apps per Chat in Koder.ai bauen.

Geschwindigkeit ist nett, aber Konsistenz macht Iteration effektiv. Ziel ist, aus „das sollten wir verbessern" eine Routine zu machen, die Ihr Team ohne Heldentaten ausführt.

Leichtgewichtige Workflow-Muster

Eine skalierbare Schleife braucht kein schweres Prozessgerüst. Ein paar einfache Gewohnheiten schlagen ein kompliziertes System:

- Wöchentliche Review (30–60 Minuten): Wählen Sie 1–3 Punkte zur Verbesserung, prüfen Sie die Änderungen der letzten Woche und entscheiden Sie, was getestet wird. Bringen Sie KI-vorbereitete Zusammenfassungen (Themen, Top-Beschwerden, aufkommende Risiken), damit das Meeting fokussiert bleibt.

- Change-Log: Führen Sie fortlaufend Notizen, was sich geändert hat, warum und was Sie erwarten. Ein einfaches Doc reicht; die Konsistenz zählt.

- Entscheidungs-Notizen: Für bedeutsame Änderungen die Entscheidung in fünf Zeilen festhalten: Kontext, betrachtete Optionen, Entscheidung, Verantwortlicher, Datum. KI kann das aus Besprechungsnotizen entwerfen, aber Sie bestätigen das Wortlaut.

Prompt-Vorlagen + wiederverwendbare Checklisten

Behandeln Sie Prompts als Assets. Speichern Sie sie in einem gemeinsamen Ordner und versionieren Sie sie wie andere Arbeit.

Pflegen Sie eine kleine Bibliothek:

- Prompt-Vorlagen für wiederkehrende Aufgaben (Feedback zusammenfassen, Varianten erzeugen, für Ton umschreiben, Akzeptanzkriterien generieren).

- Wiederverwendbare Checklisten für Qualität (Klarheit, Vollständigkeit, Compliance, Markenstimme, Barrierefreiheit). Bitten Sie die KI, die Checkliste abzuarbeiten und Lücken hervorzuheben; ein Mensch verifiziert anschließend.

Eine einfache Konvention hilft: „Task + Audience + Constraints" (z. B. "Release-Notes — nicht-technisch — 120 Wörter — Risiken erwähnen").

Menschliche Freigabe bei sensiblen Outputs

Bei allem, was Vertrauen oder Haftung betrifft — Preise, rechtliche Formulierungen, medizinische oder finanzielle Beratung — nutzen Sie KI zum Entwurf und zur Risiko-Kennzeichnung, aber verlangen Sie eine namentliche Freigabe bevor veröffentlicht wird. Machen Sie diesen Schritt explizit, damit er unter Zeitdruck nicht übersprungen wird.

Versionierung, die Verwirrung verhindert

Schnelle Iteration produziert chaotische Dateien, wenn Sie nicht klar labeln. Nutzen Sie ein vorhersehbares Muster wie:

FeatureOrDoc_Scope_V#_YYYY-MM-DD_Owner

Beispiel: OnboardingEmail_NewTrial_V3_2025-12-26_JP.

Wenn KI Optionen erzeugt, behalten Sie sie unter derselben Version (V3A, V3B), damit klar ist, was verglichen wurde und was tatsächlich ausgeliefert wurde.

Häufige Fallstricke, Sicherheitschecks und verantwortungsvoller Einsatz

KI kann Iteration beschleunigen, aber auch Fehler beschleunigen. Behandeln Sie sie wie eine leistungsfähige Teamressource: hilfreich, schnell — und manchmal überzeugend falsch.

Häufige Fehlerquellen (und wie man sie vermeidet)

Zu großes Vertrauen in KI-Ausgaben. Modelle können plausiblen Text, Zusammenfassungen oder „Erkenntnisse" erzeugen, die nicht der Realität entsprechen. Gewöhnen Sie sich an, alles zu prüfen, was Kunden, Budget oder Entscheidungen beeinflusst.

Vage Prompts liefern vage Ergebnisse. Bei Eingaben wie "mach das besser" kommen generische Edits heraus. Definieren Sie Zielgruppe, Ziel, Einschränkungen und was "besser" bedeutet (kürzer, klarer, on-brand, weniger Support-Tickets, höhere Conversion etc.).

Keine Metriken, kein Lernen. Iteration ohne Messung ist nur Veränderung. Legen Sie vorher fest, was Sie verfolgen (Aktivierungsrate, Time-to-First-Value, Churn, NPS-Themen, Fehlerquote) und vergleichen Sie vor/nach.

Umgang mit Daten: Nutzer und Firma schützen

Fügen Sie keine personenbezogenen oder vertraulichen Daten in Tools ein, sofern Ihre Organisation das nicht ausdrücklich erlaubt und Sie die Aufbewahrungs-/Trainingsrichtlinien verstehen.

Praktische Regel: Teilen Sie das Minimum, das nötig ist.

- Entfernen Sie Namen, E-Mails, Telefonnummern, Adressen, Bestell-IDs und Freitext, der sensible Details enthalten könnte.

- Fassen Sie intern zusammen und lassen die KI auf der Zusammenfassung arbeiten.

- Wenn Sie echte Rückmeldungen analysieren müssen, schwärzen Sie zuerst und speichern das Original in Ihrem genehmigten System.

Halluzinationen: Fakten und Quellen verifizieren

KI kann Zahlen, Zitate, Quellen oder Feature-Details erfinden. Wenn Genauigkeit zählt:

- Fragen Sie nach Annahmen und Unsicherheiten ("Wobei bist du unsicher?").

- Fordern Sie Links zu Primärquellen nur an, wenn Sie diese selbst verifizieren können.

- Kreuzen Sie Ergebnisse mit Ihren Docs, Analytics, Changelogs oder Support-Systemen ab.

"Vor dem Veröffentlichen"-Checkliste

Vor jeder Publikation einer KI-unterstützten Änderung führen Sie einen schnellen Durchlauf durch:

- Ziel & Metrik definiert (was Erfolg bedeutet).

- PII / vertrauliche Daten aus Prompts/Logs entfernt.

- Fakten verifiziert (Behauptungen, Zahlen, Richtlinien, Zitate).

- Randfälle geprüft (Accessibility, Ton, rechtliche/Compliance-Hinweise).

- Menschliche Freigabe vom zuständigen Owner (PM, Support, Legal, Brand).

- Rollback-Plan falls die Änderung schlechter performt.

So bleibt KI ein Multiplikator für gutes Urteilsvermögen — nicht dessen Ersatz.