Ziel und Zielgruppe klären

Eine Vergleichsmatrix ist nur so nützlich wie die Entscheidung, bei der sie hilft. Bevor Sie Tabellen, Filter oder Bewertungsregeln entwerfen, legen Sie konkret fest, wer die Seite nutzen wird und welche Entscheidung sie treffen wollen. Das verhindert einen häufigen Fehler: ein schönes Grid bauen, das keine der tatsächlich gestellten Fragen beantwortet.

Primäre Nutzer (und ihre Einschränkungen) identifizieren

Verschiedene Zielgruppen interpretieren denselben „Funktionsvergleich“ sehr unterschiedlich:

- Käufer / Produktverantwortliche wollen Klarheit, schnell eine Shortlist und eine nachprüfbare Begründung.

- Ingenieure benötigen Implementierungsdetails: APIs, SDKs, Integrationsaufwand, Limits, Performance und Fallstricke.

- Beschaffung / Sicherheit interessiert sich für Risiko: Compliance, Zertifikate, Datenresidenz, Verträge und Stabilität des Anbieters.

Wählen Sie für die erste Version eine primäre Zielgruppe. Sekundäre Nutzer können weiterhin unterstützt werden, aber Standardansichten, Terminologie und Prioritäten der Seite sollten die Hauptzielgruppe widerspiegeln.

Entscheidungen auflisten, die die Seite unterstützen soll

Schreiben Sie die konkreten Entscheidungen auf, die die Matrix ermöglichen muss. Beispiele:

- Ein Tool für ein neues Projekt auswählen

- Eine Anbieter-Shortlist für ein RFP erstellen

- Ein bestehendes System mit minimalem Migrationsrisiko ersetzen

- Validieren, ob eine Lösung nicht verhandelbare Anforderungen erfüllt

Diese Entscheidungen bestimmen, welche Kriterien zu Top-Level-Filtern werden, welche als „Details“ landen und welche weggelassen werden können.

Erfolgsmetriken definieren, die zu diesen Entscheidungen passen

Vermeiden Sie vage Ziele wie „Engagement erhöhen“. Wählen Sie Metriken, die Entscheidungsfortschritt widerspiegeln:

- Time to shortlist (z. B. von Landing bis gespeicherter Vergleich)

- Conversion-Aktionen (Demo-Anfragen, Registrierungen, Downloads)

- Abschlussrate für Schlüsselabläufe (Filter → Vergleichen → Export)

- Qualitätssignale (weniger Supportfragen, höhere Vertrauensbewertungen)

Entscheiden, was „technisch“ für Ihre Zielgruppe bedeutet

„Technische Evaluierung“ kann viele Dimensionen umfassen. Stimmen Sie ab, was für Ihre Nutzer am wichtigsten ist, z. B.:

- APIs und Integrationen (Abdeckung, Rate-Limits, Webhooks, Konnektoren)

- Sicherheit und Compliance (SSO, Audit-Logs, SOC 2, Verschlüsselung)

- Preise und Packaging (Tiers, nutzungsbasierte Kosten, versteckte Add-ons)

- Betrieb (Bereitstellungsmodell, Monitoring, SLAs, Support)

Dokumentieren Sie diese Prioritäten in klarer Sprache. Das wird Ihr Nordstern für spätere Entscheidungen: Datenmodell, Bewertungsregeln, UX und SEO.

Datenmodell für Vergleiche entwerfen

Ihr Datenmodell bestimmt, ob die Matrix konsistent, durchsuchbar und leicht zu aktualisieren bleibt. Bevor Sie Bildschirme entwerfen, legen Sie fest, welche „Dinge“ verglichen werden, was gemessen wird und wie Belege gespeichert werden.

Mit Kernentitäten beginnen

Die meisten technischen Vergleichsseiten brauchen ein kleines Set Bausteine:

- Anbieter/Produkte: die verglichenen Einheiten (oft beides: ein Anbieter kann mehrere Produkte anbieten).

- Kategorien: Gruppierungen wie „Sicherheit“, „Integrationen“ oder „Preise“.

- Kriterien: einzelne Zeilen in der Matrix (z. B. „SAML SSO“, „Exportformate“, „Uptime-SLA").

- Belege: was einen Wert stützt (Zitat aus Docs, Screenshot-Referenz, Vertragsnotiz, Testergebnis).

- Quellen: woher der Beleg stammt (öffentliche Doku, E-Mail vom Vertrieb, Kundeninterview, interner Test).

Modellieren Sie Kriterien als wiederverwendbare Objekte und speichern Sie den Wert jedes Anbieters/Produkts als separaten Datensatz (häufig „Assessment“ oder „Criterion Result“ genannt). So können Sie neue Anbieter hinzufügen, ohne die Kriterienliste zu duplizieren.

Geeigneten Datentyp pro Kriterium wählen

Vermeiden Sie, alles als freien Text abzulegen. Wählen Sie einen Typ, der zu Filter- und Vergleichsbedarf passt:

- Boolean (Ja/Nein) für Verfügbarkeit

- Numerisch für Limits und Performance (und speichern Sie Einheiten)

- Text für Nuancen (kurz halten; längere Notizen woanders)

- Multi-Select für Listen wie unterstützte Plattformen oder Compliance-Standards

Entscheiden Sie außerdem, wie Sie „Unbekannt“, „Nicht anwendbar“ und „Geplant“ darstellen, damit leere Felder nicht als „Nein“ gelesen werden.

Für Veränderung planen: Versionen und Zeitstempel

Kriterien entwickeln sich. Speichern Sie:

- Gültigkeitsdaten (wann ein Wert verifiziert wurde)

- Zuletzt überprüft Zeitstempel pro Ergebnis

- Optionale Kriterien-Versionen, damit Umbenennungen oder Aufteilungen von Kriterien die Historie nicht zerstören

Öffentliche Fakten von internen Notizen trennen

Erstellen Sie Felder (oder eine separate Tabelle) für interne Kommentare, Verhandlungsdetails und Reviewer-Confidence. Öffentliche Seiten sollten den Wert und die Belege zeigen; interne Ansichten können ehrlichen Kontext und Folgeaufgaben enthalten.

Seitenstruktur und URLs planen

Eine Vergleichsmatrix-Seite ist dann erfolgreich, wenn Besucher vorhersagen können, wo Informationen liegen und wie sie dorthin gelangen. Entscheiden Sie eine Informationsarchitektur, die widerspiegelt, wie Menschen Optionen bewerten.

Konsistente Kategorie-Hierarchie erstellen

Starten Sie mit einer einfachen, stabilen Taxonomie, die sich nicht jedes Quartal ändert. Denken Sie in „Problemfeldern“ statt in Anbieternamen.

Beispiele:

- Monitoring

- CI/CD

- IAM

- Data Warehousing

- API-Gateways

Halten Sie die Struktur flach (meist reichen 2 Ebenen). Wenn Sie mehr Nuance brauchen, nutzen Sie Tags oder Filter (z. B. „Open-source“, „SOC 2“, „Self-hosted“) statt tiefer Verschachtelung. Das hilft beim Durchstöbern und verhindert Duplicate Content später.

Kernseitentypen planen

Gestalten Sie die Website um einige wiederholbare Seitentemplates:

- Kategorie-Hub: erklärt die Kategorie, listet Produkte, hebt gängige Kriterien hervor und bietet Einstiegspunkte zum Vergleichen.

- Produktseite: Profil eines einzelnen Anbieters/Tools mit Fähigkeiten, Einschränkungen, Preisnotizen, Integrationen und „Best for“-Empfehlungen.

- Vergleichsseite: nebeneinander Ansicht für zwei oder mehr Produkte mit Kriterienzeilen, ggf. Scoring und Notizen.

Fügen Sie unterstützende Seiten hinzu, die Verwirrung reduzieren und Glaubwürdigkeit stärken:

- Methodik (wie bewertet wird, was getestet wird, wie oft aktualisiert)

- Glossar (Kriterien und Akronyme definieren)

- Kontakt (Korrekturen, Partnerschaften, Datenquellen)

URL-Patterns wählen, die skalieren

Legen Sie URL-Regeln früh fest, damit später keine chaotischen Redirects entstehen. Zwei gängige Patterns:

- Vergleiche:

/compare/a-vs-b (oder /compare/a-vs-b-vs-c für Mehrfachvergleiche)

- Kategorien:

/category/ci-cd

Halten Sie URLs kurz, kleingeschrieben und konsistent. Verwenden Sie den kanonischen Namen des Produkts (oder einen stabilen Slug), damit dasselbe Tool nicht als /product/okta und /product/okta-iam landet.

Entscheiden Sie abschließend, wie Filter und Sortierung URLs beeinflussen. Wenn gefilterte Ansichten teilbar sein sollen, planen Sie saubere Query-Strings (z. B. ?deployment=saas&compliance=soc2) und halten Sie die Basisseite ohne Parameter nutzbar.

Kriterien, Scoring und Gewichtungsregeln definieren

Eine Vergleichsmatrix hilft nur, wenn die Regeln konsistent sind. Bevor Sie weitere Anbieter oder Kriterien aufnehmen, legen Sie die „Mathematik“ und die Bedeutung jedes Felds fest. Das vermeidet endlose Diskussionen („Was meinten wir mit SSO-Unterstützung?“) und macht Ihre Ergebnisse verteidigungsfähig.

Kriteriennamen und -definitionen standardisieren

Starten Sie mit einer kanonischen Kriterienliste und behandeln Sie sie wie ein Produktspec. Jedes Kriterium sollte haben:

- Einen klaren Namen (kurz, gut scannbar, einzigartig)

- Eine Definition, die Mehrdeutigkeiten ausräumt

- Den Umfang (was eingeschlossen/ausgeschlossen ist)

- Die erwarteten Belege zur Untermauerung einer Bewertung (Docs, Screenshots, Testergebnisse)

Vermeiden Sie nahe Duplikate wie „Compliance“ vs. „Zertifizierungen“, es sei denn, die Unterscheidung ist explizit. Wenn Varianten nötig sind (z. B. „Encryption at rest“ und „Encryption in transit“), machen Sie separate Kriterien mit eigenen Definitionen.

Bewertungsrichtlinien erstellen, denen Menschen folgen können

Scores sind nur vergleichbar, wenn alle dieselbe Skala nutzen. Schreiben Sie Bewertungsrubriken, die zum Kriterium passen:

- 1–5-Skala, wenn partielle Unterstützung zählt (Usability, Reife, Integrationen)

- Pass/Fail, wenn es binär ist (unterstützt SAML? ja/nein)

- Numerische Werte, wenn direkt messbar (Preis, Latenz, maximale Aufbewahrung)

Definieren Sie, was jeder Punkt bedeutet. Beispiel: „3“ = „erfüllt die Anforderung mit Einschränkungen“, „5" = „vollständig mit erweiterten Optionen und bewährten Deployments“. Legen Sie auch fest, ob „N/A“ erlaubt ist und wann.

Gewichtungen entscheiden (oder weglassen)

Gewichtung verändert das Narrativ Ihrer Matrix — wählen Sie bewusst:

- Standardgewichte: gut für eine redaktionelle Rangliste; begründen Sie die Wahl.

- Benutzerdefinierte Gewichte: ideal für unterschiedliche Zielgruppen; lassen Sie Nutzer anpassen und sehen, wie Totale sich ändern.

- Keine Gewichte: am neutralsten; fokussieren Sie auf direkte Unterschiede.

Wenn Sie benutzerdefinierte Gewichte unterstützen, definieren Sie Guardrails (z. B. Gewichte müssen 100 ergeben oder nutzen Sie niedrig/mittel/hoch-Presets).

Unbekanntes und fehlende Daten behandeln

Fehlende Daten sind unvermeidlich. Dokumentieren Sie Ihre Regel und wenden Sie sie überall an:

- Verwenden Sie „Unbekannt“, wenn Sie nicht bestätigen konnten (und halten Sie es von „Nein“ getrennt).

- Entscheiden Sie, ob Unbekanntes als 0, neutral oder ausgeschlossen aus Totalscores zählt.

- Protokollieren Sie warum es unbekannt ist (Anbieter nicht geantwortet, Feature unklar, nicht getestet).

Diese Richtlinien halten Ihre Matrix fair, reproduzierbar und vertrauenswürdig, während sie wächst.

UX-Pattern, damit Unterschiede offensichtlich werden

Später mobil erweitern

Erstelle eine Flutter-Begleit-App für gespeicherte Vergleiche und mobile Überprüfungen, wenn es sinnvoll ist.

Die Vergleichs-UI steht und fällt damit, ob Lesende schnell erkennen können, was sich wesentlich unterscheidet. Legen Sie eine primäre Vergleichsansicht und visuelle Hinweise fest, die Kontraste hervorheben.

Wählen Sie Ihre primäre Ansicht (und bleiben Sie dabei)

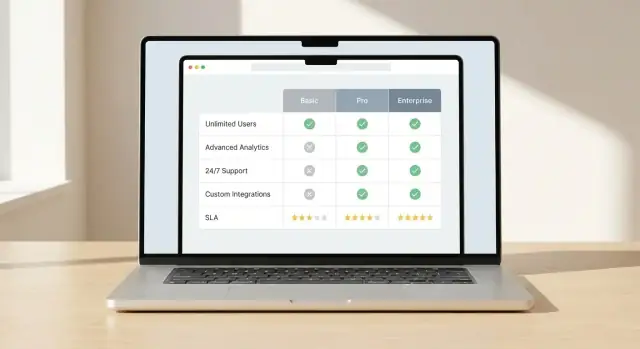

Entscheiden Sie sich für ein Hauptmuster und gestalten Sie alles darum herum:

- Tabellenmatrix für tiefe, zeilenweise Featurevergleiche über viele Optionen hinweg.

- Kartenvergleich für die Zusammenfassung weniger Optionen mit klaren Vor-/Nachteilen und Kernangaben.

- Hybrid wenn beides nötig ist: Karten für die „Headline“, Matrix darunter für Details.

Konsistenz ist wichtig. Wenn Nutzer einmal gelernt haben, wie Unterschiede angezeigt werden, sollten dieselben Regeln überall gelten.

Unterschiede visuell hervorheben

Vermeiden Sie, dass Leute jede Zelle scannen müssen. Nutzen Sie gezielte Hervorhebungen:

- Betonen Sie Deltas, nicht Gleichheit (z. B. fett die Werte, die abweichen).

- Fügen Sie „nur in A“ oder „in B fehlt“ Indikatoren für Features hinzu, die nur in einer Option existieren.

- Verwenden Sie dezente Hintergrundschattierungen für die „wichtigsten“ Kriterien, damit das Auge zuerst dort landet.

Halten Sie Farbzuweisungen einfach und zugänglich: eine Farbe für „besser“, eine für „schlechter“ und eine neutrale. Verlassen Sie sich nicht ausschließlich auf Farbe — ergänzen Sie mit Icons oder kurzen Labels.

Lange Tabellen nutzbar machen

Lange Matrizen sind in technischen Evaluierungen normal. Machen Sie sie bedienbar:

- Sticky Headers, damit Spaltennamen sichtbar bleiben

- Sticky erste Spalte, damit Kriterienlabels nicht verschwinden

- Column Pinning, damit Leser einen Anbieter fixieren und andere scrollen können

Mobil von Anfang an mitdenken

Mobile Nutzer tolerieren keine winzigen Grids. Bieten Sie:

- Horizontalen Scroll mit klaren Hinweisen (ausgeblendete Kanten, „Wischen zum Vergleichen“)

- Zeilengruppierung (Performance, Sicherheit, Preise) mit einklappbaren Abschnitten

- „Comparison Snapshots“, die 5–8 Schlüssel-Kriterien zuerst zeigen, mit „vollständige Matrix anzeigen" für Tiefe

Wenn Unterschiede leicht erkennbar sind, vertrauen Leser der Matrix und nutzen sie weiter.

Filterung, Sortierung und Nebeneinander-Vergleich bauen

Eine Vergleichsmatrix fühlt sich nur dann „schnell“ an, wenn Nutzer die Liste eingrenzen und ohne langes Scrollen sinnvolle Unterschiede sehen können. Filter, Sortierung und Side-by-Side-Ansichten sind die Kerninteraktionen dafür.

Filter, die zu Entscheidungsfragen passen

Starten Sie mit einer kleinen Menge Filter, die echte Bewertungsfragen abbilden, nicht nur, was leicht zu speichern ist. Nützliche Filter:

- Kategorie (z. B. Monitoring, CI/CD, Data Warehouse)

- Plattform (Web, Mobile, Desktop, API-only)

- Preisklasse (Free, Starter, Enterprise)

- Bereitstellungsmodell (SaaS, Self-hosted, Hybrid)

Ermöglichen Sie Kombinationen von Filtern. Zeigen Sie an, wie viele Einträge übrig bleiben, und machen Sie das Löschen von Filtern offensichtlich. Wenn manche Filter sich ausschließen, verhindern Sie ungültige Kombinationen statt bloß „0 Ergebnisse“ zu zeigen.

Sortierung, die beantwortet „Worauf soll ich zuerst schauen?“

Sortierung sollte objektive und zielgruppenspezifische Prioritäten abbilden. Bieten Sie einige klare Optionen wie:

- Bestes Ergebnis (gemäß Ihren Bewertungsregeln)

- Meiste Funktionen (Anzahl unterstützter Kriterien)

- Neueste Aktualisierung (zuletzt verifizierte Review oder Produkt-Update)

Wenn Sie „bestes Ergebnis“ zeigen, erläutern Sie, was dieser Score bedeutet (Gesamt vs. Kategorien-Score) und lassen Sie Nutzer die Bewertungsansicht wechseln. Vermeiden Sie versteckte Defaults.

Nebeneinander-Vergleich (2–5 Items)

Erlauben Sie Nutzern, eine kleine Auswahl (typisch 2–5) zu markieren und in einem festen Spaltenlayout zu vergleichen. Halten Sie die wichtigsten Kriterien oben fixiert und gruppieren Sie den Rest in einklappbare Abschnitte, um Überforderung zu reduzieren.

Machen Sie den Vergleich teilbar per Link, der Auswahlen, Filter und Sortierung bewahrt. So können Teams dieselbe Shortlist prüfen, ohne sie neu zusammenstellen zu müssen.

Exportoptionen, wenn sie passen

Exporte sind für interne Reviews, Beschaffung und Offline-Diskussionen wertvoll. Bieten Sie, falls relevant, CSV (für Analysen) und PDF (zum Teilen) an. Halten Sie Exporte fokussiert: ausgewählte Items, gewählte Kriterien, Zeitstempel und Bewertungsnotizen, damit die Datei später nicht irreführend ist.

Belege, Transparenz und Vertrauenssignale hinzufügen

Volle Kontrolle behalten

Exportiere jederzeit den Quellcode, damit dein Team das Projekt erweitern oder selbst verwalten kann.

Leser nutzen Ihre Matrix nur zur Entscheidungsfindung, wenn sie ihr vertrauen. Seiten, die starke Behauptungen ohne Quellen oder Aktualitätsangaben machen, wirken voreingenommen oder veraltet.

Zu jeder Aussage eine Quelle anfügen

Behandle jede Zelle als Aussage, die Belege braucht. Für faktische Angaben (Preislimits, API-Verfügbarkeit, Zertifizierungen) speichern Sie ein „Quelle“-Feld neben dem Wert:

- Verweis auf Anbieter-Dokumentation (Seitentitel oder Abschnitt)

- Release-Note-Referenz (Version/Datum)

- Internes Testergebnis (Testname, Umgebung, Zeitstempel)

In der UI machen Sie die Quelle sichtbar, ohne zu überfrachten: ein kleines „Quelle“-Label in einem Tooltip oder eine aufklappbare Zeile funktioniert gut.

„Zuletzt verifiziert“ und Ownership anzeigen

Fügen Sie Metadaten hinzu, die zwei Fragen beantworten: „Wie aktuell ist das?“ und „Wer steht dahinter?"

Zeigen Sie ein „Zuletzt verifiziert“-Datum für jedes Produkt (und optional für jedes Kriterium) sowie einen „Owner“ (Team oder Person), der die Überprüfung verantwortet. Das ist besonders wichtig bei schnell wechselnden Punkten wie Feature-Flags, Integrationen und SLA-Bedingungen.

Vertrauensindikatoren für Grauzonen nutzen

Nicht alles ist binär. Für subjektive Kriterien (Einrichtungsaufwand, Qualität des Supports) oder unvollständige Punkte (Anbieter hat Details nicht veröffentlicht) zeigen Sie Vertrauensstufen an wie:

- Hoch: gemessen oder klar dokumentiert

- Mittel: teilweise dokumentiert oder abgeleitet

- Niedrig: anekdotisch oder unbestätigt

Das verhindert falsche Präzision und ermutigt Leser, in die Notizen zu schauen.

Änderungsprotokoll für relevante Updates

Auf jeder Produktseite sollte es ein kleines Änderungsprotokoll geben, wenn Schlüssel-Felder sich ändern (Preise, große Features, Sicherheitslage). Leser sehen so schnell, was neu ist, und wiederkehrende Stakeholder wissen, dass sie keine veralteten Informationen vergleichen.

Content-Management und Update-Workflows einrichten

Live-Demo veröffentlichen

Stelle deine Vergleichsseite bereit und hoste sie, wenn du bereit bist, sie echten Nutzern zu zeigen.

Eine Vergleichsmatrix ist nur so nützlich wie ihre Aktualität. Bevor Sie die erste Seite veröffentlichen, legen Sie fest, wer Daten ändern darf, wie Änderungen geprüft werden und wie Sie bei Dutzenden (oder Tausenden) von Zeilen eine konsistente Bewertung sicherstellen.

Wo die Vergleichsdaten leben

Wählen Sie die „Single Source of Truth“ für Ihre Matrixdaten:

- CMS: Am besten, wenn nicht-technische Redakteure Anbieter, Features, Notizen und Belege pflegen. Ein strukturiertes CMS (mit Custom Fields) hält Einträge konsistent.

- Datenbank: Am besten, wenn die Matrix interaktiv und häufig abgefragt wird (Filter, Sort, personalisierte Views). Sie kann über ein Admin-Interface bearbeitet werden.

- Statische Dateien + Build-Step (CSV/JSON im Repo): Gut für kleinere Teams, die starke Versionierung und vorhersehbare Releases wollen. Änderungen werden mit Build und Deploy veröffentlicht.

Wichtig ist nicht die Technik, sondern ob Ihr Team zuverlässig und ohne Brüche aktualisieren kann.

Update-Workflows (Review, Freigabe, Audit Trail)

Behandeln Sie Änderungen wie Produkt-Releases, nicht als beiläufige Edits.

Ein praktischer Workflow:

- Draft: Ein Redakteur fügt Anbieterdetails, Scores und Notizen hinzu oder aktualisiert sie.

- Review: Ein Fachexperte prüft die Richtigkeit und bestätigt die korrekte Anwendung der Kriterien.

- Freigabe & Veröffentlichung: Ein finaler Owner genehmigt und veröffentlicht die Änderung.

- Audit-Trail: Protokollieren, wer was geändert hat und warum (mit kurzer Begründung).

Bei häufigen Updates ergänzen Sie leichte Konventionen: Change Requests, ein Standardfeld „Grund der Änderung“ und geplante Review-Zyklen (monatlich/vierteljährlich).

Validierungsregeln, um inkonsistente Bewertungen zu verhindern

Validierung verhindert schleichende Abweichungen in der Matrix:

- Beschränken Sie Scores auf erlaubte Werte (z. B. 0–5 oder „Yes/No/Partial“).

- Erfordern Sie eine Notiz oder Quellenangabe, wenn sich ein Score ändert.

- Sperren Sie berechnete Felder (wie gewichtete Totalwerte), damit Redakteure sie nicht manuell überschreiben.

- Markieren Sie Konflikte, z. B. „Nicht unterstützt“ zusammen mit einem hohen Score.

Import-Pipelines für große Datensätze planen

Manuelle Pflege skaliert nicht. Wenn viele Anbieter oder häufige Datenfeeds existieren, planen Sie:

- CSV-Import für Massen-Updates (neue Anbieter, neue Kriterienspalten, Score-Refreshes)

- API-Sync wenn Daten anderswo entstehen (Preis-Tabellen, Produktkataloge, interne Tools)

- Dry Runs, die Änderungen vorschauen und Validierungsfehler vor dem Veröffentlichen anzeigen

Wenn Ihr Workflow klar und durchgesetzt ist, bleibt die Matrix vertrauenswürdig — und Vertrauen bringt Leute zum Handeln.

Technische Architektur implementieren

Eine Vergleichsmatrix wirkt simpel, aber das Erlebnis hängt davon ab, wie Sie viele strukturierte Daten abfragen, rendern und aktualisieren, ohne Verzögerungen. Ziel: Seiten schnell halten und gleichzeitig dem Team das Veröffentlichen erleichtern.

Rendering-Ansatz wählen

Wählen Sie ein Modell, basierend darauf, wie oft sich Ihre Daten ändern und wie interaktiv die Matrix ist:

- Static Generation: Seiten aus Ihren Daten vorbauen. Hervorragend für Geschwindigkeit und Stabilität, wenn Updates geplant sind (täglich/wöchentlich).

- Server-side Rendering (SSR): Seiten bei Anfrage bauen. Nützlich, wenn Daten oft wechseln oder vom Nutzerkontext abhängen.

- Hybrid: Stabile Seiten vorbauen und interaktive Matrixdaten per API nachladen. Oft die beste Lösung für Anbieter-Vergleiche.

Matrix bei Skalierung schnell halten

Matrizen werden schnell groß (viele Anbieter × viele Kriterien). Planen Sie Performance früh:

- Pagination oder „Mehr laden“ für lange Anbieterlisten

- Row/Column Virtualization, sodass nur sichtbare Zellen gerendert werden

- Caching auf mehreren Ebenen (API-Antworten, Server-Output, Browser-Cache)

- Vorgecompute Aggregates (Gesamt-/Kategorien-Scores), damit die UI nicht alles on-the-fly berechnet

Suche über Anbieter und Kriterien implementieren

Suche sollte Anbietername, Synonyme und wichtige Kriterienlabels abdecken. Für Relevanz indexieren Sie:

- Anbietername + Synonyme

- Kriteriennamen + kurze Beschreibungen

- Tags/Kategorien (z. B. „security“, „pricing“, „open source")

Geben Sie Ergebnisse zurück, die Nutzer direkt zur Anbieterzeile oder zum Kriterienabschnitt führen, nicht nur zu einer generischen Ergebnisseite.

Analytics instrumentieren für echte Entscheidungen

Tracken Sie Events, die Intent und Friktion zeigen:

- Vergleichsaktionen (hinzufügen/entfernen eines Anbieters, Side-by-Side öffnen)

- Filter- und Sortieränderungen

- Exporte (CSV/PDF) und Kopieraktionen

- Outbound-Klicks (Demo anfragen, Dokumentation, Kontakt)

Erfassen Sie aktive Filter und verglichene Anbieter-IDs im Event-Payload, damit Sie lernen können, welche Kriterien Entscheidungen treiben.

Wenn Sie eine Vergleichsseite schnell live bringen wollen — ohne Wochen mit Scaffolding, Admin-CRUD und Basis-Table-UX — kann eine Vibe-Coding-Plattform wie Koder.ai ein praktischer Shortcut sein. Sie können Ihre Entitäten (Produkte, Kriterien, Belege), benötigten Workflows (Review/Freigabe) und Schlüssel-Seiten (Kategorie-Hub, Produktseite, Vergleichsseite) im Chat beschreiben und dann auf der generierten App iterieren.

Koder.ai ist besonders relevant, wenn Ihr Ziel-Stack dessen Defaults entspricht: React im Web, Go im Backend mit PostgreSQL, und optional Flutter, falls Sie später eine mobile Begleit-App für „gespeicherte Vergleiche" möchten. Sie können auch Quellcode exportieren, Snapshots/Rollbacks nutzen, während Sie die Bewertungslogik anpassen, und mit Custom Domains deployen, wenn Sie veröffentlichen möchten.