05. Juni 2025·8 Min

Wie Programmiersprachen die Bedürfnisse ihrer Zeit widerspiegeln

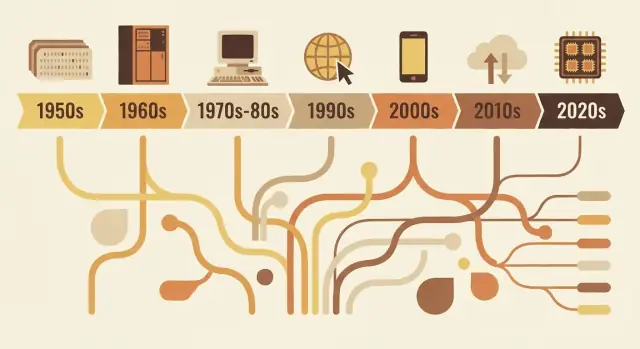

Von FORTRAN bis Rust: Sprachen spiegeln die Prioritäten ihrer Epoche wider — Hardwaregrenzen, Sicherheit, Web oder Teamarbeit. Sehen Sie, wie Design‑Entscheidungen reale Probleme adressieren.

Warum Sprachen so aussehen, wie sie aussehen

Programmiersprachen sind nicht einfach „besser“ oder „schlechter“ zueinander. Sie sind Designantworten auf die Probleme, die zu einem bestimmten Zeitpunkt der Informatik gelöst werden mussten.

Was „Sprachdesign“ eigentlich umfasst

Wenn wir von Sprachdesign sprechen, meinen wir mehr als nur die Optik von Code auf der Seite. Eine Sprache ist ein Bündel von Entscheidungen wie:

- Syntax: wie man Ideen ausdrückt (Schlüsselwörter, Satzzeichen, Lesbarkeit)

- Typen: ob Werte deklarierte Kategorien haben (und wie strikt die Sprache sie prüft)

- Speichermodell: wer verwaltet den Speicher und welche Sicherheitsgarantien gibt es

- Ausführungsmodell: kompiliert vs. interpretiert, Laufzeitverhalten, Performance-Tradeoffs

- Standardbibliothek + Tooling: Pakete, Build‑Systeme, Debugger, Formatierer und wie Teams Software ausliefern

Diese Entscheidungen gruppieren sich häufig um die Beschränkungen der jeweiligen Epoche: knappe Hardware, teure Rechenzeit, fehlende Betriebssystemfunktionen oder (später) große Teams, globale Netzwerke und Sicherheitsbedrohungen.

Die Kernidee

Sprachen spiegeln ihre Zeit wider. Frühe Sprachen priorisierten das Maximieren des Nutzens aus knappen Maschinenressourcen. Spätere priorisierten Portabilität, weil Software auf vielen Systemen laufen musste. Mit wachsenden Projekten rückten Struktur, Abstraktion und Tooling in den Vordergrund, um große Codebasen verständlich zu halten. Jüngere Anforderungen wie Nebenläufigkeit, Cloud‑Deployment und Sicherheit führten wieder zu neuen Kompromissen.

Dieser Artikel konzentriert sich auf repräsentative Beispiele — nicht auf eine vollständige, jährliche Zeitleiste. Sie sehen, wie einige einflussreiche Sprachen die Bedürfnisse ihrer Zeit verkörpern und wie Ideen wiederverwendet und verfeinert werden.

Warum das bei der Werkzeugwahl heute wichtig ist

Zu wissen, warum eine Sprache so gestaltet ist, hilft, ihre Stärken und blinden Flecken vorauszusehen. Es klärt Fragen wie: Ist diese Sprache auf enge Performance, schnelle Iteration, Wartbarkeit in großen Teams oder Sicherheit optimiert? Bei der Entscheidung, was man lernen oder in einem Projekt einsetzen sollte, ist dieser Kontext genauso praktisch wie jede Funktionsliste.

Frühe Rechenzwänge, die alles prägten

Frühe Programmiersprachen wurden weniger von Geschmack als von Physik und Budget bestimmt. Maschinen hatten sehr wenig Speicher, Speicherplatz war knapp und CPUs waren im Vergleich zu heute langsam. Das erzwang ständige Abwägungen: jedes zusätzliche Feature, jede längere Anweisung und jede Abstraktionsschicht hatte reale Kosten.

Kleiner Speicher, teure Zyklen

Wenn nur Platz für ein kleines Programm und einen kleinen Datensatz vorhanden ist, entwirft man Sprachen und Werkzeuge, die Programme kompakt und vorhersehbar halten. Frühe Systeme drängten Entwickler zu einfachem Kontrollfluss und minimaler Laufzeitunterstützung. Selbst „schöne“ Features — wie ausführliche Strings, dynamisches Speichermanagement oder hoch‑levelige Datenstrukturen — konnten unpraktisch sein, weil sie zusätzlichen Code und Verwaltung erforderten.

Batch‑Verarbeitung und lange Feedback‑Schleifen

Viele frühe Programme wurden als Batch‑Jobs ausgeführt. Man bereitete einen Auftrag vor (oft per Lochkarten), reichte ihn ein und wartete. Wenn etwas schiefging, erfuhr man erst später davon — nachdem der Job fertig war oder fehlgeschlagen hatte.

Diese langen Feedbackzyklen veränderten, was wichtig war:

- Programme mussten beim ersten Lauf korrekt arbeiten, weil erneute Ausführungen teuer waren.

- Debugging war langsamer, also setzten Entwickler auf sorgfältige Planung und Konventionen.

- Tooling und interaktive Exploration waren nicht die Standarderfahrung.

Warum Lesbarkeit und Fehlermeldungen nicht Priorität waren

Wenn Maschinenzeit kostbar und Schnittstellen beschränkt waren, optimierten Sprachen nicht für benutzerfreundliche Diagnostik oder Anfängerfreundlichkeit. Fehlermeldungen mussten oft kurz und manchmal kryptisch sein und konzentrierten sich darauf, einem Betreiber zu helfen, ein Problem in einem Kartenstapel oder einer gedruckten Ausgabeseite zu finden.

Wissenschaft und Mathematik trieben frühe Features

Ein großer Teil der frühen Nachfrage kam aus wissenschaftlicher und technischer Arbeit: Berechnungen, Simulationen und numerische Verfahren. Deshalb konzentrierten sich frühe Sprachfeatures oft auf effiziente Arithmetik, Arrays und die Darstellung von Formeln auf eine Weise, die gut zur Hardware und zur Arbeitsweise von Wissenschaftlern auf Papier passte.

FORTRAN, COBOL und sprachen für spezielle Aufgaben

Einige frühe Programmiersprachen versuchten nicht, universell zu sein. Sie wurden gebaut, um eine enge Klasse von Problemen extrem gut zu lösen — weil Computer teuer, Zeit knapp und „gut genug für alles“ oft „nirgendwo wirklich gut“ bedeutete.

FORTRAN: numerische Arbeit, Geschwindigkeit und die Arbeitslast der Wissenschaftler

FORTRAN (FORmula TRANslation) richtete sich klar an Ingenieur‑ und wissenschaftliches Rechnen. Sein zentrales Versprechen war praktisch: Menschen die Möglichkeit geben, mathematisch geprägte Programme zu schreiben, ohne jede Einzelheit in Assembler zu implementieren.

Das Ziel prägte das Design. FORTRAN setzte auf numerische Operationen und array‑ähnliche Berechnungen und strebte hohe Performance an. Die wirkliche Innovation war nicht nur die Syntax, sondern die Idee, dass ein Compiler so effizienten Maschinencode erzeugen konnte, dass Wissenschaftler ihm vertrauen würden. Bei Simulationen, ballistischen Tabellen oder physikalischen Berechnungen ist Zeitersparnis oft entscheidend.

COBOL: Geschäftsdatensätze, Lesbarkeit und Reporting

COBOL zielte auf eine andere Welt: Regierungen, Banken, Versicherungen, Lohn‑ und Gehaltsabrechnung und Inventar. Das sind „Datensätze und Berichte“‑Probleme — strukturierte Daten, vorhersehbare Abläufe und viel Auditbedarf.

Deshalb favorisierte COBOL einen englischähnlichen, ausführlichen Stil, der Programme in großen Organisationen besser überprüfbar und wartbar machte. Datenbeschreibungen waren ein zentrales Anliegen, weil Geschäftssoftware davon lebt, wie gut sie Formulare, Konten und Transaktionen abbildet.

Was „nah an der Domäne“ wirklich bedeutet

Beide Sprachen zeigen ein Prinzip, das bis heute zählt: die verwendete Vokabel sollte die Arbeit widerspiegeln.

FORTRAN spricht die Sprache der Mathematik und Berechnung. COBOL spricht die Sprache von Datensätzen und Prozeduren. Ihre Popularität offenbart die Prioritäten ihrer Zeit: nicht abstrakte Experimente, sondern reale Arbeitslasten effizient erledigen — sei es durch schnellere numerische Berechnung oder klarere Handhabung von Geschäftsdaten und Berichten.

Die Systemära: Portabilität und Kontrolle (C, Unix)

Ende der 1960er und in den 1970er Jahren wurden Computer günstiger und häufiger — aber sie unterschieden sich stark voneinander. Software, die für eine Maschine geschrieben wurde, auf eine andere zu portieren, bedeutete oft, große Teile per Hand umzuschreiben.

Ärger mit Assembler trieb Sprachen nach oben

Viel wichtige Software war in Assembler geschrieben, was maximale Performance und Kontrolle bot — aber zum Preis großer Nachteile: jede CPU hatte einen eigenen Befehlssatz, Code war schwer lesbar und kleine Änderungen konnten Tage sorgfältiger Anpassungen nach sich ziehen. Dieser Schmerz schuf Nachfrage nach einer Sprache, die „nah an der Maschine“ fühlte, einen aber nicht an einen Prozessor fesselte.

Cs Kernziel: portabler Systemcode

C entstand als praktischer Kompromiss. Es wurde entworfen, Betriebssysteme und Tools (insbesondere Unix) zu schreiben und gleichzeitig portabel über Hardware hinweg zu bleiben. C gab Programmierern:

- Eine überschaubare, kleine Menge an Features, die auf vielen Maschinen kompiliert werden konnten

- Direkten Zugriff auf Speicher durch Pointer

- Die Möglichkeit, Low‑Level‑Code zu schreiben, ohne für jede Kleinigkeit zu Assembler zurückkehren zu müssen

Dass Unix in C neu geschrieben wurde, ist der berühmte Nachweis: Das Betriebssystem konnte auf neue Hardware reisen, ohne dass alles in Assembly neu implementiert werden musste.

Warum manueller Speicherverwaltung akzeptabel war

C erwartete, dass man Speicher selbst verwaltet (alloziert, freigibt, Fehler vermeidet). Das erscheint heute riskant, aber es passte zu den Prioritäten der Zeit. Maschinen hatten begrenzte Ressourcen, Betriebssysteme benötigten vorhersehbare Performance, und Programmierer arbeiteten oft nah an der Hardware — manchmal kannten sie sogar das genaue Speicherlayout, das sie wollten.

Der bleibende Tradeoff

C optimierte für Geschwindigkeit und Kontrolle — und es lieferte. Der Preis war Sicherheit und Einfachheit: Buffer Overflows, Abstürze und subtile Bugs wurden zu normalen Gefahren. In jener Epoche galten diese Risiken oft als akzeptabler Preis für Portabilität und Performance.

Große Programme wartbar machen: Struktur und Typen

Als Programme von kleinen, einzelzweckigen Utilities zu Produkten wuchsen, die Unternehmen trugen, dominierte ein neues Problem: nicht nur „funktioniert es?“, sondern „kann man es jahrelang gepflegt halten?“ Früherer Code wurde oft durch Patches und Sprünge mit goto erweitert und produzierte Spaghetti‑Code, der schwer zu lesen, zu testen oder sicher zu ändern war.

Was strukturiertes Programmieren zu beheben versuchte

Strukturiertes Programmieren brachte eine einfache Idee: Code sollte eine klare Form haben. Statt zu beliebigen Zeilen zu springen, nutzten Entwickler wohl definierte Bausteine — if/else, while, for und switch — um den Kontrollfluss vorhersehbar zu machen.

Diese Vorhersehbarkeit war wichtig, weil Debugging oft darin besteht, zu beantworten: „Wie ist die Ausführung hierher gekommen?“ Wenn der Fluss in der Struktur sichtbar ist, verbergen sich weniger Bugs in den Lücken.

Der Aufstieg von Teams und langlebigen Codebasen

Sobald Software Teamarbeit wurde, wurde Wartbarkeit genauso ein soziales wie ein technisches Problem. Neue Teammitglieder mussten Code verstehen, den sie nicht geschrieben hatten. Manager brauchten Schätzungen für Änderungen. Unternehmen brauchten Vertrauen, dass Updates nicht alles kaputt machen.

Sprachen reagierten, indem sie Konventionen förderten, die über die Erinnerung einer einzelnen Person hinaus skalieren: konsistente Funktionsgrenzen, klarere Variable‑Lebensdauern und Möglichkeiten, Code in getrennte Dateien und Bibliotheken zu organisieren.

Warum Typen, Module und Scopes an Wert gewannen

Typen wurden wichtiger, weil sie als „eingebaute Dokumentation“ und frühe Fehlererkennung dienen. Wenn eine Funktion eine Zahl erwartet, aber Text erhält, kann ein starkes Typsystem das früh abfangen. Module und Scopes begrenzten den Explosionsradius von Änderungen. Durch das Verbergen von Details und das Exponieren stabiler Schnittstellen konnten Teams intern refaktorisieren, ohne das ganze Programm neu zu schreiben.

Design‑Maßnahmen, die Komposition unterstützten

Gängige Verbesserungen umfassten:

- Kleinere, gut benannte Funktionen, die genau eine Aufgabe erfüllen

- Lexikalisches Scoping, um unbeabsichtigte Wechselwirkungen zwischen Variablen zu vermeiden

- Bessere Kompositionsmuster (Funktionen/Daten sauber übergeben statt globale Zustände nutzen)

Zusammen verschoben diese Änderungen Sprachen in Richtung Code, der leichter zu lesen, zu reviewen und sicher weiterzuentwickeln ist.

Objekte und Enterprise: warum OOP Mainstream wurde

Gefahrlos iterieren

Sichere deinen Fortschritt mit Snapshots und rolle bei Experimenten sicher zurück.

Objektorientiertes Programmieren (OOP) „gewann“ nicht, weil es die einzige gute Idee war — es gewann, weil es zu dem passte, was viele Teams bauen wollten: langlebige Geschäftsanwendungen, die von vielen Menschen gewartet werden.

Was OOP versprach

OOP bot eine aufgeräumte Erzählung zur Beherrschung von Komplexität: das Programm als Menge von „Objekten“ mit klaren Verantwortlichkeiten.

Kapselung (Interna verbergen) klang wie ein praktischer Weg, versehentliche Brüche zu verhindern. Vererbung und Polymorphie versprachen Wiederverwendung: Ein allgemeines Verhalten einmal schreiben, später spezialisieren und verschiedene Implementierungen unter derselben Schnittstelle austauschen.

Warum GUIs und Geschäftsanwendungen es vorantrieben

Mit dem Aufkommen von Desktop‑Software und grafischen Oberflächen brauchten Entwickler Wege, viele interagierende Komponenten zu verwalten: Fenster, Buttons, Dokumente, Menüs und Events. In Objekten und Nachrichten zu denken, passte gut zu diesen interaktiven Teilen.

Gleichzeitig wuchsen Enterprise‑Systeme in Domänen wie Bankwesen, Versicherungen, Inventar und HR. Diese Umgebungen wertschätzten Konsistenz, Teamarbeit und Codebasen, die jahrelang weiterentwickelt werden konnten. OOP passte zu einem organisatorischen Bedürfnis: Arbeit in Module zu teilen, die von verschiedenen Teams verantwortet werden, Grenzen durchzusetzen und standardisierte Wege zum Hinzufügen von Features zu schaffen.

Wo es half — und wo es unordentlich wurde

OOP glänzt, wenn es stabile Grenzen und wiederverwendbare Komponenten schafft. Es wird schmerzhaft, wenn Entwickler alles übermodellieren, tiefe Klassenhierarchien, „God Objects“ oder Muster schaffen, die eher aus Modegründen eingesetzt werden. Zu viele Schichten können einfache Änderungen mit viel Bürokratie verbinden.

Bleibender Einfluss

Selbst Sprachen, die nicht „rein OOP“ sind, übernahmen viele Defaults: klassenähnliche Strukturen, Interfaces, Zugriffsmodifikatoren und Designmuster. Ein Großteil moderner Syntax spiegelt noch immer den Fokus dieser Ära auf die Organisation großer Teams rund um große Codebasen wider.

Javas Ära: Portabilität, Sicherheit und Enterprise‑Skalierung

Java stieg auf im Kontext eines sehr spezifischen Softwarebooms: große, langlebige Geschäftssysteme, verteilt über eine unübersichtliche Mischung aus Servern, Betriebssystemen und Hardware von verschiedenen Anbietern. Firmen wollten berechenbare Deployments, weniger Abstürze und Teams, die wachsen konnten, ohne alle paar Jahre alles neu schreiben zu müssen.

Was die JVM löste: Portabilität mit einer verwalteten Laufzeit

Statt direkt in Maschinencode zu kompilieren, kompiliert Java zu Bytecode, der auf der Java Virtual Machine (JVM) läuft. Diese JVM wurde zur „Standard‑Schicht“, auf die sich Unternehmen verlassen konnten: dieselbe Anwendungs‑Artefaktdatei ausliefern und sie auf Windows, Linux oder großen Unix‑Systemen mit minimalen Änderungen laufen lassen.

Das ist der Kern von „Einmal schreiben, überall ausführen“ — keine Garantie für null Plattformbesonderheiten, aber ein praktischer Weg, die Kosten und Risiken bei der Unterstützung vieler Umgebungen zu reduzieren.

Sicherheitsdefaults, die Produktionsfehler reduzierten

Java machte Sicherheit zur primären Eigenschaft statt zur optionalen Disziplin.

Garbage Collection reduzierte eine ganze Klasse von Speicherfehlern (dangling pointers, double frees), die in unmanaged Umgebungen häufig waren. Array‑Bounds‑Checks verhinderten das Lesen oder Schreiben außerhalb einer Datenstruktur. Zusammen mit einem strengeren Typsystem zielten diese Entscheidungen darauf ab, katastrophale Abstürze in vorhersehbare Ausnahmen zu verwandeln — leichter zu reproduzieren, zu protokollieren und zu beheben.

Warum es zur Enterprise‑Realität passte

Unternehmen schätzten Stabilität, Tooling und Governance: standardisierte Build‑Prozesse, starke IDE‑Unterstützung, umfangreiche Bibliotheken und eine Laufzeit, die überwacht und verwaltet werden konnte. Die JVM ermöglichte außerdem ein reiches Ökosystem aus Application‑Servern und Frameworks, die Entwicklung in großen Teams konsistenter machten.

Die Tradeoffs: Overhead, Tuning, Komplexität

Javas Vorteile waren nicht kostenlos. Eine verwaltete Laufzeit bringt Startzeit‑ und Speicher‑Overhead, und Garbage Collection kann Latenzspitzen erzeugen, wenn sie nicht getuned wird. Im Laufe der Zeit sammelte das Ökosystem Komplexität an — Schichten von Frameworks, Konfigurationen und Deployment‑Modellen, die spezielles Wissen erforderten.

Dennoch war der Tausch für viele Organisationen lohnenswert: weniger Low‑Level‑Fehler, einfachere plattformübergreifende Bereitstellung und eine gemeinsame Laufzeit, die mit der Größe von Unternehmen und Codebasis skaliert.

Skriptsprachen und der Schub für Produktivität

Verwandle Konzepte in Demos

Erstelle eine funktionierende Demo, um Anforderungen im Team zu prüfen.

Ende der 1990er und in den 2000er Jahren schrieben viele Teams keine Betriebssysteme mehr — sie verbanden Datenbanken, bauten Websites und automatisierten interne Abläufe. Der Engpass verlagerte sich von roher CPU‑Effizienz zu Entwicklerzeit. Schnelleres Feedback und kürzere Release‑Zyklen machten „Wie schnell können wir das ändern?“ zur erstklassigen Anforderung.

Warum schnelle Iteration zur Priorität wurde

Webapps entwickelten sich in Tagen, nicht Jahren. Unternehmen wollten neue Seiten, Reports, Integrationen und schnelle Fehlerbehebungen ohne vollständige Compile–Link–Deploy‑Pipelines. Skriptsprachen passten zu diesem Rhythmus: Datei editieren, ausführen, Ergebnis sehen.

Das veränderte auch, wer Software bauen konnte. Systemadministratoren, Analysten und kleine Teams konnten nützliche Werkzeuge liefern, ohne tiefes Wissen über Speicherverwaltung oder Build‑Systeme.

Dynamische Typisierung und Batteries‑Included‑Ökosysteme

Sprachen wie Python und Ruby setzten auf dynamische Typisierung: Ideen lassen sich mit weniger Deklarationen und Zeremonie ausdrücken. Kombiniert mit starken Standardbibliotheken machten sie gängige Aufgaben oft „einen Import entfernt“ erreichbar:

- Textverarbeitung und Dateioperationen

- HTTP, E‑Mail und grundlegendes Networking

- Datenbankzugriff und Datenformate (CSV, JSON, XML)

Dieser „Batteries‑Included“‑Ansatz belohnte Experimentierfreude und ließ Automatisierungsskripte natürlich zu richtigen Anwendungen wachsen.

Python, Ruby und PHP als praktische Antworten

Python wurde zur Anlaufstelle für Automatisierung und allgemeines Programmieren, Ruby beschleunigte Webentwicklung (insbesondere durch Frameworks) und PHP dominierte frühes Server‑Side‑Web, weil es sich leicht in Seiten einbetten und nahezu überall deployen ließ.

Die Tradeoffs: Geschwindigkeit, Laufzeitfehler, Skalierungspraktiken

Die gleichen Eigenschaften, die Skriptsprachen produktiv machten, brachten auch Kosten mit sich:

- langsamere Ausführung im Vergleich zu kompilierten Sprachen

- mehr Fehler, die zur Laufzeit entdeckt werden

- Skalierung erforderte Disziplin: Tests, Code‑Reviews, Linter und Konventionen

Mit anderen Worten: Skriptsprachen optimierten für Veränderung. Teams lernten, die Zuverlässigkeit mit Tooling und Praktiken zurückzukaufen — was den Boden für moderne Ökosysteme legte, in denen Entwicklergeschwindigkeit und Softwarequalität zugleich erwartet werden.

JavaScript und der browsergetriebene Softwareboom

Der Webbrowser wurde zu einem überraschenden „Computer“, den Millionen von Menschen erhielten. Aber er war kein leerer Zettel: ein Sandbox‑Umfeld, auf unvorhersehbarer Hardware lauffähig und möglichst reaktiv beim Zeichnen von Bildschirmen und Warten auf Netzwerke. Diese Umgebung prägte JavaScripts Rolle stärker als jede abstrakte Idee einer perfekten Sprache.

Eine Plattform mit ungewöhnlichen Beschränkungen

Browser verlangten, dass Code sofort ausgeliefert, sicher neben nicht vertrauenswürdigem Inhalt ausgeführt und die Seite interaktiv bleibt. Das trieb JavaScript in Richtung schneller Startzeiten, dynamischen Verhaltens und APIs, die eng an die Seite gebunden sind: Klicks, Eingaben, Timer und später Netzwerkrequests.

Warum „überall“ wichtiger war als „perfekt"

JavaScript gewann vor allem, weil es bereits vorhanden war. Wenn man Verhalten im Browser wollte, war JavaScript die Standardoption — kein Installationsschritt, keine Rechte, keine separate Laufzeit, die Nutzer herunterladen mussten. Konkurrenzideen sahen auf dem Papier oft sauberer aus, konnten aber nicht die Verbreitungsvorteile von „es läuft auf jeder Seite“ aufwiegen.

Event‑getrieben aus der Notwendigkeit heraus

Der Browser ist fundamental reaktiv: Nutzer klicken, Seiten scrollen, Requests kommen zurück, wann sie zurückkommen. JavaScripts ereignisgesteuerter Stil (Callbacks, Events, Promises) spiegelt diese Realität wider. Statt eines Programms, das von Anfang bis Ende läuft, ist viel Webcode „warte auf etwas, dann reagiere“, was gut zu UI‑ und Netzwerkaufgaben passt.

Langfristige Effekte: Ökosysteme und Kompatibilität

Erfolg erzeugte einen Gravity Well. Riesige Ökosysteme formten sich um Frameworks und Bibliotheken, und die Build‑Pipeline wurde selbst zum Produktkategorie: Transpiler, Bundler, Minifier und Paketmanager. Gleichzeitig bedeutete das Webversprechen der Abwärtskompatibilität, dass alte Entscheidungen haften bleiben — moderne JavaScript‑Entwicklung fühlt sich oft wie Schichten neuer Tools an, die mit den Beschränkungen von gestern zusammenleben müssen.

Nebenläufigkeit und die Multicore‑Realität

Vieles Zeitlang bedeuteten schnellere Computer vor allem eins: dein Programm lief schneller, ohne eine einzige Codezeile zu ändern. Dieses Geschäft hörte auf, als Chips an thermische und Leistungsgrenzen stießen und statt höherer Taktfrequenz zusätzliche Kerne hinzukamen. Plötzlich erforderte mehr Performance oft, mehrere Dinge gleichzeitig zu tun.

Warum Multicore Nebenläufigkeit unvermeidbar machte

Moderne Apps erledigen selten eine einzelne, isolierte Aufgabe. Sie bedienen viele Anfragen, sprechen mit Datenbanken, rendern UI, verarbeiten Dateien und warten auf Netzwerke — alles, während Nutzer sofortige Reaktionen erwarten. Multicore‑Hardware machte paralleles Arbeiten möglich, machte es aber auch schmerzhaft, wenn eine Sprache oder Laufzeit von „einem Hauptthread, einem Fluss“ ausging.

Was Sprachen hinzufügten, um zu helfen

Frühe Nebenläufigkeit nutzte OS‑Threads und Locks. Viele Sprachen spiegelten diese direkt, was funktionierte — aber die Komplexität auf Alltagsentwickler verlagert hat.

Neuere Entwürfe versuchen, gängige Muster zu erleichtern:

- Threads mit sichereren Primitiven: bessere Mutexes, Threadpools und klarere Speichermodelle

- async/await: eine Möglichkeit, nicht blockierenden Code zu schreiben, der dennoch wie sequenzieller Code lesbar ist

- Channels und Message Passing: „Daten durch Kommunikation teilen“ (CSP‑Stil), um Shared‑State‑Bugs zu reduzieren

Server und verteilte Systeme veränderten die Defaults

Als Software zu Always‑On‑Diensten wanderte, wurde das „normale“ Programm ein Server, der tausende gleichzeitige Anfragen bearbeitet. Sprachen begannen, I/O‑schwere Workloads, Abbruch/Timeouts und vorhersehbare Performance unter Last zu optimieren.

Fallstricke, die Sprachen zu verhindern versuchen

Nebenläufigkeitsfehler sind oft selten und schwer reproduzierbar. Sprachdesign zielt zunehmend darauf ab, zu verhindern:

- Race Conditions (zwei Tasks aktualisieren dieselben Daten unvorhersehbar)

- Deadlocks (Tasks warten ewig aufeinander)

- Starvation (einige Arbeit erhält nie CPU‑Zeit)

Die große Verschiebung: Nebenläufigkeit hörte auf, ein fortgeschrittenes Thema zu sein, und wurde zur Basiserwartung.

Moderne Prioritäten: Sicherheit, Einfachheit und Tooling (Go, Rust)

Vom Build zur Bereitstellung

Stelle deine App bereit und hoste sie ohne separate Pipeline einzurichten.

In den 2010er Jahren hatten viele Teams keine Probleme mehr, Algorithmen auszudrücken — sie hatten Probleme, Dienste sicher, stabil und unter ständigem Deploy‑Druck änderbar zu halten. Zwei Probleme stachen hervor: Sicherheitslücken durch Speicherfehler und Entwicklungsbremsen durch überkomplexe Stacks und uneinheitliches Tooling.

Die Bugs beheben, die sich ständig wiederholen

Ein großer Anteil hochschwerwiegender Sicherheitslücken lässt sich auf Speicher‑Sicherheitsprobleme zurückführen: Buffer Overflows, Use‑After‑Free und subtile undefined behavior‑Fälle, die nur unter bestimmten Builds oder Maschinen auftreten. Modernes Sprachdesign behandelt solche „Knallfüße“ zunehmend als inakzeptabel — nicht nur als Programmierfehler.

Rust ist die klarste Antwort. Seine Ownership‑ und Borrowing‑Regeln sind im Grunde ein Deal: Du schreibst Code, der strengen Compile‑Zeit‑Prüfungen genügt, und im Gegenzug erhältst du starke Garantien zur Speichersicherheit ohne Garbage Collector. Das macht Rust attraktiv für Systemcode, der historisch in C/C++ lebte — Netzwerkdienste, Embedded‑Komponenten, performancekritische Bibliotheken — wo Sicherheit und Geschwindigkeit gleichermaßen zählen.

Einfachheit und Services als Standard‑Workload

Go verfolgt nahezu den entgegengesetzten Ansatz: Sprachfeatures bewusst begrenzen, damit Codebasen über große Teams hinweg lesbar und vorhersehbar bleiben. Sein Design reflektiert eine Welt von langfristig laufenden Diensten, APIs und Cloud‑Infrastruktur.

Gos Standardbibliothek und eingebaute Nebenläufigkeitsprimitiven (Goroutinen, Channels) unterstützen Service‑Entwicklung direkt, während sein schneller Compiler und die einfache Abhängigkeitsstory Reibungsverluste im Alltag reduzieren.

Entwicklererlebnis wird zur Eigenschaft

Tooling wandelte sich von „optionalen Extras“ zum Teil des Sprachversprechens. Go normalisierte diese Denkweise mit gofmt und einer Kultur standardisierter Formatierung. Rust zog nach mit rustfmt, clippy und einem stark integrierten Build‑Tool (cargo).

In der heutigen „kontinuierlich liefern“ Umgebung reicht diese Tooling‑Geschichte zunehmend über Compiler und Linter hinaus in höhere Workflows: Planung, Scaffolding und schnellere Iterationszyklen. Plattformen wie Koder.ai spiegeln diesen Wandel, indem sie Teams erlauben, Web‑, Backend‑ und Mobile‑Applikationen per Chat‑gesteuerter Oberfläche zu bauen — anschließend Quellcode exportieren, deployen und mit Snapshots zurückrollen. Das ist ein weiteres Beispiel für dasselbe historische Muster: Die Tools, die sich am schnellsten verbreiten, machen die alltägliche Arbeit der Epoche billiger und weniger fehleranfällig.

Wenn Formatierer, Linter und Build‑Systeme Erstklass‑Bürger sind, verbringen Teams weniger Zeit damit, über Stil zu streiten oder mit inkonsistenten Umgebungen zu kämpfen — und mehr Zeit damit, zuverlässige Software auszuliefern.

Was die heutigen Probleme über zukünftige Sprachen verraten

Programmiersprachen „gewinnen“ nicht, weil sie perfekt sind. Sie gewinnen, wenn sie die alltägliche Arbeit der jeweiligen Epoche billiger, sicherer oder schneller machen — besonders in Kombination mit den passenden Bibliotheken und Deployment‑Gewohnheiten.

KI, Datenarbeit und die Macht von Ökosystemen

Ein großer Treiber aktueller Sprachpopularität ist, wo die Arbeit liegt: Datenpipelines, Analytics, Machine Learning und Automation. Deshalb wächst Python weiter — nicht nur wegen der Syntax, sondern wegen seines Ökosystems: NumPy/Pandas für Daten, PyTorch/TensorFlow für ML, Notebooks zur Exploration und einer großen Community, die wiederverwendbare Bausteine liefert.

SQL ist das leisere Beispiel desselben Effekts. Es ist nicht trendy, aber immer noch das Standard‑Interface zu Geschäftsdaten, weil es zur Aufgabe passt: deklarative Abfragen, berechenbare Optimierer und breite Kompatibilität über Tools und Anbieter hinweg. Neue Sprachen integrieren oft SQL, anstatt es zu ersetzen.

Gleichzeitig treibt performanzintensive KI GPU‑orientiertes Tooling voran. Wir sehen mehr erste Klasse Aufmerksamkeit für Vektorisierung, Batching und Hardware‑Beschleunigung — sei es durch CUDA‑Ökosysteme, MLIR und Compiler‑Stacks oder Sprachen, die das Binden an diese Laufzeiten erleichtern.

Was zukünftige Sprachdesigns formen könnte

Mehrere Druckpunkte werden wahrscheinlich „nächste Ära“ Sprachen und große Sprach‑Updates beeinflussen:

- Verifikation und Korrektheit: stärkere Typsysteme, sicherere Nebenläufigkeit und Tools, die Eigenschaften beweisen statt nur zu testen.

- Privatsphäre und Policy: bessere Unterstützung für Daten‑Governance, Auditierbarkeit und Beschränkungen bei sensiblen Daten.

- Energieverbrauch und Effizienz: Sprachen und Laufzeiten, die schnelles Code‑Schreiben ohne manuelles Mikromanagement erleichtern.

Praktische Erkenntnis

Wählen Sie eine Sprache passend zu Ihren Einschränkungen: Team‑Erfahrung, Talentpool, Bibliotheken, auf die Sie angewiesen sind, Deployment‑Ziele und Zuverlässigkeitsanforderungen. Eine „gute“ Sprache ist oft die, die Ihre häufigsten Aufgaben langweilig macht — und Ihre Fehler leichter zu verhindern und zu diagnostizieren.

Wenn Sie ein Framework‑basiertes Ökosystem brauchen, wählen Sie nach dem Ökosystem; wenn Sie Korrektheit und Kontrolle benötigen, wählen Sie nach Sicherheit und Performance. Für eine tiefere Entscheidungs‑Checkliste, siehe /blog/wie-man-eine-programmiersprache-waehlt.