19 mai 2025·8 min

Créer une application web pour analyser les annulations et tester la rétention

Apprenez à planifier, construire et lancer une application web qui suit les annulations d'abonnement, analyse leurs causes et exécute des expériences de rétention en toute sécurité.

Ce que vous allez construire et pourquoi c’est important

Les annulations sont l'un des moments les plus riches en signal dans une activité par abonnement. Un client vous dit explicitement « ça n’en vaut plus la peine », souvent juste après avoir rencontré une friction, une déception ou un décalage prix/valeur. Si vous traitez l'annulation comme un simple changement de statut, vous perdez une rare occasion d'apprendre ce qui casse — et de le corriger.

Le problème que vous résolvez

La plupart des équipes ne voient le churn que comme un chiffre mensuel. Cela masque l'histoire :

- Qui annule (nouveaux utilisateurs vs clients de longue date, type de forfait, segment)

- Quand ils annulent (jour 1, après l'essai, après une augmentation de prix, après un paiement échoué)

- Pourquoi ils annulent (trop cher, fonctionnalités manquantes, bugs, passage chez un concurrent, « je ne m’en sers pas »)

C'est ce que signifie en pratique l'analyse des annulations d'abonnement : transformer un clic d'annulation en données structurées auxquelles vous pouvez faire confiance et que vous pouvez segmenter.

Ce que signifient les “expériences de rétention”

Une fois que vous voyez des motifs, vous pouvez tester des changements conçus pour réduire le churn — sans deviner. Les expériences de rétention peuvent être des modifications produit, tarifaires ou de message, comme :

- améliorer le flux d'annulation (options plus claires, meilleurs chemins de rétrogradation)

- proposer une pause ou une remise au bon segment

- corriger des lacunes d'onboarding corrélées aux annulations précoces

L'essentiel est de mesurer l'impact avec des données propres et comparables (par exemple, un test A/B).

Ce que vous allez construire dans ce guide

Vous construisez un petit système composé de trois parties connectées :

- Suivi : événements autour du cycle d'abonnement et du flux d'annulation, y compris les raisons.

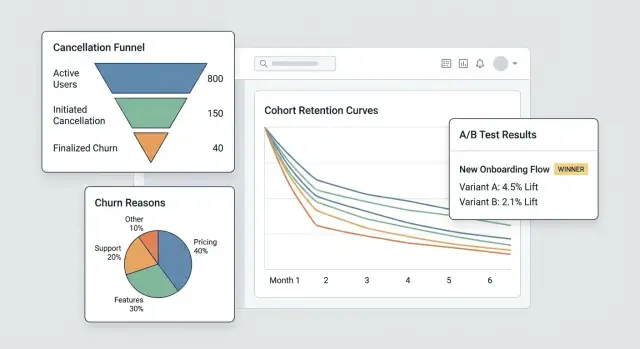

- Un tableau de bord : entonnoirs, cohortes et segments qui dévoilent d'où vient le churn.

- Une boucle d'expérimentations : la capacité à lancer des tests ciblés et à voir si le churn diminue réellement.

À la fin, vous aurez un workflow qui passe de « nous avons eu plus d'annulations » à « ce segment spécifique annule après la semaine 2 à cause de X — et ce changement a réduit le churn de Y % ».

À quoi ressemble le succès

Le succès n'est pas un graphique plus joli — c'est la vitesse et la confiance :

- Des insights plus rapides (en jours, pas en mois)

- Réduction mesurable du churn liée à des changements spécifiques

- Apprentissage reproductible : chaque annulation vous apprend quelque chose sur lequel vous pouvez agir

Définir objectifs, métriques et périmètre pour le MVP

Avant de construire des écrans, du tracking ou des tableaux de bord, clarifiez douloureusement quelles décisions ce MVP doit permettre. Une appli d'analyse d'annulations réussit quand elle répond à quelques questions à haute valeur rapidement — pas quand elle essaie de tout mesurer.

Commencez par les questions qui mènent à l'action

Écrivez les questions auxquelles vous voulez répondre pour la première version. De bonnes questions MVP sont spécifiques et mènent à des étapes évidentes, par exemple :

- Quelles sont les principales raisons d'annulation, et comment diffèrent-elles par forfait, région ou canal d'inscription ?

- Combien de temps faut-il aux clients pour annuler (time-to-cancel), et quels motifs apparaissent dans les 7/30/90 premiers jours ?

- Quels forfaits (ou cycles de facturation) ont le taux d'annulation le plus élevé, et les utilisateurs se rétrogradent-ils avant d'annuler ?

Si une question n'influence pas un changement produit, un playbook support ou une expérience, mettez-la de côté.

Choisissez 3–5 métriques “north star” pour le MVP

Choisissez une courte liste que vous examinerez chaque semaine. Gardez des définitions sans ambiguïté pour que produit, support et direction parlent des mêmes chiffres.

Métriques typiques de départ :

- Taux d'annulation (sur une période définie, ex. hebdomadaire/mensuelle)

- Taux de sauvegarde (part des tentatives d'annulation qui se convertissent en maintien)

- Taux de réactivation (clients qui reviennent après avoir annulé)

- Time-to-cancel (médiane de jours entre le début et l'annulation)

- Distribution des raisons (principales raisons par volume et par impact sur le revenu)

Pour chaque métrique, documentez la formule exacte, la fenêtre temporelle et les exclusions (essais, remboursements, paiements échoués).

Nommez les responsables et les contraintes

Identifiez qui utilisera et maintiendra le système : produit (décisions), support/success (qualité des raisons et suivis), data (définitions et validation), et engineering (instrumentation et fiabilité).

Puis accordez-vous sur les contraintes en amont : exigences de confidentialité (minimisation des PII, limites de conservation), intégrations requises (fournisseur de facturation, CRM, outil de support), calendrier et budget.

Rédigez une page de périmètre pour éviter le feature creep

Gardez-le court : objectifs, utilisateurs principaux, 3–5 métriques, intégrations “indispensables”, et une claire liste de non-objectifs (ex. « pas de suite BI complète », « pas d'attribution multi-touch en v1 »). Cette page devient votre contrat MVP quand de nouvelles demandes arrivent.

Modéliser les abonnements et les événements de cycle de vie

Avant de pouvoir analyser les annulations, vous avez besoin d'un modèle d'abonnement qui reflète comment les clients évoluent réellement dans votre produit. Si vos données ne conservent que le statut actuel de l'abonnement, vous aurez du mal à répondre à des questions basiques comme « combien de temps ont-ils été actifs avant d'annuler ? » ou « les rétrogradations prédisent-elles le churn ? »

Cartographiez le cycle de vie que vous mesurerez

Commencez par une carte de cycle de vie simple et explicite sur laquelle votre équipe est d'accord :

Trial → Active → Downgrade → Cancel → Win-back

Vous pouvez ajouter d'autres états plus tard, mais même cette chaîne de base force la clarté sur ce qui compte comme « actif » (payant ? en période de grâce ?) et ce qui compte comme « win-back » (réactivé dans les 30 jours ? n'importe quand ?).

Définissez les entités centrales

Au minimum, modélisez ces entités pour que les événements et l'argent puissent être liés de façon cohérente :

- User : la personne qui utilise l'app (peut changer dans le temps)

- Account : le contenant facturation/client (souvent la bonne unité pour le churn)

- Subscription : l'accord qui peut démarrer, renouveler, changer ou se terminer

- Plan : le niveau produit (nom, prix, intervalle de facturation)

- Invoice : ce qui a été facturé, quand, et si c'était payé/remboursé

- Cancel event : quand la demande d'annulation a été faite et quand elle a pris effet

Choisissez des identifiants stables (account_id vs user_id)

Pour l'analytics du churn, account_id est généralement l'identifiant primaire le plus sûr parce que les utilisateurs peuvent changer (des employés partent, des admins changent). Vous pouvez toujours attribuer des actions à user_id, mais agrégez la rétention et les annulations au niveau du compte sauf si vous vendez vraiment des abonnements personnels.

Conservez l'historique des statuts, pas seulement un statut

Implémentez un status history (effective_from/effective_to) pour pouvoir interroger les états passés de manière fiable. Cela rend possible l'analyse par cohorte et l'étude du comportement avant l'annulation.

Préparez les cas limites à l'avance

Modélisez explicitement ces cas pour qu'ils ne polluent pas les chiffres de churn :

- Pauses (arrêt temporaire sans annulation)

- Remboursements/chargebacks (retrait de paiement vs churn volontaire)

- Changements de forfait (upgrade/downgrade comme événements, pas « nouveaux abonnements »)

- Périodes de grâce (paiement échoué vs vraie annulation)

Instrumenter le flux d'annulation (événements et raisons)

Si vous voulez comprendre le churn (et améliorer la rétention), le flux d'annulation est votre moment de vérité le plus précieux. Instrumentez-le comme une surface produit, pas comme un simple formulaire — chaque étape doit produire des événements clairs et comparables.

Suivez les étapes clés (et rendez-les impossibles à sauter)

Au minimum, capturez une séquence propre pour pouvoir construire un entonnoir :

cancel_started— l'utilisateur ouvre l'expérience d'annulationoffer_shown— toute offre de sauvegarde, option de pause, chemin de rétrogradation, ou CTA « contacter le support » est affichéeoffer_accepted— l'utilisateur accepte une offre (pause, remise, rétrogradation)cancel_submitted— annulation confirmée

Ces noms d'événements doivent être cohérents entre web/mobile et stables dans le temps. Si vous faites évoluer le payload, incrémentez une version de schéma (ex. schema_version: 2) plutôt que de changer silencieusement les significations.

Capturez le contexte qui explique pourquoi ça s'est produit

Chaque événement lié à l'annulation doit inclure les mêmes champs de contexte afin que vous puissiez segmenter sans deviner :

- plan, ancienneté, prix

- pays, appareil

- canal d'acquisition

Gardez-les comme propriétés sur l'événement (pas déduits plus tard) pour éviter une attribution cassée quand d'autres systèmes changent.

Collectez des raisons de churn exploitables et lisibles

Utilisez une liste de raisons prédéfinies (pour les graphiques) plus un libre texte optionnel (pour la nuance).

cancel_reason_code(ex.too_expensive,missing_feature,switched_competitor)cancel_reason_text(optionnel)

Stockez la raison sur cancel_submitted, et envisagez aussi de la logger quand elle est d'abord sélectionnée (cela aide à détecter l'indécision ou des va-et-vient).

Ne vous arrêtez pas à l'annulation : suivez les issues downstream

Pour mesurer les interventions de rétention, loggez les résultats downstream :

reactivateddowngradedsupport_ticket_opened

Avec ces événements en place, vous pouvez connecter l'intention d'annulation aux résultats — et lancer des expériences sans vous disputer sur ce que les données « signifient vraiment ».

Concevoir votre pipeline de données et le stockage

Une bonne analytics de churn commence par des décisions ennuyeuses mais bien faites : où vivent les événements, comment ils sont nettoyés, et comment tout le monde s'accorde sur ce qu'est « une annulation ».

Choisissez le stockage : OLTP + (optionnel) entrepôt

Pour la plupart des MVPs, stockez d'abord les événements bruts dans la base de votre application (OLTP). C'est simple, transactionnel et facile à interroger pour le debug.

Si vous attendez un fort volume ou des rapports lourds, ajoutez plus tard un entrepôt analytique (réplica Postgres, BigQuery, Snowflake, ClickHouse). Un schéma courant : OLTP pour la « source de vérité » + entrepôt pour des tableaux de bord rapides.

Tables centrales à prévoir

Concevez les tables autour de « ce qui s'est passé » plutôt que « ce que vous pensez avoir besoin ». Un ensemble minimal :

events: une ligne par événement tracké (ex.cancel_started,offer_shown,cancel_submitted) avecuser_id,subscription_id, timestamps et propriétés JSON.cancellation_reasons: lignes normalisées pour les sélections de raison, incluant le libre-texte optionnel.experiment_exposures: qui a vu quelle variante, quand et dans quel contexte (feature flag / nom du test).

Cette séparation garde votre analytics flexible : vous pouvez joindre raisons et expériences aux annulations sans dupliquer les données.

Événements tardifs, doublons et idempotence

Les flux d'annulation génèrent des retries (bouton retour, problèmes réseau, refresh). Ajoutez une idempotency_key (ou event_id) et appliquez une unicité pour que le même événement ne soit pas compté deux fois.

Décidez aussi d'une politique pour les événements tardifs (mobile/offline) : typiquement les accepter, mais utilisez le timestamp original de l'événement pour l'analyse et le temps d'ingestion pour le debug.

ETL/ELT pour la performance des rapports

Même sans entrepôt complet, créez un job léger qui construit des « tables de reporting » (agrégats quotidiens, étapes d'entonnoir, snapshots de cohorte). Cela garde les tableaux de bord rapides et réduit les jointures coûteuses sur les événements bruts.

Documentez les définitions pour que les métriques correspondent

Rédigez un petit dictionnaire de données : noms d'événements, propriétés requises et formules de métriques (ex. « le churn utilise cancel_effective_at »). Mettez-le dans votre repo ou vos docs internes pour que produit, data et engineering interprètent les graphiques de la même façon.

Construire le tableau de bord : entonnoirs, cohortes et segments

Définissez clairement la portée du MVP

Utilisez le mode planification pour définir métriques, schémas et responsables avant d'écrire une ligne de code.

Un bon tableau de bord n'essaie pas de répondre à toutes les questions en même temps. Il doit vous aider à passer de « quelque chose cloche » à « voici le groupe et l'étape exacts qui posent problème » en quelques clics.

Vues principales à utiliser chaque semaine

Commencez par trois vues qui reflètent comment on enquête réellement sur le churn :

- Entonnoir d'annulation : de

cancel_started→ raison sélectionnée →offer_shown→offer_acceptedoucancel_submitted. Cela révèle où les gens abandonnent et où votre flux de sauvegarde (ou non) attire l'attention. - Distribution des raisons : répartition des raisons sélectionnées, avec une catégorie « Autre (libre-texte) » qui peut être échantillonnée. Affichez à la fois les comptes et les % pour que les pics soient évidents.

- Cohortes par mois de démarrage : taux de rétention ou d'annulation par mois de début d'abonnement. Les cohortes rendent plus difficile de se tromper à cause de la saisonnalité ou du mix d'acquisition.

Segments qui rendent les insights actionnables

Chaque graphique doit pouvoir être filtré par les attributs qui affectent le churn et l'acceptation des offres :

- Forfait ou niveau

- Ancienneté (ex. 0–7 jours, 8–30, 31–90, 90+)

- Région / pays

- Source d'acquisition (organique, payant, partenaire, commercial)

- Méthode de paiement (carte, facture, PayPal, etc.)

Gardez la vue par défaut « Tous les clients », mais souvenez-vous : l'objectif est de localiser quelle tranche change, pas seulement si le churn a bougé.

Contrôles temporels et performance du “save flow”

Ajoutez des présélections rapides (7/30/90 derniers jours) plus une plage personnalisée. Utilisez le même contrôle temporel sur toutes les vues pour éviter des comparaisons incohérentes.

Pour le travail de rétention, suivez le save flow comme un mini-entonnoir avec impact business :

- Vues d'offres

- Taux d'acceptation des offres

- Net retained MRR (MRR conservé après remises, crédits ou rétrogradations)

Explorations détaillées sans casser la confiance

Chaque graphique agrégé doit permettre d'explorer la liste des comptes affectés (ex. « clients qui ont choisi ‘Trop cher’ et ont annulé dans les 14 jours »). Incluez des colonnes comme forfait, ancienneté et dernière facture.

Verrouillez l'exploration derrière des permissions (contrôle d'accès par rôle) et envisagez de masquer par défaut les champs sensibles. Le tableau de bord doit permettre l'investigation tout en respectant la vie privée et les règles d'accès internes.

Ajouter un cadre d'expérimentation (A/B tests et ciblage)

Si vous voulez réduire les annulations, il vous faut un moyen fiable de tester des changements (copy, offres, timing, UI) sans vous battre sur des opinions. Un framework d'expérimentation est le « chef de la circulation » qui décide qui voit quoi, l'enregistre et relie les résultats à une variante précise.

1) Définir l'unité d'expérience (éviter la contamination croisée)

Décidez si l'attribution se fait au niveau account ou user.

- Niveau account est généralement le plus sûr pour le SaaS : tout le monde dans le même workspace voit la même variante, ce qui évite les messages mixtes et la contamination des résultats.

- Niveau user peut fonctionner pour les apps grand public, mais attention aux appareils partagés, multiples connexions ou comptes d'équipe.

Notez ce choix pour chaque expérience afin que vos analyses restent cohérentes.

2) Choisissez une méthode d'assignation

Supportez quelques modes de ciblage :

- Random (A/B classique) : bon par défaut.

- Pondéré (ex. 90/10) : utile pour un déploiement prudent.

- Ciblage par règles : n'afficher une variante qu'à des segments spécifiques (niveau de forfait, pays, ancienneté, état « sur le point d'annuler »). Gardez les règles simples et versionnées.

3) Logger l'exposition quand elle se produit vraiment

Ne comptez pas « assigné » comme « exposé ». Enregistrez l'exposition quand l'utilisateur voit effectivement la variante (ex. écran d'annulation rendu, modal d'offre ouvert). Stockez : experiment_id, variant_id, unité id (account/user), timestamp et contexte pertinent (forfait, nombre de sièges).

4) Définir les métriques : principale + garde-fous

Choisissez une métrique de succès principale, comme taux de sauvegarde (cancel_started → résultat retenu). Ajoutez des garde-fous pour éviter des gains nuisibles : contacts support, demandes de remboursement, taux de plaintes, time-to-cancel, ou churn de rétrogradation.

5) Planifier durée et hypothèses de taille d'échantillon

Avant de lancer, décidez :

- Durée minimale (souvent 1–2 cycles de facturation pour les comportements d'abonnement)

- Taille d'échantillon minimale basée sur le taux de sauvegarde actuel et le plus petit lift que vous jugez important

Cela évite d'arrêter tôt sur des données bruitées et aide votre dashboard à indiquer « encore en apprentissage » vs « statistiquement utile ».

Concevoir des interventions de rétention à tester

Instrumentez le parcours d'annulation

Mettez en place le tracking cancel_started, offer_shown et cancel_submitted avec des payloads propres.

Les interventions de rétention sont les « choses » que vous montrez ou proposez lors de l'annulation qui pourraient changer l'avis de quelqu'un — sans lui donner l'impression d'être piégé. L'objectif est d'apprendre quelles options réduisent le churn tout en préservant la confiance.

Variantes d'intervention courantes à essayer

Commencez par un petit menu de motifs que vous pouvez combiner :

- Offres alternatives : remise limitée, mois gratuit, ou prolongation d'essai

- Option de pause : laisser les utilisateurs mettre la facturation en pause 1–3 mois (et fixer les attentes de réactivation)

- Rétrogradation de forfait : basculer vers un niveau moins cher ou moins de sièges au lieu d'une annulation complète

- Texte : copy court et spécifique qui rappelle la valeur (« Exportez vos données à tout moment ») vs copy générique (« Nous sommes désolés de vous voir partir »)

Concevoir des offres qui n’enferment pas les utilisateurs

Rendez chaque choix clair et réversible quand c'est possible. Le chemin « Annuler » doit rester visible et ne pas nécessiter de chasse. Si vous offrez une remise, indiquez exactement sa durée et à quel prix le client reviendra. Si vous offrez une pause, montrez ce qui arrive à l'accès et aux dates de facturation.

Bonne règle : un utilisateur doit pouvoir expliquer en une phrase ce qu'il a sélectionné.

Utilisez la divulgation progressive

Gardez le flux léger :

-

Demandez une raison (un tap)

-

Montrez une réponse ciblée (pause pour « trop cher », rétrogradation pour « je n'utilise pas assez », support pour « bugs »)

-

Confirmez le résultat final (pause/rétrogradation/annulation)

Cela réduit la friction tout en gardant l'expérience pertinente.

Ajoutez une page de résultats et un changelog

Créez une page interne de résultats d'expériences qui montre : conversion vers le résultat « sauvé », taux de churn, lift vs contrôle, et soit un intervalle de confiance soit des règles de décision simples (ex. « déployer si lift ≥ 3 % et échantillon ≥ 500 »).

Gardez un changelog de ce qui a été testé et déployé, pour que les futurs tests n'itèrent pas sur des idées déjà explorées et pour relier les changements de rétention à des modifications spécifiques.

Confidentialité, sécurité et contrôle d'accès

Les données d'annulation sont parmi les plus sensibles que vous manipulerez : elles incluent souvent le contexte de facturation, des identifiants et du texte libre qui peut contenir des informations personnelles. Traitez la confidentialité et la sécurité comme des exigences produit, pas comme un après-coup.

Authentification et rôles

Commencez par un accès authentifié uniquement (SSO si possible). Ajoutez ensuite des rôles simples et explicites :

- Admin : gérer les réglages, la conservation des données, les accès et les exports.

- Analyste : voir les tableaux, créer des segments, lancer des expériences.

- Support : voir l'historique client nécessaire pour aider (champs limités).

- Lecture seule : voir des dashboards agrégés sans drill-down.

Faites les vérifications de rôle côté serveur, pas seulement dans l'UI.

Minimiser l'exposition des données sensibles

Limitez qui peut voir les enregistrements au niveau client. Préférez les agrégats par défaut, avec drill-down derrière des permissions renforcées.

- Masquez les identifiants (email, ID client) dans l'UI quand c'est possible.

- Hashez les identifiants pour les jointures et la déduplication (ex. SHA-256 avec sel secret) afin que les analystes puissent segmenter sans voir les PII brutes.

- Séparez les tables « facturation/identité » des tables analytiques d'événements, reliées via une clé hachée.

Règles de conservation des données

Définissez la conservation en amont :

- Conserver les données d'événements seulement tant que nécessaire pour l'analyse par cohorte (ex. 13–18 mois).

- Appliquer une conservation ou une rédaction plus courte pour les textes libres de raisons d'annulation, qui peuvent contenir des infos personnelles accidentelles.

- Fournir des workflows de suppression pour honorer les demandes des utilisateurs et les politiques internes.

Journaux d'audit

Loggez les accès et exports de tableau :

- Qui a consulté des pages au niveau client

- Qui a exporté des données, quand et quels filtres ont été utilisés

- Changements d'admin aux règles de conservation et aux permissions

Checklist sécurité avant lancement

Couvrez le basique avant la mise en production : risques OWASP (XSS/CSRF/injection), TLS partout, comptes DB à moindre privilège, gestion des secrets (pas de clés dans le code), limitation de débit sur les endpoints d'auth, et procédures de backup/restore testées.

Feuille de route d'implémentation (Frontend, Backend, tests)

Cette section cartographie la construction en trois parties — backend, frontend et qualité — pour que vous puissiez livrer un MVP cohérent, assez rapide pour un usage réel et sûr à faire évoluer.

Backend : abonnements, événements et expériences

Commencez par une petite API qui supporte le CRUD des subscriptions (création, mise à jour de statut, pause/reprise, annulation) et stocke les dates clés du cycle de vie. Gardez les chemins d'écriture simples et validés.

Ensuite, ajoutez un endpoint d'ingestion d'événements pour tracker des actions comme « ouverture de la page d'annulation », « raison sélectionnée » et « confirmation d'annulation ». Préférez l'ingestion côté serveur (depuis votre backend) quand possible pour réduire les bloqueurs de pub et la falsification. Si vous devez accepter des événements clients, signez les requêtes et limitez le débit.

Pour les expériences de rétention, implémentez l'assignation d'expérience côté serveur afin que le même compte reçoive toujours la même variante. Un pattern typique : récupérer les expériences éligibles → hasher (account_id, experiment_id) → assigner la variante → persister l'assignation.

Si vous voulez prototyper rapidement, une plateforme de génération de code comme Koder.ai peut créer la base (dashboard React, backend Go, schéma PostgreSQL) à partir d'une spécification courte en chat — puis vous exportez le code source et adaptez le modèle de données, les contrats d'événement et les permissions à vos besoins.

Frontend : tableau de bord, filtres et exports

Construisez quelques pages de dashboard : entonnoirs (cancel_started → offer_shown → cancel_submitted), cohortes (par mois d'inscription) et segments (forfait, pays, canal d'acquisition). Gardez les filtres cohérents entre les pages.

Pour le partage contrôlé, fournissez des exports CSV avec garde-fous : exporter par défaut seulement des résultats agrégés, exiger des permissions élevées pour les exports ligne-par-ligne, et journaliser les exports pour l'audit.

Principes de performance

Utilisez la pagination pour les listes d'événements, indexez les filtres courants (date, subscription_id, plan) et ajoutez des pré-agrégations pour les graphiques lourds (comptes quotidiens, tables de cohorte). Mettez en cache les résumés des « 30 derniers jours » avec un TTL court.

Tests et fiabilité

Écrivez des tests unitaires pour les définitions de métriques (ex. ce qui compte comme « annulation commencée ») et pour la consistance d'assignation (le même compte tombe toujours dans la même variante).

Pour les échecs d'ingestion, implémentez des retries et une dead-letter queue pour éviter la perte silencieuse de données. Affichez les erreurs dans les logs et une page admin pour corriger les problèmes avant qu'ils ne faussent les décisions.

Déployer, surveiller et maintenir la confiance des données

Devenez propriétaire du code source

Obtenez l'export complet du code source et adaptez le modèle de données, les permissions et l'interface à vos besoins.

Livrer votre appli d'analyse d'annulations n'est que la moitié du travail. L'autre moitié consiste à la garder exacte alors que votre produit et vos expériences changent semaine après semaine.

Choisir une approche de déploiement

Choisissez l'option la plus simple qui correspond au style d'opération de votre équipe :

- Hébergement géré (PaaS) : chemin le plus rapide vers la production si vous voulez des déploiements, logs et scalabilité intégrés.

- Conteneurs (Docker + orchestrateur) : mieux quand vous avez besoin de builds reproductibles et d'un contrôle fin sur les dépendances.

- Serverless : excellent pour des charges en pics (ingestion d'événements, jobs planifiés), mais surveillez les cold starts et les limites du fournisseur.

Quelle que soit l'option, traitez l'app analytics comme un système de production : versionnez-la, automatisez les déploiements et gardez la config dans des variables d'environnement.

Si vous ne voulez pas gérer la pipeline complète dès le jour 1, Koder.ai peut aussi prendre en charge le déploiement et l'hébergement (y compris domaines personnalisés) et propose snapshots et rollback — utile quand vous itérez rapidement sur un flux sensible comme l'annulation.

Environnements séparés (et données isolées)

Créez dev, staging et production avec isolation claire :

- Bases et buckets séparés pour que les événements de test ne contaminent pas les métriques.

- Un environnement staging qui reflète le schéma et le routage de production.

- Espaces de noms d'expérience distincts (ex. préfixer les IDs d'expériences en non-prod) pour éviter des « variantes fantômes » dans les tableaux.

Monitoring qui protège la prise de décision

Vous ne surveillez pas seulement la disponibilité — vous surveillez la vérité :

- Uptime/santé de l'API, des workers en arrière-plan et du dashboard.

- Lag d'ingestion (temps événement vs temps traité) avec alertes quand il dérive.

- Erreurs d'assignation d'expérience : pics d'unités « non assignées », déséquilibre entre variantes, ou assignation changeante pour un même compte.

Jobs automatisés de validation des données

Planifiez des vérifications légères qui échouent bruyamment :

- Événements clés manquants (ex.

cancel_startedsanscancel_submitted, quand attendu). - Changements de schéma (nouvelles/propriétés supprimées, changements de type, enums inattendues).

- Anomalies de volume (les événements tombent presque à zéro après une release).

Plan de rollback pour les changements UI des expériences

Pour toute expérience touchant le flux d'annulation, prévoyez le rollback :

- Feature flags pour désactiver instantanément des variantes.

- Chemin rapide pour redéployer la dernière build connue bonne.

- Une note dans le dashboard marquant la fenêtre de rollback pour que les analystes ne malinterpètent pas les données.

Faire fonctionner le système : des insights aux expérimentations continues

Une appli d'analyse d'annulations ne rapporte que si elle devient une habitude, pas un rapport ponctuel. L'objectif est de transformer « on a remarqué du churn » en une boucle continue insight → hypothèse → test → décision.

Instaurer un rythme hebdomadaire simple

Choisissez un moment fixe chaque semaine (30–45 minutes) et gardez le rituel léger :

- Passez en revue le dashboard pour des changements sur les métriques clés (churn global, churn par forfait, churn par ancienneté, et principales raisons d'annulation).

- Identifiez une anomalie à investiguer (ex. pic de churn chez les renouvellements annuels, ou une raison qui devient #1 soudainement).

- Choisissez une seule hypothèse à tester la semaine suivante.

Se limiter à une hypothèse force la clarté : que croyons-nous se passer, qui est affecté, et quelle action pourrait changer le résultat ?

Prioriser les expériences (impact × effort)

Évitez de lancer trop de tests en parallèle — surtout sur le flux d'annulation — car les changements qui se chevauchent rendent les résultats difficiles à interpréter.

Utilisez une grille simple :

- Fort impact / faible effort : prioritaire (changement de copy, redirection vers support, proposition de basculement annuel).

- Fort impact / fort effort : planification (flexibilité de facturation, corrections produit).

- Faible impact : mettre de côté.

Si vous débutez en expérimentation, alignez-vous sur les bases et les règles de décision avant de déployer : /blog/ab-testing-basics.

Boucler avec des retours qualitatifs

Les chiffres disent quoi ; les notes support et les commentaires d'annulation disent souvent pourquoi. Chaque semaine, échantillonnez quelques annulations récentes par segment et résumez les thèmes. Puis mappez ces thèmes en interventions testables.

Construire un playbook des interventions gagnantes

Consignez les apprentissages au fil du temps : ce qui a marché, pour qui et dans quelles conditions. Stockez de courts éléments comme :

- Définition du segment (forfait, ancienneté, usage)

- Hypothèse et changement déployé

- Résultat et niveau de confiance

- Action de suivi (déployer, itérer ou annuler)

Quand vous serez prêt à standardiser des offres (et éviter des remises ad hoc), rattachez votre playbook à votre packaging et vos limites : /pricing.