Définir le périmètre et les métriques de succès

Avant de concevoir un workflow de modération, décidez précisément de ce que vous modérez et de ce que signifie « bien ». Un périmètre clair évite que votre file de modération ne se remplisse de cas limites, de doublons et de requêtes hors sujet.

Qu'est-ce qui compte comme « contenu »

Écrivez tous les types de contenu qui peuvent créer un risque ou un préjudice pour les utilisateurs. Exemples courants : texte généré par les utilisateurs (commentaires, publications, avis), images, vidéos, livestreams, champs de profil (noms, bios, avatars), messages privés, groupes communautaires et annonces de marketplace (titres, descriptions, photos, prix).

Notez aussi les sources : soumissions d’utilisateurs, imports automatisés, modifications d’items existants et signalements d’autres utilisateurs. Cela évite de créer un système qui ne fonctionne que pour les « nouvelles publications » tout en oubliant les modifications, re-uploads ou abus en messages privés.

Vos objectifs (et les compromis)

La plupart des équipes équilibrent quatre objectifs :

- Vitesse : court délai de décision pour traiter rapidement le contenu nuisible

- Cohérence : des cas similaires reçoivent des issues similaires entre réviseurs

- Conformité aux politiques et sécurité : les décisions s’alignent sur vos règles et obligations légales

- Contrôle des coûts : le temps des réviseurs est limité ; l’automatisation et la priorisation comptent

Soyez explicite sur l’objectif prioritaire selon les zones. Par exemple, les abus à haute sévérité peuvent privilégier la vitesse au détriment d’une cohérence parfaite.

Actions à supporter

Dressez la liste complète des outcomes requis : approuver, rejeter/retirer, éditer/rediger, étiqueter/filtrer par âge, restreindre la visibilité, placer en revue, escalader vers un responsable, et actions au niveau du compte comme avertissements, verrouillages temporaires ou bannissements.

Métriques de succès à suivre

Définissez des cibles mesurables : temps médian et 95e centile de revue, taille du backlog, taux de renversement d’appel, précision des politiques via échantillonnage QA, et pourcentage d’items à haute sévérité traités dans un SLA.

Parties prenantes à impliquer tôt

Incluez modérateurs, responsables d’équipe, policy, support, ingénierie et juridique. Un manque d’alignement ici provoque des retouches ultérieures—surtout autour de ce que signifie « escalade » et qui détient la décision finale.

Modéliser le workflow de modération de bout en bout

Avant de bâtir des écrans et des files d’attente, esquissez le cycle de vie complet d’un contenu. Un workflow clair évite les « états mystères » qui confondent les réviseurs, cassent les notifications et rendent les audits pénibles.

Cartographier le cycle de vie en états explicites

Commencez par un modèle d’état simple, de bout en bout, que vous pourrez mettre dans un diagramme et dans votre base de données :

Submitted → Queued → In review → Decided → Notified → Archived

Gardez les états mutuellement exclusifs, et définissez quelles transitions sont autorisées (et par qui). Par exemple : « Queued » ne peut passer à « In review » que lorsqu’il est assigné, et « Decided » devrait être immuable sauf via un flux d’appel.

Séparer les signaux automatisés des décisions humaines

Les classifieurs automatisés, les correspondances de mots-clés, les limites de fréquence et les signalements d’utilisateurs doivent être traités comme des signaux, pas comme des décisions. Un design « humain dans la boucle » maintient l’honnêteté du système :

- Les signaux influencent la priorité et les actions recommandées.

- La décision du réviseur est l’issue faisant foi.

Cette séparation facilite aussi l’amélioration des modèles ultérieurement sans réécrire la logique des politiques.

Prévoir les appels et les re-reviews

Les décisions seront contestées. Ajoutez des flux de première classe pour :

- Soumission d’appel par l’utilisateur (liée au dossier original)

- Re-review par un réviseur différent ou une équipe spécialisée

- Résultats possibles : maintenir, renverser, modifier, ou demander plus d’informations

Modélisez les appels comme de nouveaux événements de revue plutôt qu’en éditant l’historique. Ainsi vous pouvez raconter l’histoire complète de ce qui s’est passé.

Décider de ce qui doit être traçable

Pour les audits et les litiges, définissez quelles étapes doivent être enregistrées avec horodatages et acteurs :

- Changements d’assignation

- Preuves consultées (si pertinent)

- Décision, motif de politique et action d’application

- Notifications envoyées

Si vous ne pouvez pas expliquer une décision plus tard, supposez qu’elle n’a pas eu lieu.

Concevoir rôles, permissions et structure d’équipe

Un outil de modération vit ou meurt selon le contrôle d’accès. Si tout le monde peut tout faire, vous obtiendrez des décisions inconsistantes, des expositions accidentelles de données et aucune responsabilité claire. Commencez par définir des rôles qui correspondent au fonctionnement réel de votre équipe Trust & Safety, puis traduisez-les en permissions que votre application peut appliquer.

Rôles principaux à supporter

La plupart des équipes ont besoin d’un petit ensemble de rôles clairs :

- Moderator : révise les items dans une file de modération, applique des outcomes (approve/remove/label) et laisse des notes internes.

- Senior reviewer : tout ce qu’un modérateur peut faire, plus des overrides, la gestion des escalades et le coaching (par ex. résoudre des disputes).

- Policy editor : met à jour le texte de politique, les définitions de règles et les lignes directrices, mais ne peut pas modérer directement.

- Admin : gère utilisateurs, rôles, paramètres d’équipe, intégrations et actions à haut risque.

- Read-only : peut voir tableaux de bord, dossiers et entrées du journal d’audit, mais ne peut rien changer.

Cette séparation évite les « changements de politique par accident » et garde la gouvernance de la politique distincte de l’application journalière de la règle.

Permissions au moindre privilège (RBAC)

Implémentez un contrôle d’accès basé sur les rôles pour que chaque rôle obtienne uniquement ce dont il a besoin :

- Limitez qui peut voir les données sensibles (PII, signalements, signaux d’appareil).

- Restreignez les actions à fort impact comme les décisions en masse, sanctions au niveau du compte et suppression de cas.

- Scindez les permissions par capacité (par ex.

can_apply_outcome, can_override, can_export_data) plutôt que par page.

Si vous ajoutez plus tard de nouvelles fonctionnalités (exports, automatisations, intégrations tierces), vous pouvez les rattacher aux permissions sans redéfinir toute la structure organisationnelle.

Structure multi-équipes (langue, région, produit)

Prévoyez plusieurs équipes tôt : pods par langue, groupes régionaux, ou lignes séparées pour différents produits. Modélisez les équipes explicitement, puis scopez les files d’attente, la visibilité du contenu et les assignments par équipe. Cela évite les revues inter-régionales erronées et maintient la mesurabilité des charges par groupe.

Garde-fous pour l’usurpation d’identité et approbations

Les admins doivent parfois s’usurper un utilisateur pour déboguer l’accès ou reproduire un problème. Traitez l’usurpation comme une action sensible :

- Exigez une permission spécifique pour usurper.

- Journalisez qui a usurpé qui, quand et pourquoi.

- Affichez une bannière persistante « en train d’usurper » et désactivez par défaut les actions risquées.

Pour les actions irréversibles ou à haut risque, ajoutez une approbation admin (ou une revue à deux personnes). Cette petite friction protège contre les erreurs et les abus internes, tout en maintenant la rapidité des modérations courantes.

Construire des files d’attente, priorisation et assignment

Les files d’attente rendent le travail de modération gérable. Plutôt qu’une liste infinie, scindez le travail en files correspondant au risque, à l’urgence et à l’intention—puis rendez difficile que des items tombent entre les mailles.

Définir les types de files

Commencez par un petit ensemble de files qui correspondent à la manière dont votre équipe opère réellement :

- Nouveaux items : contenu frais en attente d’une première revue.

- Haute-risque : items susceptibles de causer du tort (par ex. mineurs, signaux d’automutilation, schémas d’arnaque connus).

- Escalations : tout ce qu’un réviseur ne peut décider en confiance ou qui nécessite un spécialiste.

- Appels : demandes des utilisateurs de reconsidération.

- Backlog : items plus anciens, moindre urgence ou overflow lors de pics.

Gardez les files mutuellement exclusives autant que possible (un item devrait avoir une « maison »), et utilisez des tags pour des attributs secondaires.

Choisir des règles de priorisation difficiles à manipuler

Dans chaque file, définissez des règles de scoring déterminant ce qui remonte en tête :

- Sévérité (catégorie de politique + confiance)

- Viralité/portée (vues, partages, nombre d’abonnés)

- Signalements d’utilisateurs (nombre, réputation du rapporteur, rapporteurs uniques)

- Minuteurs SLA (âge, délais d’escalade, temps depuis le premier signalement)

Rendez les priorités explicables dans l’UI (« Pourquoi je vois ceci ? ») pour que les réviseurs fassent confiance à l’ordre.

Prévenir le travail en double avec claim + timeouts

Utilisez la réclamation/verrouillage : lorsqu’un réviseur ouvre un item, il est assigné et caché aux autres. Ajoutez un timeout (par ex. 10–20 minutes) pour que les items abandonnés retournent en file. Enregistrez toujours les événements de claim, release et completion.

Gérer l’équité : éviter le biais des « victoires faciles »

Si le système récompense la vitesse, les réviseurs peuvent choisir les cas rapides et éviter les cas difficiles. Contrez cela en :

- Assignant automatiquement une portion du travail

- Mélangeant les niveaux de difficulté (batching intelligent)

- Faisant tourner les files à fort impact entre les membres de l’équipe

L’objectif est une couverture cohérente, pas juste un fort débit.

Une politique qui existe seulement en PDF sera interprétée différemment par chaque réviseur. Pour rendre les décisions cohérentes (et auditables), traduisez le texte de la politique en données structurées et en choix UI que votre workflow peut appliquer.

Créer une taxonomie de politiques

Commencez par découper la politique en un vocabulaire partagé que les réviseurs peuvent sélectionner. Une taxonomie utile inclut généralement :

- Catégorie (par ex. Harcèlement, Contenu adulte, Désinformation)

- Type de violation (par ex. discours de haine vs insulte générale)

- Niveau de sévérité (par ex. Bas/Moyen/Élevé/Critique)

- Preuve requise (ce qui doit être présent pour appliquer la politique—phrases spécifiques, contexte, rapports utilisateur, liens, horodatages)

Cette taxonomie devient la base pour les files, les escalades et l’analytics.

Utiliser des modèles de décision pour réduire l’incohérence

Au lieu de demander aux réviseurs d’écrire une décision à partir de zéro, fournissez des templates de décision liés aux éléments de la taxonomie. Un template peut préremplir :

- L’action recommandée (remove, label, restreindre, warn, no action)

- Le message adressé à l’utilisateur (modifiable, mais guidé)

- La checklist interne (preuves à confirmer)

Les templates accélèrent le « chemin heureux » tout en permettant des exceptions.

Supporter la versioning des politiques et les dates d’effet

Les politiques évoluent. Stockez les politiques en tant qu’enregistrements versionnés avec dates d’effet, et enregistrez quelle version a été appliquée pour chaque décision. Cela évite la confusion lors d’appels ultérieurs et garantit que vous pouvez expliquer des issues des mois plus tard.

Capturer des motifs structurés (pas seulement du texte libre)

Le texte libre est difficile à analyser et facile à oublier. Exigez que les réviseurs choisissent un ou plusieurs motifs structurés (depuis votre taxonomie) et ajoutent éventuellement des notes. Les motifs structurés améliorent la gestion des appels, l’échantillonnage QA et le reporting—sans forcer les réviseurs à rédiger de longs textes.

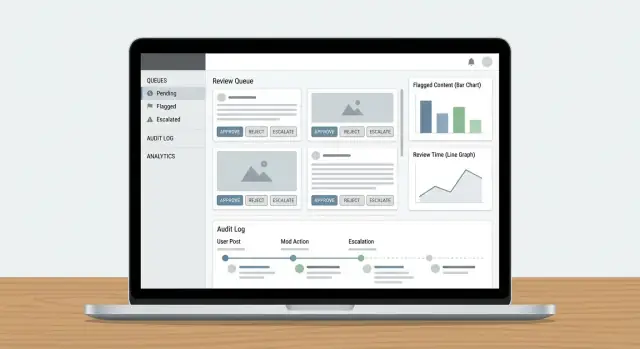

Concevoir le tableau de bord du réviseur et l’UX

Reliez les décisions aux résultats

Modélisez les événements de décision pour que notifications et mesures d'application restent cohérentes.

Un tableau de bord de réviseur réussit lorsqu’il minimise la recherche d’informations et maximise les décisions confiantes et répétables. Les réviseurs doivent pouvoir comprendre ce qui s’est passé, pourquoi cela compte et quoi faire ensuite—sans ouvrir cinq onglets.

Afficher le contenu avec le bon contexte

N’affichez pas un post isolé et attendez des issues cohérentes. Présentez un panneau de contexte compact qui répond aux questions courantes en un coup d’œil :

- Vue conversation/thread : quelques messages avant et après l’item signalé, avec mise en évidence claire du contenu concerné.

- Historique utilisateur : avertissements récents, suspensions, suppressions antérieures et résultats d’appels (limitée dans le temps pour rester pertinente).

- Actions antérieures : qui a touché l’item avant, quelle décision et quelles notes.

Gardez la vue par défaut concise, avec des options d’expansion pour des contrôles plus profonds. Les réviseurs devraient rarement quitter le tableau de bord pour décider.

Actions rapides qui correspondent à des décisions réelles

Votre barre d’action doit correspondre aux outcomes de politique, pas à des boutons CRUD génériques. Exemples courants :

- Approuver / Rejeter en un clic

- Étiquetage (spam, harcèlement, autodestruction, désinformation) pour le reporting et l’entraînement

- Éditer ou redacter (quand la politique permet un retrait partiel)

- Escalader vers des spécialistes ou une seconde ligne de revue

- Demander plus d’infos (pour les cas ambigus) avec prompts templatisés

Rendez les actions visibles et explicitez les étapes irréversibles (confirmation seulement quand nécessaire). Capturez un court code de raison plus des notes optionnelles pour les audits ultérieurs.

Fonctions de vitesse : raccourcis clavier et actions en masse

Le travail à fort volume exige peu de friction. Ajoutez des raccourcis clavier pour les actions principales (approuver, rejeter, item suivant, ajouter une étiquette). Affichez un mémo des raccourcis dans l’UI.

Pour les files avec du travail répétitif (par ex. spam évident), supportez la sélection en masse avec des garde-fous : prévisualiser le compte, exiger un code de raison, et journaliser l’action de lot.

Concevoir pour la sécurité psychologique des réviseurs

La modération expose les personnes à du contenu potentiellement dommageable. Ajoutez des paramètres de sécurité par défaut :

- Flouter les médias sensibles par défaut avec un clic pour révéler

- Bannières d’avertissement pour probable autodestruction, contenu sexuel ou violence graphique

- Un bouton rapide masquer le contenu qui préserve la capacité à décider sans exposition prolongée

Ces choix protègent les réviseurs tout en maintenant la précision et la cohérence des décisions.

Ajouter des journaux d’audit et traçabilité

Les journaux d’audit sont votre « source de vérité » lorsque quelqu’un demande : Pourquoi ce post a-t-il été retiré ? Qui a approuvé l’appel ? Le modèle ou un humain a-t-il pris la décision finale ? Sans traçabilité, les enquêtes deviennent des devinettes et la confiance des réviseurs tombe rapidement.

Capturer chaque décision (et les preuves)

Pour chaque action de modération, loggez qui l’a faite, ce qui a changé, quand cela s’est produit et pourquoi (motif de politique + notes libres). Tout aussi important : stockez des instantanés before/after des objets pertinents—texte du contenu, empreintes de média, signaux détectés, étiquettes et outcome final. Si l’item peut changer (modifications, suppressions), les snapshots empêchent le « record » de dériver.

Un pattern pratique est un enregistrement d’événement append-only :

{

"event": "DECISION_APPLIED",

"actor_id": "u_4821",

"subject_id": "post_99102",

"queue": "hate_speech",

"decision": "remove",

"policy_code": "HS.2",

"reason": "slur used as insult",

"before": {"status": "pending"},

"after": {"status": "removed"},

"created_at": "2025-12-26T10:14:22Z"

}

Journaliser les événements de file pour la clarté opérationnelle

Au-delà des décisions, loggez la mécanique du workflow : claimed, released, timed out, reassigned, escalated et auto-routed. Ces événements expliquent « pourquoi ça a pris 6 heures » ou « pourquoi cet item a rebondi entre équipes », et sont essentiels pour détecter les abus (par ex. réviseurs qui choisissent uniquement les items faciles).

Rendre les pistes d’audit recherchables pour les enquêtes

Donnez aux enquêteurs des filtres par utilisateur, ID de contenu, code de politique, plage temporelle, file d’attente et type d’action. Incluez l’export vers un fichier de dossier, avec horodatages immuables et références aux items apparentés (doublons, re-uploads, appels).

Fixez des fenêtres de rétention claires pour les événements d’audit, les snapshots et les notes des réviseurs. Documentez la politique (par ex. 90 jours pour les logs de files ordinaires, plus long pour les gels juridiques) et comment les demandes de redaction ou de suppression affectent les preuves stockées.

Connecter les signalements, notifications et actions utilisateur

Un outil de modération n’est utile que s’il boucle : les signalements deviennent des tâches de revue, les décisions atteignent les bonnes personnes et les actions côté utilisateur sont exécutées de façon cohérente. C’est souvent ici que les systèmes cassent—quelqu’un règle la file, mais rien d’autre ne change.

Intake : unifier tous les types de signalements

Traitez les signalements utilisateurs, les drapeaux automatisés (spam/CSAM/correspondances d’empreinte/signaux de toxicité) et les escalades internes (support, community managers, juridique) comme le même objet central : un report qui peut générer une ou plusieurs tâches de revue.

Utilisez un routeur de report unique qui :

- Déduplique (même contenu signalé plusieurs fois)

- Lie les items apparentés (même auteur, même fil)

- Applique un triage basique (sévérité, catégorie, juridiction)

- Crée/met à jour des items dans la file de modération

Si les escalades support sont dans le flux, liez-les directement (par ex. /support/tickets/1234) pour éviter le changement de contexte.

Outcomes : notifier les utilisateurs sans créer de nouveau risque

Les décisions de modération doivent générer des notifications templatisées : contenu retiré, avertissement émis, pas d’action, ou sanction de compte. Gardez les messages cohérents et minimaux—expliquez le résultat, référez la politique pertinente et fournissez les instructions d’appel.

Opérationnellement, envoyez les notifications via un événement tel que moderation.decision.finalized, pour que email/in-app/push puissent s’abonner sans ralentir le réviseur.

Actions utilisateur : connecter aux contrôles de compte

Les décisions nécessitent souvent des actions au-delà d’un seul contenu :

- Suspensions (temporaires/permanentes)

- Restrictions (limites de publication, limites de MP, shadow bans si autorisé)

- Mise à jour de scores de confiance / niveaux de risque

Rendez ces actions explicites et réversibles, avec durées et motifs clairs. Lie chaque action à la décision et au report sous-jacent pour la traçabilité, et fournissez un chemin rapide vers les appels pour que les décisions puissent être réexaminées sans enquête manuelle.

Choisir les modèles de données et la stratégie de stockage

Déployez votre outil de modération

Lancez avec déploiement, hébergement et domaines personnalisés lorsque votre outil est prêt.

Votre modèle de données est la « source de vérité » sur ce qui est arrivé à chaque item : ce qui a été revu, par qui, sous quelle politique et quel a été le résultat. Si vous faites bien cette couche, tout le reste—files, tableaux de bord, audits et analytics—devient plus simple.

Séparer contenu, décisions et codes de politique

Évitez de tout stocker dans un seul enregistrement. Un pattern pratique est de conserver :

- Références de contenu (ce qui est revu) : un ID stable, type de contenu (post/comment/image/video), ID auteur, date de création et pointeur vers l’emplacement brut du contenu.

- Décisions de modération (ce que les réviseurs ont fait) : ID de décision, ID du réviseur, outcome, horodatages, notes libres et champs structurés (confiance, sévérité).

- Codes de politique (pourquoi c’est décidé) : identifiants canoniques comme

HARASSMENT.H1 ou NUDITY.N3, stockés en référence pour que les politiques puissent évoluer sans réécrire l’historique.

Cela garde l’application des politiques cohérente et rend le reporting plus clair (par ex. « principaux codes de politique violés cette semaine »).

Stocker les gros médias en sécurité

Ne mettez pas d’images/vidéos volumineuses directement en base de données. Utilisez un stockage d’objets et conservez seulement les clés d’objet + métadonnées dans votre table de contenu.

Pour les réviseurs, générez des URLs signées à courte durée pour que les médias soient accessibles sans être publics. Les URLs signées vous permettent aussi de contrôler l’expiration et de révoquer l’accès si nécessaire.

Indexer pour la vitesse là où ça compte

Les files et les investigations dépendent de recherches rapides. Ajoutez des index sur :

- Filtres de file (status, priorité, réviseur assigné, date de création)

- Recherche textuelle (motif signalé, texte du contenu quand autorisé)

- Requêtes du journal d’audit (acteur, type d’action, plage temporelle, ID de contenu)

Suivre les transitions d’état pour éviter les items « bloqués »

Modélisez la modération comme des états explicites (ex. NEW → TRIAGED → IN_REVIEW → DECIDED → APPEALED). Stockez les événements de transition d’état (avec horodatages et acteur) pour détecter les items sans progression.

Une garde simple : un champ last_state_change_at plus des alertes pour les items dépassant un SLA, et un job de réparation qui re-queue les items laissés IN_REVIEW après un timeout.

Sécurité, confidentialité et résistance aux abus

Les outils Trust & Safety manipulent souvent les données les plus sensibles de votre produit : contenus générés par les utilisateurs, signalements, identifiants de compte et parfois des demandes légales. Traitez l’application de modération comme un système à haut risque et intégrez sécurité et confidentialité dès le départ.

Accès sécurisé pour réviseurs et admins

Commencez par une authentification forte et des contrôles de session stricts. Pour la plupart des équipes cela signifie :

- SSO (SAML/OIDC) pour que l’accès suive les politiques d’identité de l’entreprise

- MFA pour tout rôle privilégié (admins, éditeurs de politique, exports)

- Timeouts de session courts et ré-authentification pour actions risquées (actions de masse, exports, changements de rôle)

- Listes d’IP autorisées pour des outils internes, si pertinent (postes de contractuels ou plages de bureau)

Associez cela au RBAC pour que les réviseurs ne voient que ce dont ils ont besoin (par ex. une file, une région ou un type de contenu).

Protéger le contenu sensible et les données utilisateur

Chiffrez les données en transit (HTTPS partout) et au repos (chiffrement géré). Concentrez-vous ensuite sur la minimisation d’exposition :

- Affichez des aperçus rédigés par défaut (flouter les médias, masquer téléphone/email) avec une action reveal qui est journalisée

- Séparez les permissions de visionnage des permissions d’export

- Limitez l’accès aux champs à haut risque (adresses exactes, données de paiement) à un petit ensemble de rôles

Si vous traitez des données soumises au consentement ou des catégories spéciales, rendez ces flags visibles aux réviseurs et appliquez-les dans l’UI (par ex. visualisation restreinte ou règles de rétention).

Résistance aux abus pour les signalements et appels

Les endpoints de signalement et d’appel sont souvent attaqués par du spam et du harcèlement. Ajoutez :

- Limites de taux par utilisateur/IP/appareil

- Protections anti-bot (challenge sur les pics, détection d’anomalies)

- Contrôles de coût (plafonds journaliers, frictions croissantes pour les abus répétés)

Enfin, rendez chaque action sensible traçable avec un journal d’audit (voir /blog/audit-logs) pour enquêter sur erreurs de réviseurs, comptes compromis ou abus coordonnés.

Analytics, QA et amélioration continue

Esquissez votre modèle de données de modération

Utilisez le mode Planification pour cartographier le contenu, les signalements, les décisions et les états avant de générer le code.

Un workflow de modération ne s’améliore que si vous pouvez le mesurer. L’analytics doit vous dire si votre conception de files, vos règles d’escalade et l’application des politiques produisent des décisions cohérentes—sans épuiser les réviseurs ni laisser du contenu nuisible en attente.

Métriques qui correspondent à l’opérationnel

Commencez par un petit ensemble de métriques liées aux résultats :

- Throughput : items revus par heure/jour, ventilés par file, type de contenu et équipe.

- Temps de traitement : time-to-first-review et time-to-resolution (suivis par file et bande de priorité).

- Signaux de précision (proxies) : taux d’annulation d’appel, corrections admin, taux de violation confirmée après escalade.

Placez-les dans un tableau de bord SLA pour que les leads ops voient quelles files prennent du retard et si le goulot est le staffing, des règles floues ou une vague de signalements.

Désaccord et échantillonnage : votre système d’alerte précoce

Le désaccord n’est pas toujours mauvais—il peut indiquer des cas limites. Suivez :

- Taux de désaccord entre réviseurs sur le même item (ex. échantillons double-review)

- Résultats d’échantillonnage QA : taux de réussite/échec des revues QA et motifs d’échec les plus courants

Utilisez votre journal d’audit pour relier chaque décision échantillonnée au réviseur, à la règle appliquée et aux preuves. Cela donne de l’explainability pour le coaching des réviseurs et pour évaluer si l’UI de revue pousse à des choix inconsistants.

L’analytics doit vous aider à répondre : « Qu’observons-nous que notre politique couvre mal ? » Recherchez des clusters tels que :

- Fort désaccord sur une catégorie particulière

- Usage fréquent de raisons « autre/peu clair »

- Escalades qui rebondissent entre équipes

Transformez ces signaux en actions concrètes : réécrire des exemples de politique, ajouter des arbres de décision dans le tableau de bord, ou mettre à jour des presets d’application (par ex. délais par défaut vs avertissements).

Boucler sans briser la confiance

Considérez l’analytics comme partie d’un système humain dans la boucle. Partagez les performances par file au sein de l’équipe, mais gérez les métriques individuelles avec précaution pour éviter d’inciter la rapidité au détriment de la qualité. Associez KPIs quantitatifs à des sessions de calibration régulières et à de petites mises à jour fréquentes de politique—pour que les outils et les personnes progressent ensemble.

Tests, déploiement et opérations continues

Un outil de modération échoue souvent sur les bords : posts étranges, chemins d’escalade rares et moments où plusieurs personnes touchent le même dossier. Traitez les tests et le déploiement comme partie intégrante du produit, pas comme une case finale à cocher.

Tester avec des scénarios réalistes (pas seulement les chemins heureux)

Construisez un petit « pack de scénarios » qui reflète le travail réel. Incluez :

- Cas limites (médias mixtes, comptes supprimés, contenu édité, ambiguïté linguistique)

- Appels et renversements (une décision contestée, re-reviewée et annulée)

- Escalades (transferts à des spécialistes, juridique ou policy) et SLA basés sur le temps

- Concurrence (deux réviseurs ouvrant le même item, conditions de course sur les actions, rapports doublons)

Utilisez des volumes proches de la production en staging pour détecter tôt les ralentissements de file, problèmes de pagination/recherche.

Déployer par étapes pour protéger le throughput

Un pattern de déploiement plus sûr :

- Équipe pilote : une file, actions limitées, boucle de feedback quotidienne

- Mode shadow : faites tourner le nouveau système en parallèle de l’ancien (enregistrer les décisions sans appliquer l’exécution côté utilisateur)

- Migration complète : basculer l’exécution, garder des chemins de rollback et surveiller les métriques clés toutes les heures la première semaine

Le mode shadow est particulièrement utile pour valider les règles d’application et les automatisations sans risquer de faux positifs.

Rédigez des playbooks courts et concrets : « Comment traiter un signal », « Quand escalader », « Comment gérer les appels », « Que faire lorsque le système est incertain ». Entraînez ensuite avec le même pack de scénarios pour que les réviseurs pratiquent exactement les flux qu’ils utiliseront.

Opérations continues : politiques qui évoluent, files qui grandissent

Prévoyez la maintenance comme un travail continu : nouveaux types de contenu, règles d’escalade mises à jour, échantillonnage QA périodique et planification de capacité lors des pics. Gardez un processus de release clair pour les mises à jour de politique afin que les réviseurs voient ce qui a changé et quand—et que vous puissiez corréler les changements avec l’analytics de modération.

Construire plus vite avec Koder.ai (optionnel)

Si vous implémentez ceci en tant qu’application web, une grande part du travail est du scaffolding répétitif : RBAC, files, transitions d’état, journaux d’audit, tableaux de bord et la colle événementielle entre décisions et notifications. Koder.ai peut accélérer cette construction en vous permettant de décrire le workflow de modération dans une interface de chat et de générer une base fonctionnelle sur laquelle itérer—souvent avec un front React et un backend Go + PostgreSQL.

Deux usages pratiques :

- Mode planification d’abord : décrivez d’abord vos entités (Content, Report, ReviewTask, Decision, PolicyCode, AuditEvent), les transitions du state machine et les SLA avant de générer du code.

- Snapshots et rollback : utile quand vous ajustez des règles d’escalade, le scoring de file ou les garde-fous d’actions en masse et que vous voulez itérer rapidement et en sécurité.

Une fois la base en place, exportez le code source, connectez vos signaux modèles existants comme « inputs », et conservez la décision du réviseur comme autorité finale—correspondant à l’architecture humain-dans-la-boucle décrite ci-dessus.