Ce que signifie « le modèle logiciel PC » — et pourquoi ça comptait

Le « modèle logiciel PC » n’était pas un produit unique ni une astuce de licence intelligente. C’était une manière reproductible pour tout un marché de fonctionner : comment les développeurs construisaient des logiciels, comment ils les livraient aux utilisateurs et comment ils gagnaient de l’argent avec.

Cela paraît basique — jusqu’à ce qu’on se souvienne à quel point la situation était inhabituelle au début de l’informatique personnelle. Les premiers ordinateurs étaient souvent vendus comme des systèmes autonomes avec du matériel propriétaire, des environnements d’exploitation uniques et des chemins peu clairs pour les développeurs tiers. L’ère PC a changé cela en transformant le logiciel en quelque chose qui pouvait s’étendre au‑delà d’une seule machine — ou d’une seule entreprise.

Une définition simple en langue courante du « modèle logiciel »

Concrètement, un modèle logiciel est l’ensemble d’hypothèses qui répondent à :

- Pour quelle cible je développe ? (une base OS et matérielle stable)

- Comment le construire efficacement ? (outils, langages, documentation)

- Comment atteindre les clients et être payé ? (distribution et conditions commerciales)

Quand ces réponses sont prévisibles, les développeurs investissent. Quand elles ne le sont pas, ils hésitent.

Les trois piliers qui se renforçaient mutuellement

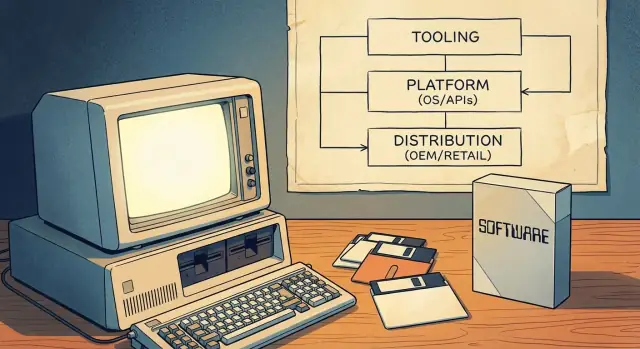

Le modèle PC a fonctionné parce qu’il réunissait trois piliers en un volant d’inertie :

- Outils de développement : langages accessibles, compilateurs, IDE et exemples qui réduisaient le coût d’entrée.

- Surface de la plateforme : API et SDK cohérents permettant au logiciel tiers de s’intégrer à l’OS (et aux autres applis).

- Canaux de mise sur le marché : moyens clairs de distribution — via préinstallations OEM, vente au détail et, plus tard, le shareware — afin que le logiciel puisse réellement devenir une activité.

Ensemble, ces éléments ont fait du PC un « lieu » fiable pour construire. Cette fiabilité a transformé l’informatique personnelle en un écosystème de développeurs grand public — pas seulement une scène de hobbyistes.

Avant les PC grand public : cibles fragmentées et portée limitée

Avant les PC grand public, « l’informatique » signifiait généralement mainframes et minicomputers détenus par les gouvernements, universités et grandes entreprises. L’accès était rare, coûteux et souvent médié par des départements informatiques. Si vous étiez développeur, vous écriviez pour une organisation spécifique — pas pour un marché public large.

Beaucoup de machines, beaucoup d’incompatibilités

Des systèmes personnels et hobbyistes existaient, mais ils ne formaient pas un marché fiable. Le matériel variait beaucoup (familles de CPU, formats de disques, graphismes, périphériques) et les systèmes d’exploitation étaient inconsistants ou propriétaires. Un programme qui fonctionnait sur une machine nécessitait souvent une réécriture pour en faire de même sur une autre.

Cette fragmentation a façonné l’économie du logiciel :

- Le logiciel était souvent fourni avec le matériel ou livré dans le cadre d’un achat plus large.

- Une grande partie était développée sur mesure pour le flux de travail d’un client.

- Les vendeurs couplaient étroitement les applications à leurs machines pour protéger les ventes matérielles.

Une portée limitée signifiait des incitations limitées

Parce que l’audience adressable pour une configuration donnée était petite, les développeurs indépendants avaient du mal à justifier le temps et le coût nécessaires pour produire des logiciels soignés et largement supportés. La distribution était aussi contraignante : on expédiait des cassettes ou des disquettes, on dépendait des groupes d’utilisateurs ou on partageait du code informellement. Rien de tout cela ne ressemblait à un business évolutif.

Ce qui a changé quand les PC sont devenus grand public

Quand les PC sont devenus des produits grand public et de bureau, la valeur est passée des déploiements uniques aux ventes récurrentes de logiciels. L’idée clé était une cible standard : une combinaison prévisible d’attentes matérielles, de conventions d’OS et de chemins de distribution sur laquelle les développeurs pouvaient parier.

Une fois critique mass de clients et de machines compatibles atteinte, écrire un logiciel n’était plus une question de « Est‑ce que ça fonctionnera ailleurs ? » mais plutôt « À quelle vitesse pouvons‑nous atteindre tous ceux qui utilisent ce standard ? »

D’abord l’outillage : les langages comme passerelle pour les développeurs

Avant que Microsoft ne soit synonyme de systèmes d’exploitation, la société était fortement identifiée aux langages de programmation — en particulier BASIC. Ce choix n’était pas anodin. Si vous voulez un écosystème, il faut d’abord des gens capables de construire des choses, et les langages sont la rampe d’accès la moins contraignante.

BASIC comme « kit de démarrage »

Les premiers micro‑ordinateurs livraient souvent BASIC en ROM, et les versions de Microsoft sont devenues un point d’entrée familier sur de nombreuses machines. Pour un étudiant, un hobbyiste ou une petite entreprise, le chemin était simple : allumer la machine, obtenir un prompt, taper du code, voir le résultat. Cette immédiateté comptait plus que l’élégance. Elle faisait de la programmation une utilisation normale de l’ordinateur, pas une profession spécialisée.

L’accessibilité élargit le vivier de créateurs

En se concentrant sur des outils abordables, Microsoft a contribué à élargir l’entonnoir des développeurs potentiels. Plus de personnes écrivant de petits programmes signifiaient plus d’expérimentations, plus d’« applis » locales et plus de demande pour de meilleurs outils. C’est un exemple précoce de la manière dont la notoriété auprès des développeurs agit comme des intérêts composés : une génération qui apprend sur votre langage et vos outils a tendance à rester et à acheter dans cet écosystème.

La cohérence entre machines renforce la confiance

L’ère du microordinateur était fragmentée, mais Microsoft a porté des idées cohérentes d’une plateforme à l’autre : une syntaxe de langage similaire, des attentes d’outillage semblables et le sentiment croissant que « si vous pouvez programmer ici, vous pouvez probablement programmer là aussi ». Cette prévisibilité réduisait le risque perçu d’apprendre à coder.

La leçon stratégique est simple : les plateformes ne commencent pas par des marketplaces ou la monétisation. Elles commencent par des outils qui rendent la création possible — puis elles gagnent la fidélité en rendant cette expérience répétable.

MS‑DOS et la standardisation de la cible PC

Un grand déclencheur de l’informatique personnelle a été l’idée d’une « couche OS standard » : au lieu d’écrire une version différente de votre appli pour chaque combinaison matérielle, vous pouviez viser une interface commune. Pour les développeurs, cela signifiait moins de ports, moins d’appels au support et un chemin plus clair pour livrer quelque chose qui fonctionnait pour beaucoup de clients.

Un seul endroit vers lequel viser votre logiciel

MS‑DOS se plaçait entre les applications et la variété de matériels PC. Il restait des différences (cartes graphiques, imprimantes, contrôleurs de disque, configurations mémoire), mais MS‑DOS offrait une base partagée pour l’accès aux fichiers, le chargement des programmes et les interactions matérielles basiques. Cette couche commune a transformé « le PC » en un marché unique adressable plutôt qu’en un ensemble de machines presque compatibles.

Ce que « compatibilité » signifiait en pratique

Pour les clients, la compatibilité voulait dire confiance : si un programme indiquait qu’il fonctionnait sur MS‑DOS (et, par extension, sur les compatibles IBM PC), il avait plus de chances de fonctionner sur leur machine aussi. Pour les développeurs, la compatibilité voulait dire comportement prévisible — appels système documentés, modèle d’exécution stable et conventions pour l’installation et le lancement des programmes.

Cette prévisibilité rendait rationnel d’investir dans la finition, la documentation et les mises à jour, parce que l’audience n’était plus limitée aux utilisateurs d’un seul vendeur matériel.

Le compromis fondamental : progrès vs préservation

La standardisation créait aussi une contrainte : maintenir le fonctionnement des anciens logiciels devenait une priorité. Cette pression de rétrocompatibilité peut ralentir les changements majeurs, car casser des programmes populaires casse la confiance dans la plateforme. L’avantage est une bibliothèque logicielle cumulée ; l’inconvénient est un couloir plus étroit pour une innovation radicale au niveau de l’OS sans plans de transition soignés.

Planifiez comme un ISV

Cartographiez les fonctionnalités, versions et dépendances avant de générer le code.

Windows n’était pas seulement « au‑dessus » de MS‑DOS — il a changé ce que les développeurs pouvaient supposer de la machine. Plutôt que chaque programme invente sa manière d’afficher l’écran, de gérer l’entrée et de parler aux périphériques, Windows offrait un modèle d’interface partagé plus un ensemble croissant de services système.

Ce que Windows a ajouté au‑delà de DOS

Le changement principal fut l’interface graphique : fenêtres, menus, boîtes de dialogue et polices qui se comportaient de façon cohérente d’une application à l’autre. Cela comptait parce que la cohérence réduisait le coût de « réinventer les bases ». Les développeurs pouvaient consacrer du temps aux fonctionnalités utiles aux utilisateurs, pas à construire un énième toolkit UI.

Windows a aussi étendu les services partagés qui étaient pénibles à implémenter à l’époque DOS :

- Une façon standardisée de travailler avec fichiers et dossiers

- L’impression via pilotes partagés et boîtes de dialogue d’impression

- Un support réseau qui n’exigeait pas l’approche personnalisée de chaque vendeur

Conventions GUI et composants partagés

Les conventions Windows — comme les raccourcis clavier standard, la disposition des boîtes de dialogue et les contrôles communs (boutons, listes, zones de texte) — ont réduit à la fois l’effort de développement et la formation des utilisateurs. Les composants partagés signifiaient moins de solutions ad hoc et moins de surprises de compatibilité quand le matériel changeait.

Versions, compatibilité et planification

À mesure que Windows évoluait, les développeurs devaient choisir : supporter les anciennes versions pour la portée ou adopter de nouvelles API pour des capacités accrues. Cette planification a façonné les roadmaps, les tests et le marketing.

Avec le temps, outils, documentation, bibliothèques tierces et attentes utilisateurs ont commencé à se centrer sur Windows comme cible par défaut — pas seulement un système d’exploitation, mais une plateforme avec des normes et de l’élan.

Expérience développeur : IDE, compilateurs, docs et exemples

Une plateforme ne paraît pas « réelle » aux développeurs tant qu’il n’est pas facile d’y livrer du logiciel. À l’ère du PC, cette facilité était moins façonnée par le marketing que par l’expérience quotidienne d’écrire, construire, déboguer et empaqueter des programmes.

Les outils sont des multiplicateurs de productivité

Compilateurs, linkers, débogueurs et systèmes de build fixent silencieusement le rythme d’un écosystème. Quand les temps de compilation baissent, que les messages d’erreur s’améliorent et que le débogage devient fiable, les développeurs peuvent itérer plus vite — et l’itération transforme une idée à moitié fonctionnelle en produit.

Les environnements de développement intégrés (IDE) ont poussé cela plus loin en regroupant édition, compilation, débogage et gestion de projet dans un seul flux. Un bon IDE réduisait le « travail de colle » qui consommait sinon des heures : configuration des chemins d’inclusion, gestion des bibliothèques, cohérence des builds et traque des crashes runtime.

Risque réduit pour les petites équipes

De meilleurs outils ne sont pas seulement « agréables » — ils changent l’économie pour les petites équipes. Si un ou deux développeurs peuvent construire et tester avec confiance, ils peuvent entreprendre des projets qui nécessiteraient autrement plus de personnel. Cela réduit les coûts, raccourcit les délais et rend moins risqué pour un petit ISV de miser sur un nouveau produit.

Les docs et exemples valent souvent plus que des fonctionnalités

La documentation et les exemples exécutables agissent comme un second produit : ils enseignent le modèle mental, montrent les bonnes pratiques et évitent les erreurs courantes. Beaucoup de développeurs n’adoptent pas une API parce qu’elle est puissante — ils l’adoptent parce qu’il existe un exemple clair qui fonctionne dès le premier jour.

L’outillage façonne ce qui semble « facile » (et donc « standard »)

Les fournisseurs d’outils influencent quelles approches deviennent dominantes en rendant certains chemins plus fluides. Si les templates, assistants, bibliothèques et vues de débogage favorisent une approche particulière, cette approche devient la valeur par défaut — pas parce qu’elle est objectivement supérieure, mais parce qu’elle est plus rapide à apprendre et plus sûre pour la mise en production.

API et SDK : rendre possible les logiciels tiers à grande échelle

Un système d’exploitation n’est pas automatiquement une « plateforme ». Il le devient quand des développeurs externes peuvent raisonnablement construire dessus. C’est là que les API et les SDK ont compté à l’ère PC.

Une API est essentiellement un menu de fonctionnalités qu’une appli peut utiliser : dessiner une fenêtre, imprimer un document, sauvegarder un fichier, parler au matériel, jouer du son. Plutôt que chaque développeur invente sa propre manière de faire ces choses, la plateforme offre des blocs de construction partagés.

Un SDK (kit de développement logiciel) est l’ensemble qui rend ces blocs utilisables : bibliothèques, headers, outils, documentation et exemples montrant comment commander dans le menu.

Les développeurs assument un coût réel quand ils bâtissent : temps, recrutement, support, marketing et mises à jour. Des API stables réduisent le risque qu’une mise à jour casse des fonctions centrales.

Quand les règles restent cohérentes — les boîtes de dialogue de fichiers se comportent pareil, l’impression fonctionne pareil, les contrôles de fenêtre suivent le même schéma — les entreprises tierces peuvent planifier des roadmaps pluriannuelles. Cette prévisibilité est une grande raison pour laquelle le modèle développeur Windows a attiré de sérieux ISV plutôt que seulement des hobbyistes.

Les programmes développeurs créent une boucle de rétroaction

Les équipes plateformes ne se contentent pas de publier des API ; elles encouragent l’adoption. Programmes développeurs, documentation précoce, bêtas et releases preview permettent aux éditeurs de tester la compatibilité avant un lancement complet.

Cela crée une boucle : les développeurs trouvent des cas limites, la plateforme corrige, et la prochaine vague d’apps est lancée avec moins de surprises. Avec le temps, cela améliore la qualité pour les utilisateurs et réduit les coûts de support pour tout le monde.

Les risques : cassures, signaux contradictoires, fragmentation

Les API peuvent aussi devenir un passif. Des changements ruptures forcent des réécritures coûteuses. Des lignes directrices incohérentes (UI différente entre applications système) donnent l’impression que les applis tierces sont « à côté » même quand elles fonctionnent. La fragmentation — plusieurs API concurrentes pour une même tâche — divise l’attention et freine l’élan de l’écosystème.

À grande échelle, la meilleure stratégie de plateforme est souvent ennuyeuse : promesses claires, dépréciation soigneuse et documentation tenue à jour.

Canaux de distribution : accords OEM, rayons et shareware

Évoluez selon vos besoins

Commencez gratuitement, puis passez à un plan supérieur quand votre projet a besoin de plus de capacité.

Une plateforme n’est pas que des API et des outils — c’est aussi la façon dont le logiciel atteint les gens. À l’ère du PC, la distribution décidait quels produits devenaient « par défaut », lesquels trouvaient une audience et lesquels disparaissaient silencieusement.

Accords OEM : le pouvoir d’être déjà présent

Quand les fabricants préinstallaient des logiciels (ou les incluaient dans la boîte), ils façonnaient les attentes des utilisateurs. Si un tableur, un traitement de texte ou un runtime était livré avec la machine, ce n’était pas seulement pratique — c’était le point de départ. Les partenariats OEM offraient aussi aux développeurs quelque chose d’encore plus précieux que du marketing : un volume prévisible. Être livré avec une ligne de matériel populaire pouvait signifier des ventes stables et prévisibles — crucial pour financer support, mises à jour et documentation.

Rayons et catalogues : la visibilité comme avantage

Les boîtes de logiciels en magasin, les catalogues et plus tard les grandes surfaces informatiques ont créé une « compétition pour la place en rayon ». Le packaging, la reconnaissance de la marque et les budgets de distribution comptaient. Un meilleur produit pouvait perdre face à un plus visible.

Cette visibilité créait une boucle : de fortes ventes justifiaient plus de présence en rayon, ce qui entraînait plus de ventes. Les développeurs ont appris que le canal n’est pas neutre — il récompense les produits capables d’échelle en promotion et support.

Shareware : un moteur de distribution grassroots

Le shareware (souvent distribué sur disquettes via des groupes d’utilisateurs, des magazines et des BBS) abaissait la barrière d’entrée pour les nouveaux venus. Les utilisateurs pouvaient essayer avant d’acheter, et de petits développeurs atteignaient des niches sans accords retail.

Le fil commun de tous ces canaux était la portée et la prévisibilité. Quand les développeurs peuvent compter sur la manière dont les clients découvriront, essaieront et paieront le logiciel, ils peuvent planifier effectifs, tarification, mises à jour et paris produits à long terme.

L’économie qui a attiré les développeurs grand public et les ISV

Une grande raison pour laquelle l’ère PC a attiré des développeurs grand public n’était pas seulement la possibilité technique — c’était l’économie prévisible. Le « modèle logiciel PC » facilitait la prévision des revenus, le financement d’améliorations continues et la construction d’entreprises autour du logiciel plutôt que des services.

Tarification, licences et cycles de mise à niveau

La tarification des logiciels empaquetés (et plus tard la licence par siège) créait des attentes de revenus claires : vendre une copie, obtenir une marge, répéter. Les mises à niveau payantes périodiques importaient parce qu’elles transformaient la « maintenance » en modèle économique — les développeurs pouvaient planifier de nouvelles versions tous les 12–24 mois, aligner le marketing sur les sorties et justifier l’investissement dans le support et la doc.

Pour les petites équipes, c’était énorme : pas besoin d’un contrat personnalisé pour chaque client. Un produit pouvait monter en échelle.

La base installée façonne ce qui vaut la peine d’être construit

Une fois qu’une plateforme atteint une grande base installée, elle change les applications qui valent la peine d’être développées. Les logiciels verticaux de niche (comptabilité pour dentistes, gestion de stock pour ateliers auto), les petits utilitaires et les jeux deviennent viables parce qu’un petit pourcentage d’un grand marché reste une opportunité business.

Les développeurs ont aussi commencé à optimiser pour des produits favorables à la distribution : des choses qui se démoient bien, tiennent sur une étagère et résolvent un problème spécifique rapidement.

Compatibilité, coûts de support et réalité des petites entreprises

Les acheteurs professionnels privilégient la stabilité plutôt que la nouveauté. La compatibilité avec les fichiers existants, les imprimantes et les flux de travail réduit les appels support — souvent le coût caché le plus important pour les éditeurs. Les plateformes qui maintiennent les anciennes applis réduisent le risque pour clients et développeurs.

Ce que signifie être un ISV

Un ISV est une société dont le produit dépend de la plateforme d’un autre. Le compromis est simple : vous gagnez en portée et en levier de distribution, mais vous vivez selon les règles, les changements de version et les attentes imposées par l’écosystème.

Effets de réseau et boucle de rétroaction de l’adoption

Mettez la théorie de la plateforme en pratique

Appliquez la boucle outils + cible + distribution à votre prochain produit.

Les effets de réseau sont simples : quand une plateforme a plus d’utilisateurs, il est plus facile pour les développeurs de justifier d’y construire. Et quand elle a plus d’apps, elle devient plus utile pour les utilisateurs. Cette boucle est la façon dont une plateforme « assez bonne » devient par défaut.

Pourquoi des choix par défaut émergent (même avec des alternatives)

À l’ère PC, choisir où développer n’était pas que question d’élégance technique. Il s’agissait d’atteindre le plus grand marché adressable avec le moins de friction. Une fois MS‑DOS puis Windows devenus cibles communes, les développeurs pouvaient livrer un produit et s’attendre à ce qu’il fonctionne pour une large part des clients.

Les utilisateurs suivaient les logiciels qu’ils voulaient — tableurs, traitements de texte, jeux — et les entreprises suivaient les talents. Avec le temps, la plateforme qui proposait le catalogue le plus profond paraissait plus sûre : meilleurs recrutements, plus de matériel de formation, plus d’intégrations tierces et moins de doutes « est‑ce que ça marchera ? ».

Standards qui renforcent le cycle

Les effets de réseau ne tenaient pas qu’au nombre d’apps. Les standards resserraient la boucle :

- Formats de fichiers qui permettent de partager sans conversion.

- Périphériques et pilotes qui « marchent » sur de nombreuses machines.

- API communes qui réduisent le coût de support des imprimantes, graphiques et réseaux.

Chaque standard réduisait les coûts de changement pour les utilisateurs — et réduisait les coûts de support pour les développeurs — rendant le choix par défaut encore plus solide.

Où le modèle peut échouer

Le volant casse quand les développeurs ne peuvent pas réussir :

- Outils médiocres, documentation floue ou API instables.

- Distribution faible (les clients ne trouvent pas ou n’installent pas les apps facilement).\n- Fragmentation qui oblige à des builds multiples pour des appareils similaires.

Une plateforme peut avoir des utilisateurs, mais sans chemin fiable pour que les développeurs construisent, expédient et soient payés, l’écosystème stagne — et la boucle s’inverse.

Le modèle logiciel PC a créé un énorme avantage pour celui qui fixait l’environnement par défaut — mais il n’a jamais garanti un contrôle total. L’ascension de Microsoft s’est produite dans un marché compétitif et parfois instable où d’autres acteurs pouvaient (et ont) changer les règles.

Une concurrence qui fait bouger le terrain

Apple proposait une alternative fortement intégrée : moins de combinaisons matérielles, une expérience utilisateur plus contrôlée et une histoire développeur différente. De l’autre côté, l’écosystème « compatible IBM » n’était pas un concurrent unique mais une coalition tentaculaire de fabricants de clones, de fournisseurs de puces et d’éditeurs — chacun pouvant modifier les standards ou le pouvoir de négociation.

Même à l’intérieur de l’orbite IBM, la direction de la plateforme était contestée. OS/2 fut une tentative sérieuse de définir l’environnement PC suivant, et son destin montra combien il est difficile de migrer des développeurs quand la cible existante (MS‑DOS, puis Windows) a déjà de l’élan.

Plus tard, l’ère du navigateur a introduit une nouvelle couche possible au‑dessus de l’OS, recentrant la compétition sur les choix par défaut, la distribution et le runtime sur lequel les développeurs pouvaient compter.

L’examen antitrust — sans entrer dans les résultats juridiques — met en lumière une tension récurrente des plateformes : les mêmes actions qui simplifient la vie des utilisateurs (fonctions groupées, logiciels préinstallés, paramètres par défaut) peuvent réduire les vraies options pour développeurs et concurrents.

Quand un composant groupé devient le défaut, les développeurs suivent souvent la base installée plutôt que la « meilleure » option. Cela peut accélérer la standardisation, mais aussi évincer des alternatives et réduire l’expérimentation.

Un enseignement pondéré

Les stratégies de croissance de plateforme impliquent des responsabilités d’écosystème. Si vous profitez du statut de valeur par défaut, vous façonnez aussi la structure des opportunités du marché — qui peut atteindre les utilisateurs, ce qui est financé et à quel point il est facile d’innover. Plus les règles sont saines et transparentes, plus la confiance des développeurs est durable et soutient la plateforme.