Remplacer, Augmenter, Intouché : un cadre simple

Les conversations sur ce que « l’IA fera aux développeurs » deviennent vite confuses parce que l’on confond souvent outils et responsabilités. Un outil peut générer du code, résumer un ticket ou suggérer des tests. Une responsabilité, c’est ce dont l’équipe reste responsable quand la suggestion est erronée.

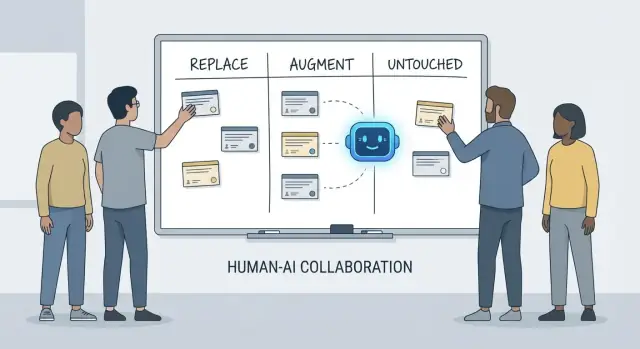

Cet article utilise un cadre simple — remplacer, augmenter, intouché — pour décrire le travail quotidien dans de vraies équipes avec des délais, du code legacy, des incidents en production et des parties prenantes qui attendent des résultats fiables.

Ce que « remplacer » signifie (et ce que cela n’implique pas)

Remplacer signifie que l’IA peut accomplir la tâche de bout en bout la plupart du temps avec des garde‑fous clairs, et que le rôle humain devient la supervision et des vérifications ponctuelles.

Les exemples sont souvent des travaux bornés : générer du boilerplate, traduire du code entre langages, rédiger des cas de test répétitifs ou produire une documentation de première passe.

Remplacer ne signifie pas « plus de responsabilité humaine ». Si la sortie casse la production, fuit des données ou viole des normes, c’est toujours l’équipe qui en répond.

Ce que « augmenter » signifie

Augmenter signifie que l’IA rend un développeur plus rapide ou plus exhaustif, mais qu’elle ne termine pas de façon fiable le travail sans jugement humain.

C’est le cas courant en ingénierie professionnelle : vous obtiendrez des brouillons utiles, des approches alternatives, des explications rapides ou une liste restreinte de bugs probables — mais un développeur décide encore de ce qui est correct, sûr et approprié pour le produit.

Ce qui reste « intouché »

Intouché signifie que la responsabilité principale reste menée par des humains parce qu’elle demande du contexte, des arbitrages et un niveau de reddition de comptes difficile à compresser en prompts.

Pensez : négocier les exigences, choisir les contraintes système, gérer les incidents, définir les seuils de qualité et prendre des décisions sans « bonne » réponse unique.

Pourquoi les responsabilités sont l’unité d’analyse

Les outils changent vite. Les responsabilités changent lentement.

Donc, au lieu de demander « Une IA peut‑elle écrire ce code ? », demandez « Qui est responsable du résultat ? » Ce cadrage maintient les attentes sur l’exactitude, la fiabilité et la responsabilité — des choses qui comptent plus que des démonstrations impressionnantes.

Ce que nous entendons par « responsabilités de développeur »

Quand on demande ce que l’IA « remplace » en développement, on pense souvent à des tâches : écrire une fonction, générer des tests, rédiger une doc. Les équipes, cependant, n’expédient pas des tâches — elles livrent des résultats. C’est là que les responsabilités de développeur importent.

Le paquet habituel de responsabilités

Le travail d’un développeur couvre généralement plus que le temps de codage :

- Livraison : transformer une idée vague en logiciel fonctionnel livré dans les délais.

- Qualité : exactitude, maintenabilité et prévention des régressions.

- Sécurité et confidentialité : paramètres sûrs par défaut, traitement des données et conscience des menaces.

- Opérations : maintenir les services en fonctionnement, comprendre les modes de défaillance et répondre aux incidents.

- Communication : s’aligner avec le produit, le design, le support et les autres ingénieurs.

Ces responsabilités couvrent tout le cycle de vie — de « que devons‑nous construire ? » à « est‑ce sûr ? » en passant par « que se passe‑t‑il à 3 h du matin quand ça casse ? »

Pourquoi ce n’est pas qu’une checklist

Chaque responsabilité inclut en réalité beaucoup de petites décisions : quels cas limites comptent, quels indicateurs reflètent la santé, quand réduire la portée, si un correctif est sûr à déployer, comment expliquer un compromis aux parties prenantes. L’IA peut aider à exécuter des morceaux de ce travail (brouillons de code, propositions de tests, synthèses de logs), mais la responsabilité, c’est assumer le résultat.

Où les transferts échouent

Les ruptures surviennent souvent aux frontières de transfert :

- « QA s’en chargera » (mais personne n’a défini ce qu’est la qualité).

- « Sécurité relira » (mais la conception a déjà verrouillé des choix risqués).

- « Ops gèrera » (mais le service n’a pas été construit pour être exploitable).

Quand la propriété est floue, le travail tombe entre les mailles.

Droits de décision : qui décide vs qui exécute

Une façon utile de parler des responsabilités est les droits de décision :

- Qui décide des exigences, des compromis et des risques acceptables ?

- Qui exécute l’implémentation et la vérification ?

L’IA peut accélérer l’exécution. Les droits de décision — et la responsabilité des résultats — doivent encore porter un nom humain.

Travail que l’IA peut souvent remplacer (avec garde‑fous)

Les assistants de codage IA sont réellement utiles quand le travail est prévisible, peu critique et facile à vérifier. Considérez‑les comme un coéquipier junior rapide : excellent pour produire une première version, mais nécessitant encore des instructions claires et une relecture attentive.

En pratique, certaines équipes utilisent de plus en plus des plateformes de « vibe‑coding » (comme Koder.ai) pour accélérer ces morceaux remplaçables : générer des squelettes, câbler des flux CRUD et produire des brouillons initiaux d’UI et de backend depuis le chat. La clé reste la même : garde‑fous, relecture et propriété claire.

Boilerplate à faible risque

Beaucoup de temps développeur est passé à structurer des projets et à tout relier. L’IA peut souvent générer :

- fichiers et dossiers de démarrage (contrôleurs, routes, DTO)

- glue code répétitif entre couches

- endpoints CRUD simples qui suivent un patron établi

Le garde‑fou ici est la cohérence : assurez‑vous que cela respecte vos conventions existantes et n’invente pas de nouveaux patterns ou dépendances.

Refactors et migrations mécaniques

Quand un changement est majoritairement mécanique — renommer un symbole sur la base de code, reformater ou mettre à jour une utilisation d’API simple — l’IA peut accélérer le travail répétitif.

Traitez‑le comme une édition massive : exécutez toute la suite de tests, scannez les diffs pour des changements de comportement inattendus, et évitez qu’elle « améliore » au‑delà du refactor demandé.

Brouillons de documentation (relecture requise)

L’IA peut rédiger des README, des commentaires inline et des notes de changelog basés sur le code et les commits. Cela accélère la clarté, mais peut aussi produire des inexactitudes sûres d’elles.

Bonne pratique : utilisez l’IA pour la structure et la formulation, puis vérifiez chaque assertion — en particulier les étapes d’installation, les valeurs par défaut de configuration et les cas limites.

Génération de tests de base comme point de départ

Pour des fonctions pures bien spécifiées, les tests unitaires générés par l’IA peuvent fournir une couverture initiale et rappeler certains cas limites. Le garde‑fou est la propriété : vous choisissez ce qui importe, ajoutez des assertions reflétant les exigences réelles et vous assurez que les tests échouent pour les bonnes raisons.

Résumés de fils et de logs

Pour de longs fils Slack, tickets ou logs d’incident, l’IA peut les transformer en notes concises et éléments d’action. Gardez‑les ancrés en fournissant le contexte complet, puis vérifiez les faits, timestamps et décisions clés avant de partager.

Travail que l’IA augmente surtout : plus rapide, pas fini

Les assistants de codage IA excellent quand vous savez déjà ce que vous voulez et avez juste besoin d’aller plus vite. Ils réduisent le temps passé à « taper » et mettent en avant du contexte utile, mais ils ne suppriment pas le besoin de propriété, de vérification et de jugement.

Accélérer l’implémentation (une bonne première passe)

Avec une spécification claire — entrées, sorties, cas limites et contraintes — l’IA peut rédiger une implémentation de départ raisonnable : boilerplate, mappage de données, handlers API, migrations ou un refactor simple. Le gain est la dynamique : vous obtenez quelque chose d’exécutable rapidement.

Le hic est que le code de première passe manque souvent d’exigences subtiles (sémantique d’erreur, contraintes de performance, compatibilité ascendante). Traitez‑le comme le brouillon d’un stagiaire : utile, mais non autoritatif.

Proposer des options — avec des compromis à valider

Pour choisir entre approches (cache vs batch, verrou optimiste vs pessimiste), l’IA peut proposer des alternatives et lister leurs compromis. Utile pour le brainstorming, mais ces compromis doivent être vérifiés face à la réalité de votre système : forme du trafic, besoins de cohérence des données, contraintes opérationnelles et conventions d’équipe.

Compréhension du code et navigation dans la base

L’IA est aussi forte pour expliquer du code peu familier, repérer des patterns et traduire « que fait‑ceci ? » en langage clair. Associée à des outils de recherche, elle aide à répondre « où X est‑il utilisé ? » et à générer une liste d’impacts probable (sites d’appel, configs, tests à revoir).

Ergonomie développeur : boucles de feedback plus rapides

Attendez‑vous à des améliorations pratiques : messages d’erreur plus clairs, petits exemples et snippets prêts à coller. Ils réduisent les frictions, mais ne remplacent pas la relecture attentive, les exécutions locales et les tests ciblés — surtout pour des changements qui touchent des utilisateurs ou la production.

Compréhension produit et exigences : toujours dirigées par des humains

L’IA peut aider à rédiger et affiner des exigences, mais elle ne peut pas décider de manière fiable ce que vous devriez construire ou pourquoi cela importe. La compréhension produit s’enracine dans le contexte : objectifs business, douleur utilisateur, contraintes organisationnelles, cas limites et coût d’erreur. Ces éléments vivent dans des conversations, de l’historique et de la responsabilité — des choses qu’un modèle peut résumer, mais pas posséder.

Les demandes initiales sonnent souvent comme « rendre l’onboarding plus fluide » ou « réduire les tickets support ». Le travail du développeur est de traduire cela en exigences claires et critères d’acceptation.

Cette traduction est majoritairement humaine parce qu’elle dépend de questions poussées et de jugement :

- quel segment d’utilisateurs optimiser et quel comportement doit changer ?

- qu’est‑ce qui compte comme « terminé » et comment le mesurer ?

- quelles contraintes sont non négociables (confidentialité, performance, délais) ?

L’IA peut suggérer des métriques ou des critères d’acceptation, mais elle ne saura pas quelles contraintes sont réelles sans qu’on les fournisse — et elle ne remettra pas en question une demande contradictoire.

Compromis et gestion des attentes

Le travail d’exigences expose des compromis inconfortables : temps vs qualité, rapidité vs maintenabilité, nouvelles fonctionnalités vs stabilité. Une personne doit expliciter les risques, proposer des options et aligner les parties prenantes sur les conséquences.

Une bonne spécification n’est pas juste du texte ; c’est un enregistrement de décision. Elle doit être testable et implémentable, avec des définitions nettes (entrées, sorties, cas limites et modes d’échec). L’IA aide à structurer le document, mais la responsabilité de sa justesse — et de dire « c’est ambigu, on a besoin d’une décision » — reste humaine.

Conception système et décisions d’architecture

La conception système transforme « que construire ? » en « sur quoi construire et comment se comportera‑t‑il quand les choses tournent mal ? » L’IA aide à explorer des options, mais elle ne peut pas assumer les conséquences.

Choisir une architecture qui colle à la réalité

Choisir entre monolithe, monolithe modulaire, microservices, serverless ou plateformes gérées n’est pas un quiz à réponse unique. C’est un problème d’ajustement : échelle attendue, budget, time‑to‑market et compétences de l’équipe.

Un assistant peut résumer des patterns et proposer des architectures de référence, mais il ne saura pas que votre équipe fait des rotations d’on‑call hebdomadaires, que le recrutement est lent ou que votre contrat fournisseur de base de données est à renouveler le trimestre prochain. Ces détails décident souvent du succès d’une architecture.

Rendre les compromis explicites

La bonne architecture est surtout une série de compromis : simplicité vs flexibilité, performance vs coût, rapidité aujourd’hui vs maintenabilité demain. L’IA peut rapidement produire des listes d’avantages/inconvénients, utile pour documenter des décisions.

Ce qu’elle ne peut pas faire, c’est fixer des priorités quand les compromis font mal. Par exemple, « nous acceptons des réponses un peu plus lentes pour garder le système plus simple et plus facile à exploiter » est un choix business, pas purement technique.

Frontières, propriété des données et modes de panne

Définir les frontières de service, qui possède quelles données et ce qui se passe lors de pannes partielles exige un contexte produit et opérationnel profond. L’IA peut brainstormer des modes de panne (« et si le fournisseur de paiement tombe ? »), mais les humains doivent décider du comportement attendu, du message client et du plan de rollback.

API qui restent utilisables

Concevoir une API, c’est concevoir un contrat. L’IA peut générer des exemples et détecter des incohérences, mais vous devez décider du versioning, de la compatibilité ascendante et de ce que vous êtes prêt à supporter à long terme.

Décider de ne pas construire (ou de supprimer)

Peut‑être la décision architecturale la plus importante est de dire « non » — ou de supprimer une fonctionnalité. L’IA ne peut pas mesurer le coût d’opportunité ou le risque politique. Les équipes le peuvent, et doivent.

Débogage et analyse de cause racine en pratique

Le débogage est souvent l’endroit où l’IA paraît impressionnante — et où elle peut faire perdre le plus de temps subtilement. Un assistant peut scanner des logs, pointer des chemins de code suspects ou suggérer un correctif qui « semble juste ». Mais l’analyse de cause racine n’est pas seulement générer des explications ; c’est les prouver.

L’IA peut suggérer ; vous confirmez la cause racine

Considérez la sortie de l’IA comme des hypothèses, pas des conclusions. Beaucoup de bugs ont plusieurs causes plausibles, et l’IA a tendance à choisir une histoire propre qui colle au snippet que vous avez collé, pas à la réalité du système en exécution.

Un flux de travail pratique :

- demander à l’IA des causes possibles et quelles preuves les distingueraient.

- reproduire l’incident et collecter ces preuves.

- n’accepter un correctif que s’il supprime réellement la condition d’échec observée.

La reproduction et la collecte de preuves restent menées par des humains

La reproduction fiable est une superpuissance debug car elle transforme un mystère en test. L’IA peut aider à écrire un repro minimal, rédiger un script diagnostique ou proposer du logging supplémentaire, mais vous décidez quels signaux importent : IDs de requête, timings, différences d’environnement, feature flags, forme des données ou concurrence.

Quand des utilisateurs rapportent des symptômes (« l’app a gelé »), il faut encore traduire cela en comportement système : quel endpoint a ralenti, quels timeouts ont déclenché, quels signaux du budget d’erreur ont changé. Cela demande du contexte : comment le produit est utilisé et ce qu’est le « normal ».

Éviter les explications « plausibles mais fausses »

Si une suggestion ne peut pas être validée, supposez‑la incorrecte jusqu’à preuve du contraire. Préférez des explications qui font une prédiction testable (par ex. « ceci n’arrivera que sur de gros payloads » ou « seulement après le warm‑up du cache »).

Patch, revert ou refonte ?

Même après avoir trouvé la cause, la décision reste difficile. L’IA peut exposer des compromis, mais les humains choisissent la réponse :

- patcher rapidement pour arrêter l’hémorragie.

- revert pour restaurer un état connu‑bon.

- redessiner si la défaillance révèle un désalignement plus profond (performance, modèle de données, hypothèses).

L’analyse de cause racine est finalement une question de responsabilité : assumer l’explication, le correctif et la confiance qu’elle ne reviendra pas.

Revue de code : le jugement et les standards ne s’automatisent pas

La revue de code n’est pas simplement une checklist de style. C’est le moment où une équipe décide de ce qu’elle est prête à maintenir, supporter et assumer. L’IA peut vous aider à voir davantage, mais elle ne peut pas décider ce qui importe, ce qui cadre avec l’intention produit ou quels compromis votre équipe accepte.

Ce que l’IA fait bien en revue

Les assistants peuvent agir comme une seconde paire d’yeux infatigable. Ils peuvent rapidement :

- signaler des bugs probables, patterns suspects, vérifications null manquantes ou manipulation de chaînes dangereuse.

- suggérer des noms plus clairs, des refactors ou des flux de contrôle plus simples.

- pointer des incohérences de formatage ou des duplications évidentes.

- générer des questions de revue (« que se passe‑t‑il si cette API renvoie une liste vide ? »).

Utilisée ainsi, l’IA raccourcit le temps entre « PR ouverte » et « risque remarqué ».

Ce qui exige encore du jugement humain

La relecture pour la correction ne se limite pas à compiler le code. Les humains relient les changements au comportement utilisateur réel, aux contraintes de production et à la maintenance à long terme.

Un réviseur doit encore décider :

- Que déployer : l’IA peut lister les problèmes, mais elle ne peut pas choisir lesquels sont bloquants pour la release.

- Lisibilité et maintenabilité : un code « techniquement correct » peut rester confus, fragile ou difficile à étendre.

- Cas limites et écarts d’environnement : de nombreuses pannes sont « ça marche sur ma machine » — config, données, concurrence ou timing de déploiement.

- Standards et intention : seule l’équipe connaît ses conventions et sa tolérance au risque. Un changement peut être propre et néanmoins erroné.

Un flux de travail pratique : l’IA comme co‑réviseur

Considérez l’IA comme un second réviseur, pas l’approbateur final. Demandez‑lui une passe ciblée (sécurité, cas limites, compatibilité ascendante), puis prenez la décision humaine sur la portée, la priorité et l’alignement avec les standards d’équipe et l’intention produit.

Stratégie de tests et propriété de la qualité

Les assistants IA peuvent générer des tests rapidement, mais ils n’en assument pas la qualité. Une suite de tests est un ensemble de paris sur ce qui peut casser, ce qui doit absolument tenir et ce qu’on est prêt à livrer sans couvrir chaque cas limite. Ces paris sont des décisions produit et ingénierie — toujours prises par des humains.

L’IA peut rédiger des tests ; les humains fixent les cibles

Les assistants sont bons pour produire le squelette de tests unitaires, simuler des dépendances et couvrir les comportements « happy path » à partir d’une implémentation. Ce qu’ils ne peuvent pas décider de manière fiable, c’est quelle couverture importe.

Les humains définissent :

- quels modules exigent une couverture approfondie car critiques ou fréquemment modifiés.

- ce que signifie « fini » pour un refactor risqué vs un petit bug.

- quand investir en tests de régression vs monitoring et plans de rollback.

Choisir le bon mélange de types de tests

La plupart des équipes ont besoin d’une stratégie en couches, pas de « plus de tests ». L’IA aide à écrire beaucoup de ces tests, mais la sélection et les frontières restent humaines :

- Tests unitaires pour règles métier et cas limites délicats.

- Tests d’intégration pour interactions base/queue/service.

- End‑to‑end pour parcours utilisateur critiques (peu, stables, haute valeur).

- Tests de contrat pour garder les APIs compatibles entre équipes/services.

- Tests de performance pour protéger latence et coût sous charge.

Éviter les tests instables et la fausse confiance

Les tests générés par l’IA reproduisent souvent trop l’implémentation, créant des assertions fragiles ou des setups sur‑mockés qui passent même quand le comportement réel échoue. Les développeurs évitent cela en :

- testant le comportement observable, pas les détails d’implémentation.

- gardant des données déterministes et contrôlant le temps, l’aléatoire et les appels réseau.

- relisant les échecs pour décider : bug réel, bug de test ou problème d’environnement.

Aligner la stratégie avec le risque et le rythme de release

Une bonne stratégie correspond à votre manière de déployer. Des releases plus rapides nécessitent des vérifications automatisées plus robustes et des chemins de rollback clairs ; des releases plus lentes peuvent tolérer une validation pré‑merge plus lourde. Le propriétaire de la qualité, c’est l’équipe, pas l’outil.

Mesurer les résultats qui comptent

La qualité n’est pas un pourcentage de couverture. Suivez si les tests améliorent les résultats : moins d’incidents en production, rétablissement plus rapide et changements plus sûrs (moins de rollbacks, déploiements plus confiants). L’IA accélère le travail, mais la responsabilité reste aux développeurs.

Le travail sécurité porte moins sur la génération de code et plus sur faire des compromis sous contraintes réelles. L’IA peut faire remonter des checklists et des erreurs courantes, mais la décision sur le risque revient à l’équipe.

Le threat modeling a besoin de contexte

Le threat modeling n’est pas un exercice générique — ce qui compte dépend de vos priorités business, de vos utilisateurs et des modes de panne. Un assistant peut suggérer des menaces typiques (injection, auth cassée, defaults non sécurisés), mais il ne saura pas lesquelles sont réellement coûteuses pour votre produit : prise de contrôle de comptes vs fuite de données vs disruption de service, ni quels actifs sont légalement sensibles.

Les risques applicatifs sont souvent hors motif

L’IA repère bien les anti‑patterns connus, mais de nombreux incidents viennent de détails applicatifs : un cas limite de permissions, un endpoint admin « temporaire » ou un workflow contournant une approbation. Ces risques demandent de lire l’intention du système, pas seulement le code.

Secrets, permissions et rétention sont des choix volontaires

Les outils peuvent rappeler de ne pas hardcoder des clés, mais ils ne peuvent pas assumer la politique complète :

- où résident les secrets (vault, CI, runtime) et comment ils tournent.

- rôles least‑privilege et revues d’accès.

- rétention des données : quoi stocker, combien de temps, qui peut exporter.

Dépendances et risque de la chaîne d’approvisionnement

L’IA peut signaler des librairies obsolètes, mais les équipes doivent avoir des pratiques : pinner les versions, vérifier la provenance, revoir les dépendances transitives et décider entre accepter le risque ou investir dans la remédiation.

La conformité n’est pas « ajouter du chiffrement ». Ce sont des contrôles, de la documentation et de la responsabilité : logs d’accès, traces d’approbation, procédures d’incident et preuves que vous les avez suivies. L’IA peut rédiger des templates, mais les humains valident les preuves et signent — c’est ce dont les auditeurs (et clients) se reposent.

Opérations, fiabilité et réponse aux incidents

L’IA peut accélérer le travail ops, mais elle n’en prend pas la responsabilité. La fiabilité est une chaîne de décisions sous incertitude, et le coût d’un mauvais choix est généralement plus élevé que celui d’un choix lent.

Où l’IA aide au quotidien

L’IA est utile pour rédiger et maintenir des artefacts opérationnels — runbooks, checklists et playbooks « si X alors Y ». Elle peut aussi résumer des logs, regrouper des alertes similaires et proposer des hypothèses de première passe.

Concrètement, cela accélère :

- tableaux de monitoring et descriptions d’alertes.

- notes de capacité et heuristiques de scaling.

- modèles de reporting de budget d’erreur.

Ce sont de bons accélérateurs, mais ce n’est pas le travail lui‑même.

Les parties restant humaines

Les incidents suivent rarement le script. Les ingénieurs on‑call traitent des signaux flous, des pannes partielles et des compromis dans l’urgence. L’IA peut suggérer des causes probables, mais elle ne décide pas de manière fiable s’il faut alerter une autre équipe, désactiver une fonctionnalité ou accepter un impact client temporaire pour préserver l’intégrité des données.

La sécurité des déploiements reste une responsabilité humaine. Les outils peuvent recommander des rollbacks, feature flags ou déploiements progressifs, mais les équipes choisissent le chemin le plus sûr selon le contexte business et le blast radius.

Postmortems : l’apprentissage est l’objectif

L’IA peut rédiger des timelines et extraire des événements clés des chats, tickets et métriques. Les humains font encore le travail critique : définir ce qu’est un bon postmortem, prioriser les corrections et effectuer des changements qui évitent les répétitions (pas seulement les mêmes symptômes).

Si vous traitez l’IA comme copilote pour la paperasse ops et la détection de patterns — pas comme un commandant d’incident — vous gagnerez en vitesse sans céder la responsabilité.

Communication d’équipe, mentorat et propriété

L’IA sait expliquer des concepts à la demande : « Qu’est‑ce que CQRS ? », « Pourquoi ce deadlock arrive ? », « Résume cette PR ». Cela aide les équipes à aller plus vite. Mais la communication au travail ne consiste pas seulement à transférer de l’information — elle construit la confiance, des habitudes partagées et des engagements sur lesquels on peut compter.

Onboarding : plus que de la doc

Les nouveaux ne cherchent pas seulement des réponses ; ils cherchent du contexte et des relations. L’IA peut résumer des modules, suggérer des parcours de lecture et traduire le jargon. Les humains doivent encore enseigner ce qui compte ici : quels compromis l’équipe privilégie, à quoi ressemble un bon travail dans cette base de code et qui contacter quand quelque chose cloche.

Alignement entre rôles

La friction de projet apparaît souvent entre rôles : produit, design, QA, sécurité, support. L’IA peut rédiger des comptes rendus, proposer des critères d’acceptation ou reformuler des retours plus neutres. Les personnes doivent toujours négocier les priorités, résoudre l’ambiguïté et remarquer quand une partie prenante « acquiesce » sans être vraiment d’accord.

Définition de fini et frontières de propriété

Les équipes échouent quand la responsabilité est floue. L’IA peut générer des checklists, mais elle ne peut pas faire respecter la responsabilité. Les humains doivent définir ce que signifie « fini » (tests ? docs ? plan de rollout ? monitoring ?) et qui possède quoi après le merge — surtout quand du code généré par l’IA masque de la complexité.

Checklist : usage responsable de l’IA dans les workflows d’équipe

- Divulguer l’usage de l’IA quand il affecte des décisions, des estimations ou du code auteur.

- Vérifier les faits : liens, APIs, affirmations de sécurité et « bonnes pratiques » avant de partager.

- Garder les prompts sans secrets (clés, données clients, détails d’incident).

- Traiter les sorties de l’IA comme des brouillons ; assigner un propriétaire humain pour chaque décision.

- Écrire des normes d’équipe : quand l’IA est autorisée, quand elle ne l’est pas, et revoir les attentes.

- Préférer des changements petits et relus — éviter les refactors IA « big bang ».